2. Foliensatz

Werbung

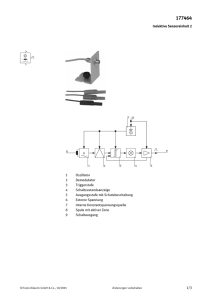

Spiel Körpergröße

9.1

Zahl: Anzahl weiblich

9.0

2

Einführung in die induktive Statistik

4

8.8

Tafelgruppe

8.9

1

1

8.6

1

8.5

Institut für Statistik

Ludwig-Maximilians-Universität München

0

3

8.7

Friedrich Leisch

5

SS 2009

8.4

8.5

8.6

8.7

8.8

8.9

9.0

Eigene.Gruppe

Friedrich Leisch, Induktive Statistik 2009

1

Inferenzstatistik

Methoden, um mit Informationen aus Stichproben auf Charakteristika

der Gesamtpopulation schließen zu können.

Konfidenzintervalle

Nach Modellierung und Parameterschätzung ist man meist an

der Überprüfung konkreter Fragestellungen interessiert (ja/neinEntscheidungen statt lange Beschreibungen der Daten).

Mögliche Frageformen:

1. Paßt eine Hypothese zu meinem Modell?

2. Widerspricht mein Modell einer gewissen Hypothese?

In der klassischen Inferenzstatistik werden vor allem Fragen der zweiten

Form behandelt.

Friedrich Leisch, Induktive Statistik 2009

3

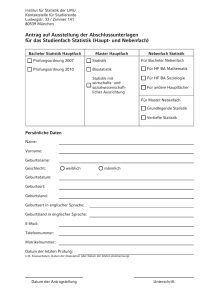

Beispiel: Sonntagsfrage

Vier Wochen vor der österreichischen Nationalratswahl 1999 wurde 499

Haushalten die Sonntagsfrage“ gestellt: Falls nächsten Sonntag Wahlen

”

wären, welche Partei würden Sie wählen?

Grüne

6%

7.4%

LIF

4%

3.65%

Sonst

3%

1.98%

0.3

FPÖ

25%

26.91%

0.2

ÖVP

24%

26.91%

Frage 1: War das Ergebnis für die SPÖ überraschend?

Frage 2: Mit welcher Wahrscheinlichkeit mußte das LIF damit rechnen,

den Wiedereinzug ins Parlament nicht zu schaffen? Mit welcher

Wahrscheinlichkeit die Grünen?

0.1

SPÖ

38%

33.15%

0.0

Umfrage

Wahl

Umfrage

Wahl

0.4

Beispiel: Sonntagsfrage

SP

VP

FP

G

LIF

sonst

Frage 3: War das Gesamtergebnis überraschend?

Friedrich Leisch, Induktive Statistik 2009

4

Friedrich Leisch, Induktive Statistik 2009

5

Konfidenzintervall für Mittelwert

Konfidenzintervall für Mittelwert

Schätzung des Mittelwerts:

√

Mit c = 1.96σ/ n haben wir 2 Ungleichungen

µ̂ = X̄ =

n

1 X

xi

n i=1

µ − c ≤ µ̂

µ̂ ≤ µ + c

Kommt die Stichprobe aus einer Population mit Mittelwert µ und Varianz

σ 2, dann gilt für n → ∞

und wollen eigentlich Aussagen über µ treffen. Bringen wir die Konstante

jeweils auf die andere Seite so erhalten wir

µ ≤ µ̂ + c

µ̂ ∼ N (µ, σ 2/n)

µ̂ − c ≤ µ

und mit 95% Wahrscheinlichkeit liegt µ̂ innerhalb des Intervalls

oder kürzer in einer Zeile

1.96σ

1.96σ

≤ µ̂ ≤ µ + √

µ− √

n

n

Friedrich Leisch, Induktive Statistik 2009

µ̂ − c ≤ µ ≤ µ̂ + c

6

Friedrich Leisch, Induktive Statistik 2009

7

Konfidenzintervall für Mittelwert

Beispiel: Sonntagsfrage

√

Setzen wir für c wieder 1.96σ/ n ein, so erhalten wir, daß mit 95%

Wahrscheinlichkeit

1.96σ

1.96σ

µ̂ − √

≤ µ ≤ µ̂ + √

n

n

Beginnen wir mit dem Ergebnis der SPÖ (Frage 1): Die Stimmen für jede

einzelne Partei können wir als binomialverteilt ansehen (jeweils gegen den

Rest).

gilt, falls die Stichprobe wirklich aus einer Population mit Mittelwert µ

und Varianz σ 2 stammt.

Die obere und untere Intervallgrenze hängen aber nicht von µ ab → die

Aussage trifft für alle µ aus diesem Intervall gleichermaßen zu.

Wir schließen also: Mit 95% Wahrscheinlichkeit liegt der wahre

Mittelwert irgendwo in dem gegebenen Intervall.

Friedrich Leisch, Induktive Statistik 2009

8

Beispiel: Sonntagsfrage

Wir haben also einen geschätzten Erwartungswert von p̂s = 0.38 und

eine zugehörige Varianz von

2 = p̂ (1 − p̂ ) = 0.2356

σ̂S

S

S

somit erhalten wir

s

c = 1.96

0.2356

= 0.04259

499

und es war zu erwarten, daß das Ergebnis der SPÖ mit 95%

Wahrscheinlichkeit im Intervall [33.7, 42.3] liegen würde. Das 99%

Intervall ist [32.4, 43.6].

Friedrich Leisch, Induktive Statistik 2009

9

Beispiel: Sonntagsfrage

Frage 2 betreffend den Verbleib der Grünen und des LIF können wir auch

so formulieren: Wie groß ist die Wahrscheinlichkeit, daß pG ≥ 0.04 bzw.

pL ≥ 0.04.

0.3

0.4

Umfrage

Wahl

P{p ≥ 0.04} = P{p̂ − p ≤ p̂ − 0.04}

0.2

Es gilt

p̂ ∼ N (p, σ 2/n)

0.0

0.1

p̂ − p ∼ N (0, σ 2/n)

√

(p̂ − p) n

∼ N (0, 1)

σ √

(p̂ − p) n

q

∼ N (0, 1)

p̂(1 − p̂)

SP

VP

Friedrich Leisch, Induktive Statistik 2009

FP

G

LIF

sonst

10

Friedrich Leisch, Induktive Statistik 2009

11

Beispiel: Sonntagsfrage

Beispiel: Sonntagsfrage

q

p̂(1 − p̂)

0.3

√

(p̂ − 0.04) n

√

(0.06 − 0.04) 499

= q

≈ 1.881225

0.06(1 − 0.06)

0.2

Grüne:

Umfrage

Wahl

0.4

√

(p̂ − p)√n

(p̂ − 0.04) n

P{p ≥ 0.04} = P q

≤ q

p̂(1 − p̂)

p̂(1 − p̂)

0.1

Φ(1.881225) ≈ 97%

√

(p̂ − 0.04) n

q

p̂(1 − p̂)

√

(0.04 − 0.04) 499

= q

0.06(1 − 0.06)

=0

0.0

LIF:

SP

VP

FP

G

LIF

sonst

Φ(0) = 50%

Friedrich Leisch, Induktive Statistik 2009

12

Beispiel: Sonntagsfrage

Friedrich Leisch, Induktive Statistik 2009

13

Beispiel: Sonntagsfrage

0.4

Die Beantwortung der Frage 3, ob das Gesamtergebnis überraschend

war, ist nicht ganz so einfach:

0.0

0.1

0.2

0.3

• Dürfen wir einfach 95% Konfidenzintervalle für alle Parteien bilden

und das Gesamtergebnis als nicht überraschend“ klassifizieren, wenn

”

alle innerhalb der Konfidenzintervalle liegen?

• Was passiert, wenn 20 Parteien antreten?

• Sollen wir dann einen Ausreißer“ akzeptieren? Oder vielleicht gar

”

2?

• Sind die Ergebnisse der Parteien voneinander unabhängig?

SP

VP

Friedrich Leisch, Induktive Statistik 2009

FP

G

LIF

→ darauf kommen wir später nochmal zurück.

sonst

14

Friedrich Leisch, Induktive Statistik 2009

15

(1 − α) Konfidenzintervall

Symmetrisches KI

Das von den Schätzstatistiken

Gu = gu(X1, . . . , Xn)

≤

Go = go(X1, . . . , Xn)

definierte Intervall [Gu, Go] heißt (1 − α) Konfidenzintervall für θ, falls für

jede vorgegebener Irrtumswahrscheinlichkeit α ∈ [0, 1]

P{Gu ≤ θ ≤ Go} = 1 − α

gilt.

Achtung: Gu und Go sind Statistiken der Stichprobe, und damit

Zufallsvariablen.

Von einem symmetrischen Konfidenzintervall spricht man, falls θ mit

gleicher Wahrscheinlichkeit links oder rechts außerhalb des Intervalles

liegt:

α

P{θ < Gu} = P{θ > Go} =

2

Falls die Verteilung von θ bekannt ist, liefern die Quantile zu den Werten

α/2 und 1 − α/2 die Intervallgrenzen.

Realisiertes Konfidenzintervall:

[gu, go]; gu = gu(x1, . . . , xn), go = go(x1, . . . , xn)

Friedrich Leisch, Induktive Statistik 2009

16

Friedrich Leisch, Induktive Statistik 2009

17

Einseitige KI

KI für Mittelwert

Falls nur eine untere oder obere Schranke für θ von Interesse ist, wird

Go oder Gu auf ∞ gesetzt:

Gegeben sei eine normalverteilte Stichprobe mit bekannter Varianz σ 2.

Dann ist

X̄ − µ

z=

√ ∼ N (0, 1)

σ/ n

P{θ ≤ Go} = P{∞ ≤ θ ≤ Go} = 1 − α

P{Gu ≤ θ} = P{Gu ≤ θ ≤ ∞} = 1 − α

Bei bekannter Verteilung von θ liefern die Quantile zu den Werten 1 − α

bzw. α die Schranken.

standardnormalverteilt, die Schranken des Konfidenzintervalls sind

σ

Gu = X̄ − z1−α/2 √

n

σ

Go = X̄ + z1−α/2 √

n

wobei zα das α-Quantil der N (0, 1) ist.

Friedrich Leisch, Induktive Statistik 2009

18

Friedrich Leisch, Induktive Statistik 2009

19

KI für Mittelwert

KI für Mittelwert

Gegeben sei eine normalverteilte Stichprobe mit unbekannter Varianz σ 2.

Dann ist

X̄ − µ

t=

√ ∼ tn−1

σ̂/ n

t-verteilt mit n−1 Freiheitsgraden, die Schranken des Konfidenzintervalls

sind

σ̂

Gu = X̄ − t1−α/2(n − 1) √

n

σ̂

Go = X̄ + t1−α/2(n − 1) √

n

Gegeben sei eine beliebig verteilte Stichprobe mit bekannter Varianz σ 2.

Dann ist

X̄ − µ

z=

√ ∼ N (0, 1)

σ/ n

approximativ standardnormalverteilt, die Schranken des entsprechenden

approximativen Konfidenzintervalls sind

σ

Gu = X̄ − z1−α/2 √

n

σ

Go = X̄ + z1−α/2 √

n

wobei tα(n − 1) das α-Quantil der t-Verteilung mit n − 1 Freiheitsgraden

ist.

wobei zα das α-Quantil der N (0, 1) ist. Bei unbekannter Varianz

wird diese wieder durch σ̂ 2 ersetzt, das KI sollte dann aber erst

für größere n verwendet werden (und damit in jedem Fall die

Normalverteilungsquantile).

Friedrich Leisch, Induktive Statistik 2009

Friedrich Leisch, Induktive Statistik 2009

20

KI für Varianz

21

KI für Anteilswert

Gegeben sei eine normalverteilte Stichprobe mit unbekannter Varianz σ 2.

Dann ist

n−1 2

q=

σ̂ ∼ χ2

n−1

σ2

χ2-verteilt mit n − 1 Freiheitsgraden, die Schranken des Konfidenzintervalls für die Varianz sind

n

X

i=1

Xi ∼ B(n, π)

q

X̄ − π

π(1 − π)/n

∼ N (0, 1)

Die Schranken des Konfidenzintervalls für π sind

s

n−1 2

Gu =

σ̂

q1−α/2

n−1 2

Go =

σ̂

qα/2

π̂(1 − π̂)

2

n

s

π̂(1 − π̂)

Go = π̂ + z1− α

2

n

Gu = π̂ − z1− α

wobei qα das α-Quantil der χ2-Verteilung mit n − 1 Freiheitsgraden ist.

Friedrich Leisch, Induktive Statistik 2009

Gegeben sein eine dichotome Stichprobe mit den Ausprägungen 0 und

1 und P(X = 1) = π. Dann ist

22

Friedrich Leisch, Induktive Statistik 2009

23

Breite von Konfidenzintervallen

Beispiel Konfidenzintervall für µ:

σ

Gu = X̄ − z1−α/2 √

n

σ

Go = X̄ + z1−α/2 √

n

Breite b:

Überprüfung von Verteilungsannahmen

σ

b = 2 · z1− α √

2

n

• 1 − α größer (kleiner) ⇒ z1− α größer (kleiner)

2

⇒ KI breiter (schmaler)

• n größer (kleiner) ⇒ KI schmaler (breiter)

• n → nc ⇒ Breite verändert sich um Faktor

√

c

Friedrich Leisch, Induktive Statistik 2009

24

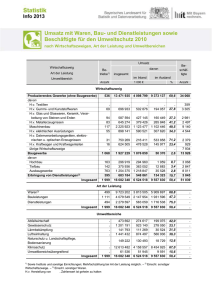

Beispiel GBÖ: Ausgaben

Beispiel GBÖ: Ausgaben

Histogram of KOPFAUSG

1200

50000

40000

30000

800

60

ALTER1

Friedrich Leisch, Induktive Statistik 2009

80

0

20

40

60

80

100

20000

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

0

0

ALTER2

●

●

●

10000

400

40

0

200

200

0

100

0

20

●

●

600

Frequency

600

400

Frequency

Median & IQR

Mean & StdDev

1000

800

500

400

300

Frequency

200

60000

Histogram of ALTER2

1000

Histogram of ALTER1

10000

20000

30000

40000

50000

60000

KOPFAUSG

26

Friedrich Leisch, Induktive Statistik 2009

27

Beispiel GBÖ: log2(Ausgaben)

Beispiel GBÖ: Welche Verteilung?

14

500

400

12

300

13

• Optisch nach Histogramm scheinbar recht gut, aber was ist gut?

200

Frequency

• Wie gut passen eine Normalverteilung zum Alter bzw. eine LogNormalverteilung zu den Augaben?

●

●

●

●

●

●

●

15

600

16

Histogram of log2(KOPFAUSG)

0

10

100

11

• Stichprobe extrem groß, daher sollte es hier eigentlich sehr leicht

sein.

10

11

12

13

14

15

●

●

●

●

●

●

●

●

16

log2(KOPFAUSG)

Friedrich Leisch, Induktive Statistik 2009

28

Empirische Dichte und Verteilung

Friedrich Leisch, Induktive Statistik 2009

29

Empirische Dichte und Verteilung

Friedrich Leisch, Induktive Statistik 2009

30

1.0

0.8

0.0

0.2

0.4

Fn(x)

0.6

0.8

Density

0.4

0.6

0.2

0.0

F (x) = P{X ≤ x}

{#i : xi ≤ x}

günstige

F̂n(x) =

=

n

mögliche

ist unverzerrter Schätzer für die unbekannte wahre Verteilung

• Echte Dichteschätzung sehr komplexes Thema, es gibt Bücher die

sich ausschließlich mit diesem Problem befassen, naive Schätzer wie

Histogramm sind meist nicht glatt genug (in Abhängigkeit von Breite

der Klassen).

ecdf(x)

1.0

Histogram, N=100

• Als einfache Visualisierung der Wahrscheinlichkeiten einer diskreten

Verteilung bzw. Dichte einer stetigen Verteilung verwenden wir

Balkendiagramme und Histogramme.

• Verteilung F und empirische Verteilung F̂n:

−1.0

−0.5

0.0

0.5

1.0

−1.0

−0.5

0.0

0.5

1.0

x

→ Verteilungsschätzer viel glatter“ (für echten Dichteschätzer muß

”

Histogramm geglättet werden).

Friedrich Leisch, Induktive Statistik 2009

31

Empirische Dichte und Verteilung

Empirische Dichte und Verteilung

Vergleich Gleichverteilung mit Normalverteilung:

Wenn Verteilungsschätzer viel einfacher sind, warum beschäftigt man

sich dann überhaupt mit dem Problem der Dichteschätzung?

0.8

0.2

0.0

0.0

• Nützlich zum Vergleich von Verteilungen.

0.6

emp.vt(z)

Fn(x)

0.2

0.4

Warum machen Verteilungsschätzer dennoch Sinn?

0.4

0.6

0.8

• Dichte ist für Menschen viel intuitiver zu lesen.

1.0

Normal P−P Plot

1.0

ecdf(x)

−1.0

−0.5

0.0

0.5

1.0

0.0

0.2

x

32

1.0

Quantile

Eine duale Sichtweise: statt der Verteilungsfunktion F (x) verwenden wir

die Quantilsfunktion F −1(α) → QQ (Quantil-Quantil) Diagramme.

1.0

●

Sample Quantiles

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●●

●●

●●●

●●●

●●

●●●●

●

● ●●

−2

−1

0

●●●

●

●●●

●●

●●●

0.5

0.5

●●●

●●●

●

●

●

●

●

●

●

●●

●●●

●

●●●●

●●●●

●

●●

●●

●●

●●●●

●●

●

●

●●

●●

●

●

0.0

1.0

●● ●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

0.0

−1.0

lebt“ für alle Verteilungen auf dem Intervall [0, 1].

”

Uniform Q−Q Plot

●

●●

●●●●●●

●

−0.5

Vorteile:

Normal Q−Q Plot

Sample Quantiles

Verwendung sowohl zum Vergleich zweier Stichproben als auch zum Vergleich einer Stichprobe mit den theoretischen Quantilen einer Verteilung.

Ersetzt die antiquierte Methode der Wahrscheinlichkeitspapiere“.

”

• F −1

0.8

33

●●●●

●●●

●●●

●●●●

●●

●●

●●

●●●

●●

●

●

●

●●●

●●●

●●

●●

●

●●●

●●

●●●●

−0.5

Quantile

0.6

Friedrich Leisch, Induktive Statistik 2009

−1.0

Friedrich Leisch, Induktive Statistik 2009

0.4

pnorm(z, sd = sd(x))

1

2

Theoretical Quantiles

●●●

●

●

0.0

0.2

0.4

0.6

0.8

1.0

Theoretical Quantiles

• Für mehrere Familien von Verteilungen, inkl. Gleichverteilung und

Normalverteilung gilt, daß QQ Diagramme gerade Linien ergeben,

auch wenn man falsche Parameter wählt.

Friedrich Leisch, Induktive Statistik 2009

34

Friedrich Leisch, Induktive Statistik 2009

35

Quantile

QQ-Plot: ALTER1 und ALTER2

Vergleich der QQ Diagramme einer N(0,1) mit einer N(3,0.25):

4

2

0

Sample Quantiles

−6

−4

−2

2

0

−2

−6

−4

Sample Quantiles

4

6

Normal Q−Q Plot

6

Normal Q−Q Plot

−4

−2

0

2

4

Theoretical Quantiles

−4

−2

0

2

4

Theoretical Quantiles

Gerade wird durch 1. und 3. Quartil der Stichprobe gelegt. Achsenabschnitt entspricht Mittelwert, Steigung der Standardabweichung.

Friedrich Leisch, Induktive Statistik 2009

36

QQ-Plot: KOPFAUSG

Friedrich Leisch, Induktive Statistik 2009

38

Ab ca. 30 Jahren greift die Normalapproximation recht gut.

Friedrich Leisch, Induktive Statistik 2009

37