Das Klima in 100 Jahren?

Werbung

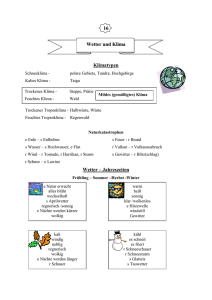

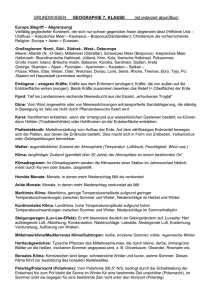

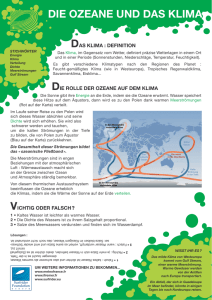

Nicht zur Verwendung in Intranet- und Internet-Angeboten sowie elektronischen Verteilern. M E T H O D E N K L I M A S I M U L AT I O N Das Klima in 100 Jahren? Trotz der Fortschritte auf den Supercomputern sind die heutigen Modelle immer noch weit da- © 2009 Carl Hanser Verlag, München www.cad-cam.de von entfernt, das Weltklima so detailliert zu simulieren, wie es die Wissenschaft wünscht. CAD CAM zeigt, wie die Simulationsmodelle entstehen, mit welcher Genauigkeit gerechnet wird und wo ihre Grenzen liegen. WISSEN, WAS KOMMT. Glaubt man dem 4. Sachstandsbericht des Intergovernmental Panel on Climate Change (IPCC) von 2007, wird sich bis 2100 die Durchschnittstemperatur auf unserem Globus um 2,5 bis 4,1 °C erhöhen. Der Meeresspiegel soll um 40 bis 50 cm steigen. Wie aber können die Wissenschaftler so überzeugt davon sein, dass ihre Berechnungen zutreffen? Schließlich ist schon die Wettervorhersage für die übernächste Woche allzu oft eher mit einem Blick in eine Kristallkugel zu vergleichen. 20 CAD CAM 3-4/2009 Ulrich Feldhaus, freier Autor An dieser Stelle sollte man zuerst die Unterschiede zwischen Wetter und Klima klären. Der Klimaforscher Larry Gates hat es salopp formuliert: »Klima ist das, was man erwartet. Wetter ist das, was man bekommt.« Mit ›Wetter‹ werden die kurzfristigen und lokalen Geschehnisse in der Atmosphäre bezeichnet. Das ›Klima‹ hingegen meint längere Zeiträume und ist wesentlich unempfindlicher gegenüber chaotischen Effekten wie etwa dem ›Schmetterlingseffekt‹, die eine langfristige Wetterprognose ver- hindern. Ein Gewitter beispielsweise beeinflusst das lokale Wetter nachhaltig, für das Klima begnügt man sich mit der Aussage, ob Parameter wie Temperatur oder Luftfeuchtigkeit für eine erhöhte Gewitterneigung sprechen. Atmosphäre als Kern eines Klimamodells Eine intensive Klimaforschung begann mit dem Aufkommen von Computern in den 1950er-Jahren. Das ist kein Zufall, denn das Klima lässt sich zwar prinzipiell mit physi- © 2009 Carl Hanser Verlag, München www.cad-cam.de Nicht zur Verwendung in Intranet- und Internet-Angeboten sowie elektronischen Verteilern. K L I M A S I M U L AT I O N kalischen Gesetzen wie den Newton`schen Bewegungsgleichungen, dem ersten Hauptsatz der Thermodynamik oder der Kontinuitätsgleichung beschreiben, die Einflussfaktoren und Abhängigkeiten sind jedoch zu komplex, als dass man sie ohne Hilfsmittel beherrschen könnte. Computer ermöglichten es erstmals, Klimamodelle zu entwerfen, in denen das Klimasystem mit physikalisch-mathematischen Gleichungen beschrieben und numerisch gelöst werden kann. Anfangs beschränkte man sich darauf, Vorgänge in der Atmosphäre in Computeralgorithmen zu erfassen. Das lag einerseits an der damals noch begrenzten Rechenleistung, andererseits bestanden auf wissenschaftlicher Seite noch Verständnis- und Wissensdefizite bei Kernprozessen wie Wolkenbildung, der Berechnung der Ozeanzirkulation oder bei Daten über das aktuelle Weltklima. Da sich in ihr das Wetter abspielt, ist auch heute die Atmosphäre der Kern eines jeden Klimamodells. Dank der kontinuierlich steigenden Rechenleistung werden die Modelle immer detaillierter. In den 1970er-Jahren gelang es den Forschern erstmals, eine überzeugende Berechnung vorzustellen, in der prognostiziert wurde, dass sich bei METHODEN Klimamodelle werden immer komplexer. Thermodynamische Prozesse, die Atmosphärenchemie sowie der CO2-Kreislauf wollen berücksichtigt werden. einer CO2-Verdopplung die Durchschnittstemperatur um einige Grade erhöhen würde. In den heute genutzten Globalen Atmosphären-Ozean-ZirkulationsModellen (AOGCMs) werden die Einzelsysteme für Atmosphäre und Ozean physikalisch abgebildet und miteinander gekoppelt. Die Atmosphäre wird durch die Basisvariablen Wind, Feuchte und Temperatur modelliert, der Ozean durch die Strömung, den Salzgehalt und die Temperatur. Die Kopplung erfolgt © 2009 Carl Hanser Verlag, München www.cad-cam.de Nicht zur Verwendung in Intranet- und Internet-Angeboten sowie elektronischen Verteilern. M E T H O D E N K L I M A S I M U L AT I O N über Niederschlag, Verdunstung, Windschub und die Wärmestrahlungsbilanz. Weitere Klimateilsysteme wie Boden (Pedosphäre), Erdkruste (Lithosphäre), Eis und Schnee (Kryosphäre) sowie Pflanzen und Tieren (Biosphäre) lassen sich in pauschalierter Form einbinden. Viele Modelle berücksichtigen neben den thermodynamischen Prozessen die Atmosphärenchemie sowie den CO2-Kreislauf. Um Aussagen darüber zu treffen, wie sich beispielsweise die Abholzung von Wäldern auf die globale Klimaentwicklung auswirkt, muss man die biogeochemischen und biopyhsikalischen Prozesse in die Form eines dynamischen Vegetationsmodells bringen. Grundsätzlich sind Klimamodelle mit den Berechnungsmodellen etwa für FEM- oder CFD-Analysen vergleichbar. Hierbei wird ein Kontinuum in diskrete Elemente zerlegt, für welche die entsprechenden Gleichungssysteme gelöst und die Ergebnisse an die benachbarten Zellen übergeben werden. Die Gesamtheit dieser Berechnungen ergibt das Klima mit seiner charakteristischen Verteilung der häufigsten, mittleren und extremen Wetterzustände sowie Witterungsvorgänge zu einem bestimmten Zeitpunkt. Heute geht die horizontale Auflösung bei Atmosphärenmodellen bis auf zirka 120 km (1,4°) herunter, die vertikalen Schichtdicken bewegen sich zwischen 1 und 30 km. Die Ozeanmodelle gehen für ihre Berechnungen von einer horizontalen Kantenlänge von 125 km und einer Schichtdicke von 200 m bis 5 km Tiefe aus. Entsprechende Modellgrößen liegen bei 4 Millionen Basisvariablen für das Dynamikmodell der Atmosphäre. Rund 30 Minuten beträgt die zeitliche Auflösung für die Atmosphäre; für den Ozean ist diese halb so groß. In der Regel tauschen die Modelle einmal pro simuliertem Tag ihre Daten aus. Das ECHAM5/MPIOM-Atmosphärenmodell des Hamburger Max-Planck-Instituts für Meteoro22 CAD CAM 3-4/2009 Beobachtete (a) und simulierte (b) jährliche durchschnittliche Niederschlagsmenge (mm), basierend auf dem Durchschnittswert aus mehreren Modellen. logie, das an den Simulationen für den IPCC-Bericht beteiligt war, verfügt über eine Gitterweite von etwa 200 km in der Horizontalen sowie über 31 vertikale Schichten und insgesamt über 500 000 Gitterpunkte. Bei derart großen Simulationsmodellen und den simulierten Zeiträumen bedarf es einer enormen Rechnerleistung. Kalkuliert man die Rechenzeit für Simulationen in der Technik in Minuten, Stunden oder Tagen, so sind bei der Klimasimulation Monate eine gängige Größe. Noch vor wenigen Jahren war der japanische Earth Simulator mit 40 Teraflops/s maßgebend und stand auf der höchsten Position der Top 500 der Supercomputer. Allein für den deutschen Beitrag zur IPCCStudie wurden 5 000 Jahre simuliert, wofür auf dem NEX SX-6 des Deutschen Klimarechenzentrums zirka 400 000 CPU-Stunden nötig waren, also ein Viertel der gesamten Jahreskapazität. Ab dem Frühjahr diesen Jahres wird man in Hamburg allerdings erheblich flotter rechnen können. Dann nämlich geht ein 60-mal schnelleres IBM-Power6-System mit einer Spitzenleistung von über 140 Teraflops/s (140 Billionen Rechenoperationen/s) in Betrieb. Damit gehört der Rechner zu den weltweit größten Supercomputern für wissenschaftliche Zwecke. Parametrisierungsschemata Trotz der inzwischen üblichen relativ hohen Auflösung gibt es genügend physikalische Vorgänge, die sozusagen ›durch das Gitter‹ fallen. So lassen sich Wolkenbildung, Niederschläge, Strömungswirbel oder die kurz- und langwelligen Strahlungsprozesse nicht direkt darstellen. Da diese Phänomene für die Temperaturentwicklung von zentraler Bedeutung sind, müssen sie aber berücksichtigt werden. © 2009 Carl Hanser Verlag, München www.cad-cam.de Nicht zur Verwendung in Intranet- und Internet-Angeboten sowie elektronischen Verteilern. K L I M A S I M U L AT I O N Bei der Parametrisierung leitet man deshalb diese Prozesse aus den an den Rändern der Gitterzelle bekannten Werten über bekannte meteorologische Gesetzmäßigkeiten ab. Zum Beispiel ist es wichtig abzuschätzen, wie viel Staubpartikel (Aerosole) in einem Element vorhanden sind, da dies eine wesentliche Bedingung für die Bildung von Regentropfen ist. Es gibt eine ganze Reihe solcher Parametrisierungsschemata – einige sind durch Beobachtungen und Messungen abgesichert, andere enthalten Unsicherheiten, wurden aber trotzdem erfolgreich mathematisiert. Die Parametrisierung gehört zu den Hauptaufgaben derjenigen Wissenschaftler, die versuchen, kleine Wasserwirbel, die Wirkung von Staubpartikeln auf die Wolkenentstehung oder die Turbulenz, die durch Baumwipfel ausgelöst wird, in mathematische Gleichungen umzusetzen. Voraussetzung dafür ist, dass sich diese kleinskaligen Prozesse hinreichend genau in den grobskaligen Variablen des Klimamodells darstellen lassen (›Closure Assumption‹). Um einigermaßen sicherzustellen, dass Klimamodelle verlässlich arbeiten, prüfen die Forscher, wie gut sie die Vergangenheit und Jetztzeit wiedergeben. Dazu werden die simulierten Daten mit klimatologischen Messwerten verglichen. Einigermaßen verlässliche meteorologische und ozeanografische Aufzeichnungen gibt es allerdings erst seit 150 Jahren. Auch sind diese nicht weltumspannend verfügbar. Häufig müssen sich die Wissenschaftler ihre Daten auf indirektem Weg beschaffen, etwa indem sie die Wachstumsringe bei Bäumen oder Eisproben untersuchen. Über Zwischenmodelle werden die unvollständigen Daten korrigiert und interpoliert, bis sie die Modellnetze vollständig ausfüllen. Man füttert das System mit Werten aus der vorindustriellen Vergangenheit und lässt es rechnen, bis sich ein stabiles Gleichgewicht einstellt. Bis zu 500 Simulationsjahre kann dieser Prozess in Anspruch nehmen. Anschließend werden klimahistorische Ereignisse wie Vulkanausbrüche, Schwankungen in der Sonnenaktivität oder die Emission von Treibhausgasen (CO2, Methan, Aerosole) als Antrieb eingespeist. Um möglichst verlässliche Startbedingungen zu finden, rechnet man das Modell mit vielen unterschiedlichen Randbedingungen durch. Je mehr Simulationen durchgeführt werden, desto verlässlicher werden die Aussagen über die Wahrscheinlichkeitsverteilung der Ergebnisse. IPCC-Prozess und vierter Sachstandsbericht 1988 wurde unter Federführung der UN das IPCC mit dem Ziel gegründet, die menschlichen Einflüsse auf das Klima zu untersuchen und politischen Entscheidungsträgern wissenschaftliche Grundlagen zu schaffen. Gruppen von führenden Wissenschaftlern unterschiedlicher Nationen verfassen regelmäßig Berichte über den Stand der Klimaforschung und über den Rückgang der Treibhausgasemissionen. CAD CAM 3-4/2009 23 METHODEN D e m A R 4 z u f o l g e k ö n n e n n a t ü r l i c h e Ur sachen für die globale Erwärmung in der zweiten Hälfte des 20. Jahrhunderts mit e i n e r Wa h r s c h e i n l i c h k e i t v o n r u n d 95 Prozent ausgeschlossen werden. Vielmehr zeichnen anthropogene Einflüsse w i e CO 2 u n d A e r o s o l e f ü r d i e d r a m a t i sche Entwicklung verantwortlich. Für den 4. Sachstandsbericht (AR4) wurde die Zutreffenswahrscheinlichkeit der Kernaussagen ermittelt. Für die Simulationen arbeiteten insgesamt 23 AOGCMs aus 18 Instituten. Aus Deutschland waren das Max-Planck-Institut für Meteorologie in Hamburg und das meteorologische Institut der Universität Bonn an den Untersuchungen beteiligt. Dem AR4 zufolge können natürliche Ursachen für die globale Erwärmung in der zweiten Hälfte des 20. Jahrhunderts mit einer Wahrscheinlichkeit von rund 95 Prozent ausgeschlossen werden. Vielmehr zeichnen anthropogene Einflüsse wie CO2 und Aerosole für diese Entwicklung verantwortlich. Dies wurde in 58 Simulationen an 14 unterschiedlichen Modellen ermittelt. Plausibel machten die Ergebnisse unter anderem, dass die historischen Daten gut nachgebildet waren und die Simulation von bekannten Klimaveränderungen eine hohe Genauigkeit erzielte, wie etwa das El-NiñoVorhersagesystem, das eine 80-prozentige Übereinstimmung mit den Messdaten erreicht. 40 Szenarien der Zukunft Wie sich das Klima über die nächsten 100 Jahre verändert, hängt entscheidend von der Bevölkerungsentwicklung und dem Wirtschaftswachstum ab. Insgesamt wurden dazu vierzig Szenarien aufgestellt, die auf unterschiedlichen Annahmen über die demografische, © 2009 Carl Hanser Verlag, München www.cad-cam.de Nicht zur Verwendung in Intranet- und Internet-Angeboten sowie elektronischen Verteilern. M E T H O D E N K L I M A S I M U L AT I O N Voraussichtliche Änderung der Oberflächentemperatur im frühen (Mitte) und späten (rechts) 21. Jahrhundert, bezogen auf die Periode von 1980 bis 1999 für die Szenarien B1 (oben), A1B (Mitte) und A2 (unten). Links befinden sich die entsprechenden relativen Wahrscheinlichkeiten unterschiedlicher Studien. wirtschaftliche und energiepolitische Entwicklung basieren. Zu den wichtigsten Szenarien zählen: ■ A1: starkes wirtschaftliches Wachstum, rasante Einführung neuer Technologien, Bevölkerungsentwicklung erreicht 2050 ihr Maximum. Je nach Energienutzung werden unterschieden: ■ A1F: intensive Nutzung der fossilen Brennstoffe, ■ A1T: intensive Nutzung der nichtfossilen Energieträger und ■ A1B: eine Mischung von beiden; ■ B1: Informations- und Dienstleistungsgesellschaft, in der intelligente Techniken und nachhaltige Prinzipien genutzt werden; soziales Gleichgewicht und globale Gerechtigkeit, keine besonderen Maßnahmen zum Klimaschutz; ■ A2: heterogenes Bevölkerungswachstum und wirtschaftliche Entwicklung bei einem langsamen weltweiten Fortschritt; ■ B2: wie A2, aber explizite Maßnahmen zum Klimaschutz. Man muss bedenken, dass die Betrachtung der durchschnittlichen Temperaturerhöhung die Situation verharmlost. So wird beispielsweise für das Szenario A1B ei24 CAD CAM 3-4/2009 ne durchschnittliche Erhöhung um 2,8 °C ermittelt, während für die Antarktis ein Anstieg um 6 °C errechnet wird. Detaillierte Studien regionaler Effekte prognostizieren zudem, dass Südeuropa austrocknen und sich der Schnee in den Alpen zurückbilden wird. Im Falle von B1 dürfte die geringste Erwärmung vonstatten gehen. Von A1B ist weniger Erfreuliches zu erwarten. In der schlechtesten Variante nutzt die Menschheit weiterhin fossile Brennstoffe. Demnach ist es dringend notwendig, nichtfossile Energieträger und Einsparpotenziale zu nutzen sowie in eine integrierte intelligente Energieerzeugung und -nutzung zu intensivieren. Insgesamt zeigt die Studie, dass für alle Szenarien mit vermehrtem Niederschlag, stärkeren Niederschlagsextremen, erhöhter Temperatur und ausgeprägteren Temperaturschwankungen, einer höheren Anzahl von Stürmen, einem Anstieg des Meeresspiegels sowie dem Rückgang des Meereises zu rechnen ist. Je komplexer das Rechenmodell, umso schwieriger wird es, die Abläufe bis ins letzte Detail zu verste- hen beziehungsweise warum sich das Modell so und nicht anders verhält. Auch hat man längst noch nicht alle für die Klimabildung relevanten Prozesse verstanden und berücksichtigt. Die Wissenschaftler träumen seit Anbeginn der Klimasimulation von einem allumfassenden Weltmodell. Erreichen wird man es aber wohl nie, selbst wenn wir alle Prozesse verstanden haben. Grenzen setzen etwa die Bandbreite der Größenordnungen, aber auch die Datenmengen, die erzeugt und interpretiert werden wollen. Dass die Klimasimulation trotz aller noch offenen Fragen und trotz der relativ groben Modellierung ein seriöses Vorhersagewerkzeug ist, dürften inzwischen nur noch notorische Skeptiker bezweifeln. JRü @ www.ipcc.ch Diesen Artikel finden Sie auf der Hompage www.cad-cam.de unter der Dokumentennummer CC110018.