Forum der Forschung 18-2005.qxd - WWW-Docs for TU

Werbung

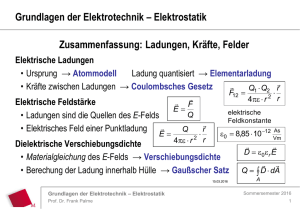

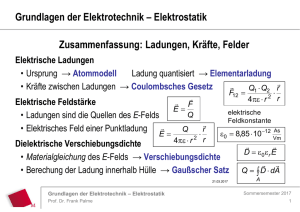

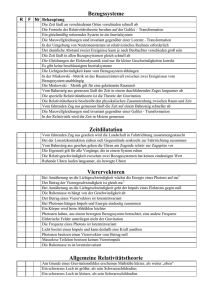

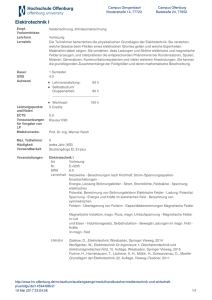

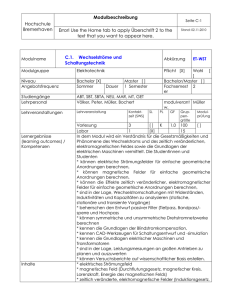

Forum der Forschung 18/2005: 19-30 BTU Cottbus, Eigenverlag, ISSN-Nr.: 0947 - 6989 Theoretische Elektrotechnik – gestern – heute – morgen Arnim Nethe, Hanns-Dietrich Stahlmann Lehrstuhl Theoretische Elektrotechnik und Prozessmodelle 1 Einleitung von Elektromagnetismus und Optik.1 Unsere Alltagswelt ist voll von Geräten, in denen man sich diese Gesetze zunutze macht.2 Theoretische Elektrotechnik, wie ist sie als eigenständiges Fachgebiet der Elektrotechnik entstanden, was ist sie eigentlich aus heutiger Sicht und was wird aus der Theoretischen Elektrotechnik in Zukunft? Diese Fragen sollen hier nicht im Detail beantwortet werden; wir wollen die Fakten für sich selbst sprechen lassen und so zu weiteren Gedanken in diese Richtung anregen. Die Fundamente der Theoretischen Elektrotechnik und damit der gesamten Elektrotechnik liegen im 18. und 19. Jahrhundert mit Wissenschaftlern wie Maxwell und Hertz. Doch auch Einstein, Planck und Dirac haben wesentliche Anteile an ihrer Fortentwicklung. Aber welche sind es und welche Konsequenzen ergeben sich hieraus? Es wird sich im weiteren Verlauf dieser Abhandlung zeigen, wie sich die Theoretische Elektrotechnik fortentwickelt hat, eine Entwicklung, auf die andere aufbaut bzw. sich ergänzt und trotzdem noch nicht abgeschlossen ist und wohl nie sein wird. 1 Heinrich Hertz gelang dann der experimentelle Nachweis der durch die Maxwellschen Gleichungen vorausgesagten elektromagnetischen Wellen3 und legte so den Grundstein für die gesamte Nachrichtentechnik. 3 Nachdem Lorentz das Gesetz für die Kraft auf eine im elektrischen Feld bewegte elektrische Ladung gefunden hatte,4 versuchte man die Maxwellschen Gleichungen dahingehend zu erweitern. Der wohl bekannteste Versuch für bewegte Medien,5 auf dem Boden der klassischen Theorie der Galilei-Transformation, stammt von H. Hertz. Klarheit und Ordnung in die sehr widerspruchsvolle und verwickelte Situation brachte schließlich Einstein (1905) durch die geniale Arbeit „Zur Elektrodynamik bewegter Körper“, die im Wesentlichen die Grundlagen der Speziellen Relativitätstheorie enthält.6 Introduction Theoretical electrotechnology, how it developed as an independent specialist field of electro-technology, what it actually is from today's point of view and what becomes of theoretical electrotechnology in the future? These questions are not to be answered here in the detail; we want to let the facts speak for themselves and thus encourage further thoughts in this direction. The foundations of theoretical electrotechnology, and thus of the whole electrotechnology, date back to the 18th and 19th centuries with scientists such as Maxwell and Hertz. But also Einstein, Planck and Dirac made essential contributions to its further development, but what are they and which consequences result from that. It will be shown in the further progress of this paper how theoretical electrotechnology has developed, how one development builds on another and supplements itself and is still not complete and will probably never be. 2 Von Maxwell über Einstein zur Speziellen Relativitätstheorie Es ist nun eine sehr eindrucksvolle Leistung der Relativitätstheorie, dass sie, wie zuerst Minkowski gezeigt hat, allein aus der Forderung der Invarianz der Feldgleichungen gegenüber Lorentz-Transformationen, diese für bewegte Körper anzuschreiben gestattet, sobald sie für den Fall der Ruhe bekannt sind, und zwar ohne irgendeine atomistische Zusatzhypothese.7 Damit gelten die vier Maxwellschen Gleichungen auch für bewegte Bezugssysteme, die drei Materialgleichungen aber nicht,8 d. h. die Maxwellschen Gleichungen sind Lorentzinvariant, die Materialgleichungen aber nicht. Die Maxwellschen Gleichungen sind nur ein inhaltloses Schema, solange nicht diese Verknüpfungsgleichungen, die den Zusammenhang zwischen den mit der Materie mitbewegten Größen und dem ruhenden System angeben, hinzugefügt werden.9 Um die Materialgleichungen in einem bewegten Bezugssystem zu bekommen, muss man auf die Felder eine Lorentztransformation anwenden.10 Einzeln ist weder die elektrische noch die magnetische Feldstärke (auch in den Maxwellschen Gleichungen) invariant gegen die LorentzTransformation, der ganze antimetrische vierdimensionale Tensor hingegen hat eine invariante Bedeutung;11 dies liegt daran, dass die Spezielle Relativitätstheorie aus der skalaren Optik auskristallisiert ist.12 Von Maxwell über Hertz zu den Grundlagen der Nachrichtentechnik Maxwell vereinheitlichte die Theorie der Erklärung der elektrischen Phänomene mit der Theorie des Magnetismus und formulierte so in seinen berühmten Gleichungen die Theorie des Elektromagnetismus, bei denen er den Verschiebungsstrom als zwingende Existenznotwendigkeit einführte, und damit gelang ihm auch die Vereinigung Hier sei noch bemerkt, dass die Maxwellschen Gleichungen in der Idealen Magnetohydrodynamik Galileiinvariant sind.13 Daher machen 19 Theoretische Elektrotechnik – gestern – heute – morgen Arnim Nethe, Hanns-Dietrich Stahlmann Lehrstuhl Theoretische Elektrotechnik und Prozessmodelle Koordinatentransformationen kein Problem. Verwendet man dagegen die exakten Maxwellschen Gleichungen, so hat man bei der nichtrelativistischen Theorie immer die Schwierigkeit, dass die mechanischen Gleichungen Galileiinvariant sind, während die Maxwellschen Gleichungen Lorentzinvariant sind.14 Die Gleichungen der idealen Magnetohydrodynamik haben viele wichtige Anwendungen in der Astro- und Plasmaphysik.15 An dieser Stelle noch ein Wort zu den beiden verschiedenen Darstellungen der Maxwellschen Gleichungen und ihren formalen Schreibweisen: ● ● ● Die differentielle Form (Differentialgleichungen) nimmt auf eine lokale (punktförmige) Betrachtungsweise Bezug. Dennoch liefert die differentielle Form für die theoretische Durchdringung tiefere Einsichten und für die Lösung praktischer Probleme durch die Lösung von Differentialgleichungen oft viele Vorteile. Die integrale Form der elektromagnetischen Grundgesetze wird besonders in der Elektrotechnik, z. B. bei der Bewegung von Spulen in Magnetfeldern, Dynamomaschine oder Elektromotor mit großem Nutzen angewendet.16 Die Maxwellsche Theorie des elektromagnetischen Feldes besitzt wichtige Bezüge zu unterschiedlichen Gebieten der Mathematik. Damit liegen sie in verschiedenen mathematischen Sprachen vor: in der Sprache der Differentialform, der Tensoranalysis, der Vektoranalysis, der Integrale, der symmetrischen hyperbolischen Systeme, der modernen Differentialgeometrie, der Eichfeldtheorien.17 Häufig wird nun gefragt: Was ist eigentlich der Unterschied zwischen der Theoretischen Elektrotechnik und der Allgemeinen Elektrotechnik? Es ist ein prinzipieller Unterschied: Die Theoretische Elektrotechnik beschäftigt sich vorwiegend mit verteilten Parametern, also mit Feldern, während sich die Allgemeine Elektrotechnik vorwiegend mit konzentrierten Parametern, also mit Bauelementen, befasst. Die meisten Bauelemente der Elektrotechnik können über den Poyntingschen Leistungsvektor mit Hilfe des komplexen Widerstandes abgeleitet werden, dies gilt auch für Elemente der Ersatzschaltbilder z. B. für elektrische Maschinen. Dass dies unbedingt nötig ist, liegt an der enormen Komplexität der Feldberechnungen, welche daher nur lokal vorgenommen werden können, man denke hier nur an die integrierten Schaltungen (IC) mit ihren Millionen von Einheiten, während die Netzwerktheorie der Elektrotechnik fast beliebige Komplexitäten zulässt. 3.1 gelegentlich vorkommende Behauptung, die Spezielle Relativitätstheorie sei nur bei Bewegungen ohne Beschleunigung (so genannten Trägheitsbewegungen) anzuwenden, trifft nicht zu.20 Die Spezielle Relativitätstheorie kann das Verhalten beschleunigter Objekte voraussagen, sofern man sich bei der Formulierung der physikalischen Gesetze auf ein Inertialsystem bezieht.21 Nicht-Inertialsysteme sind also erlaubt, in ihnen haben die Gesetze aber nicht mehr die gewohnte Form. So verwendet man ja auch in der klassischen Mechanik rotierende Bezugssysteme (etwa für die Kreiselbewegung), obwohl die Grundgesetze (die Newtonschen Axiome) nur im Inertialsystem gelten. Setzt man etwa in das zweite Newtonsche Axiom eine Transformation in ein rotierendes Bezugssystem ein, so erhält die Bewegungsgleichung zusätzliche Terme (Zentrifugal- und Corioliskraft). Das gilt selbstverständlich auch für die vierdimensionalen Maxwellschen Gleichungen22 in der Minkowskiwelt.23 Viele Lehrbücher24 bezeichnen sowohl die Invarianzeigenschaften von relativistischen Gleichungen als auch das Transformationsverhalten kovarianter Vektoren mit „kovariant“.25 Kovarianz einer Gleichung heißt dabei, dass sich ihre Form unter einer Lorentz-Transformation nicht ändert (forminvariant).26 Man beachte, die kovariante Form der MaxwellGleichungen verdeckt die Tatsache, dass die Gleichungen der Quellen des elektromagnetischen Feldes keine Zeitableitungen enthalten und daher Bedingungen für die Anfangswerte der Felder sind. Sie sind durch die restlichen beiden „Zeitentwicklungsgleichungen“ propagiert, d. h. sie gelten immer, wenn sie zu einer Zeit gelten.27 Die beschleunigte relativistische Bewegung soll an drei Beispielen verdeutlicht werden: ● Das erste Beispiel ist das berühmte Zwillingsparadoxon. Ein Weltraumfahrer, der eine Reise von der Erde mit einer der Lichtgeschwindigkeit vergleichbaren Geschwindigkeit unternommen hat, stellt bei seiner Rückkehr zur Erde fest, dass er wegen der Zeitdilatation weniger gealtert ist als sein auf der Erde verbliebener Zwillingsbruder – wer reist, bleibt jung. Bei unbedachter Anwendung des Relativitätsprinzips entsteht daraus leicht eine scheinbar paradoxe Situation. Wegen der Relativität der Standpunkte könnte jeder Zwilling den anderen als den Reisenden betrachten. Danach sollte jeder den anderen bei der Rückkehr weniger gealtert antreffen – offenbar ein Widerspruch. Diese Art der Schlussfolgerung beruht darauf, dass die Voraussetzungen der Speziellen Relativitätstheorie nicht beachtet werden. Die betrachteten Bezugssysteme sind nicht äquivalent im Sinne des Relativitätsprinzips. Der zu Hause gebliebene Zwilling befindet sich dauernd in einem Inertialsystem. Wegen der notwendigen Beschleunigungsperioden befindet sich der Raumfahrer jedoch (mindestens zeitweise) nicht in einem Inertialsystem. Mit Inertialsystemen zu beliebig (beschleunigten) Bezugssystemen Bevor wir zur Elektrodynamik in der Quantentheorie kommen, wollen wir noch einmal auf die oben erwähnte Spezielle Relativitätstheorie und damit verbundene Inertialsysteme zu sprechen kommen. Übrigens vereinigt die Spezielle Relativitätstheorie die Mechanik mit dem Elektromagnetismus.18 Zur Lösung wird angenommen, dass man entlang der Weltlinie des Raumfahrers eine gegenüber Beschleunigungen unempfindliche Uhr (ideale Uhr) benutzt. Die Gangrate einer solchen beschleunigt bewegten idealen Uhr stimmt in jedem Zeitpunkt mit der Gangrate überein, die diese Uhr bei gleichförmiger Bewegung (also in einem Inertialsystem) mit derselben Geschwindigkeit hätte. Dann gilt Der Grund für das Attribut „spezielle“ und die damit verbundene Einschränkung ist häufig missverstanden worden. Die Einschränkung besagt einfach, dass die Spezielle Relativitätstheorie nur in solchen Fällen gilt, in denen man von Gravitationseffekten19 absehen kann. Die 20 Theoretische Elektrotechnik – gestern – heute – morgen Arnim Nethe, Hanns-Dietrich Stahlmann Lehrstuhl Theoretische Elektrotechnik und Prozessmodelle in jedem Zeitpunkt die Zeitdilatation, die aus der Lorentz-Transformation folgt. – Das Vorgehen ist analog zum bekannten geometrischen Rektifizierungsverfahren, bei dem man die Länge einer Kurve durch die Summe der sie approximierenden Strecken definiert. Die Konstruktion einer idealen Uhr ist im Prinzip möglich, denn Beschleunigungen haben hier absolute Bedeutung. Man kann also die Uhr mit einem Beschleunigungsmesser versehen und die Uhr gemäß der festgestellten Beschleunigung nachregulieren. Im Gegensatz dazu kann der geschwindigkeitsabhängige Effekt der Zeitdilatation nicht eliminiert werden. Eine natürliche ideale Uhr sind in guter Näherung die Myonen wegen der auch bei starken äußeren Kräften unveränderlichen Zerfallszeiten.28 ● ● Das zweite Beispiel bezieht sich auf die Feldtheorie einer beliebig, also auch mit relativistischen Geschwindigkeiten, bewegten Punktladung. Auch dieses Beispiel kann in einem Inertialsystem berechnet werden und zwar mit Hilfe des Lienard-Wiechert-Potentials29, welches eine Lösung der Maxwell-Gleichungen für beliebig bewegte Punktladungen darstellt. Es ist eine relativistische Verallgemeinerung des Coulomb-Potentials der Elektrostatik – der Elektrostatik, damit hätten Sie nicht gerechnet. Man soll eben niemals die „ach so einfachen“ Grundlagen unterschätzen. Beim dritten Beispiel stellen wir nach kurzer Überlegung fest, dass der Magnetismus in Wirklichkeit ein relativistischer Effekt ist. Dazu betrachten wir den Fall, wo zwei Ladungen sich parallel zueinander bewegen, hier müssen wir mit relativistischen Korrekturen an der Bewegung in der Größenordnung im Quadrat des Verhältnisses der Teilchen- zur Lichtgeschwindigkeit rechnen. Diese Korrekturen müssen der magnetischen Kraft entsprechen. Was ist aber zu der Kraft zu sagen die zwischen zwei Leitern wirkt? Da ist die magnetische Kraft die einzige Kraft, es sieht nicht nach einer „relativistischen Korrektur“ aus. Wenn wir außerdem die Geschwindigkeiten der Elektronen im Draht schätzen, stellen wir fest, dass die Durchschnittsgeschwindigkeit entlang des Drahtes ungefähr 0.1 mm pro Sekunde beträgt. Die relativistische Korrektur beträgt also ungefähr 10-25. Gewiss eine unbedeutende „Korrektur“. Aber nein! Obwohl die magnetische Kraft in diesem Fall das 10-25-fache der elektrischen Kraft zwischen den bewegten Elektronen ist, müssen wir bedenken, dass die elektrischen Kräfte aufgrund des nahezu vollkommenen Gleichgewichts verschwunden sind – weil die Leiter dieselbe Anzahl von Protonen wie Elektronen haben. Das Gleichgewicht ist sehr viel genauer als 10-25, und der kleine relativistische Faktor, den wir die magnetische Kraft nennen, ist der einzige, der übrig bleibt. Und damit wird er der wichtigste Betrag. Da die elektrischen Effekte sich in so idealer Weise aufheben, war es möglich, relativistische Auswirkungen (nämlich den Magnetismus) zu untersuchen und die richtigen Gleichungen bis zur Größenordnung des relativistischen Faktors aufzustellen, obwohl die Physiker nicht wussten, dass genau das geschah. Und aus diesem Grund mussten auch, als die Relativität entdeckt wurde, die elektromagnetischen Gesetze nicht abgeändert werden. Im Gegensatz zu den Gesetzen der Mechanik waren sie schon bis zur Größenordnung des relativistischen Faktors genau.30 Andererseits ist bei den Anwendungen der Speziellen Relativitätstheorie – wie schon oben erwähnt – darauf zu achten, dass die mit Hilfe des metrischen Tensors im Minkowski-Raum, also mit dem konstanten Minkowskitensors gewonnenen Aussagen, nur in nicht beschleunigten Bezugssystemen gelten, d. h. auf Inertialsysteme beschränkt sind. Diese mit der pseudo-euklidischen Metrik verbundene Beschränkung auf Inertialsysteme wird oft übersehen. In einem beschleunigten Bezugssystem sind Trägheitskräfte (nichtpermanente Gravitationskräfte) vorhanden. Solche Bezugssysteme sind daher zu den Inertialsystemen nicht äquivalent. Der entsprechende metrische Tensor hat nicht mehr die einfache konstante Form, sondern hängt von den Koordinaten selbst ab. Das Linienelement wird dann durch krummlinige Koordinaten ausgedrückt. Das Einsetzen der Koordinatentransformation in das Wegelement ändert nicht die Bedeutung des Wegelementes, sondern nur dessen Ausdruck.31 Im Falle des echten (permanenten) Gravitationsfeldes kann die Raum-Zeit Mannigfaltigkeit nicht mehr der Minkowski-Raum sein.32 3.2 Vom beliebigen Bezugssystem über lokale Inertialsysteme zur Allgemeinen Relativitätstheorie Was ist denn nun eigentlich das Besondere an einem beliebig beschleunigten Bezugssystem und warum beschäftigen wir uns in der Theoretischen Elektrotechnik bzw. Feldtheorie damit – was hat das alles mit unserer Alltagswelt zu tun und welche gesellschaftlichen Auswirkungen ergeben sich? Die erste Frage werden wir gleich beantworten, die Antwort auf die zweite Frage folgt dann automatisch. Die Verallgemeinerung des beliebig beschleunigten Bezugssystems führt zur Allgemeinen Relativitätstheorie (ART); in der Speziellen Relativitätstheorie werden physikalische Prozesse typischerweise von inertialen, d. h. ruhenden oder mit konstanter Geschwindigkeit bewegten Beobachtern beschrieben. Nach den Prinzipien der Speziellen Relativitätstheorie ist kein Inertialsystem ausgezeichnet, jedes physikalische Experiment verläuft in jedem Inertialsystem genau gleich. Im Gegensatz dazu haben beschleunigte oder rotierende Bezugssysteme durch das Auftreten von Trägheitskräften eine absolute Bedeutung in der Speziellen Relativitätstheorie. Die Allgemeine Relativitätstheorie resultierte aus dem erfolgreichen Versuch Einsteins, diese spezielle Rolle der Inertialsysteme aus der Relativitätstheorie zu eliminieren und allgemeine, beliebig beschleunigte und rotierende Bezugssysteme gleichwertig zu erlauben. Trägheitskräfte die in einem nicht inertialen Bezugssystem wirken, sind lokal aber nicht von Gravitationskräften zu unterscheiden. Das ist in komprimierter Form der Grund dafür, dass die Allgemeine Relativitätstheorie eine Theorie der gravitativen Wechselwirkungen darstellt. Ein Schlüssel zur Allgemeinen Relativitätstheorie ist daher die Beschreibung von Trägheitskräften in der Speziellen Relativitätstheorie. Durch Transformation der Bewegungsgleichung eines kräftefreien Teilchens in einem Inertialsystem in ein Nicht-Inertialsystem werden die Komponenten der neuen Terme der Christoffel-Konnexion mit den auftretenden Trägheitskräften sowie die Komponenten der Metrik mit dem entsprechenden Trägheitspotential identifiziert. Die lokale 21 Theoretische Elektrotechnik – gestern – heute – morgen Arnim Nethe, Hanns-Dietrich Stahlmann Lehrstuhl Theoretische Elektrotechnik und Prozessmodelle Gleichsetzung von Gravitationskräften mit Trägheitskräften durch das Äquivalenzprinzip führt unmittelbar zu den folgenden Grundideen der Allgemeinen Relativitätstheorie: Gravitationspotentiale bzw. -kräfte werden mit der Metrik bzw. mit der Christoffel-Konnexion identifiziert. Lokal ergibt sich die (flache) Geometrie der Speziellen Relativitätstheorie: die Tangentialräume (lokale Inertialsysteme) an jedem Punkt der Raumzeitmannigfaltigkeit sind Minkowski-Räume. In endlichen Gebieten kann die Gravitation allerdings nicht durch Transformation auf ein frei fallendes Bezugssystem „wegtransformiert“ werden. Dies bedeutet mathematisch, dass die Christoffel-Konnexion in Anwesenheit von Gravitationsfeldern im Allgemeinen nicht integrabel ist. Somit verschwindet der entsprechende Riemannsche Krümmungstensor – im Unterschied zur Speziellen Relativitätstheorie – nicht mehr: die speziell-relativistische Minkowski-Geometrie wird in der Allgemeinen Relativitätstheorie von einer Riemannschen Geometrie der Raumzeit abgelöst. Die Feldgleichungen der Allgemeinen Relativitätstheorie bestimmen die Geometrie der Raumzeit in Abhängigkeit von der Verteilung der Materie, d. h. wie die Raumzeit bei einer bestimmten Energie- und Masseverteilung gekrümmt ist. Dabei wird die Raumzeitgeometrie durch die Metrik bzw. durch den entsprechenden Riemannschen Krümmungstensor und Materie durch den Energie-Impuls-Tensor beschrieben. So trägt auch elektromagnetische Energie zur Krümmung der Raumzeit bei. Um die Feldgleichungen zu finden, orientierte sich Einstein am Prinzip der allgemeinen Kovarianz: die Formulierung physikalischer Gesetze muss unabhängig vom verwendeten – inertialen oder nichtinertialen – Bezugssystem sein. Für die mathematische Beschreibung folgt daraus, dass die Gesetze der Physik tensoriell formuliert werden müssen. Die Feldgleichungen sind darüber hinaus einem Korrespondenzprinzip unterworfen, damit in zwei wichtigen Grenzfällen der Beobachtung Rechnung getragen wird. Erstens muss im Limes verschwindender Gravitation die Spezielle Relativitätstheorie als Grenzfall enthalten sein, und zweitens muss für nichtrelativistische Geschwindigkeiten und schwache Gravitationsfelder die Newtonsche Gravitationstheorie resultieren. Insbesondere muss also die Poissongleichung für das Newtonsche Gravitationspotential im genannten Limes aus den Feldgleichungen folgen. Die Gravitationspotentiale der Allgemeinen Relativitätstheorie sind aber die Komponenten der Metrik, daher suchte Einstein nach Differentialgleichungen zweiter Ordnung für diese Komponenten. Die im November 1915 von Einstein vorgeschlagenen, praktisch gleichzeitig auch von Hilbert gefunden Feldgleichungen, sind die berühmten Einstein-Gleichungen. Aus den Einstein-Gleichungen folgt durch Anwendung der kontrahierten Bianchi-Identitäten die lokale Energie-Impuls-Erhaltung. Einstein erkannte, dass sich daraus die Bewegungsgleichung der Allgemeinen Relativitätstheorie, die geodätische Gleichung, ableiten lässt, wobei die Christoffel-Konnexion im Unterschied zur speziell-relativistischen Gleichung in der allgemeinen Theorie zu einem Riemann-Tensor gehört. Die Bewegungsgleichung muss also nicht zusätzlich postuliert werden, sondern ist, wie auch schon in der Elektrodynamik, in den Feldgleichungen enthalten. Damit ist ein wichtiger Kreis geschlossen: durch die Einstein-Gleichung „sagt“ die Materie im Universum der RaumzeitGeometrie wie sie sich krümmen soll. Gleichzeitig „sagt“ die Raumzeit- Geometrie der Materie wie sie sich bewegen soll: auf den durch die geodätische Gleichung festgelegten Geodäten. Hier zeigt sich die Umsetzung des Machschen Prinzips in der Allgemeinen Relativitätstheorie.33 Das Machsche Prinzip ist die Hypothese, dass die Trägheitskräfte durch die Gesamtheit der im Universum vorhandenen Materie verursacht werden.34 Zum Schluss der Überlegungen zur ersten Frage ergibt sich folgende Übersicht: 1. Das Äquivalenzprinzip ist die lokale Gleichsetzung von Gravitationskräften mit Trägheitskräften. 2. Mit Hilfe des Äquivalenzprinzips konnte Einstein den Einfluss der Gravitation auf physikalische Phänomene ermitteln, denn hiernach brauchte man nur das betreffende Phänomen von einem beschleunigten Bezugssystem aus betrachten. Er erhielt so bereits aus der Speziellen Relativitätstheorie 1907 das Ergebnis, dass Uhren in starken Gravitationsfeldern langsamer gehen als in der Umgebung von schwächeren Gravitationsfeldern.35 3. Die Frequenzänderung elektromagnetischer Wellen unter dem Einfluss eines Gravitationsfeldes beruht auf dem Zusammenhang zwischen Eigenzeit und Zeitkoordinate und der daraus resultierenden Zeitdilatation im Gravitationsfeld.36 4. Für reale Gravitationsfelder gibt es keine globale Transformation, die das allgemeine Wegelement auf die Minkowskiform bringt. Umgekehrt gilt, dass der Raum eben ist, wenn es eine solche Transformation gibt.37 5. Das Bezugssystem des beschleunigten Koordinatensystems könnte auch ein rotierendes Bezugssystem sein. Dann würden die Komponenten der Metrik außer Gravitationskräften auch Zentrifugal- und Corioliskräfte beschreiben. Solche Kräfte sind hier äquivalent.38 6. Lokale Inertialsysteme (Satellitenlabor) existieren nur in einem Punkt, da nur dort die Zentrifugalkraft und die Gravitationskraft sich exakt aufheben, in unmittelbarer Umgebung existiert die Mikrogravitation. Auch können zwei Inertialsyteme zweier Satteliten auf unterschiedlichen Bahnen nicht ineinander überführt werden – es gibt dafür keine Lorentz-Transformation.39 Im lokalen Inertialsystem gelten die bekannten Gesetze der Speziellen Relativitätstheorie ohne Gravitation.40 7. Das Kovarianzprinzip bedeutet, man formuliert die physikalischen Gesetze, die nichts mit der Gravitation zu tun haben, in ihrer speziell-relativistischen Form und ersetzt anschließend die partiellen Ableitungen durch die kovarianten Ableitungen.41 Angewandt auf die speziell-relativistischen Maxwellgleichungen ergibt deren kovariante Verallgemeinerung, also die Maxwellgleichungen im Gravitationsfeld (oder krummlinigen Koordinaten).42 8. Das Gravitationsfeld geht über die Christoffel-Konnexion in die kovarianten Ableitungen der Maxwellgleichungen ein.43 9. Das magnetische Feld geht auch in die Einsteinschen Feldgleichungen ein, weil es als Energieform Quelle des Gravitationsfeldes ist.44 Daher stellen die kovariante Verallgemeinerung der Maxwellgleichungen45 und die Einsteinschen Feldgleichungen im Prinzip ein gekoppeltes System für die elektromagnetischen Potentialfelder und die Komponenten der Metrik dar – in der Gravitationstheorie repräsentiert die Metrik selbst eine dynamische Variable.46 Der Bei- 22 Theoretische Elektrotechnik – gestern – heute – morgen Arnim Nethe, Hanns-Dietrich Stahlmann Lehrstuhl Theoretische Elektrotechnik und Prozessmodelle trag des elektromagnetischen Feldes zur Energiedichte kann aber meist gegenüber vorhandenen Massen vernachlässigt werden. Dann sind die Komponenten der Metrik in den Maxwellgleichungen vorgegebene äußere Felder,47 d. h. die Metrik des Raumes ist dabei unabhängig von den dynamischen Variablen fest vorgegeben.48 10. Die Komponenten der Metrik hängen vom Gravitationsfeld und den gewählten Koordinaten ab. Daher stellen die kovariante Verallgemeinerung der Maxwellgleichungen auch die richtigen Gleichungen für krummlinige Koordinaten dar, zum Beispiel für Kugelkoordinaten im euklidschen Raum (also ohne Gravitationsfeld). Das gelegentlich mühevolle Umschreiben von Vektorgleichungen auf spezielle nichtkartesische Koordinaten ist in dieser Form der Maxwellgleichungen allgemein und kompakt gelöst.49 11. Das Äquivalenzprinzip ist die lokale Gleichsetzung von Gravitationskräften mit Trägheitskräften. Ist dann eine lokale Unterscheidung zwischen permanenten und nichtpermanenten Gravitationsfeldern überhaupt möglich? Erstaunlicherweise gibt es ein geometrisches, d. h. koordinatenunabhängiges Kriterium, nämlich über den Riemannschen Krümmungstensor:50 In einem Ereignis liegt ein permanentes Gravitationsfeld vor, wenn der Krümmungsvektor in diesem Ereignis nicht verschwindet.51 12. Eine Besonderheit sei hier noch angemerkt, dass geladene Teilchen in einem inhomogenen Schwerefeld anders fallen als ungeladene. Dieses folgt aus der Lorentz-Dirac-Gleichung der Algemeinen Relativitätstheorie.52 Unsere zweite Frage lautete: Was hat das alles mit unser Alltagswelt zu tun und welche gesellschaftlichen Auswirkungen ergeben sich? Unsere heutige Welt ist ohne Satelliten nicht mehr vorstellbar. Satelliten bewegen sich aber immer in einem Gravitationsfeld. Als Beispiel betrachten wir eine Uhr, die auf der Erdoberfläche ruht, und eine gleichartige Uhr in einem die Erde umkreisenden Satelliten. Im Vergleich zur Erduhr geht die Uhr im Satelliten schneller (S), weil das Gravitationsfeld dort schwächer ist, und langsamer (L), weil die Geschwindigkeit des Satelliten größer ist. Moderne Satelliten-Ortungssysteme (GPS, Galileo) müssen beide Effekte berücksichtigen! Zur Berechnung des Gesamteffekts betrachtet man etwa ein Inertialsystem, in dem die Bahngeschwindigkeit der Erde um die Sonne momentan (praktisch heißt das in guter Nährung für einige Wochen) verschwindet. In diesem Inertialsystem ergibt sich die Geschwindigkeit für die Erduhr aus der Eigendrehung der Erde, und für die Satellitenuhr aus der Umlaufgeschwindigkeit. Für einen erdnahen Satelliten überwiegt der zweite Effekt (L), für einen erdfernen Satelliten dagegen der erste (S). Für die Berechnung braucht man bei der Zeit- bzw. Frequenzverschiebung nur das Äquivalenzprinzip. Die Feldgleichungen der Allgemeinen Relativitätstheorie spielen hierbei keine Rolle.53 Die Feldgleichungen der Allgemeinen Relativitätstheorie finden hauptsächlich in der Forschung und hier besonders in der Kosmologie ihre Anwendung. Das soll aber nicht heißen, dass sie keinen Einfluss auf die Entwicklung der Technik hat, hier sei nur das weite Gebiet der Radioastronomie erwähnt. Zwei Beispiele sollen das verdeutlichen: Die kosmische Hintergrundstrahlung, welche 1963 von Arno A. Penzias und Robert W. Wil- son (Nobelpreis 1978) entdeckt wurden. Sie erkannten, dass das ständige Radiorauschen in den Empfängern einen astrophysikalischen Ursprung hatte. Diese kosmische Hintergrundstrahlung ist das rotverschobene und erkaltete Glimmen des Urknalls aus der Zeit, als das Universum von einem photonendominierten in einen materiedominierten Zustand wechselte. Messungen dieses Hintergrunds bilden heute die Grundlage für die Vermessung der Geometrie des Universums und die Bestimmung seiner fundamentalen Konstanten (Dichte der dunklen Materie, Dunkle Energie, Krümmungsradius, etc.). Das zweite Beispiel sind die von der Allgemeinen Relativitätstheorie vorausgesagten Gravitationswellen: Die Rotation eines Neutronensterns liefert ein ultrapräzises Zeitsignal im Radiobereich. Die darauf folgende Entdeckung eines Doppelpulsars und seiner Periodenänderung führte zum indirekten Nachweis von Gravitationswellen durch die Messung der Orbitaländerung (Phase) des von Hulse und Taylor untersuchten Pulsars als Funktion der Zeit und der vorhergesagten Änderung aufgrund der Abstrahlung von Gravitationswellen im Rahmen der Allgemeinen Relativitätstheorie. Weitere wissenschaftliche und technische Entwicklungen sind auf folgenden Gebieten der Radioastronomie zu erwarten: Erweiterung des Frequenzbereiches bis hin zu 1 THz – noch ein Stück weiter, und der Bereich der Infrarot-Astronomie ist erreicht. Damit ist der größtmöglichste Frequenzbereich nach oben erschlossen; allerdings steckt die Technik der höchsten Frequenzen noch in den Kinderschuhen. Hier liegen zahlreiche Emissionslinien von Molekülen und Atomen, deren Vermessung einen Zugang zur kosmischen Chemie liefern wird. Aber auch die Frequenzen im MHz-Bereich, am unteren Ende de Radiospektrums, liegen seit Jahrzehnten brach. Höhere räumliche Auflösung durch Verbindung von Radioteleskopen auf verschiedenen Kontinenten (interkontinentale Radiointerferometrie oder Very Long Baseine Interferometrie VLBI). Sie liefert die höchste in der Astronomie verfügbare Auflösung – tausendfach so hoch wie das Weltraumteleskop HUBBLE –, die der Auflösung eines virtuellen Einzelteleskops mit dem Durchmesser der Erde entspricht. Die kleinste bisher aufgelöste Struktur hat eine Größe von 18 Mikrobogensekunden am Himmel; dies entspricht dem Winkel, unter dem uns eine auf dem Mond liegende Erdnuss erscheinen würde, und stellt den unangefochtenen Weltrekord dar. Höhere Empfindlichkeit, d. h. die Messung der spektralen Energieflussdichte der elektromagnetischen Strahlung soll in den Nano-Jansky-Bereich vordringen (1Jy = Jansky = 10-26 W m-2 Hz-1). Eine völlig neuartige Erweiterungsmöglichkeit bietet sich der Radioastronomie zurzeit aufgrund einer fast unbegrenzten Flexibilität durch direkte digitale Bearbeitung der Radiowellen. Damit verbunden ist die Möglichkeit, ein Teleskop fast komplett in Software zu realisieren. Hat man nämlich die Radiophotonen, welche die Antennen erreichen – bei einem „Phased Array“ stehen sie und die Empfänger über die ganze Fläche verteilt –, digitalisiert, so kann man ihren Strahlengang (insbesondere ihre relative Verzögerung), so wie er in einer Antennenschüssel verlaufen würde, im Rechner nachbilden und beliebig verändern, bevor man die Photonen in einem digitalen Brennpunkt zusammenführt. Radiophotonen können digitalisiert werden, weil sie aufgrund ihrer Vielzahl den Gesetzen der klassischen Elektrodynamik gehorchen 23 Theoretische Elektrotechnik – gestern – heute – morgen Arnim Nethe, Hanns-Dietrich Stahlmann Lehrstuhl Theoretische Elektrotechnik und Prozessmodelle und Quanteneffekte keine große Rolle spielen. Die einmal digital vorliegenden Wellen können verlustfrei kopiert und reproduziert werden. Damit lassen sich dann zusätzliche virtuelle Antennen nachbilden „Multi-Beaming“. Allein begrenzt durch die Rechnerleistung, kann man so in beliebig viele Richtungen gleichzeitig schauen, seine Blickrichtung in Sekundenbruchteilen exakt ändern (entsprechend dem Schwenken eines herkömmlichen Teleskops), und – falls man Daten eine zeitlang speichert – auch noch ein paar Minuten in die Vergangenheit schauen (retrospective Beamforming genannt) und den Himmel kurz vor einem plötzlich eingetretenen Ereignis studieren. Das Radioteleskop LOFAR (LOw-Frequency-ARray) wird nach dem Prinzip eines Phased Arrays gebaut, es verspricht nicht weniger als eine komplette Revolution der Radioastronomie bei niedrigen Frequenzen. Sein Einsatzbereich wird zwischen 10 MHz und 220 MHz liegen. Ein höchst interessanter Aspekt liegt in der Datenverarbeitung. Tatsächlich steckt bei diesem Teleskop das meiste Geld im Datennetzwerk (bis zu einem Terabit pro Sekunde), in den Computern in der Software. Die eigentlichen Empfänger – Dipole, Verstärker, und A/D-Wandler – enthalten preiswerte Komponenten heutiger Alltagstechnik. Sein wissenschaftliches Anwendungsgebiet geht von der Kosmologie über das Weltraumwetter bis zur Atmosphären- und Ionosphärenüberwachung.54 Zur gesellschaftlichen Auswirkung der Technik, insbesondere der Informationstechnologien, wollen wir John Gray (Professor für European Thought an der London School of Economics und ehemaliger „Cheftheoretiker“ von Premierminsterin Margaret Thatcher) selbst zu Wort kommen lassen: „Die heutige Entwurzelung des gesellschaftlichen und wirtschaftlichen Lebens geht jedoch nicht allein auf den freien Markt zurück. Hinzu kommt nämlich, dass die technologischen Innovationen westlicher Industrieländer überall kopiert werden. Die regulierte Nachkriegswirtschaft hätte in keinem Fall überleben können, selbst wenn es nicht zur neuerlichen Politik des freien Marktes gekommen wäre – die Fortschritte der Technik, die der traditionellen Vollbeschäftigung ein Ende setzten, hätten dafür schon gesorgt. Insbesondere Informationstechnologien bringen Bewegung in die gesellschaftliche Arbeitsteilung. Viele Berufe verschwinden und keine Stelle ist mehr absolut sicher. Nie seit der Industriellen Revolution war die gesellschaftliche Arbeitsteilung so instabil wie heute. Die globalen Märkte übertragen nun diese Instabilität auf sämtliche Volkswirtschaften der Welt und machen damit eine Politik der Unsicherheit zum universellen Phänomen“. Weiter führt er aus: „Für die Menschheit der ausgehenden Moderne hat sich die Globalisierung längst als ein historisches Schicksal erwiesen, deren Motor die unerbittlich voranschreitende immer schneller werdende Technologieentwicklung ist. Die technikbedingte Modernisierung der Weltwirtschaft wird unabhängig vom Schicksal des freien Weltmarktes anhalten. … Eine der wichtigsten sozialen Institutionen ist der berufliche Lebensweg. In traditionellen bürgerlichen Gesellschaften konnten Angehörige der Mittelschicht davon ausgehen, dass sie ihr Arbeitsleben in ein und demselben beruflichen Bereich verbringen. Das ist heute nicht mehr zu erwarten. Die wirtschaftliche Unsicherheit hat nicht nur zu Folge, dass man viele verschiedene Jobs durchläuft, sondern auch, dass die Vorstellung von einer kontinuierlichen beruflichen Laufbahn an sich hinfällig wird. … Ihr ortsgebundenes und bereits angeeignetes Wissen wird für sie (die Menschen) immer nutzloser“ Soweit John Gray.55 Deswegen ist ein fun- diertes zeitloses Basiswissen für die Zukunft so immens wichtig, auf das man flexibel – je nach Jobangebot – aufbauen kann, die so genannte Strategie der flexiblen Spezialisierung.56 4 Von Maxwell über Planck zu den Grundlagen der Quantentheorie Alle Gleichungen der Physik, die Wechselwirkungen in der Natur beschreiben, sind nichtlinear. Eine scheinbare Ausnahme bilden die linearen Maxwellgleichungen. Diese enthalten jedoch nur einen Teil der elektromagnetischen Phänomene. Die vollständige Theorie, die Quantenelektrodynamik, die die Wechselwirkungen zwischen elektromagnetischen Feldern den Photonen und Elementarteilchen den Elektronen und Positronen berücksichtigt, ist tatsächlich nichtlinear. Ferner ist die lineare Schrödingergleichung der Quantenmechanik und Quantenchemie eine Nährung der relativistischen Diracgleichung, die ihre volle Kraft erst durch Ankopplung an das elektromagnetische Feld entfaltet, also durch die nichtlinearen Gleichungen der Quantenelektrodynamik. Damit kommen wir zur Elektrodynamik in der Quantentheorie.57 4.1 Elektrodynamik in der Quantentheorie Seit etwa 1920 ist die Quantenphysik das wichtigste Instrument des physikalischen Fortschritts, und das gilt für nahezu sämtliche Teilbereiche: die Festkörperphysik, die Atomphysik, die statistische Physik, die Kernphysik, die Teilchenphysik, usw. Ihre Entwicklung begann, als die Physiker Anfang des 20. Jahrhunderts entdeckten, dass die gewöhnlichen Gesetze der Physik sich nicht auf die Atome anwenden ließen. So vermochten diese Gesetze weder die Stabilität der Atome noch den Mechanismus zu erklären, über den die Atome Licht emittieren. Es zeigte sich auch, dass die Elektronen, von denen man zunächst annahm, sie umkreisten den Atomkern etwa in derselben Weise wie Planeten die Sonne, keine fest umrissene Bahn besitzen. Sie scheinen über den Raum ausgebreitet zu sein, sofern man nicht gerade ihre Position misst.58 Den Ausgangspunkt für die Entwicklung der Quantenphysik bildete die Elektrodynamik. Alle anfänglichen Überlegungen bezogen sich auf die Problematik der Spektralverteilung der thermischen Strahlung: Angefangen hat dann alles mit der Energiedichte der von einem schwarzen Körper emittierten Strahlung (Hohlraumstrahlung), welche innerhalb der klassischen Physik durch zwei sich widersprechende Gesetze angegeben wurden. Das Rayleigh-Jeanssch Strahlungsgesetz gab die Experimente im Bereich der langwelligen Strahlung wieder. Das Wiensche Gesetz war im Bereich der kurzwelligen Strahlung korrekt. Durch die Einführung einer neuen Konstanten gelang es Max Planck, eine Interpolation zwischen den beiden Gesetzen zu finden. Das Plancksche Strahlungsgesetz überdeckt den gesamten Frequenzbereich und enthält die beiden anderen Strahlungsgesetze in den jeweiligen Grenzfällen.59 Die Einführung dieser Konstanten (Plancksches Wirkungsquantum) war die Geburtsstunde der Quantenphysik. Was Planck nur formal ein- 24 Theoretische Elektrotechnik – gestern – heute – morgen Arnim Nethe, Hanns-Dietrich Stahlmann Lehrstuhl Theoretische Elektrotechnik und Prozessmodelle geführt hatte, konnte dann Einstein 1905 mit seiner Lichtquantenhypothese als Energie (Produkt aus Wirkungsquantum und Frequenz) eines Photons physikalisch interpretieren.60 Vorweg wollen wir zwei besondere Beispiele angeben: ● ● Supraleiter, Materialien die den Strom ohne Widerstand leiten, Supra- oder Superflüssigkeiten: Substanzen, die ohne Reibung strömen. Beide Effekte sind nur mit Hilfe der Quantenphysik zu verstehen. Die Besonderheit ist hier jedoch, dass sich der Quanteneffekt makroskopisch, d. h. als in unseren vertrauten Dimensionen, bemerkbar macht.61 Da vielen nicht bewusst ist, wo Supraleitung heute überall Anwendung findet, wollen wir hier einige Beispiele geben: ● Supraleitende Magnetspulen für Kernspinresonanz, Kernspintomographie, Teilchenbeschleuniger, Kernfusion, Energiespeicher, Motoren und Generatoren, magnetische Separation; supraleitende Permanentmagnete; Supraleitung für die Leistungsübertragung bei Kabel, Transformatoren und Strombegrenzer; supraleitende Resonatoren und Filter für Teilchenbeschleuniger und Kommunikationstechnik (Hochfrequenz); Supraleiter als Detektoren als inkohärente Strahlungs- und Teilchendetektoren: Bolometer und Kalorimeter; als kohärente Strahlungsdetektion und -erzeugung: Mischer, Lokalozillatoren und integrierte Empfänger; Quanteninterferometer als Magnetfeldsensoren: SQUID-Magnetometer; Supraleitung in der Mikroelektronik: Spannungsstandards und Digitalelektronik mit Josephsonkontakten.62 Geforscht wird unter anderem an Quantencomputern und an der Quantenkryptografie, deren Sicherheit nicht allein durch mathematische Verschlüsselungsverfahren, sondern durch die physikalischen Gesetze der Quantenmechanik gewährleistet wird (Prototypen existieren 2004 schon). Wir wollen hier nicht die Quantentheorie ableiten, sondern nur die für uns relevanten, d. h. für das Verständnis der elektromagnetischen Felder notwendigen Ergebnisse betrachten. Allen voran interessieren in der Elektrotechnik die Auswirkungen der elektrischen Ladungen (ruhende sowie bewegte), sie sind die Voraussetzung aller elektromagnetischen Felder. – Woraus kann man sich diese Felder nun aufgebaut vorstellen? Die Träger des elektromagnetischen Feldes sind die Photonen (Lichtquant, Strahlungsquant), d. h. das Photon ist das Quant des elektromagnetischen Feldes, welches sich zugleich wie eine Welle und ein Teilchen verhält. In der relativistischen oder kovarianten Formulierung der Elektrodynamik verschmelzen elektrisches Feld und Magnetfeld zum Feldstärketensor. In der Quantenelektrodynamik (QED) wird das (kontinuierliche) elektrische Feld als makroskopischer Limes des Austausches von diskreten, virtuellen Feldquanten, den Photonen, interpretiert.63 Das Photon bildet eine Familie der Elementarteilchen für sich. Jeder elektromagnetischen Strahlung z. B. in Form von Licht (Lichtquanten), Röntgenstrahlung (Röntgenquanten) oder Gammastrahlung (Gammaquanten), entsprechen Photonen mit entsprechender Energie und dem dazugehörigen Impuls, dessen Richtung mit der Ausbreitungsrichtung der elektromagnetischen Strahlung zusammenfällt. Nach der Speziellen Relativitätstheorie ist die Ruhemasse des Photons Null, da es sich mit Lichtgeschwindigkeit bewegt. Ladungen und magnetisches Moment sind ebenfalls gleich Null. Photonen haben ferner den Spin Eins und genügen daher der Bose-EinsteinStatistik, sie zählen also zu den Bosonen. Die Quantentheoretische Beschreibung des Photons erfolgt durch die Quantenelektrodynamik gemeinsam mit dem Elektron und dem Positron.64 Für die elektromagnetische Wechselwirkung (es gibt noch die Gravitation, die schwache und die starke Wechselwirkung) existiert also eine Theorie, die alle Einzelheiten von Feld, Ladung und Austauschquanten erschöpfend beschreibt, die Quantenelektrodynamik. Die elektromagnetische Wechselwirkung bindet Elektronen und Kerne zu Atomen, Atome zu Molekülen und Moleküle zu Molekülverbänden. Die Gesetze der Quantenelektrodynamik sollten es im Prinzip ermöglichen, alle Phänomene der Chemie und der Biologie zu berechnen.65 Wobei zu bedenken ist, dass bereits beim Wassermolekühl für eine genaue Beschreibung die Schrödinger-Gleichung für zehn Elektronen im Kraftfeld von zwei Protonen (gleich Wasserstoffkern) und einem Sauerstoffkern zu lösen ist. Leider übersteigt das bereits die Kapazitäten unser heutigen Computer.66 Hier sei auf ein interessantes Experiment hingewiesen, bei dem die Coulombkraft ausgenutzt wird: Werden Cluster – schwach gebundene Ansammlungen von einigen Atomen oder Molekülen – mit starken Laserpulsen schlagartig ionisiert, so führt die plötzliche Abstoßung der eng benachbarten gleichnamigen Ladungen wegen der schwachen Kohäsionskräfte zur Coulomb-Explosion. Geschieht dies während einer chemischen Reaktion, so geben die Fragmente Auskunft über Reaktionszwischenprodukte.67 Allgemein kann man sagen, dass die in der Chemie übliche Einteilung in verschiedene Bindungstypen (Hetropolare (Ionenbindung), Homöopolare (kovalente), Van der Waals-Bindung) physikalisch gesehen immer Wechselwirkungen auf elektrostatischer Basis sind, die nur insofern den Anschein unterschiedlicher Bindungsarten haben, als die Elektronenwellenfunktionen unterschiedliche Strukturen aufweisen.68 Die Fähigkeit eines Teilchens zur elektromagnetischen Wechselwirkung, d. h. zur Emission oder Absorption eines Photons, ist durch die elektrische Ladung gegeben. Sie ist beim Elektron die elektrische Elementarladung.69 4.2 Von der elektromagnetischen Ladung zum verallgemeinerten Ladungsbegriff70 Die Ladung ist in der Quantenphysik eine streng additive, skalare Größe; die Ladung eines Systems ist also die Summe der Ladungen aller Teilsysteme. Ladungen sind die Quellen von Feldern, die die fundamentalen Wechselwirkungen vermitteln. Die wichtigste Ladung ist die elektrische Ladung (Quarks und einige der Leptonen), die als positive und negative Ladung vorkommt, welche die Ladung der elektromagne- 25 Theoretische Elektrotechnik – gestern – heute – morgen Arnim Nethe, Hanns-Dietrich Stahlmann Lehrstuhl Theoretische Elektrotechnik und Prozessmodelle tischen Kraft ist, ihre Feldquanten sind die masselosen Photonen. Die Farbladung (Quarks) ist mit den drei Werten rot, grün und blau die Ladung der starken Kraft, ihre Feldquanten sind die masselosen Gluonen, die selbst eine Farbladung tragen und damit, weil sie untereinander koppeln, eine endliche Reichweite haben. Die Flavour-Ladung (Leptonen und Quarks) mit Aroma und Geschmack, welche die Ladung der schwachen Kraft ist, ihre Feldquanten sind die massebehafteten Vektor-Bosonen und die schwere Masse, die die Ladung der Gravitation ist, ihre Feldquanten sind die masselosen Gravitonen (noch hypothetisch). Mit Ausnahme der Masse sind alle Ladungen gequantelt und relativistisch invariant. Die elektromagnetische und die schwache Wechselwirkung wurden zur elektroschwachen Wechselwirkung zusammengefasst. Das Hauptproblem der Vereinheitlichung stellt der große Unterschied in den Massen der Austauschbosonen dar: Das Photon hat die Ruhemasse Null, die Vektorbosonen haben Massen vom Hundertfachen der Protonenmassen. Die Vereinheitlichung gelingt, wenn man am Anfang auch den schwachen Austauschbosonen die Masse Null zuschreibt. Das Photon und die schwachen Bosonen lassen sich durch ein elektroschwaches Austauschboson mit vier Komponenten beschreiben. Der große Unterschied in der Masse ergibt sich erst dadurch, dass die schwachen Bosonen mit dem Higgs-Feldern verschmelzen. Der Nutzen dieser Vereinheitlichung ist groß. Man kann damit das Verhältnis zwischen den Kopplungskonstanten der elektromagnetischen und der schwachen Wechselwirkung und auch die Massen der Vektorbosonen voraussagen. Formal kann auch von einer magnetischen Ladung gesprochen werden, allerdings konnte bisher noch keine magnetische Punktladung, ein sog. magnetischer Monopol, nachgewiesen werden.71 Der eigentliche Ursprung der den Teilchen eigenen Landung ist ungeklärt. Ihre Erhaltung im Verlauf bestimmter Wechselwirkungen folgt aus hochabstrakten (nicht unbedingt geometrischen) Symmetrien, auf denen die betreffenden Theorien basieren. Damit verlagert sich die Frage nach dem Ursprung der Ladungen auf die ebenso ungeklärte Frage nach dem Ursprung der Symmetrien.72 Die Austauschkräfte kann man sich durch eine zwar einfache, aber sicher unzulängliche Vorstellung zugänglich machen. Die maßgebliche Eigenschaft ist eine Ladung im weitesten Sinn (s. oben). Sie befähigt das Teilchen ständig, d. h. in sehr kurzen Abständen, Feldquanten auszusenden. Dieser Prozess kann aber nur „virtuell“ erfolgen, solange kein zweites Teilchen in der Nähe ist. Die Feldquantenenergie kommt dabei „aus dem Nichts“, verletzt also den Energiesatz. Die Physiker glauben an eine solche Verletzung des Energiesatzes nur im Rahmen der Unschärferelation, d. h. innerhalb einer Zeit die proportional dem Quotient aus Planckschen Wirkungsquantums und Energie ist, weil dann innerhalb dieser Zeit das ausgeschickte Feldquant wieder eingefangen werden kann, ehe der Verstoß bemerkt wird. Das „Teilchen spielt ständig Ball“ mit seinen Feldquanten. Man muss natürlich mit derartigen Modellvorstellungen äußerst vorsichtig sein. Sie sind eigentlich von vornherein unzulässig, weil wegen der Unschärferelation nichts über die Vorgänge „an sich“ ausgesagt werden kann. Wenn man sich aber ab und zu an solche grundsätzlichen Vorbehalte erinnert, und mögen sie noch so unqualifiziert wirken, jedenfalls dann, wenn man mit ihrer Hilfe von sonst gänzlich unverständlichen Dingen wenigstens eine Ahnung bekommt. Malen wir das Elementarteilchen-„Ballspiel“ also noch etwas aus. Solange das Teilchen mit sich selbst „Ball spielt“, geschieht nach außen hin nichts. Wir können aber die Reichweite abschätzen, die das Feld der Wechselwirkung hat. Feldquanten mit der Ruhemasse Null wie sie bei der elektromagnetischen Wechselwirkung als Photonen und der Gravitation als Gravitonen auftreten sollen, haben prinzipiell eine unendliche Reichweite. Feldquanten mit endlicher Ruhemasse müssen dagegen nach spätestens einer Zeit, die proportional dem Quotient aus Planckschen Wirkungsquantums und seiner Masse mal dem Quadrat der Lichtgeschwindigkeit ist, wieder eingefangen werden. Da sich das Feldquant höchstens mit Lichtgeschwindigkeit bewegt, folgt daraus seine Reichweite. Von dieser Theorie her ist es gleichgültig, ob das Feldquant, das von einem Teilchen ausgesandt wird, von ihm selbst wieder eingefangen wird oder von einem anderen Teilchen. Der zweite Fall führt jedoch auf eine echte Wechselwirkung, bei der auch ein Impulsaustausch stattfindet und daher eine Kraft auftritt.73 Die Heisenbergsche Unschärferelation (Messprozess in der Quantenmechanik) oder das Heisenbergsche Unbestimmtheitsprinzip wurde von W. Heisenberg 1927 gefunden. Die Gesetzmäßigkeit sagt aus, dass kanonisch konjugierte Größen (wie Ort und Impuls) nicht gleichzeitig und mit beliebiger Genauigkeit gemessen werden können. Mathematisch wird dieser Tatsache Rechnung getragen durch eine Ungleichung bzw. die sog. Vertauschungs- oder Kommutationsrelation. Michael Hall von der Australian National University in Canberra und Marcel Reginatto von der Physikalisch-Technischen Bundesanstalt in Braunschweig haben jetzt gezeigt, dass man die Schrödingergleichung aus einer „exakten Unschärferelation“ herleiten kann. Zur Herleitung ihrer exakten Unschärferelation griffen die beiden Physiker auf ein statistisches Verfahren zurück, welches im Jahr 1925 von dem britischen Mathematiker Ronald Fisher entwickelt worden war. Darüber hinaus machten sie die Annahme, dass sich die Geschwindigkeitsvarianzen zu jedem Zeitpunkt exakt umgekehrt proportional zu den Ortsvarianzen verhalten. Dies ist die einzige Annahme in ihrer Herleitung, die nicht der klassischen Physik entspringt. Der Ansatz soll zu einem besseren Verständnis der Grundenergie von quantenmechanischen Systemen beitragen. „Es gibt in Quantensystemen eine Art von Bewegungsenergie, die aus der Unbestimmtheit resultiert“, so Hall.74 Eine wichtige Folgerung aus der Heisenbergschen Unschärferelation ist, dass physikalische Systeme auch am absoluten Nullpunkt der Temperatur nicht in Ruhe sind und daher eine von Null verschiedene kinetische Energie haben, die sog. Nullpunktsschwingung (Robert Knobel und Andrew Cleland versuchen diese direkt zu messen 2004). Die entsprechenden Schwankungen vereinfachen manche Probleme. So entschärfen die Schwingungen der kinetischen Energie (Nullpunktenergie) die Singularitäten der Coulombpotentiale, so dass das in der klassischen Mechanik so lästige Problem der Zusammenstoßbahnen wegfällt.75 Auch zwischen Energie und Zeit besteht eine Unbestimmtheitsrelation, die z. B. für die natürliche Breite der Spektrallinien verantwortlich ist. In der klassischen Wellenlehre besteht ebenfalls eine der Heisenbergschen analoge „Unschärferelation“. Für Wellenzüge endlicher Länge wird die Ungenauigkeit der Wellenlängenmessung umso größer, je kleiner die Länge ist.76 26 Theoretische Elektrotechnik – gestern – heute – morgen Arnim Nethe, Hanns-Dietrich Stahlmann Lehrstuhl Theoretische Elektrotechnik und Prozessmodelle 5 Von Maxwell über Dirac zur Quantenelektrodynamik Es ist nun wichtig, die mathematische Beschreibung des gesamten elektromagnetischen Feldes zu kennen, das sind die Formeln der Quantenelektrodynamik. Allgemein kann man feststellen, dass ein Paradigmenwechsel in der Theoretischen Physik häufig eine neue mathematische Arena erfordert: Newtons Mechanik und Gravitationstheorie, die Differentialrechnung, Maxwellsche Elektrodynamik partielle Differentialgleichungen und die Analysis; Einsteins Allgemeine Relativitätstheorie benötigt die Differentialgeometrie und die Quantenmechanik Hilberträume und Operatoralgebra.77 Die Grundgleichungen der Quantenelektrodynamik sind die kovarianten Maxwellgleichungen zusammen mit der Diracgleichung für ein relativistisch bewegtes Elektron in allgemeinen Koordinaten (kovariante Ableitung). Die Diracgleichung beschreibt die Bewegung eines relativistischen Elektrons. Das Vektorpotential geht dann in das Viererpotential des elektromagnetischen Feldes über.78 Die Diracgleichung ergibt sich durch Quantisierung der klassischen Energierelation (erste Quantisierung). Das Prinzip der lokalen Eichinvarianz liefert die klassischen Feldgleichungen der Quantenelektrodynamik. Um das zugehörige Quantenfeld zu erhalten, das die Wechselwirkung zwischen Elektronen, Positronen (Antiteilchen zum Elektron) und Photonen (Quanten des elektromagnetischen Feldes) beschreibt, muss man die Feldgleichungen der Quantentheorie einem erneuten Quantisierungsprozess unterwerfen (zweite Quantisierung). Dafür wurde die Methode des Feynmanintegrals (Im Unterschied zur Schrödingergleichung, die eine grobe Statisik darstellt, beschreibt das Feynmanintegral die Feinstruktur von Quantenprozessen) entwickelt, die sich auf alle Feldtheorien universell anwenden lässt und im Wesentlichen von dem Stromterm bestimmt wird. Die analytischen Manipulationen mit dem Feynmanintegal führen zu einer Störungstheorie, für deren Berechnung eine geometrische Sprache entwickelt wurde – die Sprache der Feynmandiagramme. Diese Diagramme erlauben erstens eine direkte physikalische Interpretation und zweitens eine bequeme Berechnung physikalischer Effekte (z. B. Streuprozesse in Teilchenbeschleunigern). Die Berechnung der Feynmangraphen führt in höherer Störungsordnung zu Ausdrücken, die unendlich werden. Die Physiker haben eine raffinierte Methode entwickelt, um derartigen sinnlosen Ausdrücken doch einen Sinn zu geben. Das ist die Methode der Renormierung. In der Quantenelektrodynamik kann man damit in jeder Störungsordnung die Divergenzen beseitigen, d. h. die Quantenelektrodynamik ist „renormierbar“. Im Gegensatz dazu ist die Allgemeine Relativitätstheorie nicht „renormierbar“. In der Sprache der Feynmangraphen bedeutet dies, dass die ursprünglichen Graphen um Zusatzglieder ergänzt werden, die die Konvergenz von gewissen Integralen erzwingen. Es werden nur solche Quantenfeldtheorien akzeptiert die renormierbar sind. Bis zum heutigen Tag fehlt eine mathematisch strenge Quantenfeldtheorie für realistische Situationen. Trotzdem berechnen die Physiker mit ihren vom mathematischen Standpunkt aus sehr zweifelhaften Methoden physikalische Effekte mit größter Präzision (wie auch auf anderen Gebieten der klassischen Feldtheorie, z. B. der Randwertprobleme mit ihren Or- thogonalentwicklungen oder der von uns entwickelten erweiterten Ersatzladungsmethode). Es bleibt die Aufgabe der Mathematiker, diese erstaunliche Tatsache zu begründen, parallel zur mathematischen Begründung der Diracschen Delta-Funktion durch die Distributionentheorie.79 5.1 Das elektrostatische Feld – quantentheoretisch betrachtet Zum Schluss wollen wir nochmals auf das Coulombsche Gesetz zurückkommen und uns fragen, woraus besteht eigentlich (quantentheoretisch) sein elektrostatisches Feld? Für zeitlich veränderliche Felder sind es reale Photonen, die von den sich bewegenden Ladungen ausgesandt werden. Bei nicht bewegter Ladung (Punktladung) sind es virtuelle Photonen, was heißt das nun aber? Das Coulombsche Gesetz gilt in der einfachen Form exakt nur für Punkladungen und für kugelförmige Körper, die homogen geladen sind. Für Ladungen mit beliebiger Gestalt treten Abweichungen auf. Man sollte sich dennoch wundern – und einige Studenten tun das auch – über die Abhängigkeit der Coulombkraft als reziprokes Abstandsquadrat. Dieses spezielle Kraftgesetz hängt damit zusammen, dass die durch die Ladung ausgetauschten Photonen die Ruhemasse Null haben. Sie können dann nach der Heisenbergschen Unschärferelation virtuell mit großer Reichweite erzeugt werden. Die Zeitunschärfe (proportional zur reziproken Energieunschärfe) ist in diesem Fall die Lebensdauer des virtuellen Teilchens mit der Ruhemasse, bzw. der Energieunschärfe (proportional der Masse mal dem Quadrat der Lichtgeschwindigkeit in eV). Das macht die Langreichweitigkeit der Coulombkraft verständlich. Hätte das Photon eine Ruhemasse, dann müsste das Coulombsche Potential vom Yukawa-Typ sein mit der so genannten Comptonwellenlänge, die proportional der reziproken Ruhemasse ist. Die besten heutigen Präzisionsmessungen ergeben eine Photonenmasse kleiner 10-48g oder 5·10-16 eV.80 Die zeitunabhängige Lösung der Klein-Gorden-Gleichung kann also als das statische Potential des Feldes einer Punktladung, dargestellt durch die Austauschteilchen, interpretiert werden.81 Zur Einordnung der Klein-Gorden-Gleichung, der Diracgleichung sowie der d’Alembertschen Wellengleichung in ein formales Gleichungsschema sei angemerkt: ● Die ersten beiden quantenmechanischen Feldgleichungen ergeben sich als Grenzfälle einer allgemeinen Spinorgleichung. Als wichtiger relativistischer Grenzfall der spinlosen, massebehafteten Klein-Gorden-Gleichung ist die d’Alembertsche Wellengleichung zu nennen, wenn Teilchen mit einer verschwindenden Ruhemasse betrachtet werden. Im nichtrelativistischen Grenzfall kann die spinund massebehaftete Dirac-Gleichung in die Pauli-Gleichung überführt werden, welche unter Vernachlässigung, insbesondere der Spin-Teilcheneigenschaft, in die Schrödingergleichung übergeht.82 Im Zusammenhang mit der elektrischen Ladung stoßen wir hier noch auf einen interessanten Effekt: Bekanntlich ist die Dielektrizitätskonstante ein Maß dafür, wie leicht sich die betreffende Substanz polarisieren lässt. Den tatsächlichen Wert der Ladung kann man nur messen, wenn man der Ladung selber sehr nahe kommt, näher als das 27 Theoretische Elektrotechnik – gestern – heute – morgen Arnim Nethe, Hanns-Dietrich Stahlmann Lehrstuhl Theoretische Elektrotechnik und Prozessmodelle nächste Molekühl, so dass keine Abschirmung mehr auftritt, d.h. näher also als der Gleichgewichtsabstand der Moleküle. In der Quantenelektrodynamik führt die Erzeugung und Absorption virtueller Photonen dazu, dass sich das Vakuum wie ein Dielektrikum verhält. Die Ladung emittiert und absorbiert ständig virtuelle Photonen. Gelegentlich entsteht aus einem solchen Photon ein Elektron-Positronen-Paar, das nachfolgend annihiliert. Das virtuelle Elektron und das virtuelle Positron werden von der Ladung angezogen bzw. abgestoßen; so kommt es zur Polarisation des Vakuums und folglich zur teilweisen Abschirmung der Ladung, analog zur Einbettung einer Ladung in ein Dielektrikum. Den vollen Wert der Ladung beobachtet man wieder nur dann, wenn man sich innerhalb der Abschirmung befindet. Die Rolle des Gleichgewichtsabstands übernimmt bei der Vakuumpolarisation die Compton-Wellenlänge des Elektrons (2,43 mal 10-12 m). Selbst im Vakuum erhält man also nur dann den tatsächlichen Wert der Ladung, wenn man ihr näher kommt als diese Wellenlänge. Unser Messwert, den wir als „Ladung des Elektrons“ bezeichnen, ist in Wirklichkeit die voll abgeschirmte effektive Ladung. Die Sommerfeldsche Feinstrukturkonstante, die proportional zum Quadrat der elektrischen Ladung ist, nimmt also bei sehr kleinen Abständen von der Ladung zu, ist also in Wirklichkeit überhaupt nicht konstant.83 Nun ist es nicht so, dass elektrostatische Ladungen in der Praxis keine Rolle spielen, im Gegenteil, seit es gelungen ist, die Oberfläche von Kondensatoren nach den Regeln der fraktalen Geometrie um einen Faktor von mehreren Zehntausend zu steigern, sollen sie Anwendung bei Brennstoffzellen- oder Hybridautos als Pufferspeicher finden. Möglich wurde dies durch winzige Kohlenstoffpartikel mit einer sehr fein strukturierten, dreidimensionalen Oberfläche. Pro Gramm des Materials sind so Oberflächen von etwa 200 Quadratmetern und damit eine extrem hohe Kapazität möglich. Die aus solchen Materialen entwickelten „Supercaps“ wiegen 320 Gramm und können eine Energie von 1,4 Wattstunden speichern. Mit einem 50 Kilogramm schweren Satz aus 160 solchen Hochleistungskondensatoren lassen sich daher die für den Betrieb eines Fahrzeugs erforderlichen 220 Wattstunden erreichen. Vorteil ist eine praktisch unbegrenzte Lebensdauer bei niedrigem Gewicht. Mit herkömmlichen Elektrolyt-Kondensatoren würde dieser Speicher vier Tonnen wiegen. Zweitausendundvier geht in der Schweiz der erste Elektrokleinbus nur mit „Supercaps“ in Betrieb.84 5.2 Alltagsanwendung der Quantenelektrodynamik Die praktische Anwendung ist so vielfältig, dass wir nur zwei Alltagsbereiche anschneiden wollen, nämlich den medizintechnischen der Diagnostik und Therapie sowie die Lichterzeugung durch Licht emittierende Dioden (LED). Die normale Röntgen- und Computer-Tomographie Technik (CT) die mit Röntgenquanten (Photonen) arbeitet, kennt jeder. Bei der Magnetresonanz-Tomographie (MRT) werden auf besonders raffinierte Art Experimente mit Atomkernen gemacht, die im menschlichen Körper vorkommen. Meisten arbeitet man mit den Wasserstoffkernen – einfachen Protonen – und nutzt dabei die Tatsache, dass die Protonen ei- nen Spin haben und sich damit wie magnetische Kreisel verhalten. Diese Kreisel führen in einem starken äußeren Magnetfeld eine Präzessionsbewegung aus. Durch Einstrahlen kurzer Pulse von elektromagnetischen Wellen im Frequenzbereich der Radiowellen erreicht man, dass die Kerne für kurze Zeit selber zum Sender von Radiowellen werden. Die Radiowellen werden gemessen und die Messdaten mit einem Computer ausgewertet. So entstehen Bilder vom Inneren des Menschen.85 Viele Phänomene der magnetischen Kernresonanz lassen sich nur aufgrund quantenmechanischer Modelle erklären. Insbesondere ist eine umfassende Interpretation von Kernresonanzspektren nur mit quantentheoretischen Grundlagen möglich.86 Die planare Sintigraphie der Singel-Photon-Emissions-Computer-Tomography (SPECT) bzw. der Positronen-Emissions-Tomographie (PET) sind Tracer-Methoden, hierbei werden dem Patienten Chemikalien verabreicht, die radioaktiv markiert sind, und zwar beim PET mit einem Positronenstrahler. Nach dem Zerfall des Kernes werden die aus den vom Patienten emittierten Photonen (Vernichtungsstrahlung) zweidimensionale „Bilder“ erzeugt. Dabei vernichten sich Elektronen und Positronen (Antiteilchen des Elektrons) nach den Regeln der Quantenelektrodynamik und senden zwei Gamma-Strahlung aus. Diese laufen wegen der Energie-Impuls-Erhaltung in entgegengesetzter Richtung. Diese wird durch ihren koinzidenten Nachweis festgelegt. Die Messung vieler Koinzidenzen erlaubt rückwärts den Schluss auf den Ort, wo sich die Substanz mit dem Tracer befunden hat. Es lässt sich die zeitliche Wanderung des Tracers im Körper messen. Durch Vergleich mit Prozessmodellen können die physiologischen Parameter, z.B. der Stoffwechsel bestimmt werden.87 Die Photodynamische Diagnostik arbeit im Bereich des sichtbaren Lichtes, die Infrarotdiagnostik im Bereich der Wärmestrahlung und in der Forschung ist die Terahertz-Diagnostik, sie liegt im elektromagnetischen Spektrum zwischen Mikrowellen- und Infrarotstrahlung. Es ist wenig bekannt, dass jeder Körper Terahertzwellen abstrahlt, und bei Bestrahlung mit künstlichen Terahertzwellen lässt sich aus den Reflektionen ebenfalls ein Bild gewinnen.88 Bei der Therapie kommen Röntgenstrahlen (Photonen), Protonen, Neutronen, Schwerionen und noch in der Forschung Antimaterie zum Einsatz. Alle diese Verfahren treiben die Zelle in den Selbstmord durch Zerstörung der DNA. Die Licht emittierende Diode ist eine in Durchlassrichtung gepolte pnDiode, bei der Elektron-Loch-Paare bei ihrer Rekombination Photonen einer bestimmten, vom der exakten Materialzusammensetzung abhängigen Farbe aussenden.89 Wegen ihres hohen Wirkungsgrades, theoretisch nahezu hundert Prozent, eignet sie sich hervorragend für Beleuchtungszwecke. In der Praxis haben die Entwickler eine solche Perfektion zwar noch längst nicht bewerkstelligt. Aber der Wirkungsgrad der besten momentan erhältlichen weißen LEDs liegt immerhin schon zwischen dem Wirkungsgrad von Glühbirnen und Leuchtstoffröhren. Farbige LEDs haben einen wesentlich höheren Wirkungsgrad und werden bereits vielfach angewendet. Zum Beispiel in Ampelanlagen, wo man von 150 W auf 15 W und von einem Jahr auf fünf Jahre Lebensdauer kommt. Der kalifornische Bundesstaat hat damit seine Stromrechnung um mindestens zehn Millionen Dollar gesenkt. 28 Theoretische Elektrotechnik – gestern – heute – morgen Arnim Nethe, Hanns-Dietrich Stahlmann Lehrstuhl Theoretische Elektrotechnik und Prozessmodelle Die neue Lichttechnologie würde also den Energiebedarf drastisch reduzieren. Nach einer Studie des amerikanischen Energieministeriums könnte ein breiter Einsatz weißer LEDs der nächsten Generation den Energiebedarf bis 2025 weltweit um etwa zehn Prozent senken. Das käme einer Einsparung von rund 100 Milliarden Dollar gleich und könnte Ausgaben von ungefähr 50 Milliarden Dollar für den Bau von Kraftwerken überflüssig machen.90 6 Von Maxwell über Einsteins Allgemeine Relativitätstheorie zu den Einstein-Maxwell-Feldgleichungen Bei den Einstein-Maxwellschen-Feldgleichungen (Geometrodynamik) muss man leider sagen, dass es sich nur um eine mathematische Zusammenfassung handelt, d.h. es ist nicht möglich, sie aus einem einheitlichen Wirkprinzip herzuleiten (weder die Rainiche-Gleichung alleine noch mit den Nebenbedingungen).91 In der Sprache der Elementarteilchenphysik würde man sagen, es ist nicht gelungen, die elektromagnetische Wechselwirkung und die Gravitation als Facetten einer einzigen übergeordneten Wechselwirkung zu beschreiben.92 Dieses versuchte Kaluza durch Einführung einer fünften Dimension (geometrisch vierte Dimension, deren Krümmung das elektromagnetische Feld darstellt).93 Trotzdem bilden die Überlegungen von Kaluza und Klein mit einen Ausgangspunkt für die Stringtheorie, welche ihrerseits wieder aus der Eulerschen Beta-Funktion geboren wurde – aber, das ist eine andere Geschichte.94 7 Von der Theoretischen Elektrotechnik über die Prozessmodelle zu den Vereinheitlichungen Wie sie sicherlich bemerkt haben, kommt in der Bezeichnung des Lehrstuhls der Begriff Prozessmodelle vor. Diesen Zusammenhang wollen wir jetzt etwas näher betrachten. Technologie sei doch nichts anderes als Technik, glauben manche – Falsch. Technologie ist mehr als Technik. Technologie ist – siehe Enzyklopedia Britannica – die Anwendung von wissenschaftlichem Wissen für praktische Zwecke. Anders ausgedrückt: Technik ist was für Ingenieure, Technologie geht uns alle an. Technik lehrt uns zum Beispiel, wie ein Verbrennungsmotor funktioniert. Automobil-Technologie hat die Welt verändert. Um den Unterschied zu begreifen, braucht es historische Zusammenhänge. Zunächst mal: Technik ist älter als die Naturwissenschaft. Brücken wurden schon gebaut, ehe die Gesetze der Statik bekannt waren. Erst im 17. Jahrhundert versuchte Francis Bacon, Wissenschaft und Technik zusammenzubringen. Die experimentelle Naturwissenschaft sah er als ein „Mittel, um die Herrschaft des Menschen über die Natur auszudehnen“. Doch Bacons Prinzipien fielen nicht gleich auf fruchtbaren Boden. Lange Zeit arbeiteten die Ingenieure ohne naturwissenschaftliche Grundlagen. Erst im 19. Jahrhundert wuchsen Naturwissenschaft und Technik zu „Technologie“ zusammen. Technologie ist auf Anwendung gerichtet – auf die Gestaltung der menschlichen Welt. Das Internet zum Beispiel ist mehr als das Übertragungsprotokoll, auf dem es beruht. Es schuf Möglichkeiten – eine neue Form der Kommunikation und neue Geschäftsmodelle. Doch Innovation braucht auch den Freiraum reiner von kommerziellen Interessen unbelasteter Wissenschaft, da die Entwicklung von Technologie das tiefe Verständnis der zugrunde liegenden Naturgesetze voraussetzt. Ein Beispiel ist die Fusionsreaktortechnologie, die eigentlich noch gar keine Technologie ist, sondern vorläufig noch ein interdisziplinäres Forschungsprojekt. Bevor man Energie aus einem Fusionsreaktor gewinnen kann, müssten Forscher erst mal herausfinden, ob die Gesetze der Physik den Bau eines entsprechenden Reaktors erlauben.95 Dieses tiefe Verständnis96 der Naturgesetze drückt sich in ihrer mathematischen Beschreibung, also in der Sprache der Formeln aus. Man muss also einen mathematischen Formalismus entwickeln, der alle bekannten (gewünschten) Prinzipien in sich vereinigt. Es entsteht ein Prozessmodell, d. h. die Modellierung eines realen Prozesses in der Sprache der Mathematik. Wobei man unter einem Prozess einen Vorgang versteht, bei dem sich der Wert einer oder mehrere Kenngrößen verändert.97 7.1 Von der physikalisch mathematischen Beschreibung zum allgemeinen Prozessmodell Das allgemeine Prozessmodell eines Systems ist ein Objekt, welches dem Beobachter erlaubt, ihn interessierende Fragen zu dem System mit Hilfe dieses Objektes zu beantworten. Es ist ein Abbild der zeitlichen Aufeinanderfolge von Zuständen und Zustandsübergängen eines Systems. Ein allgemeines Prozessmodell ist ein Mittel zur möglichst vollständigen Beschreibung der erfahrenen (auch durch Experimente) Realität. Ein eingeschränktes Prozessmodell ist ein Modell mit geringem Detaillierungsgrad, das nur innerhalb der Grenzen der Prozessparameter die für einen bestimmten Anwendungszweck wichtigen Eigenschaften hinreichend genau wiedergibt.98 Das beste Beispiel für ein möglich allgemeines Prozessmodell ist heute das Standardmodell der Teilchenphysik: Die Partikel im Standardmodell reichen aus, die Alltagswelt – außer der Gravitation – und fast alle von Teilchenphysikern gesammelten Daten zu beschreiben. Das Standardmodell beschreibt die fundamentalen Teilchen und die Art ihrer Wechselwirkungen. Für ein komplettes Bild müssen wir auch die Regeln kennen, mit denen sich das Ergebnis einer Wechselwirkung berechnen lässt. Nehmen wir als Beispiel das Coulombsche Gesetz über die Kraft zweier Punktladungen. Selbst wenn man alles über die Teilchen und die auf sie wirkenden Kräfte weiß, kann man das Verhalten der Teilchen nur berechnen, wenn man außerdem die Regel, d. h. das Coulombsche Gesetz, kennt. Die moderne Version der Regeln ist die relativistische Quantenfeldtheorie, die in der ersten Hälfte des 20. Jahrhunderts entwickelt wurde. In der zweiten Hälfte des 20. Jahrhunderts entstand das Standardmodell; es gab Auskunft über die Teilchen und Wechselwirkungen – sozusagen die Mitspieler, die nach den Regeln der Quantenfeldtheorie spielen.99 29 Theoretische Elektrotechnik – gestern – heute – morgen Arnim Nethe, Hanns-Dietrich Stahlmann Lehrstuhl Theoretische Elektrotechnik und Prozessmodelle Als größtmögliches allgemeines Prozessmodell ist heute die Vereinheitlichung von Gravitation und Quantentheorie anzusehen. 7.2 Vom allgemeinen zum eingeschränkten Prozessmodell100 Beispiel für ein eingeschränktes Prozessmodell ist die Bewegung eines Elektrons im Coulombfeld eines Kerns. Fügt man noch ein Elektron hinzu, wie etwa im Helium-Atom, so stört die Abstoßung der Elektronen die Lösbarkeit des Problems. Um uns über deren Auswirkung zu orientieren, versuchen wir eine möglichst einfache Annahme (eingeschränktes Prozessmodell). Nachdem das Elektron nicht streng lokalisiert sein kann, stellen wir uns vor, seine Ladung erfüllt homogen eine Kugel. Eine solche Ladungswolke erzeugt ein elektrostatisches Potential. Ist das zweite Elektron ebenfalls eine homogen geladene Kugel, so erfahren die Elektronen eine Abstoßung. Die Gesamtenergie wird damit die kinetische Energie plus Kernenergie plus Elektronenabstoßung. Trotz so einer primitiven Abschätzung kommen die so ermittelten Ergebnisse dem experimentellen Resultat recht nahe.101 Betrachten wir schließlich noch das H2-Molekül und nehmen wir das H-Atom wieder als Kugel an. Überlappen sie sich nicht, dann ist die elektrostatische Energie zweimal derjenigen eines HAtoms, und sie üben keine Kräfte aufeinander aus. Durchdringen sich die Kugeln, so sinkt zunächst die Energie, da sich die Abstoßung der Elektronen vermindert, während die anderen Verhältnisse gleich bleiben. Um zu sehen, wie viel Energie man gewinnen kann, bringen wir die Kugeln zur Überdeckung und setzen die Protonen diametral zueinander vom Zentrum. Die Abstoßung der Elektronen ist wie beim HeAtom, damit ergibt sich die gesamte potentielle Energie. Der entsprechende Protonenabstand stimmt ausgezeichnet mit dem tatsächlichen Abstand überein. Dementsprechend ist die resultierende Bindungsenergie ziemlich nahe an der gemessenen Dissoziationsenergie. Wesentlich ist dabei, dass die Elektronen antiparallele Spins haben, damit durch das Ausschließungsprinzip ihr Lebensraum nicht beschnitten wird. Diese rohen Überlegungen zeigen, dass es bei delikateren Fragen wie Stabilitätsproblemen auf kleinere Differenzen der Energie ankommt.102 fende Theorien, können in allen Bereichen stattfinden, so konnten wir zeigen, dass die Ersatzladungs- und die Ersatzstromtheorie in der Magnetostatik aus der Ampereschen Molekularstromtheorie ableitbar ist.105 Bei vielen Prozessmodellen treten aufgrund starker Vereinfachungen zur Bestimmung von Prozessgrößen singuläre Gleichungssysteme auf, welche mit herkömmlichen Mitteln naturgemäß nicht lösbar sind. Hat man es nun mit einer Klasse von Gleichungssystemen zu tun, die durch Orthogonalentwicklung an den Randgebieten zweier Bereiche mit unterschiedlichen Bedingungen entstehen, führt man Zwischenbereiche endlicher Größe ein und umgeht so dieses Problem. Durch die Anwendung solcher Verfahren werden allerdings größere Gleichungssysteme erzeugt und der Rechenaufwand erheblich erhöht. Ein Ausweg ist das von uns modifizierte Moore-Penrose-Verfahren zur Lösung singulärer Gleichungssysteme am Beispiel des Prozessmodells einer Hohlleiterblende.106 Zurzeit arbeiten wir mit anderen Wissenschaftlern zusammen an einem feldtheoretischen Lösungsansatz für ein Prozessmodell zur Beschreibung der inneren Struktur der Materiefeldquanten und deren Masse. 8 Literatur Zum vertiefenden Nachlesen der teilweise überarbeiteten Zitate finden Sie die detaillierten Literaturstellen im Internet auf den Web-Seiten der BTU-Cottbus unter: http://www.tu-cottbus.de/BTU/BTU-Typo3.7/ Forum_der_Forschung.693.0.html Apl. Prof. Dr.-Ing. habil. Arnim Nethe, Jahrgang 1963, studierte an der TU Berlin Elektrotechnik, nach seiner Promotion kam er an die BTU Cottbus, wo er 1998 im Fach Theoretische Elektrotechnik habilitierte. Er ist designierter Studiengangsleiter für den zukünftigen Studiengang Biomedizinische Gerätetechnik. Die Qualität eines allgemeinen Prozessmodells misst sich daran, inwieweit es in der Lage ist, die Beobachtungsdaten zu komprimieren, das heißt durch eine wesentlich kleinere Menge von theoretischen Voraussetzungen und Deduktionsregeln zu ersetzen, aus denen die Daten rekonstruierbar sind. Unter mehreren Theorien, die dasselbe leisten (auch in Bezug auf Voraussagen), ist stets die einfachste vorzuziehen.103 Prof. Dr.-Ing. habil. Hanns-Dietrich Stahlmann, Jahrgang 1948, studierte an der TU Berlin Elektrotechnik, nach seiner Promotion und Habilitation leitete er die Abteilung Prozessmodelle am IPK Berlin der Fraunhofer Gesellschaft. Seit 1992 leitet er den Lehrstuhl Theoretische Elektrotechnik und Prozessmodelle an der BTU Cottbus. Fazit am Beispiel eigener Arbeiten: Das Sammeln von Daten ohne verbindendes Prozessmodell nutzt gar nichts. Das haben wir selbst erfahren müssen, als wir im Auftrag der Automobilindustrie den Lackiervorgang von Freiformflächen mathematisch erfassen sollten. Tausende von Messdaten haben uns erst dann etwas genutzt, als wir erkannten, dass der zugrunde liegende Prozess durch die Diffusionsgleichung beschrieben wurde.104 Anderseits konnten wir das bis dahin unlösbare räumliche Problem des elektrostatischen Lackierens durch die von uns renommierte Ersatzladungsmethode auf das Blech, d. h. auf eine Freiformfläche mit Feldumgriff, übertragen und so einer Berechnung zugänglich machen. Vereinheitlichungen, d. h. bis dahin getrennt lau- 30