Meine Stochastik Zusammenfassung ()

Werbung

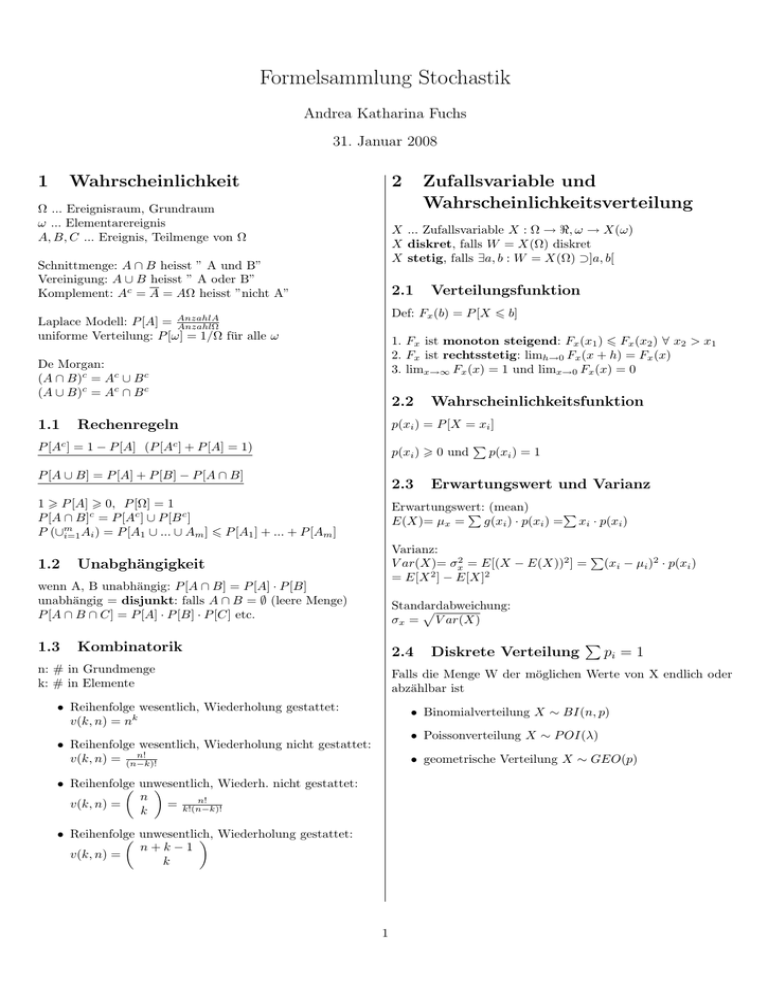

Formelsammlung Stochastik

Andrea Katharina Fuchs

31. Januar 2008

1

2

Wahrscheinlichkeit

Ω ... Ereignisraum, Grundraum

ω ... Elementarereignis

A, B, C ... Ereignis, Teilmenge von Ω

X ... Zufallsvariable X : Ω → <, ω → X(ω)

X diskret, falls W = X(Ω) diskret

X stetig, falls ∃a, b : W = X(Ω) ⊃]a, b[

Schnittmenge: A ∩ B heisst ” A und B”

Vereinigung: A ∪ B heisst ” A oder B”

Komplement: Ac = A = AΩ heisst ”nicht A”

2.1

Verteilungsfunktion

Def: Fx (b) = P [X 6 b]

Laplace Modell: P [A] = AnzahlA

AnzahlΩ

uniforme Verteilung: P [ω] = 1/Ω für alle ω

1. Fx ist monoton steigend: Fx (x1 ) 6 Fx (x2 ) ∀ x2 > x1

2. Fx ist rechtsstetig: limh→0 Fx (x + h) = Fx (x)

3. limx→∞ Fx (x) = 1 und limx→0 Fx (x) = 0

De Morgan:

(A ∩ B)c = Ac ∪ B c

(A ∪ B)c = Ac ∩ B c

1.1

Zufallsvariable und

Wahrscheinlichkeitsverteilung

2.2

Rechenregeln

Wahrscheinlichkeitsfunktion

p(xi ) = P [X = xi ]

P [Ac ] = 1 − P [A] (P [Ac ] + P [A] = 1)

p(xi ) > 0 und

P [A ∪ B] = P [A] + P [B] − P [A ∩ B]

2.3

P

p(xi ) = 1

Erwartungswert und Varianz

1 > P [A] > 0, P [Ω] = 1

P [A ∩ B]c = P [Ac ] ∪ P [B c ]

P (∪m

i=1 Ai ) = P [A1 ∪ ... ∪ Am ] 6 P [A1 ] + ... + P [Am ]

Erwartungswert:

P (mean)

P

E(X)= µx =

g(xi ) · p(xi ) = xi · p(xi )

1.2

Varianz:

P

V ar(X)= σx2 = E[(X − E(X))2 ] = (xi − µi )2 · p(xi )

= E[X 2 ] − E[X]2

Unabghängigkeit

wenn A, B unabhängig: P [A ∩ B] = P [A] · P [B]

unabhängig = disjunkt: falls A ∩ B = ∅ (leere Menge)

P [A ∩ B ∩ C] = P [A] · P [B] · P [C] etc.

1.3

Standardabweichung:

p

σx = V ar(X)

Kombinatorik

2.4

n: # in Grundmenge

k: # in Elemente

Diskrete Verteilung

P

pi = 1

Falls die Menge W der möglichen Werte von X endlich oder

abzählbar ist

• Reihenfolge wesentlich, Wiederholung gestattet:

v(k, n) = nk

• Binomialverteilung X ∼ BI(n, p)

• Poissonverteilung X ∼ P OI(λ)

• Reihenfolge wesentlich, Wiederholung nicht gestattet:

n!

v(k, n) = (n−k)!

• geometrische Verteilung X ∼ GEO(p)

• Reihenfolge

Wiederh. nicht gestattet:

unwesentlich,

n

n!

v(k, n) =

= k!(n−k)!

k

• Reihenfolge

unwesentlich,

Wiederholung gestattet:

n+k−1

v(k, n) =

k

1

3

Stetige W’keitsverteilung

P [X 6 b] = Fx (b) =

Rb

−∞

4

fx (u)du

4.1

Fx ... Verteilungsfunktion von X

fx ... Dichtefuntion von X

V ar(X) =

σx2

• A1 , ..., An sind unabhängig, Unabh.keit der Ereignissse

• P [A1 ] = ... = P [An ] = P [A] gleiche Wahrsch.keiten

R∞

x · f (x)dx

−∞

=

R∞

−∞

• X1 , ..., Xn sind unabhängig

2

• alle Xi haben dieselbe Verteilung

(x − µx ) · f (x)dx

Somit gilt:

P [A ∩ B] = P [A] · P [B]

Fx1 = Fxn → P (x1 6 t) = P (xn 6 t)

E[X1 · X2 ] = E[X1 ] · E[X2 ]

f (x) ist Dichtefunktion, wenn:

1. f (x) > 0

R∞

2. −∞ f (x)dx = 1

3.1

4.2

Quantile q(α)

Summe: Sn = X1 + ... + Xn

Median wenn α = 1/2: q(1/2)

arithmetisches Mittel: X n =

Wichtige stetige Verteilungen

Sn

n

Ausnahmen von Sn mit einfacher Bestimmung:

• uniforme Verteilung X ∼ U N I(a, b)

• Exponentialverteilung X ∼ EXP (α)

Wenn die Zeiten zwischen den Ausfällen eines Systems

Exponential(λ)-verteilt sind, dann ist die Anzahl Ausfälle

in einem Intervall der Länge t Poisson(λ t)-verteilt.

2

• Normalerteilung (Gauss) X ∼ N (µ, σ )

3.2.1

Funktionen von Zufallsvariablen

Y = g(X1 , ...Xn ) und X1 , ...Xn stets i.i.d.

P [X 6 q(α)] = α ⇔ q(α) = F −1 (α)

3.2

Die i.i.d. Annahme

independent and identically distributed

f (b) = F 0 (b) = limh→0 P [x6b6x+h]

h

E[X] = µx =

Mehrere Zufallsvariablen und

Funktionen davon

2. Wenn Xi ∼ P OI(λ), dann ist Sn ∼ P OI(n · λ)

3. Wenn Xi ∼ N (µ, σ 2 ), dann ist Sn ∼ N (n · µ, n · σ 2 )

E[Sn ] = n · E[Xi ]

V ar(Sn√) = n · V ar(Xi )

σSn = n · σXi

Transformation

Y = g(X)

E[X n ] = E[Xi ]

V ar(X n ) = √

V ar(Xi )/n

σXn = σXi / n

limn→∞ V ar(barXn ) = 0

g linear: g(X) = a + b · X = Y

E[Y ] = E[a + bX] = a + b · E[X]

V ar(Y ) = V ar(a + bX) = b2 · V ar(X) und σy = b · σx

1

x−a

Fy (x) = Fx ( x−a

b ) und fy (x) = b fx ( b )

4.3

Allgemein:

R∞

E[Y ] = E[g(x)] = −∞ g(x) · f (x)dx

V ar(Y ) = E[Y 2 ] − E[Y ]2

1

Fy (b) = Fx (g −1 (b)) · g0 (g−1

(b))

Das Gesetz der Grossen Zahlen

X1 , ..., Xn i.i.d. mit Erwartungswert µ, dann:

X n → µ (n → ∞)

Spezialfall davon: fn [A] → P [A] (n → ∞)

Lognormalverteilt:

Y ∼ LOG(µ, σ 2 ) ↔ log(Y ) ∼ N (µ, σ 2 )

Y = ex aus X ∼ N (µ, σ 2 )

2

Es gilt: E[Y ] = exp( µ+σ

2 )

E[ln(X)] = µ

P [a < X < b] = P [ln a < ln X < ln b] = Ψ

Ψ ln a−µ

σ

1. Wenn Xi ∈ {0, 1}, dann ist Sn ∼ BI(n, p) mit p =

P [Xi = 1]

4.4

Der Zentrale Grenzwertsatz

X1 , ..., Xn i.i.d. mit Erwartungswert µ und Varianz σ 2 , dann:

ln b−µ

σ

2

− Sn ≈ N (n · µ,2n · σ ) für grosse n

X n ≈ N (µ, σ /n) für grosse n

4.5

Paretoverteilt:

Y = ex aus X ∼ EXP (α)

P [X > x] = x−α

fy (x) = α · x−(α+1)

Fy (x) = 1 − x−α

Chebychev Ungleichung

P [|X n − µ| > c] 6

σ2

n·c2

Mit dieser ist man stets auf der sicheren Seite, dafür aber

meistens ziemlich grob.

2

5

5.1

Gemeinsame und

bedingte Wahrscheinlichkeit

6

Bedingte Wahrscheinlichkeit

6.1

Die Bedingte Wahrscheinlichkeit von A gegeben B:

P [A|B] =

P [A∩B c ]

P [B c ]

Daraus abgeleitete

R Rallgemeine Wahrscheinlichkeit:

P [(X, Y ) ∈ A] =

f

(x, y)dxdy mit A ⊆ <2

A X,Y

Falls A und B unabhängig:

P [A|B] = P [A|B c ] = P [A]

5.2

Gemeinsame Dichte

Gemeinsame Dichte fX,Y (., .) von zwei stetigen Zufallsvariablen X und Y:

P [x 6 X 6 x + dx, y 6 Y 6 y + dy] = fX,Y (x, y)dxdy

P [A∩B]

P [B]

analog: P [A|B c ] =

Gemeinsame und

bedingte stetige Verteilungen

6.1.1

Randdichte und bedingte Dichte

Randdichte

R ∞von X, bzw. von Y:

fX (x) = −∞ fX,Y (x, y)dy

R∞

fY (y) = −∞ fX,Y (x, y)dx

Satz der totalen Wahrscheinlichkeit

Gegeben: P [B], P [A|B], P [A|B c ]

Bedingte Dichte, wenn X = x gegeben:

Satz I:

(x,y)

P [A] = P [A∩B]+P [A∩B c ] = P [A|B]·P [B]+P [A|B c ]·P [B c ] fY (y|X = x) = fX,Y

fX (x)

Satz II: P

k

P [A] = i=1 P [A|Bi ] · P [Bi ]

Bei Unabghängigkeit von X und Y:

fX,Y (x, y) = fX (x) · fY (y)

5.3

6.2

Satz von Bayes

P [Bi |A] =

P [A|Bi ]·P [Bi ]

P [A|B1 ]·P [B1 ]+...+P [A|Bk ]·P [Bk ]

Erwartungswert bei

mehreren Zufallsvariablen

E[g(X, Y )] =

5.4

Gemeinsame und

bedingte diskrete Verteilungen

R∞ R∞

−∞ −∞

g(x, y) · fX,Y (x, y)dxdy

Im diskreten Fall:

P P

E[g(X, Y )] = i j g(xi , yj ) · P [X = xi , Y = yj ]

Randverteilung:

P [X = xi ] und P [Y = yj ]

ErwartungswertR der einen Zufallsvariable Y gegeben X = x:

∞

E[Y |X = x] = −∞ yfY (y|X = x)dy

Gemeinsame Verteilung:

P [X = xi , Y = yj ]

6.3

Kovarianz und Korrelation

Kovarianz:

Cov(X, Y ) = E[(X − µX )(Y − µY )]

BedingteVerteilung:

P [Y = yj |X = xi ]

Korrelation:

Corr(X, Y ) = ρXY =

Cov(X,Y )

σX ·σY

Rechenregeln:

E[X + Y ] = E[X] + E[Y ] für beliegige, auch abhängige Zufallsvariablen

Cov(X, Y ) = E[XY ] − E[Y ] · E[Y ]

Cov(X, Y ) = 0 falls X und Y unabhängig

Cov(a + bX, c + dY ) = b · d · Cov(X, Y )

Cov(a + bX, c + dY ) = sign(b) · sign(d) · Cov(X, Y )

V ar(X + Y ) = V ar(X) + V ar(Y ) + 2Cov(X, Y )

Die Korrelation misst Stärke und Richtung der linearen

Abhängigkeit zwischen X und Y.

Corr(X, Y ) = +1 genau dann wenn Y = a + bX für ein

a ∈ < und ein b > 0

Corr(X, Y ) = −1 genau dann wenn Y = a+bX für ein a ∈ <

und ein b < 0

Wenn X,Y unabhängig: ⇒ Corr(X, Y ) = 0

3

6.4

8

Lineare Prognose

Schliessende Statistik

Lineare Prognose von Y gestützt auf X, Ansatz: Yb = a + bX: 8.1 Das Testproblem

)

Yb = µY + Cov(X,Y

V ar(X) (X − µX )

Nullhypothese:

E[(Y − Yb )2 ] = (1 − ρ2XY ) · V ar(Y )

H0 : p = p0

Alternativen:

6.5 Zwei-dimensionale Normalverteilung

p 6= p0 (zweiseitig)

p > p0

Kovarianz-Matrix:

(einseitig nach oben)

p < p0

V ar(X)

Cov(X, Y )

(einseitig nach unten)

Cov(X, Y )

V ar(Y )

Normalverteilung:

X

Y

∼ N2

µX

µY

Wenn wir an der Abweichung nach oben interessiert sind,

dann lehnen wir die Nullhypthese ab, falls x > c. Wir nehmen

einmal an, dass die Nullhypthese stimmt, dann ist die Wahrscheinlichkeit, die Nullhypthese fälschlicherweise abzulehnen

(Fehler 1. Art): Pn

n

Pp0 [X > c] = k=c

pk0 (1 − p0 )n−k

k

,Σ

Dichte:

0

fX,Y (x, y) =

6.6

7

7.1

1

√

e

2π detΣ

− 21 (x−µX ,y−µY )Σ−1 @

x − µX

y − µY

1

A

Fehler 2. Art: kein Verwerfen der Nullhypthese, obwohl sie

falsch ist:

Pp0 [X > c] 6 α

Mehr als 2 Zufallsvariablen

Zweiseitig:

verwerfe Nullhypothese, falls c1 > x und c2 6 x

Pc1

n

pk0 (1 − p0 )n−k 6 α2

k=0

k

Pn

n

pk0 (1 − p0 )n−k 6 α2

k=c2

k

Deskriptive Statistik

Kennzahlen

Arithmetisches Mittel:

x = n1 (x1 + ...xn )

Ablauf eines Testes

1. Lege Nullhypothese fest

Empirische

Varianz:

2. Vernünftige Alternative, zweiseitig oder einseitig, oben oder

P

n

1

2

s2 = n−1

i=1 (xi − x)

unten

3. Signifikanzniveau, α = 0.05(üblich) oder 0.01

Empirisches α-Quantil: x(k) mit k die kleinste ganze Zahl 4. Konstruiere Verwerfungsbereich für H0 , so dass:

> αn bei geordetenen Werten x(1) 6 x(2) 6 ... 6 x(n)

P [F ehler1.Art] 6 α

5. Erst jetzt: betrachte ob Beobachtung x in den VerwerfungsQuartilsdifferenz: Unterschied zwischen 25%- und 75%-Quantil bereich fällt. Falls ja, verwerfe Nullhypothese

7.2

Histogramm, Boxplot und Q-Q Plot

8.2

P-Wert

Es gibt ein Niveau, wo H0 gerade noch verworfen wird. Der PWert ist das kleinste Signifikanzniveau wo H0 verworfen

wird.

8.3

Vertrauensintervalle

Vertrauensintervall

q für p, falls X ∼ Binom(n, p):

x

α

−1

(1 − 2 ) nx (1 − nx ) n1

n ±Φ

Vertrauensintervall

√ für λ, falls X ∼ P oisson(λ):

x ± Φ−1 (1 − α2 ) x

Vertrauensintervall

q für λ̂:

λ̂ ± Φ−1 (1 − α2 ) nλ̂

Histogramm: Berechnung der Häufigkeit einzelner Werte im

Intervall, proportianale Balken

Boxplot: Rechteck begrenzt durch das 25%- und 75%-Quantil,

Linien von gršsstem bis kleinstem ”normalen”Wert (1.5 mal

die Quartilsdifferenz), Ausreisser: Sterne

Q-Q-Plot: ”Quantil-Quantil-Plot”, bei Normalverteulung: Gerade, jedoch nicht durch Null und nicht im 45 Grad Winkel

Vertrauensintervall

q für p̂:

α

−1

p̂ ± Φ (1 − 2 ) np̂

4

9

Statistik bei

normalverteilten Daten

9.1

allen möglichen Tests ist, falls die Beobachtungen normalverteilt sind. Bei nicht-normalverteilten Beobachtungen können

andere Tests sehr viel besser sein.

Schätzungen

10

Punktschätzungen:

Pn

µ

b = X n = n1 i=1 Xi

σ

b2 = Sn2 =

1

n−1

Pn

i=1 (Xi

−µ

b)2

Die Verteilung von Xi sei bekannt bis auf einen unbekannten

Parameter θ, dabei kann θ auch mehrere Komponenten haben

und ist dann ein Parametervektor.

Erwartungswert der Schätzer:

E(b

µ) = µ

E(b

σ2 ) = σ2

9.2

10.1

X̄−µ

√0

σ/ n

10.2

∼ N (0, 1)

Maximum-likelihood Schätzer

Wählt als Schätzer Parameterwert, der die log-LikelihoodFunktion maximiert P

n

für diskrete Xi : l(θ) =P i=1 log(pθ (Xi ))

n

für stetige Xi : l(θ) = i=1 log(fθ (Xi ))

Vertrauensintervall

zweiseitig:

i

h

α

σ

−1

√

X̄ − n Φ (1 − 2 ), X̄ + √σn Φ−1 (1 − α2 )

Verwerfungsbereich

einseitig:

−1

Φ

(1

−

α),

∞

oben

−∞, Φ−1 (α) unten

t-Test

σ unbekannt, Daten sind Normalverteilt

H0 verwerfen, falls:

zweiseitig: √

0

|T | = | x−µ

n| > tn−1,1− α2

Sx

einseitig: √

0

n > tn−1,1−α

T = x−µ

Sx

Vertrauensintervall

zweiseitig:

h

i

Sx

S

α , X̄ + √x t

α

X̄ − √

t

n n−1,1− 2

n n−1,1− 2

Verwerfungsbereich einseitig:

[tn−1,1−α , ∞] oben

[−∞, tn−1,α ] unten

9.2.1

Momentenmethode

Unbekannter Parameter mit Hilfe der Momente µk = E[X k ]

ausdrückbar:

θj = gj (µ1 , ...µp )

Momentenschätzer ersetzt wahre µk durch empirische Analoga:

θ̂j = gj (µ̂

P1n, ..., µ̂p )

µ̂k = n1 i=1 Xik

Testen

z-Test

σ bekannt, Daten sind Normalverteilt

H0 verwerfen, falls:

|X n − µ0 | > √σn Φ−1 (1 − α2 )

Betrag bei zweiseitigem Test, ohne bei einseitigem, > bei nach

oben, < bei nach unten

Z=

Punktschätzungen:

allgemeine Methoden

Macht eines Tests

Macht:

1 − β(µ) = P [Test verwirft richtigerweise H0 für ein µ ∈ HA ]

mit Wahrscheinlichkeit eines Fehler 2. Art:

β(µ) = P [Test akzeptiert H0 obschon ein µ ∈ HA stimmt]

Die Macht beschreibt die Kapazität wie gut ein Test einen Parameter im Bereich der Alternative richtigerweise entdecken

kann. Deshalb kann die Macht als Gütekriterium gebraucht

werden, um optimale Tests zu charakterisieren.

Man kann zeigen, dass der t-Test der optimale Test unter

5

11

11.1

Vergleich zweier Stichproben

|X̄n −Ȳm |

√

Spool 1/n+1/m

X̄

√n −Ȳm

Spool 1/n+1/m

Gepaarte und ungepaarte Stichproben

> tn+m−2,1− α2 bei Alternative HA : µX 6= µY

> tn+m−2,1−α bei Alternative HA : µX > µY

mit:

Pn

Pn

Randomisierung:

1

2

(Xi − X̄n )2 + i=1 (Yi − Ȳm )2

Spool

= n+m−2

i=1

Zufällig gewählte Reihenfolge der Versuche, verschiedene Versuchseinheiten unter zwei verschiedenen Versuchbedingungen

1

V ar(X̄n − Ȳm ) = σ 2 ( n1 + m

)

ergeben eine ungepaarte Stichprobe. Einzelne Tests müssen

nicht gleiche Stichprobengrösse haben.

Gepaarte Stichproben: beide Versuchsbedingungen an derselben Versuchseinheit getestet. Notwendigerweise müssen die

beiden Stichprobengrössen gleich sein.

11.2

Gepaarte Vergleiche

Differenz innerhalb der Paare: ui = xi − yi

Besteht kein Unterschied zwischen den Versuchsreihen:

E[Ui ] = 0 → Nullhypthese und Alternative aufstellen

Verschiedene mögliche Tests:

1. t-Test

2. Vorzeichen-Test

3. Wilcoxon-Test

11.2.1

Vorzeichen-Test

Annahme: NUR i.i.d, keine normalverteilten Daten

Daten: X1 , ..., Xn und Zi = Xi − µ

Vorzeichen: sign(Z1 ), ...sign(Zn )

wobei: sign(Zi > 0) = 1 und sign(Zi 6 0) = −1

Teststatistik: V=Anzahl pos. Beobachtungen

Verteilung von V: BIN (n, p = P [Zi > 0])

11.2.2

Wilcoxon-Test

Kompromiss: setzt weniger vorraus als t-Test, nützt Daten

aber besser aus als Vorzeichen-Test.

1. Ränge bilden: Rang(|Ui |) = k z.B. k = 1 für kleinste Differenz U. Wenn einzelne |Ui | zusammenfallen, teilt man die

Ränge auf

2. Vi ist Indikator, ob Ui positiv ist: V (U > 0) = 1 und

V (U < 0) = 0

3. Verwerfung

der Nullhypothese falls

Pn

W = i=1 Rang(|Ui |) · Vi

zu gross, zu klein oder beides ist.

Eigenschaften:

U hält das Niveau α exakt, falls F symm. (um 0) und xi i.i.d

Fehler 2.Art von t-Test ist oft viel grösser als Fehler

2.Art von U.

Wilcoxon-Test ist in der Praxis dem t- oder Vorzeichen-Test

vorzuziehen, ausser z.B. die Daten sind gut mit einer Normalverteilungbeschrieben (dann t-Test).

11.3

Zwei-Stichproben Tests

Ungepaarte Stichproben, unabhängige Zufallsvariablen

Xi ∼ N (µX , σ 2 )

Yi ∼ N (µY , σ 2 )

Nullhypothese H0 : µX = µY verwerfen, falls:

6