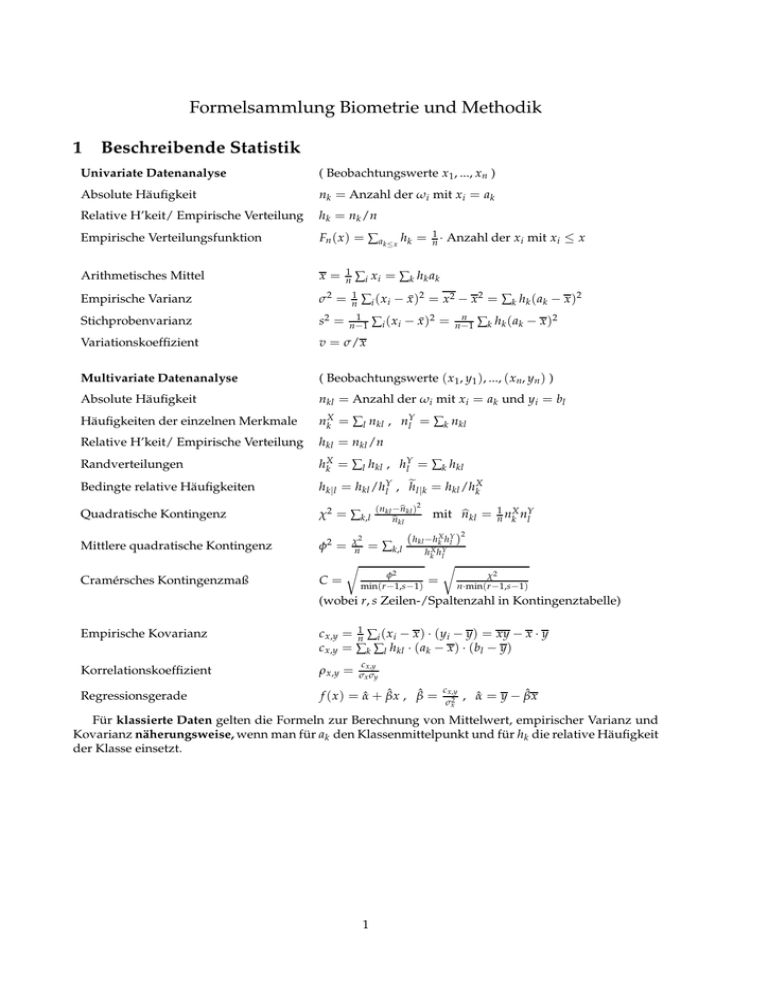

Formelsammlung Biometrie und Methodik 1 Beschreibende Statistik

Werbung

Formelsammlung Biometrie und Methodik

1

Beschreibende Statistik

Univariate Datenanalyse

( Beobachtungswerte x1 , ..., xn )

Absolute Häufigkeit

nk = Anzahl der ωi mit x i = ak

Relative H’keit/ Empirische Verteilung

hk = nk /n

Empirische Verteilungsfunktion

Fn ( x ) = ∑ ak ≤ x hk = n1 · Anzahl der xi mit xi ≤ x

Arithmetisches Mittel

x=

Empirische Varianz

σ2 =

1

n

Stichprobenvarianz

s2 =

1

n −1

Variationskoeffizient

v = σ/x

Multivariate Datenanalyse

( Beobachtungswerte ( x1 , y1 ), ..., ( xn, yn ) )

Absolute Häufigkeit

nkl = Anzahl der ωi mit xi = ak und yi = bl

Häufigkeiten der einzelnen Merkmale

nkX = ∑l nkl , nYl = ∑k nkl

Relative H’keit/ Empirische Verteilung

hkl = nkl /n

Randverteilungen

hkX = ∑l hkl , hYl = ∑k hkl

Bedingte relative Häufigkeiten

hk|l = hkl /hYl , e

hl |k = hkl /hkX

Quadratische Kontingenz

Mittlere quadratische Kontingenz

Cramérsches Kontingenzmaß

1

n

∑i xi = ∑k hk ak

∑i ( x i − x̄ )2 = x2 − x 2 = ∑k hk ( ak − x )2

χ2 = ∑k,l

∑i ( xi − x̄ )2 =

bkl )2

(nkl −n

bkl

n

n

n −1

∑k h k ( a k − x )2

bkl = n1 nkX nYl

mit n

2

2

( h −h X hY )

φ2 = χn = ∑k,l kl h X hkY l

k l

r

r

2

2

φ

C = min(r −1,s−1) = n·min(rχ−1,s−1)

(wobei r, s Zeilen-/Spaltenzahl in Kontingenztabelle)

Empirische Kovarianz

c x,y = n1 ∑i ( xi − x ) · (yi − y) = xy − x · y

c x,y = ∑k ∑l hkl · ( ak − x ) · (bl − y)

Korrelationskoeffizient

ρ x,y =

Regressionsgerade

f ( x ) = α̂ + β̂x , β̂ =

c x,y

σx σy

c x,y

σx2

, α̂ = y − β̂x

Für klassierte Daten gelten die Formeln zur Berechnung von Mittelwert, empirischer Varianz und

Kovarianz näherungsweise, wenn man für ak den Klassenmittelpunkt und für hk die relative Häufigkeit

der Klasse einsetzt.

1

2

Wahrscheinlichkeiten

Gegenereignis

P[ A tritt nicht ein] = 1 − P[ A tritt ein]

Additionssatz

P[ A tritt ein oder B tritt ein]

= P[ A tritt ein] + P[ B tritt ein] − P[ A tritt ein und B tritt ein]

P [ A und B ]

P[B]

=

P [ A und B treten beide ein]

P [ B tritt ein]

Bedingte W’keit

P[ A| B] =

Fallunterscheidung

P [ A] = ∑ni=1 P [ A| Hi ] · P [ Hi ]

wobei Hi disjunkte Fälle, von denen genau einer eintritt

Satz von Bayes

P [ Hi | A ] =

P [ A | Hi ]· P [ Hi ]

∑nj=1 P [ A | H j ]· P [ H j ]

= const. · P[ A| Hi ] · P[ Hi ]

wobei Hi disjunkte Fälle, von denen genau einer eintritt

Multiplikativität

P[ A und B treten ein] = P[ A] · P[ B| A] = P[ B] · P[ A| B]

Unabhängigkeit

P[ A und B treten ein] = P[ A] · P[ B]

2

3

3.1

Zufallsvariablen und ihre Verteilung

Diskrete Zufallsvariablen

Verteilung/Massenfkt.

p X ( ak ) = P[ X = ak ]

Verteilungsfunktion

FX (y) = P [ X ≤ y] = ∑ ak ≤y p X ( ak )

i

i

h

h

P X < x( p) ≤ p ≤ P X ≤ x( p)

p-Quantil

E[ X ] = ∑k ak · p X ( ak )

Erwartungswert

Varianz

Standardabweichung

3.2

Stetige Zufallsvariablen

Rb

P[ a ≤ X ≤ b] = P[ a < X < b] = a f X ( x ) dx

Ry

FX (y) = P[ X ≤ y] = −∞ f X ( x ) dx

Dichtefunktion

Verteilungsfunktion

′

f X = FX

Zusammenhang

p-Quantil

Erwartungswert

Varianz

Standardabweichung

3.3

E[ g( X )] = ∑k g( ak ) · p X ( ak )

h

i

Var ( X ) = E ( X − E[ X ])2 = E X 2 − E [ X ]2

p

σ ( X ) = Var ( X )

h

i

FX ( x( p) ) = P X ≤ x( p) = p

R∞

E [ X ] = −∞ x · f X ( x ) dx

R∞

E [ g( X )] = −∞ g( x ) · f X ( x ) dx

h

i

Var ( X ) = E ( X − E[ X ])2 = E X 2 − E [ X ]2

R∞

= −∞ ( x − E[ X ])2 · f X ( x ) dx

p

σ ( X ) = Var ( X )

Rechenregeln

Erwartungswert

E[ a · X + b · Y ] = a · E[ X ] + b · E[Y ]

Varianz

Var ( a · X ) = a2 · Var ( X )

σ ( a · X ) = | a| · σ ( X )

Var ( X + Y ) = Var ( X ) + Var (Y ) + 2 · Cov( X, Y )

X, Y unkorreliert ⇒ Var ( X + Y ) = Var ( X ) + Var (Y )

Standardisierung

Y=

X −E[X ]

σ( X )

ist ZV mit E [Y ] = 0 und σ (Y ) = 1

3

4

Spezielle Verteilungen

1

m

1

= Anzahl der möglichen

Werte

Gleichverteilung

p( ai ) =

(auf { a1 , . . . , am })

Erw.wert =

Empirische Verteilung

(der Daten x1 , . . . , x n )

p( ak ) = rel. Häufigkeit von ak unter x1 , . . . , x n

Erw.wert = x n = n1 ∑i xi

m +1

2 ,

Varianz = σn2 =

Bernoulli (p)

p(1) = p,

1

n

m2 −1

12

Varianz =

∑i (xi − x n )

2

p (0) = 1 − p

Erw.wert = p, Varianz = p · (1 − p)

Bin (n, p)

p(k) = (nk) · p k · (1 − p)n−k

(nk) =

n ·( n −1)·····( n −k +1)

k ·( k −1)·····1

=

(k = 0, 1, . . . , n)

n!

k! ( n −k ) !

Erw.wert = n · p , Varianz = n · p · (1 − p)

Hypergeom (b

n, b

k, n)

Poisson (λ)

p(k) =

b

b

( kk)·( nnb−−kk)

( nnb)

Erw.wert = n ·

p(k) =

1 k

k! λ

(k = 0, 1, . . . , n)

bk

b,

n

Varianz = n

· e−λ

bk n

b− b

b− n

k n

b n

b

b−1

n

n

(k = 0, 1, 2, ...)

Erw.wert = λ, Varianz = λ

Exp (λ)

f (t) = λ · e−λ·t für t > 0, f (t) = 0 für t ≤ 0

Erw.wert =

N (0, 1)

f (x) =

1

λ,

Standardabw. =

1

λ

2

√1 e− x /2

2π

Erw.wert = 0, Varianz = 1

N (m, σ2)

f (x) =

2

2

√ 1 e−( x −m) /2σ

2πσ2

Erw.wert = m, Varianz = σ2

Lineare Transformationen

X ∼ N (m, σ2)

X + a ∼ N (m + a, σ2 )

=⇒

b · X ∼ N (b · m, b2 · σ2 )

4

5

Approximation von Verteilungen

Poissonapproximation

der Binomialverteilung

Für große n und für p mit n · p = λ (also p = λ/n) gilt

(nk) · pk · (1 − p)n−k ≈ k!1 λk · e−λ

Gesetz der großen Zahlen

(n → ∞)

Für X1 , X2 , . . . unabh., ident. vert., E [ Xi ] = m, Var ( Xi ) = σ2 gilt:

X n = n1 · (X1 + X2 + · · · + Xn ) −→ m

Anwendung auf rel. H’keiten

hn ( a) −→ p( a)

Zentraler Grenzwertsatz

Für X1 , X2 , . . . unabh., ident. vert., E[ Xi ] =m, Var ( Xi ) = σ2 gilt:

2

X n = n1 · (X1 + X2 + · · · + Xn ) ≈ N m, σn für große n

Normalapproximation

X ∼ Bin(n, p),

der Binomialverteilung

p

Y = ( X − np)/ np(1 − p)

Rb

2

P [ a ≤ Y ≤ b] ≈ a √1 e− x /2 dx = Φ(b) − Φ( a)

2π

Anwendbarkeit (Faustregel)

np(1 − p) > 9

Normalapproximation für

P [| X − E[ X ]| ≤ σ ( X )] ≈ 68.2% (exakt für X ∼ N (0, 1))

W’keiten der σ-Umgebungen

P [| X − E[ X ]| ≤ 2σ ( X )] ≈ 95.4% (exakt für X ∼ N (0, 1))

P [| X − E[ X ]| ≤ 3σ ( X )] ≈ 99.7% (exakt für X ∼ N (0, 1))

5

6

Punktschätzer und Teststatistiken

Verteilung unter H0

Einstichprobenproblem

Statistiken

Schätzung des Mittelwerts

· ( X1 + X2 + · · · + X n )

2

n

1

S2n = n−

1 ∑ i =1 Xi − X n

Schätzung der Varianz

Gauß-Statistik

Xn =

1

n

Zn =

Xn −

√m0

σ/ n

X n −√

m0

Sn / n

∼ N (0, 1) im Gaußmodell

t-Statistik

T=

V-Statistik (Vorzeichentest)

V =Anzahl der pos. Vorzeichen

von Xi − µ0

∼ Bin(n, 0.5) bei stet. Verteilung

W-Statistik (Wilcoxontest)

W =Summe der Ränge der

pos. Differenzen Xi − m0

N (n(n + 1)/4, n(n + 1)(2n + 1)/24)

für große n

Vorauss. stet. sym. Verteilung

Verb. Zweistichprobenprobl.

Statistiken (Ui = Xi − Yi )

Verteilung unter H0

Schätzung der Diff. der Mittelw.

Un = Xn − Yn

Schätzung der Varianz

S2n =

1

n −1

Gauß-Statistik

Zn =

U√

n

σ/ n

t-Statistik

T=

V-Statistik (Vorzeichentest)

V =Anzahl der pos. Vorzeichen

von Ui

∼ Bin(n, 0.5) bei stet. Verteilung

W-Statistik (Wilcoxontest)

W =Summe der Ränge der

pos. Differenzen Ui

N (n(n + 1)/4, n(n + 1)(2n + 1)/24)

für große n

Vorauss. stet. Verteilungen

unterscheiden sich nur in Lage

Unverb. Zweistichprobenprobl.

Statistiken

Verteilung unter H0

Schätzung der Mittelwerte

∼ t(n − 1) im Gaußmodell

∑ni=1 Ui − U n

2

U√

n

Sn / n

Xn =

1

n

Ym =

1

m

∼ N (0, 1) im Gaußmodell

∼ t(n − 1) im Gaußmodell

· ( X1 + X2 + · · · + X n )

· (Y1 + Y2 + · · · + Ym )

2

= n+m1 −2 ∑ni=1 Xi − X n

2 + ∑m

Y

−

Y

m

i

i =1

Gepoolte Schätzung der Varianz

S2pool

Gauß-Statistik

Zn =

t-Statistik

T=

Xq

n −Y m

1

1

n+m

∼ N (0, 1) im Gaußmodell

X nq

−Y m

∼ t(n + m − 2) im Gaußmodell

σ·

S pool ·

1

1

n+m

6

Einfaktorielle Varianzanalyse

Schätzer für i-tes Gruppenmittel

Yi =

Schätzer für Gesamtmittelwert

Y=

Varianz zwischen den Gruppen

Verteilung unter H0

Statistiken

ni

1

n i ∑ j =1 Yij

n

∑ki=1 ∑ j=i 1 Yij

= n1 ∑ki=1 ni · Y i

2

S2b = n1 ∑ki=1 ni · Y i − Y

1

n

Varianz innerhalb der Gruppen

S2w =

F-Statistik

F=

1

n

n

( n−k ) S2b

( k −1) S2w

2

∼ F (k − 1, n − k) im Gaußmodell

Verteilung unter H0

Statistiken

Chiquadrat-Statistik

(Anpassungstest)

χ2 = ∑rl=1 l nb l

l

nl =Häufigkeit der Klasse Kl

bl =theoretische H’keit unter H0

n

b )2

(n −n

b

n −n

(k Gruppen)

∑ki=1 ∑ j=i 1 Yij − Y i

Anpassungs- und

Unabhängigkeitstest

Chiquadrat-Statistik

(Unabhängigkeitstest)

(ni Daten yi1 , . . . , y ini in Gruppe i)

2

χ2 = ∑kl ( kl nb kl )

kl

nkl =H’keit der Kombin. (ak , bl )

bkl = n1 nkX nYl theoret. H’keit

n

7

≈ χ2 (r − 1) für große n

≈ χ2 ((r − 1) · (s − 1)) für große n

7

Konfidenzintervalle (im Gaußmodell)

Einstichprobenproblem

Konfidenzintervall

√

X n ± z1−α/2 · σ/ n

Mittelwert bei bekannter Varianz

√

X n ± tn−1,1−α/2 · Sn / n

Mittelwert bei unbekannter Varianz

Konfidenzintervall (Ui = Xi − Yi )

√

U n ± z1−α/2 · σ/ n

Verbundenes Zweistichprobenproblem

Differenz der Mittelwerte bei bekannter Varianz

Differenz der Mittelwerte bei unbekannter Varianz

√

U n ± tn−1,1−α/2 · Sn / n

Unverbundenes Zweistichprobenproblem

Konfidenzintervall

Differenz der Mittelwerte bei bekannter Varianz

X n − Y m ± z1−α/2 · σ ·

Differenz der Mittelwerte bei unbekannter Varianz

X n − Y m ± tn+m−2,1−α/2 · S pool ·

8

q

1

n

+

1

m

Hypothesentests

=

=

α =

uα =

U

u

Teststatistik (z.B. U = Z, T, W, χ2 , etc.)

beobachteter Wert der Teststatistik

Signifikanzniveau

α-Quantil der Teststatistik

Testentscheidung über Quantile

H0 wird verworfen, falls

Rechtsseitige Alternative

u > u1 − α

Linksseitige Alternative

u < uα

Beidseitige Alternative

(allgemein)

u > u1−α/2 oder u < uα/2

Beidseitige Alternative

(bei symmetrischer Verteilung von U mit Mittelwert 0)

|u| > u1−α/2

Testentscheidung über p-Wert

H0 wird verworfen, falls

Beliebige Alternative

α>p

Berechnung des p-Werts

p-Wert

Rechtsseitige Alternative

p = PH0 [U ≥ u]

Linksseitige Alternative

p = PH0 [U ≤ u]

Beidseitige Alternative

(bei symmetrischer Verteilung von U mit Mittelwert c)

p = PH0 [|U − c| ≥ |u − c|]

8

q

1

n

+

1

m

9

!

" " " " #

$" 10