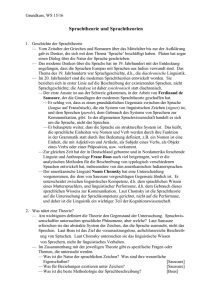

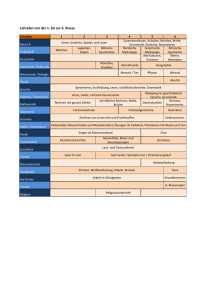

Sprachsysteme - Universität Konstanz

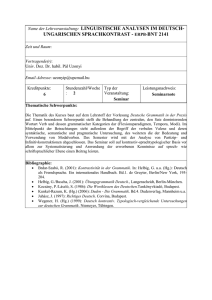

Werbung