Leseprobe - FernUni Hagen

Werbung

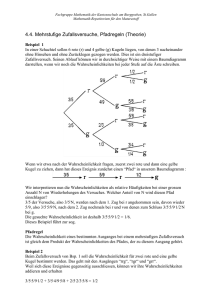

Entscheidungsstrategien des Operations Research 00840: Wissensbasiertes Entscheiden e s e L e b pr o Autoren: Prof. Dr. Wilhelm Rödder Dr. Friedhelm Kulmann Prof. Bruno Hartmut Kopittke (Brasilien) 1.3 Die Wissensbasis in probabilistischen Expertensystemen 9 Übungsaufgabe 1.4 Beantworten Sie die drei voranstehenden Fragen, indem Sie die entsprechenden Wahrscheinlichkeiten berechnen! Hat man eine Wahrscheinlichkeitsverteilung, kann man sie zur Beantwortung von Anfragen auswerten. Doch wie erhält man die Verteilung? Das Schätzen aller Einzelwahrscheinlichkeiten fällt als Akquisitionsform wohl von vornherein aus! Erstens wächst ihre Anzahl exponentiell mit der Zahl der Variablen; schon bei 10 binären (ja/nein) Variablen wären 210 = 1024 Zahlen zu schätzen. Zweitens kann kein Experte alle geforderten Angaben machen; wer weiß schon, wie viele Weltbürger Nichtamerikaner sind und kein Telefon, wohl aber ein Auto besitzen! In den folgenden Abschnitten wird auf die Wissensakquisition und deren wahrscheinlichkeitstheoretische Grundlagen eingegangen. Wissensakquisition 1.4. Wahrscheinlichkeit und Information 1.4.1. Der Satz von Bayes In der Wahrscheinlichkeitstheorie und Statistik wird versucht, dem Zufall gehorchende Phänomene der Realität zu beschreiben. Also müssen sich probabilistische Modelle auch an eben dieser Realität orientieren; Informationen über reale Sachverhalte werden in Form von Parametern geeigneter Wahrscheinlichkeitsverteilungen verdichtet. Aus Statistik-Vorlesungen kennen Sie z. B. • die Schätzung von Erwartungswert und Varianz durch Stichprobenmittel und empirische Varianz, • die Berechnung von Vertrauensbereichen für diese Schätzungen, • den statistischen Test zur Ablehnung oder Nicht-Ablehnung einer Hypothese über den unbekannten Parameter einer Verteilung. Wir werden in diesem Abschnitt zwei weitere Informationsgewinnungsarten hinzufügen: den Satz von Bayes und das Entropiekonzept. Da die Zusammenhänge im Rahmen dieses Lehrbriefes nur für diskrete Variable benötigt werden, beschränken wir uns auf diesen Fall. Zur Vereinfachung der Notation verwenden wir sogar nur binäre ≡ zweiwertige Variable A, B, C mit Ausprägungen (a / a ) , (b / b ) , (c / c ) . Satz von Bayes Entropiekonzept 10 Satz der totalen Wahrscheinlichkeit 1. Probabilistische Expertensysteme Zur Erinnerung formulieren wir jetzt den Satz der totalen Wahrscheinlichkeit und dann den Satz von Bayes. Beide Ergebnisse entstehen durch einfache Umrechnungen bedingter Wahrscheinlichkeiten. Satz 1.1 (Satz der totalen Wahrscheinlichkeit) Ist P eine Wahrscheinlichkeitsverteilung über A, B, so gilt ( ) p( A) = p( A B = b) ⋅ p( B = b) + p A B = b ⋅ p( B = b ) . (1.1) Die Wahrscheinlichkeit von A = a und A = a ist also als eine Konvexkombination der bedingten Wahrscheinlichkeiten p( A B = b) und p A B = b berechen- ( ) bar. Gilt eine Formel z. B. für A = a und auch für A = a , schreiben wir oft − wie in (1.1) − einfach A. Ist ferner aus dem Zusammenhang klar, welche Variable gemeint ist, genügt auch die Notierung lediglich der Ausprägung. ( ) p( a ) = p(a b) ⋅ p( b) + p a b ⋅ p(b ) ist also eine erlaubte Schreibweise für die Berechnung von p(A = a) gemäß dem Satz der totalen Wahrscheinlichkeit. Übungsaufgabe 1.5 Beweisen Sie den Satz der totalen Wahrscheinlichkeit durch Ausrechnen der bedingten Wahrscheinlichkeiten und geeignetes Zusammenfassen. Der Satz von Bayes mutet etwas komplizierter an, sein Nachweis ist jedoch ebenso einfach wie der des obigen Satzes. Satz 1.2 (Satz von Bayes) Ist P eine Wahrscheinlichkeitsverteilung über A, B, so gilt p( B A) = p( A B) ⋅ p( B ) . p( A B = b) ⋅ p( B = b) + p( A B = b ) ⋅ p( B = b ) (1.2) 1.4 Wahrscheinlichkeit und Information 11 Die bedingten Wahrscheinlichkeiten der Ausprägungen von B unter A lassen sich (umgekehrt) aus denen von A unter B berechnen! Beweis ) Der Nachweis der Richtigkeit des Satzes ist trivial, wenn man für den Nenner we- gen (1.1) p(A) einsetzt und die Gleichung mit p(A) multipliziert. Man erhält dann p( B A) ⋅ p( A) = p( A B) ⋅ p( B ) . Diese Identität gilt aber offensichtlich, da z.B. p( B A) = p( AB ) . p( A) 9 Zur Verdeutlichung der Bedeutung des Satzes von Bayes betrachten wir folgendes Beispiel, das wir im Verlauf dieses Abschnitts gelegentlich wieder aufgreifen. Beispiel 1.2 Bei einer polizeilichen Fahrzeugkontrolle am Samstagabend seien aufgrund statistischer Analysen folgende Sachzusammenhänge bekannt: Betrachtet wurden u.a. das Geschlecht G = m (männlich) bzw. G = f (weiblich), das Ergebnis des Alkoholtests A = n (negativ) bzw. a (alkoholpositiv). Frauen waren nur zu 2 % alkoholisiert, Männer jedoch zu 16 %; außerdem betrug der Anteil von Fahrerinnen 40 %. Verifizieren Sie, dass die folgende Verteilung den Angaben auf 3 Nachkommastellen genügt! Sie ist übrigens die einzige, die das tut. Tab. 1.5: Verteilung zu Beispiel 1.2 P m n 0,504 m a 0,096 f n 0,392 f a 0,008 Hauptwachtmeister Holm sitzt im Kontrollfahrzeug und erfährt durch Zuruf, dass der letzte Alkoholtest negativ verlief. Wie groß ist die Wahrscheinlichkeit, dass die überprüfte Person eine Frau war? 12 1. Probabilistische Expertensysteme Die Lösung ist leicht ermittelt: p( f n) = ( ) ( ) p n f ⋅ p( f ) p n f ⋅ p( f ) + p(n m) ⋅ p( m) = 0,98 ⋅ 0,4 0,98 ⋅ 0,4 + 0,84 ⋅ 0,6 ≅ 0,438 . Die Wahrscheinlichkeit von Frauen unter nicht alkoholisierten Personen beträgt ca. 44 %, also signifikant mehr als in der Grundgesamtheit. ® Übungsaufgabe 1.6 Berechnen Sie die Wahrscheinlichkeit, dass eine alkoholisierte Person ein Mann ist. 1.4.2. A priori- und a posteriori-Verteilung Soweit also eine einfache Anwendung des Satzes von Bayes. Doch wo ist hier die Informationsgewinnung bei diesem einfachen Umrechnen von bedingten Wahrscheinlichkeiten? Warum ist dieser Satz die am meisten kontrovers diskutierte Erkenntnis der Wahrscheinlichkeitstheorie? Zur Erklärung fahren wir im Beispiel der Fahrzeugkontrolle fort. Beispiel 1.3 (Fortsetzung von 1.2) Hauptwachtmeister Holm sitzt nun schon einige Stunden im Kontrollfahrzeug und kommt bei jedem negativen Alkoholtest ins Grübeln. Die 2 % bzw. 16 % alkoholisierter bei weiblichen bzw. männlichen Fahrern sind statistisch untermauert, die 40 % Frauenanteil sind jedoch lediglich seine Vermutung. Ist der Anteil in der Grundgesamtheit eigentlich korrekt geschätzt? Schließlich sind 98 % der Frauen nicht alkoholisiert im Gegensatz zu nur 84 % bei den Männern. Liefert da nicht jeder sichere (w(n) = 1) negative Alkoholtest auch Informationen über den Frauenanteil ?! Die Bayesianer sagen nun: Es ändert sich nicht nur die bedingte Wahrscheinlichkeit p(f |n); Formel (1.2) kann auch benutzt werden, um die neue Wahrscheinlichkeit für Frauen in der Grundgesamtheit zu schätzen: p post ( f | w( n) = 1) . 1.4 Wahrscheinlichkeit und Information 13 Mit dieser sogenannten a posteriori Wahrscheinlichkeit − d. h. nach der Beobachtung − kann man in Zukunft arbeiten. Sie wird damit zur neuen a priori Wahrscheinlichkeit für weitere Berechnungen. a posteriori Wahrscheinlichkeit a priori Wahrscheinlichkeit Vollziehen Sie bitte nach, dass sich mit ppost(f) = 0,438 und ppost(m) = 0,562 bei ( ) der Beibehaltung der bedingten Wahrscheinlichkeiten p n f und p(n m) die in Tabelle 1.6 notierte Wahrscheinlichkeitsverteilung ergibt Tab. 1.6: Modifizierte Verteilung aus Tabelle 1.5 Ppost m n 0,472 m a 0,090 f n 0,429 f a 0,009 Da Holm in seinen Überlegungen nur Beobachtungen des Merkmals Testergebnis A berücksichtigte, kann er über die obigen bedingten Wahrscheinlichkeiten „Testergebnis negativ bei Frauen bzw. Männern“ natürlich auch nichts gelernt haben. Wohl aber ändert sich seine Einstellung zum Frauenanteil gemäß Formel (1.2). ® Übungsaufgabe 1.7 Nehmen Sie an, Hauptwachtmeister Holm beobachte ein weiteres negatives Testergebnis. Zu welcher Einschätzung des Fahrerinnenanteils käme er jetzt? 1.4.3. Von Bayes zur Entropie Nach dieser ausführlichen Diskussion der (umstrittenen) Informationsgewinnung durch Beobachtung mittels des Bayesschen Satzes werden wir wieder bescheidener. Ab jetzt dient das Theorem nur der Berechnung von bedingten Wahrscheinlichkeiten bei gegebenen evidenten Fakten. Auch in dieser Form ist es von großer Wichtigkeit für die Wissensverarbeitung in Expertensystemen. Informationsgewinnung durch Beobachtung 14 1. Probabilistische Expertensysteme Beispiel 1.4 (Fortsetzung von 1.3) Ein Wagen wird mit der Kelle heraus gewunken, die lenkende Person entzieht sich aber der Kontrolle durch Fahrerflucht. Nach Einschätzung von Hauptwachtmeister Holm hat der Fahrer oder die Fahrerin die Flucht vorgezogen, da er oder sie Alkohol zu sich genommen hat. Diese Wahrscheinlichkeit schätzt er mit 80 % ein. Wie groß ist jedoch die Wahrscheinlichkeit, dass es eine Frau war? Kann man sie mittels (1.2) berechnen? ® unsichere Information In Verallgemeinerung des Bayesschen Satzes kann man auch bei unsicherer Kenntnis 0 ≤ w(n) ≤ 1 über das Testergebnis auf p( f w( n) ) schließen. p( f w( n) ) = w( n) ⋅ p( f n) + w( a ) ⋅ p( f a ) (1.3) Die gewünschte Wahrscheinlichkeit ist bei unsicherer Kenntnis − auch: unsicherer Evidenz − eine Konvexkombination der bedingten Wahrscheinlichkeiten nach Bayes. Übungsaufgabe 1.8 Errechnen Sie basierend auf der Verteilung in Tabelle 1.6 − auf drei Stellen hinter dem Komma − die Wahrscheinlichkeit von f bei 80 % Evidenz, dass die Person am Steuer alkoholisiert ist. Ist diese Vorgehensweise schon schwierig, so wird das Theorem von Bayes bei Auftreten mehrerer unsicherer Evidenzen unzureichend. Auch zur Illustration dieser Bemerkung bedienen wir uns wieder unseres Beispiels. Beispiel 1.5 (Fortsetzung von 1.4) Zu den bereits aufgeführten Merkmalen kommt ein weiteres hinzu: K = l oder K = s stehe für Fahrzeugklasse luxuriös oder sonstige. Die Wahrscheinlichkeitsverteilung aus Tabelle 1.5 über den beiden Merkmale Geschlecht und Alkoholtest wird in Tabelle 1.7 durch die Kombination mit der Fahrzeugklasse nun erweitert. Die Erweiterung resultiert aus langjährigen statistischen Erhebungen eines Automobilclubs. 1.4 Wahrscheinlichkeit und Information 15 Tab. 1.7: Erweiterung der Tabelle 1.5 auf drei Merkmale P m n l m n P m n 0,504 m a 0,096 s 0,050 m a l wird zu m a 0,454 0,048 s 0,048 f n 0,392 f n l f a 0,008 f n f a l f a 0,200 s 0,192 0,004 s 0,004 Will man nun sowohl die virtuelle Evidenz w(a) = 0,80 als auch z. B. w(f) = 0,5 in dieser Verteilung berücksichtigen, ist das Konzept nach Bayes überfordert, wie Sie auf den beiden folgenden Seiten nachvollziehen. ® Übungsaufgabe 1.9 Errechnen Sie − auf drei Stellen hinter dem Komma − erneut die Wahrscheinlichkeit von G = f bei 80 % Evidenz, dass die Person am Steuer alkoholisiert war. Gehen Sie jetzt jedoch von der erweiterten Verteilung in Tabelle 1.7 aus ! Sie haben gemerkt, dass Sie zur Lösung der letzten Übungsaufgabe den verallgemeinerten Satz von Bayes (1.3) nun auf drei Merkmale übertragen mussten. Er lautet jetzt p( GK w( n) ) = w( n) ⋅ p(GK n) + w( a ) ⋅ p(GK a ) (1.4) Schreibt man (1.3) ein wenig um, erhält man eine handlichere Form zur Berechnung aller Wahrscheinlichkeiten unter der virtuellen Evidenz w(n): ( ) p GK w(n) = w( n) w( a ) ⋅ p( GKn) + ⋅ p( GKa ) p( a ) p( n) (1.5) 16 1. Probabilistische Expertensysteme Es sind zur Berechnung von (1.5) somit folgende Anweisungen auszuführen: marginalisieren 1. Dividiere die vier Wahrscheinlichkeiten p(G K n) in Tabelle 1.7 durch die Randverteilung p(n) und multipliziere mit der gewünschten Wahrscheinlichkeit w(n)! 2. Dividiere die vier Wahrscheinlichkeiten p(G K a) in Tabelle 1.7 durch die Randverteilung p(a) und multipliziere mit der Gegenwahrscheinlichkeit w(a) ! 3. Das Ergebnis der obigen Operationen finden Sie als Liste aller Wahrscheinlichkeiten der Elementarergebnisse in Tabelle 1.8a. 4. Marginalisieren2 Sie auf G, A, und Sie erhalten die in Tabelle 1.8b notierten Wahrscheinlichkeiten. Tab. 1.8: a) Resultierende Verteilung zu den Variablen G, A, K b) Verteilung marginalisiert auf G,A P′ 0,101 m n l m n s 0,011 m a l 0,369 m n 0,112 m a s 0,369 m a 0,738 f n l 0,045 f n 0,088 f n s 0,043 f a 0,062 f a l f a s 0,031 P′ 0,031 Damit enthält Tabelle 1.8a die unter der virtuellen Evidenz w(a) = 0,80 modifizierten Wahrscheinlichkeiten aus Tabelle 1.7. Natürlich ist jetzt p(a) = 0,80 − das hat man ja gerade gewollt − aber i.a. keineswegs p(f) = 0,5. Um p(f) = 0,5 zu erreichen, muss man die Wahrscheinlichkeiten aus Tabelle 1.8a erneut analog den obigen Anweisungen modifizieren. Dann jedoch stimmt i.a. p(a) = 0,80 nicht mehr.... Übungsaufgabe 1.10 Errechnen Sie aus Tabelle 1.8a die unter w(f) = 0,5 modifizierten Wahrscheinlichkeiten aus und tragen Sie diese in Tabelle 1.9 ein. 2 Bilden Sie die Randverteilung zu den genannten Variablen durch Summation. 1.4 Wahrscheinlichkeit und Information 17 Wie groß ist jetzt die Wahrscheinlichkeit des Ereignisses A = a ? Tab. 1.9: Schema zu Wahrscheinlichkeitsverteilung aus Aufgabe 1.10 P′ ′ m n l m n s m a l m a s f n l f n s f a l f a s An dieser Stelle nun ist ein geistiger Bruch notwendig! Bisher haben wir stets nur bedingte Wahrscheinlichkeiten unter sicherer oder unsicherer Evidenz berechnet, etwa in dem Sinne: Wie groß ist die Wahrscheinlichkeit von A = a, wenn ich nur zu 50 % sicher bin, dass die kontrollierte Person eine Frau ist? Gelegentlich haben wir schon von einer modifizierten Verteilung unter der sicheren oder unsicheren Evidenz gesprochen. Nun kommt eine völlig neue Qualität in das Bayessche Konzept! Man kann sich natürlich auch fragen, wie die gesamte Verteilung für den Fall lautet, dass nunmehr w(f) = 0,5 ist − endgültig und nicht nur zur Berechnung bedingter Wahrscheinlichkeiten. Wie adaptiert man P´ aus Tabelle 1.8a an die neue Situation, dass nunmehr 50 % in der Grundgesamtheit Frauen sind und nicht länger 15 %? Die Antwort ist fast selbstverständlich: Führe die gleichen Berechnungen aus wie in der letzten Übungsaufgabe mit dem Ergebnis P* in Tabelle 1.10. Tab. 1.10: Verteilung mit p(f) = 0,5 m m m m f f f f n n a a n n a a l s l s l s l s P* 0,059 0,007 0,217 0,217 0,150 0,144 0,103 0,103 modifizierte Verteilung 18 1. Probabilistische Expertensysteme Der * an dem P deutet darauf hin, dass hier etwas qualitativ anderes geschieht als bei der Berechnung von P´´ (vgl. Tabelle 1.9). Auch dieses Vorgehen firmiert unter dem Namen Satz von Bayes, da ja die Berechnungen identisch sind. Lesen Sie den gesamten Abschnitt 1.4.3 nochmals durch und interpretieren Sie jede Modifikation der Verteilung als Adaption an eine neue Situation oder an eine neue „Welt“, in der veränderte Bedingungen gelten. 1.4.4. Das Entropiekonzept virtuelle Bedingung Regel Während der Satz von Bayes zur Modifizierung einer Verteilung bei Vorliegen mehrerer virtueller Evidenzen seine Grenzen erreicht hat, ist das nun vorzustellende Konzept maximaler Entropie viel allgemeiner. Es gestattet nicht nur die Verarbeitung virtueller Evidenzen, sondern sogar virtueller Bedingungen oder Regeln. Eine Regel ist hierbei ein bedingtes Ereignis mit einer vorgegebenen Wahrscheinlichkeit. Ist die Bedingung tautologisch, liegt wieder der (einfachere) Fall einer virtuellen Evidenz vor. Diese wird im vorliegenden Text auch oft als probabilistisches Faktum oder schlicht Faktum bezeichnet. Beispiel 1.6 (Fortsetzung von 1.5) Neueste statistische Erhebungen haben ergeben, dass die Männer nur noch zu 10 % − statt 16 % − positive Alkoholtestergebnisse zeigen. Wie sollte man die gesamte Verteilung in Tabelle 1.7 ändern, um dieser neuen Erkenntnis Rechnung zu tragen? Wir haben offenbar die Aufgabe zu lösen, die Verteilung in Tabelle 1.7 zu modifizieren unter Berücksichtigung der Regel w(a m) = 0,100 . Dabei sollten so viele der alten stochastischen Sachzusammenhänge wie möglich erhalten bleiben! ® Ist schon die Aufgabe des obigen Beispiels schwierig, so erst recht die Modifizierung einer Wahrscheinlichkeitsverteilung bei mehreren virtuellen Evidenzen und virtuellen Bedingungen. Wir formulieren jetzt ein Prinzip, welches diese schwie- 1.4 Wahrscheinlichkeit und Information 19 rige Aufgabe löst. Dazu ist auch die Symbolik an die komplizierter gewordene Situation anzupassen. Eine Regel bezeichnen wir allgemeiner als im obigen Beispiel mit B|A bzw. indiziert mit Bi|Ai. Bi und Ai können hierbei zusammengesetzte logische Formeln sein. Mehr darüber erfahren Sie im nächsten Kapitel. Soll z. B. eine Regel Bi|Ai in der Wahrscheinlichkeitsverteilung Q den Wert wi haben, wird das ab jetzt als Bedingung q(Bi|Ai)=wi geschrieben. Ohne Verwendung des Symbols q notiert man das auch einfacher durch den in eckigen Klammern vorangestellten Wert: [wi] Bi|Ai. Das angekündigte Prinzip besagt nun: Prinzip der Minimalen Relativen Entropie Sei P eine Ausgangsverteilung und P* die neue Verteilung, die den Regeln [wi] Bi|Ai, i = 1,...,m, genügen soll. Wähle P* so, dass es die Aufgabe löst Min R(Q,P) (1.6) unter den Nebenbedingungen q(Bi|Ai)=wi i = 1,...,m. Hierbei ist R(Q,P) die relative Entropie zwischen der (variablen) Verteilung Q und der Ausgangsverteilung P. Sie stellt ein informationstheoretisches Abstandsmaß zwischen Q und P dar und ist wie folgt definiert: Definition 1.1 Sind pi und qi die Wahrscheinlichkeiten der Elementarereignisse unter den Verteilungen P und Q, so ist ∑q i ld i qi pi (1.7) die relative Entropie R ( Q, P ) von Q bzgl. P; ld bezeichnet hier den Logarithmus zur Basis 2. In wissenschaftlichen Arbeiten konnte bewiesen werden, dass die Lösung der Aufgabe (1.6) in idealer Weise ein P* liefert. Dieses P* nämlich relative Entropie 20 1. Probabilistische Expertensysteme sichere Evidenz virtuelle Evidenz • modifiziert die Verteilung P nur so weit wie eben nötig, • liefert bei nur einer sicheren Evidenz das gleiche Ergebnis wie der Bayessche Satz (1.2), • liefert bei nur einer virtuellen Evidenz das gleiche Ergebnis wie der verallgemeinerte Bayessche Satz (1.3). Folgt man dieser idealen Lösung, erhält man bei der Modifikation der Tabelle 1.7 nach Anwendung der Regel [0,100] a|m das Ergebnis in Tabelle 1.11. Tab. 1.11: Verteilung unter Berücksichtigung des Prinzips minimaler relativer Entropie m m m m f f f f n n a a n n a a l s l s l s l s P* 0, 484 0, 053 0, 030 0, 030 0, 202 0,194 0, 004 0, 004 Es bedarf schon eines aufwendigen mathematischen Apparats zur Berechnung dieser Zahlenkolonne. Mit Details wollen wir sie verschonen. Prinzip maximaler Entropie Abschließend besprechen wir noch das Prinzip Maximaler Entropie. Es ist eigentlich ein Spezialfall des Prinzips Minimaler Relativer Entropie, verdient aber dennoch eine besondere Erwähnung. Oft liegt nämlich in praxi der Fall vor, dass über den stochastischen Zusammenhang der Zufallsvariablen a priori keine Informationen vorliegen. Dann sollen aus diesem Zustand des Nichtwissens heraus virtuelle Evidenzen und/oder virtuelle Bedingungen „erlernt“ werden. Gleichverteilung Man kann nun ähnlich vorgehen wie in (1.6); anstelle von P erscheint in der Zielfunktion jedoch jetzt die Gleichverteilung, die wir mit P0 bezeichnen wollen. Sie weist bekanntlich allen Elementarereignissen die gleiche Wahrscheinlichkeit zu. Die Gleichverteilung zur Tabelle 1.7 steht in Tabelle 1.12. Übungsaufgabe 1.11 1.4 Wahrscheinlichkeit und Information 21 Berechnen Sie die relative Entropie R(P,P0) gemäß den Tabellen 1.7 (rechts) und 1.12. Tab. 1.12: Gleichverteilung bei Kombination dreier binärer Variabler P0 m n l m n s 1 8 m a l 1 8 m a s 1 8 1 8 f n l 1 8 f n s 1 8 f a l 1 8 f a s 1 8 Min R(Q,P0) lautet also jetzt das Ziel unter Einhaltungen von Nebenbedingungen wie in (1.6). Man kann zeigen, dass die Minimierung der relativen Entropie zu Gleichverteilung P0 äquivalent zur Maximierung der (absoluten) Entropie H ist. (1.6) liefert mithin das gleiche P* wie die Aufgabe Prinzip der Maximalen Entropie Max H ( Q ) (1.8) unter den Nebenbedingungen q(Bi|Ai)=wi i = 1,...,m. Hierbei ist die absolute Entropie der Verteilung Q wie folgt definiert. Definition 1.2 Sind qi die Wahrscheinlichkeiten der Elementarereignisse unter der Verteilung Q, so ist −∑ qi ld qi i die absolute Entropie H(Q) von Q. absolute Entropie 22 1. Probabilistische Expertensysteme Es war der amerikanische Wissenschaftler Shannon, der den Entropiebegriff aus der Thermodynamik in die Informationstheorie übertrug. H(Q) ist ein reziprokes Maß des Informationsgehalts in Q. H ist maximal für Q=P0 und minimal, wenn ein qi = 1 ist. In der Gleichverteilung steckt keine Information, bei Sicherheit bzgl. des Eintretens eines Elementarereignisses ist die Information maximal. Das System SPIRIT verwendet als Informationsverarbeitungskonzept die Prinzipien Maximaler Entropie und Minimaler Relativer Entropie. Im gewissen Sinne sind die Antworten einer solchen Wissensbasis auf Anfragen eines Benutzers also einzigartig, da kein anderes Prinzip den gleichen strengen Ansprüchen genügt. 1.5. Wissensakquisition in probabilistischen Expertensystemen In probabilistischen Expertensystemen, so z. B. in HUGIN oder SPIRIT, wird die Wissensbasis „Wahrscheinlichkeitsverteilung“ durch den Experten stückweise aufgebaut. Soll heißen, er gibt Informationshäppchen in Form von Fakten und Regeln über kleine Variablengruppen und die Inferenzmaschine erzeugt sich dazu eine passende gemeinsame Verteilung über alle Variablenausprägungen. Die Inferenzmaschinen in HUGIN und SPIRIT arbeiten sehr verschieden. Hier wird Ihnen die von SPIRIT erläutert, für die prinzipielle Vorgehensweise in HUGIN siehe ANDERSEN et al. (1990). Lassen Sie uns wieder das Beispiel 1.1 aufgreifen, diesmal jedoch nur die Variablen T und U betrachten. Gegeben seien die Informationen q(T = t) = 0,34 und q (T = t | U = u ) = 0,80 . Lassen Sie uns annehmen, dieses Wissen sei leichter akquirierbar als alle vier Zahlen q1 = q ( u , t ) , q2 = q ( u , t ) , q3 = q ( t , u ) , q4 = q ( t , u ) . Durch die beiden Angaben 34 % für alle Telefonbesitzer und 80 % Telefonbesitzer unter den US-Bürgern ist ein lineares (Un-) Gleichungssystem festgelegt: q2 q1 + q2 + − 0,8 q3 + 0, 2 + + q3 q1 , q2 , q3 , q4 q4 q4 q4 = 0,34 = 0, 00 = 1, 00 ≥ 0. 70 Lösungen zu den Übungsaufgaben Übungsaufgabe 1.4 = 0,05 p( u) = p( t u) p( a t , u) = p( t , u) p(u) p( a , t , u) p( t , u) = = 0,04 0,05 0,03 0,04 = 0,8 = 0,75 9 Übungsaufgabe 1.5 ( ) p( A B = b) ⋅ p( B = b) + p A B = b ⋅ p( B = b ) = p( A, B = b ) p( A, B = b) ⋅ p( B = b) + ⋅ p( B = b ) = p( B = b) p( B = b ) p( A, B = b) + p( A, B = b ) = p( A) 9 Übungsaufgabe 1.6 p(m a ) = p(a m) p( m) ( ) p( a m) p( m) + p a f p( f ) = 0,16 ⋅ 0,6 0,16 ⋅ 0,6 + 0,02 ⋅ 0,4 ≅ 0,923 . Die Wahrscheinlichkeit von Männern unter alkoholisierten Personen beträgt ca. 92 %, also signifikant mehr als in der Grundgesamtheit. 9 71 Übungsaufgabe 1.7 Basierend auf der veränderten Verteilung in Tabelle 1.6 berechnet man bei einem weiteren negativ ausgefallenen Alkoholtest an einer Fahrerin [ p post ( f | w( n) = 1) ]: p( f n) = ( ) ( ) p n f p( f ) p n f p( f ) + p( n m) p( m) = 0,979 ⋅ 0,438 0,979 ⋅ 0,438 + 0,83986 ⋅ 0,562 ≅ 0,476 . 9 Übungsaufgabe 1.8 Geht man mit einer Evidenz von 80 % davon aus, dass die Person am Steuer alkoholisiert bzw. mit einer Evidenz von 20 % dass sie nicht alkoholisiert war, so berechnet man mit der Verallgemeinerung des Satzes von Bayes eine Wahrscheinlichkeit von 0,168, dass es sich dabei um eine Frau gehandelt hat. p( f w( n) ) = w( n) p( f n) + w( a ) p( f a ) = 0,2 ⋅ 0,476 + 0,8 ⋅ 0,091 = 0,168 9 Übungsaufgabe 1.9 Sie müssen zur Lösung dieser Übungsaufgabe den verallgemeinerten Satz von Bayes (1.3) nun auf drei Merkmale übertragen. Er lautet somit p( f , K w( n) ) = w( n) p( f , K n) + w( a ) p( f , K a ) . Zur Beantwortung der Frage sind folgende Berechnungen durchzuführen: p( f , l n) = 0,200 0,896 72 Lösungen zu den Übungsaufgaben p( f , s n) = 0,192 0,896 p( f , l a ) = 0,004 0,104 p( f , s a ) = 0,004 0,104 p( f , l w( n) ) = 0,2 ⋅ 0,200 0,004 + 0,8 ⋅ = 0,075 0,896 0,104 p( f , s w( n) ) = 0,2 ⋅ 0,192 0,004 + 0,8 ⋅ = 0,074 0,896 0,104 p( f w( n) ) = p( f , l w( n) ) + p( f , s w( n) ) = 0,149 Wieder geht man mit einer Evidenz von 80 % davon aus, dass die Person am Steuer alkoholisiert bzw. mit einer Evidenz von 20 % dass sie nicht alkoholisiert war. Diesmal berechnet man mit der Verallgemeinerung des Satzes von Bayes bei Erweiterung auf drei Merkmale eine Wahrscheinlichkeit von 0,149, dass es sich bei der flüchtigen Person um eine Frau gehandelt hat. 9 Übungsaufgabe 1.10 P′ ′ 0,059 m n l m n s 0,007 l 0,217 m a f s 0,217 n l 0,150 f n f a s 0,144 l 0,103 f a s m a 0,103 Es gilt nun p(a) = 0,641 ≠ 0,800. 9 73 Übungsaufgabe 1.11 P0 m n l P 0,125 0,454 m n s 0,125 0,050 m a l 0,125 0,048 m a s 0,125 0,048 ergibt einen Wert von 0,861. 0,125 0,200 f n l f n s 0,125 0,192 f a f a s 0,125 0,004 l Die Berechnung der relativen Entropie 0 R(P,P ) mit (1.7) gemäß den Tabellen 1.7 0 (rechts) und 1.12, hier die Spalten P und P , 0,125 0,004 9 Übungsaufgabe 1.12 0 1 0,34⎞ ⎛ 0 1 0 1 0,34⎞ ⎛0 1 ⎜ ⎟ ⎜ ⎟ 0 ⎟ = ⎜ 0 0 4 −1 0 ⎟ ⎜ 0 0 −0,8 0,2 ⎜ ⎟ ⎜ ⎟ 1 1 1 ⎠ ⎝ 1 0 1 0 0,66⎠ ⎝1 1 ⎧ q = 0,34 − q 4 ⎪ 2 1 ⎪ q4 ⇒ ⎨ q3 = 4 ⎪ ⎪⎩ q1 = 0,66 − q3 = 0,66 − 1 q4 4 9 Übungsaufgabe 2.1 BATTERIE 2 - wertig ⎫ ⎬ 3 - wertig ⎭ insgesamt 2⋅3 = 6 Werte BATTERIE KEILRIEMEN 3 - wertig⎫ ⎬ 3 - wertig⎭ insgesamt 3⋅3 = 9 Werte KEILRIEMEN TEMPERATUR 3 - wertig ⎫ ⎪ 3 - wertig ⎬ 2 - wertig ⎪⎭ insgesamt 3⋅3⋅2 = 18 Werte PARKLICHT ELEKTRIK