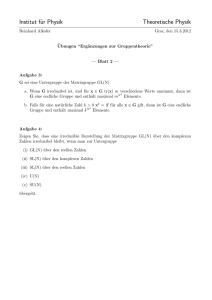

Titel der Arbeit

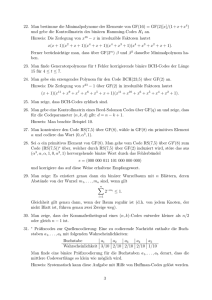

Werbung