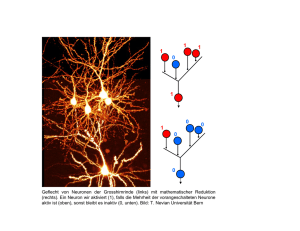

Vereinfachte Neuronenmodelle

Werbung

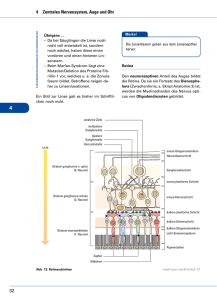

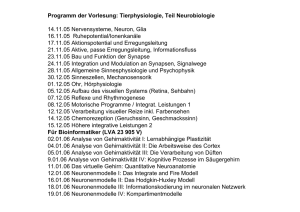

Vereinfachte Neuronenmodelle (Integrate & Fire, künstliche neuronale Netze) Computational Neuroscience 8.1.2007 Jutta Kretzberg (Vorläufiges) Vorlesungsprogramm 23.10.06!! ! 30.10.06!! ! 06.11.06!! ! 13.11.06!! ! 20.11.06!! ! 27.11.06 ! ! 04.12.06! ! 11.12.06 ! ! 18.12.06!! ! 08.01.06! ! ! ! ! ! ! ! 15.01.07!! ! 22.01.07! ! 29.01.07! ! 05.02.07 !! Motivation Neuronale Kodierung sensorischer Reize Auswertung neuronaler Antworten Variabilität neuronaler Antworten Passive Eigenschaften von Neuronen Räumliche Struktur von Neuronen Aktive Eigenschaften von Neuronen ausgefallen Das Hodgkin-Huxley Modell Das Integrate-and-Fire Modell und kurze Einführung in Neuronale Netze Lernen in Neuronalen Netzen Synaptische Übertragung und Plastizität Dendritische Verarbeitung Zwei Modelle retinaler Verarbeitung Programm für heute: Vergleich von Neuronenmodellen veschiedener Komplexität Integrate & Fire Neuronenmodell Idee künstlicher neuronaler Netze Grundlegende Verschaltungsmuster in neuronalen Netzen Modellierung neuronaler Aktivität Integration von Eingangssignalen (synaptische oder Rezeptorpotentiale) Auslösen von Aktionspotentialen Zwei Hauptaspekte: 1. Modellierung des Verhaltens einzelner Zellen 2. Modellierung von Netzwerken abnehmende Komplexität Modellierungsansätze Betrachte räumlich getrennte Untereinheiten der Zelle: Compartmental Model Betrachte die Zelle als Ganzes: HodgkinHuxley Betrachte die einzelnen Verarbeitungsschritte getrennt von einander: Integrate and Fire Betrachte die Arbeitsweise ganzer Netzwerke, ohne die einzelne Zelle genau zu modelieren: Künstliche neuronale Netze Grundlage für die Modellierung Theorie: Differentialgleichung von Einzelzellen: Passive Membran innen; Ui ie ic Cm ie außen; Ue ie = ic + ir Rm ir U(t) U (t) m ER ic = Cm • dU(t)/dt ir = U(t)/Rm Grundlage für die Modellierung von Einzelzellen: Passive Membran Integration mit passiver Membran: dU(t) U(t) Iext(t) =- . + dt CR C Diskrete Zeitschritte: U(t) I ext(t) U(t+1) = U(t)- t. . + t. CR C Schwelle: Simulationsparameter: Modellparameter: Δt U(t)>O, sonst C, RS(t)=0 S(t) =U(t=0), 1 wenn Matlab-Simulation einer passiven Membran Ausgabe: integriertes Membranpotential Eingabe: injizierter Strom I_ext und u sind Vektoren, z.B. I_ext=[0 0 0 0 0 1 1 1 1 1 0 0 0] function u=integrate(I_ext) %Festlegung von Parametern: C=1; R=25; dt=0.01; u(1)=0; % % % % Kapazitaet in pF Eingangswiderstand der Zelle in MOhm Zeitschritte in msec Ausgangspunkt des Membranpotentials anzpunkte=length(I_ext); %Laenge der Strominjektion bestimmen %Integration mit der Euler Methode: for t=2:anzpunkte u(t)=u(t-1)-dt*(u(t-1)/(C*R))+dt*(I_ext(t)/C); end Grundlage für die Modellierung von Einzelzellen: Passive Membran Integration mit passiver Membran: dU(t) U(t) Iext(t) I m(t) Iext(t) =+ =- . + dt CR C C C Diskrete Zeitschritte: U(t) I ext(t) U(t+1) = U(t)- t. . + t. CR C Schwelle: Simulationsparameter: Modellparameter: Δt U(t)>O, sonst C, RS(t)=0 S(t) =U(t=0), 1 wenn Erweiterung: Aktive Membran dU(t) C = -Im(t)-INa+(t)-IK(t)+I ext(t) dt Aktionspotentiale (Na und K+) Im(t)=gm(t) . (U(t)-Er) = U(t)/R INa(t)=gNa(t) .(U(t)-ENa) IK(t)=gK(t). (U(t)-EK) Ui innen im cm gm Er außen Ue iK gK EK iNa gNa ENa Hodgkin-Huxley: Bestimmung von gNa(t) und gK(t) mit Hilfe der Zustandsvariablen m, n und h Hodgkin-Huxley Gleichungen 4 gekoppelte Differentialgleichungen mit sehr vielen Parametern Compartmental Models Anatomie der Zelle wird nachgebildet Einzelne Abschnitte werden durch Kabeltheorie beschrieben In Abschnitten mit Spannungsabhängigen Prozessen werden Hodgkin-Huxley Gleichungen verwendet. Sehr exakte Beschreibung des Neurons mit sehr vielen Parametern Von der passiven Membran zu Integrate & Fire Theorie: Different Integration mit passiver Membran: dU(t) U(t) Iext(t) =- . + dt CR C Diskrete Zeitschritte: innen; Ui ie ic Rm Cm ie außen; Ue U(t) I ext(t) U(t+1) = U(t)- t. . + t. CR C Idee: Nur Zeitpunkte der Spikes modellieren Umsetzung: Schwelle S(t) = 1 wenn U(t)>θ, sonst S(t)=0 ir U(t) U (t) m ER Matlab-Simulation eines Integrate & Fire Neurons function s=integrate_and_fire(I_ext) %Festlegung von Parametern: C=1; % Kapazitaet in pF R=25; % Eingangswiderstand der Zelle in MOhm dt=0.01; % Zeitschritte in msec u(1)=0; % Ausgangspunkt des Membranpotentials theta=10; % Feuerschwelle in mV anzpunkte=length(I_ext); %Laenge der Strominjektion bestimmen %Integration mit der Euler Methode: for t=2:anzpunkte u(t)=u(t-1)-dt*(u(t-1)/(C*R))+dt*(I_ext(t)/C); if u(t)>theta % Wenn die Feuerschwelle ueberschritten ist s(t)=1; % wird ein Spike ausgeloest u(t)=u(1); % und das Membranpotential zurueckgesetyt else % sonst s(t)=0; % wird kein Spike ausgeloest. end end Erweiterungen des Integrate & Fire Modells Die Standardform des Integrate & Fire Modells kann zwar viele Aspekte des neuronalen Feuerverhaltens nachbilden, hat aber auch viele Nachteile. Deshalb gibt es als phänomenologische Erweiterungen z.B.: Absolute Refraktärzeit (if-Abfrage, die erneuten Spike in der Refraktärzeit verhindert) Relative Refraktärzeit (z.B. indem die SpikeWahrscheinlichkeit nach Ende der absoluten Refraktärzeit exponentiell ansteigt) Adaptation (z.B. durch Modellierung von Hyperpolarisation nach Auftreten eines Spikes) Stochastische Antworten (z.B. durch eine auf das Membranpotential addierte Zufallszahl) Netzwerke aus Integrate & Fire Neuronen Integrate & Fire Modelle sind einfach genug, um auch große neuronale Netze zu simulieren Künstliche neuronale Netze sind an synaptisch miteinander verkoppelte Neurone angelehnt Es wird ein gekoppeltes Gleichungssystem aufgestellt, bei dem für jedes Neuron die Feuerrate berechnet wird Als Input werden zusätzlich zum injezierten Strom Iext(t) synaptische Eingangssignale verwendet: wij⋅fj(t) dU(t) U(t) Iext(t) i i =- . + +∑ dt CR C j C Netzwerke aus Integrate & Fire Neuronen wij⋅fj(t) dU(t) U(t) Iext(t) i i für jedes Neuron i: =- . + +∑ dt CR C j C diskret: U(t) I ext (t) w ij⋅fj(t) i . U(t+1) = U(t)+Δt + + i ( ) ∑ i C .R C j C prä1 synaptisch postsynaptisch 2 i 3 4 wij: synaptisches Gewicht von Neuron j zu Neuron i fj(t)=g(Uj(t)): Antwort von Neuron j, ermittelt mit stationärer Nichtlinearität g Idee künstlicher neuronaler Netze Weitere Vereinfachung der Aktivität von Neuron i: Membraneigenschaften werden vernachlässigt Zeitpunkte einzelner Aktionspotentiale unwichtig häufig auch keine Strominjektion vorgesehen rein phänomenologische Betrachtung der Spikeraten zeitlich diskrete Berechnung prä1 synaptisch postsynaptisch 2 i 3 4 Formel reduziert sich zu: fi(t+1)=g(∑w ij⋅fj(t)) j Notwendige Wahl: Aktivierungsfunktion 1 Parameter pro Verbindung Bedeutung der Parameter künstlicher neuronaler Netze fi(t+1)=g(∑w ij⋅fj(t)) j Die Funktion g setzt die gewichtete, summierte Aktivität der präsynaptischen Neurone in eine Feuerrate um. Normalerweise ist g nichtlinear, z.B. eine Sigmoidfunktion. Das synaptische Gewicht wij fasst alle Aspekte synaptischer Übertragung zusammen, z.B.: Die Anzahl Vesikelbindungsstellen Die Wahrscheinlichkeit der Transmitterfreisetzung Den postsynaptischen Effekt eines Transmitterquantum Excitation: wij>0, Inhibition: wij<0 Ziel der meisten Studien: Finden optimaler wij bei festem g Grundlegende Verschaltungen: 1:1-Verschaltung präsynaptisch postsynaptisch + - + - Bedeutung: 1. Prä- und postsynaptische Zelle haben gleiche rezeptive Felder 2. Topologie-erhaltende Abbildung des Reizortes Die Aktivität eines präsynaptischen Neurons wird gewichtet an ein postsynaptisches Neuron übertragen Dabei kann durch Inhibition eine Vorzeichenumkehr stattfinden Grundlegende Verschaltungen: Konvergenz präsynaptisch postsynaptisch +- +- Bedeutung: 1. Räumliche Vergrößerung des rezeptiven Feldes 2. Komplexe Struktur des rezeptiven Feldes 3. Zeitlicher Vergleich der Inputs möglich 4. Erhöhte Zuverlässigkeit bei redundanten Inputs Die Aktivität mehrerer präsynaptischer Neuronen wird durch ein postsynaptisches Neuron integriert Die synaptischen Verbindungen können unterschiedlich stark sein Excitation und Inhibition (auch shunting inhibition) können gemischt auftreten Das postsynaptische Neuron nimmt eine “Mittelung” der gewichteten präsynaptischen Aktivitäten vor In biologischen neuronalen Netzen ist die Interaktion nichtlinear Konvergenz: Integration vs Koinzidenzdetektion präsynaptisch postsynaptisch +- +- z.B. Ermittlung von Reizintensität durch zeitliche Integration im visuellen Cortex z.B. Vergleich zwischen Ohren bei Richtungshören im auditorischen Cortex Zusätzlich zur räumlichen hat Konvergenz auch eine zeitliche Komponente Wichtiger Parameter: Zeitskala der Konvergenz lange Integrationszeiten bedeuten zeitliche Integration => Ratencode kurze Integrationszeiten ermöglichen Koinzidenzdetektion => Zeitcode Grundlegende Verschaltungen: Divergenz präsynaptisch postsynaptisch + - + - Bedeutung: 1. Mehrere präsynaptische Neurone mit gleichem rezeptiven Feld 2. Erhöhte Zuverlässigkeit der Populationsantwort bei unzuverlässigen Synapsen Die Aktivität eines präsynaptischen Neurons wird an mehrere postsynaptische Neurone weitergegeben Die synaptischen Verbindungen können unterschiedlich stark sein In künstlichen neuronalen Netzen kann ein Neuron normalerweise sowohl erregende als auch hemmende Synapsen bilden Bei biologischen Neuronen ist nur für manche Transmitter Excitation und Inhibition möglich Grundlegende Verschaltungen: Vorzeichenumkehr präsynaptisch + postsynaptisch - + Bedeutung: 1. Möglichkeit, Excitation und Inhibition zu kombinieren 2. Hemmung eines “Gegenspielers” bewirkt indirekte Verstärkung Die Aktivität eines präsynaptischen Neurons wird sowohl direkt an postsynaptische Neurone, als auch an postynaptische Interneurone weitergegeben, die bei der weiteren Verschaltung das Vorzeichen umkehren Grundlegende Verschaltungen: komplette Vernetzung präsynaptisch Alle präsynaptischen Neuron sind mit allen postsynaptischen verbunden postsynaptisch Synaptische Gewichte können unterschiedlich und Excitation und Inhibition gemischt sein (soweit Transmitterausstattung biologischer Neurone das zulässt) Bedeutung: 1. Postsynaptische Zellen können komplexe rezeptive Felder haben 2. Vorteile von Konvergenz und Divergenz werden kombiniert Normalfall für künstliche neuronale Netze, die häufig mit zufällig gewählten Gewichten einer kompletten Vernetzung initialisiert werden Grundlegende Verschaltungen: Reziproke Vernetzung (Feedback) Selbsterregung Selbsterregung Selbsthemmung + + - + - Bedeutung: 1. Aktivität hängt nicht nur von sensorischen Inputs ab 2. Es können sich typische Aktivitätsmuster entwickeln 3. Besonders wichtig bei Taktgeber-Netzwerken Zwei Neurone sind wechselseitig miteinander verschaltet Information fließt im Kreis, Neurone sind also gleichzeitig präund postsynaptisch zu sich selbst z.B. Stomatogastrisches Ganglion: Grundlegende Verschaltungen: Rekurrente Vernetzung (Feedback) Allgemeiner Fall des Feedbacks Mehrere Neurone sind im Kreis miteinander verbunden Es gibt also keine eindeutig geschichtete Struktur Bedeutung: 1. Netzwerk-intrinsische Aktivität überlagert stimulus-getriebene 2. Definition von rezeptiven Feldern wird schwierig (oder unmöglich) Alle Kombinationen aus Erregung und Hemmung sind möglich Neurone können an mehreren Feedback-Schleifen beteiligt sein Normalfall kortikaler Verarbeitung Bei künstlichen neuronalen Netzen sehr mächtig, aber schwer analysierbar Der Normalfall: Kombination vieler Möglichkeiten Zusammenfassung: Vergleich der Modelle künstl. NN Integrate & Fire Komplexität 1 Parameter pro Synapse 1 DGL 4 Parameter Reproduziert nur Feuerraten nur SpikeZeitpunkte typische technische Anwendung, Fragestellung grosse Netze Netzwerk Netzwerke, neuronales Rauschen Hodgkin & Huxley Compartment Models 4 DGL > 20 Parameter Verlauf des Membranpotentials im Soma je nach Größe sehr viele DGL und Parameter räumlich aufgelöster Membranpotentialverlauf Einfluss von Ionen, Adaptation dendritische Integration Einzelzelle anding how e mysteries ol in ve levels of key to success. main levels odels e based on on how the butes to its extend the hematically eads asymws dendrites tivation patfor motion nt conductl integration —the ‘‘como solve the equations. e than 1000 e the cell’s to simulate eurons) (4). te testable Literaturtipp Downloaded from www.sciencemag.org on November 24, 2006 s highly efficiently, often close to their p intensity and light contrast (42) and the generic limits (56). Indeed, Barlow’s ‘‘efficient nature of adaptation in the retina (43). New Level V: Black-Box Models analysis tools have opened up the possibility of Last but not least, one may want to understand hypothesis’’ suggests that neurons optimize using multiple parallel linear filters in an LN and quantify the signal-processing capabilities of formation about frequently occurring stimu Theoretical studies have shown how ind cascade to investigate, for example, complex a single neuron without considering its biocells in visual cortex (44) and thus improve on physical machinery. This approach may reveal neurons may shift their input-output curves t general principles that explain, for example, that goal (23). Moreover, recordings of a m classical energy-integration models (45). Extending LN cascades allows one to capture where neurons place their operating points and sensitive neuron in the fly visual system rev additional neural characteristics while retaining the how they alter their responses when the input adaptation can modify a neuron’s input function to maximize information abou ability to fit these more complex models to ex- statistics are modified. varying sensory stimuli ( perimental data. To reveal filter this case, however, it is p mechanisms that are otherwise that the adaptive mechan hidden by spike-time jitter, one not implemented on the may append a noise process to cell level but instead the cascade (46, 47) or measure from the underlying m spike probabilities instead of lular Reichardt motion spike times (48). For the latter tion circuitry (59, 60). S method, temporal resolution is ambiguities between sin limited only by the precision of and network adaptation stimulus presentation so that in the auditory midbrain parameters of more elaborate Evolutionary adaptatio models (e.g., LNLN cascades) not be guided to optimize can be obtained. formation about all natura The analog output of tradili. In acoustic commun tional cascade models describes systems, for example, ne a firing rate. An important consponses are well matc ceptual extension is therefore particular behaviorally r achieved by adding an explicit subensembles. Most likely spike generation stage. Using a li from those ensemble fixed firing threshold and feedselected as communicati back mimicking neural refracFig. 3. Single-neuron computation. The neuron in the center (86) can be apnals because they lead to e toriness (49), this has led to a proximated by an NLN cascade (left) for stationary inputs (67), or, more generally, by neural representations (62 successful model of spike timing a compartmental model (right). The cascade (level IV) is equivalent to a two-layer in early vision (50). Even when augmented with an integrate- feedforward network and shows that under a firing-rate assumption, a single neuron Challenges and-fire mechanism and intrinsic may perform the function of an entire artificial neural net. Electrical couplings within ‘‘A good theoretical mod compartmental models (levels I and II) are bidirectional. The right model therefore complex system should b bursting, this model structure still corresponds to a feedback network and can exhibit persistent activity, hysteresis, good caricature: it should allows generic fits to measured periodic oscillations, and even chaos. These phenomena are impossible in size those features which a spike trains (51). feedforward systems and may support complex computations in the time domain. Cascade models can also The relevance of either model depends on the statistics of synaptic inputs (i.e., on important and should do the inessential details. N directly translate into specific the neural code of the investigated brain area). only snag with this advice computations: Experiments inone does not really know dicate that in locusts, an identiFor such questions about neural efficiency are the inessential details until one has und fied neuron multiplies the visual size x and angular velocity y of an object while tracking and adaptability, a neuron is best regarded as a the phenomena under study’’ (64). This general dilemma, formulated its approach (52). The nearly exponential shape black box that receives a set of time-dependent of this neuron’s output curve suggests that inputs—sensory stimuli or spike trains from physicist Frenkel almost a century ago, ap A.V.M. Herz, T. Gollisch, C.M. Machens, D. Jaeger: “Modeling Single-Neuron Dynamics and Computations: A Balance of Detail and Abstraction” Science 314:80-85, 2006 Welches Modell? Das Modell muss der Fragestellung angepasst sein: Werden Intrazellulär- oder Extrazellulär-Daten reproduziert? Ist die Zeitstruktur des unterschwelligen Membranpotentials oder die Spikeform wichtig? Möchte man Aussagen über die Entstehung eines Phänomens machen? Die Simulation muss den technischen Möglichkeiten entsprechen. Goldene Regel: So wenige Parameter wie möglich, aber so viele wie nötig!