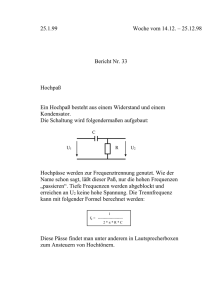

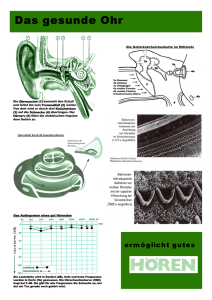

Diskretfrequente Synthese von Nachhall-Prozessen

Werbung