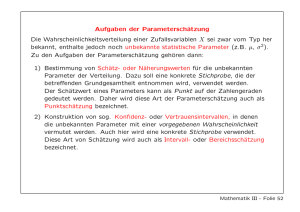

PARAMETERSCH ¨ATZUNG 1. Punktschätzung Bisher waren die

Werbung

PARAMETERSCHÄTZUNG 1. Punktschätzung Bisher waren die Wahrscheinschlichkeitsverteilungen der Zufallsvariablen stets bekannt, so dass wir Aussagen über die Wahrscheinlichkeiten von Werten bzw. Wertebereichen treffen konnten. In der Praxis ist es jedoch meistens umgekehrt; es liegen gemessene Werte vor, aber die zugehörige Verteilung ist weitestgehend unbekannt. Da die Anzahl der beobachteten Werte in der Regel jedoch zu niedrig ist, um die Verteilung genau zu schätzen, muss man sich damit begnügen, Verteilungsparameter wie Erwartungswert oder Varianz zu schätzen. Für viele Zwecke ist dies jedoch ausreichend, da man häufig das statistische Modell kennt und somit die konkrete Verteilung durch diese Parameter eindeutig bestimmt ist (z.B. die Normalverteilung N (µ, σ 2 )). Definition: Die Angabe eines solchen Schätzwertes für einen Verteilungsparameter heißt eine Punktschätzung. Die Menge aller zugrundeliegenden potentiellen Untersuchungsobjekte bezeichnet man als Grundgesamtheit. Eine zufällige Auswahl von Untersuchungsobjekten aus der zugrundeliegenden Grundgesamtheit nennt man eine Stichprobe. Aus pragmatischen Gründen wird normalerweise nicht die ganze Grundgesamtheit, sondern eine repräsentative Stichprobe untersucht. An ihr wird dann (repräsentativ) eine gewisse Zufallsvariable X gemessen. Dies liefert eine Messreihe x1 , . . . , xn . Ist der Kontext klar, spricht man bei der Messreihe ebenfalls häufig von einer Stichprobe. Statt nun aber jeden dieser Werte als Realisation einer Zufallsvariablen zu verstehen, ist es häufig nützlich, die Werte als Realisationen von n verschiedenen (identisch verteilten, unabhängigen) Zufallsvariablen zu interpretieren. Definition: Es seien X1 , . . . , Xn : Ω → R unabhängige und identisch verteilte Zufallsvariablen. Dann nennen wir X1 , . . . , Xn Stichprobenvariablen und jedes n-Tupel von Werten/Realisationen x1 , . . . , xn ein Stichprobenergebnis oder eine Messreihe der Länge oder des Umfangs n. Eine Funktion T (X1 , . . . , Xn ) der Stichprobenvariablen heißt Schätzfunktion für einen Verteilungsparameter θ, falls ihr Wert θ̂ als Schätzwert für θ verwendet wird. T heißt erwartungstreue Schätzfunktion für θ, wenn E(T ) = θ gilt, und T heißt konsistent, falls die Varianz von Tn = T (X1 , . . . , Xn ) beliebig klein wird, d.h. falls limn→∞ V (Tn ) = 0 ist (hierbei wird angenommen, dass T für jede Anzahl von Stichprobenvariablen definiert ist). Beispiel: Es sei µ der gemeinsame Erwartungswert und σ 2 die Varianz Pnder Stichprobenvariablen X1 , . . . , Xn . Dann hat das Stichprobenmittel X̄ = 1/n i=1 Xi den Erwartungswert E(X̄) = µ und die Varianz V (X̄) = σ 2 /n (vgl. Zentralen Grenzwertsatz), d.h. X̄ ist eine erwartungstreue und konsistente Schätzfunktion für den Erwartungswert µ von X. Auch Schätzfunktionen sind Zufallsvariablen. Ihr Wert kann jedoch erst berechnet werden, wenn die Stichprobenvariablen gewisse Werte angenommen haben, d.h. wenn eine Messreihe vorliegt. Mithilfe eines Stichprobenergebnisses, also einer Messreihe, kann sogar eine Näherungsfunktion für die unbekannte Verteilungsfunktion konstruiert werden. Hierzu betrachtet man die zufällige Auswahl Y eines Wertes dieser Messreihe als Zufallsvariale und bezeichnet die zughörige Verteilung von Y als empirische Verteilung. Dann ist beispielsweise P Pnder Erwartungswert der empirischen Verteilung E(Y ) = n x · 1/n = 1/n i i=1 i=1 xi gerade das arithmetische Mittel der Messreihe, d.h. E(Y ) ist immer gleich dem Wert, den das Stichprobenmittel X̄ annimmt. Wir folgen daher mit unserem Schätzwert für den Erwartungswert dem folgenden Prinzip. Allgemeines Schätzprinzip: Ein unbekannter Parameter der Verteilungsfunktion der Stichprobenvariablen kann durch den entsprechenden Parameter der empirischen Verteilung geschätzt werden. Beispiel: Bei der Varianz weichen wir allerdings etwas vom allgemeinen Schätzprinzip Verteilung ist gegeben durch V (Y ) = Pn ab. Die Varianz der empirischen Pn 1/n i=1 (xi −x̄)2 mit x̄ = 1/n i=1 xi . Dies ist gerade der Wert der Schätzfunktion Pn 2 2 Ŝ 2 = 1/n i=1 (Xi −X̄)2 . Allerdings kann man zeigen, dass E(Ŝ 2 ) = n−1 n σ , d.h. Ŝ n 2 2 ist nicht erwartungstreu für die Varianz. Dies lässt sich beheben durch S = n−1 Ŝ . n n n n−1 2 2 2 Dann ist nämlich E(S 2 ) = E( n−1 Ŝ 2 ) = n−1 E(Ŝ 2 ) = n−1 n σ = σ und somit S 2 erwartungstreu für σ . Als √ Schätzfunktion für die Standardabweichung σ verwendet man entsprechend S = S 2 . Diese ist in der Regel ebenfalls nicht erwartungstreu. Bemerkung: einer Messreihe x1 , . . . , xn wurde im letzten Semester Pn Die Varianz 1 2 durch n−1 (x −x̄) definiert. Dies entspricht dann gerade dem Wert der obigen i=1 i (erwartungstreuen) Schätzfunktion S 2 für σ 2 . Zusammenfassung: Anhand einer Stichprobe/Messreihe x1 , . . . , xn mit zugrundeliegender Zufallsvariable X schätzen wir: Pn • den Erwartungswert E(X) mithilfe der Schätzfunktion X̄ = 1/n i=1 Xi , Pn d.h. über das arithmetische Mittel x̄ = 1/n i=1 xi der Messreihe, Pn 1 2 • die Varianz V (X) mithilfe der Schätzfunktion S 2 = n−1 i=1 (Xi − X̄) , P n 1 2 2 d.h. über die Varianz s = n−1 i=1 (xi − x̄) der Messreihe (wie sie im letzten Semester definiert p wurde), √ • die Standardabweichung V (X) mithilfe der Schätzfunktion S = S2, √ 2 d.h. über die Standardabweichung s = s der Messreihe. Eine weitere Schätzmethode ist die Maximum-Likelihood-Schätzung . Ihr zugrunde liegt der Ansatz eine Schätzgröße zu verwenden, so dass die Messung der vorliegenden Messwerte am wahrscheinlichsten wird. Ist hierbei die zugrundeliegende Zufallsvariable X diskret mit Wahrscheinlichkeitsverteilung f = fθ , d.h. sie hängt von einem unbekannten Parameter θ ab, so hängt für eine Messreihe x1 , . . . , xn die Wahrscheinlichkeit P (x1 , . . . , xn ) = P (x1 , . . . , xn )(θ) von θ ab und man erhält die sogenannte Likelihood-Funktion L(θ) = P (x1 , . . . , xn )(θ) = fθ (x1 ) · · · fθ (xn ). In der Praxis gibt es hierbei dann meistens genau eine Maximumsstelle θ̂, welche dann als Schätzwert für θ verwendet wird. Im stetigen Fall geht man genauso vor und nimmt für die Likelihood-Funktion einfach die Dichte statt der Wahrscheinlichkeitsverteilung, d.h. ist X stetig mit Dichte f = fθ , so ist die Likelihood-Funktion gegeben durch L(θ) = fθ (x1 ) · · · fθ (xn ). Beispiel: Ist X Poisson-verteilt nach Pθ , d.h. fθ (x) = dann ist für eine gegebene Messreihe x1 , . . . , xn θx x! e−θ für x ∈ N und θ > 0, θx1 −θ θxn −θ e ·...··· e x1 ! xn ! θx1 +...+xn −nθ e = x1 ! · . . . · xn ! θnx̄ e−nθ . = x1 ! · . . . · xn ! L(θ) = Um nun das Maximum von L(θ) zu finden, nutzt man aus, dass der Logarithmus streng monoton wachsend ist und daher θ̂ genau dann ein Maximum von L(θ) ist, wenn θ̂ ein Maximum von ln(L(θ)) ist. Mithilfe der Rechenregel ln(ab) = ln(a) + ln(b), ln(a/b) = ln(a) − ln(b) und ln(ab ) = b ln(a) erhält man dann θnx̄ −nθ e ln(L(θ)) = ln x1 ! · . . . · xn ! = ln θnx̄ e−nθ − ln(x1 ! · . . . · xn !) = ln(θnx̄ ) + ln(e−nθ ) − ln(x1 ! · . . . · xn !) = nx̄ ln(θ) − nθ − ln(x1 ! · . . . · xn !), also ist d nx̄ ln(L(θ)) = −n dθ θ und man erhält als einzige Nullstelle der Ableitung, d.h. als einzigen Kandidaten d2 nx̄ für eine Extremstelle θ̂ = x̄. Wegen dθ 2 ln(L(θ)) = − θ 2 < 0 handelt es sich bei θ̂ auch tatsächlich um ein Maximum, d.h. x̄ ist (auch) nach der Maximum-LikelihoodMethode der Schätzwert für den unbekannten Parameter θ. Das hätte uns in diesem Fall, wegen E(X) = θ, allerdings auch das allgemeine Schätzprinzip geliefert. 2. Intervallschätzung Bei der Punktschätzung versucht man einen konkreten Wert für einen unbekannten Parameter zu schätzen. Eine andere Form der Parameterschätzung besteht darin, dass man gerne ein Intervall angeben würde, in dem der unbekannte Parameter sicher liegt. Wie wir in Beispiel 4 der Vorlesung gesehen haben, ist dies gelegentlich auch möglich, in den meisten Fällen muss man sich jedoch mit einem Intervall zufrieden geben, das den unbekannten Parameter (lediglich) mit hoher Wahrscheinlichkeit enthält. Ziel: Angabe des Fehlers einer Schätzgröße θ̂ für einen Parameter θ mit einer Sicherheit von mindestens β. Dabei bedeutet - Fehler ≤ d: θ ∈ [θ̂ − d, θ̂ + d], - Sicherheit von mindestens β: P (θ ∈ [θ̂ − d, θ̂ + d]) ≥ β Definition Eine Intervallschätzung für einen Parameter θ ist die Angabe eines (minimalen und um den Schätzwert θ̂ symmetrischen) Intervalls I, in dem θ mit Sicherheit ≥ β liegt, d.h. P (θ ∈ I) ≥ β für β ∈ (0, 1). Ein solches Intervall I mit P (θ ∈ I) = β nennt man dann ein Konfidenzintervall zum Konfidenzniveau β. Je nachdem was man über die zugrundeliegende Verteilung weiß und je nach Fragestellung, gibt es verschiedene Vorgehensweisen bei der Bestimmung des Konfidenzintervalls oder des Konfidenzniveaus. Wir diskutieren hier im Folgenden exemplarisch den Fall einer Messreihe x1 , . . . , xn mit zugrundeliegender Normalverteilung X ∼ N (µ, σ 2 ). Schätzung von µ 1. Fall: σ bekannt. Problem A: Gegeben sei das Konfidenzniveau β und gesucht sei der Fehler d vom Schätzwert µ̂ = x̄. Wie in der Vorlesung ausführlich diskutiert nutzt man hier aus, dass das arithmePn 2 tische Mittel X̄ = 1/n i=1 Xi ∼ N (µ, σn ) normalverteilt, bzw. die standardisierte X̄−µ √ ∼ N (0, 1) standardnormalverteilt ist. Für d > 0 erhält man dann Variable σ/ n leicht √ √ x̄ − µ d n d n √ ∈ − µ ∈ [x̄ − d, x̄ + d] ⇐⇒ , . σ σ σ/ n Wie wir in der Vorlesung gesehen haben, führt dann die Gleichung P µ ∈ [X̄ − d, X̄ + d] = P √ √ d n d n X̄ − µ √ ∈ − , =β σ σ σ/ n unter Aussnutzung der√Symmetrie der Dichte der Standardnormalverteilung mit α = 1−β darauf, dass d σ n gerade das (1− α2 )-Quantil der Standardnormalverteilung N (0,1) sein muss, das man üblicherweise mit z1− α2 bezeichnet (statt mit ξ1− α ). Also muss 2 d = z1− α2 · √σn gelten. Ergebnis: Das symmetrische Konfidenzintervall zum Konfidenzniveau β ist gegeben durch [x̄ − d, x̄ + d] mit d = z1− α2 · √σn und α = 1 − β. Beispielaufgabe: Bei einem Versuch wurde die Reaktionszeit von 80 zufllig ausgewhlten Personen auf ein bestimmtes visuelles Signal gemessen. Die hierbei ermittelte durchschnittliche Reaktionszeit lag bei 0.8 Sekunden. Geben Sie unter der Annahme, dass die die Reaktionszeit beschreibende Zufallsvariable normalverteilt mit einer Varianz von 0.04 ist, ein 95%-iges Konfidenzintervall (oder Konfidenzintervall zum Konfidenzniveau von 95%) fr den Erwartungswert der Zufallsvariablen an. Antwort: Es handelt sich beim Typ der Aufgabenstellung um Problem A, die allgemeine Formel für das Konfidenzintervall (KI) ist demnach σ σ α α √ √ KI : x̄ − z1− 2 · , x̄ + z1− 2 · n n Der Aufgabenstellung entnimmt man: n = 80 und σ 2 = 0.04, also σ = 0.2. Wegen β = 0.95, ist dann α = 1 − β = 0.05, d.h. 1 − α2 = 0.975, und somit erhält man mithilfe der Wertetabelle der Standardnormalverteilung: z1− α2 = z0.975 = 1.96 Mit x̄ = 0.8 und σ = 0.2 also σ 0.2 x̄ − z1− α2 · √ = 0.8 − 1.96 · √ = 0.75617 n 80 und analog σ 0.2 x̄ + z1− α2 · √ = 0.8 + 1.96 · √ = 0.84382 n 80 Also ist [0.75617, 0.84382] das gesuchte Konfidenzintervall. Problem B: Gegeben sei der Fehler d von x̄ und gesucht sei das zugehörige Konfidenzniveau β. Lösung: Aus der obigen Rechnung zu Problem A folgt, dass β =√ 1 − α das zugehörige Konfidenzniveau ist, falls man α so wählt, dass z1−α/2 = d σ n ist. Problem C: Gegeben seien nun das Niveau β sowie der Fehler d und gesucht sei der Umfang n der Messreihe, so dass das entsprechende Konfidenzintervall höchstens die Länge 2d hat. Lösung: Hierfür löst man einfach die Gleichung d = z1− α2 √σn nach n auf und erhält die Bedingung n ≥ (z1−α/2 σd )2 . In der Praxis ist der Umfang der Stichprobe meistens vorgegeben. Will man daher ein kleines Konfidenzintervall/eine große Sicherheit, so muss man sich mit geringer Sicherheit/einem großen Konfidenzintervall zufrieden geben. 2. Fall: σ unbekannt. In diesem Fall ersetzt man σ 2 durch die Schätzung n 1 X σ̂ 2 = s2n = (xi − x̄)2 , n − 1 i=1 also durch die Stichprobenvarianz. Statt der N (0, 1)-verteilten Zufallsvariablen erhält man dann die Zufallsvariable X̄ − µ √ Tn−1 = sn / n X̄−µ √ σ/ n p mit sn = s2n . Die Zufallsvariable Tn−1 ist ebenfalls symmetrisch um 0 verteilt. Die entsprechende Verteilung nennt man die tn−1 -Verteilung oder Student-Verteilung mit n − 1 Freiheitsgraden. Man erhält nun völlig analog zum ersten Fall z.B. das symmetrische Konfidenzintervall zum Niveau β = 1 − α durch [x̄ − d, x̄ + d] mit sn d = tn−1;1−α/2 · √ , n wobei hier tn−1;1−α/2 das (1 − α/2)-Quantil der tn−1 -Verteilung bezeichnet. Diese Quantile entnimmt man dann wieder der entsprechenden Tabelle (s. Homepage). Die restlichen Problemstellungen werden ebenfalls völlig analog behandelt. Neben dem Erwartungswert bestimmt auch die Varianz die Normalverteilung. Wir müssen uns daher auch Gedanken zu ihrer Schätzung machen. Schätzung von σ 2 Es sei wieder x1 , . . . , xn eine Messreihe mit X ∼ N (µ, σ 2 ) und s2n bezeichne wieder die Varianz derP empirischen Verteilung, welche wir als Realisation der Schätzn 1 2 2 2 funktion S 2 = n−1 i=1 (Xi − X̄) deuten. Wie wir gesehen haben, gilt E(S ) = σ 4 2σ , d.h. S 2 ist eine erwartungstreue und konsistente Schätzfunktion und V (S 2 ) = n−1 2 2 für σ . Die Zufallsvariable n−1 σ 2 S folgt einer besonderen Verteilung, der sogenann2 ten χ -Verteilung mit n − 1 Freiheitsgraden (kurz: X ∼ χ2n−1 ). Bemerkung: Die χ2 -Verteilung geht zurück auf Helmert und die zugrundeliegende Beobachtung ist die folgende: Sind X1 , . . . ,P Xf unabhängige Zufallsvariablen, die n alle standardnormalverteilt sind, so ist χ2 = i=1 Xi2 nicht normalverteilt, sondern besitzt eine Verteilung mit Dichte ( 0, x < 0, g(x) = f −2 1 −x/2 , x ≥ 0. x 2 e 2f /2 Γ(f /2) R∞ mit der Gammafunktion Γ(s) = 0 e−t ts−1 dt, d.h. die Verteilungsfunktion der χ2f -Verteilung ist ( 0, x < 0, R x f −2 −t/2 Fχ2f (x) = 1 t 2 e dt, x ≥ 0. 2f /2 Γ(f /2) 0 Auch hierzu gibt es Tabellen für ausgewählte Freiheitsgrade bzw. Tabellen für die entsprechenden Quantile χ2n−1;γ . Als Anwendung der χ2 -Verteilung werden wir später noch den χ2 -Test kennenlernen, mit dem man überprüfen kann welcher Verteilung eine Zufallsvariable folgt. Um nun ein Konfidenzintervall für σ 2 zum Konfidenzniveau β = 1 − α zu be2 stimmen, verwenden wir die χ2n−1 -verteilte Zufallsvariable n−1 σ 2 S . Per Definition der Quantile gilt dann α =P 2 sowie n−1 2 S ≤ χ2n−1; α2 σ2 =P n−1 2 S ≤ σ2 χ2n−1; α 2 ! α 1− =P 2 n−1 2 S ≤ χ2n−1;1− α2 σ2 =1−P n−1 2 S ≥ χ2n−1;1− α2 σ2 bzw. α =P 2 n−1 2 S ≥ χ2n−1;1− α2 σ2 ! n−1 =P 2 χ2n−1;1− α S ≥σ 2 . 2 Daraus erhalten wir das Konfidenzintervall " # n−1 2 n−1 2 s , 2 s , χ2n−1;1− α χn−1; α 2 2 2 wobei hier s wieder die konkrete Realisation der Schätzfunktion S 2 , also die Stichprobenvarianz, bezeichnet.