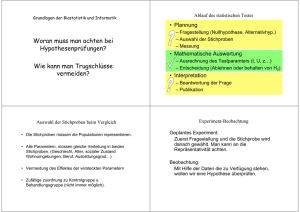

Skript zur "Einführung in die Statistik"

Werbung