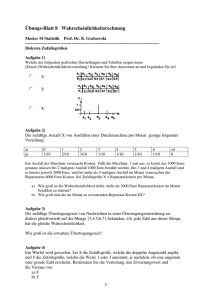

Vorlesung Mathematik für Informatiker 3 Wahrscheinlichkeitstheorie

Werbung