EXPERIMENTELLE PHYSIK IV Statistik-Thermodynamik

Werbung

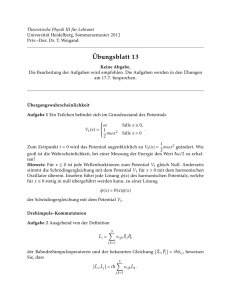

EXPERIMENTELLE PHYSIK IV Statistik-ThermodynamikFestkörperphysik Skriptum zur Vorlesung von Hrn. Prof. Pfeiler Sebastian Stefanitsch, Manuel Bahr Skript großteils übernommen von SS07, Georg Kopsky Inhaltsverzeichnis 1 Statistische Physik 1.1 Elementare Statistik und Wahrscheinlichkeitsverteilung . . . . . . . . . . . . . . 1.1.1 Grundgriffe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1.1.2 Die eindimensionale Zufallsbewegung (random walk → Diffusion) . . . 1.1.3 Mittelwertbildung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1.1.4 Die Gauß’sche Wahrscheinlichkeitsverteilung . . . . . . . . . . . . . . . 1.2 Statistik von Vielteilchensystemen . . . . . . . . . . . . . . . . . . . . . . . . . . 1.2.1 Mikroskopische Beschreibung des Systemzustandes, Zustandsraum . . . 1.2.2 statistisches Ensemble und Makrozustände . . . . . . . . . . . . . . . . . 1.2.3 Das grundlegende Postulat . . . . . . . . . . . . . . . . . . . . . . . . . . 1.2.4 Mikrokanonische Zustandssumme und Berechnung der Wahrscheinlichkeit makroskopischer Parameter . . . . . . . . . . . . . . . . . . . . . . . 1.2.5 Teilchen im 3-dimensionalen Kasten . . . . . . . . . . . . . . . . . . . . 1.3 Thermische Wechselwirkung und repräsentative Ensembles physikalischer Systeme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1.3.1 Thermische Wechselwirkung zwischen makroskopischen Systemen . . . 1.3.2 Thermisches Gleichgewicht und Temperatur . . . . . . . . . . . . . . . . 1.3.3 statistische Physik und Thermodynamik . . . . . . . . . . . . . . . . . . 1.3.4 Systeme in Kontakt mit einem Wärmereservoir, kanonische Zustandssumme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1 2 2 2 5 9 13 17 17 21 22 22 25 27 27 31 33 36 1 Statistische Physik Nun wir haben uns im letzten Semester mit Systemen aus wenigen Teilchen beschäftigt (Atome, Systeme Nukleonen, Elementarteilchen) Statistische Physik beschäftigt sich aus Systemen mit vielen Teilchen (Gase, Flüssigkeiten, Photonensysteme) Wir unterscheiden zwischen mikroskopischen und makroskopischen Systeme: • mikroskopisches Systeme: Dimension ≤ 1µ m (Atomare Dimension) • makroskopisches Systeme: sichtbar im Licht Mikroskop (≥ µm);ein System das aus vielen Atomen und Molekülen besteht – makroskopische Parametern: Volumen, Temperatur, Druck, Magnetisierung Ereignis: Ergebnis einer Messung (des Zustands eines Systems) Beispiel: Energie eines Gasmolekühls (Energie in gew. ∆E, Druckmessung, Wurf eines Würfels) Ereignis ist zufällig wenn es unter gewissen Bedingungen eintritt oder nicht eintritt. Eine Größe (Variable) ist dann zufällig, wenn sie unter bestimmten Bedingungen nur vom Zufall abhängig ist. Zufällige Größen charakterisieren wir durch die Wahrscheinlichkeiten (W) mit der ihre Werte auftreten. Die statistische Methode untersucht welche Regelmäßigkeiten fallen bei solchen Vorgängen aus vielen zufälligen Einzelereignissen auf. 1.1 Elementare Statistik und Wahrscheinlichkeitsverteilung 1.1.1 Grundgriffe Für die statistische Beschreibung werden im allgemeinen sogenannte Ensembles verwendet: • Ensemble ist die Gesamtheit (= statistisches Kollektiv = Schar) einer großen Zahl N von gleichen präperierten (= gleichen Randbedingungen unterworfen) Systemen Frage: Mit welcher W tritt ein bestimmtes Ereignis auf? Entweder: • je eine Messung an N gleichartigen Systemen → Enseblemittel = Scharmittel oder • N Messungen am selben System → Zeitmittel Wenn der Systemzustand zeitunabhängig ist, dann folgt das beide Methoden gleichwertig sind. Ein System ist genau dann im Gleichgewicht (GG), wenn das zugehörige Ensemble zeitunabhängig ist. 2 M . . . Anzahl der Möglichkeiten einander ausschließender Ergebnisse N . . . Gesamtzahl der Messungen Nj . . . Anzahl der Messungen die das Ergebnis j liefern (j = 1, 2, . . . , M ) Definieren: • die relative Häufigkeit (für das Ergebnis j): hj = Nj N ≤1 Nj N →∞ N • statistische Wahrscheinlichkeit (für das Ergebnis j): Wj = lim hj (N ) = lim N →∞ M ≤1 N Es gilt: ∑ Nj = N ⇐⇒ jede Messung muss ein Ergebnis aus M liefern ⇒ ∑ hj = 1 j=1 j=1 Additions und Multiplikation von Wahrscheinlichkeiten Die Wahrscheinlichkeit für das Auftreten irgendeines von zwei einander ausschließenden Ereignissen i und j: Ni oder j = Ni + Nj ⇒ Wi oder j = Wi + Wj . . . Additionssatz (1.1) Wahrscheinlichkeit für das gleichzeitige oder hintereinander in Serie auftretender zweier Ereignisse i, j die voneinander unabhängig sind: Wi und j = Wi ⋅ Wj . . . Multiplikationssatz (1.2) Wenn wir keine weiteren Annahmen machen können, können wir auch keine Vorhersagen über das Auftreten der M Ereignisse machen. Wenn wir aber die Annahme machen, das gleiche Wahrscheinlichkeit für das Auftreten der M Ergebnisse (gleiche a priori ..von vornherein Wahrscheinlichkeit der Elementarereignisse) ⇒ Wj wird unabhängig von j: Wj = 1 M 1 = Anzahl der möglichen Ereignisse 3 Beispiel 1: Würfel: Anzahl der Ereignisse M = 6 = 1,2,3,4,5,6 Experiment: Machen 100 Würfe → 17 mal 6 ⇒ W6 = 48 Würfe mit Augenzahl ≤ 3 W≤3 = 48 100 17 100 = 0.17 = 0.48 Beispiel 2: 10 Kugeln in einer Schachtel: 5 Rote, 3 Grüne, 2 Blaue Fragen uns wie groß ist die Wahrscheinlichkeit dass beim wahllosen hineingreifen die grüne Kugel gezogen wird?: Annahme: Wahrscheinlichkeit ist für jede Kugel gleich groß → Additionssatz: Wgrün = 1 10 1 1 + 10 + 10 = 0.3 Wie groß ist die Wahrscheinlichkeit dass die Grüne oder Blaue erwischt wird?: Additionssatz: Wgrün = 0.3, Wblau = 0.2 → Wgrün + Wblau = 0.5 Wie groß ist die Wahrscheinlichkeit zuerst grün, dann blau? Wgr dann bl = Wgrün ⋅ Wblau = 0.3 ⋅ 0.2 = 0.06 − wenn grün zurück gelegt wird! Wenn grüne Kugel draussen: W → 1 9 ⇒ Wgr dann bl 4 = Wgrün ⋅ Wblau = 0.3 ⋅ 2 9 = 0.067 1.1.2 Die eindimensionale Zufallsbewegung (random walk → Diffusion) Wir haben ein Teilchen welches eine Verschiebung vom Ursprung (auf x-Achse) erfährt Nach N Verschiebungen der Länge l befindet sich das Teilchen dann an der Stelle x = m ⋅ l (m ganz, −N ≤ m ≤ N , −N wenn nur Linkssprünge, N wenn nur Rechtssprünge) Frage: Wahrscheinlichkeit PN (m), dass Teilchen nach N Verschiebungen an bestimmter Stelle x = m ⋅ l ist? n1 Verschiebung nach rechts n2 Verschiebung nach links N = n1 + n2 resultierende Verschiebung (in Einheiten von l): m = n1 − n2 ⇒ resultierende Verschiebung vom Ursprung: m = n1 − n2 = n1 − (N − n1 ) = 2n1 − N (1.3) Aus (1.3) folgt natürlich sofort, dass m (un)gerade ist ⇔ N (un)gerade ist. Unter der Annahme, dass aufeinanderfolgende Sprünge statistisch unabhängig sind und kein Einfluss der Vorgeschichte besteht, definieren wir uns p als die Wahrscheinlichkeit für einen Sprung nach rechts und q = 1 − p für dasselbe nach links. Für die Frage nach der Wahrscheinlichkeit einer bestimmten Abfolge von Sprüngen benötigen wir nach dem vorigen Abschnitt das Produkt der Wahrscheinlichkeiten: p ⋅ p⋯p ⋅ q ⋅ q⋯q = pn1 ⋅ q n2 ´¹¹ ¹ ¹ ¸ ¹ ¹ ¹ ¹ ¶ ´¹¹ ¹ ¹ ¸¹ ¹ ¹ ¹¶ n1 n2 (1.4) (Produktsatz kommt ins Spiel Abfolge von Rechtssprünge n1 & Linkssprünge n2 ) Jetzt kommt die Kombinatorik ins Spiel. Die Kombination von n Elementen zu je m Teilen ohne Berücksichtigung der Anordnung ist ja bekanntlich gegeben durch: n! n ( )= m m!(n − m)! (1.5) Frage: Wieviele Möglichkeiten gibt es, die Sprünge so auszuführen dass n1 nach rechts und n2 nach links? N! N! N ( )= = n1 n1 !(N − n1 )! n1 !n2 ! 5 (1.6) Die Wahrscheinlichkeit, also das Objekt nach insgesamt N Sprüngen an einer bestimmten Stelle zu finden ergibt sich durch das Produkt aus Anzahl der Möglichkeiten und Wahrscheinlichkeit der Abfolge: PN (m) = WN (n1 ) = N! n1 n2 n1 !n2 ! p q N = ( ) pn1 (1 − p)N −n1 n1 (1.7) Das ist die altbekannte Binomialverteilung. Durch n1 = 12 (N +m) und n2 = N −n1 = N − 21 N − 12 m = 12 (N −m) lässt sich (1.7) anschreiben als: PN (m) = N! ( N +m )! ( N −m )! 2 2 p N +m 2 (1 − p) N −m 2 (1.8) Ein Spezialfall, nämlich die Gleichverteilung folgt aus p = q = 12 : PN (m) = N! 1 N ( ) ( N +m )! ( N −m )! 2 2 2 6 (1.9) Näherungen: √ N! ≅ 2πN ( N! ≅ ( N N ) e √ N! ≅ 2πN ( Beispiel: N=3 zunächst Abfolgen der Sprünge: N N ) e . . . Sterling Näherung . . . für große N 1 N N ) ⋅ e 12N e (1.10) . . . für kleine N N! n1 !n2 ! 1. alle 3 nach rechts: 3! n1 = 3 ⇒ 3!0! =1 2. 2 nach rechts 1 nach links: 3! n1 = 2 ⇒ 2!1! = 6/2 = 3 3. 1 nach rechts 2 nach links: 3! n1 = 1 ⇒ 1!2! =3 4. Analog zu 1 jetzt: Wahrscheinlichkeit das Teilchen nach 3 Sprüngen x = ml, p = q = n1 = 0, 1, 2, 3 ⇒ m = 2n1 − N = −3, −1, 1, 3 1 3 3 1 ⇒ P3 (m) = W3 (n1 ) = , , , 8 8 8 8 P3 (−3) = 3! 1 3 1 ⋅ ( ) = 8 0! ( 62 )! 2 ´¹¹ ¹ ¹ ¸¹ ¹ ¹ ¹ ¶ =1 7 1 2 (1.11) (1.12) Die Wahrscheinlichkeit das es an der Stelle 0 ist, ist nach mehreren Sprüngen höher, für die gleiche Wahrscheinlichkeit von Rechts- und Linkssprüngen. Abbildung 1: Binomiale Wahrscheinichkeitsverteilung für p = 0.6 und q = 0.4, wenn N = 20. Der Graph zeigt wieder die Wahrscheinlichkeit W (n1 ) für n1 Rechsverschiebungen bzw. die Wahrscheinlichkeit P (m) für die resultierende Verschiebung von m Einheiten nach rechts. Die Mittelwerte m und (∆m)2 sind ebenfalls gegeben. 8 Abbildung 2: Die Binomialverteilung für p = q = 1/2 und N = 20. Das Diagramm zeigt die Wahrscheinlichkeit WN (n1 ) für n1 Rechtsverschiebungen bzw. die Wahrscheinlichkeit PN (m) für eine resultierende Verschiebung um m Einheiten nach rechts. 1.1.3 Mittelwertbildung Wir betrachten die Variable u, M diskrete Werte: u1 , u2 , u3 , . . . , uM und die zugehörigen Wahrscheinlichkeiten: P (u1 ), P (u2 ), P (u3 ), . . . P (uM ) Definition Mittelwert: u= ∑M i=1 P (ui )ui ∑M i=1 P (ui ) (1.13) ∑M i=1 P (ui )f (ui ) ∑M i=1 P (ui ) (1.14) Allgemein für eine Funktion f (u): f (u) = 9 Im Allgemeinen ist die Wahrscheinlichkeit normiert im Intevall [0, 1], sodass: M ∑ P (ui ) = 1 (1.15) i=1 wodurch der Nenner bei Gleichung (1.13) und (1.14) wegfällt. Für die Mittelwerte gilt: • f (u) + g(u) = f (u) + g(u) • cf (u) = cf (u), c ∈ R Der Mittelwert u ist das Maß für den zentralen Wert von u. Die ui sind um u gestreut. Sehen wir uns noch die Abweichung vom Mittelwert ∆u = u−u an, so ergibt sich für normierte: M M M ∆u = (u − u) = ∑ P (ui )(u − u) = ∑ P (ui )ui − u ∑ P (ui ) = u − u = 0 i=1 i=1 (1.16) i=1 ´¹¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¸¹¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¶ ´¹¹ ¹ ¹ ¹ ¹ ¹ ¹ ¸ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹¶ u 1 Daher benötigen wir eine Größe für die Abweichung. ⇒ Schwankungsquadrat (= Streuung = Varianz): M (∆u)2 = ∑ P (ui ) (ui − u)2 ≥ 0 ⇔ ui = u ´¹¹ ¹ ¸¹ ¹ ¹ ¶ i=1 ´¹¹ ¸¹¹ ¹ ¶ ´¹¹ ¹ ¹ ¹ ¹ ¹ ¹ ¸¹¹ ¹ ¹ ¹ ¹ ¹ ¹ ¶ ≥0 ≥0 ∀ui ≥0 = (u − u)2 = u2 − 2uu + (u)2 = u2 − 2ūū +(u)2 ° 2(u)2 = u2 − (u)2 Ô⇒ u2 ≥ (u)2 (1.17) Daraus folgt nun die Definition der Standardabweichung: ∆∗ u = ∆u = √ (∆u)2 mittlere quadratische Abweichung Man beachte, dass im Allgemeinen u2 ≥ (u)2 ist (siehe (1.17)). 10 (1.18) Anwendung der Mittelwertbildung auf die Zufallsbewegung: Zuerst verifizieren wir die Normierungsbedingung der Wahrscheinlichkeitsverteilung W (n1 ): N N! pn1 q n1 −N = binomischer Lehrsatz = (1 − p + p)N = 1 n !(N − n )! 1 1 n1 =0 ∑ (1.19) Nun betrachten wir die mittlere Zahl der Sprünge nach rechts n1 : N N N! pn1 q n1 −N n1 = pN n !(N − n )! 1 n1 =0 1 n1 = ∑ W (n1 )n1 = ∑ n1 (1.20) Analog gilt das für n2 = N q Schwankungsquadrat von n1 : (∆n1 )2 = n21 − (n1 )2 Ð→ n1 = N p ⇒ (n1 )2 = N 2 p2 N n21 = ∑ W (n1 ) n21 = (n1 )2 + N pq n1 =0 ⇒ (∆n1 )2 = N pq = N p(1 − p) Schwankungsquadrat (1.21) Daraus folgt n1 + n2 = N und für die mittlere Gesamtverschiebung: m = n1 − n2 = N (p − q). √ √ Die Standardabweichung, also ∆n1 ist hier (∆n1 )2 = N pq. Sie ist ein Maß für die Breite der Verteilung. Jetzt bilden wir noch die relative Breite der Verteilung WN (n1 ): √ √ √ q ∆n1 N qp q 1 N →∞ √ = = =√ Ð→ 0 n1 Np p N Np (1.22) Hier fließt das Gesetz der großen Zahlen“ ein. Man erkennt sofort, dass im Falle der Gleich” verteilung, also p = q = 21 für die relative Breite ∆n1 1 ∝√ n1 N gilt. 11 (1.23) Für resultierende Gesamtverschiebung m: (∆m)2 = 4(∆n1 )2 = 4N pq = 2N p(1 − p) 1 (∆m)2 = N . . . für p = q = 2 12 (1.24) 1.1.4 Die Gauß’sche Wahrscheinlichkeitsverteilung Die Binomialverteilung ist für große Zahlen aufgrund der Faktoriellen nur schwer handhabbar, daher wollen wir uns nun um die Entwicklung einer neuen Verteilung kümmern, die sozusagen große Zahlen erlaubt. Dies wird spätestens dann notwendig sein, wenn wir Systeme betrachten, die vielleicht 1024 Teilchen beinhalten. Wie in Abbildung 2 zu erkennen ist, hat W (n1 ) ein ausgeprägtes Maximum bei W (nmax ). Daraus ergeben sich zwei Dinge: 1. W (n1 ) ist unbedeutend für ein n1 , das weit weg ist von nmax , daher studieren wir in der Folge W (n1 ) nur in der Umgebung von nmax . 2. Es ergibt sich, dass weder n1 = 0, noch n1 = N , wenn nicht p ≈ 0 und oder q ≈ 0. D.h.: Wenn N groß ist, dann liegt n1 im Bereich von nmax . Damit dies gilt, muss ∣W (n1 + 1) − W (n1 )∣ << W (n1 ) sein. Anders ausgedrückt, variiert W sehr langsam in einer kleinen Umgebung von nmax . Wir betrachten aus diesen Gründen W als stetige Funktion von n1 Was uns jetzt zugute kommt, ist der Umstand, dass ln W sehr viel langsamer variiert als W selbst, weswegen wir eine gute Näherung für ln W (n1 ) im Bereich n1 ≈ nmax suchen. Setzen wir also den Logarithmus in die Binomialverteilung ein und setzen die Ableitung = 0 x! und verwenden die (gute!) Näherung d ln dx ≈ ln x. So ergibt sich das Maximum bei n1 = N p = n1 (1.25) Jetzt untersuchen wir das Verhalten von ln W in der Gegend des Maximums, also führen wir eine Taylorreihenentwicklung um n durch: ln W (n1 ) = ln W (n1 ) + d ln W 1 d2 ln W ∣ (n1 − n1 ) + ∣ (n1 − n1 )2 + . . . dn1 n1 2! dn21 n1 ´¹¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹¸ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¶ =0 13 (1.26) Man erkennt (oder auch nicht), dass d2 ln W N =− 2 n1 (N − n1 ) dn1 (1.27) und an der Stelle n1 = n1 gilt n1 = N p, sodass sich schreiben lässt: ln W (n1 ) = ln W (n1 ) − (n1 − n1 )2 2N pq (1.28) Bringt man schlußendlich noch den ln (mithilfe der Exponentialfunktion) weg, ergibt sich die bekannte GAUSS- oder Normalverteilung: ̃⋅e W (n1 ) = W − (n1 −n1 )2 2N pq ̃ = const ...W (1.29) Diese Verteilung geht natürlich gegen 0 für große (n1 − n1 ). ̃ zu berechnen. Wie so oft erhält man diese Machen wir uns nun noch daran, die Konstante W aus einer Normierungsbedingung, wie in diesem Falle N ∑ WN (n1 ) = 1 (1.30) ni =0 Wie wir bereits gesehen (oder besser gehofft) haben, ändert sich WN (n1 ) kaum, wenn n1 um 1 erhöht wird, d.h. wir können die Summe getrost durch ein Integral ersetzen. ∞ ∞ ̃e− ∫ WN (n1 ) dn1 = ∫ W −∞ (n1 −n1 )2 2N pq −∞ ∞ y2 ̃ ∫ e− 2N pq dy = 1 dn1 = W (1.31) √π ist. Somit folgt −∞ Dabei handelt es sich um ein Gauss’sches Integral, dessen Lösung einfach für die Konstante: ̃= √ 1 W 2πN pq a (1.32) Wenn Schrittlänge l klein gegen kleinste Länge L des physikalischen Problems (Beispiel: Sprunglänge im Festkörper ≙ Gitterkonstante) beobachtbare Länge L ≈ µm ⇒ P (m) als konstante Funktion der Variablen x, x wird konstante Variable im mirkoskopischen Maßstab. also: dx ist mikroskopisch groß, aber makroskopisch klein m = 2n1 − N m nimmt ganzahlige Werte im Abstand ∆m = 2 ⇒ in jeden Intervall dx liegen dx 2l Werte 14 Man kann die Gaussverteilung auch über die Mittelwerte formulieren, was zur sogenannten Standardform führt. Dabei schreibt man die Verteilung unter Verwendung der Mittelwerte an und fragt nach PN (m), wobei m die effektive Verschiebung ist. Danach fragt man sich nach der Wahrscheinlichkeit, das Objekt nach insgesamt N Sprüngen im Intervall [x, x + dx] zu finden. Das führt nach kurzer Überlegung auf P (x)dx = PN (m) dx 2l und das zur gewünschten Standardform der Gaussverteilung: −[m−N (p−q)]2 1 8N pq PN (m) = √ ⋅e 2πN pq ⇒ P (x)dx = (1.33) −[m−N (p−q)]2 dx 1 1 8N pq PN (m) = √ dx ⋅e 2l 2l 2πN pq (x−x)2 1 =√ ⋅ e− 2σ2 dx 2πσ 2 hier ist σ = ∆n1 (1.34) √ ∞ mit σ = 2l N pq und x = ∫−∞ P (x)xdx P (x) ist Wahrscheinlichkeitsdichte = Vertreilungsdichte Die Verteilung ist Maximal bei x = x. Die Schärfe des Maximums wird durch σ bestimmt. σ 2 = (x − x)2 . . . Schwankungsquadrat = Varianz σ . . . Standardabweichung xh . . . Funktionswert wenn P(x) auf die Hälfte gefallen es gilt: √ ∆xh = 2(xh − x) = 2 2ln2 ⋅ σ = 2.3548 σ √ √ 1 2 ln2 P (x) ⋅ ∆xh = √ 2 2ln2 σ = √ = const. π σ 2π ⇒ kleine Halbwärtsbreite ⇒ hohes Maximum und umgekehrt Für p << 1 ⇒ q ≈ 1 ⇒ Näherung für n << N , in diesem Fall ist sie die Poisson-Verteilung: WN (n1 ) = λn1 −λ e n1 ! 15 . . . λ = n1 = N p (1.35) λ bestimmt allein die Form der Verteilung! 16 1.2 Statistik von Vielteilchensystemen Wie schon der Titel sagt, wollen wir in diesem Kapitel Systeme beschreiben, die aus vielen Teilchen bestehen. Wir wollen thermodynamische Gesetze aus statistischer Beschreibung gewinnen. Insbesondere werden wir folgende Punkte eingehender behandeln: • Eine Beschreibung des Systemzustandes • Von statistischen Ensembles zu Wahrscheinlichkeitsaussagen • Das grundlegende Postulat der statistischen Physik und • Die dazu notwendige Wahrscheinlichkeitsrechnung 1.2.1 Mikroskopische Beschreibung des Systemzustandes, Zustandsraum Die hier betrachteten Systeme sind z.B. gekoppelte Oszillatoren, Gase, Fluide, Festkörper, u.v.m. Daraus folgt, dass die hier zu behandelnden Teilchen z.B. e− , Atome, Moleküle, . . . , sind. In der Quantenmechanik werden wir den Teilchen Wellenfunktionen zuordnen müssen, d.h. ein System wird durch einen Satz von Quantenzahlen charakterisiert. Ein spezieller Mikrozustand ist dann gegeben durch r = (n1 , n2 , . . . , nf ) (nf sind QZ des Systems), wobei f die Zahl der Freiheitsgrade des Systems ist. Mikrozustand eines Systems ist festgelegt durch Angabe seines Quantenzustands (QZ, die seinen Zustand festlegt). 17 Beispiele: 1. Ein ortsfestes Teilchen mit s = 1/2. Der Zustand ist also durch eine Quantenzahl gegeben, das entspricht einem Freiheitsgrad mit den zwei möglichen Werten ↑ bzw. ↓. (z.B.: im B-Feld hat es zwei Einstellmöglichkeiten) 2. N Teilchen mit festem Ort und s = 1/2. Hier wird der Systemzustand durch N Quantenzahlen festgelegt. ⇒ N QZ: m1 , . . . , mN 3. Der ortsfeste dreidimensionale harmonische Oszillator: ̵ Der Zustand wird durch die Energie festgelegt: En = hω(n + 1/2). Das bedeutet, er hat einen Freiheitsgrad, gegeben durch n = 0, 1, . . . 4. N (schwach) gekoppelte Oszillatoren: Hier gibt es N Quantenzahlen, die den Systemzustand beschreiben. Gesamtenergie E = En1 + En2 + ⋅ ⋅ ⋅ + EnN 5. Ein Teilchen ohne Spin, kräftefrei in 3 dim. Potential Topf mit eindimensionaler Breite L ̵ 2 π2 2 h → En = 2mL 2 n , n = 1, 2, 3, . . . jetzt 3-Dim: 0 ≤ x, y, z ≤ Lx , Ly , Lz E= ̵ 2 π 2 n2 n2y n2 h ( x+ + z) 2m L2x L2y L2z (1.36) 6. N nicht wechselwirkende (WW) Teilchen im Volumen V = L3 Gesamtenergie E = E1 + ⋅ ⋅ ⋅ + EN ⇒ Zustand festgelegt durch 3N QZ (n1x , n1y , n1z , . . . , nN x , nN y , nN z ) 18 (1.37) Klassische Beschreibung des Systemzustandes Wir betrachten ein einzelnes Teilchen in einer Dimension. Die vollständige Beschreibung gelingt durch die Ortskoordinaten q und die zugehörigen Impulse p. Wird bilden Zellen gleichen Volumens (hier gleiche Fläche), dies ergibt einen 2-dimensionalen Phasenraum des Systems. Der Punkt (q(t), p(t)) (p und q sind kontinuierliche Größen) ist der repräsentative Punkt, der sich im Phasenraum bewegt. Abbildung 3: Phasenraum in Zellen gleicher Flächen dp ⋅ dq = h0 geteilt. h0 hat die Dimension eines Drehimpulses, also einer Wirkung (hat Einheit [Js] und ist ein Skalar, kein Vektor) h0 = δpδq = F δtδq = F δq δt = Eδt ± (F = δp ) δt (1.38) E Der Systemzustand liegt im Intervall [q, q + dq] und [p, p + dp], d.h. der repräsentative Punkt befindet sich in einer Zelle des Phasenraums (In Abbildung 3 eine Fläche). Klassisch kann h0 beliebig klein gewählt werden, in der Quantenmechanik gilt aber die Hei” ̵ senberg’sche Unschärferelation“ dp ⋅ dq ≥ h2 . Jetzt betrachten wir ein Vielteilchensystem: Hier gibt es f Ortskoordinaten q1 , q2 , . . . , qf und f dazugehörige Impulse p1 , p2 , . . . , pf , sodass es insgesamt 2f Parameter für f Freiheitsgrade. 19 Beispiel: Sei ein System von N Massenpunkten: Dieses hat 3 Ortskoordinaten pro Teilchen, also f = 3N und daher insgesamt 6N Parameter für die Beschreibung des Systemzustandes. (z.B.: ideales Gas (keine WW)) Die mikroskopischen Orts- und Impulskoordinaten sind Koordinaten eines i.A. hochdimensionalen (nämlich 2f ) Phasenraum. Dieser Phasenraum wird auch Zustandsraum“, Gibb’scher Phasenraum“ oder Γ-Raum“ ” ” ” (Γ = Gamma) genannt. Γ = q1 , . . . , q f , p 1 , . . . , p f Einem Mikrozustand wird also ein Punkt im Phasenraum zugeordnet. Erinnern wir uns an die vorhin besprochene Zelle des Phasenraums, so besteht hier durchaus ein klassisches Analogon zu Quantenzuständen, bei denen alle möglichen Zustände durch die Quantenzahlen durchnumeriert werden. Zelleinteilung: ̵ f δq1 ⋯δqf ⋅ δp1 ⋯δpf = hf0 ≥ (2π h) (1.39) r(q1 , . . . , qf , p1 , . . . , pf (1.40) klassischer Mikrozustand: Beschreibung ähnlich zur QM: Eine Zelle r im Phasenraum Γ ist klassisches Analogon zum Quantenzustand r“ ” 20 1.2.2 statistisches Ensemble und Makrozustände Der Makrozustand“ eines Systems wird durch äußere Parameter, wie z.B. Energie, Volumen ” usw. festgelegt. Zu jedem Makrozustand gehören sehr viele Mikrozustände, nämlich all jene, die gleiche äußere Parameter besitzen. Nehmen wir viele gleiche Systeme her. Diese seien im selben Makrozustand. Die Mikrozustände sind i.A. verschieden. Jetzt bilden wir das sogenannte statistische Ensemble, durch das genau ein Makrozustand repräsentiert wird. Das statistische Ensemble ist also die Menge der repräsentativen Punkte im Phasenraum. Anders ausgedrückt: Nehmen wir an, wir haben ein ideales Gas, bestehend aus 2 Atomen. Es gibt genau 2 Punkte auf einer Geraden, wo sie sich befinden können. In einem Fall wird das erste links und das zweite rechts sitzen, im zweiten Fall umgekehrt. In beiden Fällen hat das Gas denselben Druck, die selbe Temperatur, etc.. Es gibt also zwei Mikrozustände, die zum selben Makrozustand führen. Wir benötigen noch den Begriff der zugänglichen“ Zustände des Systems. Das sind Mikro” zustände, die mit den äußeren Parametern verträglich sind. D.h. Ein Makrozustand ist charakterisiert durch die Wahrscheinlichkeit Pr für das Auftreten eines gewissen Mikrozustandes r. Pr = (P1 , P2 , . . . ) Frage: Wie groß ist das Pr ? Früher: Wahrscheinlichkeit für das Auftreten eines Ereignisses j aus N Messungen (Versuchen): Wj = lim N →∞ Nj Nj ≈ N N (1.41) Jetzt: M gleichartige Systeme In Mikrozustand r seien Mr der M Systeme Pr = lim M →∞ Mr M r ≈ M M . . . wenn M hinreichend groß (1.42) Makrozustand: nur durch Wahrscheinlichkeit seiner zugänglichen Mikrozuständen gegeben, also mit den Wahrscheinlichkeiten mit denen der Systemzustand mit einem der zugänglichen Mirkozustände übereinstimmt. 21 1.2.3 Das grundlegende Postulat Wir betrachten ein isoliert abgeschlossenes System. Dieses tauscht ja bekanntlich keine Energie mit seiner Umgebung aus, d.h. dtEgesamt = 0. Man kann dieses System also durch seine Energie E, bzw. durch ein Energieintervall [E, E + dE] charakterisieren. Daraus folgt, dass alle dem System zugänglichen Mikrozustände diese Energie haben müssen. Weiters findet man bei der Betrachtung eines isolierten Systems im Gleichgewicht, dass die Wahrscheinlichkeit, das System in einem gewissen Mikrozustand zu finden, zeitunabhängig ist, sowie auch die makroskopischen Parameter zeitunabhängig sind. Wir wissen jetzt, dass das System in einem seiner zugänglichen Zustände, vereinbar mit Er ist. Postulat: E IN ISOLIERTES S YSTEM IM G LEICHGEWICHT IST GLEICHWAHRSCHEINLICH IN JEDEM SEINER ZUG ÄNGLICHEN M IKROZUST ÄNDE Dieses grundlegende Postulat der gleichen a-priori-Wahrscheinlichkeiten1 erlaubt es uns, eine Verbindung herzustellen zwischen mikroskopischen Strukturen und makroskopischen Größen. 1.2.4 Mikrokanonische Zustandssumme und Berechnung der Wahrscheinlichkeit makroskopischer Parameter System im Gleichgewicht → Gesamtenergie erhalten ⇒ alle zugänglich Mikrozustände mit Gesamteenergie vereinbar. Energie ist nur mit endlicher Genauigkeit bestimmbar. Da die Energie nur mit endlicher Genauigkeit messbar ist und das liegt, wie wir wissen, nicht nur an der Geschicklichkeit eines Experimentators, definieren wir uns die mikrokanonische Zustandssumme als die Menge aller Mikrozustände, die für ein System mit E = E − δE, E zugänglich sind. Ω(E) = 1 ∑ r∶ E−δE≤Er ≤E 1 . . . mikrokanonische Zustandssumme lateinisch a von . . . her“ und lateinisch prior der vordere; also von vornherein“ ” ” ’ 22 (1.43) Ω(E): Zustände zwischen E − δE und E, abhängig von δE wählen δE: • mikroskopisch groß (z.B E-Differenzen des E-Niveaus) • makroskopisch klein (Gesamt-E) für große Teilchenzahlen Ω(E) konstante Funktion. ⇒ Entwicklung nach Potenzen von δE δE klein ⇒ nur linearer Term ⇒ Ω(E) ∝ δE Ω(E) = ρ(E)δ(E) (ρ(E) Zustandsdichte“ unabhängig von δE) ” Das grundlegende Postulat sagt uns ja, dass alle Mikrozustände Ω(E) gleichwahrscheinlich sind. Das führt uns auf: ⎧ 1 ⎪ ⎪ Pr = ⎨ Ω(E) ⎪ ⎪ ⎩0 . . . E − δE ≤ Er ≤ E . . . mikrokanonische Verteilung . . . sonst (1.44) Da ein Makrozustand ja gegeben ist durch Pr = (P1 , P2 , . . . ), liegt es auf der Hand, dass ein Makrozustand umso wahrscheinlicher ist, je mehr Mikrozustände er zulässt. Machen wir uns also jetzt daran, die Wahrscheinlichkeit für das Auftreten makroskopischer Parameter im Ensemble zu berechnen. Sei y ein beliebiger äußerer Parameter (z.B. Druck oder magnetisches Moment,. . . ). Dieser Parameter kann die Werte y ∶ y1 , y2 , . . . , yn annehmen. Insgesamt gibt es Ω Mikrozustände im betrachteten System. Ωi davon führt darauf, dass y den Wert yi annimmt. Wir brauchen jetzt die Wahrscheinlichkeit, dass sich das System in einem der Zustände Ωi befindet. Nach dem grundlegenden Postulat hat jeder Zustand Ωi die Wahrscheinlichkeit 1/Ω. D.h. wir bilden ∑ Ωi 1 1 = Ωi ⋅ Ω Ω (1.45) Daraus folgt für die Wahrscheinlichkeit für das Auftreten einer messbaren Größe yi : Pr (yi ) = Ωi Ωi (E, yi ) = Ω Ω(E) (1.46) Makrozustand charakterisieren ist realisierbar durch gewisse Anzahl gleicherwahrscheinlicher 23 Mikrozustände ⇒ jener häufiger, der durch mehr Mikrozustände realisierbar ist ⇒ Makrozustand ist umso wahrscheinlicher je mehr Mikrozustände er zulässt Aus der Definition des Mittelwertes folgt hier: n y = ∑ Pr (yi ) ⋅ yi = i=1 1 n ∑ Ωi yi Ω i=1 (1.47) und für das Schwankungsquadrat: n (∆y)2 = ∑ Pr (yi )(yi − yi )2 = i=1 1 n 2 ∑ Ωi (yi − yi ) Ω i=1 (1.48) Beispiel: Gegeben seien 3 ortsfeste Spin 21 -Teilchen. Die z-Achse eines Magnetfeldes sei vorgegeben. Die potentielle Energie ist durch das magnetische Dipolmoment −µB = Epot gegeben. Nehmen wir an, µ weise in/gegen die z-Richtung für m = ± 12 Wählen Gesamt-E: −µB ⇒ System ist Gleichwahrscheinlich: (+ + −), (+ − +), (− + +) • Die Wahrscheinlichkeit dafür, dass der Spin des 1. Teilchens nach oben weist? Ωi = 2, Ω = 3 Daraus folgt für P1 (+) = 23 • µz in positive z-Richtung vom 1.Teilchen? Ω = 3, y = µz , daher 2 Werte: y1 = +µ und y2 = −µ Die Anzahl der Zustände mit y1 ist also Ω1 = 2 und mit y2 ist Ω2 = 1. y = µz = 1 1 (2µ + 1(−µ)) = µ 3 3 24 1.2.5 Teilchen im 3-dimensionalen Kasten Teilchen im Kastenpotential: Bilden wir einen 3D Kasten mit den Kanten: Lx = Ly = Lz = L, so ist die Energie eines Teilchens darin durch die QM gegeben durch: E= ̵ 2π2 h L2 2 2 2 2 2 2 2 (n + n + n ) ⇒ n + n + n = x y z x y z ̵ 2 2mE = R 2mL2 π2h Wir bilden den Zustandsraum (aus den QZ) mit Achsen: nx , ny , nz Das gesuchte der Zustandssumme liegt zwischen E − δE und E 25 (1.49) Formel (1.49) ist der Radius einer Kugel im nx − ny − nz −Raum. Für eine gegebene Energie befinden sich die Werte nx , ny , nz auf einer Kugeloberfläche mit Radius R. Der gleich auftauchende Faktor 1/8 rührt daher, dass nur positive Werte von ni physikalisch sind und wir daher nur einen Kugeloktanten brauchen. Betrachten wir erst nur Zustände mit Φ(E) ≤ E, so folgt für sie: Φ(E) = 3 1 4 3 π L 3 ( πR ) = ( ̵ ) (2mE) 2 8 3 6 πh (1.50) Φ(E) = Gesamtzahl der Zustände mit Energie ≤ E Wie wir vorhin gesehen haben, gilt Ω(E) = Φ(E) − Φ(E − δE) (Wählen δE mikroskopisch groß, aber makroskopisch klein ⇒ Ω(E) stetige, kontinuierliche Funktion), und damit dΩ Φ(E) − Φ(E − δE) = dE δE (1.51) Daraus folgt nach der Durchführung des Limes: Ω= dΦ δE dE (1.52) wobei wir den Differentialquotienten definieren als ρ(E) und als Zustandsdichte bezeichnen. Für die mikrokanonische Gesamtheit folgt dann insgesamt (mit V = L3 ): Ω(E) = 1 3 1 3π L 3 V ( ̵ ) (2mE) 2 2mδE = 2 ̵ 3 (2m) 2 E 2 δE 2 6 πh 4π h 26 (1.53) √ Interessant ist in diesem Zusammenhang, dass ρ(E) ∝ 1.3 E ist. Thermische Wechselwirkung und repräsentative Ensembles physikalischer Systeme ⇒ Energieniveus sind auch von x = (x1 , . . . , xn ) abhängig. → Er = Er (x1 , . . . , xn ) Mikrozustand: r = (n1 , . . . , nf ), für x = (x1 , . . . , xn ). Makrozustand: Satz von Wahrscheinlichkeiten Pr = (P1 , . . . , Pn ), für x = (x1 , . . . , xn ). ⇒ Durch Änderung der äußeren Parameter ändern sich auch die Mikro- und Makrozustände. 1.3.1 Thermische Wechselwirkung zwischen makroskopischen Systemen Wir betrachten 2 Systeme A1 und A2 mit der Energie E1 und E2 , die in Einheiten von δE skaliert ist. Die zugänglichen Zustände seien: A1 → Ω(E1 ), E1 − δE ≤ E1r ≤ E1 A2 → Ω(E2 ), E2 − δE ≤ E2r ≤ E2 Es seien zwar die äußeren Parameter xi fest, aber die Systeme NICHT voneinander isoliert, d.h. ein Energieaustausch zwischen A1 und A2 ist möglich. Aus diesem Grund betrachten wir ein zusammengesetztes System A∗ ≡ A1 + A2 mit E ∗ = E1 + E2 = const. Wenn E1 also von A1 gegeben ist, folgt daraus E2 = E ∗ − E1 . Treffen wir die Annahme, dass A1 mit A2 im Gleichgewicht ist, so ist zwingend auch A∗ im Gleichgewicht und daher ist das grundlegende Postulat anwendbar auf A∗ . Frage: Was ist Wahrscheinlichkeit P (E), dass A1 den Wert E1 hat, wodurch A2 den Wert E2 = E ∗ − E1 hätte? Laut Voraussetzung sind alle zugänglichen Zustände von A∗ gleichwahrscheinlich, was einer Zustandssumme Ω∗total entspricht. Unsere Frage muss daher lauten: Wieviele Mikrozustände Ω∗ (E1 ) erlauben, dass A1 den Wert E1 hat? Dies können wir bereits beantworten: P (E1 ) = Ω∗ (E1 ) = c ⋅ Ω∗ (E1 ) Ω∗total 27 mit c = 1 Ω∗total (1.54) Bleibt nur noch nach Ω∗ (E1 ) zu fragen. Bei gleichzeitigem Auftreten hat A1 . . . E1 zugängliche Zustände Ω1 (E1 ) und A2 . . . E2 = E ∗ − E1 zugängliche Zustände Ω2 (E ∗ − E1 ) Jeder zugängliche Zustand von A1 und A2 trägt zu den zugänglichen Zuständen von A∗ bei. Zugänglicher Zustand von A∗ bedeutet gleichzeitige Auftreten eines Zustands vonA1 und A2 ⇒ Multiplikationssatz. woraus folgt, dass Ω∗ (E1 ) = Ω1 (E1 ) ⋅ Ω2 (E ∗ − E1 ) und somit P (E1 ) = c ⋅ Ω1 (E1 ) ⋅ Ω2 (E ∗ − E1 ) (1.55) Frage: Wie sieht es nun aus mit P (E1 ) als Funktion f (E1 )? A1 , A2 sind makroskopische Systeme ⇒ sehr viele Freiheitsgrade. ⇒ Ω1 (E1 ), Ω2 (E) wachsen sehr schnell mit E1 und E2 (Kugelvolumen). Wenn E1 wächst, steigt Ω1 (E1 ) sehr stark und Ω1 (E2 ) fällt sehr stark. ⇒ P (E1 ) steigt für große Systeme → scharfes Maximum. 28 Ω1 (E1 ) und Ω2 (E2 ) wachsen ja enorm mit E1 . Bei konstantem E ∗ steigt Ω1 (E1 ) mit E1 und fällt Ω2 (E ∗ − E). Daraus folgt, dass P (E) ein ausgeprägtes Maximum bei, sagen wir Ê mit Breite ∆E << E1 hat. Begeben wir uns auf die Suche nach diesem Maximum. Zugute kommt uns hierbei, dass ln(P (E)) viel schwächer variiert, als P (E), so kommen wir auf: ln P (E1 ) = ln(c) + ln(Ω1 (E1 )) + ln(Ω2 (E2 )) (1.56) Wobei wir uns nochmal in Erinnerung rufen, dass Ê1 , Ê2 die Energiewerte von A1 , A2 für P (E) = max sind. Es gilt also: β1 (Ê1 ) = β2 (Ê2 ) mit β1 (E1 ) = . . . Bedingungsgleichung ∂ ln Ω1 1 ∂Ω1 = ∂E1 Ω1 ∂E1 29 (1.57) (1.58) β hat die Dimension einer reziproken Energie und veranlasst uns, einen neuen Parameter T so einzuführen, dass T11 ≡ kT1 gilt. k hat die Dimension einer Energie und sei vorerst noch beliebig. Später werden wir finden, dass es sich hierbei um die Boltzmannkonstante handelt. ln Ω1 , dann können wir T11 anschreiben als: Sei also β1 = kT1 1 = ∂∂E 1 1 k ∂ ln Ω1 ∂S1 = = T1 ∂E1 ∂E1 (1.59) und schon haben wir eine bekannte Größe gefunden, die Entropie: S1 = k ⋅ ln Ω1 . . . Boltzmann’sche Entropiegleichung (1.60) Wie man in Gleichung (1.60) sieht, ist sie das logarithmische Maß für die Anzahl der zugänglichen Zustände des Systems. Frage: Was hat das nun für Konsequenzen für unser Pmax (E1 )? Wir müssen logarithmieren: ln P (E1 ) = ln(c) + ln Ω1 (E1 ) + ln Ω2 (E2 ) ´¹¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¸¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¶ ´¹¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¸¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¶ S1 k Daraus folgt, dass: (1.61) S2 k P (E1 ) = max ⇔ S ∗ = S1 + S2 = max Nebenbei sei bemerkt, dass ja dann wie oben bereits gezeigt auch β1 (Ê1 ) = β2 (Ê2 ) gilt und damit kT1 1 = kT1 2 woraus folgt: T1 = T2 Also: A1 hat genau die Energie, bei der S ∗ von A∗ maximal ist. Nur dann ist das Gesamtsystem A∗ so gleichmäßig wie möglich über alle zugänglichen Mikrozustände verteilt. Damit gibt es eine Größe, welche die Unordnung beschreibt. Diese Größe ist eben die Entropie. Sie ist ein Maß für die Unordnung eines makroskopischen Systems. Durch Gleichung (1.60) wird eine Verbindung hergestellt zwischen mikroskopischer Struktur (Ω1 ) und den makroskopischen Messgrößen S1 und T1 . Sie ist eine der zentralen Gleichungen der statistischen Physik und wurde 1877 von Ludwig Boltzmann aufgestellt. heißt: ⇒ System über größtmögliche Zahl von Mikrozustandes verteilt ⇒ gleichmäßigste“ Verteilung der makroskopischen Systems auf seine zugängliche Mikro” zustände ⇒ Mikrozustand maximal unbestimmt ⇒ System im Zustand maximaler Unrodnung“ ” ⇒ Die Entropie ist ein Maß für die Unordnung eines Makroskopischen Systems 30 1.3.2 Thermisches Gleichgewicht und Temperatur Wahrscheinlichkeit P (E1 ) soll scharfes Maxima bei E1 = Ẽ1 haben. Systeme in Kontakt: Gleichgewicht mit großer Wahrscheinlichkeit A1 ∶ E1 = Ẽ1 A2 ∶ E2 = E ∗ − Ẽ1 Zeitpunkt t = 0 Systeme in Kontakt: 0 A1 , Ē1 0 A2 , Ē2 i.A.: Ē1 , Ē2 unwahrscheinlich Energien für A∗ 0 0 Wartezeit t = t∞ ∞ Ē1 = Ẽ1 , . . . , sodass P (E1 ) max. ∞ ∞ ⇒ β1∞ = β1 (Ē1 ) = β2∞ = Ē1 und daraus folgt: T1∞ = T2∞ (1.62) P (E1 ) ist max heißt: S ∗ ist max ⇒ Anstreben“ von T1 = T2 heißt: ” Entropieaustausch erfolgt so, dass Gesamtentropie maximal wird. ∞ bzw. ∞ ∞ 0 0 S1 (E 1 ) + S2 (E 2 ) ≥ S1 (E 1 ) + S2 (E 2 ) ∞ 0 0 S1 (E 1 ) − S1 (E 1 ) + S2 (E 2 ) − S2 (E 2 ) = ∆S1 + ∆S2 ≥ 0 Die Entropie eines abgeschlossenen Systems nimmt beim Anstreben des GG-Wertes immer zu. 2. HS der THermodynamik aus statistischen Prinzipien abgeleitet Der Index ∞ soll die unendlichlange Wartezeit andeuten, bis sich die Systeme im Gleichgewicht befinden. Zwei Dinge sind zum Parameter β zu sagen: 1. Wenn zwei Systeme für sich im Gleichgewicht sind, aber β für beide denselben Wert hat, dann ist bereits ein Gleichgewicht erreicht und somit bei Kontakt auch kein Energieaustausch mehr im Gange. 2. Wenn der Wert von β aber nicht der gleiche ist, dann bleiben die Systeme solange nicht im Gleichgewicht, bis Gleichung (1.62) ereicht ist. 31 Die folgende Bemerkung wird auch als 0-ter Hauptsatz der Thermodynamik“ bezeichnet: ” Für drei Systeme A, B und C gilt: • A ist in Kontakt und Gleichgewicht mit C ⇒ βA = βC • B ist in Kontakt und Gleichgewicht mit C ⇒ βB = βC Daraus folgt: A und C sind im Gleichgewicht Wenden wir uns noch kurz dem Parameter T zu, so wissen wir • Boyle-Mariotte: für festes T gilt: pV = const (. . . isotherm) • Gay-Lussac: V T = const (. . . isobar) • ideale Gasgleichung: pV = cT • Ausdehnungskoeffzient: α = • kin. Gastheorie: p̄ = 1 V 1N ⟨v 2 ⟩ 3V m ( ∂V ) ∂T p = 1 c V p = 1 T =C ⋅T Frage: Wie können wir eine Temparaturskala entwickeln? Aus der kinetischen Gastheorie wissen wir, dass der Druck als Impulsübertragung anzusehen ⟨v 2 ⟩, und damit p̄V = 32 N ⋅ 12 m ⟨v 2 ⟩. ist, also p̄ = 31 N V m ´¹¹ ¹ ¹ ¹ ¹ ¸¹ ¹ ¹ ¹ ¹ ¹ ¶ Ekin 3 2 kT Setzen wir Ekin = (=kalorische Zustandsgleichung), so ist die Gesamtenergie Ē = 32 N kT . Wenn wir jetzt noch verlangen, dass T = 0 für Ē = 0 und in die ideale Gasgleichung p̄V = N kT (=thermische Zustandsgleichung), dann müssen wir uns nur noch entscheiden, ob wir T oder k festlegen. Wir halten uns an die Geschichte und legen k fest. Zwei Punkte der T -Skala liegen bereits fest, nämlich T = 0 und der Tripelpunkt von H2 O bei 273, 16K. Sehen wir nochmal die ideale Gasgleichung an, nur diesmal mit Mol: p̄ = νRT , wobei ν die J Molzahl ist und R = 8, 31451 mol⋅K . J Damit ist R ≡ NA k und damit k = (138066 ± 0, 00006) ⋅ 10−23 K wenn wir NA = (6, 0221367 ± 0, 0000036) ⋅ 1023 Moleküle als Loschmidt-Zahl identifizieren. mol 32 1.3.3 statistische Physik und Thermodynamik Gehen von mikroskopischen Struktur aus, den Mikrozuständen. Frage: Wie kommen wir zu thermodynamischen Größen? Entscheidende Verbindung zwischen mikroskopischen Struktur eines Systems und der Thermodynamik, also makroskopischen Größen und ihren Beziehungen, stellt die Boltzmann’sche Entropiegleichung (S = k ⋅ ln Ω) dar 1 2 3 4 H(x) → Er (x) → Ω(E, x) → S(E, x) → T, X(E, x) 1. Die äußeren Parameter seien x = (x1 , . . . , xn ). QM: Wir bestimmen die Energieeigenwerte Er des Hamilton-Operators Ĥ(x). Das legt die Mikrozustände fest. klassisch: Funktion der Orts und Impulskoordinaten → Hamilton-Funktion 2. Berechnung der Zustandsumme aller Zustände r, die mit E −δE ≤ Er (x) ≤ E verträglich sind. Ω(E, x) = ∑ 1 r Summe r: Summen von f Termen über die QZ ni r = (n1 , . . . , ni ) f . . . Freiheitsgrade f ≈ 1024 klassisch: Summe → Integral über Volumen im Phasenraum 3. Annahme: System isoliert und im Gleichgewicht: → Grundlegendes Postulat. ⎧ 1 ⎪ ⎪ Ω(E,x) Pr = ⎨ ⎪ ⎪ ⎩0 E − δE ≤ Er (x) ≤ E sonst ⇒ S = k ⋅ ln Ω 4. Wir benötigen den Begriff der Verallgemeinerten Kraft“. Wenn ” 1 ∂S(E, x) = T ∂E die treibende Kraft für den Wärmeaustausch ist, dann ist Xi = T ∂S(E, x) ∂Ω(E, x) = kT ∂xi ∂xi Xi . . . verallgemeinerte Kraft zum äußeren Parameter 33 die verallgemeinerte Kraft für einen xi -Austausch. z.B. hat Xi die Dimension einer Kraft, wenn xi die Dimnension einer Länge hat. Wenn Gleichgewicht herrscht, dann gilt also für den • Wärmeaustausch: gleiches T • Volumenaustausch: gleiches P • Teilchenaustausch: gleiches µ (chemisches Potential) • xi -Austausch: gleiches Xi 34 Beispiel: ideales, einatomiges Gas äußere Parameter: V = L3 , N 1. Mikrozustände r mit Energie Er : QM: r = (n1 , . . . , n3 N ) Er (N, V ) = ̵ 2 π 2 3N h 2 ∑n 2mL2 i=1 i (1.63) → ni : QZ des i-ten Freiheitsgrad gleiche QZ für mehrere Teilchen zugelassen ⇒ klassische Näherung klassisch: E = Ekin = m N ∑ 2 i=1 3 2 ∑ vij (1.64) i=1 ² 3 Raumrichtungen 2. Auswertung der Zustandssumme: E V 3N ln ( ) + N ln ( ) + N ln c 2 N N 5 3 2π ln c = ln ĉ + + ln ( ) 2 2 3 ln Ω(E, V, N ) = (1.65) (1.66) 3. ⇒ Entropie: 3 E V S(E, V, N ) = k ln Ω = N k ln ( ) + N k ln ( ) + N k ln c 2 N N bilden 1 ∂S 3 1 = = Nk T ∂E 2 E 3 → E = N kT 2 Xi ∂S = T ∂xi → P V = N kT . . . klassische Zustandsgleichung“ ” und (1.67) P ∂S 1 = = Nk T ∂V V . . . thermische Zustandsgleichung“ ” 35 (1.68) 1.3.4 Systeme in Kontakt mit einem Wärmereservoir, kanonische Zustandssumme Frage: Wie groß ist Wahrscheinlichkeit Pr , dass klassische System A in Kontakt mit groß A′ in einem bestimmten Mikrozustand r mit Energie Er ist? So teilen wir die Energieskalen in passend kleine Intervalle δE Ω′ (E ′ ) ist die Anzahl der zugänglichen Mikrozustände für A′ , wenn seine Energie zwischen E ′ − δE und E ′ liegt. Zusammengesetzte Systeme A∗ = A + A′ ist isoliert ⇒ E ∗ = const E liegt zwischen E ∗ − δE, E ∗ Annahme: A sei in einem seiner zugänglichen Mikrozustände r mit Er ⇒ E ∗ = E ′ + Er , E ′ = E ∗ − Er Wenn A in einem seiner Mikrozustände ist, dann Anzahl der für A∗ zugänglichen Zustände nur mehr durch zugänglichen Zustände von A′ bestimmt, wenn seine Energie im Intervall E ′ − δE = E ∗ − Er − δE und E ′ = E ∗ − Er ! 36 Die zugänglichen Zustände von A∗ sind: Ω∗ = Ω′ (E ∗ − Er ) Grundlegendes Postulat: A∗ gleichwahrscheinlich in jedem seiner zugänglichen Mikrozustände ⇒ Wahrscheinlichkeit: A im Zustand r zu finden ist proportional zur Anzahl der Zustände von A∗ wenn A in Zustand r: Pr = C ′ Ω∗ = C ′ Ω′ (E ∗ − Er ) (1.69) ′ C → aus Normierungsbedingung: ∑r Pr = 1 Wir brauchen Ω′ ! Annahme: A′ ist Wärmebad = Energie Reservoir ⇒ sehr, sehr viele Freiheitsgrade Er << E ′ ⇒ Er << E ∗ also: E ′ = E ∗ − Er ≅ E ∗ rechnen aus: vorzügliche Näherung für Ω′ (E ′ ) durch Entwicklung der schwach variierende Funktion ln Ω′ (E ′ ) Taylorentwicklung: lnΩ′ (E ∗ − Er ) = lnΩ′ (E ∗ ) − ∂lnΩ′ ∣ ⋅Er ∂E ′ E ′ ≅E ∗ ´¹¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹¸ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¹ ¶ (1.70) ∂lnΩ′ ∂lnΩ′ ∂E ′ = ∂E ′ ⋅ ∂E ∗ ∂E ∗ ∂lnΩ′ 1 ∣ = β′ = ∂E ′ E ′ ≅E ∗ kT (1.71) ⇒ β von Er unabhängige Konstante. sagen β ′ = β (lassen ′ weg): konstanter Temperaturparameter des Wärmebades A′ bedeutet physikalisch: T des Wärmebades A′ ändert sich nicht beim Austausch kleiner Energieportionen mit A. ⇒ ln Ω′ (E ∗ − Er ) = ln Ω′ (E ∗ ) − βEr Ω′ (E ∗ −Er ) = Ω′ (E∗)exp(−βEr ) Ω′ (E∗) → const., hängt nicht von r ab Ô⇒ Pr = C ′ Ω′ (E ∗ − Er ) = Ce−βEr = Ce− kT Er 37 . . . Boltzmann-Verteilung (1.72) −βEr =1 ⇒ C= ∑ Pr = C ∑ e r r e−βEr e− kT Pr = = E ∑r e−βEr ∑r e− kTr 1 ∑r e−βEr Er exp(−βEr ) = exp (− Z(T ) = ∑ exp (− r Er ) kT Er ) kT . . . kanonische Verteilung (canonical distribution) . . . Boltzmann-Faktor . . . kanonische Zustandssumme (canonical partition function) zugehöriges Ensemble: kanonisches Ensemble = Gibbs Ensemble kanonisches System A: ist in genau einen seiner zugänglichen Mikrozustände kanonisches System A′ = Wärmebad: ist in irgendeinem seiner sehr vielen zugänglichen Zustände Ω′ (E ∗ − Er ) Ω′ (E ′ ) wächst sehr stark mit E ′ : β = ∂ ln Ω ∂E >0 ⇒ je größer Er desto kleiner E ′ ⇒ damit sinkt stark die Zahl der zugänglichen Zustände für Ω′ ⇒ es sinkt Wahrscheinlichkeit im Ensemble für Systeme mit hoher Energie Er sinkt entsprechend. 38 39 Berechnung vom Mittelwerten y sei eine messbare Größe, im Mikrozustand r von A: yr ∑r e− kT ⋅ yr Er y = ∑ P r yr = r −E kT = ∑r e r ∑r e− kT ⋅ Er Er 1 ∑ yr e kT Z(T ) r Er E = ∑ Pr Er = r r −E kT = ∑r e−βEr ⋅ Er ∑r e−βEr ∑r e ∂ ∑ e−βEr ⋅ Er = r = − lnZ(T ) Z(T ) ∂β 40 (1.73)