TECHNISCHE UNIVERSITÄT DRESDEN

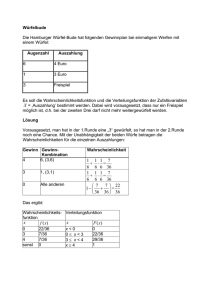

Werbung