Abteilung für Mathematische Stochastik

Werbung

Stochastik

Vorlesung

an der

Albert–Ludwigs–Universität Freiburg i. Br.

Wintersemester 2013/14

Sommersemester 2014

Prof. Dr. H. R. Lerche

5. Oktober 2015

Inhaltsverzeichnis

1 Einleitende und historische Bemerkungen

1

1.1

Was ist Stochastik? . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1

1.2

Stochastische Tätigkeiten im Alltag . . . . . . . . . . . . . . . . . . . . . .

1

1.3

Historisches . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3

2 Ereignisse und Wahrscheinlichkeiten

4

2.1

Der Würfel . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4

2.2

Chancen-/Gewinnverhältnisse und Auszahlungsquoten

. . . . . . . . . . .

6

2.3

Mengentheoretische Beschreibung von Ereignissen . . . . . . . . . . . . . .

8

2.4

Wahrscheinlichkeitsmaße . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9

3 Gleichverteilungen

14

3.1

Gleichverteilung und Kombinatorik . . . . . . . . . . . . . . . . . . . . . . 14

3.2

Verteilungen, die aus Gleichverteilungen entstehen . . . . . . . . . . . . . . 22

3.3

Verteilungen mit mehr als zwei Kategorien, die aus Gleichverteilungen entstehen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27

3.4

Die probabilistische Methode in der Kombinatorik . . . . . . . . . . . . . . 28

4 Bedingte Wahrscheinlichkeiten und Unabhängigkeit

30

4.1

Bedingte Wahrscheinlichkeit: Definition und Folgerungen . . . . . . . . . . 30

4.2

Satz von der vollständigen Wahrscheinlichkeit und Bayesschen Formel . . . 34

4.3

Unabhängigkeit von Ereignissen . . . . . . . . . . . . . . . . . . . . . . . . 38

4.4

Anwendung der Unabhängigkeit in der Zahlentheorie . . . . . . . . . . . . 43

5 Zufallsvariable und ihre Verteilung

46

5.1

Zufallsvariable, Verteilung einer Zufallsvariable . . . . . . . . . . . . . . . . 46

5.2

Unabhängigkeit von Zufallsvariablen . . . . . . . . . . . . . . . . . . . . . 49

I

6 Erwartungswert und Varianz von Verteilungen

55

6.1

Der Erwartungswert . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 55

6.2

Beispiele von Erwartungswerten . . . . . . . . . . . . . . . . . . . . . . . . 58

6.3

Varianz und Kovarianz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 60

6.4

Varianzen einiger Verteilungen . . . . . . . . . . . . . . . . . . . . . . . . . 62

6.5

Das Gesetz der Großen Zahlen . . . . . . . . . . . . . . . . . . . . . . . . . 65

6.6

Die Approximation stetiger Funktionen durch Polynome. . . . . . . . . . . 67

6.7

Poisson-Verteilung und das Gesetz der kleinen Zahlen . . . . . . . . . . . . 68

6.8

Der zentrale Grenzwertsatz . . . . . . . . . . . . . . . . . . . . . . . . . . . 71

6.9

Der Beweis des Satzes von de Moivre-Laplace . . . . . . . . . . . . . . . . 75

7 Zufallsvariable und Wahrscheinlichkeitsdichten

81

7.1

Dichten und Verteilungsfunktionen . . . . . . . . . . . . . . . . . . . . . . 81

7.2

Die Normalverteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 83

7.3

Exponential- und Gamma-Verteilung . . . . . . . . . . . . . . . . . . . . . 85

7.4

Lebensdauern . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 88

7.5

Gemeinsame Verteilung mehrerer Zufallsvariablen . . . . . . . . . . . . . . 90

7.6

Bedingte Verteilungen und Bedingte Erwartungen . . . . . . . . . . . . . . 97

7.7

Empirische Verteilungsfunktion und Quantile . . . . . . . . . . . . . . . . . 101

8 Kombinatorische Resultate zur Symmetrischen Irrfahrt

105

9 Erzeugende Funktionen und Momentenerzeugende Funktionen

113

9.1

Definition und Eigenschaften erzeugender

Funktionen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 113

9.2

Poisson-Prozesse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 115

9.3

Ausgedünnte Poisson-Prozesse . . . . . . . . . . . . . . . . . . . . . . . . . 116

9.4

Poisson-Prozess über dem Einheitsquadrat . . . . . . . . . . . . . . . . . . 118

9.5

Momentenerzeugende Funktionen . . . . . . . . . . . . . . . . . . . . . . . 119

9.6

χ2k -Verteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 120

9.7

tn -Verteilung

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 122

10 Die mehrdimensionale Normalverteilung

II

124

11 Schätzen

129

11.1 Maximum-Likelihood Methode . . . . . . . . . . . . . . . . . . . . . . . . . 129

11.2 Methode der Momente . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 132

11.3 Die Bayessche Formel im stetigen Fall . . . . . . . . . . . . . . . . . . . . . 133

11.4 Eigenschaften von Schätzern . . . . . . . . . . . . . . . . . . . . . . . . . . 134

11.5 Bewertung von Schätzern: Die Risikofunktion bei Bernoulli-Beobachtungen 135

11.6 Konfidenzintervalle . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 139

12 Hypothesentests

149

12.1 Grundtatsachen der Testtheorie . . . . . . . . . . . . . . . . . . . . . . . . 149

12.2 Die Gütefunktion von Tests . . . . . . . . . . . . . . . . . . . . . . . . . . 154

12.3 Der χ2 -Anpassungstest . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 157

12.4 Lineare Regression und Methode der kleinsten Quadrate . . . . . . . . . . 160

13 Markov-Ketten

163

13.1 Die Kain und Abel-Aufgabe . . . . . . . . . . . . . . . . . . . . . . . . . . 163

13.2 Markov-Ketten . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 164

13.3 Absorbierende Zustände . . . . . . . . . . . . . . . . . . . . . . . . . . . . 167

13.4 Rekurrente und transiente Zustände . . . . . . . . . . . . . . . . . . . . . . 170

13.5 Stationäre Verteilungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 172

13.6 Konvergenz gegen die stationäre Verteilung . . . . . . . . . . . . . . . . . . 175

Literaturverzeichnis

177

Kapitel 1

Einleitende und historische Bemerkungen

1.1

Was ist Stochastik?

Stochastik ist der Oberbegriff von Wahrscheinlichkeitsrechnung und mathematischer Statistik. In der Stochastik werden mathematische Modelle von Zufallserscheinungen konstruiert, deren Gesetzmäßigkeiten studiert und ihre Anwendbarkeit auf reale Daten untersucht. Die Modelle basieren auf Zufallsbegriffen, wie z.B. dem der „Wahrscheinlichkeit“.

Diese werden durch mathematische Axiome beschrieben. Die Axiome erklären jedoch nicht

das Wesen des Zufalls. Dieses ist bis heute, trotz diverser mathematischer Ansätze durch

von Mises und Kolmogorov, noch weitgehend ungeklärt.

1.2

1.

2.

3.

4.

5.

6.

7.

8.

Stochastische Tätigkeiten im Alltag

Raten

Entscheiden

Schätzen

Vergleichen / Testen

Vorhersagen

Versichern

Kontrollieren

Messen

1.–3. kennt man schon aus dem Kindesalter. Alle acht Typen von Tätigkeiten haben zum

Ziel dem Zufall geschickt zu begegnen.

1

1.2.1

Beispiele

Raten

a) In welcher Hand ist der Gegenstand?

b) Welche Antwort ist richtig bei Unwissenheit, z. B. bei “Wer wird Millionär”?

c) Wieviele Prozent erhält die AfD bei der Europwahl?

Entscheiden

a) Das Spiel: Stein–Schere–Papier

b) Wann und wo lege ich mein Geld an?

c) Zu welchem Arzt gehe ich?

Schätzen

a) Wieviel Sprit ist noch im Tank meines Autos?

b) Wie hoch ist das Steueraufkommen in der BRD in Jahr 2014?

c) Wie häufig ist eine Krankheit in der Bevölkerung (Inzidenzrate)?

Vergleichen / Testen

a) ärztliche Untersuchung auf Krankheit

b) Vergleich von ärztlichen Behandlungen

c) Entwicklung von Medikamenten

Vorhersagen

a) Tippen: Toto, Lotto

b) Dollarkurs an Weihnachten

c) Das Wetter morgen in Freiburg

Versichern

Auto, Haus, Leben

Kontrollieren

a) Kontrollieren des Blutdrucks

b) Fehlerkontrolle in der Produktion eines industriellen Teils

c) Flugsicherung

2

Messen von physikalischen Größen in Experimenten wie Masse, Länge, Temperatur,

Geschwindigkeit, Energie, Impuls:

a) Die Kombination der Ergebnisse geschieht in der Regel mit der mit der sogenannten

Fehlerausgleichsrechnung.

b) Will man sehr genau messen, kann man in Konflikt mit der Unschärferelation von

Heisenberg geraten. Diese gibt eine untere Schranke für die Maßgenauigkeit zweier zueinander konjugierter physikalischer Größen, wie z.B. Ort und Impuls eines Teilchens.

Die von Heisenberg, Schrödiger u.a. entwickelte Theorie ist stochastischer Natur. Aus

heutiger Sicht funktioniert sie in der Praxis sehr gut, ist aber von ihren Grundlagen

her noch immer unvollständig. Es scheint heute aber ziemlich klar, dass Einstein mit

seinem Spruch: “Gott würfelt nicht” nur dann recht hat, wenn es Gott tatsächlich nicht

gibt.

1.3

Historisches

Die Wahrscheinlichkeitsrechnung geht in ihren Anfängen auf das Bestimmen von Chancen

und Auszahlungen bei Spielen zurück; etwa um 1480 gibt es dazu erste Zeugnisse. Das

Spielen aber ist so alt wie die Menschheit und der Zufall war wohl schon immer beim

Spielen mit dabei. Im Altertum hat man sehr oft mit würfelähnlichen Gebilden gespielt,

meist hergestellt aus Knochen von Tieren. Bei den Griechen und Römern hieß ein solcher

“Würfel” Astragalus; er wurde aus Ziegenknochen gefertigt. Im Mittelalter kannte man

schon die uns heute geläufigen Würfel und natürlich die dazugehörigen Spiele. Eines der

frühesten Werke, das sich mit Chancen und Quoten beim Würfelspielen beschäftigt, geht

zurück auf Cardano, ca. 1550. Es heißt “Liber de Ludo Alea”. Darin finden sich Überlegungen von der Art, dass, wenn ein Würfel nicht “gezinkt” ist, die Wette auf 1, 3, 5 als

genauso günstig anzusehen ist, wie die auf 2, 4, 6. Cardano war auch einer der ersten,

der Additions- und Multiplikationsgesetze für Wahrscheinlichkeiten formulierte. Später

um 1650 berechneten Pascal und auch Huygens die Wahrscheinlichkeiten von Spielergebnissen. Um 1800 gab es bereits statistische Überlegungen in der Astronomie, z. B. bei

der Bestimmung von Planetenorten durch Gauss. Im 19. Jahrhundert wurde die Wahrscheinlichkeitsrechnung noch zur Physik gezählt. Aber Hilberts Bemühungen die Gebiete

der Mathematik solide zu begründen, führten dazu, dass Kolmogorov 1933 einen axiomatischen Zugang zur Wahrscheinlichkeitstheorie fand, der diese zu einem Teilgebiet der

Mathematik machte. Wahrscheinlichkeiten und Statistiken begegnen uns heute an vielen

Stellen des Alltags, sei es im Sport, in der Technik und Wissenschaft, in der Medizin, im

Banken- und Versicherungswesen.

Ich will diese einleitenden Bemerkungen schließen mit einem Beispiel, das die Brücke

schlägt von Cardano zu den Ereignissen unserer Tage. Am 08.04.2005 sollte ursprünglich

die Hochzeit zwischen Prinz Charles und Camilla Parker-Bowles stattfinden. Ende März

2005 stellten die Buchmacher in London die Wette auf eine Verschiebung der Hochzeit

mit einer Quote 19:1, d.h. 19 Pfund Gewinn bei 1 Pfund Einsatz. Tatsächlich trat durch

den Tod des Papstes das Ereignis ein und die Londoner Wettbüros durften kräftig zahlen.

3

Kapitel 2

Ereignisse und Wahrscheinlichkeiten

2.1

Der Würfel

Ein Würfel werde einmal geworfen:

Die Menge der möglichen Ergebnisse ist Ω1 = {1, 2, . . . , 6}. Ist der Würfel fair, so hat

man P ({i}) = 61 , 1 ≤ i ≤ 6. Folglich ergibt sich weiter

P ({2, 4, 6}) = P ({2}) + P ({4}) + P ({6}) = 3 ·

und ebenso P ({1, 3, 5}) =

1

2

1

1

=

6

2

sowie P (Ω1 ) = 1. Ist A ⊂ Ω1 , so definiert man

P (A) :=

|A|

.

|Ω1 |

Dabei ist |A| die Anzahl der Elemente der Menge A.

Nun einige Beispiele zu möglichen Ereignissen.

Beispiele:

1. Ergebnis ist ungerade ⇒ {1, 3, 5}.

2. Ergebnis ist gerade und kleiner als 4 ⇒ {2, 4, 6} ∩ {1, 2, 3} = {2}.

Ein Würfel werde zweimal geworfen:

Ein Ergebnis ist z.B. (1, 3). Beim 1. Wurf kommt eine 1, beim 2. Wurf kommt eine 3. Hier

ist die Menge der möglichen Ergebnisse

Ω2 = {(1, 1), (1, 2), . . . , (6, 6)} = {(i, j)|1 ≤ i ≤ 6, 1 ≤ j ≤ 6},

Für A ⊂ Ω2 definiert man P (A) :=

|A|

|A|

=

.

|Ω2 |

36

4

|Ω2 | = 36.

Beispiel:

Was ist die Wahrscheinlichkeit, dass die Summe zweier Würfe ≤ 10 ist?

P (Summe ≤ 10) = 1 − P (Summe > 10)

= 1 − P (Summe ≥ 11)

|B c |

3

11

c

= 1 − P (B10

) = 1 − 10 = 1 −

= .

|Ω2 |

36

12

c

Dabei sind B10 = {(1, 1), . . . , (4, 6)} und B10

= {(5, 6), (6, 5), (6, 6)}.

Beispiel:

Was ist die Wahrscheinlichkeit, dass das Ergebnis des 2. Wurfs größer ist als das des 1.?

Sei C = {(i, j)|i < j, 1 ≤ i ≤ 6, 1 ≤ j ≤ 6}. Dann ist

P (2. Wurf > 1. Wurf) = P (C) =

6(6−1)

2

62

=

5

.

12

Ein Würfel wird n-mal geworfen:

Zunächst sollen Produktmengen erklärt werden.

Seien Ω1 , . . . , Ωn Mengen und Ai ⊂ Ωi , i = 1, . . . , n Teilmengen. Dann heißt

A1 × A2 × · · · × An := {(a1 , . . . , an ) | ai ∈ Ai , i = 1, . . . , n}

Produktmenge der Ai . Gilt |Ai | < ∞ für alle 1 ≤ i ≤ n, so ist

|A1 × A2 × · · · × An | =

n

∏

|Ai |.

i=1

Die Ergebnismenge beim n-maligen Würfelwurf ist

Ωn = Ω1 × · · · × Ω1 = {(a1 , . . . , an ) | ai ∈ {1, . . . , 6}, 1 ≤ i ≤ n}.

{z

}

|

n×

Es gilt |Ωn | = 6n .

Beispiel:

Was ist die Wahrscheinlichkeit, dass alle Ergebnisse größer als “1” sind? Sei

A = {(a1 , . . . , an ) | ai > 1, i = 1, . . . , n} = {(a1 , . . . , an ) | ai ∈ {2, . . . , 6}, i = 1, . . . , n}

( )n

|A|

5n

5

Damit ist

P (A) =

= n =

.

|Ωn |

6

6

Es sei noch bemerkt, dass nicht alle Ergebnismengen Ω Produktform haben, wie das folgende Beispiel zeigt.

5

Beispiel:

In der ersten Stufe wird ein Würfel einmal geworfen, sagen wir mit Ergebnis “i”. In der

zweiten Stufe wird i mal gewürfelt und das Ergebnis jedes Wurfes festgehalten. Wie groß

ist die Wahrscheinlichkeit, dass die Summe der Ergebnisse der zweiten Stufe kleiner gleich

“6” sind?

6

∪

Seien Ωi = {(a1 , . . . , ai ) | 1 ≤ aj ≤ 6 für 1 ≤ j ≤ i}, Ω = {i} × Ωi ,

i=1

{

}

∑

6

i

∪

aj ≤ 6 . Sei A = {i} × Ai , dann ist

Ai = (a1 , . . . , ai ) ∈ Ωi j=1

i=1

)

(6

6

6

6

∑

∑

∪

1

1 ∑ |Ai |

P ({i} × Ai ) =

P (A) = P

{i} × Ai =

P (Ai ) =

.

6

6 i=1 |Ωi |

i=1

i=1

i=1

Bestimme die Ai und ihre Anzahl.

A1 = {(1), (2), . . . , (6)}, |A1 | = 6

A2 = {(1, 1), (1, 2), . . . , (5, 1)},

|A2 | = 15

A3 = {(1, 1, 1), (1, 1, 2), . . . , (4, 1, 1)},

|A3 | = 20

|A4 | = 15, |A5 | = 6, |A6 | = 1 .

Es folgt

1

P (Summe ≤ 6) =

6

2.2

(

6 15 20 15

6

1

+ 2 + 3 + 4 + 5+ 6

6 6

6

6

6

6

)

= 0, 253604 .

Chancen-/Gewinnverhältnisse und Auszahlungsquoten

Das Chancenverhältnis

(englisch: odds)

Sei A ein Ereignis und Ac das Gegenereignis.

R(A) :=

P (A)

P (A)

=

c

P (A )

1 − P (A)

heißt das Chancenverhältnis von A.

Beispiel: “Sechs” beim Würfeln

Für einen fairen Würfel gilt:

1

5

und P ({6}c ) =

6

6

1

1/6

= .

R(A) =

5/6

5

P ({6}) =

In Worten: R(A) ist 1 zu 5.

6

Das Gewinnverhältnis

Bleiben wir bei obigem Beispiel und spielen folgendes Spiel. Der Spieler gewinnt, wenn die

“6” kommt, ansonsten verliert er. Der Einsatz sei 1A

C. Die Auszahlung ist 6A

C, wenn “6”

kommt und 0A

C, wenn keine “6” kommt. Die Auszahlung setzt sich aus 5A

CGewinn + 1A

C

Einsatz zusammen. Der mittlere Gewinn (MG) ist

MG = P ({6}) · Gewinn − P ({6}c ) · Einsatz =

1

5

· 5 − · 1 = 0.

6

6

Da der mittlere Gewinn gleich 0 ist, spricht man von einem fairen Spiel. Das Gewinnverhältnis beträgt hier 5 zu 1 (5:1).

Grundprinzip des fairen Wettens

Bei einer fairen Wette, verhalten sich die Gewinnverhältnisse umgekehrt proportional wie

die Chancenverhältnisse.

Man kann dieses Prinzip aber auch über den Einsatz ausdrücken: Die Einsätze sind proportional zu den Wahrscheinlichkeiten.

Man denke nur an das Würfelspiel, bei dem der Spieler 1A

C Einsatz und der Wettanbieter

5A

C zahlen.

Auszahlungsverhältnisse

Bei Sportwetten wie z.B. b-win werden nicht die Gewinnverhältnisse angegeben, sondern

die Auszahlungsverhältnisse, auch einfach Quoten genannt. Das Auszahlungsverhältnis

gibt die Auszahlung im Verhältnis zum Einsatz an. Die Auszahlung setzt sich aus Einsatz und Gewinn zusammen. So gab es für das Bundesligaspiel “Karlsruher SC - TSG

Hoffenheim” am 18.04.2009 die Quoten:

1) 2,85 : 1

2) 3,20 : 1

3) 2,30 : 1

bei Karlsruher SC-Sieg

bei Unentschieden

bei Karlsruher SC-Niederlage.

Das Angebot ist nicht ganz fair, was natürlich daran liegt, dass b-win etwas Gewinn

machen will.

Betrachten wir nochmals die Situation beim Würfel, wenn wir die drei Ereignisse {1, 2, 3},

{4, 5} und {6} wählen. Faire Quoten sind dann:

1) 2 : 1 bei {1, 2, 3}

2) 3 : 1 bei {4, 5}

3) 6 : 1 bei {6}.

Die jeweiligen Wahrscheinlichkeiten ergeben sich gerade als die Kehrwerte der Quoten.

Dies gilt allgemein.

Hat die faire Wette auf ein Ereignis E die Wahrscheinlichkeit p und den Gewinn G, so

gilt bei einem Einsatz von 1

p(G + 1) = 1.

7

Denn sei E c das Gegenereignis von E, so ist der mittlere Gewinn

M G = G · p − 1 · (1 − p) = 0.

Diese Gleichung ist aber äquivalent zur vorangegangenen. Also gilt bei einer fairen Wette

der Zusammenhang

p=

1

, wobei (G + 1) : 1 die Wettquote ist.

G+1

Bezogen auf das Spiel “Karlsruher SC” gegen “TSG Hoffenheim” findet man

Karlsruher SC-Sieg

p1 = 0, 35

Unentschieden

p2 = 0, 36

Karlsruher SC-Niederlage p3 = 0, 43

Da p1 + p2 + p3 = 1, 14 ist, ist die Wette nicht ganz fair. Bekanntlich ist das Spiel 2:2

ausgegangen.

2.3

Mengentheoretische Beschreibung von Ereignissen

Sei Ω die Menge aller möglichen Ergebnisse ω eines Zufallsexperiments. Ein Ereignis wird

durch eine logische Aussage festgelegt. Dazu gehört genau eine Menge A ⊂ Ω. Wir identifizieren von nun an Ereignisse mit Teilmengen von Ω, nämlich genau mit den Mengen,

deren Elemente die logische Aussage erfüllen. Das heißt, was eintritt bzw. nicht eintritt,

beschreiben wir durch Mengen.

Bezeichnungsweisen

Grundraum Ω:

sicheres Ereignis

Leere Menge Ø : unmögliches Ereignis

A ⊂ B:

A liegt in B; aus A folgt B

B \ A:

B ohne A; ω ∈ B \ A genau dann wenn ω ∈ B und ω ̸∈ A

c

A:

Komplement von A, Gegenereignis; ω ∈ Ac genau dann wenn ω ̸∈ A

A ∩ B:

A und B; ω ∈ A ∩ B genau dann wenn ω ∈ A und ω ∈ B

A ∪ B:

A oder B; ω ∈ A ∪ B genau dann wenn ω ∈ A oder ω ∈ B

(lässt ω ∈ A ∩ B zu!)

P(Ω) :

Potenzmenge von Ω; das System aller Teilmengen von Ω.

Wichtige Rechenregeln:

Kommutativgesetze:

Assoziativgesetze:

Distributivgesetze:

Gesetze von de Morgan:

A ∩ B = B ∩ A, A ∪ B = B ∪ A

A ∩ (B ∩ C) = (A ∩ B) ∩ C,

A ∪ (B ∪ C) = (A ∪ B) ∪ C

A ∩ (B ∪ C) = (A ∩ B) ∪ (A ∩ C),

A ∪ (B ∩ C) = (A ∪ B) ∩ (A ∪ C)

(A ∪ B)c = Ac ∩ B c , (A ∩ B)c = Ac ∪ B c

8

Endliche Vereinigungen und Schnitte. Seien A1 , . . . , An Ereignisse

∪ni=1 Ai = A1 ∪ . . . ∪ An und ∩ni=1 Ai = A1 ∩ . . . ∩ An

Abzählbare Vereinigungen und Schnitte. Seien A1 , A2 , . . . Ereignisse

∞

∪∞

i=1 Ai = A1 ∪ A2 ∪ . . . und ∩i=1 Ai = A1 ∩ A2 ∩ . . .

Gesetze von de Morgan gelten auch hier:

c

c

∞

c

∞

∞

c

(∩∞

i=1 Ai ) = ∪i=1 Ai und (∪i=1 Ai ) = ∩n=1 Ai

Man definiert auch zu einer Folge von Ereignissen (An ; n ≥ 1)

lim inf An :=

n

∞ ∩

∪

Am

n=1 m≥n

und

lim sup An :=

n

∞ ∪

∩

Am

n=1 m≥n

Es gilt stets lim inf An ⊂ lim sup An . Man sagt lim An existiert, wenn lim inf An = lim sup An

n

n

n

n

∪n

An = A. Dann ist

gilt. Dies gilt zum Beispiel, wenn An ⊂ An+1 für alle n ≥ 1 ist und

n≥1

A = lim An .

n

2.4

Wahrscheinlichkeitsmaße

Sprechweise: Zwei Ereignisse A und B mit A ∩ B = Ø heißen disjunkt. Ist A1 , A2 , . . .

eine endliche oder abzählbare Folge von Ereignissen mit Ai ∩ Aj = Ø für i ̸= j, so heißen

diese Ereignisse paarweise disjunkt.

Definition 2.4.1 Sei Ω eine endliche oder abzählbar unendliche Menge. Eine Abbildung

P von P(Ω) nach IR heißt Wahrscheinlichkeitsmaß auf P(Ω), falls gilt

1. P (A) ≥ 0 für A ∈ P(Ω)

2. P (Ω) = 1

3. für paarweise disjunkte Ereignisse A1 , A2 , . . . aus P(Ω) ist

P

(∞

∪

i=1

)

Ai

=

∞

∑

P (Ai ) (σ-Additivität).

i=1

9

Rechenregeln:

i) P (Ø) = 0.

Begründung: Ai = Ø für i ≥ 1 ist paarweise disjunkte Folge. Damit P (Ø) = P (Ø) +

P (Ø) + . . ..

ii) P (A ∪ B) = P (A) + P (B) falls A und B disjunkt sind.

Begründung: A ∪ B = A ∪ B ∪ Ø ∪ Ø ∪ . . .. Damit ist P (A ∪ B) = P (A) + P (B) +

0 + 0 + . . . = P (A) + P (B).

iii) P (Ac ) = 1 − P (A).

Begründung: folgt aus ii) mit Ω = A ∪ Ac .

iv) Ist A ⊂ B, so gilt P (B \ A) = P (B) − P (A).

Begründung: folgt aus ii) mit B = A ∪ (B \ A) und A ∩ (B \ A) = Ø.

v) Ist A ⊂ B, so gilt P (A) ≤ P (B).

vi) P (A ∪ B) = P (A) + P (B) − P (A ∩ B).

Begründung: A ∪ B = A ∪ (B \ (A ∩ B)).

Für die weiteren Überlegungen ist die folgende Gleichung nützlich:

∑

P (A) =

P ({ω})

ω∈A

Sie ist eine direkte Folge der Definition eines Wahrscheinlichkeitsmaßes.

Weitergehend hat man

P (A ∪ B ∪ C) = P (A) + P (B) + P (C) − P (A ∩ B) − P (A ∩ C) − P (B ∩ C) + P (A ∩ B ∩ C)

Dies sieht man durch Fallunterscheidung, wenn man alle Terme als Summen gemäß der

vorangegangenen Gleichung liest und zählt wie oft die einzelnen Terme jeweils auftauchen.

Entsprechend argumentierend erhält man die Ungleichungen

(n

)

n

∪

∑

P

Ai ≤

P (Ai )

i=1

(

P

n

∪

i=1

)

Ai

i=1

≥

n

∑

P (Ai ) −

i=1

∑

P (Ai ∩ Aj )

i<j

Schließlich gilt allgemein die Ein- und Ausschlussformel von Poincaré:

(

vii) P

n

∪

i=1

)

Ai

=

n

∑

i=1

+

P (Ai ) −

∑

∑

P (Ai ∩ Aj )

i<j

P (Ai ∩ Aj ∩ Ak ) + · · · + (−1)n+1 P (A1 ∩ A2 ∩ . . . ∩ An ).

i<j<k

10

Sie beweist man folgendermaßen:

Wir schreiben die Aussage wie folgt um:

(n

)

( )

∪

∑

P

Ai =

(−1)|I|−1 P AI

i=1

Dabei ist AI :=

∩

i∈I

I⊂{1,...,n}

Ai und I bezeichnet eine nicht leere Teilmenge von {1, . . . , n}.

Zeige, die rechte Seite ist gleich der linken. Sei Jω = {i | ω ∈ Ai }. Dann gilt ω ∈ AI genau

dann, wenn I ⊂ Jω . Die rechts Seite ist folglich gleich

)

(∑

)

(∑

∑

∑

P ({ω}) =

P ({ω})

(−1)|I|−1 .

(−1)|I|−1

ω∈AI

I⊂{1,...,n}

ω∈

∪n

i=1

I⊂Jω

Ai

Sei nun |Jw | = j ≥ 1.

Dann gilt

∑

(−1)

|I|−1

=

j

∑

i−1

(−1)

i=1

I⊂Jω

= 1−

j−1

∑

i=0

( )

j

i

( )

j

(−1)

i

i

=1

Der 2. Term in der 2. Zeile ist gleich Null wegen der binomischen Formel für (1 − 1)n

(siehe unten!).

2

Wir wollen zunächst noch drei weitere Eigenschaften von Wahrscheinlichkeitsmaßen angeben, die auf unendlichen Folgen und Reihen beruhen:

viii) Seien An ⊂ Ω mit An ⊂ An+1 für alle n ≥ 1 und sei A =

∞

∪

An . Dann gilt

n=1

P (A) = lim P (An ).

n→∞

ix) Seien An ⊂ Ω mit An+1 ⊂ An für alle n ≥ 1 und sei A =

∞

∩

An . Dann gilt

n=1

P (A) = lim P (An ).

x) P

(∞

∪

i=1

n→∞

)

Ai

≤

∞

∑

P (Ai ) für beliebige Ai ⊂ Ω.

i=1

Beweis von viii)und ix):

Seien B1 = A1 , Bi = Ai \ Ai−1 für i ≥ 1. Dann sind die Bi paarweise disjunkt und es gilt

n

∞

∪

∪

An =

Bi und A =

Bi . Es folgt mit der σ-Additivität

i=1

i=1

P (A) = P

(∞

∪

i=1

)

Bi

=

∞

∑

P (Bi ) = lim

n→∞

i=1

11

n

∑

i=1

P (Bi ) = lim P (An ).

n→∞

Eigenschaft ix) sieht man so: An ⊃ An+1 ⊃ . . . ,

A=

∞

∩

An .

n=1

Seien A′n = Acn und A′ = Ac . Dann ist A′n ⊂ A′n+1 ⊂ . . . ,

A′ =

∞

∪

A′n .

n=1

Wegen viii) gilt

lim P (A′n ) = P (A′ ), d.h. lim (1 − P (An )) = 1 − P (A),

n→∞

n→∞

2

woraus lim P (An ) = P (A) folgt.

n→∞

Beispiel für die Stetigkeitseigenschaft

Wir betrachten beim beliebig langen Würfelwurf das Ergebnis

A = {irgendwann kommt eine “6”}

Im Grundraum

Ω = {(ω1 , ω2 , ω3 , . . . ) | ωi ∈ {1, . . . , 6}}

lässt sich Ac leicht darstellen als

Ac = {(ω1 , ω2 , ω3 , . . . ) | ωi ̸= 6 für alle i ≥ 1}.

Sei

An = {unter den ersten n Würfen kommt “6”}.

Dann ist

Da Acn ⊃ Acn+1

Acn = {(ω1 , ω2 , ω3 , . . . ) | ωi ̸= 6 für i = 1, . . . , n}.

∞

∩

für alle n und Ac =

Acn , können wir, Formel ix) anwenden:

i=1

c

P (A ) = lim

n→∞

P (Acn )

( )n

5

= 0.

= lim

n→∞

6

Damit ist P (A) = 1 − P (Ac ) = 1.

2. Möglichkeit: Man kann dies auch so erhalten:

∞

∑

P (irgendwann kommt “6“) =

P (“6” kommt erstmals im i-ten Wurf)

=

i=1

∞ (

∑

i=1

)

5 i−1 1

6

6

=

1

6

∞ ( )

∑

5 i

i=0

6

=

1 1

6 1− 56

= 1.

Eine einfache Festlegung eines Wahrscheinlichkeitsmaßes geschieht durch eine Wahrscheinlichkeitsfunktion.

Definition 2.4.2 Sei Ω eine höchstens abzählbar unendliche Menge. Eine Abbildung

p : Ω → [0, 1]

∑

p(ω) = 1 ist.

heißt Wahrscheinlichkeitsfunktion, falls

ω∈Ω

12

Satz 2.4.3 (Zusammenhang zwischen WS-Maße und WS-Funktion)

1.) Sei p eine Wahrscheinlichkeitsfunktion auf Ω. Für A ⊂ Ω wird durch

∑

P (A) :=

p(ω)

ω∈A

ein Wahrscheinlichkeitsmaß definiert.

2.) Sei P ein Wahrscheinlichkeitsmaß. Durch

p(ω) := P ({ω})

wird eine Wahrscheinlichkeitsfunktion erklärt.

Beweis:

Zu 1.): Weise die Eigenschaften eines Wahrscheinlichkeitsmaßes nach.

a) P (Ω) =

∑

p(ω) = 1 nach Definition 2.4.2.

ω∈Ω

b) Seien Ai ⊂ Ω i ≥ 1 disjunkt. Dann folgt mit dem Reihenumordungssatz

(∞ )

∞ ∑

∞

∪

∑

∑

∑

P

Ai =

p(ω) =

p(ω) =

P (Ai ).

i=1

ω∈

∪

i=1 ω∈Ai

Ai

i=1

i

Zu 2.) Weise die Eigenschaft einer Wahrscheinlichkeitsfunktion nach.

(

)

∑

∑

∪

p(ω) =

P ({ω}) = P

{ω} = P (Ω) = 1.

ω∈Ω

ω∈Ω

ω∈Ω

2

Die Wahrscheinlichkeitsfunktion heißt oft auch Zähldichte oder Wahrscheinlichkeitsgewichtsfunktion.

Beispiele für Wahrscheinlichkeitsfunktionen:

1. Würfel: Ω = {1, 2, . . . , 6}, p(ω) = 16 .

2. Fairer Münzenwurf: Ωn = {ω = (ω1 , . . . , ωn ) | ωi ∈ {0, 1}, i = 1, . . . , n}, p(ω) =

für ω ∈ Ωn .

3. Gleichverteilung: Ω endlich, p(ω) =

1

.

|Ω|

13

1

2n

Kapitel 3

Gleichverteilungen

3.1

Gleichverteilung und Kombinatorik

Man nimmt an, es gibt endlich viele Ausgänge, die alle gleich wahrscheinlich sind.

Sei Ω = {ω1 , ω2 , . . . , ωn } mit n = |Ω|

P ({ω1 }) = P ({ω2 }) = . . . = P ({ωn }) = 1/n

Für beliebiges A ⊂ Ω gilt dann:

P (A) =

Anzahl der für A günstigen Ergebnisse

|A|

=

.

Anzahl aller möglichen Ergebnisse

|Ω|

Dies ist die sogenannte Abzählregel.

Beispiel:

Dreimaliges Werfen einer fairen Münze. Wappen kodieren wir mit 0 und Zahl mit 1. Dann

ist

Ω = {0, 1} × {0, 1} × {0, 1}

= {(0, 0, 0), (1, 0, 0), (0, 1, 0), (0, 0, 1), (1, 1, 0), (1, 0, 1), (0, 1, 1), (1, 1, 1)}

Offensichtlich ist |Ω| = 23 = 8. Sei A das Ereignis mindestens einmal Wappen und mindestens einmal Zahl. Dann ist

A = {(1, 0, 0), (0, 1, 0), (0, 0, 1), (1, 1, 0), (1, 0, 1), (0, 1, 1)}.

Wir haben |A| = 6 und somit P (A) = 6/8 = 3/4. Man kann natürlich auch über das

Gegenereignis kein mal Wappen oder kein mal Zahl argumentieren und erhält

Ac = {(0, 0, 0), (1, 1, 1)}

14

mit P (Ac ) = 2/8 = 1/4.

Auch bei Ereignissen mit unendlich vielen Elementen lässt sich mit Gleichverteilung rechnen: Man werfe eine faire Münze beliebig lange. Was ist die Wahrscheinlichkeit irgendwann

eine “1” zu werfen? Das entsprechende Ereignis lautet: A = {(1), (0, 1), (0, 0, 1), . . .}.

Mit Hilfe der σ Additivität des Wahrscheinlichkeitsmaßes ergibt sich

P (A) = P ((1)) + P ((0, 1)) + P ((0, 0, 1)) + . . .

∑

1 1 1

+ + + ... =

2−i = 1.

2 4 8

i=1

∞

=

Kombinatorische Hilfsmittel

Zunächst führen wir die Binomialkoeffizienten ein. Wie betrachten ein quadratisches Gitter und zählen die Wege von( (0,

) 0) zu dem Punkt (k, n − k). Dies geht rekursiv. Wir

n

bezeichnen diese Anzahl mit k .

1

1

1

1

1

1

1

1

7

6 21

5 15

4 10

3 6

2 3

1 1

35

20 35

10 15 21

4 5 6 7

1 1 1 1

1

Drehen wir nun dieses Schema, so erhalten wir das Pascalsche Dreieck.

1

1

1

1

1

1

1

1

7

2

5

3

6

1

4

10

15

21

1

3

4

6

1

10

20

35

1

5

15

35

1

6

21

1

7

1

Nach Konstruktion gehorcht es dem folgenden Bildungsgesetz

( ) (

) (

)

n

n−1

n−1

=

+

k

k−1

k

für 1 ≤ k ≤ n − 1 und n ≥ 1.

Zusätzlich gilt

15

( ) ( )

n

n

=

=1

0

n

für n ≥ 0

und

( )

n

=0

k

für k > n.

Aus dem Bildungsgesetz folgt mit vollständiger Induktion

( )

n

n!

=

.

k

k!(n − k)!

Dabei ist n! = n · (n − 1) · · · 2 · 1, gesprochen “n Fakultät”.

Hier sind einige Formeln für für Binomialkoeffizienten.

( )

n

n!

=

(1)

für 0 ≤ k ≤ n

k

k!(n − k)!

( ) (

)

n

n

(2)

=

n−k

k

( )

(

)

n

n−1

(3) k

=n

k

k−1

m ( )

∑

n k n−k

n

(4) (x + y) =

x y , x, y ∈ IR

k

k=0

(5)

n ( )

∑

n

k=0

k

= 2n

( )

n

(−1)

=0

(6)

k

k=0

n

∑

k

( )

n

∑

n

k

= n · 2n−1

(7)

k

k=0

(8)

n ( )

∑

k

k=0

m

(

=

n+1

m+1

)

für n ≥ m

Wir geben nun zwei Mengen an, deren Mächtigkeiten jeweils

1.) Sei A = {(ω1 , . . . , ωn ) | ωi ∈ {0, 1},

n

∑

(n )

k

ist.

ωi = k} Dann ist |A| =

i=1

(n )

k

.

Diese Menge entspricht genau den Wegen im Gitter mit Länge n und k Anstiegen in

Richtung y-Achse.

( )

2.) Sei Ω = {1, . . . , n} und Pk = {A ⊂ Ω | |A| = k}. Dann ist |Pk | = nk .

Dies folgt so: Jede Teilmenge mit k Elementen einer n-elementigen Menge entspricht

eine 0-1 Folge der Länge n. An der i-ten Stelle der 0-1 Folge steht eine 1, wenn das

i-te Element in der Menge A liegt.

16

Eine wichtige Methode zum Abzählen stellen wir nun vor.

Das Kombinationsprinzip: Sei Ω eine Menge von k-Tupeln ω = (ω1 , . . . , ωk ), die man

als Ergebnisse eines aus k Teilexperimenten bestehenden Zufallsexperimentes auffassen

kann, wobei ωi das Ergebnis des i-ten Teilexperimentes ist. Für das erste Teilexperiment

gebe es n1 mögliche Ausgänge. Für jedes i sei ni die Zahl der möglichen Ausgänge des

i-ten Teilexperimentes, unabhängig davon wie die früheren Teilexperimente ausgegangen

sind. Dann ist: |Ω| = n1 n2 . . . nk

Ein Beispiel:

In einer Urne sind 5 weiße und 4 schwarze nummerierte Kugeln. Es werden 3 Kugeln

gezogen. Was ist die Wahrscheinlichkeit

2 weiße und eine schwarze Kugel

(9)

(5)(4)zu ziehen? Die

Anzahl der möglichen Fälle ist 3 . Die Anzahl der günstigen Fälle ist 2 1 . Die gesuchte

(5)(4)

Wahrscheinlichkeit beträgt also 2 9 1 = 10

.

21

(3)

Was heißt Ziehen? Sei eine Urne mit n nummerierten Kugeln gegeben. Aus der Urne

wird eine Stichprobe vom Umfang k gezogen. Wir interessieren uns für die Anzahl der

verschieden Stichproben. Dies ist für die Berechnung von Wahrscheinlichkeiten nach der

Abzählregel von Nutzen. Dabei gilt es zu beachten, dass unter Ziehen unterschiedliches

gemeint sein kann.

• Berücksichtigung der Reihenfolge:

– Reihenfolge der Ziehung wird berücksichtigt: geordnete Probe.

– Reihenfolge der Ziehung wird nicht berücksichtigt: ungeordnete Probe.

• Zurücklegen:

– mit Zurücklegen: Mehrfachziehung möglich.

– ohne Zurücklegen: Mehrfachziehung nicht möglich.

Damit ergeben sich vier Kombinationsmöglichkeiten.

Geordnete Probe mit Zurücklegen: Die Anzahl der Proben ist gleich der Anzahl der

k-Tupel (x1 , . . . , xk ) mit xi ∈ N für i = 1, . . . , k. Diese Anzahl ist nk .

Geordnete Probe ohne Zurücklegen: Die Anzahl der Proben ist gleich der Anzahl

der k-Tupel (x1 , . . . , xk ) mit xi ∈ N für i = 1, . . . , k, bei denen xi ̸= xj für i ̸= j gilt. Mit

dem Kombinationsprinzip ergibt sich diese Anzahl (die Zahl der Möglichkeiten wird bei

jeder Ziehung um eins kleiner!) als:

n(n − 1) . . . (n − (k − 1)) =

k−1

∏

i=0

17

(n − i).

Offensichtlich muss hier k ≤ n gelten. Für den Spezialfall k = n entspricht jede Stichprobe einer Anordnung der Elemente der Menge N = {1, . . . , n}. Man erhält also die

Permutationen von N . Deren Anzahl n(n − 1) . . . 1 ist gleich n!. Damit ist

n(n − 1) . . . (n − k + 1) =

n!

.

(n − k)!

Ungeordnete Probe ohne Zurücklegen: Die Anzahl solcher Proben ist gleich der

Anzahl der verschiedenen Teilmengen von N mit genau k Elementen. Diese Anzahl ist

( )

n(n − 1) . . . (n − (k − 1))

n!

n

=

=

.

k(k − 1) . . . 1

k!(n − k)!

k

Dies ist der Binomialkoeffizient n über k.

Ungeordnete Probe mit Zurücklegen: Bei der vorangegangenen Situation lässt sich

die Menge aller möglichen Ergebnisse schreiben als

Ωnk := {(ω1 , . . . , ωk ) | 1 ≤ ω1 < ω2 < · · · < ωk ≤ n}

Hier nun beim Ziehen mit Zurücklegen ist die Menge aller Ergebnisse

Ω := {(ω1 , . . . , ωk ) | 1 ≤ ω1 ≤ ω2 ≤ · · · ≤ ωk ≤ n}

Um nun Ω abzuzählen, bilden wir Ω auf eine neue Menge mit derselben Mächtigkeit ab

und bestimmen deren Größe. Die Abbildung geht so: Sei ω ∈ Ω und dargestellt als

1 ≤ ω1 ≤ ω2 ≤ ω3 ≤ · · · ≤ ωk ≤ n.

Für das Bildelement wählen wir (ω1 , ω2 + 1, ω3 + 2, . . . , ωk + k − 1), so dass gilt:

1 ≤ ω1 < ω2 + 1 < ω3 + 2 < · · · < ωk + k − 1 ≤ n + k − 1.

Diese Zuordnung liefert eine Bijektion von Ω auf Ωkn+k−1 . Letztere Menge hat aber

Elemente.

(n+k−1)

k

Anwendung: (Lotto 6 aus 49)

Es werden 6 Kugeln aus 49 Kugeln gezogen, die von 1 bis 49 nummeriert sind. Die Reihenfolge der Ziehung spielt dabei keine Rolle. Der Ziehungsmechanismus stellt sicher, dass

jede Kombination (= ungeordnete Stichprobe ohne Zurücklegen!) gleichwahrscheinlich ist.

Damit liegt Gleichverteilung vor.

Der Grundraum lässt sich folgendermaßen beschreiben:

Ω = {(ω1 , . . . , ω6 )|1 ≤ ω1 < ω2 < ω3 < ω4 < ω5 < ω6 ≤ 49}.

Die Wahrscheinlichkeit für Sechs Richtige ist

1

(49) =

6

6×5×4×3×2×1

1

=

≈ 7, 510−8 .

49 × 48 × 47 × 46 × 45 × 44

13.983.816

Um die Wahrscheinlichkeit für Drei Richtige zu bestimmen, benötigen wir die Anzahl

der Kombinationen, die genau drei der von uns getippten Zahlen enthalten. Unser Tipp

18

zerlegt die 49 Zahlen in zwei Mengen: die 6 von uns getippten und die 43 von uns nicht

getippten. Eine Kombination mit drei richtigen enthält drei Zahlen aus den 6 getippten

und drei Zahlen aus den 43 nicht getippten. Die Wahrscheinlichkeit für Drei Richtige ist

damit

( )( )

6

3

43

(49)3

≈ 0, 0176.

6

Die Wahrscheinlichkeit für 5 Richtige mit Zusatzzahl ist

(1)(6)(42)

1

5

(49

)0

≈ 4, 2 · 10−7 .

6

Richtige günstige Fälle

6R

1

5R+Z

6

5R

258

4R+Z

630

4R

13545

3R

246820

Chance

1/13983816

1/2330636

1/54200

1/22196

1/1032

1/57

Tabelle 3.1: Lotto ’6 aus 49’

Fixpunktfreie Permutationen

Nun wollen wir noch eine Aufgabe behandeln, die sowohl die kombinatorischen Hilfsmittel

als auch die Ein- und Ausschlussformel benutzt.

n Personen kommen mit je einem Geschenk zu einer Party. Die Geschenke werden zufällig

verteilt. Jede Person erhält genau ein Geschenk. Wie groß ist die Wahrscheinlichkeit, dass

wenigstens eine Person ihr Geschenk zurückerhält?

Wir denken uns die n Personen durchnummeriert von 1, . . . , n. Sei ωi die Nummer der

Person, die ihr Geschenk von i erhält. Sei Ω = {ω = (ω1 , . . . , ωn ) | 1 ≤ ωi ≤ n, ωi ̸=

ωj für i ̸= j}. Ω stellt die Menge der Permutationen von 1, . . . , n dar. Ω hat nach dem

Kombinationsprinzip n! Elemente und man nimmt Gleichverteilung an:

P ({ω}) =

1

.

n!

Sei Ai das Ereignis, dass Person i ihr Geschenk zurückerhält. Das genau k Personen ihr

Geschenk zurückerhalten, hat Wahrscheinlichkeit

P (Ai1 ∩ . . . ∩ Aik ) = P (A1 ∩ . . . ∩ Ak ) =

(n − k)!

.

n!

Denn die Anzahl der Permutationen, die die ersten k Elementen fest lassen, ist gleich

der Anzahl der Permutationen von n − k Elementen, also (n − k)!. Dann ist die Wahrscheinlichkeit, dass mindestens eine Person ihr Geschenk zurückerhält, nach der Ein- und

19

Ausschlussformel gleich

P (A1 ∪ . . . ∪ An ) =

n

∑

∑

(−1)k−1 P (Ai1 ∩ . . . ∩ Aik )

k=1 {i1 ,...,ik }∈Pk

=

n

∑

k−1

(−1)

k=1

=

( )

n (n − k)!

k

n!

n

∑

(−1)k−1

k=1

= 1−

k!

n

∑

(−1)k

k=0

k!

Für sehr viele Gäste (n → ∞) konvergiert diese Wahrscheinlichkeit gegen 1 − e−1 .

Das Komplementärereignis hierzu ist, dass kein Gast sein mitgebrachtes Geschenk zurückerhält. Die Wahrscheinlichkeit dafür konvergiert gegen e−1 ∼

= 0, 37. Folglich sind für

große n etwa 37 % aller Permutationen fixpunktfrei.

Eine kombinatorische Aufgabe

In einer Urne seien n weiße und n schwarze nummerierte Kugeln. Die weißen Kugeln tragen

die Nummern 1, . . . , n, die schwarzen Kugeln die Nummern n + 1, . . . , 2n. n Personen

ziehen ohne Zurücklegen je zwei Kugeln. Was ist die Wahrscheinlichkeit, dass jede Person

eine schwarze und eine weiße Kugel zieht?

Sei A = {1, 2, . . . , n, n + 1, . . . , 2n} die Menge der Kugeln in der Urne. Der Grundraum

| {z } |

{z

}

weiß

schwarz

ist dann: Ωn = {({a1 , b1 }, . . . , {an , bn })|ai , bi ∈ A,

n

∪

{ai , bi } = A}.

i=1

( )

es 2n

2

Die erste Person zieht zwei Kugeln. Dafür gibt

Möglichkeiten.

In der( Urne) befinden sich jetzt nur noch 2n − 2 Kugeln. Für die zweite Person gibt es also

noch 2n−2

Möglichkeiten.

2

(2n+2−2k)

Führt man diesen Gedanken fort, so

gibt

es

für

die

k-te

Person

Möglichkeiten

2

(2n+2−2n) (2)

und für die letzte Person nur noch

= 2 = 1 Möglichkeit.

2

Nach dem Kombinationsprinzip ist somit die Mächtigkeit des Grundraumes:

( )(

)(

) ( )

2n 2n − 2 2n − 4

2

(2n)(2n − 1) (2n − 2)(2n − 3)

(2n)!

|Ωn | =

...

=

...1 = n .

2

2

2

2

2

2

2

Sei

Bn := {({a1 , b1 }, . . . , {an , bn }) | ai ∈ {1, . . . , n}, bi ∈ {n + 1, . . . , 2n},

n

∪

{ai , bi } = A} ⊂ Ωn

i=1

das Ereignis, dass alle n Person zwei Kugeln mit unterschiedlichen Farben ziehen.

Dann ist die Mächtigkeit von Bn : |Bn | = n · n · (n − 1) · (n − 1) · . . . · 1 = (n!)2 .

20

(n!)2

Damit ist P (Bn ) =

.

(2n)!/2n

Für große n lässt sich die Wahrscheinlichkeit näherungsweise mit der Stirling-Formel berechnen:

P (Bn ) =

(n!)2 2n

(2πn)n2n e−2n · 2n √ 1 · 2n √

∼ √

= πn 2n = πn/2n .

2n

−2n

(2n)!

2

4πn(2n) e

Dabei haben wir die Stirling-Formel verwendet. Diese lautet:

√

n! ∼ 2πnnn e−n für n → ∞,

das heißt

√

n!/ 2πnnn e−n → 1

für n → ∞.

Das Schachtelmodell

Dies ist eine duale Betrachtungsweise zum Urnenmodell. Verteilt man k nummerierte

Kugeln auf n nummerierte Schachteln, so gibt (a1 , . . . , ak ) die Schachtelnummern an, in

denen die Kugeln liegen. ai ist die Schachtel, die die i-te Kugel enthält. Da es n Möglichkeiten für jede Kugel gibt, hat man nk Möglichkeiten. Erlaubt man nur je eine Kugel pro

Schachtel, hat die erste Kugel n mögliche Schachteln zur Auswahl, die zweite Kugel nur

n!

(n − 1) u.s.w.; insgesamt (n−k)!

Möglichkeiten. Sind die Kugeln nicht nummeriert, so gelten sie als ununterscheidbar. Einfachbesetzung

bedeutet eine k-elementige Teilmenge von

(n )

Schachteln auszuwählen. Dies geht auf k Weisen. Wie ist es mit Mehrfachbesetzungen

bei ununterscheidbaren Kugeln?

Beispiel: n = 5, k = 5.

1

2

3

4

5

Abbildung 3.1: Schachtelmodell

Sehe die äußeren Wände als fest, die inneren Wände als verschiebbar an. Dies liefert die

Darstellung:

Abbildung 3.2: Schachtelmodell

Umgekehrt liefert eine solche Darstellung eine Urnenbelegung. Wieviele Möglichkeiten

gibt es? Was

(9) ist die Anzahl der Möglichkeiten 4 Wände zwischen und neben 5 Kugeln zu

stecken? 4 !!

21

Zwischen dem Urnenmodell und dem Schachtelmodell besteht ein enger Zusammenhang.

Die Fragestellungen: „Wie viele Möglichkeiten gibt es k Kugeln aus einer Urne mit n

Kugeln zu ziehen?“ und „Wie viele Möglichkeiten gibt es k Kugeln auf n Schachteln zu

verteilen?“ sind äquivalent. Dabei ist das Zurücklegen in die Urne äquivalent zur Mehrfachbesetzung der Schachteln und das Beachten der Reihenfolge ist äquivalent zur Angabe

der Schachtelnummern, in die die nummerierten Kugeln fallen. “Ohne Reihenfolge” bedeutet, dass die Kugeln nicht nummeriert sind. Dann wird lediglich die Anzahl der Kugeln

pro Schachteln angegeben.

So gibt es zum Beispiel genau so viele Möglichkeiten 3 Kugeln aus einer Urne mit 8 Kugeln

ohne Zurücklegen und mit Beachtung der Reihenfolge zu ziehen wie es Möglichkeiten gibt

3 nummerierte Kugeln auf 8 Schachteln zu verteilen.

Die folgende Tabelle gibt die Größen der verschiedenen Grundräume im Urnen und

Schachtelmodell an.

Urnenmodell

mit Zurücklegen

ohne Zurücklegen

mit Reihenfolge

nk

n!

(n−k)!

(n)

k

ohne Reihenfolge

(n+k−1)

k

mit Mehrfachbesetzung ohne Mehrfachbesetzung

nummeriert

nicht nummeriert

Schachtelmodell

Tabelle 3.2: Urnenmodell und Schachtelmodell

3.2

Verteilungen, die aus Gleichverteilungen entstehen

Die Binomialverteilung

Wir leiten diese Verteilung für rationale Erfolgswahrscheinlichkeiten mit Hilfe des Urnenmodells her. In einer Urne seinen W weiße und S schwarze Kugeln. Es werden n Kugeln

mit Zurücklegen gezogen. Die Kugeln seien nummeriert, die Kugeln mit den Nummern

1, . . . W seien weiß und die Kugeln mit den Nummern W +1 bis N = W +S seien schwarz.

Da hier Ziehen mit Zurücklegen und mit Reihenfolge vorliegt enthält der Grundraum N n

Elemente. Fragen wir nun nach der Wahrscheinlichkeit eine gewisse Stichprobe zu ziehen

mit genau k weißen Kugeln. Diese Stichprobe können wir darstellen als eine 0-1 Folge

n

∑

der Länge n (c1 , . . . , cn ) mit

ci = k. Dabei bedeutet ci = 1, die i-te gezogene Kugel

i=1

ist weiß. Nun gibt es nach dem Kombinationsprinzip genau W k S n−k Möglichkeiten eine

solche Folge zu ziehen und die Wahrscheinlichkeit für eine Stichprobe mit genau k weißen

(n )

W k S n−k

.

Da

es

aber

mögliche Folgen gibt mit k weißen Kugeln, ist die

Kugeln ist

k

(W + S)n

Wahrscheinlichkeit “k weiße Kugeln zu ziehen”:

22

( )(

)k (

)n−k

n

W

S

P (“k weiße Kugeln”) =

k

W +S

W +S

( ) ( )k (

)n−r

n

W

W

=

1−

k

N

N

( )

n k

=

p (1 − p)n−k

k

mit p =

W

N

und 0 ≤ k ≤ n.

Wegen der Binomialformel summiert sich die rechte Seite über k zu Eins auf und definiert

damit eine Wahrscheinlichkeitsfunktion. Sie gehört zur Binomialverteilung mit Parametern n und p.

Die Hypergeometrische Verteilung

In vielen Anwendungen, etwa bei der Qualitätskontrolle mittels Stichproben, wird ohne

Zurücklegen gezogen. Wir betrachten deshalb nun die folgende Situation. In einer Urne

seien W weiße Kugeln und S schwarze Kugeln. Aus dieser Urne werde n mal jeweils eine

Kugel gezogen und danach nicht zurückgelegt. Offensichtlich muss dann n ≤ W + S = N

gelten. Sei X die Anzahl der weißen Kugeln in der gesamten Stichprobe. Wir bestimmen

nun die P (X = k) auf zwei Weisen.

Für die erste Herleitung denken wir uns die Kugeln von 1 bis N nummeriert und nehmen

an, die Kugeln seien prinzipiell unterscheidbar. Die Kugeln mit den Nummern 1 bis( W)

seien weiß und die Kugeln mit den Nummern W + 1 bis N seien schwarz. Es gibt Nn

verschiedene Möglichkeiten, aus den N Kugeln eine n-elementige Teilmenge auszuwählen.

Um eine Stichprobe mit k weiße Kugeln zu erhalten, muss man k Elemente aus der Menge

{1, . . . , W } auswählen und n − k Elemente aus der Menge {W + 1, . . . , N } auswählen.

Dies ergibt nach dem Kombinationsprinzip

)

( )(

W

S

k

n−k

viele Möglichkeiten. Damit erhalten wir

(W )(

P (X = k) =

S

k

n−k

(W +S )

n

)

für alle k mit 0 ≤ k ≤ W und 0 ≤ n − k ≤ S. (Offensichtlich können wir nicht mehr

als W weiße oder mehr als S schwarze Kugeln ziehen!) Die obige Verteilung von X heißt

Hypergeometrische Verteilung.

Beispiel:

Ein Kunde weiß, dass im Mittel 10% der Lieferungen von Bauteilen einer Firma defekt

sind. Dieser Anteil ist vertraglich akzeptiert. Um sich gegen einen höheren Anteil an defekten Bauteilen abzusichern, entnimmt der Kunde jeder Einheit zu 50 Bauteilen eine

23

Stichprobe vom Umfang 5 (selbstverständlich ohne Zurücklegen!) und testet diese 5 Bauteile. Der Kunde lehnt die Einheit ab, falls sich unter den fünf gezogenen mehr als ein

defektes Bauteil befindet. Mit welcher Wahrscheinlichkeit lehnt er eine Einheit ab, die 8

defekte Bauteile enthält?

Hier ist N = 50, n = 5, W = 8, S = 42. Damit ist

P (X > 1) = 1 − (P (X = 0) + P (X = 1))

(8)(42) (8)(42)

= 1 − 0(50)5 − 1(50)4

5

5

= 1 − 0.4015 − 0.4226

= 0.1759.

Wir wollen nun noch eine weitere Herleitung der Hypergeometrischen Verteilung betrachten. Dabei gehen wir ähnlich wie bei der Binomialverteilung vor. Es zeigt sich nämlich,

dass – trotz der Abhängigkeit zwischen den Ziehungen – die Reihenfolge, in der weiße und

schwarze Kugeln gezogen werden, keine Rolle spielt. Man sieht dies am besten an einem

Beispiel: sei W = 3, S = 5 und n = 3. Die Wahrscheinlichkeit erst zwei weiße und dann

eine schwarze Kugel zu ziehen ist

3 2 5

3×2×5

× × =

.

8 7 6

8×7×6

Die Wahrscheinlichkeit erst eine weiße, dann eine schwarze und dann noch eine weiße

Kugel zu ziehen ist

3 5 2

3×5×2

× × =

.

8 7 6

8×7×6

Die zwei Ausdrücke ergeben denselben Wert. Offensichtlich hat sich nur die Reihenfolge

der Zahlen im Zähler geändert. Eine Möglichkeit k weiße Kugeln zu erhalten besteht darin,

erst k weiße Kugeln in Folge zu ziehen und anschließend n − k schwarze Kugeln in Folge

zu ziehen. Die Wahrscheinlichkeit für dieses Elementarereignis ist

W

W +S

×

W −1

W +S−1

× ··· ×

W −k+1

W +S−k+1

×

S

W +S−k

×

S−1

W +S−k−1

× ··· ×

S−(n−k)+1

.

W +S−n+1

Die k weißen Kugeln und n − k schwarzen Kugeln können natürlich auch in einer anderen

Reihenfolge auftreten; dies ändert jedoch nichts

( )an der Wahrscheinlichkeit des betreffenden Elementarereignisses. Insgesamt gibt es nk viele verschiedene Elementarereignisse

mit k gezogenen weißen Kugeln. Damit erhalten wir

∏n−k+1

( ) ∏k−1

(S − j)

n

j=0

j=0 (W − j)

P (X = k) =

∏n−1

k

j=0 (W + S − j)

( )

n

W!

S!

(W + S − n)!

=

k (W − k)! (S − n + k)! (W + S)!

(W )( S )

=

n−k

(k W +S

) .

n

24

Man rechnet die letzte Gleichung leicht direkt nach.

Ist N = W +S groß im Verhältnis zu n, so sollte der Unterschied zwischen Ziehen mit und

Ziehen ohne Zurücklegen kaum bemerkbar sein. Wir betrachten nun den Grenzübergang

S, W → ∞ mit

W

→ p ∈ (0, 1).

W +S

Dann gilt auch S/(W + S) → q und N → ∞. Gleichzeitig lassen wir k und n fest. Terme

der Form

W −j

W +S−j

streben dann für 0 ≤ j ≤ k − 1 gegen p und Terme der Form

S−j

W +S−k−j

streben für 0 ≤ j ≤ n − k − 1 gegen 1 − p. Damit strebt P (X = k) gegen

( )

n k

p (1 − p)n−k .

k

Die Wahrscheinlichkeiten der Hypergeometrischen Verteilung streben also gegen die Wahrscheinlichkeiten der Binomialverteilung. Die folgende Tabelle veranschaulicht diese Approximation. Dabei ist n = 5.

k

0

1

2

3

4

5

W =20, S=10 W =100, S=50

0.002

0.004

0.029

0.0039

0.160

0.164

0.360

0.335

0.340

0.331

0.109

0.127

W =200, S=100

0.004

0.040

0.164

0.332

0.330

0.129

W =1000, S=500

0.004

0.041

0.165

0.330

0.329

0.131

p = 2/3

0.004

0.041

0.165

0.329

0.329

0.132

Die genaue Formulierung der Grenzwertaussage lautet:

Satz 3.2.1 Sei N = WN + SN und gelte lim WNN = p mit 0 < p < 1. Sei n ∈ IN fest.

N →∞

Dann gilt für N → ∞

(

)(

)

WN

SN

( )

n k

k

n−k

( )

→

p (1 − p)n−k

N

k

k

für 0 ≤ k ≤ n.

Ein typisches Anwendungsbeispiel ist bei Wahlumfragen. Hier ist typischerweise N =

4 · 107 aber n = 1200.

25

Anwendung in der Qualitätskontrolle

Sowohl Binomial- als auch Hypergeomoetrische Verteilung treten in der Qualitätskontrolle

auf. In einer Warenlieferung oder Produktionseinheit sei W die Anzahl der defekten Stücke

und S die Anzahl der intakten Stücke. Wird eine Produktionseinheit verkauft, so einigen

sich Produzent und Abnehmer darauf, dass der Verkauf nur dann stattfindet, wenn die

Lieferung gewisse Qualitätsstandards erfüllt. Der Qualitätsstandard gelte als erfüllt, wenn

der Anteil der defekten Stücke in der Lieferung maximal c sei.

Es wäre ideal, wenn es eine Möglichkeit gäbe, den Anteil der defekten Stücke exakt zu

bestimmen. Das ist jedoch nur möglich, wenn man jedes einzelne Stück prüft. Dafür ist

aber der Aufwand an Zeit und Geld in der Regel zu hoch. Also bleibt nur die Möglichkeit

aufgrund von Stichproben etwas über die Größen W und S herauszufinden.

Wenn A(p) die Abnahmewahrscheinlichkeit einer Lieferung bezeichnet, in der ein Anteil

von p Stücken defekt ist, wäre ein Prüfverfahren ideal, für das gilt:

{

1 falls p ≤ p0

A(p) =

.

0 falls p > p0

Das geht jedoch nur mit einer Volluntersuchung aller Stücke. Man muss sich also für

einen Mittelweg zwischen Umfang der Stichprobe und Genauigkeit des Testverfahrens

entscheiden.

Bei einer Qualitätskontrolle werden n Teile aus einer Einheit gezogen und überprüft. Die

Wahrscheinlichkeit bei dieser Stichprobe vom Umfang n genau k defekte Stücke zu finden

beträgt

)

) /(

( )(

W +S

S

W

.

p(k) =

n

n−k

k

Man legt eine Grenze c fest, bei der die Einheit gerade noch akzeptiert wird, d.h. sind

höchstens c Teile in dieser Stichprobe defekt, wird die Produktionseinheit abgenommen.

Wir definieren zwei Größen:

Das Produzentenrisiko α ist die Wahrscheinlichkeit, dass eine Prokuktionseinheit, in

der maximal ein Anteil von p1 Stücken defekt ist, nicht abgenommen wird.

Das Abnehmerrisiko β ist die Wahrscheinlichkeit, dass eine Produktionseinheit, in der

der Anteil der defekten Stücke größer oder gleich p2 ist, abgenommen wird. Man beachte,

im Idealfall ist p0 = p1 = p2 .

Um den Rechenaufwand zu verringern verwendet man oft die Binomialverteilung als Näherung der hypergeometrischen Verteilung. p ist dabei der Anteil der defekten Teile in der

untersuchten Einheit. Damit ist

c ( )

∑

n i

A(p) := Pp (höchstens c defekte Teile in Stichprobe vom Umfang n) =

p (1−p)n−i

i

i=0

die Wahrscheinlichkeit, dass die Produktionseinheit abgenommen wird.

Trägt man für einen festen Stichprobenumfang die Abnahmewahrscheinlichkeit A(p) gegen den Anteil p der defekten Stücke auf, so ergibt sich folgendes Schaubild, das man

„operation characteristic“ (OC) nennt:

26

Abblidung3.3: OC-Kurve

Wenn p1 , p2 , α und β festgelegt sind, stellt sich die Frage nach n und c. Im Allgemeinen

wird die OC-Funktion steiler, wenn n größer wird. Für n = 100 und c = 5 gilt:

a) A(0, 05) = 0, 9601,

b) A(0, 10) = 0, 005.

3.3

Verteilungen mit mehr als zwei Kategorien, die

aus Gleichverteilungen entstehen

In einer Urne seien N Kugeln. Davon seien Ni vom Typ i (i = 1, . . . , k und k ≥ 2), wobei

der Typ z.B. die „Farbe“ oder den „physikalischen Energiezustand“ bezeichnen soll. Es

k

∑

soll wieder

Ni = N gelten. Es werden n Kugeln gezogen.

i=1

Frage: Was ist die Wahrscheinlichkeit jeweils ni Kugeln vom Typ i zu ziehen (i = 1, .., k)?

Dabei ist

k

∑

ni = n.

i=1

Der Multinomialkoeffizient

(

n

n1 ...nk

)

bezeichnet die Anzahl der Möglichkeiten eine nk

∑

elementige Menge in k Teilmengen vom Umfang ni , i = 1, . . . , k, zu zerlegen, wobei

ni =

i=1

n.

(

)

( )

Für k = 2 gilt: n1nn2 = n1n!

= nn1 .

!n2 !

Für

)(n−n1 )(n−n1 −n2 ) (nk )

( n k )≥ 2 (gilt:

n

=

. . . nk =

n1

n1 ...nk

n2

n3

(n−n1 )!

(n−n1 −n2 )!

n!

n1 !(n−n1 )! n2 !(n−n1 −n2 )! n3 !(n−n1 −n2 −n3 )!

...1 =

Ziehen mit Zurücklegen und mit Reihenfolge

Die Wahrscheinlichkeit jeweils ni Kugeln vom Typ i zu ziehen (mit

P ({(n1 , . . . , nk )}) =

n

(n1 ...n

)N1n1 ...Nknk

k

Nn

=

(

n

n1 ...nk

)

27

k

∑

i=1

pn1 1 . . . pnk k mit pi =

Ni

.

N

ni = n) ist:

n!

.

n1 !n2 !...nk !

Es gilt:

∑

n1 +...+nk =n

(

∑

P ({(n1 , . . . , nk )}) =

n1 +...+nk =n

n

n1 ...nk

)

pn1 1 . . . pnk k = (p1 + . . . + pk )n = 1.

Dabei haben wir die Multinomialformel

( n ) n1

∑

(a1 + a2 + . . . + ak )n =

a1 . . . ank k verwendet.

n1 ...nk

n1 +...+nk =n

Damit wird durch P eine Wahrscheinlichkeitsfunktion erklärt. Sie heißt Multinomialverteilung.

In der Physik wird diese Verteilung auch Maxwell-Bolzmann-Verteilung genannt. Sie gibt

an, wieviele Teilchen sich im Energieniveau „i“ befinden. Dabei wird angenommen, dass

die Teilchen unterscheidbar (nummerierbar) sind; eine typische Annahme der klassischen

Physik! In den folgenden Beispielen sind die Teilchen nicht unterscheidbar, was typisch

für die Quantenmechanik ist.

Ziehen ohne Zurücklegen und ohne Reihenfolge

(N 1 )

P ({(n1 , . . . , nk )}) =

n1

( )

. . . Nnkk

(N )

0 ≤ ni ≤ Ni , i = 1, . . . , k

n

Diese Verteilung ist eine Verallgemeinerung der hypergeometrischen Verteilung. In der

Physik wird sie auch Fermi-Dirac-Verteilung genannt. Im Schachtelbild: ein Teilchen pro

Schachtel gemäß Pauli-Verbot. Typische Teilchen sind Elektronen.

Ziehen mit Zurücklegen und ohne Reihenfolge

(N1 +n1 −1)

P ({(n1 , . . . , nk )}) =

n1

...

(Nk +nk −1)

(N +n−1)

nk

0 ≤ ni ≤ Ni , i = 1, . . . , k

n

In der Physik wird diese Verteilung Bose-Einstein-Verteilung genannt. Im Schachtelbild:

mehrere Teilchen pro Schachtel, kein Pauli-Verbot. Typische Teilchen sind Photonen.

3.4

Die probabilistische Methode in der Kombinatorik

Wir wollen nun an einem Beispiel zeigen, wie wahrscheinlichkeitstheoretische Überlegungen zu nichttrivialen Resultaten der Kombinatorik führen. Wir wählen als Beispiel

Ramsey-Zahlen. Diese sind Objekte der Kombinatorik, die sehr unzugänglich sind. Zunächst führen wir Ramsey-Zahlen ein. Dazu betrachten wir den vollständigen Graphen

KN mit N Ecken. Dieser Graph verbindet alle N Ecken miteinander.

Beispiel:

Wir sagen KN hat die Eigenschaft (m, n), wenn, egal wie wir die Kanten von KN rot oder

blau färben, es immer einen vollständigen Untergraphen Km gibt, dessen Kanten alle rot

sind, oder es einen vollständigen Untergraphen Kn gibt, dessen Kanten alle blau sind. Ist

s ≥ N , so hat Ks auch diese Eigenschaft. Die kleinste Zahl N mit der Eigenschaft (m, n)

heißt Ramsey-Zahl R(m, n).

28

usw.

K2

K4

K3

K5

Abbildung 3.1: vollständige Graphen mit N Ecken

Bemerkung: Es gilt R(m, 2) = m ebenso R(2, m) = m. Denn, entweder sind alle Kanten

von Km rot oder es gibt eine blaue Kante, also ein blaues K2 .

Man kann zeigen: Für m, n ≥ 2 ist

(

)

m+n−2

R(m, n) ≤

,

m−1

und insbesondere R(k, k) ≤ 22k−3 für k ≥ 2. Wir leiten nun eine untere Schranke für

R(k, k) her. Dazu müssen wir zeigen, dass für ein möglichst großes N < R(k, k) es keine

Färbung von KN gibt, für die ein roter oder blauer Kk auftritt.

Satz 3.4.1 (Erdös, P.)

R(k, k) ≥ 2k/2

für k ≥ 2

Beweis: Wir wissen R(2, 2) = 2. Außerdem ist R(3, 3) ≥ 6, wegen der folgenden Fünfeckfärbung: den Rand außen blau und alle Diagonalen rot.

Sei k ≥ 4 und angenommen, dass N < 2k/2 . Wir betrachten alle rot-blau Färbungen von

KN , wobei jede Kante unabhängig

mit Wahrscheinlichkeit 21 rot oder blau gefärbt wird.

( )

Alle Färbungen, es gibt 2

N

2

, sind gleichwahrscheinlich. Sei A eine Eckenmenge der Größe

( )

k. Die Wahrscheinlichkeit des Ereignisses AR , alle Kanten in A sind rot gefärbt, ist 2−

Dann ist die Wahrscheinlichkeit, dass irgendeine k-Menge rot gefärbt ist,

( )

( )

∪

∑

k

N

AR ≤

P (AR ) =

· 2− 2 .

PR = P

k

|A|=k

k

2

.

|A|=k

( )

k

k

N

Mit N < 2 2 und k ≥ 4 und wegen

≤ 2Nk−1 für k ≥ 2 folgt

k

( ) ( )

( )

( )

k2

k

k

Nk − k

1

1

N − k

−

PR ≤

2 2 ≤ k−1 2 2 < 2 2 2 −k+1 = 2− 2 +1 ≤ ⇒ PR < .

k

2

2

2

Ganz entsprechend folgt, dass die Wahrscheinlichkeit PB , dass irgendeine k-Menge blau

gefärbt ist, PB < 12 ist. Es folgt weiter

⇒ PR + PB < 1 für N < 2k/2 .

Das heißt es muss eine Färbung ohne rote oder blaue Kk geben, das heißt KN hat nicht

die Eigenschaft (k, k).

29

Kapitel 4

Bedingte Wahrscheinlichkeiten und

Unabhängigkeit

4.1

Bedingte Wahrscheinlichkeit: Definition und Folgerungen

Einführendes Beispiel:

Eine faire Münze wird dreimal hintereinander geworfen. Dabei entspreche 1 dem Ausgang

Zahl und 0 dem Ausgang Wappen in einem einzelnen Wurf. Also Ω = {0, 1} × {0, 1} ×

{0, 1}. Sei A das Ereignis mindestens zweimal Zahl:

A = {(0, 1, 1), (1, 0, 1), (1, 1, 0), (1, 1, 1)}.

Für die faire Münze sind alle Ergebnisse gleichwahrscheinlich. Damit ist

P (A) =

|A|

4

1

= = .

|Ω|

8

2

Angenommen wir wissen bereits, dass der erste Wurf Zahl ergeben hat. Wie ändert sich

unsere Einschätzung der Wahrscheinlichkeit für das Eintreten von A? Wir wissen also,

dass das Ereignis

B = {(1, 0, 0), (1, 1, 0), (1, 0, 1), (1, 1, 1)}

auf alle Fälle eintritt. Was ist die bedingte Wahrscheinlichkeit von A gegeben dieses Wissen? Die Intuition legt es nahe, alle Elemente aus B als gleichwahrscheinlich anzusehen

und diese Menge als neuen Grundraum heranzuziehen. Damit erhalten wir als bedingte

Wahrscheinlichkeit

|A∩B|

3

P (A ∩ B)

|A ∩ B|

|Ω|

= = |B| =

.

|B|

4

P (B)

|Ω|

Definition 4.1.1 Seien A und B Ereignisse und sei P (B) > 0. Dann ist

P (A|B) =

P (A ∩ B)

P (B)

die bedingte Wahrscheinlichkeit von A gegeben B.

30

Aus der Definition folgt sofort (für P (B) > 0) die Multiplikationsregel

P (A ∩ B) = P (A|B)P (B).

Aus der Definition folgt weiter

(1) P (·|A) ist Wahrscheinlichkeitsmaß auf P(Ω) mit P (B|A) = 1 für B ⊃ A und P (C|A) =

0 für C ⊂ Ac .

(2) Seien A1 , A2 , . . . , Ak ⊂ Ω mit P (A1 ∩ A2 ∩ . . . ∩ Ak ) > 0. Dann gilt:

P (A1 ∩ A2 ∩ . . . ∩ Ak ) = P (A1 )P (A2 |A1 )P (A3 |A1 ∩ A2 ) . . . P (Ak |A1 ∩ . . . ∩ Ak−1 ).

Beweis:

Zu (1):

a) P (Ω|A) =

P (A∩Ω)

P (A)

=

P (A)

P (A)

= 1.

b) Seien Bi ⊂ Ω disjunkt. Dann gilt:

P(

∞

∪

Bi |A) =

i=1

P ([

∞

∪

Bi ]∩A)

i=1

=

P (A)

∞

∪

P(

∞

∑

[Bi ∩A])

i=1

=

P (A)

P (Bi ∩A)

i=1

P (A)

=

∞

∑

P (Bi |A).

i=1

Damit ist P (·|A) ein Wahrscheinlichkeitsmaß auf P(Ω).

Sei B ⊃ A und C ⊂ Ac .

Dann gilt: P (B|A) =

P (A∩B)

P (A)

=

P (A)

P (A)

= 1 und P (C|A) =

P (A∩C)

P (A)

=

P (Ø)

P (A)

= 0.

Zu (2): Beweis mit Induktion. Richtig für k = 2 per Definition. Gelte die Formel für

k − 1, d.h.

P (A1 ∩ . . . ∩ Ak−1 ) = P (A1 )P (A2 |A1 ) . . . P (Ak−1 |A1 ∩ . . . ∩ Ak−2 )

so schreibe

P (A1 ∩ . . . ∩ Ak ) = P (Ak |A1 ∩ . . . Ak−1 ) · P (A1 ∩ . . . Ak−1 )

und setze die Formel für k − 1 ein.

Beispiel: Das Geburtstagsproblem

k Personen befinden sich in einem Raum. Mit welcher Wahrscheinlichkeit haben mindestens zwei von ihnen am selben Tag Geburtstag?

Wir setzen voraus

• das Jahr hat 365 Tage,

• jeder Tag kommt mit gleicher Wahrscheinlichkeit als Geburtstag in Frage,

• es besteht keine Abhängigkeit zwischen den Geburtstagen verschiedener Personen

(also keine Zwillinge!).

31

Der Einfachheit halber denken wir uns die Personen von 1 bis k nummeriert und stellen

uns vor, dass wir sie der Reihe nach befragen. Sei

Ω = {1, . . . , 365}k = {ω|ω = (ω1 , . . . , ωk ); ωi ∈ {1, . . . , 365}}.

Dabei ist ωi der Geburtstag der i-ten Person.

Sei

Dj = {(j + 1)-te Person hat an einem anderen Tag Geburtstag als die Personen

1 bis j}

= {ω ∈ Ω|ωj+1 ̸= ωi für 1 ≤ i ≤ j}.

Dann gilt

365 · 364

364

=

.

365 · 365

365

Sei nun j ≥ 2. Auf dem Ereignis D1 ∩ . . . ∩ Dj−1 haben die Personen 1, . . . , j an j

verschiedenen Tagen Geburtstag. Damit ergibt sich die bedingte Wahrscheinlichkeit des

Ereignisses Dj gegeben D1 ∩ . . . ∩ Dj−1 zu

P (D1 ) = P (ω1 ̸= ω2 ) =

P (Dj |D1 ∩ . . . ∩ Dj−1 ) =

365 − j

j

=1−

.

365

365

(Man beachte, dass dies bedingte Wahrscheinlichkeiten sind. So ist etwa P (D3 |D2c ) =

364/365.) Wir erhalten nun wegen Folgerung (2)

P (D1 ∩ D2 ∩ . . . ∩ Dk−1 )

= P (D1 )P (D2 |D1 )P (D3 |D1 ∩ D2 ) . . . P (Dk−1 |D1 ∩ D2 ∩ . . . ∩ Dk−2 )

)(

) (

)

(

2

k−1

1

1−

... 1 −

= 1−

365

365

365

(

)

k−1

∏

j

=

1−

.

365

j=1

Für größere Werte von k bietet sich folgende Näherung an. Es gilt log(1 − h) ≈ −h und

somit

log(P (D1 ∩ D2 ∩ . . . ∩ Dk−1 )) =

k−1

∑

log(1 − j/365) ≈ −(1/365)

j=1

=−

k−1

∑

j

j=1

k(k − 1)

.

2 · 365

Die Wahrscheinlichkeit, dass mindestens zwei Personen am selben Tag Geburtstag haben,

ist daher näherungsweise

k(k−1)

1 − e− 2·365 .

Die Näherung ist sehr gut. Für k = 23 liefert sie 0.500 im Vergleich zu dem exakten Wert

0.506.

32

Beispiel: Sterbetafeln

Wir betrachten eine Bevölkerungsgruppe, z.B. die Einwohner einer Stadt oder eines Landes und wollen die Lebensdauern ihrer Einwohner erfassen. Dazu ordnen wir jedem Individuum sein ganzzahliges Sterbealter zu. Wir nennen diese Größe T . T ist eine ganzzahlige

Größe, die vom Zufall abhängt. Sei p(k) die Wahrscheinlichkeit im Alter k zu sterben.

Diese ist dann p(k) = P (T = k). Im Versicherungswesen, insbesondere bei Lebensversicherungen interessiert die Sterberate. Diese wird wie folgt erklärt.

Sei S(l) := P (T ≥ l) die Wahrscheinlichkeit mindestens l Jahre alt zu werden (Überlebenswahrscheinlichkeit) und sei h(l) = P (T = l|T ≥ l) die Wahrscheinlichkeit im Alter von l

Jahren zu sterben, wenn man bereits dieses Lebensjahr erreicht hat (Sterberate). Es gilt:

h(l) = P (T = l|T ≥ l) =

P (T = l, T ≥ l)

P (T = l)

p(l)

S(l) − S(l + 1)

=

=

=

.

P (T ≥ l)

P (T ≥ l)

S(l)

S(l)

Darstellung von S(l) durch h(l):

Es gilt: S(l) =

l−1

∏

(1 − h(i)). Das ergibt sich aus der Anwendung der Folgerung (2):

i=1

S(l) = P (T ≥ l) =

l−1

∏

P (T ≥ i + 1|T ≥ i) =

i=1

l−1

∏

i=1

S(i+1)

S(i)

=

l−1

∏

(1 − h(i)).

i=1

Beispiel:

Wir nehmen folgendes an: Die Wahrscheinlichkeit im Alter i zu sterben, gegeben man hat

das Alter i bereits erreicht, sei für alle i gleich p. In Formeln: h(i) = p für alle i.

Dann ist S(l) = (1 − p)l−1 und

p(k) = P (T = k) =

P (T =k)

P (T ≥k)

· P (T ≥ k) = h(k)S(k) = p(1 − p)k−1

für k ∈ N.

Dies ist die Wahrscheinlichkeitsfunktion der geometrischen Verteilung.

Beispiel: Sterbetafel von Breslau nach Halley (1693)

Sterberaten berechnet nach der Halleyschen Tafel:

S(1)

S(2)

S(3)

S(4)

=

=

=

=

..

.

P (T

P (T

P (T

P (T

≥ 1) = 1

≥ 2) = 855/1000

≥ 3) = 798/1000

≥ 4) = 760/1000

S(82) = 28/1000

S(83) = 23/1000

S(84) = 19/1000

S(85) = 0

p(1)

p(2)

p(3)

p(4)

= 145/1000

= 57/1000

= 38/1000

= 28/1000

..

.

p(82) = 5/1000

p(83) = 4/1000

p(84) = 19/1000

p(85) = 0

33

h(1)

h(2)

h(3)

h(4)

= 145/1000

= 57/855

= 38/798

= 28/760

..

.

h(82)

h(83)

h(84)

h(85)

= 5/28

= 4/23

= 1

= 0

Abblidung 4.1: Die Sterberate h für die Sterbetafel von Halley

4.2

Satz von der vollständigen Wahrscheinlichkeit und

Bayesschen Formel

Beispiel:

Von einem gut gemischten Skat-Blatt (bestehend aus 32 Karten) werden vom Stapel

nacheinander zwei Karten gezogen. Was ist die Wahrscheinlichkeit, dass die zweite Karte

“Kreuz oder Pik”, d.h. “schwarz” ist? Vermutung: Sie ist gleich 12 .

P (2. Karte “schwarz”)

= P (2. Karte “schwarz” | 1. Karte “schwarz”) · P (1. Karte “schwarz”)

+ P (2. Karte “schwarz” | 1. Karte “rot”) · P (1. Karte “rot”)

1 15 1 16

1 15 + 16

1

= ·

+ ·

= ·

= .

2 31 2 31

2

31

2

Satz 4.2.1 (Satz von der vollständigen Wahrscheinlichkeit) Es seien A1 , A2 , ...

∞

∪

paarweise disjunkte Mengen mit

Ai = Ω. Weiter sei B ⊂ Ω. Dann gilt:

P (B) =

∞

∑

i=1

P (B|Ai )P (Ai ). Dabei setzt man P (B|Ak )P (Ak ) = 0, falls P (Ak ) = 0.

i=1

Beweis:

∞

∪

A1 ∩ B, A2 ∩ B, ... sind paarweise disjunkt und (Ai ∩ B) = B.

Damit gilt: P (B) = P (

∞

∪

(Ai ∩ B)) =

i=1

∞

∑

i=1

P (Ai ∩ B) =

i=1

∞

∑

i=1

34

P (B|Ai )P (Ai ).

2

Eine direkte Folgerung aus dem Satz von der vollständigen Wahrscheinlichkeit ist die

Bayessche Formel. Sie ist von grundlegender Bedeutung und beschreibt, wie neues Wissen

zu verwerten ist. Sie wird deswegen auch oft als Lernformel bezeichnet.

Satz 4.2.2 (Bayesche Formel) {A1 , . . . An } sei eine disjunkte Zerlegung von Ω. Sei B

ein weiteres Ereignis. Dann gilt:

P (B|Ai )P (Ai )

P (Ai |B) = ∑

.

n

P (B|Aj )P (Aj )

j=1

Beweis:

P (Ai | B) =

P (B | Ai )P (Ai )

P (B | Ai )P (Ai )

= ∑

m

P (B)

P (B | Aj )P (Aj )

j=1

Dabei wurde in der letzten Gleichung der Satz von der vollständigen Wahrscheinlichkeit

verwendet.

2

Beispiel: Farbenblindheit

Farbenblindheit ist eine typische Männerkrankheit. M stehe für männlich, W für weiblich

und f b für farbenblind. Die Zahlenverhältnisse seien wie folgt:

1

1

1

P (M ) = P (W ) = , P (f b|M ) = , P (f b|W ) =

.

2

12

288

Wie groß ist die Wahrscheinlichkeit, dass eine Person männlich ist, wenn sie farbenblind

ist?

1

·1

P (f b|M )P (M )

24

P (M |f b) =

= 1 112 21 1 = .

P (f b|M )P (M ) + P (f b|W )P (W )

25

· + 288 · 2

12 2

Beispiel: Zuverlässigkeit von Prüfverfahren

Ein bestimmter Chip wird in Massenproduktion hergestellt. Dabei wird jeder Chip vor

Auslieferung getestet. Die Produktion hat eine Ausschussrate von 0.01; dass heißt ein

einzelner Chip ist mit Wahrscheinlichkeit 0.01 defekt. Das Prüfverfahren besitzt folgende

Eigenschaften:

• bei einem fehlerfreien Chip zeigt das Prüfverfahren mit Wahrscheinlichkeit 0.1 fälschlich einen Fehler an.

• bei einem fehlerbehafteten Chip zeigt das Prüfverfahren mit Wahrscheinlichkeit 0.05

fälschlich keinen Fehler an.

35

Chips bei denen das Prüfverfahren einen Fehler anzeigt werden aussortiert und die verbleibenden Chips werden ausgeliefert. Mit welcher Wahrscheinlichkeit ist ein ausgelieferte

Chip auch wirklich fehlerfrei? Sei

A = {Chip ist fehlerfrei} und B = {Prüfverfahren zeigt Fehler an}.

Wir wissen P (A) = 0.99, P (B|A) = 0.1 und P (B|Ac ) = 0.95. Mit A1 = A und A2 = Ac

liefert die Formel von Bayes

P (B c |A)P (A)

P (B c |A)P (A) + P (B c |Ac )P (Ac )

0.9 × 0.99

=

0.9 × 0.99 + 0.05 × 0.01

= 0.999.

P (A|B c ) =

Die Wahrscheinlichkeit, dass ein aussortierter Chip auch wirklich defekt ist ergibt sich

mit analoger Rechnung als

P (Ac |B) =

0.95 × 0.01

= 0.0876.

0.95 × 0.01 + 0.1 × 0.99

Beispiel: Welche Urne (Box)?

3 Urnen mit weißen und schwarzen Kugeln seien gegeben:

Box 1

Box 2

Box 3

Abbildung 4.2: Urnen 1-3

Es wird eine Urne zufällig ausgewählt und dann eine Kugel daraus gezogen; die Kugel

wird gezeigt, nicht aber die Urne. Man rate, aus welcher Urne gezogen wurde.

Pick Box

Pick Ball

1/2

1/3

1/2

2/3

1/3

1/3

3/4

1/3

1/4

Abbildung 4.3: Wahrscheinlichkeiten

Bayes-Formel: P (Urne i | weiß) = ?

P (Urne i und weiß) = P (weiß | Urne i)P (Urne i) =

36

1

i

·

3 i+1

P (weiß) =

1 1 1 2 1 3

23

· + · + · =

3 2 3 3 3 4

36

Dann folgt

P (Urne 3 | weiß) =

1

3

·

23

36

3

4

=

3

12

23

36

=

9

23

Weiter sind:

8

23

6

P (Urne 1 | weiß) =

.

23

P (Urne 2 | weiß) =

Beispiel: Diagnostischer Test

Wir betrachten einen Test auf Vorhandensein einer Krankheit, z.B. den PSA-Test auf ein

Prostata-Karzinom. Der Test hat die Ausgänge “positiv” und “negativ”. Aus “positiv”

schließt man auf das Vorhandensein der Krankheit, aus “negativ” auf das Nichtvorhandensein. Doch der Test kann ein falsches Ergebnis liefern. Man unterscheidet zwischen

zwei Fehlern:

Fehler 1. Art: falsch positiv (Es liegt keine Krankheit vor; falscher Alarm)

Fehler 2. Art: falsch negativ (Die Krankheit wurde nicht entdeckt; kein Alarm trotz

Gefahr)

Wir betrachen das folgende Diagnose-Beispiel: Die Krankheitsrate sei 1% und der Testfehler 10%. Die Anwendung der Bayesschen Formel ergibt dann das Folgende

P (k|+) =

P (+|k)P (k)

=

P (+|k)P (k) + P (+|g)P (g)

9

10

·

9

10

1

100

1

· 100

1

+ 10

·

99

100

=

1

.

12

Dabei steht k für krank, + steht für “der Test war positiv” und − steht für “der Test war

negativ”.

Ein Weg ohne die Bayessche Formel und ohne Wahrscheinlichkeitsrechung das Resultat

zu erhalten, geht so: Man stellt sich die Größen in einer Vierfelder-Tafel bezogen auf 1000

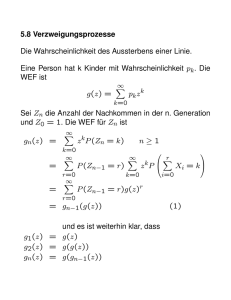

Probanden dar und liest das Ergebnis daraus ab.