Evolution als Optimierungsprozess

Werbung

Evolution als

Optimierungsprozess

Proseminar

Evolutionsstrategien

Sommersemester 2002

Mirko Wölflick

Quelle: Schöneburg, E.; Heinzmann, F.; Feddersen, S.: Genetische

Algorithmen und Evolutionsstrategien. Bonn, Paris: Addison-Wesley

1994. (Kapitel 2, S. 96-140)

Gliederung

1.

Evolution als Optimierungsprozess

1.1

1.2

1.3

Prinzipien der Evolution

Die Evolution - eine kombinierte Suchstrategie

Finden des globalen Optimums

2.

Konventionelle Optimierungsverfahren

2.1

2.1.1

2.1.2

2.1.3

2.2

2.2.1

Deterministische Verfahren

Gauß-Seidel-Verfahren

Gradientenverfahren

Simplexverfahren

Nicht-deterministische Verfahren

Monte-Carlo-Verfahren

3.

Aspekte der modernen Evolutionstheorien

3.1

3.2

3.2.1

3.2.2

3.2.3

3.2.4

3.2.5

3.3

3.3.1

3.4

Evolution als Rückkopplungsprozess

Chaos, Fraktale und Selbstorganisation

Chaostheorie

Prinzip der Fraktale

Simuliertes Chaos

Anwendung auf Differenzierungsprozesse von biologischen Zellen

Selbstorganisation in NK-Zufallsnetzwerken

Gradualismus versus Saltationismus

Paradoxon bei Räumen hoher Dimension

Kommunikation, Kultur und Kooperation

4.

Zusammenfassung, Ausblick

1.

Evolution als Optimierungsprozess

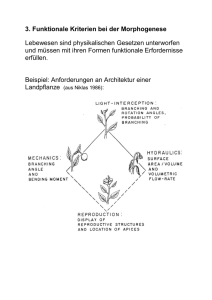

Die Evolution ist ein Optimierungsverfahren, welches durch Manipulation der Erbinformation

eine Anpassung von Organismen an die Bedingungen der sie umgebenden Umwelt erreicht.

Dabei ist die Evolution mit einem Suchprozess vergleichbar, der den gigantischen Raum der

genetischen Informationen, nach der besten Genkombination durchsucht, die ein Individuum

dazu befähigt im Kampf ums Dasein zu bestehen.

1.1

Prinzipien der Evolution

Die Evolution wendet bei ihrer Suche drei Grundprinzipien an. Diese sind die Mutation, die

Rekombination und die Selektion. Alle Prinzipien unterscheiden sich hinsichtlich ihrer Funktion und Wichtigkeit für den Evolutionsprozess.

Die Mutation ist ein ungerichteter Suchprozess. Sie erzeugt Varianten und Alternativen. Dies

ist besonders wichtig, um lokale Optima zu überwinden. Die Wahrscheinlichkeit einer Mutation ist jedoch sehr gering.

Sehr viel häufiger finden Rekombinationen statt. Rekombination (engl. crossing over) genannt, bezeichnet den Austausch von langen Nucleotidketten zwischen den homologen

Chromosomen der Eltern. Der Sinn dieses Verfahrens besteht darin, bereits bewährte Genkombinationen neu zu mischen, um eine Verbesserung in Richtung des Optimums zu erreichen.

Das wohl wichtigste Prinzip der Evolution ist die Selektion. Sie bestimmt im Wesentlichen

die Richtung, in der sich die Evolution bewegt. Die Selektion wäre ein deterministischer Vorgang. Jedoch machen Störungen, z.B. zufällige Unglücke einzelner Individuen, oder Umweltkatastrophen, die den Lebensraum ganzer Populationen verändern, sowie Rückkopplungseffekte zwischen Lebewesen und Umwelt, aus der Selektion einen nicht-deterministischen

Vorgang.

1.2

Die Evolution – eine kombinierte Suchstrategie

Kombinierte Suchstrategie heißt, dass es sich um eine gleichzeitige Tiefen- und Breitensuche

handelt (auch serielle und parallele Suche genannt). Das Ziel dieser Kombination ist die

Minimierung der Evolutionszeit. In der Evolution bedeutet Tiefensuche, die Suche über Generationen hinweg. Dagegen bedeutet Breitensuche, die Suche über eine Anzahl gleichzeitig

lebender Individuen. Um eine möglichst schnelle Anpassung an sich verändernde Umweltbedingungen zu erreichen, müssen somit die Generationsfolgen (Reproduktionszeit) kurz und

die Individuenanzahl (Reproduktionsquote) hoch gehalten werden. In der Realität ist jedoch

das Verhältnis von Reproduktionszeit zu Reproduktionsquote von Art zu Art unterschiedlich.

Besondere Wichtigkeit fällt der parallelen Suche zu. Sie erhöht auf der einen Seite die Wahrscheinlichkeit optimale Punkte des Suchraumes zu erreichen und sie verringert auf der anderen Seite die Wahrscheinlichkeit suboptimale Pfade zu verfolgen.

1.3

Finden des globalen Optimums

Das wichtigste Ziel der Evolutionsstrategen ist ein schnelles und systematisches Finden der

optimalen Parameterwerte für die Komponenten eines Vektors, der einen Punkt im Suchraum

markiert. Um Aussagen über die Qualität einer Kombination aus Parametern treffen zu können, benötigt man eine Zielfunktion, die jedem Parametervektor einen Qualitätswert zuweist.

Diese nennt man Qualitätsfunktion. Sie besitzt lokale und globale Maxima und Minima.

Dabei ist es von der jeweiligen Problemstellung abhängig, ob man das Maximum oder das

Minimum sucht.

Nun könnte man, um das globale Optimum zu finden, alle möglichen Vektoren bewerten und

miteinander vergleichen. Dies würde jedoch sehr viel Zeit in Anspruch nehmen. Unter Umständen würde man länger rechnen müssen als das Universum existiert. Also benötigt man ein

Verfahren, um diese Zeit zu verkürzen.

2.

Konventionelle Optimierungsverfahren

Die bekannten klassischen Optimierungsverfahren teilen sich auf in deterministische und

nicht-deterministische Verfahren. Typische deterministische Verfahren sind: das GaußSeidel-Verfahren, das Gradientenverfahren und das Simplexverfahren. Diese Verfahren werden auch als Hill-Climbing bezeichnet.

Alle weiteren Betrachtungen beziehen sich auf folgende Vereinbarung:

Gesucht ist der Parametervektor (p1, p2, …, pn) für den die Qualitätsfunktion

Q(p1, p2, …, pn) ihr Maximum annimmt.

2.1

Deterministische Verfahren

2.1.1

Gauß-Seidel-Verfahren

Bei dieser Methode wird zunächst der erste Parameter p1 in einer Richtung verändert. Wenn

die Qualitätsfunktion Q größer wird, dann wird weiter in derselben Richtung verändert bis Q

wieder kleiner wird. Dann verändert man p2 in eine Richtung. Wenn Q kleiner wird, dann

verändert man in entgegengesetzter Richtung bis Q wieder kippt. Dies führt man für alle Parameter durch. Bei pn angekommen wiederholt man die gesamte Prozedur bis Q einen zufriedenstellenden Wert erreicht hat oder auf diese Weise keine Verbesserung mehr möglich ist.

2.1.2

Gradientenverfahren

Bei dieser Methode verändert man die Parameter je nach dem, welchen Anstieg die Qualitätsfunktion in einem Punkt hat. Dazu muss man zunächst die Ableitung der Qualitätsfunktion

bestimmen. Dann verändert man die Parameter in Richtung des steilsten Gradienten und proportional zum Anstieg. Das heißt, dass bei großem Anstieg die Parameter stark, und bei kleinem Anstieg die Parameter wenig verändert werden. Ein Nachteil dieses Verfahrens ist, dass

es bei lokalen Optima hängen bleibt.

2.1.3

Simplexverfahren

Beim Simplexverfahren handelt es sich um ein komplett anderes Prinzip. Es beginnt mit mehreren Startpunkten. Und zwar mit n+1 Startpunkten im n-dimensionalen Raum. Dabei haben

alle Punkte den gleichen Abstand zueinander. Bildlich gesprochen bedeutet dies im 2dimensionalen Raum ein gleichseitiges Dreieck, im 3-dimensionalen Raum ein Tetraeder und

im n-dimensionalen Raum ein reguläres Polyeder – ein Simplex.

Man verfährt bei dieser Strategie wie folgt: Zuerst bewertet man alle Eckpunkte. Dann

streicht man den Schlechtesten und ersetzt ihn durch seine Spiegelung am Mittelpunkt des

verbleibenden n-Ecks. Sollte der neue Punkt auch wieder der Schlechteste sein, so würde der

Simplex sich oszillierend zwischen den beiden Zuständen bewegen. Deshalb streicht man in

diesem Fall nicht den Schlechtesten Eckpunkt, sondern den Zweitschlechtesten. Nach einigen

Iterationen rotiert der Polyeder dann um den Punkt der höchsten Qualität. An diesem Zustand

angekommen, lässt sich eine Qualitätsverbesserung nur noch durch eine Verkürzung der Kantenlänge erreichen.

Es existieren noch weitere deterministische Verfahren, wie z. B. die Newton-Strategien und

die Complex-Strategie von Box. Die Nachteile dieser Verfahren sind: Zum einen, die Möglichkeit der Unauffindbarkeit des Optimum, welche aus der Systematik der Suchvorschrift

resultiert, und zum anderen die Unklarheit über die zu verwendende Suchmethode, wenn die

Struktur des Suchraums unbekannt ist.

2.2

Nicht-deterministische Verfahren

Bei diesen Verfahren verzichtet man völlig auf eine komplizierte Vorschrift und macht stattdessen systematisch vom Zufall Gebrauch. Der Vorteil der sich hieraus ergibt, liegt in der

geringeren Gefahr das Optimum „zu verpassen“.

2.2.1

Monte-Carlo-Verfahren

Anhand dieser Methode kann man zeigen, dass es möglich ist, durch den systematischen

Gebrauch des Zufalls, zu recht brauchbaren Ergebnissen zu gelangen. Man kann dieses Verfahren verwenden, um zum Beispiel den Flächeninhalt einer kompliziert zu berechnenden

Fläche zu ermitteln.

Man beginnt, indem man um die zu berechnende Fläche ein Rechteck zeichnet. Als nächstes

erzeugt man innerhalb des Rechtecks zufällige Punkte – die jedoch alle die selbe Wahrscheinlichkeit besitzen müssen. Einige Punkte werden dann innerhalb der zu berechnenden Fläche

liegen – andere nicht. Der Flächeninhalt, der komplizierten Fläche errechnet sich dann aus der

Anzahl der Punkte innerhalb der Fläche mal der Anzahl der Punkte, die nur im Rechteck liegen, geteilt durch die gesamte Anzahl der erzeugten Punkte. Das Ergebnis wird dann um so

genauer, je mehr Punkte man erzeugt.

Da die nicht-deterministischen Verfahren rein zufallsbasiert sind, kann die Suche nach dem

Optimum, jedoch sehr lang dauern.

Nebenbei sei gesagt, dass die Evolution nicht nach diesem simplen Prinzip vorgeht. Sie sucht

sehr viel zielgerichteter.

3.

Aspekte moderner Evolutionstheorien

Seit Darwin hat sich unser Weltbild hinsichtlich der Evolution stark verändert. Dazu haben

neue Erkenntnisse und Sichtweisen beigetragen.

3.1

Evolution als Rückkopplungsprozess

Ein Aspekt, den Darwin noch nicht erkannt hatte, ist, dass die Evolution ein von Rückkopplungen beeinflusster Prozess ist. Das heißt, dass die Lebewesen sich nicht nur an ihre Umwelt

anpassen, sondern sie auch verändern. Und das schon allein durch ihre bloße Existenz. Der

Rückkopplungseffekt besteht dann darin, dass sich die Lebewesen erneut an die veränderte

Umwelt anpassen müssen. Der Einfluss der Lebewesen ist von Art zu Art unterschiedlich.

Außerdem unterscheidet man direkten und indirekten Einfluss.

Das Rückkopplungsprinzip ist ein wichtiges Element der folgenden Theorien.

3.2

Chaos, Fraktale und Selbstorganisation

3.2.1

Chaostheorie

Die Chaostheorie untersucht das Verhalten komplexer rückgekoppelter Systeme. Zum Beispiel das Zusammenspiel der Zellen eines Individuums oder die Entwicklung von Organen.

Die Chaostheorie ist eine relativ junge Theorie – sie existiert erst seit einigen Jahrzehnten.

Unter Chaos versteht man den unvorhersagbaren spontanen Wechsel zwischen Ordnung und

Unordnung. Man unterscheidet nicht-deterministisches Chaos und deterministisches Chaos.

Das Merkmal des nicht-deterministischen Chaos ist, dass sein unvorhersehbarer Zustandswechsel allein von Zufallsfaktoren abhängt. Im Gegensatz dazu entsteht die Unvorhersehbarkeit beim deterministischen Chaos nicht durch den Gebrauch des Zufalls sondern allein durch

die Eigendynamik, die solche Systeme entwickeln.

Man spricht von einem chaotischen System, wenn eine geringfügige Änderung der Randbedingung ein gravierend anderes Verhalten zur Folge hat.

Die Unvorhersehbarkeit natürlicher Systeme resultiert zum einen aus der Fülle an beeinflussenden Faktoren, zum anderen aus der strukturbestimmten Nichtmessbarkeit bestimmter Elementarzustände (vgl. Heisenberg’sche Unschärferelation):

Faktoren, die unter der Messbarkeitsschwelle liegen. Und nicht zuletzt machen auch noch

generelle Messungenauigkeiten eine genaue Vorhersage unmöglich.

Das interessante an chaotischen Systemen ist, das sie in sich die Möglichkeit des Anti-Chaos

bergen. Da wo vorher Unordnung war, kann plötzliche Ordnung entstehen. Dies kann verwendet werden um ein Modell zur Entstehung des Lebens zu entwickeln.

3.2.2

Prinzip der Fraktale

Es ist Benoit Mandelbrot zu verdanken, dass man heute die Unvollkommenheit der Natur

(platonisches Weltbild) nicht mehr als einen Makel betrachtet, sondern als ein Grundprinzip

der belebten und unbelebten Materie, mit dem Zweck, eine große Formenvielfalt hervorzubringen. Dies hat er in seinem Buch „Die Fraktale Geometrie der Natur“ nachgewiesen.

Die wichtigste Eigenschaft der Fraktale ist ihre Selbstähnlichkeit (man spricht hier von Skaleninvarianz), das heißt wenn man in eine fraktale Struktur (einen fraktalen Graphen) hineinoder herauszoomt, so sieht man immer wieder dieselben, sich wiederholenden Muster. Weitere Eigenschaften sind der Wechsel zwischen Regularität und Irregularität sowie ihre spezielle,

gebrochene (nicht ganzzahlige!) Dimension.

In der Evolution findet man Fraktale bei der Vererbung von bestimmten phänotypischen

Merkmalen wieder. Der Fingerabdruck oder das Muster des Leopardenfells sind Beispiele für

solche Merkmale. Bei der Vererbung dieser Merkmale werden anstelle komplexer Baupläne

fraktale Erzeugungsfunktionen weitergegeben. Dies ist vorteilhaft, weil dadurch die Erbinformation sehr viel kompakter dargestellt werden kann und weil schon kleine Mutationen

große phänotypische Veränderungen hervorbringen können.

3.2.3

Simuliertes Chaos

Stuart Kauffman untersuchte das Problem, wie durch das Zusammenspiel der Gene der Phänotyp eines Lebewesens entsteht. Er entwickelte dazu ein Modell zur Simulation der Genaktivität.

Bei dem Modell handelt es sich um Boole’sche NK-Zufallsnetzwerke, in denen Gene durch

logische Funktionen (UND, ODER, XOR, ...) dargestellt werden. Diese werden miteinander

verschaltet und zwar so, dass der Ausgang eines Gens mit dem Eingang eines anderen Gens

verbunden ist. Der Ausgang eines Gens stellt dessen Zustand (aktiv oder nicht) dar. Die Anzahl der Elemente in einem solchen Netzwerk wird mit N angegeben und die Anzahl der Eingänge pro Element wird mit K angegeben. Daher die Bezeichnung NK-Zufallsnetzwerke.

Bei der Simulation wird dann wie folgt vorgegangen: Zuerst initialisiert man ein solches

Netzwerk, das heißt: aus allen möglichen Kombinationen, die Elemente miteinander zu verschalten, greift man sich eine heraus und weist jedem Element einen Zustand (aktiv oder inaktiv) zu. Dann startet man das Netzwerk und schaut sich an, wie sich das Netzwerk verhält.

Das Netzwerk durchläuft nacheinander viele Zustände. Der Zustand des gesamten Netzwerkes

lässt sich als Aktivitätsvektor der einzelnen Elemente darstellen. Bei einem Beispielnetzwerk

aus 200 Elementen ergibt dies eine Anzahl von 2200 ≈ 1060 möglichen Zuständen. Das Interessante hierbei ist, dass nicht alle möglichen Zustände durchlaufen werden. Es werden Zustandsketten durchlaufen, deren Anfangs- und Endvektoren gleich sind. Diese Ketten nennt

man dann Zyklus. Befindet sich einmal ein Netzwerk in einem solchen Zyklus, so kann es ihn

nicht mehr verlassen. Dies resultiert aus dem deterministischen Charakter dieser Systeme.

Wenn man dann jedoch das Netzwerk mit nur leicht verändertem Startvektor startet, zeigt sich

das chaotische Verhalten, denn es werden dann komplett andere Zustandsketten durchlaufen.

Das Interessante hierbei jedoch ist, dass oftmals viele dieser verschiedenen Zustandsketten in

ein und demselben Zyklus enden. Man nennt einen solchen Zyklus, in den viele Zustandsketten hineinmünden, einen Attraktor. Auf Grund der hohen Anzahl der möglichen Aktivitätsvektoren könnte man meinen, dass die Länge von Zyklen sehr groß sein sollte. Sie ist jedoch

tatsächlich nur ca. N/e. Das heißt bei N = 200 sind das ca. 74 Zyklen. Die Gesamtheit der Aktivitätsvektoren, die in einen Attraktor münden, nennt man den Einzugsbereich des Attraktors.

Beispiele für Attraktoren sind allgemein Krater in einer „hügeligen Landschaft“ oder spezielle

Fraktale (z.B. der Henon-Attraktor).

3.2.4

Anwendung auf Differenzierungsprozesse von biologischen Zellen

In der Natur ist die Rückkopplung der Gene nicht so stark, wie bei Netzwerken mit K=N-1.

Deshalb beschränkt man sich bei folgender Betrachtung auf Netzwerke mit K=2. Die Zykluslänge, sowie die Anzahl der Zyklen lassen sich bei beliebigem N leicht abschätzen. Sie sind

gleich groß und betragen ≈ N .

Durch Gen-Regulation wird die Differenzierung der Zellen eines Organismus gesteuert. Man

kann nun die verschiedenen Zelltypen mit Attraktoren für die Gen-Regulation vergleichen.

Nimmt man als Beispiel das Genom des Menschen, dass aus ca. 100.000 Genen besteht, so

ergibt sich eine ungefähre Zykluslänge von 370. Daraus lässt sich dann die durchschnittliche

Länge eines Zellzyklus berechnen. Es ist bekannt, dass ein Gen ca. eine bis zehn Minuten

benötigt um aktiv zu werden. Die Länge eines Zellzyklus sollte dann zwischen 370 · 1 min

und 370 · 10 min, also zwischen 6 und 60 Stunden liegen. Dies deckt sich mit der Realität!

Ebenso deckt sich die Anzahl der möglichen Zyklen (370) mit der Anzahl der möglichen Zelltypen (tatsächlich ca. 260). Bei Berücksichtigung aller möglichen Genomzustände (2100.000) ist

die Abweichung sicherlich vertretbar.

3.2.5

Selbstorganisation in NK-Zufallsnetzwerken

Interessante Ergebnisse wurden bei der Simulation von NK-Zufallsnetzwerken erzielt. Das

Forscherteam um Kauffman fand heraus, dass sich bestimmte Netzwerke chaotischer verhalten als andere. Chaotischeres Verhalten bedeutet, dass diese Netzwerke eher zu Unordnung

neigen. Unordnung heißt, es werden lange Zyklusketten durchlaufen. Und ein Netzwerk, dass

zu Ordnung neigt durchläuft dementsprechend kurze Zyklusketten.

Der Versuch, den die Forscher machten, gestaltete sich wie folgt. Alle Elemente eines Netzwerkes werden während der Simulation eingefärbt. Elemente, die selten ihren Zustand wechseln, bekommen eine rote Farbe und Elemente, die häufig ihren Zustand wechseln, bekommen

eine blaue Farbe. Als Konsequenz verhalten sich überwiegend blaue Netzwerke chaotischer

als rote. Die Ordnung der Netzwerke nimmt zu, je größer das Verhältnis aus roten zu blauen

Elementen ist. Außerdem nimmt die Ordnung zu, je kleiner man die Rückkopplung wählt (K

≤ 2). Die Ordnung wird ebenfalls erhöht, wenn man Elemente verwendet, die nur selten ihren

Zustand wechseln (ODER-Funktion).

Die Bedeutung dieser Ergebnisse für die Evolutionstheorie ist, dass diese NK-Zufallsnetzwerke, das Genom höherer Lebewesen recht gut beschreiben. Deshalb lassen sich aus dem

Verhalten dieser Netzwerke Vorhersagen über die spontane Bildung von Ordnung in GenRegulationssystemen treffen. Außerdem kann man abschätzen, welche Auswirkungen Mutationen auf die Gen-Regulation haben.

Dies konnte wiederum durch Experimente belegt werden. Bei der induzierten Mutation eines

Gens (von 5000) bei der Taufliege Drosophila, folgte eine Kaskade von 150 Veränderungen

der Genaktivitäten. Die Simulation mittels NK-Zufallsnetzwerken (N = 5000, K = 2 und

ODER-Elemente) sagte einen Wert von 160 voraus.

3.3

Gradualismus versus Saltationismus

Der Gradualismus ist eine Theorie, die davon ausgeht, dass die Evolution der Arten durch

geringfügige, kontinuierliche Veränderung vonstatten geht. Diese Ansicht wurde besonders

von Darwin und Leibniz entwickelt und vertreten.

Die Befürworter des Saltationismus hingegen, vertreten die Ansicht, dass die Evolution der

Arten durch größere, qualitative Sprünge fortschreitet. Ein wichtiges Argument für den Saltationismus ist die Tatsache, dass selten Fossilien gefunden werden, die Bindeglieder zwischen

zwei Arten sind.

Ein weiteres Argument gegen den Gradualismus liefert die moderne Genetik. Sie besagt, dass

die Entwicklung neuer Organe eine unvorstellbar große Anzahl an Mutationen benötigt und

dass dies nicht in einer Folge vieler kleiner Veränderungen möglich ist.

Allerdings sprechen auch Argumente gegen Makromutationen. Denn die Wahrscheinlichkeit,

dass sich durch Makromutationen neue Organe bilden, ist sehr gering. Die meisten dieser Mutationen führen nämlich zum Verlust der Überlebensfähigkeit.

Trotz der Argumente für den Saltationismus ist der Gradualismus dank dem Modell von Ingo

Rechenberg und Manfred Eigen theoretisch besser fundiert. Sie haben ein Modell entwickelt,

den „Rechenberg’schen Gradientenpfad“, der eine geeignete Struktur für den Suchraum vorgibt. Diese Struktur ermöglicht nun, durch eine kurze Folge von Mutationen, jede möglich

Genkombination im Suchraum zu erreichen. Die Grundlage dieses Modells ist die Basensequenz. Somit besitzt der Suchraum die Dimension n mit n gleich Anzahl der Basenpaare. Ein

jeder Punkt im Suchraum repräsentiert als Vektor eine mögliche Basensequenz. Man nennt

diesen Raum daher auch Sequenzraum.

Wird nun eine Base einer solchen Basensequenz durch Mutation verändert, so entspricht die

Änderung gerade einem Schritt im Sequenzraum von einem Punkt zum nächsten Punkt.

Durch die Redundanz des genetischen Codes (jede Aminosäure wird durch verschiedene

Codewörter codiert), haben geringe Mutationen auch kaum Auswirkungen.

3.3.1

Paradoxon bei Räumen hoher Dimension:

Bei Räumen hoher Dimension ist der Abstand zwischen zwei zufällig gewählten Punkten nahezu konstant. Dies kann man leicht am Beispiel eines Wanderers, der einen Ausweg aus einem Gebirge sucht und dabei keine Berge überqueren darf, zeigen. Befindet sich der Wanderer in einem Gebirge des zweidimensionalen Raumes, so ist es für ihn unmöglich dieses zu

verlassen. Befindet er sich in einem Gebirge des dreidimensionalen Raumes, so ist es schon

recht wahrscheinlich, dass es in irgend einer Richtung bergab geht. Bei Räumen höherer Dimension wird es immer wahrscheinlicher einen Ausweg zu finden. Bis es dann bei Räumen

extrem hoher Dimension sogar keine Umwege und Sackgassen mehr gibt.

Für die Evolution bedeutet dies, dass sie, bei ihrer Suche, zu keiner früheren Position mehr

zurückkehren muss. Und weiterhin bedeutet es, dass jeder Punkt des Sequenzraumes durch

eine kurze Folge von Mutationen erreichbar ist. Doch wie lang ist nun eine solche Mutationskette? Um diese Frage zu beantworten, arbeitet man zunächst mit einem vereinfachten Raum.

Man betrachtet einen binären Raum mit n Dimensionen. D.h. jeder Punkt dieses Raumes ergibt sich aus einem binären Vektor der Länge n. Man wählt sich dann einen Startpunkt s = (x1,

x2, ... , xn) und einen Zielpunkt z = (y1, y2, ... , yn) wobei xi, yi ∈{0,1}. Der Abstand zwischen

diesen beiden Punkten berechnet sich dann so:

Abstand (s, z ) =

n

∑ (x − y )

i =1

i

2

i

Da xi und yi nur in zwei von vier Fällen etwas zum Abstand beitragen, gilt

Abstand (s, z ) = n / 2

Der Abstand ist also gleich der Wurzel aus der halben Dimension, und er ist konstant. Das

selbe Prinzip gilt auch für den Basensequenzraum.

Dies alles zeigt, dass sich der Gradualismus durchaus rechtfertigen lässt.

3.4

Kommunikation, Kultur und Kooperation

Diese drei Prinzipien wurden in den klassischen Evolutionstheorien ebenfalls vernachlässigt.

Dabei stellen sie, besonders bei höher entwickelten Lebewesen, wichtige Evolutionsfaktoren

dar. Durch Kommunikation kann Wissen weitergegeben werden, durch dessen Einsatz der

Selektionsdruck gemindert werden kann. Diese Art des Informationsaustausch ist dabei sehr

viel gezielter und schneller als über den Weg der Vererbung.

Durch die Bildung von Kulturgemeinschaften können Individuen überleben, die sonst, auf

sich allein gestellt, nur geringe Überlebenschancen haben.

Das Prinzip der Kooperation existiert schon seit der Entstehung von mehrzelligen Organismen. Darwin ging davon aus, dass nur die Individuen einer Art zur Fortpflanzung kommen,

die sich im Kampf um Nahrung und Territorium gegenüber den Artgenossen durchsetzen

können. In der Realität finden Kämpfe zwischen Artgenossen jedoch relativ selten statt. Es

überwiegt die Kooperation.

Eine besondere Art der Kooperation ist die Symbiose. Dabei kooperieren Lebewesen unterschiedlicher Art miteinander.

Auch Kulturgemeinschaften unterliegen einer Art Evolution. Einige sind bereits „ausgestorben“. Andere müssen sich noch behaupten bzw. weiterentwickeln. Bei der Evolution der Kulturen herrschen jedoch andere Gesetze, als bei der Evolution der Arten.

4.

Zusammenfassung, Ausblick

Die klassische Evolutionstheorie geht von einer ewig währenden Evolution aus. Die moderne

Gentechnik prophezeit jedoch das Gegenteil. Mit dem Wissen, was die Menschheit bereits

über Evolutionsprozesse erworben hat und mit Hilfe der modernen Gentechnik ist es dem

Menschen (zumindest theoretisch) möglich, die Evolution durch natürliche Selektion zu beenden. Mit wachsendem Wissen über die Evolutionstheorien könnte der Mensch eines Tages

in der Lage sein, die Entwicklung aller Lebewesen nach seinem Willen zu steuern. Die natürliche Evolution wäre damit am Ende. Aber die Kenntnisse über die Evolution sind längst noch

nicht vollständig. Viele Fragen sind noch offen. Es existieren weitere interessante Theorien,

auf die hier nicht eingegangen wurde. Zum Beispiel die Überlegungen von Manfred Eigen zur

präbiotischen Evolution.

Die existierenden Algorithmen, die verwendet werden um evolutionäre Prozesse zu simulieren, sind im Vergleich zu realen Prozessen geradezu simpel. Aber trotzdem kann man mit

ihnen erstaunliche Ergebnisse erzielen, was für die Genialität der Evolution spricht.