Konvergenzbegriffe

Werbung

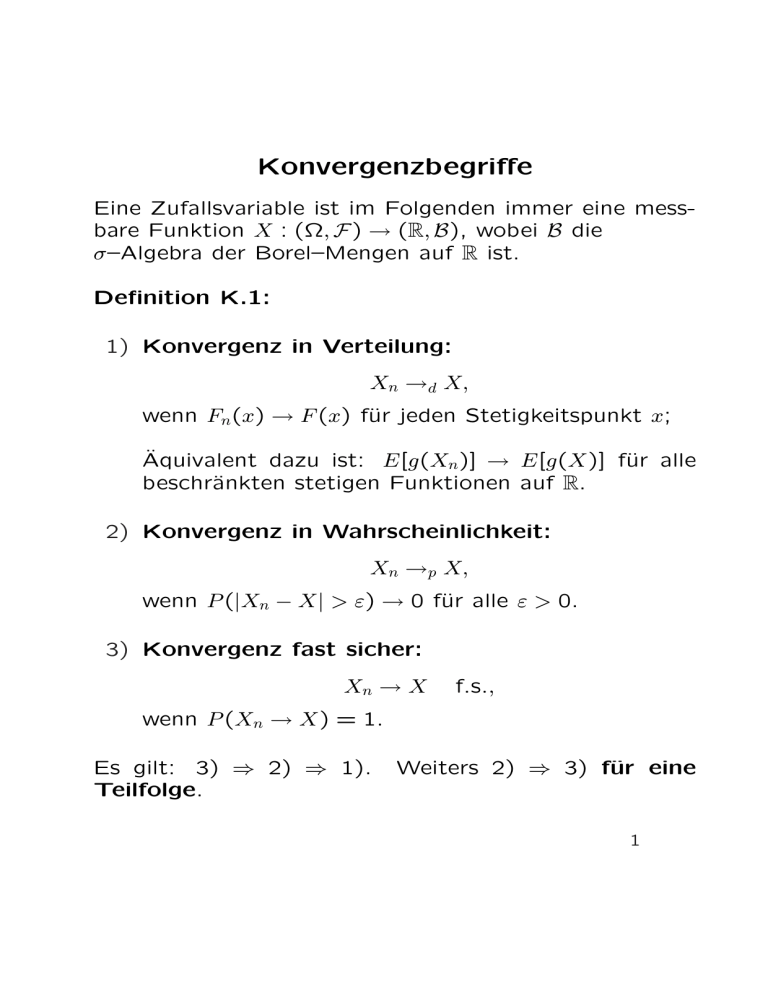

Konvergenzbegriffe

Eine Zufallsvariable ist im Folgenden immer eine messbare Funktion X : (Ω, F ) → (R, B), wobei B die

σ–Algebra der Borel–Mengen auf R ist.

Definition K.1:

1) Konvergenz in Verteilung:

Xn →d X,

wenn Fn (x) → F (x) für jeden Stetigkeitspunkt x;

Äquivalent dazu ist: E[g(Xn )] → E[g(X)] für alle

beschränkten stetigen Funktionen auf R.

2) Konvergenz in Wahrscheinlichkeit:

Xn →p X,

wenn P (|Xn − X| > ε) → 0 für alle ε > 0.

3) Konvergenz fast sicher:

Xn → X

f.s.,

wenn P (Xn → X) = 1.

Es gilt: 3) ⇒ 2) ⇒ 1).

Teilfolge.

Weiters 2) ⇒ 3) für eine

1

Definition K.2: Eine Familie C von Z.V. heisst

gleichmässig (oder auch gleichgradig) integrierbar, falls

zu jedem ε > 0 ein K ∈ [0, ∞) existiert, sodass

sup E[|X|1I{|X|>K} ] < ε.

X∈C

Definition K.3:

4) Konvergenz in Lp : Sei E[|Xn |p ] < ∞ für alle n.

Dann

Xn → X

in Lp ,

wenn E(|Xn − X|p ) → 0.

4) ⇔ 2) + {|Xn |p : n ≥ 1} gleichmässig integrierbar.

2

Konvergenz der Erwartungswerte:

Satz K.4:

1) Monotone Konvergenz: Wenn Xn ≥ 0 und Xn ↑ X

f.s., dann gilt limn→∞ EXn = EX.

2) Fatou: Wenn Xn ≥ c > −∞, dann gilt

E[lim inf Xn ] ≤ lim inf E[Xn ].

n

n

3) Dominierte Konvergenz: Wenn |Xn | ≤ Y , für alle

n, für eine integrierbare Z.V. Y und Xn → X f.s.,

dann gilt

lim E[Xn ] = E[X].

n

3