über konservierte Sequenzen

Werbung

Mehr über konservierte

Sequenzen

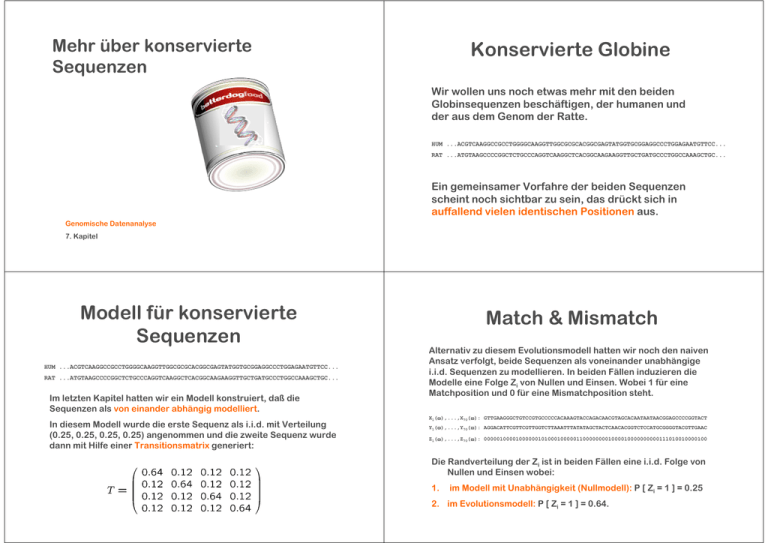

Konservierte Globine

Wir wollen uns noch etwas mehr mit den beiden

Globinsequenzen beschäftigen, der humanen und

der aus dem Genom der Ratte.

HUM ...ACGTCAAGGCCGCCTGGGGCAAGGTTGGCGCGCACGGCGAGTATGGTGCGGAGGCCCTGGAGAATGTTCC...

RAT ...ATGTAAGCCCCGGCTCTGCCCAGGTCAAGGCTCACGGCAAGAAGGTTGCTGATGCCCTGGCCAAAGCTGC...

Ein gemeinsamer Vorfahre der beiden Sequenzen

scheint noch sichtbar zu sein, das drückt sich in

auffallend vielen identischen Positionen aus.

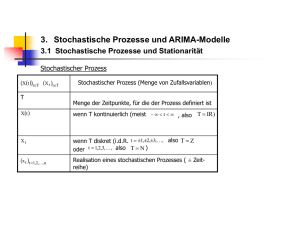

Genomische Datenanalyse

7. Kapitel

Modell für konservierte

Sequenzen

HUM ...ACGTCAAGGCCGCCTGGGGCAAGGTTGGCGCGCACGGCGAGTATGGTGCGGAGGCCCTGGAGAATGTTCC...

RAT ...ATGTAAGCCCCGGCTCTGCCCAGGTCAAGGCTCACGGCAAGAAGGTTGCTGATGCCCTGGCCAAAGCTGC...

Im letzten Kapitel hatten wir ein Modell konstruiert, daß die

Sequenzen als von einander abhängig modelliert.

In diesem Modell wurde die erste Sequenz als i.i.d. mit Verteilung

(0.25, 0.25, 0.25, 0.25) angenommen und die zweite Sequenz wurde

dann mit Hilfe einer Transitionsmatrix generiert:

Match & Mismatch

Alternativ zu diesem Evolutionsmodell hatten wir noch den naiven

Ansatz verfolgt, beide Sequenzen als voneinander unabhängige

i.i.d. Sequenzen zu modellieren. In beiden Fällen induzieren die

Modelle eine Folge Zi von Nullen und Einsen. Wobei 1 für eine

Matchposition und 0 für eine Mismatchposition steht.

X1(ω),...,X70(ω): GTTGAAGGGCTGTCCGTGCCCCCACAAAGTACCAGACAACGTAGCACAATAATAACGGAGCCCCGGTACT

Y1(ω),...,Y70(ω): AGGACATTCGTTCGTTGGTCTTAAATTTATATAGCTACTCAACACGGTCTCCATGCGGGGTACGTTGAAC

Z1(ω),...,Z70(ω): 0000010000100000010100010000011000000001000010000000000111010010000100

Die Randverteilung der Zi ist in beiden Fällen eine i.i.d. Folge von

Nullen und Einsen wobei:

1.

im Modell mit Unabhängigkeit (Nullmodell): P [ Zi = 1 ] = 0.25

2. im Evolutionsmodell: P [ Zi = 1 ] = 0.64.

Bernoulli-Verteilung

Interessiert man sich also nicht für die

beiden Sequenzen sondern nur für die

Abfolge von Match und

Mismatchpositionen, kann man jede

einzelne Position durch ein einfacheres

Zufallsexperiment realisieren:

1

Bernoulli-Verteilung

Sei X~Bernoulli(p)

Jakob Bernoulli 1654-1705

0

E[X]=

1 × p + 0 × (1-p) = p

0

p

1

Ein solches Experiment heißt Bernoulli-Experiment, und die

zugehörige Zufallsvariable hat eine Bernoulli-Verteilung mit

Erfolgsparameter p.

Var (X) =

p(1-p)2+(1-p)(0-p)2 = p(1-p)

Also X~Bernoulli(p) bedeutet das gleiche wie X~ (p, 1-p) mit

Werten (0,1).

Anzahl Erfolge

Binominalverteilung

In anderen Worten:

Hat man eine i.i.d. Sequenz von n Bernoulli-Variablen Z1,...,Zn,

dann ist die Anzahl der Erfolge (Einsen):

S ~ (b0,...,bn) mit Werten in (0,...,n)

wieder eine Zufallsvariable. S kann als Werte (0,...,n) annehmen.

P [ S=k ] =

Man sagt auch S ist binominal verteilt mit

Parameter (p,n)

S ~ Bin (p,n)

?

E [ S ] = E [ ∑ Zi ] = ∑ E [ Zi ] = np

?

Anzahl der mögliche

Positionen der Einsen

k Einsen ... und nicht mehr

Var (S) = Var (∑ Zi) = n Var (Zi) = np(1-p)

Erwartungswert der Summe

von Zufallsvariablen

Varianz der Summe von

Zufallsvariablen

Es gilt allgemein: E [ X + Y ] = E [ X ] + E [ Y ]

Es gilt:

E [ X ] := ∑i xi P [ X = xi ]

Var ( X+Y ) = E [ (X + Y – E [ X + Y ] )2 ]

= E [ ((X – EX) + (Y – EY))2 ]

= E [ (X – EX)2] + E [(Y – EY)2] + 2 E [ (X-EX)(Y-EY)]

E [ X + Y ] = ∑i,j (xi + yj) P [X=xi, Y=yj]

= Var ( X ) + Var ( Y ) + 2 E [ (X-EX)(Y-EY) ]

= ∑i,j xi P [X=xi, Y=yj] + ∑i,j yj P [X=xi, Y=yj]

= ∑i xi (∑j P [X=xi, Y=yj]) + ∑j yj (∑i P [X=xi, Y=yj])

= ∑i xi P [X=xi] + ∑j yj P [Y=yj]

= E[X]+E[Y]

Erwartungswert eines

Produktes unabhängiger

Zufallsvariablen

Sind X und Y unabhängig, dann gilt:

Unabhängige

Ereignisse

Varianz der Summe

unabhängiger

Zufallsvariablen

Unabhängige

Zufallsvariablen

Es gilt:

Var ( X+Y ) = Var ( X ) + Var ( Y ) + 2 E [ (X-EX) (Y-EY) ]

E [ X Y ] = ∑i ∑j xi yj P [ X=xi, Y=yj ]

= ∑i ∑j xi yj P [ X=xi ] P [ Y=yj ]

= Var ( X ) + Var ( Y ) + 2 E [ (X-EX) ] E [ (Y-EY) ]

= Var ( X ) + Var ( Y ) + 2 ( EX-E[ EX ]) (EY –E [ EY ] ]

= Var ( X ) + Var ( Y )

= ∑i ∑j xi P [ X=xi ] yj P [ Y=yj ]

E [ EX ] = EX

= ∑i xi P [ X=xi ] ∑j yj P [ Y=yj ]

Erwartungswert einer konstanten Zufallsvariablen

=E [ X ] E [ Y ]

Binominalverteilung

Also wirklich:

S ~ Bin (p,n)

E [ Zi ] =p für alle n

Summanden

Konservierten Sequenzen:

Nullmodel

HUM ...ACGTCAAGGCCGCCTGGGGCAAGGTTGGCGCGCACGGCGAGTATGGTGCGGAGGCCCTGGAGAATGTTCC...

RAT ...ATGTAAGCCCCGGCTCTGCCCAGGTCAAGGCTCACGGCAAGAAGGTTGCTGATGCCCTGGCCAAAGCTGC...

1011010001111110010101111000011011111101101010111011011111110011010101

Bei diesem Sequenzvergleich beobachten wir 45 Matchpositionen

von 70 Möglichen.

Summe von BernoulliVariablen Zi

Wir haben n = 70

E [ S ] = E [ ∑ Zi ] = ∑ E [ Zi ] = np

Nullmodel: p=0.25, also S~Bin (0.25,70)

Wie wahrscheinlich ist die Beobachtung S=45?

Var (S) = Var (∑ Zi) = n Var (Zi) = np(1-p)

Summe von

unabhängigen BernoulliVariablen Zi

Var ( Zi ) = p(1-p) für alle n

Summanden

Konservierten Sequenzen:

Evolutionsmodel

Punktwahrscheinlichkeit

Im Evolutionsmodel gilt p=0.64: S~ Bin (0.64,70)

P [ S=45 ] =

Hat man die beiden Alternativen:

1. Die Sequenzen sind nicht verwandt (repräsentiert durch

das Nullmodell)

2. Die Sequenzen sind evolutionär verwandt (repräsentiert

durch das Evolutionsmodel)

Dann liefert die Beobachtung von 45 Matchpositionen eine

erschlagende Evidenz zugunsten von 2.

Die Beobachtung erscheint aber auch im Evolutionsmodell

nicht sonderlich wahrscheinlich, nur 10%. Woran liegt das?

Die Wahrscheinlichkeit, genau 45 Matches (Erfolge) zu

generieren ist in der Tat klein. Aber bei 46, 47 , ... Matches

haben wir ja immernoch Evidenz für evolutionäre

Konservierung ... dann erst recht.

Die Wahrscheinlichkeit punktgenau 45 Matche zu haben,

nennt man auch Punktwahrscheinlichkeit ...

... Sie ist wenig hilfreich, es empfiehlt sich, wieder ein

gröberes Maß anzulegen.

Extremalwahrscheinlichkeit

Betrachten wir an Stelle des Ereignisses S=45, das

Ereignis

Extremalwahrscheinlichkeit

S ≥ 45 ...

S=0, S=1, S=2,...,S=k sind disjunkte

Ereignisse.

„Mindestens 45 Matches oder noch mehr

Konservierung“

Unter dem Nullmodell (p=0.25) erhalten wir:

P [ S ≥ 45 ] = 1 – P [s < 45] = 1-F (45)

P [ S ≥ 45 ] ≈ 0 (immer noch extrem klein)

wobei F(k) die Verteilungsfunktion von S ist:

Unter dem Evolutionsmodell (p=0.64)

P [ S ≥ 45 ] ≈ 0.44 (... also ein typisches

Ergebnis)

Statt von Punktwahrscheinlichkeit sprechen wir hier

von Extremalwahrscheinlichkeit (tail probability)

Zusammenfassung

45 Match-Positionen scheinen eine sehr deutliche Sprache

zu sprechen:

Large Scale Effects

Könnte unsere Beobachtung so etwas ähnliches sein, wie wir sie bei den

Splice-Positionen hatten ...

... eine „Fata Morgana“, die man

beim Durchsuchen großer

Datenmengen ja haben kann

(Borel-Cantelli). Die Sequenzen

wurden ja erst in den riesigen

Genomsequenzen gefunden ...

Die Sequenzen sind verwandt ... haben vermutlich einen

gemeinsamen Vorfahren.

Wir haben zweierlei Evidenz:

1. Signifikanz:

45 Match-Positionen sind für nicht verwandte Sequenzen

(Nullmodell) sehr ungewöhnlich.

... GTGGTAAGT...

2. Modellvergleich: (Likelihood-Ratio)

45 Match-Positionen sind im Evolutionsmodell viel

wahrscheinlicher als im Nullmodell.

... ACGGTAAGC

...

...AAGGTAAAA...

...AGGGTAAGA..

.

... kann es da nicht mal zufällig

vorkommen, daß es nach

Konservierung aussieht obwohl

nichts dahinter steckt?

Statt von einer Fata Morgana

sprechen wir ab jetzt nüchterner

vom „Problem multipler Tests“

oder von einem Large Scale Effect.

Large Scale Effects

Zurück zu den Globinen

HUM ...ACGTCAAGGCCGCCTGGGGCAAGGTTGGCGCGCACGGCGAGTATGGTGCGGAGGCCCTGGAGAATGTTCC...

Diese Large Scale Effects sind ein generelles Problem in der

Bioinformatik und spielen auch bei der Einschätzung von

Sequenzähnlichkeiten eine entscheidende Rolle.

RAT ...ATGTAAGCCCCGGCTCTGCCCAGGTCAAGGCTCACGGCAAGAAGGTTGCTGATGCCCTGGCCAAAGCTGC...

Zum Beispiel ist das Datenbank-Suchprogramm BLAST ein

Spezialist auf dem Gebiet.

Man kann in BLAST eine Querysequenz eingeben, und Blast sucht

dann ganze Datenbanken von Sequenzen (mit diversen

vollständigen Genomen darin) nach kleinen Segmenten ab, die

Ähnlichkeit zu einem Stück der Query haben.

Weitgehend mutierter

Bereich. Wenig selektiver

Druck.

Perfekt konservierter

Bereich. Mutationen

wurden von der Selektion

nicht toleriert.

Dabei muß BLAST so gut wie möglich zwischen zufälliger und

echter Ähnlichkeit unterscheiden.

Beobachten wir hier so etwas wie einen Unterschied im Ausmaß

des selektiven Drucks?

Mehr dazu später in der Vorlesung.

Konnte der rote Bereich nicht mutieren, da diese Mutationen

unvorteilhaft waren?

Wenn ja, dann muß dieser Bereich besonders wichtig sein.

Headruns

Headruns

HUM ...ACGTCAAGGCCGCCTGGGGCAAGGTTGGCGCGCACGGCGAGTATGGTGCGGAGGCCCTGGAGAATGTTCC...

HUM ...ACGTCAAGGCCGCCTGGGGCAAGGTTGGCGCGCACGGCGAGTATGGTGCGGAGGCCCTGGAGAATGTTCC...

RAT ...ATGTAAGCCCCGGCTCTGCCCAGGTCAAGGCTCACGGCAAGAAGGTTGCTGATGCCCTGGCCAAAGCTGC...

RAT ...ATGTAAGCCCCGGCTCTGCCCAGGTCAAGGCTCACGGCAAGAAGGTTGCTGATGCCCTGGCCAAAGCTGC...

1011010001111110010101111000011011111101101010111011011111110011010101

1011010001111110010101111000011011111101101010111011011111110011010101

In der Sequenz von Nullen und Einsen,

entsprechen dem roten Bereich 7 Einsen direkt

hintereinander.

7 Einsen direkt hintereinander:

Eine ununterbrochene Abfolge von Einsen nennt

man einen Headrun.

Also Z1,...,Zn i.i.d. mit Zi ~ Bernoulli (0.64)

Perfekt konservierte Sequenzabschnitte im

Alignment entsprechen also Headruns der Zi.

Ist das auffällig ?

Nehmen wir das Evolutionsmodell:

Die Länge des längsten Headruns in Z1,...,Zn nennen wir

Rn.

Wir sind an P [ Rn ≥ 7 ] interessiert.

Startruns

Verteilung von

Startruns

Betrachten wir zunächst nur Headruns, die gleich zu

Anfang der Sequenz auftreten:

Die Wahrscheinlichkeit, daß die ersten r Positionen alle

Einsen sind:

P [ Z1=1,...,Zr=1 ] = pr

SR ist eine Zufallsvariable. Wie ist sie verteilt?

P [ SR=r ] =

pr (1-p)

Als Länge des Startruns einer Sequenz SR bezeichnen

wir die Anzahl von Einsen zur Beginn der Sequenz:

Also: SR(„111010“) = 3

Die ersten r Positionen

sind Einsen

... und dann folgt eine Null,sonst wäre

der Startrun ja mindestens r+1 lang.

SR(„011111“) = 0

Geometrische Verteilung

Für eine unendlich lange Bernoulli-Sequenz und gr:=pr(1-p), ist der

Startrun: SR ~ (g0,g1,...) mit Werten in (0,1,...)

Eine Zufallsvariable X für die P [ X=r ] = pr (1-p) gilt, nennt man

geometrisch verteilt mit Parameter p ...

... und wir schreiben kurz X ~ Geo(p).

Signifikanz von

Startruns

Wir können damit Aussagen über die Verteilung der Länge des

Startruns machen. Für ein Alignment, das mit einem

konservierten Bereich beginnt, können wir entscheiden, ob diese

Beobachtung eine zufällige Fluktuation sein könnte oder erhöhte

Sequenzkonservierung widerspiegelt.

Es gibt eine Einschränkung:

Das Alignment hat nur eine endliche Länge n=70.

E[X]=

Eine Geo(p) verteilte Zufallsvariable kann aber auch größere

Werte annehmen.

Das würde in unserem Fall keinen Sinn machen (Randeffekt).

Ein Startrun größer als 70 ist aber sehr unwahrscheinlich.

Var (X) =

... kann man nachrechnen.

Deshalb vernachlässigen wir das Problem

Startruns vs. Headruns

Für ein Alignment, das mit einem konservierten Bereich beginnt,

können wir entscheiden, ob diese Beobachtung eine zufällige

Fluktuation sein könnte oder erhöhte Sequenzkonservierung

widerspiegelt.

Nur sind wir daran ja nicht interessiert:

Identische Ereignisse

Die folgenden zwei Ereignisse sind identisch:

A: Die (0-1) Sequenz startet nicht mit r Einsen.

B: SR < r.

A lautet im Kontext des Alignments auch:

HUM ...ACGTCAAGGCCGCCTGGGGCAAGGTTGGCGCGCACGGCGAGTATGGTGCGGAGGCCCTGGAGAATGTTCC...

RAT ...ATGTAAGCCCCGGCTCTGCCCAGGTCAAGGCTCACGGCAAGAAGGTTGCTGATGCCCTGGCCAAAGCTGC...

1011010001111110010101111000011011111101101010111011011111110011010101

Unsere Beobachtung war ja nicht Konservierung am Beginn des

Alignments sondern in seinem Inneren.

Wir sind am längsten Headrun Rn und nicht am längsten

Startrun SR interessiert.

Signifikanz von

Headruns

(A‘)c ist genau das Ereignis, das zu unserer Beobachtung paßt:

Es gibt einen konservierten Bereich der Länge r oder länger.

HUM ...ACGTCAAGGCCGCCTGGGGCAAGGTTGGCGCGCACGGCGAGTATGGTGCGGAGGCCCTGGAGAATGTTCC...

RAT ...ATGTAAGCCCCGGCTCTGCCCAGGTCAAGGCTCACGGCAAGAAGGTTGCTGATGCCCTGGCCAAAGCTGC...

1011010001111110010101111000011011111101101010111011011111110011010101

Um festzustellen ob die Beobachtung weitere Aufmerksamkeit

rechtfertigt (Hypothesen-Generierung) müssen wir ...

P[

(A‘)c

] = 1 – P [ Rn < r ]

... berechnen.

Gesucht ist die Verteilung der Länge Rn des längsten Headruns.

A: Das Alignment startet nicht mit r identischen

Positionen

Die folgenden Ereignisse sind ebenfalls identisch:

A‘: Die (0-1) Sequenz enthält keinen Headrun der Länge r

B‘ : Rn < r. (Der längste Headrun ist kürzer als r).

Headrun = lokaler Startrun

Der Startrun ist ein Headrun, dessen Startpunkt wir kennen.

Er muß bei Position 1 starten.

Der längste Headrun, könnte theoretisch überall starten.

Es gibt damit n mögliche Startpunkte, wobei n die Länge des

Alignment ist.

Für jede beliebige Startposition i sei SR(i) die Länge des längsten

dort startenden Headrun.

Für unendlich lange (0-1) Sequenzen sind alle SR(i) ~ Geo(p).

Für eine endlich lange Sequenz taucht wieder das Problem der

Randeffekte auf.

Jetzt aber in verschärfter Form, da die Randeffekte für Startpunkte

nahe dem Ende der Sequenz erheblich sein können.

Erster Versuch

Zweiter Versuch

Es gibt keinen Headrun der Länge r.

Versuchen wir es anders:

Dann gibt es auch keinen Startpunkt für einen solchen Headrun.

Für eine feste Position i und eine feste Runlänge r definieren wir:

Es gilt SR(i) < r für alle i · n.

Xi = 1 falls Zi × ... × Zi+r-1 = 1

Sei Ai das Ereignis { SR(i) <r },

Xi = 0 sonst.

Dann ist P [ Rn < r ] = P [ A1 ∩ A2 ∩ ... ∩ An ].

Wären die SR(i) i.i.d., dann wären wir fertig:

Xi zeigt an, ob in i ein Headrun beginnt, der mindestens r Positionen

lang ist.

P [ Kein konservierter Bereich der Läng r ] =

Sei W = ∑ Xi

W zählt wie häufig Headruns die länger als r sind auftreten:

= P [ A1 ] n

= ( pr (1-p) ) n

... nur sind sie das gerade nicht ! (überlappende Positionen)

Zi(ω): 0100100111010100111110101111111001010101010

Xi(ω): 0000000100000000111000001111000000000000000

Das war eine Sackgasse ... aber eine lehrreiche!

Abhängigkeit durch

überlappende Positionen in

der Runs

P[Xi=1]= pr ... also Xi ~ ( pr, 1-pr )

... aber die Xi sind auch hier nicht unabhängig!

z.B. P[ Xi=1 | Xi+1=1]

Abhängigkeit durch

überlappende Positionen in

der Runs

Aus dem gleichen Grund sind auch Xi und Xi+∆ genau

dann abhängig, wenn ∆ < r ist.

E[ Xi ]

= pr

=p

E[W]

P[ Xi=1]

= pr

Also sind Xi und Xi+1 abhängig.

= (n-r+1) pr

Approximation mit

Binominalverteilung

Analoges i.i.d. Modell

Die Xi sind zwar identisch verteilt: Xi ~ ( pr, 1-pr ) ...

... aber nicht unabhängig ( independent ) ...

Wie ist W‘ verteilt?

× Sequenz.

da fehlt ein i zur i.i.d.

W‘ ~ Bin(pr,n)

Definieren wir uns trotzdem die entsprechende i.i.d.

Sequenz:

W ist eine binominal verteilte

Zufallsvariable ...

Y1,...,Yn Yi i.i.d. mit Yi ~ Xi

mit Erfolgsparameter pr ...

( Achtung: Yi ~ Xi aber ( Xi, Xi+1 ) ¿ ( Yi, Yi+1 ) )

Im Globin-Alignment:

Sei W‘ = ∑ Yi

p=0.64, r=7 pr= 0.04

Wie ist W‘ verteilt?

Weniger als t:

Weniger als t Headruns der

Mindestlänge r

Poissonverteilung

Entweder 0 oder 1 ... oder t-1

( Disjunkte Ereignisse )

Mindestens i

Headruns ...

Eine Zufallsvariable W mit Werten 0,1,2,3, ... und

der Verteilung:

heißt poissonverteilt mit Intensität λ.

λx ...

i von n-r+1

möglichen

Startpunkten

P[ W‘ = i ]

... und nicht mehr

x! ...

e-λ ...

... und das alles in einer Formel

... wer denkt sich denn so was aus?

Simon Denis Poisson

(1781- 1840)

Ausgedünnte Erfolge

X binominal verteilt mit Erfolgsparameter p und n Versuchen

Binominalverteilung Æ

Poissonverteilung

λ= E [ X ] = n p

Legen wir eine Intensität λ fest ...

Verdoppeln wir die Anzahl von Versuchen und halbieren die

Erfolgswahrscheinlichkeit:

... und betrachten immer größer werdende Versuchsgrößen:

X‘ ~ Bin(p/2,2n)

Dann konvergiert:

n =1,2,3, ... und dazugehörige pn= λ, λ\2, λ\3, ....

( pn = λ\n)

E [ X‘ ] = n p = λ

Wir erwarten wieder λ Erfolge, nur jetzt auf doppelt soviele

Versuche aufgeteilt.

Ausdünnen der Erfolge

Machen wir weiter so ...

... wir teilen λ erwartete Erfolge auf immer mehr Versuche auf.

Dazu müssen wir p auch im richtigen Verhältnis immer kleiner

machen.

Seltene Ereignisse

Was betrachten wir für große n?

Wir zählen Ereignisse:

•

die selten sind (pn klein) ...

•

... unter vielen (n groß) ...

•

bei mittel großer Gesamthäufigkeit (λ=const.)

Zusätzlich haben wir noch verlangt:

•

Das die Ereignisse unabhängig und gleich

wahrscheinlich sind.

•

Das pn proportional zu 1/n ist.

Also Xn ~ Bin( pn,n ) und Y ~ Poisson(λ): P [Xn=t] Æ P [ Y=t ]

Für große n und entsprechend kleines p ist eine

binominalverteilte Zufallsvariable einer poissonverteilten

Zufallsvariablen ähnlich.

Poissonapproximation

Man muß sich nicht auf den

Fall verdünnter binominal

Verteilungen beschränken.

Es gibt das allgemeine Prinzip

der Poissonapproximation:

Die Anzahl seltener

Ereignisse ist annähernd

poissonverteilt.

Poissonapproximation

Es gibt hunderte Lehrsätze in denen dieses Prinzip in speziellen

Situationen nachgewiesen wurde. Die Konvergenz der

Binonimalverteilung ist nur eines davon.

Die Voraussetzungen:

1. Das die Ereignisse unabhängig und gleich wahrscheinlich

sind.

2. Das pn proportional zu 1/n ist.

braucht man nicht in voller Strenge. Es genügt in der Regel:

1‘: Das die Experimente nicht zu sehr abhängig sind.

2‘: Das p hinreichend klein ist im Vergleich zu n.

Allgemeines Prinzip der

Wahrscheinlichkeitstheorie

Poissonapproximation

Es genügt in der Regel:

1‘: Das die Experimente nicht zu sehr abhängig sind.

2‘: Das p hinreichend klein ist im Vergleich zu n.

Das sind keine präzisen Auskünfte. Was ist zu abhängig und was

ist hinreichend klein?

Zum einen gibt es eine umfangreiche mathematische Literatur zu

diesem Thema.

Zum anderen kann man es anhand der Daten überprüfen, mehr

dazu später.

Mehr als nur ein Theorem:

Das Prinzip:

Seltene Ereignisse sind oft poissonverteilt ...

Das Prinzip:

Die Anzahl seltene Ereignisse sind poissonverteilt ...

... gehört zu den wichtigen Prinzipien der

Wahrscheinlichkeitstheorie, wie auch

- das Gesetz der großen Zahlen

- der zentrale Grenzwertsatz (Normalapproximation, später in

der Vorlesung)

Es ist auch unter dem Namen:

... ist sehr allgemein und geht auch über mathematische

Theorie hinaus.

Man hat auch bei statistisch erhobenen Daten häufig

Poissonverteilungen beobachtet, wenn seltene Ereignisse

gezählt wurden.

z.B.

-Tote durch Hufschlag in preußischen Kavallerieregimenten.

- Anzahl von Verkehrsunfällen in einem festen Zeitraum.

Gesetz der kleinen Zahlen

bekannt.

... und in der Bioinformatik?

Häufige Konzepte mit

selten Ereignissen in der

Bioinformatik

- Lange „Wörter“ im Genom

- Die selbe Sequenz in zwei Genomen

- Anzahl

von Mutationen in einem langen DNA-Abschnitt.

- Die Anzahl von Headruns ?

Zurück zum Alignment

Xi = 1 falls Zi × ... × Zi+r-1 = 1

Xi = 0 sonst.

Xi zeigt an, ob in i ein Headrun beginnt, der mindestens r

Positionen lang ist.

Für r groß (lange Headruns) ist P [Xi=1] klein. Das Zählen von

langen Headruns ist also ein Zählen von seltenen Ereignissen.

Das ist schon mal gut im Hinblick auf eine Poissonapproximation.

Die Xi sind aber nicht unabhängig, ...

deswegen folgt die Poissonapproximation nicht automatisch.

Vielleicht sind sie aber doch nicht zu abhängig.

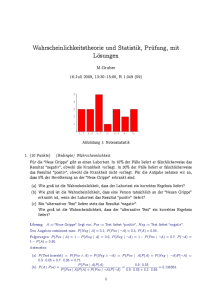

Simulation

Antwort: Nein

500 i.i.d. (0-1) Sequenzen der Länge 1000

p=0.64 (für eine 1)

Headruns mit mindest Länge 15 wurden gezählt.

Die Wahrscheinlichkeit, daß an einer festen Position ein Headrun

länger als 15 startet ist gleich pr=0.0012 (seltenes Ereignis)

Intensität: λ =

(0.64)15*1000

≈ 1.2

Frage: Ist die Anzahl Headruns mit einer Mindestlänge von 15

poissonverteilt?

Woran liegt das?

Woran liegt das?

Zi(ω): 0100100111010100111110101111111001010101010

Xi(ω): 0000000100000000111000001111000000000000000

Clumping

Zi(ω): 0100100111010100111110101111111001010101010

Xi(ω): 0000000100000000111000001111000000000000000

Die entscheidende Sequenz sind die Xi

Xi ist 1 falls in i ein Headrun länger als r startet (oben r=3)

Das sind seltene Ereignisse

Es fällt auf, daß die Einsen in der Sequenz gehäuft hinter einander

auftreten

P [ Xi+1=1 | Xi=1 ]

=p

Im Vergleich zur Randverteilung P[ Xi=1 ] =

pr

Die Abhängigkeit ist zu stark.

Die Xi zeigen ein Clumping.

Ein Headrun der Länge 6 führt zu gleich 4 Headruns

der Mindestlänge 3.

Die Headruns sind zwar seltene Ereignisse, wir zählen

sie teilweise aber öfters als einmal.

Startend mit Xi+1 gibt es auf alle Fälle bereits Einsen auf den r-1

nächsten Positionen. Zum Erfolg fehlt nur noch eine weitere Eins.

Die Poissonapproximation ist fehlgeschlagen.

Declumping

Hilft Declumping bei der

Poissonapproximation?

Zi(ω): 0100100111010100111110101111111001010101010

Xi(ω): 0000000100000000111000001111000000000000000

Yi(ω): 0000000100000000100000001000000000000000000

Wir wollen jeden Headrun von 3 Einsen und mehr nur einmal

zählen, auch wenn er 5 oder 10 Positionen lang ist.

Für die Sequenz Zi wollen wir also 3 Headruns zählen und nicht 8.

Wir wollen die Position i nur dann als Beginn eines Headruns

zählen, wenn er auch wirklich dort beginnt ... und nicht schon

früher.

Definiere Y1=1 falls X1=1

Für i>1 definiere Yi=1 falls Xi=1 und Xi-1=0

W‘‘= ∑ Yi ist die Anzahl der Headrun-Clumps

Den Übergang von Xi zu Yi nennt man Declumping

Ja!

Die Anzahl von

Headrun Clumps ist

in der Tat annähernd

poissonverteilt.

Zusammenfassung:

- Bernoulliverteilung

- Erfolgsparameter

- Binominalverteilung

- geometrische Verteilung

- Randeffekten

- Poissonverteilung

- Intensität

- seltene Ereignisse

- Poissonapproximation

- Headruns

- Declumping

- Large scale Effekt

Erwartungswert der Summe

von Zufallsvariablen

Es gilt allgemein: E [ X + Y ] = E [ X ] + E [ Y ]

E [ X ] := ∑i xi P [ X = xi ]

= ∑i ∑ω:X(ω)=x ) xi P [ ω ]

i

= ∑ω X(ω) P[ ω ]

E [ X + Y ] = ∑ω X+Y (ω) P [ ω ]

= ∑ω ( X(ω) + Y(ω)) P [ ω ]

= ∑ω X(ω) P [ ω ] +∑ω Y(ω) P [ ω ]

= E[X]+E[Y]