Vorlesung 9a Der Korrelationskoeffizient

Werbung

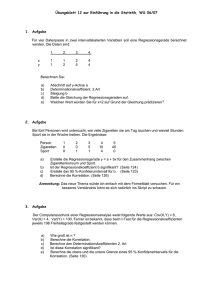

Vorlesung 9a Der Korrelationskoeffizient 1 Hier sind 5 Zahlen zur (teilweisen) Beschreibung der Verteilung einer R × R-wertigen Zufallsvariablen oder anders gesagt: eines zufälligen Paares (X, Y ): µX und µY : die Erwartungswerte von X und Y σX und σY : die Standardabweichungen von X und Y κXY : der Korrelationskoeffizient von X und Y . 2 Definition. Für zwei Zufallsvariable X, Y mit positiven, endlichen Varianzen sei κ = κXY := √ Cov[X, Y ] √ VarX VarY der Korrelationskoeffizient von X und Y . 3 Aus der Cauchy-Schwarz-Ungleichung (s. Ende von VL 7b) folgt mit U := X − E[X], V := Y − E[Y ]: |E[(X − E[X])(Y − E[Y ])]| ≤ q q E[(X − E[X])2] E[(Y − E[Y ])2], also: −1 ≤ κXY ≤ 1. 4 Wir werden sehen: Grob gesprochen sagt κ2, um wieviel besser Y durch eine affin lineare Funktion von X vorhergesagt werden kann als durch eine Konstante. Das analysieren wir genauer. Die “Güte der Vorhersage” bezieht sich auf einen kleinen erwarteten quadratischen Fehler (mean sqare error). 5 Durch welche Konstante wird die Zufallsvariable Y (im Sinn des erwarteten quadratischen Fehlers) am besten vorhergesagt? Durch ihren Erwartungswert E[Y ] ! Denn: 6 E(Y − c)2 = E[(Y − EY + EY − c)2] = E[(Y − EY )2] + 2E[(Y − E[Y ])(EY − c)] + (E[Y ] − c)2 = Var Y + 0 + (E[Y ] − c)2. 7 E(Y − c)2 = E[(Y − EY + EY − c)2] = E[(Y − EY )2] + 2E[(Y − E[Y ])(EY − c)] + (E[Y ] − c)2 = Var Y + 0 + (E[Y ] − c)2. Das wird minimiert von c = EY und hat den Minimalwert Var Y . 8 Durch welche affin lineare Funktion von X, aX + b, wird die Zufallsvariable Y (wieder im Sinn des erwarteten quadratischen Fehlers) am besten vorhergesagt? Genauer: Für welche Zahlen a, b wird E[(Y − aX − b)2] minimal? 9 Die Lösung ist: σY κXY a := σX und b so, dass µY = aµX + b. M. a. W.: b so, dass der Punkt (µX , µY ) auf der Geraden y = ax + b liegt. Wir nennen diese Gerade die Regressionsgerade für Y auf der Basis von X. 10 Wir begründen jetzt die Behauptung über a und b: E[(Y − aX − b)2] = Var[Y − aX − b] + (E[Y ] − aE[X] − b)2 11 Wir begründen jetzt diese Behauptung. Dazu formen wir um: E[(Y − aX − b)2] = Var[Y − aX − b] + (E[Y ] − aE[X] − b)2 Der zweite Summand ist Null für b = EY − aEX. Damit haben wir schon mal die eine Bedingung gefunden. Der erste Summand ist gleich Var[Y − aX]. Für welches a wird das minimal? 12 Var[Y − aX] = VarY − 2aCov[X, Y ] + a2VarX = = σY2 − σY2 Cov[X, Y ] 2 + a2σX − 2aσX σX Cov[X, Y ]2 2 σX + 2 Cov[X, Y ] X− σX aσ 13 Var[Y − aX] = VarY − 2aCov[X, Y ] + a2VarX = = σY2 − σY2 Cov[X, Y ] 2 + a2σX − 2aσX σX Cov[X, Y ]2 2 σX + 2 Cov[X, Y ] X− σX aσ Der rechte Summand wird Null für Cov[X, Y ] σY a= κ. = 2 σX σX Der Minimalwert von Var[Y − aX] ist also σY2 (1 − κ2). 14 Damit ist auch der Minimalwert von Var[Y − aX − b] gleich σY2 (1 − κ2). Der Minimalwert von Var[Y − c] war σY2 . Also ist der Anteil von Var Y = σY2 , der von den Vielfachen von X zusätzlich zu den Vielfachen von 1 “erklärt” wird, gleich κ2σY2 . 15 Beispiel 1: (x1, y1), . . . , (xn, yn) seien n Punkte im R2. Die gemeinsame Verteilung von (X, Y ) sei n 1 X ν̄ := δ(xi,yi). n i=1 (Dabei ist δz (B) := 1 für z ∈ B, und := 0 für z 6= B.) Vorstellung: ν̄ gibt jedem Punkt (xi, yi), i = 1, . . . , n, 1. das Gewicht n 16 n 1 X δ(xi,yi). Dann ist (X, Y ) hat Verteilung ν̄ = n i=1 1X xi =: x̄ EX = n 2 σX κ= q 1X = (xi − x̄)2 n (xi − x̄)(yi − ȳ) P q 2 P (xi − x̄) P (yi − ȳ)2 . 17 E[(Y − aX − b)2] n 1 X (yi − axi − bi)2 = n i=1 18 E[(Y − aX − b)2] n 1 X (yi − axi − bi)2 = n i=1 wird, wie wir gezeigt haben, minimiert durch E[(Y − aX − b)2] n 1 X (yi − axi − bi)2 = n i=1 wird, wie wir gezeigt haben, minimiert durch σY κ= a := σX (xi − x̄)(yi − ȳ) P (xi − x̄)2 P E[(Y − aX − b)2] n 1 X (yi − axi − bi)2 = n i=1 wird, wie wir gezeigt haben, minimiert durch σY κ= a := σX (xi − x̄)(yi − ȳ) P (xi − x̄)2 P und b so, dass ax̄ + b = ȳ. E[(Y − aX − b)2] n 1 X (yi − axi − bi)2 = n i=1 wird, wie wir gezeigt haben, minimiert durch σY κ= a := σX (xi − x̄)(yi − ȳ) P (xi − x̄)2 P und b so, dass ax̄ + b = ȳ. Diese Gerade y = ax + b heißt die Regressionsgerade zu den Punkten (xi, yi), i = 1, . . . , n.. Beispiel 2: Z1, Z2 seien unabhängig und standard-normalverteilt, ρ ∈ [−1, 1]. X := Z1, q Y := ρZ1 + 1 − ρ2Z2. 2 = σ 2 = 1, Dann gilt: σX Y κXY = ρ. 19 Die folgenden Bilder (ρ = −0.9, −0.8, . . . , 0.8, 0.9) zeigen jeweils die Realisierungen von 1000 unabhängige Kopien (Xi, Yi) von (X, Y ), zusammen mit der Regressionsgerade für Y auf der Basis von X (in schwarz) und der Regressionsgerade für X auf der Basis von Y (in grau). Korrelation = −0.9 Korrelation = −0.8 Korrelation = −0.7 Korrelation = −0.6 Korrelation = −0.5 Korrelation = −0.4 Korrelation = −0.3 Korrelation = −0.2 Korrelation = −0.1 Korrelation = 0 Korrelation = 0.2 Korrelation = 0.3 Korrelation = 0.4 Korrelation = 0.5 Korrelation = 0.6 Korrelation = 0.7 Korrelation = 0.8 Korrelation = 0.9