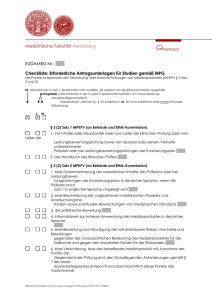

Randomisierung - Fachschaft Psychologie Freiburg

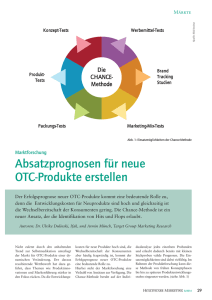

Werbung