QualitativeMethoden-ss04c

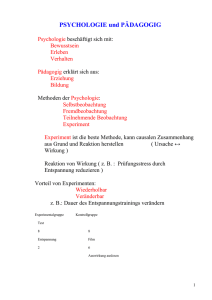

Werbung