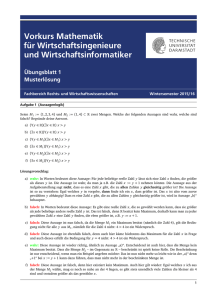

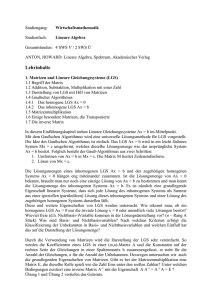

LinAlg - Zusammenfassung

Werbung

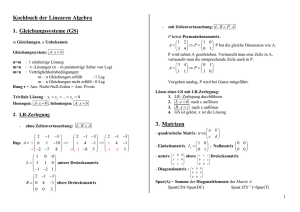

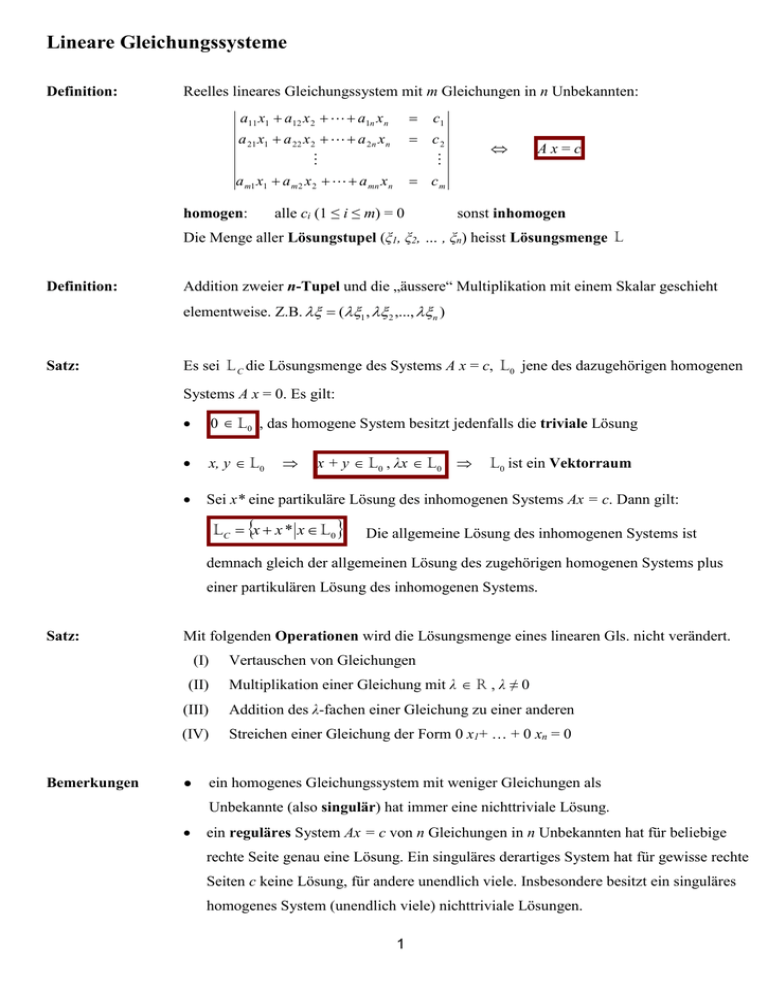

Lineare Gleichungssysteme

Definition:

Reelles lineares Gleichungssystem mit m Gleichungen in n Unbekannten:

a11 x1 a12 x 2 a1n x n

a 21 x1 a 22 x 2 a 2 n x n

a m1 x1 a m 2 x 2 a mn x n

c2

cm

homogen:

c1

alle ci (1 ≤ i ≤ m) = 0

Ax=c

sonst inhomogen

Die Menge aller Lösungstupel (ξ1, ξ2, … , ξn) heisst Lösungsmenge L

Definition:

Addition zweier n-Tupel und die „äussere“ Multiplikation mit einem Skalar geschieht

elementweise. Z.B. (1 , 2 ,..., n )

Satz:

Es sei L C die Lösungsmenge des Systems A x = c, L 0 jene des dazugehörigen homogenen

Systems A x = 0. Es gilt:

0 L 0 , das homogene System besitzt jedenfalls die triviale Lösung

x, y L 0

Sei x* eine partikuläre Lösung des inhomogenen Systems Ax = c. Dann gilt:

x + y L 0 , λx L 0

L C x x * x L 0

L 0 ist ein Vektorraum

Die allgemeine Lösung des inhomogenen Systems ist

demnach gleich der allgemeinen Lösung des zugehörigen homogenen Systems plus

einer partikulären Lösung des inhomogenen Systems.

Satz:

Mit folgenden Operationen wird die Lösungsmenge eines linearen Gls. nicht verändert.

(I)

(II)

Bemerkungen

Vertauschen von Gleichungen

Multiplikation einer Gleichung mit λ R , λ ≠ 0

(III)

Addition des λ-fachen einer Gleichung zu einer anderen

(IV)

Streichen einer Gleichung der Form 0 x1+ … + 0 xn = 0

●

ein homogenes Gleichungssystem mit weniger Gleichungen als

Unbekannte (also singulär) hat immer eine nichttriviale Lösung.

ein reguläres System Ax = c von n Gleichungen in n Unbekannten hat für beliebige

rechte Seite genau eine Lösung. Ein singuläres derartiges System hat für gewisse rechte

Seiten c keine Lösung, für andere unendlich viele. Insbesondere besitzt ein singuläres

homogenes System (unendlich viele) nichttriviale Lösungen.

1

Beispiel:

Bestimme in Abhängigkeit des reellen Parameters

die Lösungsmenge des folgenden

reellen linearen Gls.

x1

2x 2

x1

3x 2

5x 2

2 x1 4 x 2

3x 4

1

x 3

(1 2 )x 3

x 4

0

5

(1 )x 3

(2 8 )x 4

…

2

1

0

0

0

2

0

1

0

4

2

3λ

3

λ

0

0 1 λ 4λ

0

0 1 λ

(1 )x 4 2 für 1: L

3 Fälle:

1

(1 )x 3 4x 4 4 für -1: L (1- 2x 2 x 4 , x 3 ,1 x 3 R

3

für -1,1 eindeutige Lösung, die aus dem GS abgelesen w erdenkann

■

Achtung: beim Umformen können zusätzliche Lösungen entstehen!!!

Matrizen

Definition:

Eine (m × n)-Matrix ist ein rechteckiges Zahlenschema folgender Art:

a11 a12

a

a 22

21

A

a i1 a i 2

a m1 a m 2

Definition:

Bezeichnungen

Definition:

a1k

a 2k

aik

a mk

a1n

a 2n

aik

ain

a mn

aik R

m,i

Zeilen

n, k

Spalten

Es seien A und B zwei Matrizen gleichen Formats m × n, λ R . So gilt:

Summe

A + B = [aik] + [bik] = [aik + bik]

Produkt

λ A = λ[aik] = [λ aik]

(n × n)-Matrix:

quadratische Matrix der Ordnung n

(1 × n)-Matrix:

Zeilenvektor → x’

(m × 1)-Matrix:

Kolonnenvektor → x

colk(A)

:= (a1k, a2k, … , amk)

rowi(A)

:= (ai1, ai2, … , ain)

elmik(A)

:= aik

Diagonalmatrix:

diag(λ1, λ2, ... , λn)

Einheitsmatrix:

diag(1, 1, …, 1) = I = [δik]

Nullmatrix:

[aik] = 0

Transposition:

R mn R nm

A AT

Spiegelung an der Hauptdiagonalen

Rechenregeln: AB B T AT

T

A B T

2

AT B T

δik = Kronecker-Delta

a ikT = aki

( 1 i n, 1 k m )

Definition:

Eine Matrix A (zwangsläufig (n × n)) heisst symmetrisch, falls gilt: A = A’

( Ax) y x ( Ay ) ist dazu äquivalent! (Skalarprodukte)

Definition:

Matrixmultiplikation

Sei

A = [aij] eine (m × p)-Matrix und

p: Spaltenzahl

B = [bjk] eine (p × n)-Matrix

p: Zeilenzahl

Das Produkt C = A·B ist definiert als die (m × n)-Matrix mit

n

cik : aij b jk = elmik(AB) = rowi(A) • colk(B)

j 1

Satz:

Matrix-Rechenregeln

AB C AB AC

ABC ABC Assoziativität

AB AB AB

AB 1 B1A 1

Bemerkungen:

I.A. ist AB ≠ BA

Beispiel:

Berechnung der Inversen:

2 1 1

A : 4 1 0

2 2 1

→

2 1 1

A 4 1 0

2 2 1

1 0 0

0 1 0

0 0 1

1 0 0 1/8 1/8 - 1/8

0 1 0 - 1/2 1/2 1/2

0 0 1 5/4 - 3/4 - 1/4

→

→

1/8 1/8 - 1/8

A1 - 1/2 1/2 1/2

5/4 - 3/4 - 1/4

Vektorräume

Definition:

Ein Vektorraum V über den Körper R ist eine nicht leere Menge von Elementen

{u, v, w, …} („Vektoren“), in der als Verknüpfungen eine Addition „ “ und eine skalare

Multiplitkation „ “ mit folgenden Eigenschaften definiert sind:

(I)

(II)

VR VC

Seien u, v V, dann ist u v wieder V

i.

u+v=v+u

ii.

u + (v + w) = (u + v) + w

iii.

ein eindeutig bestimmtes Element 0 V mit u + 0 = u. Nullelement!

iv.

zu jedem u V ein eindeutig bestimmtes (-u) V mit u + (-u) = 0

Sei u V und λ, μ R , dann ist λ u wieder V

v.

λ·(u + v) = λ·u + λ·v

vi.

(λ + μ) u = λ·u+ μ·v

vii.

(λ·μ) u = λ·(μ·u)

viii.

1·u = u

3

Linearkombinationen Unterräume

Definition

Ein Vektor x lässt sich aus gegebenen Vektoren a1, a2, …, aN eines Vektorraums V als

Linearkombination folgendermassen schreiben:

N

x : i ai 1a1 N a N

i R , x V

i 1

Definition:

Es sei V ein Vektorraum. eine nicht leere Untermenge W von V heisst Unterraum von V,

wenn sie bezüglich der in V erklärten Operationen abgeschlossen ist. D.h. für beliebige u, v

W und λ R stets gilt: u + v W und λ · u wieder W. Zudem muss ein

ausgezeichnetes Nullelement existieren. Jeder Unterraum ist für sich also wieder ein

Vektorraum

Definition:

Eine Familie von Vektoren (a1, a2, …, aN ) V bezeichnet man als Erzeugendensystem,

wenn sie V aufspannen. Man schreibt a1, a2 , , a N

Beispiel:

Es sei A eine (m × n)-Matrix. Die m Zeilenvektoren spannen einen UR Z (Zeilenraum von

A) von R n auf. Analog K (Kolonnenraum) UR von R m (dimK = dimZ = r)

Beispiel:

Welche der folgenden Teilmengen des VRs der reellen n x n Matrizen sind Unterräume?

Menge der symmetrischen Matrizen ( A AT )

(I)

0T 0

(II)

A B A T B T A BT

A B U

(III)

A A T A T A U

qed

0 U

qed

qed

ist Unterraum

Menge der invertierbaren Matrizen

(I)

0A A0 0

0 1 existiert

ist kein Unterraum

nicht

Menge der oberen Dreiecksmatrizen

Beispiel:

(I)

Bedingung: unterhalb der Hauptdiagonalen nur 0en O-Matrix U

(II)

A B U ,

(III)

A U ,

da bei der Addition immer „punktweise“ addiert wird

ist Unterraum

da „punktweise“ multipliziert wird

V: VR der n x n Matrizen,

sind

T

2

U1

A V A 2A , U2 A V A In

(I)

0T 0 2 0

(II)

A BT A T BT 2A 2B 2A B

0 U1

(III) α A T A T 2A 2 A

Unterräume?

qed

A U1

4

qed

A B U1

qed

U1

ist ein Unterraum von V

(I)

0 2 0 In

U2

ist kein Unterraum von V

5

Beispiel:

U1,U2

sind zwei Unterräume von V, zu zeigen:

U3 U1 U2

u, v U3

und

u, v U 2 u v U2

Beispiel:

u v U1 und U2

U1 U2

U3

u U1 und U2

U1 U2

U3

0 U1 und U2

U1 U2

U3

Die Unterräume

U1 :

U1, U2 des R 4

x1 x 4

U1 U2 :

,

x 2, x 3 , x 4

U und V sind UR von

U V

U V : u v u U, v V

■

, U x R

x 2 2x 3 x 4 0

2

4

x1 x 4

U1, U2 und U1 U2

R4 :

,

1

0

0

0

2

1

x1 x 3 x 4 x1, x 3 , x 4 R

0

1

0

0

1

0

frei wählbar

frei wählbar

x 2 2x 3 x 4 , x1 x 4

ges. Basis von

u U1

seien definiert durch U1 x R 4

x 2 2x 3 x 4 , x1, x 3 , x 4

U2 :

und

u U2

Bestimme die Basen von

Beispiel:

u, v U1 u v U1

ist ebenfalls Unterraum von V:

U1 U2

x3, x 4

0

0

1

0

0

1

x 2 x 3 x 4 x 2 , x 3 , x 4 R

0

1

0

0

1

0

U 1,1,2,1T , 0,0,2,1T

und Basis von

frei wählbar

,

0

1

1

2

x

x

x

,

x

R

3

4

3 4

0

1

1

0

V 1,3,2,3 T , 0,2,4,1T , 5,3,2,3 T

■

Basen!!

U V

Basis von V und solange Basisvektoren von U zufügen, wie die

Vektoren noch lin. unabh. sind 1,3,2,3T , 0,2,4,1T , 5,3,2,3T , 1,1,2,1T

U V : w w U w V

Aufgabe 2 Vordip.

■

Dimension und Rang

Definition:

ein r-Tupel (a1, a2, …, ar ) von Vektoren ak V heisst linear abhängig, wenn gilt:

(I)

(II)

Definition:

Ein ap ist Linearkombination der übrigen ak.

Es gibt Zahlen λk, nicht alle = 0 mit

r

k 1

k a k 0

(V)

ein r-Tupel (a1, a2, …, ar ) von Vektoren ak V heisst linear unabhängig, wenn gilt:

(I)

(II)

Kein ap ist Linearkombination der übrigen ak.

Aus

r

k 1

k a k 0

(V) folgt: alle λk= 0

6

Beispiel:

Zeige: Die 3 Vektoren

1

2

3

v1 2, v 2 1, v 3 0

1

3

5

sind linear unabhängig. Gebe eine Basis von

an und ergänze diese Basis zu einer Basis von

V : v1, v 2 , v 3

Gauss

1 2 3

0 1 2

0 0 0

Rang = 2

Basis für

R3 :

R3

1 0 0

2 , 1 , 0

3 2 1

■

Definition:

Eine Basis eines Vektorraums V ist ein linear unabhängiges Erzeugendensystem.

Satz:

Ist (b1, b2, …, bn) eine Basis von V, so lässt sich jeder Vektor x V so darstellen:

x 1b1 2 b2 ... n bn k 1 k bk Koeffizienten k eindeutig bestimmt.

n

Bemerkung:

Die „Koordinaten-“ Abbildung : V R n x (1 , 2 ,..., n ) ist ein Isomorphismus.

Theorem:

Jeder endlich erzeugbare VR besitzt eine Basis.

Theorem:

Alle Basen eines VRs bestehen aus gleichviel Vektoren: Dimension von V: dimV = n

Bemerkungen:

Jedes lin. unabh. System von Vektoren ak V lässt sich zu einer Basis von V erweitern.

Jedes endliche Erzeugendensystem eines VR V enthält eine Basis von V.

Weniger als n Vektoren bilden kein Erzeugendensystem

Mehr als n Vektoren sind linear abhängig.

Jedes Erzeugendensystem von n Vektoren ist eine Basis von V.

Beispiel:

Finde eine Basis für den Lösungsraum

x1 2x 2

3 x1 x 2

x1

Gauss

x 3

4x 3

3 x 4

x4

x3

x4

x 5

5x 5

0

0

x5

0

0

1 2 1 3 1

0 2 1 3 2

0 0

1 1 0

0 0 0 3 1

wähle

7

R 5 des

x5

folgenden GS

auflösen

L , , , , R ,

3 3 3

( dim L 1 )

Rang einer Matrix

Satz:

Der Zeilenraum Z einer Matrix A bleibt bei Zeilenoperationen unverändert.

Somit bilden die Nicht-Null-Zeilen der Zeilenstufenform von A eine Basis von Z

Satz:

dimZ = dimK = rang(A) (Zeilenrang = Spaltenrang = Rang der Matrix).

Erklärung:

Zeilenoperationen verändern Zeilenraum nicht: dimZ konstant.

BLATTER S71

Satz:

Hauptsatz über homogene Gleichungssysteme:

Sei A eine (m × n)-Matrix und L der

Lösungsraum des hom. Gls. Ax = 0. Dann gilt: dim L = n – rang(A)

Definition:

Bespiel:

Es sei A eine (n × n)-Matrix. Falls gilt

(I)

rang(A) = n

so nennt man A regulär

(II)

rang(A) < n

so nennt man A singulär

folgende Aussagen sind äquivalent:

(I)

A ist regulär

(II)

rang(A) = n

(III)

die Zeilen und Spalten sind linear unabhängig

(IV)

das lineare Gleichungssystem A x = 0 hat nur die triviale Lösung

(V)

(VI)

Zu A existiert eine eindeutig bestimmte (n × n)-Matrix B mit AB = I = BA.

A ist die Matrix eines Basiswechsels in einem n-dimensionalen VR.

Bemerkung:

AB = I = BA gilt!!! Mit dem Begriff der Inversen kann man dies verinnerlichen.

Satz:

rang(A) ist gleich der Ordnung der grössten regulären (quadrat.) Teilmatrix von A

Koordinatentransformationen (KT)

Begriffe:

Koordinaten eines Punktes P E (eukl. Erfahrungsraum) werden als n-Tupel (x1, x2, … , xn)

zusammengefasst. Bijektive Beziehung: E R n

Definition:

Standardbasis des R n : ei := (0, … , 0, 1, 0, … ,0) (1 ≤ i ≤ n)

n

x = (x1, x2, … , xn) = cik : xi e i

j 1

8

Definition:

Die Transformationsmatrix T fasst alle neuen Vektoren geschrieben in den alten

Koordinaten zusammen. Konstruktion: In den Kolonnen von T notiert man die alten

Koordinaten der neuen Basisvektoren.

Satz

Seien x und x dieselben Vektoren, x hat die „alten“, x die neuen Koordinaten: Es gilt:

x Tx bzw. x T 1 x

Bemerkungen

●

Eine KT ist zulässig, wenn alte und neue Basisvektoren denselben Raum aufspannen.

Dann ist die Inverse T 1 wohlbestimmt.

Definition:

zulässige Basistransformationen sind umkehrbar:

T 1 T = I = T T 1

orthogonal:

heissen zwei Vektoren x, y V, falls gilt: x • y = 0.

orthonormal

heissen zwei Vektoren, wenn gilt: x y 1 und x • y = 0

heisst eine Basis (e1 ,..., en ) , wenn gilt: ei • ek = δik

(Kronecker-Delta)

Definition:

Matrizen heissen orthogonal, falls gilt: T T T I bzw. T 1 = T T

Satz:

Sind alte und neue Basis orthormal, so ist die Transformationsmatrix T orthogonal, und

umgekehrt.

Lineare Abbildungen

Definition:

Es seien V, W zwei Vektorräume. Eine Abbildung f: V → W heisst linear, falls gilt:

(I)

(II)

Definition:

A( x y ) A( x ) A( y ) für alle x, y V

A(x ) A( x ) x V, F

Eine Lineare Abbildung von einem VR V in einen anderen W hat folgende Struktur:

A : V W , x Ax

Bemerkung

Die VR V und W sind genau dann isomorph zueinander, wenn gilt: dimV = dimW .

Begriffe

lineares Funktional: Abbildung mit Bild im Grundkörper R

9

Definition:

Die Matrix A einer Abbildung enthält alle Information über die Abbildung. Dabei stehen in

den Kolonnen von A die Bilder der Basisvektoren (ausgedrückt in den Koordinaten der

neuen Basisvektoren).

a1k

a

m

Ae k a ik f i 2 k VERGLEICHE BLATTER S88

i 1

a mk

Satz:

Jeder Vektor x V mit den Koordinaten (x1, x2, …, xn) bezüglich einer Basis (e1, … , en) lässt

sich mit der Matrix A in W abbilden. Es ergibt sich für das Bild von x neue Koordinaten (y1,

y2, … , ym) bezüglich einer Basis (f1, f2, …, fm) von W. Es gilt:

y1 a11

y a

2 21

y m a m1

Beispiel:

a12

a 22

a m2

allgemeine axionometrische Abbildungen

Satz von Pohlke

Beispiel:

a1n x1

a 2n x 2

oder kurz als y = A x

a mn x n

BALTTER S 99

Für einen festen Vektor a R 3 definieren wir die Abbildung f a R3 R3 durch f a ( x) : a x

(Vektorprodukt). Wie lautet die Matrix von f a bezüglich der Standardbasis?

Beispiel:

?

x1 a2 x3 a3 x2

0

x

a

x

a

x

2 3 1 1 3

a3

x a x a x

a

2 1

3 1 2

2

a3

0

a1

Welche der folgenden Abb. sind linear?

a2

a1

0

■

f1x, y x 2 , 3 y , f2 x, y x 5 y, x y

f1x1 x 2 , y1 y 2 x1 x 2 2 , 3y1 y 2 f1( x1, y1) f1x 2 , y 2 x1 x 2 4 , 3y1 y 2

nicht linear

f2 x1 x 2 , y1 y 2 x1 x 2 5y1 5 y 2 , x1 x 2 y1 y 2 x1 5 y1 , x1 y1 x 2 5 y 2 , x 2 y 2 f1( x1, y1) f1x 2 , y 2

f2 cx , cy c x 5y , c x y c x 5y , x y c f2

Beispiel:

linear ■

x1

x1

2

1

lineare Abbildung s : R R sei gegeben durch s : x2 x2 (2 x1 x2 x3 ) 1 .

3

x3

x3

1

3

3

Ebene E R3 : x1 x2 x3 0 . Zeige: s( E ) E , Einschränkung: s | E : E E

x1 x2 x3 x1 4 x1 2 x2 2 x2 2 x3 x2 ... x1 x2 x3 selbe Ebene ■

3

3

3

3

Bestimme ( s | E ) 2 s | E s | E

(s | E) 2 s | E s | E s | E ( E E) E E E E E

10

■

Beispiel:

Für einen festen Vektor a R 3 ist die Abbildung f a R3 R3 durch f a ( x) : a x definiert.

Zeige: f a ist linear.

Beispiel:

f a ( x ) f a ( y) a x a y a ( x y)

f a ( x y) a ( x y)

dasselbe

f a ( x ) a ( x ) ( a x )

f a ( x ) (a x )

dasselbe

■

A :lineare Selbstabbildung von R 2 . Zeige: Bildet A eine fixierte Gerade l in sich ab, so

bildet A jede parallele G. in eine Parallele von l ab. l : y mx q A(mx q ) mx q linear!

l : A(mx q ) A(mx ) A(q ) m A( x ) A(q ) m x q da : A( x ) x , A(q ) q

g : A(mx p) A(mx ) A( p) m A( x ) A( p) m x ~

p da : A( x ) x , A(q ) ~

p

gleiche Steigung, verschiedener Achsenabschnitt parallele Geraden

Satz:

■

Es seien A : X Y und B : Y Z zwei lineare Abbildungen. Ihre Zusammensetzung

B A : X Z , x z : BAx ist als Produkt BA der Abbildungsmatrizen definiert.

Bemerkungen:

Abbildungsmatrix A ist basisabhängig: abhängig von den in V und in W gewählten Basen.

Sie ist somit auch von Koordinatentransformationen abhängig.

Suche nach möglichst einfachen Abbildungsmatrizen: die Diagonalform haben.

In Abbildungen A : V V will man sich auf nur eine Basis beschränken.

In Abbildungen A : V W (V ≠ W) lassen voneinander unabhängige Basen definieren.

Definition:

Ist A : V W eine lineare Abbildung, seien x V, y W. So heisst die Menge der

Vektoren x V, die von A in 0 überführt werden, Kern von A:

ker A : {x V Ax 0}

Vektoren y W, die als Werte von Ax tatsächl. angenommen werden, Bildraum von A:

im A : {Ax x V }

Satz:

V

W

kerA ist ein Unterraum von V, imA ist ein Unterraum von W

A ist genau dann injektiv, wenn gilt: ker A ={0}

Definition:

Sei dimV = n, dimW = m. Der Bildraum imA W besitzt dann eine wohlbestimmte

Dimension ≤ m. Dies ist der Rang der Abbildung A: rang (A).

Satz:

Der Rang der linearen Abbildung A : V W ist gleich dem Rang der Matrix von A

bezüglich irgendwelcher Basen in V und in W. rang(A) ist basisunabhängig

11

Satz:

Fundamentalsatz über lineare Abbildungen: Es sei A : V W eine lineare Abbildung

zwischen endlichdimensionalen VR. Dann gilt rang A dim(ker A) dim V

Beweis:

Der Unterraum kerA V ist der Lösungsraum L des homogenen Gls Ax = 0.

Dort gilt dim L = n – r…

Definition:

Seien A : V V , A : R n R n , also Abbildungen von R n in sich selber. Derartige

Abbildungen heissen regulär, falls sie den Rang n besitzen, sonst singulär.

Bemerkung:

Der Bildraum imA einer singulären Abbildung hat eine Dimension < n und ist somit ein

echter Teilraum von V. Eine singuläre Abbildung ist also nicht surjektiv.

Der Kern einer singulären Abbildung hat eine Dimension > 0 (vgl. Fundamentalsatz…).

Eine singuläre Abbildung ist somit auch nicht injektiv.

Bemerkung:

Unterschied zwischen Abbildungen A : V V und A : V W mit dimV = dimW: man wählt

im ersten Fall eine Basis, im zweiten zwei Basen.

Satz:

Eine reguläre lineare Abbildung A : V V ist bijektiv und besitzt eine wohlbestimmte

Umkehrabbildung (Inverse) A 1 : V V , A-1 ist ebenfalls linear und regulär.

Satz:

Eine reguläre Matrix A R nn besitzt eine wohlbestimmte Inverse A-1 R nn

Satz:

Es sei A : V V , x Ax eine (reguläre) lineare Abbildung bezüglich einer bestimmten

Ausgangsbasis (e1 ,..., en ) . Zusätzlich sei eine zweite Basis (e1 ,..., en ) gegeben.

Dann gilt: Bei einem Basiswechsel erhält eine lineare Abbildung A : V V die neue Matrix

A T 1 AT

Satz:

T

(für orthogonale Abbildungsmatrizen A: A T AT )

Eine lineare Abbildung A : V V besitzt eine basisunabhängige Determinante:

det A : det[aik ] , insbesondere gilt: det A = 0 A singulär

12

Determinanten:

Beispiele:

Anwendungen:

Determinante als Testgrösse für quadratische Matrizen: det A = 0 A singulär

Determinante als Volumen eines n-dimensionalen Parallelepipeds. Sie stellt die

Volumendilatation dar… (VERGLEICHE BLATTER SEITE 103)

Definition:

Determinante als Abbildung mit gew. Eigenschaften: det: R nn R A det A

Die Determinante ist eine wohlbestimmte Funktion det: R nn R A det A mit

folgenden Eigenschaften

(I)

Entsteht Aflip aus A durch Vertauschung von wie Zeilen oder Kolonnen, so gilt:

det( A flip ) det A

Insbesondere: Hat A zwei gleiche Zeilen, Kolonnen, so ist det A = 0

(II)

Die Determinante ist eine lineare Funktion jeder einzelnen Zeile, Kolonne:

detA x y detA x detA y und detA x detA x

Insbesondere: det A 0 0

(III)

Es gilt der Multipliationssatz:

Insbesondere: det A 1

(IV)

det( A B ) det( A) det( B )

1

und det I 1

det A

Hat die Matrix A die Kästchenform mit quadratischen Teilmatrizen A1,…,An

so gilt: det( A) det( A1 ) det( A2 ) ... det( An )

(V)

Die Determinante bleibt bei Transposition ungeändert:

det AT det A

Satz:

Zeilen- bzw. Kolonnenoperationen (III) ändern den Wert der Determinante nicht.

Satz:

Die Determinante einer Dreiecksmatrix A R nn ist das Produkt der Diagonalenelemente.

Satz:

det A = 0 A singulär

Satz:

Der Rang einer (m × n)-Matrix B ist gleich der Ordnung der grössten nichtverschwindenden Unterdeterminanten (Minor) von B

Definition:

Als Kofaktor von aik in der Determinante bezeichnet man den mit einem Vorzeichen

versehene Minor des Elements aik:

Aik : (1) i k det[ A]iˆkˆ (^ steht für Unterdrückung)

13

Satz:

Satz:

Es gilt für jedes feste i:

det A k 1 aik Aik ai1 Ai1 ai 2 Ai 2 ... ain Ain

und für jedes feste k:

det A i 1 aik Aik a1k A1k a 2k A2k ... a nk Ank

n

~

Es sei A [ Aik ] die Matrix der Kofaktoren der regulären Matrix A R nn . Dann gilt:

A 1

Satz:

n

1 ~T

A

det A

Die Determinante einer Matrix A R nn ist eine „alternierende“ summe von n! Termen,

und zwar der sämtlichen möglichen Produkte von n Matrixelementen, keine zwei davon au

derselben Zeile oder derselben Kolonne.

Beispiel:

Eine spezielle Determinante: die Vandermondesche Determinante.

1

1

V (1 , 2 ,..., n ) : det 12

1n 1

Beispiel:

1

2

22

1

n 1

2

1

n

n2 ( j i )

i j

nn1

Zeige, dass für eine schiefsymmetrische ( AT A ) n × n - Matrix gilt: det A (1)n det A

det(A) det(AT ) (1) n det(AT ) (1) n det(A)

für n ungerade: det(A) -det(A) det(A) 0

■

Zeige, dass für eine orthogonale ( AT A I ) nxn-Matrix gilt: det( A ) 1

det(A AT ) det(A) det(AT ) det(A) det(A) (det(A)) 2

det(I) det(A 1 A) det(A 1 ) det(A) det(A) det(A) (det(A)) 2

det(I) 1 (det(A)) 2

det(A) 1 1

■

Eigenwerte und Eigenvektoren

Definition

Ein Vektor e ≠ 0, für den A e = λ e mit einem geeigneten λ R (bzw. λ c ) zutrifft, heisst

ein Eigenvektor der Abbildung A. Die betreffende Zahl λ heisst der zugehörige Eigenwert

von A.

Bemerkung

VERGLEICHE BLATTER SEITE 106

Bemerkung:

E : {x V Ax x} , also die Menge aller Eigenvektoren einer Matrix A sowie dem

Nullvektor, ist ein Unterraum von V: Eλ stellt nämlich den Kern der Abbildung A – λ I dar.

14

Bemerkung

Man betrachte das System (A - λ I ) x = 0. (A sei eine quadratische Matrix) So hat man

folgende Alternativen:

(I)

(A - λ I) ist regulär. Das System (A - λ I) x = 0 besitz dann nur die triviale Lösung Eλ =

{0}. Somit findet man in diesem Fall keinen Eigenvektor.

(II)

(A - λ I) ist singulär. Das System (A - λ I) x = 0 besitz dann nichttriviale Lösungen. Es

ist dim Eλ > 0, und Eλ V ist der zugehörige Eigenraum. Das System (A - λ I) x = 0

ist genau dann singulär, wenn seine Determinante verschwindet: det (A - λ I) = 0

Definition:

det (A - λ I) = 0 ergibt ein Polynom mit λ als Variable und vom genauen Grad n mit reellen

Koeffizienten, genannt charakteristische Polynom chp(λ) = 0. Die Lösungen dieser

Gleichungen sind die Eigenwerte λi (1 ≤ i ≤ n). Die zugehörigen Eigenvektoren eλ erhält

man als Lösung des Systems (A - λ I ) x = 0

Bemerkung:

Es sind auch komplexe Eigenwerte möglich.

Satz:

Zu verschiedenen Eigenwerten gehörende Eigenvektoren sind linear unabhängig.

Satz:

Diagonalisierbarkeit. Ist A : V V eine lineare Abbildung mit dimV = n

verschiedene(!!!) reellen Eigenwerten λj (1 ≤ j ≤ r), so lässt sich A diagonalisieren, das

heisst, es gibt eine Basis (e1 ,..., e n ) von V mit A diag( 1 , 2 ,..., n ) .

Bemerkungen:

chp(λ) = 0 ist vom genauen Grad n und besitzt nach dem Fundamentalsatz der Algebra

genau n Lösungen λj c (1 ≤ j ≤ n), mehrfache mehrfach gezählt.

Diagonalisierbarkeit gewährleistet i. A., auch bei komplexen Eigenwerten.

Definition:

Eine Abbildung ist symmetrisch, falls für Abbildungsmatrix A R nn gilt: A AT

Satz:

Ist A R nn eine symmetrische Matrix mit Eigenwerten 1 , 2 ,..., n , so gilt:

(I)

(II)

Alle Eigenwerte sind reell

Eigenvektoren, die zu verschiedenen Eigenwerten gehören, stehen aufeinander

senkrecht.

Bemerkungen

(III)

Es gibt eine orthonormale Basis (e1 ,..., e n ) von R n mit A diag( 1 , 2 ,..., n )

(IV)

Es gibt eine orthogonale Matrix T mit A T diag( 1 , 2 ,..., n )T T

BLATTER SEITE 113

15

Gram-Schmidt-Verfahren

Systeme von linearen Differentialgleichungen

Definition:

Es sei A R nn (bzw c nn ) eine fest vorgegebene Matrix. Dann heisst

x1

x 2

x n

a11 x1 a12 x 2 a1n x n

a 21 x1 a 22 x 2 a 2 n x n

, kondensiert: x Ax

a n1 x1 a n 2 x 2 a nn x n

ein System von n linearen homogenen Differentialgleichungen erster Ordnung mit

konstanten Koeffizienten. Eine vektorwertige Funktion x(t ) x1 (t ), , x n (t ) ist eine

Lösung dieses Systems, falls x (t ) Ax(t ) , t R , gilt.

Bemerkungen:

Die Lösungen bilden einen VR L von vektorwertigen Fkt.: L C ( R, R n ) . Zu jedem

Anfangsvektor x 0 R n (bzw. x 0 C n ) gibt es genau eine Lösung x () L mit x( 0 ) x0

Für eine vollständige explizite Beschreibung von L sind n linear unabhängige

Lösungsfunktionen nötig.

Satz:

Ist v ( v1 ,, v n ) ein Eigenvektor der Matrix A zum Eigenwert λ, so ist die Funktion

x(t ) e t v eine Lösung von x Ax , und zwar die Lösung mit dem Anfangsvektor

x( 0 ) v (Beweis durch Einsetzen).

Satz:

Die Matrix A R nn besitze n linear unabhängige Eigenvektoren v (1) ,, v ( n ) zu (nicht

notwendigerweise verschiedenen) Eigenwerten 1 , 2 ,..., n . Dann ist die allgemeine Lösung

von x Ax gegeben durch x(t ) C1e 1t v (1) C n e n t v ( n ) x(t ) C j e t v ( j )

n

j

j 1

mit beliebigen reellen (komplexen) Koeffizienten Cj (1 ≤ j ≤ n) und Anfangsbedingung

n

x 0 C j v ( j ) Gleichungssystem…

j 1

16

Quadratische Formen, Hauptachsentransformationen

Definition:

Ein homogenes Polynom q(·)zweiten Grandes in den jeweiligen Koordinatenvariablen (z.B.

x, y, … oder x1, …, xn) heisst eine quadratische Form: q () : R n R

Satz:

Eine quadratische Form lässt sich folgenderweise notieren:

q ( x ) x T Qx , dabei ist Q [qik ] eine symmetrische Matrix, für Einträge gilt:

q Koeffizien t vor reinqu adratische n Termen x i 2 falls i k

q ik ik

q ik Koeffizien t (1/2) vor gemischten Termen x i x k falls i k

Definition:

Die quadratische Form heisst

(I)

(II)

(III)

Bemerkung:

positiv (negativ) definit,

wenn gilt: q(x) > 0

(<0)

x 0

positiv (negativ) semidefinit,

wenn gilt: q(x) ≥ 0

(≤0)

x

indefinit

wenn q(x) Werte < und > 0 annimmt

Als Funktion q () : R n R ist eine gegebene quadratische Funktion wohlbestimmt.

Die Funktion ist aber koordinatenabhängig!

Satz:

q () : R n R ist koordinatenabhängig! Bei Koordinatentransformation verändert sich die

symm. (!) Matrix Q auf charakteristische Weise: Q T T QT . T ist Transformationsmatrix

„alte Basis neue Basis“. Beweis: q ( x) x T Qx (Tx )T QTx x T T T QTx x T Q x

Satz:

Trägheitssatz. Jede quadratische Form lässt sich in geeigneten (schiefwinkligen)

Koordinaten ( x1 ,..., xn ) auf die Normalform q ( x ) x12 ... x r2 x r21 ... x r2 s bringen.

Definition:

Man bezeichnet

r+s

als Rang

r–s

als Signatur

Satz:

Die Matrix Q [qik ] ist symmetrisch. Es gilt daher: T T QT diag( 1 , 2 ,..., n )

Satz:

Hauptachsentransformation. Es sei eine reelle quadratische Form gegeben. Weiter seien

1 , 2 ,..., n die Eigenwerte von Q [qik ] und (e1 ,..., e n ) eine zugehörige orthonormierte

Basis von Eigenvektoren. Dann besitz q () : R n R in den neuen Koordinaten ( x1 ,..., xn ) die

Gestalt q ( x ) 1 x12 2 x r2 ... n x n2

17

Unitäre Räume

Definition:

natürliches Skalarprodukt: x y : x1 y1 x2 y2 ... xn yn k 1 xk yk

Definition:

Gilt x y 0 , so heissen x und y zueinander orthogonal.

n

Der absolute Betrag oder die Norm versteht man unter x :

x x k 1 xk yk k 1 xk

n

Satz:

Definition:

n

2

xx

ACHTUNG: komplexe Zahlen und Rechenregeln!!

xyz xy xz

xy yx

x y x y

C

x y x y

x x 0 ( x 0)

Ein endlich- oder unendlichdimensionaler komplexer Vektorraum V mit einem

Skalarprodukt : V V C , das letzterem Satz genügt, heisst ein unitärer Raum.

Satz:

Jeder endlichdimensionale unitäre Raum V besitzt orthonormale Basen. Sind (x1, x2, …, xn)

zu einer orthonormalen Basis gehörige Koordinaten, so erscheint V als Standardmodell

C n mit Skalarprodukt definiert wie oben.

Definition:

Eine Abbildung A : V V von unitären Vektorräumen bezüglich einer orthonormalen Basis

und der dazugehörigen Matrix A nennt man linearer Operator, speziell wenn man damit

Eigenschaften zur Erkennung bringen will.

Definition:

Es gibt zu A in der Menge der Operatoren ein „Spieglbild“, den sogenanten adjungierten

Operator A*: A * x y x Ay ( x, y V )

Satz:

Definition:

Sei A ein linearer Operator und A* sein adjungiertes Komplement. Dann gilt:

elm ik(A*) elm ki (A)

transponiert und komplex konjugiert

(A)* A *

( AB)* B * A *

A ** A

Sei eine (n × n)-Matrix A ein linearer Operator und A* sein adjungiertes Komplement.

Dann heisst A, wenn folgendes gilt:

(I)

(II)

(III)

selbstadjungiert, falls A = A* ( Ax y x Ay )

unitär, falls A*A = AA* = I

normal, falls A*A = AA*

18

Bemerkungen:

In der Praxis treten selbstadjungierte Operatoren am häufigsten auf.

Unitäre Operatoren lassen Abstände invariant: Für alle x, y V gilt:

Tx Ty T * Tx y x y . „Drehung“. Alle unitären Operatoren sind normal!

Satz:

Es sei V ein unitärer Raum und A : V V ein normaler Operator. Dann gilt:

(I)

Ae e A * e e , d.h. A und A* besitzen dieselben Eigenvektoren.

(II)

Ist e ein Eigenvektor von A, so ist dessen orthogonales Komplement U ein

invarianter Unterraum von A

(III)

Zu verschiedenen Eigenwerten gehörende Eigenvektoren stehen aufeinander

senkrecht

Bemerkung:

Orthogonales Komplement: S V , 0 für alle S. Eigenschaften:

S ist ein Unterraum von V.

S S 0

S S

S S

Bemerkung:

wichtig:

U

U

dim U dim V dim U V ist endlich

* , , V

Adjungierte Abbildungen: Funktional:

adjungierte Abbildung

f * : V V zu f : V V

ist lin. Abb.

ist definiert durch: f , , f * , V

Selbstadjungiert: f = f *.

lineare Selbstabbildung:

Beispiel:

geg.:

f:V→V

f x1, x 2, x3 x1 x 2,x1 x 2 2x3 , x 2 x3

ges.: adjungierte Abbildung

setze:

ker f * = (im f ); rang f = rang f *.

x1, x 2, x3

und

f* : R3 R3

y1, y 2, y3

f , x1 x2 y1 x1 x2 2x3 y2 x2 x3 y3 x1y1 y2 x2 y1 y2 y3 x3 2y2 y3

Satz:

f * y1, y 2, y3 y1 y 2,y1 y 2 y3 ,2y 2 y3

Spektralsatz 1. Es sei V ein endlichdimensionaler unitärer Raum und A : V V ein

selbstadjungierter Operator. Dann gilt:

(I)

(II)

Alle Eigenwerte λj von A sind reell.

Es gibt eine orthonormale Basis von V, die A diagonalisiert: Bezüglich dieser Basis

besitzt A die Matrix A diag (1 , 2 ,..., n )

19

Satz:

Spektralsatz 2. Es sei A eine selbstadjungierte (n × n)-Matrix. Dann gilt

(I)

(II)

Satz:

Alle Eigenwerte λj von A sind reell.

Es gibt eine unitäre (n × n)-Matrix T mit A T diag (1 , 2 ,..., n ) T *

Spektralsatz 3. Es sei V ein endlichdimensionaler unitärer Raum und T : V V ein

unitärer Operator. Dann gilt:

(I)

(II)

Alle Eigenwerte λj von T besitzen den Betrag 1:

j e i (i ≤ j ≤ n)

j

Es gibt eine orthonormale Basis von V, die T diagonalisiert. Bezüglich dieser Basis

besitzt T die Matrix T diag (e i1 , e i 2 ,..., e in )

Anhang

Fibonacci:

explizit:

rekursiv:

Lineare Gls.:

1 5 n 1 5 n

2n 5

n 1

0 1

An B 1

B ,

0

( 2n 1)

wobei

1

1 5

1 5

, 2

,B

2

2

Gegeben sei eine A a jk = reelle 7x4-Matrix,

und das dazugehörige lineares Gls:

1 1 1

1

, (B

1

2

2 1

2 1

)

1 1

a11x1 a12 x2 a13 x3 a14 x4 0

a21x1 a22 x2 a23 x3 a24 x4 0

a31x1 a32 x2 a33 x3 a34 x4 0

a41x1 a42 x2 a43 x3 a44 x4 1

a51x1 a52 x2 a53 x3 a54 x4 0

a61x1 a62 x2 a63 x3 a64 x4 0

a71x1 a72 x2 a73 x3 a74 x4 0

Aussagen

richtig falsch

Die Lm. Ist eine Teilmenge des R 7

Die Lm. Ist eine Teilmenge des R 4

Ein derartiges System kann unendlich viele Lös. haben.

Ein derartiges System kann genau eine Lös. haben.

Es gibt jedenfalls die tr. Lös.

Die Lm. Ist ein VR.

Es gibt jedenfalls dann eine Lös., wenn die rechte Seite im Kolonnenraum von A liegt.

Wenn die augmentierte Matrix den Rang 5 hat, so gibt es eine Lös.

Falls die Lm. Nicht leer ist, so ist die Menge der Differenzen von je 2 Lös. ein VR.

Das arithmetische Mittel von 2 Lösungen ist wieder eine Lösung.

Werden die letzten 3 Gl. gestrichen, so besitzt das Restsystem jedenfalls eine Lös.

Werden die letzten 4 Gl. Gestrichen, so besitzt das Restsystem nichttr. Lös.

20