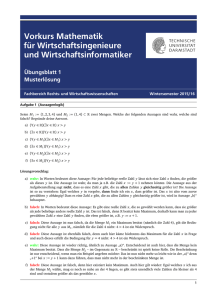

Kochbuch der Linearen Algebra

Werbung

Kochbuch der Linearen Algebra

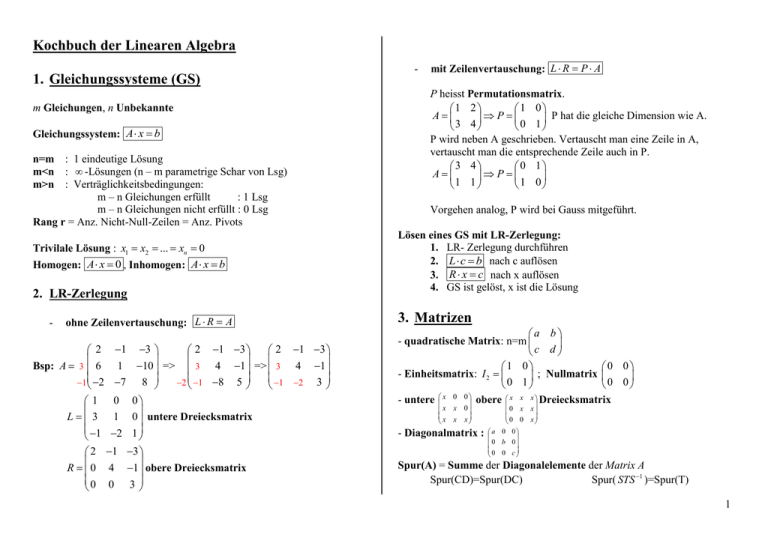

1. Gleichungssysteme (GS)

m Gleichungen, n Unbekannte

Gleichungssystem: A x b

n=m : 1 eindeutige Lösung

m<n : -Lösungen (n – m parametrige Schar von Lsg)

m>n : Verträglichkeitsbedingungen:

m – n Gleichungen erfüllt

: 1 Lsg

m – n Gleichungen nicht erfüllt : 0 Lsg

Rang r = Anz. Nicht-Null-Zeilen = Anz. Pivots

Trivilale Lösung : x1 x2 ... xn 0

Homogen: A x 0 , Inhomogen: A x b

2. LR-Zerlegung

-

ohne Zeilenvertauschung: L R A

3

2 1 3

2 1 3

=>

=>

1 10

3 4 1

3 4 1

1 2 3

7 8

2 1 8 5

0 0

1 0 untere Dreiecksmatrix

2 1

2 1 3

R 0 4 1 obere Dreiecksmatrix

0 0 3

2

Bsp: A 3 6

1 2

1

L 3

1

1

-

mit Zeilenvertauschung: L R P A

P heisst Permutationsmatrix.

1 2

1 0

A

P

P hat die gleiche Dimension wie A.

3 4

0 1

P wird neben A geschrieben. Vertauscht man eine Zeile in A,

vertauscht man die entsprechende Zeile auch in P.

3 4

0 1

A

P

1 1

1 0

Vorgehen analog, P wird bei Gauss mitgeführt.

Lösen eines GS mit LR-Zerlegung:

1. LR- Zerlegung durchführen

2. L c b nach c auflösen

3. R x c nach x auflösen

4. GS ist gelöst, x ist die Lösung

3. Matrizen

a b

- quadratische Matrix: n=m

c d

1 0

- Einheitsmatrix: I 2

; Nullmatrix

0 1

- untere

x 0 0

x x 0

x x x

x x

0 x x

0 0 x

a

0

0

0 b 0

0 0 c

obere

- Diagonalmatrix :

0 0

0 0

x Dreiecksmatrix

Spur(A) = Summe der Diagonalelemente der Matrix A

Spur(CD)=Spur(DC)

Spur( STS 1 )=Spur(T)

1

Spur( A )= Spur(A)

Spur( A )=Spur( AT )

Spur(A+B)=Spur(A)+Spur(B)

A m n

Transponierte Matrix: T

A nm

i) ( AT )T A

ii) ( A B)T AT BT

iii) ( AB)T BT AT !!

-

schiefsymmetrisch: A AT

A1 AT

regular <=> invertiertbar, r=m, Det(A) 0

Gegeteil: singulär

A B orthogonal & invertierbar

A1 orthogonal

I n orthogonal

4. Matrix-Multiplikation

A (m n) , B (n p) => (m n) (n p) (m p)

A B nur wenn #Spalten(A) = #Zeilen(B)

1 2 5 6 1 5 2 7 22

Bsp:

50

3 4 7 8 43

5. Matrix-Addition

A B nur wenn beide (m n)

a ( j ) A e( j ) e( j ) =Einheitsvektor j

kommutativ: A B B A ABER: ( A B) ( B A) !!!

Gauss: Elementare Operationen:

- Vertauschen von Zeilen

- System mit skalar multiplizieren

- Subtraktion eines Vielfachen der i-ten von der j-ten Zeile

AT A I n

A, B orthogonal & invertierbar

1 2 5 6 1 5 8

3 4 7 8 10 12

Rechenregeln

- assoziativ: ( AB)C A( BC ) ; ( A B) C A ( B C )

a b a b

- Multiplikation mit Skalar:

c d c d

symmetrisch: A AT

ortogonal:

Bsp:

6. Inverse einer Matrix

A1 heisst Inverse von A

Berechnung:

I) A | I n I n | A1

Auf beiden Seiten Vielfache von einer Zeile von einer anderen

subtrahieren, addieren, oder Zeilen vertauschen, etc bis links die

Einheitsmatrix steht und rechts die Inverse.

II) Gausselimination parallel zu den drei rechten Seiten der

Einheitsmatrix

1 2 3 1 0 0

Bsp: A 4 5 6 0 1 0 =>3 Lösungsvektoren => A1

7 8 11 0 0 1

III) Für 2x2 Matrizen:

a b

A

c d

A1

1 d b

ad bc c a

2

-

Regeln:

V= #Vertauschungen

Zeilen-/Spaltenvertauschung ändert Vorzeichen: (1)V

Gauss-Elimination ändert det(A) nicht (wenn keine Vertausch.)

det AT det A

-

det A V det A

-

det A B det A det B

Regeln:

1

- A A I n AA

1

- A1 A

- I n 1 I n

1

- AB B A

1

1

1

- AT A1

1

6.3.

T

-

A heisst invertierbar zug. Hom. GS hat nur Nulllösung

A2 0

det( A) 0

det I n 1 det A det A1 det AA1

-

det A1 det A

Determinante

-

A heisst lin.unabhängig <=> det A 0

-

A B

det

det A det C

0 C

det( A) A

N=2:

a b

A

c d

1

=> det( A) ad bc

n

c1

c2 Entwicklung nach der 1. Spalte

c3

b c

b c

b

det( A) a1 det 2 2 a2 det 1 1 a3 det 1

b2

b3 c3

b3 c3

Analog Entwicklung nach anderen Zeile oder Spalte

Determinante einer Dreiecksmatrix:

n

det( A) aii

i 1

A,B,C Matrizen

7. Vektorräume

n

N=3,… :

a1 b1

A a2 b2

a b

3 3

1

det A

c1

c2

Reeller Vektorraum der Dimension n

Komplexer Vektorraum

Ein reeller (komplexer) Vektorraum ist eine Menge von V Elemente

(z.B. Vektoren, oder Polynomen) mit der Eigenschaft:

- Addition: a, b V ist auch (a b) V

- Multiplikation: (od . ) gilt: a V ist auch a V

- Nullelement: ist in jedem Vektorraum vorhanden

Regeln:

- a b ba

- (a b) c a (b c)

- Neutralelement: a 0 a und 1a a

- Entgegengesetzter Vektor zu a: a a (a) 0

- ( a) ( )a

- ( )a a a und (a b) a b

3

7.3.

Unterräume

Eine nicht-leere Teilmenge U eines Vektorraums V heisst Unterraum. Ein

Unterraum ist ein Vektorraum, d.h. es muss gelten:

- a, b U ( a b ) U

- a U , a U

- Nullvektor enthalten. Nullvektor bildet sich auf sich selber ab!

Bsp:

Basis finden für Unterraum

U = {x 4 | x 2 - 2x 3 + x 4 = 0}.

Basis: linear unabhängiges Erzeugendensystem (ohne abhängige

Vektoren). Alle Basen eines Vektorraums haben dieselbe Anz. Elemente

(=Dimension von V, dim V)

x1

x 3 -x 4

U =

4 |x1 , x 3 , x 4

x 3

x 4

( x1 ,..., x4 der Reihe nach 1 setzen und die anderen 0, Nullvektor kann kein

Basisvektor sein)

Es folgt, dass a(1), a(2), a(3) eine Basis von U bildet mit

1

0

0

0 (2) 2 (3) -1

(1)

,a =

,a =

Dimension = 3

a =

0

1

0

0

0

1

Konvention: dim(0) 0

8.

Linear unabhängige Vektoren können zu Basis erweitert werden!

Input: linear unabhängige Vektoren b(1) ,..., b( n ) , Ziel: b (i ) e(i ) , eine

orthonormale Basis

U span a (1) ,..., a ( k ) ist der von a (1) ,..., a ( k ) aufgespannte VR

Erzeugendensystem: V span a (1) ,..., a ( k ) falls a ( i ) ganzen VZ

aufspannen

Linear unabhängig:

- falls auf 1a (1) ... n a ( n ) 0 folgt, dass 1 ... n 0

- Rang A = Anz. Spalten = k

Test: Vektoren in Spalten schreiben -> Gauss-Elimination

falls Nullzeilen -> lin.abhängig.

Rang A = Anz. Unabh. Vektoren

Sei k die Anz. Vektoren, r der Rang der Matrix nach dem

Eliminationsverfahren und n die Dimension des VR, dann gilt:

- linear unabhängig, falls r = k.

- linear abhängig, falls r < k.

- erzeugend, falls r = n.

- Sie bilden also eine Basis für n , falls r = k = n.

Gram-Schmidt-Verfahren

b(1)

(Einheitsvektor)

b(1)

Schritt 1:

e(1)

Schritt 2:

c (2) b(2) e(1) , b(2) e(1) => e(2)

(3)

b

(3)

e ,b

(1)

(3)

e e ,b

(1)

(2)

(3)

c (2)

c (2)

e

Schritt 3:

c

Schritt k:

c ( k ) b( k ) e(i ) , b( k ) e( i ) => e( k )

k 1

i 0

(2)

=> e

(3)

c (3)

(3)

c

c(k )

c(k )

Orthonormal = Alle Vektoren stehen senkrecht aufeinander( x, y 0 )

und haben die Länge 1 ( x 1 )

4

9.

x

Norm (= Allgemeine Längenfunktion)

x, x

x 2 x12 ... xn 2

Norm ordnet jedem Vektor x V eine reelle Zahl x zu, s.d. gilt:

x 0.

- x V ,

Maximumsnorm:

x

max x1 , x2 ,..., xn

n

Allgemeine Norm auf

n

/

:

max f (t ) , t [a, b] max f (t ) , t [a, b]

1

Matrixnorm: A quadratisch:

1

A 2 max(eig ( A A)) ; A

min(eig ( A A))

T

2

n

: x, y xi yi

i 1

Linear im zweiten Faktor

x, y (1) y (2) x, y (1) x, y (2)

n

2

x p xi für p=2 euklidische Länge

i 0

für C [a, b] : f 0 max f (t ) , t [a, b]

T

1

x, y x , y

Symmetrie

x, y y, x

Positiv definit

x, x 0

2

min i

Linear im ersten Faktor (analog)

n

n

: x, y xi yi

i 1

analog

Symmetrie

y , x x, y

analog

Antilinear im ersten Faktor:

x, y x, y

1

11.

10.

Komplexes Skalarprodukt

x, x 0 x 0

A symmetrisch:

A 2 max i ; A1

=> 90 x, y 0

n

1

p

für C1 [a, b] : f

x, y V

orthogonal, falls: x, y 0

Reelles Skalarprodukt

x y x y Dreiecksungleichung

- x, y V :

x, y y , x

x 0x0

x x

:

2

x, y

Zwischenwinkel: arccos

x y

Länge eines Vektors (euklidische Länge):

- x V :

Schwarz’sche Ungleichung: x, y

Skalarprodukt

x y

In Ebene: 1 1 x, y x1 y1 x2 y 2

x2 y2

x, y

Cosinussatz: cos

x y

Fehlerrechung

Vorgehen:

1) Ax c identifizieren, c ist der Inputvektor

2) Ax c r aufstellen, r soll minimal werden

3) Normalgleichungen aufstellen:

AT Ax AT c

4) Gauss-Elimination und Auflösen nach x

5

Bsp: f(x) = ax + b => f(0) = b, f(1) = a + b, f(2) = 2a + b.

xi | 0........ 1....... 2

yi | 5.41 5.17 5.93

5.41 r1

0 1

5.41

a

a b 5.17 r2 1 1 5.17 r

b

2a b 5.93 r 3

2 1 :z 5.93

b

: A

:c

Normalgleichungen aufstellen, eliminieren, auflösen, fertig…

12.

Zusammengesetzte Abbildungen: T : V W , S : W U

x V , T ( x) W S (T ( x)) U

x

S (T ( x)) , V U

T ( x) Ax S ( y ) By

" S T B A " Mult. von Matrizen

invertierbare lineare Abbildungen:

V, W, Vektorräume. T : V W linear

T umkehrbar/invertierbar, wenn - y W

=> Umkehrabbildung y

V W n , T ( x) Ax

Skalarprodukt: (U , Ax) ( ATU , x) gilt nur für

n

n

Kern: Kern( A) x V n | Ax 0 Unterraum von V

T ( x), T ( x) x, x

orthogonal => längentreu

orthogonal = längentreu + winkeltreu

mit

Bild ( A) span a (1) ,..., a ( n )

Beziehungen:

- dim( Bild ( A)) Rang ( A)

- dim( Kern( A)) n Rang ( A)

-

heisst

n

- orthogonal, falls T ( x), T ( y ) x, y

T:

Bild ( A) y W m | x V

- längentreu, falls T ( x) x

Ax y Unterraum von W

mit y T ( x)

x (ordnet jedem y W ein x V zu)

Linear, wenn: - T ( x1 x2 ) T ( x1 ) T ( x2 )

- T ( x) T ( x)

Bild:

x V

- A regulär und T 1 ( x) A1 ( x)

Lineare Abbildungen

V,W Vektorräume

Abbildung V-> W: ordnet jedem Vektor x V einen Vektor T(x)->W zu

T : V W , x T ( x)

x, y

x

x Spezialfall von orth.

Abbildungsmatrix finden:

1) Basis wählen: e(1) , e(2) ,..., e( k )

2) Bilder der Basisvektoren berechnen: e(1) , e(2) ,..., e( k )

d.h. e(1) f (e(1) ),..., e( k ) f (e( k ) )

Rang ( AT ) Rang ( A)

dim( Bild ( A)) dim( Bild ( AT ))

dim( Bild ( A)) dim( Kern( A)) n dim(V n ) Dimensionsformel

Kern( A) 0 det 0 A invertiertbar A bijektiv

3) Koordinaten der Vektoren e(1) , e(2) ,..., e( k ) bestimmen

-> e( k ) 1e(1) 2 e(2) ... n e( n)

1 , 2 ,..., n sind Koordinaten von e( k )

4) In der ersten Spalte der gesuchten Abbildungsmatrix A stehen

die Koordinaten von e(1) , usw.

6

d

p ( x)

dx

1) Basis ist 1, x, x 2

( e(1) 1, e(2) x, e(3) x 2 )

2) e(1) f (e(1) ) f (1) 0, e(2) 1, e(3) 2 x

3) 0 0 1 0 x 0 x 2 ,

Bsp1 Sei V P2 ( ) ; f : V V ; p ( x)

1 1 1 0 x 0 x 2 ,

2 x 0 1 2 x 0 x

2

0 1 0

=> A 0 0 2

0 0 0

x F

x x

Bsp2 x 1

x 1 2

x2

x1 x2

Zeige: - F ( x y ) F ( x) F ( y )

- F ( x ) F ( x )

Abbildungsmatrix bez. Standardbasis:

1 1 0 1

F

1 1

0 1 0 1

A

0 0 1 1

1 1

F

1 0 1 1

Vermeidung der Inversenberechnung:

Trick: TB AT

1) T bestimmen wie oben

2) AT berechnen

3) GS: TX AT lösen (parallel für alle (drei) rechten Seiten)

X=B

13.

Basiswechsel

Wie sieht die Abbildungsmatrix A bezüglich einer anderen Basis aus?

Neue Basis: B b(1) ,..., b( n )

Zwei Möglichkeiten:

I) f (b(i ) ) berechnen und als Linearkombination von b ( i ) schreiben

-> GS lösen für Linearkombinationen

-> Koeffizienten in Spalten von neuer Abbildungsmatrix schreiben

Bsp: A von Bsp1, neue Basis:

b1 x 2 x 1, b2 x 2 2 x 3, b3 x 2 3x 4

d

b1 2 x 1 1b1 4b2 3b3

dx

1 0 1

d

f (b2 ) b2 2 x 2 0b1 2b2 2b3 B 4 2 0

dx

3 2 1

d

f (b3 ) b3 2 x 3 1b1 0b2 1b3

dx

f (b1 )

II) Transformationsmatrix T bestimmen (zw. alten e ( i ) u.neuen b ( i ) )

b (i ) 1e(1) 2 e(2) ... n e( n ) -> Koeffizienten in Spalten

von T => B T 1 AT

Bsp: b1 1e1 1e2 1e3 , b2 3e1 2e2 1e3 , b3 4e1 3e2 1e3

1 3

T 1 2

1 1

0

1

4 2

3

2

B

4

3 B T 1 AT

1

1 1 1 1 0 1 0 1 3 4

0 2 3 1 0 0 2 1 2 3

1 1 2 1 0 0 0 1 1 1

T 1

A

T

7

14.

Eigenraum zu 1: mit Gauss A 13 v 0 lösen

Eigenwerte und Eigenvektoren

Eigenwert:

Nullstelle des Charakteristischen Polynoms

!

det( A ) 0

Eigenvektor: Zu jedem Eigenwert gibt es einen Eigenvektor.

Es gilt: A i v 0

Mit Gauss-Elimination nach v auflösen.

Freie Parameter wählen.

Niemals 0!

Algebraische Vielfachheit: Grad einer Nullstelle i des

Charakteristischen Polynoms.

Geometrische Vielfachheit: dim( Ei ( A)) = max. Anz. Unabh.

Eigenvektoren von

i

Es gilt: 1 geom. Vielfachheit alg. Vielfachheit

Eigenraum: Menge der Eigenvektoren zum Eigenwert i

E x

n

| Ax x

Eigenbasis: für A: Basis deren Elemente Eigenvektoren sind

Summe der Basen aller Eigenräume von A

gV n : gV aV

Bsp:

2 1 1

A 1 2 1

1 1 2

1 1 1

1 v1 0

2 1 1

=> 0 0 0

2 1 1 v2 0

1

0 0 0

1

1

2 1 v3 0

v3 , v2 , v1

wähle einmal 1, 0 und einmal 0, 1

1 1

E1 , span 0 , 1

1 0

geom. Vielfachheit = 2

Eigenraum zu 4 : Vorgehen analog

1

E1 span 1

1

geom. Vielfachheit=1

1

1

1

1

0

1

Eigenbasis: die Vektoren u (1) 0 , u (2) 1 , u (3) 1 sind linear

……………..unabhängig und bilden eine Eigenbasis von A:

1 1 1

1 1

1 0 1

……... U 0

1

1

2

Eigenwerte: PA ( ) det( A 3 ) det 1

2

1

1

1

2

det( A 3 ) ... ( 1) 2 ( 4)

1 2 1 alg.Vielfachheit=2

3 4 alg. Vielfachheit=1

8

15.

Diagonalisieren einer Matrix

A heisst diagonalisierbar, falls eine reguläre T-Matrix existiert:

T 1 AT D

Matrix in Diagonalform:

A TDT 1

0

1

D

...

0

n

T: Eigenraum

Diagonalmatrix mit Eigenwerten

Eigenschaften von diagonalisierbar:

- A besitzt n verschiedene Eigenwerte (einfache NS)

- aV ( ) gV ( ) 1 : A ist „einfach“

- eine Eigenbasis exisitert

Spalten von T: sind Eigenvektoren zu den versch. Eigenwerten.

Falls aV ( ) 2 => nimmt man 2 lin. Unabh. Vektoren

aus E => nur möglich, falls aV ( ) gV ( )

Jordan’sche Normalform:

A TDT 1

symmetrische Matrizen:

- Alle Eigenwerte sind reell

- Eigenvektoren zu versch. Eigenwerten stehen senkrecht aufeinander

- Symm. Matrix halbeinfach -> diagonalisierbar

- orthogonale Eigenbasis zu A

- orthogonale Matrix 0, sd. 0T A0 diagonal ist.

In den Diagonalen stehen die Eigenwerte von A.

Die Spalten von 0 sind die entsprechenden Eigenvektoren von A.

Ähnliche Matrizen:

- haben dieselben Eigenwerte und aV, gV

- B SAS 1 S bildet Ei ( A) auf Ei ( B ) ab

-

Potenzen: Ak TDkT 1

9

16.

Differentialgleichungen

y1 (t ) 2 y1 (t ) y2 (t )

Bsp: y2 (t ) .... y1 (t ) 2 y2 (t ) y3 (t )

I) Systeme zweiter Ordnung

Masse *

Beschleunigung

= Kraft

y

1kg

*

= y C ( 1)

- Gleichungssystem in Matrizenform schreiben:

y (t ) Ay (t )

- Eigenwerte von A ausrechnen und dazugehörige Eigenvektoren

(normiert)

- Eigenvektoren in Spalten von T schreiben

Orthogonale Eigenbasis zu A => T : (u (i ) )

- y (t ) Tx (t ) Koordinatentransformation (vorläufig vergessen)

- x(t ) T 1 ATx(t )

x(t ) Dx(t ) falls A diag’bar. D=diag.Matrix mit von A

- x(t ) i xi (t ) alles auf linke Seite

-

xi (t ) i 2 xi (t ) 0 mit i i

-

Ansatz: xi (t ) ai cos(i t ) bi sin(i t )

-> y (t ) Tx (t )

-

y (t ) x1 (t ) u (1) x2 (t ) u (2) x3u (3) ...

Ansatz einsetzen

Mit Anfangswerten in Matrizenform:

y (0), y (0) => ai , bi bestimmen

y3 (t ) ............... y2 (t ) 2 y3 (t )

y1 (t ) 2 1 0 y1 (t )

y2 (t ) 1 2 1 y2 (t )

y (t ) 0 1 2 y (t )

3

3

1 2, 2,3 2 2

A

1

Eigenräume: E2 span 0 ,

1

E2

2

1

span 2

1

Orthogonale Basis zu A:

2

1

1

1

1

1

(1)

(2)

(3)

u 0 , u 2 , u 2

2

2

2

2

1

1

2

1

T : u (1) , u (2) , u (3) 0

2

2

y (t ) Tx(t ) u

(1)

u

(2)

1

2

1

1

2

1

x1 (t )

u x2 (t )

x (t )

3

(3)

xi (0) ai und xi (0) i bi

-

a1

1b1

y (0) Tx(0) T a2 und y (0) Tx(0) T 2b2

a

b

3

3 3

Ta ( y0 ) , T (ibi ) Tbi ( y0 )

Da T orthogonal und normiert: T 1 T T

=> a T T ( y0 )

10

2

a1 cos( 2t ) b1 sin( 2t ) 0

2

1

1

y (t ) a2 cos( 2 2 t ) b2 sin( 2 2 t ) 2

2

1

1

a3 cos( 2 2 t ) b3 sin( 2 2 t ) 2

1

1/ 2

y (0) 0 ,

1/ 2

1/ 2

0

Ta 0 , Tb 0

1/ 2

0

0

y(0) 0

0

bi : i bi

II)

cos 2t

2

1

Allg. Lösung

2t 0

0

2

cos 2t

2

T c y0 Koeffizienten mit Anfangswerten bestimmen

-

y(t ) Ay(t ), y (0) y0 in Matrixschreibweise

Eigenwerte und dazugehörige Eigenvektoren ausrechnen

Eigenvektoren in T schreiben: T : u (1) , u (2) , u (3)

-

y (t ) Tx (t ) Koordinatetransformation (später)

x(t ) Dx(t )

-

Ansatz: x j (t ) c j e j ,

y1 (t ) 3 y1 (t ) 4 y2 (t ),

y1 (0) 6

y2 (t ) 3 y1 (t ) 2 y2 (t ),

y2 (0) 1

6

T c :

1

Systeme erster Ordnung

t

-

4 1 1 6

4

1

(1)

(2)

A

1 u , u

3 1 2

3

1

4 1

T

3 1

4

1

y (t ) c1e6t c2et

4

1

T

2

cos

=> y (t )

4

y (t ) Tx(t ) c1e1t (u (1) ) c2e 1t (u (2) ) ... cne nt (u ( n ) )

Bsp:

b 0 b 0 da T regulär.

2

1/ 2

1

AT 0 0

2

1/ 2

0

-

c1 1,

=>

4 1 c1 4c1 c2 6

3 1 c2 3c1 c2 1

c2 2

y1 (t ) 4e6t 2e t

y2 (t ) 3e6t 2e t

j 1,..., n

11