Nagl, Einführung in die Statistik Seite 1 B3 Einführung in die

Werbung

Nagl, Einführung in die Statistik

Seite 1

B3 Einführung in die Wahrscheinlichkeitstheorie

B3.1 Wahrscheinlichkeitsmodelle

B3.1.1 Stichprobenraum

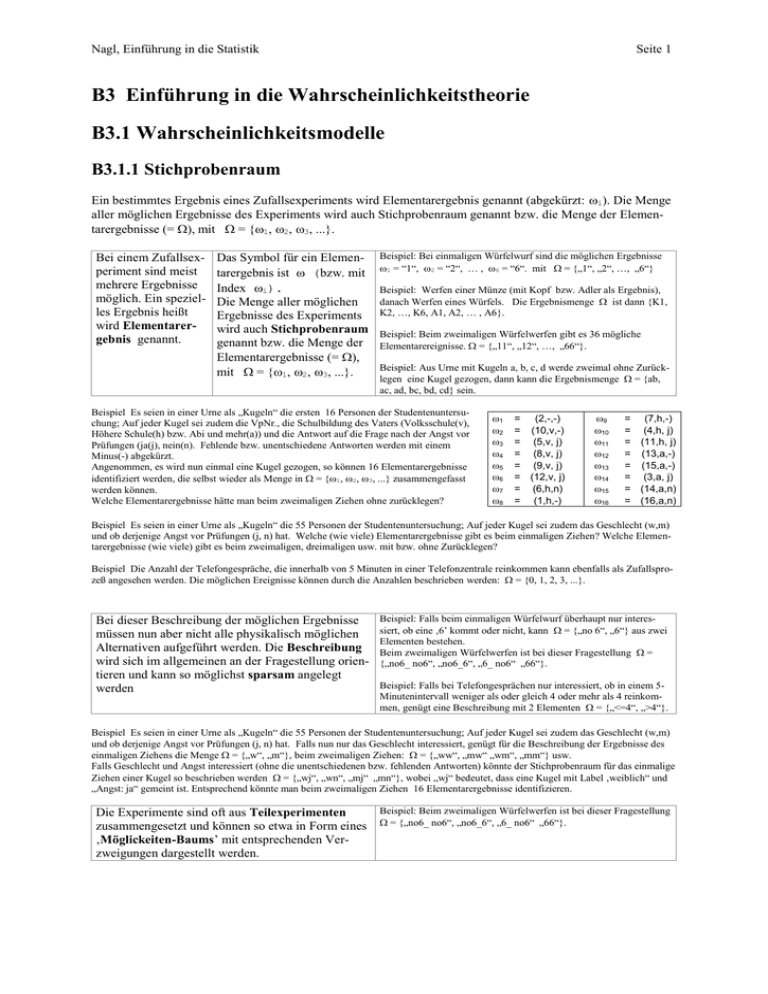

Ein bestimmtes Ergebnis eines Zufallsexperiments wird Elementarergebnis genannt (abgekürzt: i). Die Menge

aller möglichen Ergebnisse des Experiments wird auch Stichprobenraum genannt bzw. die Menge der Elementarergebnisse (= ), mit = {1, 2, 3, ...}.

Bei einem Zufallsexperiment sind meist

mehrere Ergebnisse

möglich. Ein spezielles Ergebnis heißt

wird Elementarergebnis genannt.

Das Symbol für ein Elementarergebnis ist (bzw. mit

Index i).

Die Menge aller möglichen

Ergebnisse des Experiments

wird auch Stichprobenraum

genannt bzw. die Menge der

Elementarergebnisse (= ),

mit = {1, 2, 3, ...}.

Beispiel: Bei einmaligen Würfelwurf sind die möglichen Ergebnisse

1 = “1“, 2 = “2“, … , 6 = “6“. mit = {„1“, „2“, …, „6“}

Beispiel: Werfen einer Münze (mit Kopf bzw. Adler als Ergebnis),

danach Werfen eines Würfels. Die Ergebnismenge ist dann {K1,

K2, …, K6, A1, A2, … , A6}.

Beispiel: Beim zweimaligen Würfelwerfen gibt es 36 mögliche

Elementarereignisse. = {„11“, „12“, …, „66“}.

Beispiel: Aus Urne mit Kugeln a, b, c, d werde zweimal ohne Zurücklegen eine Kugel gezogen, dann kann die Ergebnismenge = {ab,

ac, ad, bc, bd, cd} sein.

Beispiel Es seien in einer Urne als „Kugeln“ die ersten 16 Personen der Studentenuntersuchung; Auf jeder Kugel sei zudem die VpNr., die Schulbildung des Vaters (Volksschule(v),

Höhere Schule(h) bzw. Abi und mehr(a)) und die Antwort auf die Frage nach der Angst vor

Prüfungen (ja(j), nein(n). Fehlende bzw. unentschiedene Antworten werden mit einem

Minus(-) abgekürzt.

Angenommen, es wird nun einmal eine Kugel gezogen, so können 16 Elementarergebnisse

identifiziert werden, die selbst wieder als Menge in = {1, 2, 3, ...} zusammengefasst

werden können.

Welche Elementarergebnisse hätte man beim zweimaligen Ziehen ohne zurücklegen?

1

2

3

4

5

6

7

8

= (2,-,-)

= (10,v,-)

= (5,v, j)

= (8,v, j)

= (9,v, j)

= (12,v, j)

= (6,h,n)

= (1,h,-)

9

10

11

12

13

14

15

16

= (7,h,-)

= (4,h, j)

= (11,h, j)

= (13,a,-)

= (15,a,-)

= (3,a, j)

= (14,a,n)

= (16,a,n)

Beispiel Es seien in einer Urne als „Kugeln“ die 55 Personen der Studentenuntersuchung; Auf jeder Kugel sei zudem das Geschlecht (w,m)

und ob derjenige Angst vor Prüfungen (j, n) hat. Welche (wie viele) Elementarergebnisse gibt es beim einmaligen Ziehen? Welche Elementarergebnisse (wie viele) gibt es beim zweimaligen, dreimaligen usw. mit bzw. ohne Zurücklegen?

Beispiel Die Anzahl der Telefongespräche, die innerhalb von 5 Minuten in einer Telefonzentrale reinkommen kann ebenfalls als Zufallsprozeß angesehen werden. Die möglichen Ereignisse können durch die Anzahlen beschrieben werden: = {0, 1, 2, 3, ...}.

Bei dieser Beschreibung der möglichen Ergebnisse

müssen nun aber nicht alle physikalisch möglichen

Alternativen aufgeführt werden. Die Beschreibung

wird sich im allgemeinen an der Fragestellung orientieren und kann so möglichst sparsam angelegt

werden

Beispiel: Falls beim einmaligen Würfelwurf überhaupt nur interessiert, ob eine ‚6’ kommt oder nicht, kann = {„no 6“, „6“} aus zwei

Elementen bestehen.

Beim zweimaligen Würfelwerfen ist bei dieser Fragestellung =

{„no6_ no6“, „no6_6“, „6_ no6“ „66“}.

Beispiel: Falls bei Telefongesprächen nur interessiert, ob in einem 5Minutenintervall weniger als oder gleich 4 oder mehr als 4 reinkommen, genügt eine Beschreibung mit 2 Elementen = {„<=4“, „>4“}.

Beispiel Es seien in einer Urne als „Kugeln“ die 55 Personen der Studentenuntersuchung; Auf jeder Kugel sei zudem das Geschlecht (w,m)

und ob derjenige Angst vor Prüfungen (j, n) hat. Falls nun nur das Geschlecht interessiert, genügt für die Beschreibung der Ergebnisse des

einmaligen Ziehens die Menge = {„w“, „m“}, beim zweimaligen Ziehen: = {„ww“, „mw“ „wm“, „mm“} usw.

Falls Geschlecht und Angst interessiert (ohne die unentschiedenen bzw. fehlenden Antworten) könnte der Stichprobenraum für das einmalige

Ziehen einer Kugel so beschrieben werden = {„wj“, „wn“, „mj“ „mn“}, wobei „wj“ bedeutet, dass eine Kugel mit Label ‚weiblich“ und

„Angst: ja“ gemeint ist. Entsprechend könnte man beim zweimaligen Ziehen 16 Elementarergebnisse identifizieren.

Die Experimente sind oft aus Teilexperimenten

zusammengesetzt und können so etwa in Form eines

‚Möglickeiten-Baums’ mit entsprechenden Verzweigungen dargestellt werden.

Beispiel: Beim zweimaligen Würfelwerfen ist bei dieser Fragestellung

= {„no6_ no6“, „no6_6“, „6_ no6“ „66“}.

Nagl, Einführung in die Statistik

Seite 2

B3.1.2 Ereignisse

Ein Ereignis ist

irgendeine Menge

von Elementarergebnissen. Es kann

durch Aufzählung

der Elementarergebnisse oder durch eine

allgemeine Beschreibung charakterisiert

werden.

Ein Ereignis (wird meist mit

Großbuchstaben aus dem vorderen

Teil des Alphabets bezeichnet) E

ist die Menge der , die

einer speziellen Charakterisierung entspricht:

E := { | wobei einer ECharakterisierung entspricht

und }.

Beispiel(Bw): Bei einmaligem Würfelwurf könnten die Menge der

Ergebnisse mit ungeraden Zahlen interessieren. Daher das Ereignis U

(‚ungerade’ - Charakterisierung): U = {1, 3, 5}.

Beispiel(Bmw): Werfen einer Münze (mit Kopf bzw. Adler als

Ergebnis), danach Werfen eines Würfels. Die Ergebnismenge ist

dann {K1, K2, …, K6, A1, A2, … , A6}. Das Ereignis, das ‚Kopf’

enthält: K := {K1,K2, K3, K4, K5, K6}.

Beispiel(Bww): Beim zweimaligen Würfelwerfen gibt es 36 mögliche

Elementarereignisse. = {„11“, „12“, …, „66“}.

Beispiel(Buu): Aus Urne mit Kugeln a, b, c, d werde zweimal ohne

Zurücklegen eine Kugel gezogen, dann kann die Ergebnismenge =

{ab, ac, ad, bc, bd, cd } sein; Im Ereignis: A := {ab, ac, ad} sind die

Ergebnisse zusammengefasst, die ein ‚a’ enthalten.

Zwei spezielle Ereignisse sind: das sichere Ereignis (das ist das Ereignis, das mit Sicherheit eintritt; das ist )

und das unmögliche Ereignis ∅ (leere Menge, die keine Elemente enthält).

Ein Ereignis A kann Die Teilmengenrelation

eine Teilmenge eines

AB

anderen Ereignisses bedeutet, dass alle Elemente,

B sein

die in A sind auch in B sind.

Man kann auch sagen: A

B

impliziert B.

A

Es gilt auch für jedes Ereignis E: ∅ E .

Beispiel(für Bww): Sei B das Ereignis ‚gleiche Augenzahl : B = {11,

22, 33, 44, 55, 66}. Sei A das Ereignis zweimal eine 5 oder zweimaql

eine 6: A={55, 66}.

Dann ist A Teilmenge von B. A impliziert B: d,h. Falls ein Elementarergebnis aus A ist, weiß man auch, dass es aus B ist.

Man sagt auch: B ist eine notwendige Bedingung für A; auch: A ist

eine hinreichende Bedingung für B

Zwei Mengen A und B sind genau dann gleich (A = B), wenn gilt: A B und B A.

Operationen mit Ereignissen

Der Schnitt (auch

Durchschnitt genannt) zweier Ereignisse A und B ist das

Ereignis mit denjenigen Elementen, die

in jeder der beiden

Ereignisse vorhanden

sind

Die Vereinigung

zweier Ereignisse A

und B ist das Ereignis mit denjenigen

Elementen, die in

mindest einem der

beiden Ereignisse

vorhanden sind

Die Differenz zweier

Ereignisse A ohne B

ist das Ereignis mit

jenen Elementen, die

in A aber nicht in B

sind.

Die Schnitt zweier Ereignisse

A und B:

A B = { | A B }.

Karierte

Fläche

A

B

Die Vereinigung zweier

Ereignisse A und B:

A B = { | A B}.

GesamtFläche

Beispiel(Fortsetzung): Dann ist A B das Ereignis, für das zumindest eine der beiden Aussagen zutreffen, also die Vereinigungsmenge: {11, 22, 33, 44, 55, 56, 65, 66}

A

B

Die Differenz zweier Ereignisse A - B:

A - B = { | A B}.

Schraffierte

Fläche

Beispiel(für Bww): Sei B das Ereignis ‚gleiche Augenzahl : B = {11,

22, 33, 44, 55, 66}. Sei A das Ereignis, dass die Augensumme >9 ist:

A={55, 56, 65, 66}. Dann ist A B das Ereignis, für das beide

Aussagen zutreffen, also die Schnittmenge: {55, 66}

B

A

Beispiel(Fortsetzung): Dann ist A - B das Ereignis mit den Elementen,

die in A enthalten sind, aber nicht in B:. {11, 22, 33, 44}.

Nagl, Einführung in die Statistik

Seite 3

Die Differenz zweier Ereig- Beispiel: Bei einmaligem Würfelwurf könnten die Menge der Ergebnisse mit ungeraden Zahlen interessieren. Daher das Ereignis U

nisse Ac:

(‚ungerade’ - Charakterisierung): U = {1, 3, 5}.

Ac = - A.

A

Schraffierte

Fläche

Mit Hilfe des Komplements kann auch eine Differenz folgendermaßen formuliert werden: A - B = A Bc.

Das Komplement

eines Ereignisses A

enthält alle Elemente

von , die nicht in

A sind.

Zwei Mengen A und B heißen disjunkt oder wechselseitig exklusiv, wenn gilt: A B = ∅. (A und

B haben also kein Element gemeinsam)

Eine Partition (auch

Zerlegung genannt)

von heißt die

Aufteilung von in

eine Menge exklusiver Ereignisse.

Sei Z={A1, A2, …, Ak} eine

Menge paarweise disjunkter

Ereignisse, dann heißt Z eine

Partition, wenn gilt: =A1

A2 …Ak.

Beispiel: Seien M die Menge der Männer, F die Menge der Frauen,

dann ist die Schnittmenge leer. M und F sind disjunkt.

Beispiel: Seien bei einem Würfelwurf G die Menge der geradezahligen,

U die Menge der ungeradzahligen Ergebnisse, so sind die beiden

Ereignisse disjunkt.

Beispiel: Die beiden Ereignisse M (Männer) und F (Frauen) sind eine

Zerlegung des Stichprobenraums. Jede Einteilung der Elementarergebnisse nach einem Merkmal mit exklusiven Ausprägungen liefert

eine Zerlegung der Gesamtmenge.

Beispiel (Graphisch).

A1, A2, A3, A4 seien disjunkteEreignisse.

Alle zusammen bilden , Daher

ist A1, A2, A3, A4 eine Partition.

A1 A2

A3

A4

Folgende Rechenregeln gelten für Vereinigung, Schnitt und Komplement:

Vereinigung

Schnitt

AA=A

AA=A

(A B) C = A (B C)

(A B) C = A (B C)

AB=BA

AB=BA

A (B C) = (A B) (A C)

A (B C) = (A B) (A C)

A=A

A∅=A

A∅=∅

A=

6 KOMPLEMENTGESETZ

A Ac =

A A c =∅

7 DEMORGAN`S GESETZ

(A B) c = A c B c

(A B) c = A c B c

Ein System von Elementen, für das diese Rechenregeln gelten, nennt man auch eine Bool’sche Algebra.

1

2

3

4

5

Bezeichnung der Gesetze

IDEMPOTENZGESETZ

ASSOZIATIVGESETZ

KOMMUTATIVGESETZ

DISTRIBUTIVGESETZ

IDENTITÄTSGESETZ

B3.1.3 Mengen von Ereignissen

Im Allgemeinen sollen für ein Zufalls-Experiment

eine Vielzahl von Fragen gestellt werden können.

Das bedeutet, dass nicht nur ein spezielles Ereignis

betrachtet wird, sondern meist mehrere Ereignisse.

Neben den interessierenden Ereignissen gehört auf

jeden Fall das sichere Ereignis mit dazu. Zudem

kommen für die interessierenden Ereignisse auch

noch jene hinzu, die durch Schnitt-, Vereinigungsoder Komplementbildung aus bereits Vorhandenen

entstehen.

Ein solches System von Die Mengenalgebra Z()

Mengen heißt auch

erfüllt die Forderungen:

Mengenalgebra, die

1. Z() enthält

gegenüber Vereini2. Wenn A Z(), dann

gungs- und Kompleauch Ac Z()

mentbildung abge3. Wenn A Z() und

schlossen ist (dann auch

B Z(), dann ist auch

automatisch gegenüber

AB Z()

Schnittbildung).

Beispiel: a) Bei einmaligem Würfelwurf könnte die Menge der

Ergebnisse mit ungeraden Zahlen interessieren: U = {1, 3, 5}.

b) Neben U könnte zusätzlich das Ereignis S = {6} interessieren.

Für Beispiel a) würde das bedeuten: Uc gehört auch dazu wegen

Komplementbildung; daher gehören zu dieser Ereignismenge: {∅, U,

Uc, }.

Für Beispiel b) erhält man noch mehr zusätzliche Ereignisse: {∅, U,

Uc, S, Sc, A, Ac, }, wobei A={2, 4}.

Beispiel: Angenommen sei {a, b, c}. Zusätzlich gehöre A={a}

und B={b} zur Mengenalgebra Z().

Welche anderen Ereignisse müssen dann mindestens noch dazugehören?

Die Komplemente Ac={b,c}, Bc={a,c}, die Vereinigung von A und

B: C={a,b}, daher auch Cc={c};

Daher gehören zu Z(). , A, B, C, Ac, Bc, Cc und .

Nagl, Einführung in die Statistik

Seite 4

Bemerkungen:

a) Wenn die Vereinigung je zweier Ereignisse dazugehören, gehört auch die Vereinigungen endlich vieler

Ereignisse dazu.

b) Oft ist die Vervollständigung der Mengenalgebra sehr aufwendig. Daher wird bei diskretem und endlichem einfach die Potenzmenge gebildet, die alle möglichen Teilmengen von enthält.

Falls nicht nur endlich viele Elemente enthält, wird die 3. Forderung zur Mengenalgebra auf die Vereinigung

von abzählbar unendlich vielen Ereignissen erweitert. Dann heißt diese so modifizierte Mengenalgebra auch eine

Sigma-Algebra (-Algebra): ().

B3.1.4 Axiome der Wahrscheinlichkeit

Die Idee von Wahrscheinlichkeit wurde mit Hilfe des klassischen, frequentistischen bzw. subjektivistischen

Wahrscheinlichkeitsbegriffs bereits vermittelt. Diese Begriffe liefern allerdings keine mathematisch befriedigende Fundierung der Wahrscheinlichkeit. Eine zufrieden stellende Fundierung des Wahrscheinlichkeitsbegriffs

gelang Kolmogoroff(1933) mit seinen 3 Axiomen, aus denen dann die übrigen ‚Rechenregeln’ der Wahrscheinlichkeit ableitbar sind.

Als Wahrscheinlichkeitsraum bezeichnet man das Tripel (, (), P), wobei der Stichprobenraum, () die

Sigma-Algebra und einem Maß P (die Wahrscheinlichkeit), das folgende Axiome erfüllt:

1. für jedes A () gilt: 0 P(A) 1

2. P() = 1

3. P(A1 A2 … An) = P(A1) + P(A2) + … + P(An) für Ereignisse A1, A2, …An aus (), die

paarweise disjunkt sind.

Für unendliche Stichprobenräume kann das 3. Axiom erweitert werden von n auf abzählbar unendlich viele

paarweise disjunkte Ereignisse A1, A2, …An, …

Beispiele für Folgerungen aus den Axiomen

Die Wahrscheinlichkeit des Komplements (Ec)

P(Ec) = 1- P(E).

Beweis: E Ec = , zudem sind E und Ec disjunkt. Daher folgt aus

Axiom 2: P( E Ec )= P() = 1.

Nach Axiom 3 gilt: P( E Ec ) = P( E) + P( Ec )

Daher gilt: P(Ec)=1- P(E). qed.

Additionstheorem für

zwei beliebige

Ereignisse

P(A B)=

P(A) + P(B) – P(AB)

Beweis: Rückführung auf zwei disjunkte Mengen, und zwar: A und

(B – AB). Es gilt: A B = A (B – AB). Daher gilt nach

dem 3. Axiom: P(A B ) = P(A) + P(B – AB).

B kann wieder in die Vereinigung zweier disjunkter Ereignisse zerlegt

werden: B = (AB) (B – AB). Daher gilt nach Axiom 3

P(B) = P(AB) + P(B–AB) bzw. P(B–AB) = P(B) - P(AB) .

Mithin folgt die Behauptung (A B ) = P(A) + P(B) - P(AB) qed

B

A

Additionstheorem für mehr als zwei beliebige Ereignisse

Auch hier könnte der Beweis exakt geführt werden.

Additionstheorem für

P(A B C) =

Die Behauptung soll hier aber nur erläutert werden.

drei beliebige

P(A) + P(B) + P(C)

Durch die Addition der Wahrscheinlichkeiten von

Ereignisse

– P(AB) – P(AC) – P(BC) A, B und C selbst werden die Überschneidungen

gleich mehrfach addiert.

+ P(ABC).

1

B

A

C

A

1

B

1

1 –1 1

1

C

1

A

2

2

3

B

1

2

Daher werden nun die Schnitte

C1

der Ereignis-Paare abgezogen,

– P(AB) – P(AC) – P(BC).

Das führt wiederum dazu, dass beim Dreifachschnitt ABC diese Fläche einmal zu oft abgezogen wird; daher wird sie nochmals addiert: +

P(ABC).

Das Additionstheorem kann auf beliebig viele Ereignisse erweitert werden: Die Wahrscheinlichkeiten der Einzelmengen werden addiert, die aller Paare subtrahiert, die aller ‚Dreier’ addiert usw.

In diesem Zusammenhang kann auch die BONFERRONI-Ungleichung gut verstanden werden:

P(A1 A2 … An) P(A1) + P(A2) + … + P(An)

Denn: Gleichheit gilt für paarweise disjunkte Ereignisse(Axiom 3). Falls nur zwei Ereignisse eine Nichtleere Schnittmenge haben, wird auf

der rechten Seite zu viel addiert, erst recht dann, wenn mehrere überschneiden. Qed.

Nagl, Einführung in die Statistik

Satz der totalen

(bzw. Rand-) Wahrscheinlichkeit.

Seite 5

Sei Z={A1, A2, …, Ak} eine Beispiel (Graphisch):

A1, A2, A3, A4 seien disjunkte Ereignisse.

Partition. Dann gilt:

Alle zusammen bilden ,

P(B) = P(B A1)+ P(BA2) +

… + P(BAk)

Im diskreten (endlich oder auch abzählbar unendlichen) Fall reicht es, für jedes Elementarergebnis

nichtnegative Zahlen so zuzuordnen, dass die Summe über die Zahlen insgesamt 1 ist. Dann sind die

Axiome auch erfüllt: P() = 1; Für ein beliebiges

Ereignis E gilt P( E) =

P({}) ; damit ist auch

B

A1 A2

A3

A4

Beispiel: Ein Würfel werde so lange geworfen, bis eine ‚6’ kommt

(mit k soll ‚keine 6’ abgekürzt werden)

Die möglichen Erlementarergebnisse sind: 6, k6, kk6, kkk6, kkkk6, …

n 1 1

P(nach n-1 Fehlversuchen eine Sechs zu haben) = 56

.

6

Nach der Formel für geometrische Reihen

s n 1 a a 2 ...

E

1

(für - 1 a 1)

1 a

Axiom 3 erfüllt. Da das eine Summe über nichtnega2

1/ 6

P() =1/6( 1 56 56 .. ) =

=1

tive Zahlen ist, gilt: 0 P( E); andererseits wird

1 56

wohl über weniger summiert als über alle ElemenSei E das Ereignis, dass die ‚6’ bei einem ungeraden Versuch pastarereignisse, daher ist P( E) 1. Daher ist auch

siert: 6, kk6, kkkk6 …

Axiom 1 erfüllt.

1/ 6

25

25 2

36

.. ) =

P(E) =1/6 ( 1 36

= 6/11.

25

1 36

Im nichtdiskreten (überabzählbar unendlichen) Fall

kann nicht den einzelnen Punkten eine Wahrscheinlichkeit zugeordnet werden. Die einzelnen Punkte

hätten jeweils eine Wahrscheinlichkeit von 0. In

diesem Fall wird die Wahrscheinlichkeit als Masse

über einer (eventuell sehr kleinen) Region definiert.

Beispiel: Im eindimensionalen Fall (Betrachtung einer Variablen)

wird die Wahrscheinlichkeit als Fläche unter einer Dichtefunktion

definiert für ein bestimmtes Intervall. Die Fläche für einen Punkt ist

jeweils 0.

Beispiel: Für zweidimensionalen Fall (Betrachtung zweier Variablen)

wird für eine Grundfläche die Masse (dreidimensionales Volumen)

unter der Dichtefunktion über dieser Fläche als Wahrscheinlichkeit

definiert.

B3.1.4 Abhängigkeit und Unabhängigkeit

Zwei Ereignisse E und B werden dann als abhängig angesehen, wenn sich die Wahrscheinlichkeitseinschätzung

von E ändert durch die Kenntnis von B.

Beispiel: Zufallsexperiment sei folgendes: Sie Ziehen zuerst eine Urne

P(E B)

; P(B)>0 (aus zwei Urnen, in der ersten Urne seien 2 schwarze und 1 weisse

P(B)

Kugeln und in der zweiten 1 schwarze und 2 weisse). Danach ziehen

(Sprich: Wahrscheinlichkeit Sie aus der gewählten Urne eine Kugel.

Die Ergebnismenge ist dann {1s, 1s, 1w, 2s, 2w, 2w}.

von E, gegeben B).

E sei das Ereignis, eine weiße Kugel zu ziehen= {1w, 2w, 2w}. Ohne

Die Nichtbedingte WahrEinschränkung ist das = P(E) = P(E | ) = 0.5.

Sei nun B das Ereignis, die erste Urne zu ziehen. B = {1s, 1s, 1w}.

scheinlichkeit könnte auch

Das Ereignis E berücksichtigt nun auch nur die weißen Kugeln in B

als bedingte geschrieben

werden (Bedingung ist dann (im Sinne der Teilmengenrelation): E B={1w}. Unter dieser Restriktion B gilt: P(E|B) = P(E B)/ P(B) = 1/ 3

)

Genau wenn P(E) = P(E | B) sind E und B stochastisch unabhängig (bei Ungleichheit abhängig).

Bei Gleichheit ist der Kenntnisstand über E gleich groß wie nach Hinzufügen der Information B.

Die bedingte Wahrscheinlichkeit von E

ist die Wahrscheinlichkeit eines Ereignisses eingeschränkt

auf eine Bedingung

B

P(E | B)=

Die Definition der bedingten Wahrscheinlichkeit ist zugleich der Ausgangspunkt Multiplikation von Wahrscheinlichkeiten.

Beispiel: P(E B) = P(B) P(E|B) = 1/2 * 1/3 = 1/6

Multiplikationsge- P(B E) = P(B)*P(E | B)

setz

Die Wahrscheinlichkeit der Schnittmengen wird oft auch als gemeinsame Wahrscheinlichkeit bezeichnet.

Nagl, Einführung in die Statistik

Seite 6

Bedingte Wahrscheinlichkeiten

Das Multiplikationsgesetz lässt sich beliebig

erweitern (z.B für drei und vier Mengen)

P(ABC) = P(A)*P(B | A)* P(C | AB)

P(ABCD)= P(A)*P(B | A)* P(C | AB)

* P(D | ABC)

Mit Hilfe von Möglichkeitsbäumen können sehr

gut die verschiedenen Konstellationen dargestellt

werden. Die gemeinsamen Wahrscheinlichkeiten

können jeweils durch die Multiplikation der

bedingten Wahrscheinlichkeiten entlang der Äste

berechnet werden (Baummultiplikationsregel)

Gemeinsame Wahrscheinlichkeit

P(C|AB)

P(B|A)

P(A)

B

c

P(C |AB)

A

P(C|ABc)

c

P(B |A)

c

B

P(Cc|ABc)

P(C|AcB)

P(B|Ac)

c

P(A )

A

B

P(Cc|AcB)

c

P(C|AcBc)

P(Bc|Ac)

c

B

P(Cc|AcBc)

P(ABC)

C

c

C

P(ABCc)

C

P(ABcC)

c

C

P(ABcCc)

C

P(AcBC)

c

C

P(AcBCc)

C

P(AcBcC)

c

P(AcBcCc)

C

B3.1.4.1 Der Satz von BAYES

Beispiel: Krebs-Vorsorgeuntersuchung.

In manchen Situationen sind nur die bedingten

Wahrscheinlichkeiten für B unter allen Bedingungen

Testergebnis

einer Zerlegung in m Teile A1, A2, … , Am gegeben

Krank

Gesund

P(B | Ai) und die Randwahrscheinlichkeiten für die

(B)

(Bc)

Tatsäch1=

0=

einzelnen Bedingungen P(Ai).

Krank (A1)

Eine häufige Anwendung dieser Art findet bei Reihenuntersuchungen statt, bei denen oft Tests mit sehr hoher Sensitivität, aber

eher bescheidener Spezifität eingesetzt werden.

Spezifität = P(Testergebnis: Gesund | tats. gesund) und

Sensivität = P(Testergebnis: Krank | tats. krank).

Gesucht ist dann aber für die Betroffenen mit positivem Ergebnis

die Wahrscheinlichkeit P(tats. Krank | Testergebnis: Krank).

Gesucht sind aber die bedingten Wahrscheinlichkeiten P(Ai | B).

Laut Definition gilt: P(Ai | B) = P(BAi)/P(B);

mit: P(BAi) = P(B | Ai) P(Ai) und

P(B) = P(B A1) + … + P(BAm).

In Form einer einzigen Formel angeschrieben heißt

diese Rechenvorschrift Satz von BAYES:.

P( B | A i ) P( A i )

P(A i | B)

P ( B | A 1 ) P( A 1 ) P( B | A m ) P( A m )

lich

Gesund (A2)

P(B1|A1) P(B2|A1)

0.20 =

0.80 =

P(B1|A2) P(B2|A2)

?

?

0.10 =

P(A1)

0.90 =

P(A1)

Die Randwahrscheinlichkeiten sind bekannt durch die Kenntnis der

Verbreitung der Krankheit in der Bevölkerung. Die bedingten Wahrscheinlichkeiten sind zugleich Eigenschaften von Tests

Gemeinsame

W’keiten

Tatsächlich

Krank (A1)

Gesund (A2)

Testergebnis

Krank

Gesund

(B)

(Bc)

0.10 =

0=

P(A1B1) P(A2B1)

0.18 =

0.72 =

P(A1B2) P(A2B2)

.28

.72

=P(B1)

0.10 =

P(A1)

0.90 =

P(A1)

Gesucht sind die Wahrscheinlichkeiten, daß jemand krank ist unter

der Vorausetzung eines positiven Testergebnisses: P( A1 | B). Dies

ist P(A1 B)/P(B) = 0.10 / 0.28 = 0.36

In Kreuztabellensprechweise für Prozentrechnen könnte man auch sagen, dass so Zeilenprozente in Spaltenprozente (bzw. Spalten- in Zeilenprozente) umgerechnet werden können.

Gemeinsame WahrBedingte

Der Satz von BAYES kann leicht auf mehrere Bedingungen (Bedingungskonstellation) verallgemeinert

werden. Die Bedingungskonstellation sei B= B1

B2 B3 … Bb. Die Bedingungskonstellation

bestehe aus dem Schnitt von b Ereignissen.

0.7

0.8

Methode der Diagnose, wobei auf Grund von Tests

eine Eigenschaft erschlossen wird.

0.224

c

B2

0.096

B2

0.056

A

0.7

c

B1

0.3

0.2

0.1

A

c

B2

0.024

B2

0.012

B1

0.8

0.6

B2

B1

0.3

0.4

0.2

Beispiel: In der Gesamtheit seien 40% A-Menschen (60% NichtAs). A Menschen lösen Beispiel 1 mit W’t 0.8, und Beispiel 2 mit

Wahrscheinlichkeit 0.7. Die Nicht-A-Menschen lösen Beispiel 1

mit W’t 0.1 und Beispiel 2 mit W’t 0.2.

Angenommen, es wurde zufällig eine Person aus der Gesamtheit

ausgewählt. Sie löst beide Aufgaben.

Wie groß ist die Wahrscheinlichkeit, dass die Person eine APerson ist:

P(A | B1B2) = P( A B1B2)/ P( B1B2) = 0.224/ 0.236= 0.949, wobei

P( B1B2) = P(A B1B2)+ P(Ac B1B2) = 0.224+0.012.

Der Satz von BAYES wird so zu einer zentralen

scheinlichkeit

Wahrscheinlichkeiten

c

B2

0.048

B2

0.108

c

0.2

0.9

c

B1

0.8

c

B2

0.432

Nagl, Einführung in die Statistik

Seite 7

B3.1.4.2 Unabhängigkeit und bedingte Unabhängigkeit von Ereignissen

Für zwei Ereignisse A und B kann die stochastische Unabhängigkeit auf folgendermaßen formuliert werden:

Genau wenn P(A) = P(A | B), sind A und B stochastisch unabhängig (bei Ungleichheit abhängig). Oder auch:

P(A | B) = P(A | Bc ). Oder auch: P(AB) = P(A)*P(B).

Bei mehreren Ereignissen sind weitere Forderungen Beispiel: Dieses Beispiel zeigt, dass

drei Ereignisse zwar paarweise jeweils

A

B

nötig. Die Produktformulierung kann so verallge0.25

unabhängig sein können

0

0

meinert werden:

(P(A) = P(B) = P(C) = 0.50.

0

Drei Ereignisse A, B und C sind genau dann

P(AB) = P(AC) = P(BC) =0.25), aber

0.25 0.25

die Wahrscheinlichkeit des Dreifachstochastisch unabhängig, wenn alle paarweisen

0

schnitts P(ABC) = 0; und daher nicht

Ereignisse unabhängig sind und zudem gilt: P(ABC)

C

gleich P(A) P(B) P(C).

0.25

= P(A)P(B)P(C).

Vier Ereignisse sind genau dann stochastisch unabhängig, wenn alle Tripel stochastisch unabhängig sind unhd

das Produkt der 4 Randwahrscheinlichkeiten gleich der gemeinsamen Wahrscheinlichkeit ist; usw.

Die Formulierung der Unabhängigkeit mit Hilfe von bedingten

Wahrscheinlichkeiten ist besonders für Darstellungen mit Hilfe

von ‚Wahrscheinlichkeitsbäumen“ vorteilhaft.

Drei Ereignisse sind genau stochstisch unabhängig, wenn gilt

P(B| A) = P(B| Ac), P(C| AB) = P(C|ABc) = P(C| AcB)

=P(C|AcBc)

P(B|A)

B

A

P(C|AB)

C

=

C

c

P(C|ABc)

c

=

B

c

=

C

P(C|AcB)

P(B|Ac)

Diese Formulierung der Unabhängigkeit ist äquivalent bei

unterschiedlichen Reihenfolgen der Ereignisse.

A

B

C

c

=

c

C

C

P(C|AcBc)

c

C

B

c

C

Beispiel (Fortsetzung): Auf Grund der gemeinsamen Anteile im

obigen Beispiel , bei dem die 3 Ereignisse abhängig waren,

wurden die bedingten Wahrscheinlichkeiten für die einzelnen

Äste des Baumes berechnet.

Auch bei der Überprüfung mit Hilfe der bedingten Wahrscheinlichkeiten sind nicht alle Gleichheitsforderungen erfüllt (zweimal

sind Ungleichheiten vorhanden:

P(C| AB) P(C|ABc) und P(C| AcB) P(C|AcBc).

Bedingte

Wahrscheinlichkeiten

0

0.5

0.5

B

A

=

1

1

0.5

B

c

=

0

1

0.5

Eine einzige Ungleichheit reicht für die Feststellung der Abhängigkeit aus.

Gemeinsame Wahrscheinlichkeit

0.5

A

B

c

0

0

0.5

B

c

1

0.000

C

C

c

C

c

c

0.000

0.000

C

C

0.000

0.250

C

C

0.250

0.250

C

c

0.250

Bedingte Unabhängigkeit. Bei manchen Anwendungen sind die Ereignisse nicht vollständig unabhängig,

sondern erst nach der Einführung einer bestimmten Bedingung:

A.

Sei B und C stochastisch unabhängig unter der Bedingung A;

dann gilt zumindest für den A-‚Ast’ die Unabhängigkeitsforderung. (Oft wird auch für das Komplement von A Unabhängigkeit zwischen B und C unterstellt).

Diese Forderung kann wiederum für mehrere Ereignisse formuliert werden, die unabhängig sind (statt B und C: B, C, D usw.)

Ebenfalls könnten mehrere Bedingungen (statt nur einer einzigen) eingeführte werden.

P(B|A)

B

A

c

P(C|AB)

C

=

C

c

P(C|ABc) C

B

c

C

P(B|Ac)

A

P(C|AcB) C

B

c

c

=

c

C

P(C|AcBc) C

B

c

C

Die Annahme der bedingten Unabhängigkeit (auch lokal stochastische Unabhängigkeit genannt) wird auch in

den probabilistischen Testmodellen verwendet: Gegeben die Fähigkeit einer Person als Bedingung gilt, dass das

Lösen mehrerer Aufgaben unabhängig voneinander ist.

Nagl, Einführung in die Statistik

Beispiel (siehe oben, Fortsetzung)

Bedingte

Wahrscheinlichkeiten

0.8

0.4

B1

A

Gemeinsame Wahrscheinlichkeit

0.7

0.3

0.7

0.2

c

B1

0.3

0.2

0.1

0.6

A

B1

0.8

c

0.2

0.9

c

B1

Seite 8

0.8

B2

0.224

c

B2

0.096

B2

0.056

B2

c

0.024

B2

0.012

B2

c

0.048

B2

0.108

c

0.432

B2

1.

2.

Für das oben zum Satz von BAYES eingeführte Beispiel soll hier

nachvollzogen werden, dass die Ereignisse B1 und B2 bedingt

unabhängig sind unter Bedingung A (ebenfalls unter Bedingung

Ac). Bedingung A könnte eine Fähigkeit bedeuten; B1 und B2

‚Testaufgabenlösen’.

Falls die Aufgliederung nach A (bzw. Ac) eliminiert wird und

daher die gemeinsamen Wahrscheinlichkeiten addiert werden,

können diese in Form folgender Kreuztabelle dargestellt werden:

Die beiden B-Ereignisse (B1 und B2) sind nun abhängig (phi=

0.35).

Gemeinsame

B2

B2c

W’keiten

B1

0.236

0.144

0.38

B 1c

0.164

0.456

0.62

0.40

0.60

Daher liegt hier ein Beispiel dafür vor, dass die Abhängigkeit zwischen zwei Ereignissen durch die Einführung der Bedingung A bzw.

Ac aufgelöst werden kann.

Die bedingte Unabhängigkeit ist in der Modellbildung für den Zusammenhang von Ereignissen zentral. Speziell

das Entlarven von Scheinzusammenhängen zwischen Ereignissen ist eine zentrale Aufgabe der Datenanalyse

(z.B. Störche-Geburten-Korrelation). Wenn es gelingt, eine Bedingung zu finden, die den Zusammenhang zwischen anderen Ereignissen zum Verschwinden bringt, kann diese Bedingung als relevant für den Zusammenhang

zwischen den Ereignissen angesehen werden. Falls es gelingt, die Abhängigkeit zwischen mehreren Ereignissen durch die Einführung einer Bedingung aufzulösen, ist es vorteilhaft, für eine sparsame Beschreibung der

Daten vor allem diese Bedingung heranzuziehen. Man drückt das oft auch so aus: die (Unabhängigkeit zwischen

Ereignissen erzeugende) enthält all die Information über die Abhängigkeit der Ereignisse.

B3.2 Zufallsvariablen und deren Verteilung

Bisher wurden nur Ereignisse bzw. Elementarergebnisse und das Wahrscheinlichkeitsmaß darauf (, (), P)

betrachtet, wobei () die Sigma-Algebra ist, das System aller betrachtbaren Ereignisse. Dieses Tripel wurde

als Wahrscheinlichkeitsraum bezeichnet. Numerische Größen wurden bisher nicht betrachtet, obwohl in vielen

Bereichen der Anwendung numerische Größen üblich sind. Diese Lücke füllt das Konzept der Zufallsvariablen.

In voller Abhängigkeit vom Ergebnis im Zufallsexperiment nimmt die Zufallvariable bestimmte Werte an. Werte

sind daher gedacht als eine Funktion der Ergebnisse des Zufallsexperiments. Im Allgemeinen ist der Wertebereich die Menge der reellen Zahlen (oder einer Teilmenge); es könnten aber auch mehrere solche Funktionen in

einem Vektor reeller Zahlen zusammengefasst werden. Auch komplexen Zahlen wären als Bildbereich denkbar

(wird aber fast nie verwendet. Hier soll nun die reelle Zufallsvariable definiert werden. Da standardmäßig die

reelle Zufallsvariable verwendet wird, soll die reelle gemeint sein, falls von einer Zufallsvariablen gesprochen

wird.

Die reelle Zufallsvariable X ist eine Funktion auf

dem Stichprobenraum mit den reellen Zahlen

als Wertebereich: X: .

Daher ist X() = x für alle , wobei x

auch als Realisation der Zufallsvariablen X bezeichnet wird (=univariate ZV).

Eine m-dimensionale bzw. m-variate Zufallsvariable V ist eine Funktion auf dem Stichprobenraum

mit den Vektoren mit m Komponenten m als

Wertebereich: V: m.

Die vorher besprochene Zufallsvariable X wird auch

als eindimensionale Zufallsvariable bezeichnet.

Die m-dimensionale Zufallsvariable kann auch als

Zusammenfassung von m eindimensionalen Zufallsvariablen interpretiert werden.

Beispiel (E1): Einmal Würfeln sei das Zufallsexperiment. Zufallsvariable X sei 2 Euro Gewinn pro Augenzahl. ={‚1’,’2’,’3’,’4’,’5’,’6’}.

X: {‚1’,’2’,’3’,’4’,’5’,’6’} {2,4,6,8,10,12} mit X()=2* Zahlenwert().

Beispiel(E2): 2x Münzwurf, ={‚KK’,’KA’,’AK’,’AA’}: ; die

Zufallsvariable Y sei die Kopf-Anzahl; Y: ; Y(‚KK’) = 2,

Y(‚KA’) =1 usw.

Beispiel(E3): In einem Spielsalon werden folgende Spiele für das

Werfen zweier

Wür- WürWürfel

i

i P({i}) X(i) Y(i) Z(i) a

fel 1 fel 2

angeboten.:

-2

-4

-2

a

1 No '6' No '6' 1 25/36

Beim X-Spiel

-2

8

-2

a

2 No '6' '6'

2 5/36

gewinnt man 6

'6' No '6' 3 5/36

4

-4

-2

a

3

€, falls der 1.

'6'

'6'

4

8

16

a

4

4 1/36

Würfel eine

‚6’ zeigt

(Einsatz =2 €). Beim Y-Spiel gewinnt man 12 € bei einer ‚6’ (Einsatz

= 4 €). Das Z-Spiel bringt 18 €, falls bei beiden Würfen ‚6’ kommt

(Einsatz =2 €).

Diese 3 eindimensionalen Zufallsvariablen könnten auch zu einer

dreidimensionale Zufallsvariable V zusammengefasst werden.

Nagl, Einführung in die Statistik

Seite 9

Die Zufallsvariablen sind eigentlich Funktionen (z.B. X()), die i.a. mit großen Buchstaben aus dem hinteren

Teil des Alphabets abgekürzt werden. Die Funktionswerte selbst wiederum sind die Realisationen, die mit entsprechenden kleinen Buchstaben abgekürzt werden.

Ein Zusatzproblem bei der Betrachtung der Zufallsvariablen ist die sogenannte Messbarkeit der Funktion X();

das bedeutet, dass für beliebig vorgebbare Werte Z (einer Teilmenge der reellen Zahlen) die Menge der Urbild aus (=A = X-1(Z)) zur Sigma-Algebra gehören muss; dadurch kann dann auch die Wahrscheinlichkeit P(A)

angegeben werden. Für diskrete Mengen, für die meist die Potenzmenge als Sigma-Algebra gewählt wird, ist

das kein Problem, da ja dann jede mögliche Menge A in der Sigma-Algebra enthalten ist. Etwas detailierter:

Sei Z eine Teilmenge von : Z . Dann kann das

inverse Bild von Z betrachtet werden:

X-1(Z) = {| X() Z} = A (d.h. X invers von Z)

A ist so die Menge der Elementarereignisse, die den

Funktionswert in Z haben..

Beispiel(E1): (Sei Z= {4, 8, 12}. Dann ist A = {‚2’,’4’,’6’} = X-1(Z) =

{| X() Z}, das ist sicher ein Ereignis aus dem System der

Ereignisse (=Sigma-Algebra)..

Oder: Z() sei ein Intervall z ;

Sei = 8. dann ist A = {‚1’‚2’,’4’ } = X-1(Z(8)) = {| X() Z(8)},

A soll nun wiederum zur Sigma-Algebra gehören, damt die Wahrscheinlichkeit für dieses A (und damit implizit die Aussage über das

Intervall) berechnet werden kann.

Anders ausgedrückt: Mit Hilfe der Zufallsvariablen kann man alle möglichen Aussagen formulieren (und damit

Ereignisse charakterisieren). Die Wahrscheinlichkeit ist aber nur für die Ereignisse aus dem Ereignissystem (der

Sigma-Algebra) definiert. Daher muss gewährleistet sein, dass das Ereignis im Ereignissystem (Sigma-Algebra)

enthalten ist (sonst würde man mit Hilfe der Zufallsvariablen Ereignisse formulieren, für die keine Wahrscheinlichkeiten P definiert sind).

Falls für eine Zufallsvariable X etwa für alle Intervalle z x mit beliebigem x die Wahrscheinlichkeiten

berechnet werden können (d.h. enthalten sind im Ereignissystem (Sigma-Algebra)), ist es möglich, für diese

Zufallsvariable die Verteilungsfunktion F(x) = P(X x) zu berechnen.

Nagl, Einführung in die Statistik

Seite 10

B3.2.1 Erwartungswerte für Zufallsvariablen und Funktionen von Zufallsvariablen

Hier wird nur eine abzählbare Elementarergebnismenge betrachtet. Grundsätzlich können die Erwartungswerte direkt für die Elementarergebnismenge definiert werden oder für die Verteilungen. Hier sollen die Erwartungswerte direkt für betrachtet betrachtet werden.

Erwartungswert einer Der Erwartungswert kann

Zufallsvariablen.

folgendermaßen angeschrieben werden:

E(X) =

X( )P({ }) .

i

i

i

Die Erwartungswerte

wurden nach entsprechender Anpassung

der Definition an die

ZufallsvariablenBezeichnungen

berechnet.

i P({i})

1

2

3

4

25/36

5/36

5/36

1/36

1

a*

X(i)* Y(i) )* Z(i)*

P({i}) P({i}) P({i}) P({i})

-50/36 -100/36 -50/36 25a/36

-10/36

40/36 -10/36 5a/36

20/36

-20/36 -10/36 5a/36

4/36

8/36

16/36 a/36

-1

-2

-1.5

a

=E(X)

=E(Y) =E(Z) =E(a)

Eine Konstante a hat bei jedem Elementarergebnis den gleichen Wert.

Erwartungswert einer Erwartungswert einer Funktion einer Zufallsvariablen:

Funktion g einer

E(g(X))

Zufallsvariablen.

=

g (X( i )) P({ i }) .

i

Seien folgende Funktionen gegeben: f(X) =(X-E(X))2 und g(X) =X2.

g(X(i))* f(X(i)) *

P({i})

P({i})

100/36

1

25/36

20/36

1

5/36

80/36

25

125/36

16/36

25

25/36

6

E( g(X))=

5

=E(f(X))

i

i P({i}) X(i) g(X(i)) f(X(i))

1

2

3

4

1

2

3

4

25/36

5/36

5/36

1/36

-2

-2

4

4

4

4

16

16

Der

Erwartungswert

dieser speziellen Funktion f(X) ist gleich der Varianz von X.

Ein spezieller Fall einer Funktion g(X) ist (X-E(X))2; Der mit dieser Funktion berechnete Erwartungswert ist

zugleich die Varianz von X: Var(X) = E( X-E(X))2 .

Falls mehrere Zufallsvariable vorhanden sind, kann auch eine Funktion mehrerer Zufallvariablen betrachtet

werden.

Erwartungswert einer Erwartungswert einer Funk- Seien folgende Funktionen gegeben:g(Y,Z) =(Y-E(Y)*(Z-E(Z))

g(Y,Z) *

Y(i)- Z(i)Funktion g mehre- tion zweier Zufallsvariabler

g(Y,Z)

i

i P({i})

P({i})

E(Y)

E(Z)

rer Zufallsvariabler X und Y:

25/36

-2

-0.5

1

1 1 25/36

E(g(X,Y)) =

-25/36

10

-0.5

-5

2 2 5/36

g(X( ), Y( )) P({ })

i

i

.

i

i

Der Erwartungs3 3 5/36

wert dieser speziel4 4 1/36

len Funktion

g(Y,Z) ist zugleich

die Kovarianz zwischen von Y und Z.

-2

10

5/36

-0.5

1

17.5

175 175/36

5

E(g(X,Y)) =

Ein spezieller Fall von g(X,Y) ist das Produkt der zentrierten Zufallsvariablen X und Y: (X-E(X))(Y-E(Y)). Der

mit dieser Funktion berechnete Erwartungswert ist zugleich die Kovarianz zwischen X und Y:

Cov(X,Y) = E(( X-E(X))(Y-E(Y))).

Weitere Rechenregeln und Anwendungen des Erwartungswerts, der Varianz und der Kovarianzen wurden unter

Anhang A3.2 behandelt.

Nagl, Einführung in die Statistik

Seite 11