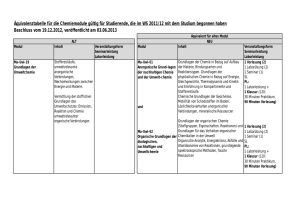

Document

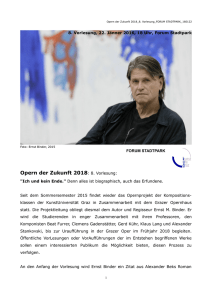

Werbung