Multiple Regression mit kategorialen unabhängigen Variablen

Werbung

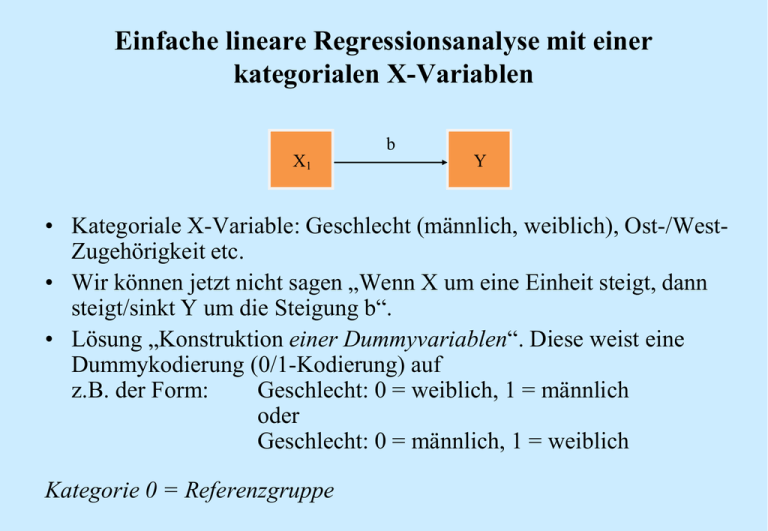

Einfache lineare Regressionsanalyse mit einer kategorialen X-Variablen b X1 Y • Kategoriale X-Variable: Geschlecht (männlich, weiblich), Ost-/WestZugehörigkeit etc. • Wir können jetzt nicht sagen „Wenn X um eine Einheit steigt, dann steigt/sinkt Y um die Steigung b“. • Lösung „Konstruktion einer Dummyvariablen“. Diese weist eine Dummykodierung (0/1-Kodierung) auf z.B. der Form: Geschlecht: 0 = weiblich, 1 = männlich oder Geschlecht: 0 = männlich, 1 = weiblich Kategorie 0 = Referenzgruppe Ein Beispiel: X = Geschlecht, Y = Einkommen (in 100 Euro) Geschlecht (xi) Monatl. Einkommen original / dummysiert (in 100 Euro) (yi) A 1/0 12 B 1/0 24 C 2/1 14 D 1/0 26 E 2/1 18 F 1/0 28 G 2/1 32 H 2/1 16 I 1/0 30 J 2/1 20 1 bzw. 0 = weiblich (Referenzgruppe), 2 bzw. 1 = männlich Person Das Streudiagramm: X = Geschlecht 35 Einkommen (in 100 Euro) 30 25 20 15 R-Quadrat linear = 0,091 10 0 0,2 0,4 0,6 0,8 Geschlecht (dummysiert) 0 = weiblich (Referenzgruppe), 1 = männlich 1 Berechnung von a und b: Person xi yi xi - x A B C D E F G H I J ∑ 0 0 1 0 1 0 1 1 0 1 5 12 24 14 26 18 28 32 16 30 20 220 -0,5 -0,5 0,5 -0,5 0,5 -0,5 0,5 0,5 -0,5 0,5 0 x 5 / 10 0,5 (xi - x )2 yi - y 0,25 0,25 0,25 0,25 0,25 0,25 0,25 0,25 0,25 0,25 2,50 i 2 i -0,5 · (-10) = 5 -0,5 · 2 = -1 0,5 · (-8) = -4 -0,5 · 4 = -2 0,5 · (-4) = -2 -0,5 · 6 = -3 0,5 · 10 = 5 0,5 · (-6) = -3 -0,5 · 8 = -4 0,5 · (-2) = -1 -10 y 220 / 10 22 (x x)(y y) 10 b 4,00 2,50 (x x) i -10 2 -8 4 -4 6 10 -6 8 -2 0 (x i - x ) · (y i - y ) a y b x 22 (4,00) 0,50 24 Ergo: y'i a b xi 24 4 xi Interpretation: • a = Frauen weisen im Durchschnitt ein Einkommen von 24,00 (in 100 Euro, also 2400 Euro) auf. • b = Männer hingegen weisen ein niedrigeres Einkommen auf. Sie unterschreiten den Mittelwert der Frauen um 4,00 (in 100 Euro, also 400 Euro). Das Streudiagramm im umgekehrten Fall : 35 Einkommen (in 100 Euro) 30 25 20 15 R-Quadrat linear = 0,091 10 0 0,2 0,4 0,6 0,8 Geschlecht (dummysiert) 0 = männlich (Referenzgruppe), 1 = weiblich 1 Berechnung von a und b: Person xi yi xi - x A B C D E F G H I J ∑ 1 1 0 1 0 1 0 0 1 0 5 12 24 14 26 18 28 32 16 30 20 220 0,5 0,5 -0,5 0,5 -0,5 0,5 -0,5 -0,5 0,5 -0,5 0 x 5 / 10 0,5 (xi - x )2 yi - y 0,25 0,25 0,25 0,25 0,25 0,25 0,25 0,25 0,25 0,25 2,50 i 2 i 0,5 · (-10) = -5 0,5 · 2 = 1 -0,5 · (-8) = 4 0,5 · 4 = 2 -0,5 · (-4) = 2 0,5 · 6 = 3 -0,5 · 10 = -5 -0,5 · (-6) = 3 0,5 · 8 = 4 -0,5 · (-2) = 1 10 y 220 / 10 22 (x x)(y y) 10 b 4,00 2,50 (x x) i -10 2 -8 4 -4 6 10 -6 8 -2 0 (x i - x ) · (y i - y ) a y b x 22 4,00 0,50 20 Ergo: y'i a b xi 20 4 xi Interpretation: • a = Männer weisen im Durchschnitt ein Einkommen von 20,00 (in 100 Euro, also 2000 Euro) auf. • b = Frauen hingegen weisen ein höheres Einkommen auf. Sie überschreiten den Mittelwert der Männer um 4,00 (in 100 Euro, also 400 Euro). Wie sieht das Ganze in SPSS aus? Referenzgruppe = weiblich Koeffizienten (a) Modell 1 (Konstante) Geschlecht Nicht standardisierte Koeffizienten Standard B -fehler 24,000 3,162 -4,000 4,472 Standardisierte Koeffizienten T Signifikanz Beta -,302 7,589 -,894 ,000 ,397 95%-Konfidenzintervall für B UnterObergrenze grenze 16,708 31,292 -14,313 6,313 a Abhängige Variable: Einkommen (in 100 Euro) Referenzgruppe = männlich Koeffizienten (a) Modell 1 (Konstante) Geschlecht Nicht standardisierte Koeffizienten Standard B -fehler 20,000 3,162 4,000 4,472 a Abhängige Variable: Einkommen (in 100 Euro) Standardisierte Koeffizienten T Signifikanz Beta ,302 6,325 ,894 ,000 ,397 95%-Konfidenzintervall für B UnterObergrenze grenze 12,708 27,292 -6,313 14,313 Wir fassen zusammen: Referenzgruppe „weiblich“: Referenzgruppe „männlich“: (x x)(y y) 10 b 4,00 2,50 (x x) (x x)(y y) 10 b 4,00 2,50 (x x) a y b x 22 (4,00) 0,50 24 a y b x 22 4,00 0,50 20 y’i = 24 - 4 ∙ x y’i = 20 + 4 ∙ x i i 2 i i i 2 i • a (Schnittpunkt mit der Y-Achse) = Mittelwert der Referenzgruppe: a y Frau yGesamt (y Mann y Frau ) 0,5 für Referenzgruppe (Ref.) Frau • b (Steigungsparameter) = Mittelwert der Gruppe j - Mittelwert der Referenzgruppe bzw. Mittelwertsdifferenz: b y Mann y Frau für Ref. Frau Ergo: a + b = Mittelwert der Gruppe j: y Mann y Frau (y Mann y Frau ) für Ref. Frau Oftmals weisen kategoriale Variablen mehr als zwei Merkmalsausprägungen auf: • z.B. Schichtzugehörigkeit (Unterschicht, Mittelschicht, Oberschicht), Staatsangehörigkeit (deutsch, türkisch, griechisch etc.), Familienstand (ledig, verheiratet, geschieden etc.) • Lösung „Konstruktion von mehreren Dummyvariablen“. Es werden n - 1 Dummyvariablen z.B. der Form: Mittelschicht (D2): 0 = nein, 1 = ja Oberschicht (D3): 0 = nein, 1 = ja konstruiert. • Unterschicht geht nicht in die Analyse ein, da diese aus D2 und D3 eindeutig reproduzierbar ist.1 Unterschicht ist folglich die Referenzgruppe, denn: – wenn D2 oder D3 = 1, dann Unterschicht = 0 – wenn D2 und D3 = 0, dann Unterschicht = 1 1 Dies gilt ebenfalls für alle anderen Kategorien (Mittelschicht und Oberschicht). Zumeist wird jene Kategorie als Referenzgruppe ausgewählt, die mit der höchsten Häufigkeit vertreten ist. Ein Beispiel: X = Schichtzugehörigkeit Schichtzugehörigkeit (xi) original SchichtzugeMonatl. Person hörigkeit (xi) Einkommen dummysiert (in 100 Euro) D1 D2 D3 A 1 1 0 0 12 B 2 0 1 0 24 C 1 1 0 0 14 D 2 0 1 0 26 E 1 1 0 0 18 F 3 0 0 1 28 G 3 0 0 1 32 H 1 1 0 0 16 I 3 0 0 1 30 J 2 0 1 0 20 Kodierung: 1 = Unterschicht (D1), 2 = Mittelschicht (D2), 3 = Oberschicht (D3) Unterschicht (D1) geht nicht in die Analyse ein (Referenzgruppe) Wir fassen zusammen: Referenzgruppe = Unterschicht Koeffizienten (a) Modell 1 Nicht standardisierte Koeffizienten Standard B -fehler (Konstante) 15,000 Mittel8,333 schicht (D2) Ober15,000 schicht (D3) Standardisierte Koeffizienten Signifi -kanz 95%-Konfidenzintervall für B UnterObergrenze grenze 11,619 ,000 11,947 18,053 T Beta 1,291 1,972 ,576 4,226 ,004 3,670 12,996 1,972 1,036 7,606 ,000 10,337 19,663 a Abhängige Variable: Einkommen (in 100 Euro) y’i = 15 + 8,333 ∙ x1 + 15 ∙ x2 a y b1 x1 b2 x 2 22 8,333 0,30 15 0,30 22 2,50 4,50 15 bzw. a y Unter yGesamt (y Mittel y Unter ) 0,3 (yOber y Unter ) 0,3 Die Konstante a = 15 entspricht dem Mittelwert des Einkommens für die Unterschicht, die als Referenzgruppe dient. Sind also Mittelschicht und Oberschicht = 0, erhalten wir den Vorhersagewert der Unterschicht, der ihrem Mittelwert entspricht. bj (Steigungsparameter) = Mittelwert der Gruppe j - Mittelwert der Referenzgruppe bzw. Mittelwertsdifferenz: b1 yMittel y Unter b 2 yOber y Unter Ergo: a + bj = Mittelwert der Gruppe j: y Mittel y Unter (y Mittel y Unter ) yOber y Unter (yOber y Unter ) Wir sind bereits in der multiplen Regressionsanalyse angelangt! Dort haben wir es in der Regel sowohl mit metrischen als auch kategorialen X-Variablen kombiniert zu tun. Wie unterscheidet sich die einfache Regression zur multiplen Regression? Unterschied - Erweiterung des einfachen Regressionsmodell Einfache Regression: Multiple Regression: Y X Stichprobe: b0 bzw. a Stichprobe: b1 bzw. b Grundgesamtheit: β0, β1 ei = yi - y’i yi = b0 + b1 ∙ xi + ei Streudiagramm: Gerade im zweidimensionalen Raum Y X1, X2, …, Xn Stichprobe: b0 bzw. a Stichprobe: b1, b2, …, bj Grundgesamtheit: β0, β1, β2, …, βj ei = yi - y’i yi = b0 + b1 ∙ x1i + b2 ∙ x2i + ... + bj ∙ xji + ei Streudiagramm: Ebene im dreidimensionalen Raum, ab 3 X-Variablen nicht mehr vorstellbar r2 (Determinationskoeffizient) r2korr. (hier nicht relevant) r (Bivariate Korrelation) b (Regressionskoeffizient) und a Beta = r (Standardisierter b) Standardfehler für a und b F-Test, T-Test, Konfidenzint. R2 (Multipler Determinationskoeffizient) R2korr. (hier relevant) R (Multiple Korrelation) bj (Partieller Regressionskoeffizient) und a Betaj ≠ R (standardisierter partieller b) Standardfehler für a und bj F-Test, T-Test, Konfidenzintervall Das Streudiagramm - Eine Ebene: Die Grundidee der OLS-Schätzung besteht auch hier, bj so zu wählen, dass die Summe der quadrierten Abweichungen in der Stichprobe (d.h. ei2 ) so klein wie möglich wird. y’i = 5.73 - 0.51 ∙ x1 + 0.76 ∙ x2 In verkürzter Schreibweise: y i' Xb bzw. y Xb e Matrizennotation der multiplen Regression: In den multivariaten Verfahren hat man mit großen Gleichungssystemen zu tun. Mit diesen zu rechnen, ist sehr aufwendig. Man bedient sich zur Vereinfachung der Matrizenrechnung, innerhalb derer die Gleichungssysteme besser handhabbar sind. Beispiel: Für n Personen i (i = 1, .., n) ergibt sich bei m Variablen j (j = 1, ...., m) folgendes Gleichungssystem: y1 b 0 b1x11 b 2 x12 ... b j x1 j ... b m x1m e1 y 2 b 0 b1x 21 b 2 x 22 ... b j x 2 j ... b m x 2 m e 2 .............................................. .............................................. y i b 0 b1x i1 b 2 x i 2 ... b j x ij ... b m x im ei y n b 0 b1x n1 b 2 x n 2 ... b j x nj ... b m x nm e n Darstellbar als y Xb e (Regressionsgleichung der Stichprobe) mit y = (n x 1)-Spaltenvektor, X = (n x m)-Beobachtungs-/ Messwertmatrix, b = (m x 1)-Spaltenvektor der Koeffizienten, e = (m x 1)-Spaltenvektor der Residuen Das Pendant dazu ist die Regressionsgleichung der Grundgesamtheit: y Xβ e y1 1 x11 y2 .. 1 x 21 y X ... ... yi 1 x .. n1 y n ... x1 j ... x1m ... x 2 j ... x 2 m ... ... ... ... ... x nj ... x nm b0 e1 b 1 e2 b ... 2 b ... e ei b j ... ... e n b m Was ist eine Matrix? Wir kennen ja die Bezeichnung KorrelationsMATRIX, KovarianzMATRIX Ein Beispiel für eine Matrix: a11 A a 21 a 31 a12 a 22 a 32 a13 a 23 a 33 Der erste Index gibt an, in welcher Zeile der Matrix und der zweite Index, in welcher Spalte der Matrix das Element steht. • Eine rechteckige Anordnung von Elemente bzw. Zahlen aij in mehreren Zeilen und Spalten bezeichnet man als eine Matrix. • Die Gesamtmatrix wird durch einen fettgedruckten Großbuchstaben (z.B. A) gekennzeichnet. Die Anzahl der Zeilen und Spalten gibt die Größe bzw. Ordnung der Matrix an. - Eine (n x m)-Matrix hat n Zeilen und m Spalten. - Eine (2 x 3)-Matrix umfasst also 2 Zeilen und 3 Spalten. Was ist eine Matrix? Ein weiteres Beispiel für eine Matrix: 3 1 2 A 5 0 4 Ihre Elemente sind z.B.: a11 = 3, a21 = -5, a23 = 4, … Was ist ein Vektor? • Besteht eine Matrix aus nur einer Zeile, so bezeichnet man sie als Zeilenvektor. Es liegt eine (1 x m)-Matrix vor. • Besteht eine Matrix aus nur einer Spalte, so bezeichnet man sie als Spaltenvektor. Es liegt eine (n x 1)-Matrix vor. • Ein Vektor ist durch einen fetten Kleinbuchstaben gekennzeichnet, ein Zeilenvektor ist zusätzlich durch ein Apostroph gekennzeichnet, also bspw. a’. Was ist ein Vektor? Ein Beispiel für ein Vektor: a ' 7 8 9 Zeilenvektor (Matrix der Ordnung 1 x 3) 2 5 a 8 11 Spaltenvektor (Matrix der Ordnung 4 x 1) Spezielle Matrizen: 1 2 3 A 4 5 6 7 8 9 Quadratische Matrix (z.B. Korrelationsmatrix) 1 0 I 0 0 0 0 0 1 0 0 0 1 0 0 0 1 1 2 3 4 2 2 5 6 A 3 5 3 7 4 6 7 4 Symmetrische Matrix (z.B. Kovarianzmatrix) 3 0 A 0 0 0 0 0 1 3 0 0 0 3 0 3 0 0 0 0 0 3 1 0 0 0 0 2 0 0 A 0 0 3 0 0 0 0 4 Diagonalmatrix, da alle Nicht-Diagonalelemente gleich Null sind 0 0 0 1 0 0 0 1 0 0 0 1 3 2 A 1 2 0 0 0 3 0 0 5 3 0 4 4 3 Einheitsmatrix (I), da alle Skalarmatrix , da alle Diagonalelemente Dreiecksmatrix, da alle Diagonalelemente gleich eins und Nicht-Diagonalelemente gleich Null sind (z.B. sieht man oft (I-B-1)) gleich > eins und Nicht-Diagonalelemente gleich Null sind. Diese Matrix kann geschrieben werden als A = k · I, k = Skalar Elemente entweder über (Obere Dreiecksmatrix) oder unter (Untere Dreiecksmatrix) der Hauptdiagonalen gleich Null sind. Wir kommen zur multiplen Regression zurück: • Wenn man mehr als eine unabhängige Prädiktorvariable in das Regressionsmodell aufnimmt, erhält man eine multiple lineare Regression der Form (Schätzer für y-Werte): ŷ Xb ŷ1 1 x11 x12 ŷ 2 1 x 21 x 22 ... ... ... ... ŷ i 1 x i1 x i 2 ... ... ... ... ŷ 1 x n n1 x n 2 x13 x 23 b 0 ... b1 xi3 b2 ... b 3 x n 3 X1 X 2 X 3 Anmerkung: ŷ yi' Messwert-Matrix (ist im Grunde die SPSS-Datenmatrix) Parameter-Matrix Y besteht aus dem Schätzwert zuzüglich eines Fehlerterms e, also: y Xb e y1 1 x11 y 2 1 x 21 ... ... ... y i 1 x i1 ... ... ... y 1 x n n1 x12 x 22 ... xi2 ... xn2 x13 e1 x 23 b 0 e 2 ... b1 ... x i 3 b 2 ei ... b 3 ... e x n 3 n Wir müssen uns die grundlegenden Rechenoperationen „Multiplikation und Addition“ ansehen. Hier: „Matrix ∙ Spaltenvektor“ sowie „Spaltenvektor + Spaltenvektor“ Multiplikation von Matrizen: • Zwei Matrizen A und B können genau dann die Produktmatrix C = A·B erzeugen, wenn die Anzahl der Spalten von A (der linksstehenden Matrix) der Anzahl der Zeilen von B (der rechtsstehenden Matrix) entspricht. • Wichtig: Die Matrizenmultiplikation ist nicht kommutativ, d.h. es gilt: A(n x m) · B(m x p) = C(n x p) A B C 6 1 2 8 42 44 64 32 2 3 6 2 8 6 0 4 1 5 4 3 7 8 46 27 49 8 (2 x 3) (3 x 4) (2 x 4) c11 = (2 · 6) + (3 · 2) + (6 · 4) = 42 c12 = (2 · 1) + (3 · 8) + (6 · 3) = 44 .... c24 = (4 · 8) + (1 · 0) + (5 · (-8)) = -8 a b’ C 1 5 4 1 5 4 5 4 1 5 4 (3 x 1) (1 x 2) (3 x 2) c11 = (1 · 5) = 5 c12 = (1 · 4) = 4 .... c32 = (1 · 4) = 4 a’ B c’ 3 1 1 1 1 7 4 15 12 5 7 (1 x 3) (3 x 2) A 6 2 4 1 8 3 2 6 7 (1 x 2) (3 x 4) c11 = (1 · 3) + (1 · 7) + (1 · 5) = 15 c12 = (1 · 1) + (1 · 4) + (1 · 7) = 12 ŷ1 1 x11 x12 ŷ 2 1 x 21 x 22 ... ... ... ... ŷ i 1 x i1 x i 2 ... ... ... ... ŷ 1 x n n1 x n 2 x13 x 23 b 0 ... b1 xi3 b2 ... b 3 x n 3 X1 X 2 X 3 b c 1 8 26 2 0 24 1 8 1 2 (4 x 1) (3 x 1) c11 = (6 · 1) + (1 · 2) + (2 · 1) + (8 · 2) = 26 c21 = (2 · 1) + (8 · 2) + (6 · 1) + (0 · 2) = 24 c31 = (4 · 1) + (3 · 2) + (7 · 1) + ((-8) · 2) = 1 Die Gleichung der ersten Zeile lautet ausgeschrieben: ŷ1 1 b0 x11b1 x12b 2 x13b3 Es resultieren so viele Einzelgleichungen wie auch Fälle (n) vorhanden sind bzw. ein (n x 1)-Zeilenvektor. Addition und Subtraktion von Matrizen: • Die Matrizen A und B müssen die gleiche Ordnung/Größe aufweisen. Das Ergebnis der Addition bzw. Subtraktion ist die Matrix C der gleichen Ordnung wie A und B. A B C 2 2 2 5 4 3 4 2 3 4 1 2 3 1 2 1 1 2 (3 x 2) y1 1 x11 y 2 1 x 21 ... ... ... y i 1 x i1 ... ... ... y 1 x n n1 (3 x 2) x12 x 22 ... xi2 ... xn2 (3 x 2) x13 e1 x 23 b 0 e 2 ... b1 ... x i 3 b 2 ei ... b 3 ... e x n 3 n (n x 1)-Zeilenvektor A B C 2 2 2 1 0 3 4 2 3 4 7 6 3 1 2 1 5 0 (3 x 2) (3 x 2) (3 x 2) y1 (b 0 x b) e1 y 2 (b 0 x b) e 2 ... ... ... y i (b 0 x b) ei ... ... ... y (b x b) e n 0 n Die Gleichung der ersten Zeile lautet ausgeschrieben: y1 b0 x11b1 x12b 2 x13b3 e1 Zum Abschluss noch weiteres Grundlegendes: Transponieren einer Matrix • Werden die Zeilen und Spalten einer (n x m)-Matrix B vertauscht, so entsteht die zu B transponierte Matrix oder die Transponierte von B. • B’ ist eine (m x n)-Matrix, wenn B eine (n x m)-Matrix ist. 1 2 3 4 5 6 B 7 8 9 10 11 12 1 4 7 10 ' B 2 5 8 11 3 6 9 12 Und ein paar Begrifflichkeiten, die wir nicht näher erörtern können: • Inverse einer Matrix B/Reziprokmatrix von B: B-1 - hierbei benötigt man die Determinante der Matrix B: |B|, (Determinante sollte immer ungleich Null sein, d.h. die Matrix ist dann nicht singulär) sowie die Adjustierte Matrix von B: adj(B) und den Rang einer Matrix Wir schauen und nun die Kennwerte der multiplen Regression an: • • • • • • • R2 (Multipler Determinationskoeffizient) R2korr. (hier relevant) Diesen kennen wir bereits! R (Multiple Korrelation) bj (Partieller Regressionskoeffizient) und a Betaj ≠ r (standardisierter partieller b) Standardfehler F-Test, T-Test Beide Tests unterscheiden sich zur einfachen Regression. Das wissen wir bereits! • Konfidenzintervall Multipler Determinationskoeffizient R2: Erklärte Variation R Beta j Pearson' s ryx Gesamtvari ation 2 Der Wertebereich ist [0; +1]. Interpretation: R2 besagt, dass die Variablen X1 bis Xn .... % (R2 ∙ 100) die Variation der Variable Y linear erklären bzw. determinieren. • R2 ist i.d.R immer kleiner als die Summe der einzelnen Determinationskoeffizienten, weil u.a. die Korrelation der Prädiktoren untereinander herauspartialisiert (herausgerechnet) wird (siehe im Detail Betaj). Der korrigierte R2-Wert berechnet sich unverändert: R 2 korr J (1 R 2 ) R K J1 2 Multipler Korrelationskoeffizient R: R R2 Beta j Pearson' s ryx Der Wertebereich ist weiterhin [-1; +1], wobei R in SPSS vorzeichenlos ist. • R erfasst den Zusammenhang zwischen den k unabhängigen Variablen und der abhängigen Variablen. R ist ebenfalls um die Korrelationen der Prädiktoren untereinander bereinigt (siehe im Detail Betaj). • Berechnet man zwischen den vorhergesagten y’-Werten und den erhobenen y-Werten eine bivariate Produkt-Moment-Korrelation, erhält man als Resultat die multiple Korrelation. • Es gilt nicht wie in der einfachen linearen Regressionsanalyse unter Zugrundelegung von z-transformierten Variablen, dass: Beta = r = cov(x,y), sondern lediglich, dass a = 0 ist. Partialisierung im Drei-Variablen-Fall (X1, X2 und Y): 1) Pearson’s ryx: Korrelation ohne Partialisierung (übersetzt: Herausrechnung, Bereinigung) 2) Partielle Korrelation: • gibt die Korrelation zwischen Y und X1 unter KONSTANTHALTUNG aller anderen Variablen (hier: X2) an. D.h. der Einfluss von X2 wird aus Y und X1 herausgerechnet (herauspartialisiert) • Man berechnet die Korrelation der Regressionsresiduen, die sich aus der Regression: X2 X1 und X2 Y ergeben. ryx1 x 2 ryx1 ryx 2 rx1x 2 1 ryx2 2 1 rx21x 2 • Zudem: r ist maßgeblich für die Aufnahme der 1. unabhängigen Variable in der Schrittweisen Methode. Nach der partiellen Korrelation richtet sich die Aufnahme der 2., 3., 4. etc. unabhängigen Variable. 3) Semipartielle Korrelation (ry(x1-x2)): Der Einfluss von X2 wird nur aus X1, aber nicht aus Y, herausgerechnet; ist relevant für R2 jedes einzelnen X Partialisierung im Drei-Variablen-Fall (X1, X2 und Y): Standardisierter partieller Regressionskoeffizient Betaj: • gibt den Einfluss von X1 auf Y nach Herauspartialisierung des Einflusses aller anderen Variablen (hier: X2) an. Beta yx1 x 2 ryx1 ryx 2 rx1x 2 1 rx21x 2 Beta ist (1) um die Korrelation der Prädiktoren untereinander (rx1x2) sowie (2) um die Korrelation der übrigen Prädiktoren (hier: X2) mit Y (ryx2) bereinigt. Der Einfluss von X2 wird aus X1 und Y herausgerechnet. Partieller Regressionskoeffizient bj: b j Beta j sy sx Beta j b j sx sy a in der einfachen Regression: a y b x Regressionskonstante a bzw. b0: Bei 2 unabhängigen Variablen: a y b1 x1 b2 x 2 Bei 4 unabhängigen Variablen: a y b1 x1 b 2 x 2 b3 x 3 b 4 x 4 Interpretation: a spiegelt den Erwartungswert für Y wider, unter der Bedingung, dass die X-Variablen (X1 bis Xn) den Wert Null annehmen. Beispiel: metrische und kategoriale X-Variablen, Y = Einkommen • a = Erwartungswert für Y, wenn X den Wert Null annimmt (z.B. Mittelschicht = 0 und Oberschicht = 0 und Alter = 0) • D.h. für Personen der Unterschicht (Code = 1) wird im Durchschnitt ein Einkommen von a erwartet, wenn sie ein Alter von 0 aufweisen (≠ Mittelwert der Referenzgruppe). Beispiel: metrische und kategoriale X-Variablen, Y = Einkommen • bMittelschicht, Oberschicht = unabhängig vom Alter (unter Kontrolle/ Konstanthaltung des Alters) wird ein Anstieg/Abstieg des Einkommens bei den betrachteten Gruppen j (z.B. Mittel- und Oberschicht im Vergleich zur Referenzgruppe Unterschicht) erwartet (≠ Mittelwertsdifferenz der Gruppe j zur Referenzgruppe) • bAlter = unabhängig von der Schichtzugehörigkeit (für alle 3 betrachteten Gruppen Unter-, Mittel- und Oberschicht) wird ein Anstieg/Abstieg des Einkommens bei steigendem Alter um b Einheiten erwartet Standardfehler: Der Standardfehler von bj (sbj) = 2 (y y' ) i i Varianz von b 2 K J 21 s x n (1 rX1,X 2 ) neu Zur Erinnerung: F-Test F-Test in der multiplen Regressionsanalyse: • Die Nullhypothese H0 lautet: β1 = β2 = … = βj = 0 • Die Alternativhypothese H1 lautet: mindestens ein β-Parameter ≠ 0 (β0 ist nicht eingeschlossen) Unveränderte Formel: Fempirisch Erklärte Variation/ J Nicht erklärte Variation/ (K J 1) Zur Erinnerung: T-Test T-Test in der multiplen Regressionsanalyse: • Es werden so viele T-Tests durchgeführt wie auch Regressionsparameter im Modell (b0 und bj) vorhanden sind. • Die Nullhypothese H0 lautet: β0 = 0, β1 = 0, …, βj = 0 • Die Alternativhypothese H1 lautet: β0 ≠ 0, β1 ≠ 0, …, βj ≠ 0 Unveränderte Formel: t empirisch b sb Zudem: Auch werden so viele Konfidenzintervalle berechnet wie Regressionsparameter im Modell (b0 und bj) vorhanden sind. Unveränderte Formel: b t s b β b t s b Darstellung der Ergebnisse in der Praxis - Ein paar Beispiele - Darstellungsbeispiel I zur linearen Regressionsanalyse: Wasmer/Koch (2000: S. 272) Darstellungsbeispiel II zur linearen Regressionsanalyse: Bergmann/Erb (2000: S. 428) Darstellungsbeispiel III zur linearen Regressionsanalyse: Lüdemann (2000: S. 386) Darstellungsbeispiel IV zur linearen Regressionsanalyse: Alba/Johnson (2000: S. 244) Tabellarische Aufbereitung der Ergebnisse • • • • Korrelationen (optional) bj und βj (Betaj), also die un- und standardisierten Regressionskoeffizienten Konstante a (uneinheitlich) Signifikanzen bzw. T-Wert (uneinheitlich), aber i.d.R.: Signifikanzniveau p > 0.05 p ≤ 0.05 p ≤ 0.01 p ≤ 0.001 Bedeutung nicht signifikant signifikant hoch signifikant höchst signifikant Symbolisierung ns, n.s. * ** *** Erläuterung unterhalb der Tabelle platziert • R2 bzw. korrigiertes (adjusted) R2 • N (in Tabelle oder Text) • Bei Dummyvariablen Referenzkategorie ausgewiesen