PowerPoint-Präsentation

Werbung

Markow-Ketten

Jens Keienburg, Nora Rieber,

Samuel Bandara, Felix Bonowski

Übersicht

• Definitionen

• Veranschaulichung; ‚Bienen-Modell‘

– die Übergangsmatrix

– die Grenzmatrix

• Anwendung in Genomics

Stochastischer Prozess

•

•

•

•

•

Folge von Zufallsexperimenten

beschreibbar durch Funktion X(t), t g T

X(t): ‚Zufallsvariable‘

T: ‚Parameterraum‘

M: ‚Zustandsraum‘; M = {X(t) | t g T}

• Bsp: n-maliger Münzwurf

Markow-Ketten

• diskret in Zeit und Raum

• Besonderheit: Wahrscheinlichkeit eines

Zustands hängt nur von der

Wahrscheinlichkeit des vorherigen ab

• Markow-Kette ist bestimmt durch

– Anfangsverteilung

– Übergangswahrscheinlichkeiten

– ihren Zustandsraum

Das Bienen-Modell

Chrysantheme

Akelei

• Wohin geht die

Biene als nächstes?

Tulpe

Geranie

Übergangswahrscheinlicheiten

Chrysantheme

1/2

1/3

1/3

1/2

Akelei

Tulpe

1/4

1/3

1/3

1/3

1/4

1/3

1/4

Geranie

A

G

C

T

A

1/3

1/3

1/3

0

G

1/4

1/4

1/4

1/4

C

1/2

0

0

1/2

T

0

1/3

1/3

1/3

1/4

Die Übergangsmatrix

• P=

• Allgemein:

in der i-ten Zeile und der k-ten Spalte

Wahrscheinlichkeit pik für einen Übergang

vom Zustand i in den Zustand k

Die Übergangsmatrix

• P=

• Matrix ist stochastisch

pik g [ 0;1]

i,k = 1,2,...,N

Mehrstufige Übergänge

Chrysantheme

• Wo ist die Biene in

n Zügen?

Akelei

Tulpe

• Grenzwert?

Geranie

Definitionen

• p(n)= (p1(n), p2(n), …, PN(n))

Wahrscheinlichkeiten für jeden Zustand

nach n Durchgängen

• Anfangsverteilung: p(0)

• z.B. (1 0 0 0) Biene sitzt auf Akelei

• oder (0.25 0.25 0.25 0.25) Anfangsort

unbekannt

Spätere Verteilungen

• Zustände auf mehreren Wegen erreichbar

• Nächster Zustand durch Anwendung der

Übergangsmatrix zugänglich

• p(n+1)= P*p(n)

Beispiel:

p(0) *

n

= p(n)

Langfristiges Verhalten

• Die Matrix limn ¥(P)n heißt Grenzmatrix

• Wenn sie existiert erlaubt sie Aussagen über

das langfristige Verhalten des Systems.

• In unserem Beispiel:

• limn ¥(P)n =

Diskussion des Beispiels

• In unserer Grenzmatrix sind die Elemente

einer Spalte gleich (Ergodische Matrix)

Jede Anfangsverteilung führt im Grenzwert

zur gleichen Verteilung

p(¥)= (0,265 0,235 0,235 0,264)

• Das dann der Fall, wenn es zwischen allen

Zuständen irgendeinen zulässigen Weg gibt.

Wahrscheinlichkeiten von Pfaden

Chrysantheme

Akelei

•Pfad: (C T G C A)

Tulpe

Geranie

p(CTGCA)=p(C®T)*p(T®G)…

*P(G®A)

Zwei Gärten…

Garten 1 mit Übergangsmatrix P1

C

A

Gegeben: Die Biene hat die

Blumen in der Reihenfolge

CTGATC besucht.

T

G

Frage: In welchen Garten war

sie?

C

A

T

G

Garten 2 mit Übergangsmatrix P2

Genomics

Problematik :

Entschlüsselung des Genoms

Welche Bereiche codieren ?

Wo befinden sich Gene?

Genomics

Gene Prediction :

Codierende und nicht codierende DNA-Sequenzen besitzen

unterschiedliche Übergangswahrscheinlichkeiten.

Mit Hilfe von Markovketten lassen sich Gene zuverlässig

finden !

Genomics

Definition :

Ein Open Reading Frame (ORF) ist eine

Gensequenz, die von einem Start- und einem

Stopcodon terminiert wird.

Ein Gen ist ein codierender ORF

Jeder ORF ist ein möglicher Kandidat für ein Gen.

Wesentlich mehr ORF als Gene.

Genomics

Markowmodell :

Xt(b) sei Zufallsvariable

T ist Indexmenge mit T ={1, ...N}, wobei N = Anzahl der Basen

Zustandsraum B ={A, C, T, G}, und b1, b2, ... g B

Markow‘sche Eigenschaft :

P( Xn(b) = b1 | Xn-1(b) = b1 , Xn-2(b) = b2, ... ) = P( Xn(b1) | Xn-1(b2) )

Genomics

Produkt aller Wahrscheinlichkeiten ist ein Maß für die

Wahrscheinlichkeit eines Gens.

Genom :

Abhängigkeit Xn von Xn-1, ... Xn-j

mit 0 < j < 8 ist Grad der Markowkette

Auf jedes j-Tupel von Basen folgt eine Base.

Erfassung der Übergangswahrscheinlichkeiten mit einer

höher dimensionalen Übergangsmatrix.

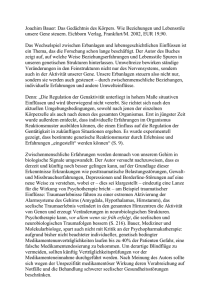

Genomics

Versuch am Genom von E. Coli liefert folgende Ergebnisse

score

ORFs

0.07

Gene

1.49

0.08

1.46

1.43

1.4

1.37

1.34

1.31

1.28

1.25

1.22

1.19

1.16

1.13

1.1

1.07

1.04

1.01

0.98

0.95

0.92

0.89

0.86

0.83

0.8

0.77

0.74

0.71

0.68

0.65

0.62

0.59

0.56

0.53

0.5

rel. Häufigkeit

Verteilung von Genen und ORFs :

0.09

0.06

0.05

0.04

0.03

0.02

0.01

0

Gene Prediction

Ergebnisse :

1) Der Algorithmus identifiziert ein Gen mit einer

Wahrscheinlichkeit von 94% richtig.

2) ORFs werden zu weniger als 10% fälschlicherweise als Gene erkannt.

Vielen Dank für Eure

Aufmerksamkeit!