Folien - Johannes Gutenberg

Werbung

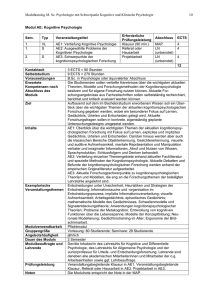

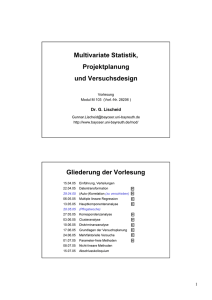

Methoden der Psychologie Multivariate Analysemethoden Multivariate Distanz – Multivariate Normalverteilung Minimum Distance Classifier – Bayes Classifier Günter Meinhardt Johannes Gutenberg Universität Mainz Methoden der Psychologie Klassifikation Multivariate Klassifikation Ziele • Einordnen von Fällen (Versuchspersonen, Beobachtungen) in Gruppen aufgrund ihrer Werte in mehreren Meßvariablen. • Maßgeblich für die Zuordnung zu eine Gruppe ist a) die Methoden Wahrscheinlichkeit des Auftretens des Falles in der Zielgruppe (falls ermittelbar) oder b) die Distanz des Falles vom charakteristischen Wert der Gruppe (Prototyp, Zentroid) • Deskriptive Methoden: * Bestimmung von Distanzen und Wahrscheinlichkeiten auf dem Set der beobachteten Meßvariablen • Analytische Methoden: * Bestimmung von Distanzen und Wahrscheinlichkeiten auf transformierten Meßvariablen mit dem Ziel, die Separation von Gruppen zu maximieren (Diskriminanzanalytische Methoden) • Weitere Kriterien sind Kosten von Fehlklassifikationen und die apriori Wahrscheinlichkeit von Gruppen (Allg. Likelihood-Ratio und Bayes-Klassifikation) Methoden der Psychologie Kreis Iso-Distanz Konturen in 2D Klassifikation Iso-Distanz-Konturen in 2D Kreis mit Radius c: Alle Punkte auf dem Kreisbogen haben euklidischen Abstand c zum Kreismittelpunkt c2 x2 y 2 c x2 y 2 c y x • Der Kreis ist die Grundform der Iso-Distanz Kontur im zweidimensionalen Raum (p = 2). • Er entspricht im Variablenraum einer Iso-Distanz-Kontur für 2 unkorrelierte (orthogonale) Variablen mit derselben Skalierung. Methoden der Psychologie Ellipse: Skalierung Klassifikation Iso-Distanz Konturen in 2D Ellipse mit Ellipsenradius c: Alle Punkte auf dem Ellipsenbogen haben, auf Standardskala normiert, denselben Abstand c zum Mittelpunkt 2 2 y0 c b x y c2 a b y x x0 c a v c2 u 2 v2 Standardskala: x u a y v b u Methoden der Psychologie Ellipse Translation Klassifikation Iso-Distanz Konturen in 2D Translation zum Punkt (x0,y0) ändert an dieser Eigenschaft nichts: y ( x0 , y0 ) x x0 y y0 c2 a b 2 2 x v c2 u 2 v2 Standardskala: StandardTransformation u x x0 a v y y0 b u Methoden der Psychologie StandardEllipse Neigung Korrelation r Die Invarianz der Distanz im neuen Koordinatensystem mit geneigten Achsen (Korrelation der Variablen) ist über eine Rotation der Koordinaten (anticlock) erklärt: c 2 x 2 y 2 2 r xy [Tafel: cos ] u2 r1 r2 c2 u 2 v2 r cos y Koordinaten Korrelierte Achsen Klassifikation Iso-Distanz Konturen in 2D x u1 Mit der Transformation v u u u1 a v erfüllen alle Ellipsenpunkte: c2 u 2 v2 u2 b Methoden der Psychologie StandardEllipse: ZeichenRoutine Klassifikation Iso-Distanz Konturen in 2D Ellipsen sind in kartesischen Koordinaten unpraktisch zu zeichnen. Man geht über zur Darstellung in Polarkoordinaten. c 2 x 2 y 2 2 r xy y r x kartesisch r x, y r y polar r, Es gelten die Transformationen: x polar kartesisch x r cos y r sin r 2 x2 y 2 kartesisch polar y tan 1 x Zum Zeichnen muß die Ellipsengleichung als Gleichung in Polarkoordinaten (Vektorlänge in Abhängigkeit des Winkels ) umgeschrieben werden Methoden der Psychologie StandardEllipse: ZeichenRoutine Iso-Distanz Konturen in 2D Von der Darstellung in Polarkoordinaten kann einfach in kartesische Koordinaten zurückgerechnet werden (Setzen der Ellipsenpunkte) c 2 x 2 y 2 2 r xy Setze damit y r x r y y x c 2 x 2 1 q 2 2 r q q x x c 1 q2 2r q r x2 y 2 x Verfahren 1 q 1. Variiere von –p bis p (= ein Kreisumlauf). 2. Für jeden Winkel berechne q = tan-1(). 3. Berechne dann x 4. Berechne damit r. 5. Berechne dann x,y: [Excel-Sheet] x r cos y r sin 2 Methoden der Psychologie 1 D-Normal Verteilung Klassifikation Multivariate Normalverteilung Die Funktion f x e 1 x 2 2 hat Fläche 2p Die auf die Fläche 1 normierte Funktion 1 f x e 2p 1 x 2 z 2 heißt Normalverteilung (Gauss-Verteilung). Mit ihr sind Wahrscheinlichkeiten als FlächenAnteile für z - Standardvariablen definierbar. x 1 12 z 2 f z e 2p (Standard-NV) f(z) f(z) 0.4 68.26% 0.3 [Kurzübung] -3 -2 -1 0.4 0.2 0.2 0.1 0.1 1 2 3 z 95.5% 0.3 -3 -2 -1 1 2 3 z Methoden der Psychologie Klassifikation Mahalanobisdistanz 1 x z2 x 2 x 2 p-variater Fall Man bemerke daß ist. Man habe nun nicht eine, sondern p Variablen: x1 x2 x xp mit Zentroid 1 2 p (jeder Messpunkt ist ein p- dimensionaler Vektor und der Zentroid ist ein p- dimensionaler Vektor) Dann definiert MahalanobisDistanz [Excel-Beispiel 2D] 2 x Σ 1 x t mit Σ1 die Inverse der VarianzKovarianz Matrix S. die verallgemeinerte quadrierte Distanz im multivariaten Raum. Sie heißt quadrierte Mahalanobis-Distanz. 1 1 0.5 3 2 x Σ 4 0.5 1 1 2 Methoden der Psychologie p D-Normal Verteilung Klassifikation Multivariate Normalverteilung Die Funktion f x e 1 x t Σ1 x 2 hat Volumen 2p p/2 Σ 1/ 2 Die auf Volumen 1 normierte Funktion f x 1 2p p/2 Σ 1/ 2 e 1 x t Σ1 x 2 heißt multivariate Normalverteilung (multivariate Gauss-Verteilung). Mit ihr sind Wahrscheinlichkeiten als Anteile des Gesamtvolumens eines p-dimensionalen Ellipsoids definiert. Die in ihrem Argument auftretende Mahalanobis-Distanz erfüllt die Bedingung: 2 x Σ 1 x p2 t mit einem zu setzenden alpha-Fehler Niveau. Alle Mahalanobisdistanzen , die diese Bedingung erfüllen, erzeugen Konturen gleicher Wahrscheinlichkeit (iso-probability contours) mit P = 1- in der multivariaten Normalverteilung. Methoden der Psychologie 2 D-Normal Verteilung Klassifikation Multivariate Normalverteilung Die multivariate Normalverteilung mit p = 2 Variablen (bivariate Normalverteilung) hat die Form f x1 , x2 1 2p 12 22 1 r 2 e 1 2 1 r 2 x 2 x 2 x x 1 1 2 2 2 r 1 1 2 2 1 2 1 2 Die im Argument auftretende Mahalanobis-Distanz definiert eine Ellipse im zweidimensionalen Raum für jede Konstante c: c 2 2 x Σ 1 x t 2 2 x1 1 x2 2 x1 1 x2 2 1 2r 2 1 r 1 2 1 2 Diese ist eine Iso-Probability-Contour im obigen Sinne (s. multivariate NV, vorherige Folie) [Tafelbetrachtung] Methoden der Psychologie 2 D-Normal Verteilung Klassifikation Multivariate Normalverteilung Bivariate Normalverteilung mit p = 2 Variablen und Korrelation r = 0.6 0 0 Density-Plot Contour-Plot f x1 , x2 x2 P=0.95 2 P=0.75 1 P=0.5 P=0.25 x2 -2 -1 1 x1 0.75 0.57 2 2 x1 -1 2 2 -2 2 22 0.5 1.38 2 22 0.05 5.99 2 22 0.25 2.77 [Excel-Übung] Ellipsen gleicher Wahrscheinlichkeit und zugehöriges Distanzmaß (quadrierte Mahalanobis-Distanz) Methoden der Psychologie Iso-Distanz Konturen in 2D x 2 x 2 x1 1 x2 2 1 1 1 2 2 c2 2 r 2 1 r 1 2 1 2 NV-2DEllipse: ZeichenRoutine q Setze y x und temporär (NV-Ellipse) 1 0, 2 0 2 2 1 x qx x qx c 2r 2 1 r 1 2 1 2 2 x2 r r x 3. Berechne dann x2 x1 1 q2 rq 2 1 c x 2 1 r 2 12 22 1 2 2 x 1 2 c 1 1 q2 rq 2 1 r 2 12 22 1 2 Und es gilt: Verfahren a) läuft von –p bis p (= ein Kreisumlauf) b) r [Excel-Sheet] x12 x22 x 1 q 2 c) x1 r cos 1 x2 r sin 2 Methoden der Psychologie p D-Normal Verteilung Klassifikation Multivariate Normalverteilung Die Ellipsen der Form c 2 x Σ 1 x p2 t sind zentriert in c i ei und haben Hauptachsen mit Eigenwertbedingung Σei i e Eine Eigenwertzerlegung der Varianz-Kovarianz Matrix liefert somit die Hauptachsen des p- variaten Ellipsoids der multivariaten Normalverteilung x2 Beispiel 2D Länge = c 1 2 x1 Länge = c 2 1 Methoden der Psychologie MDC Klassifikation Minimum Distance Classifier Mit der Mahalanobisdistanz für eine Beobachtung der Gruppe cj x zum Zentroid x j Σj 1 x j t 2 j definiere die Regel: Gruppiere x in Gruppe ci, wenn gilt i2 min 12 , 22 , MDC-Regel , 2j , 2k Die Performance des MDC läßt sich mit großen Stichproben für die k – Gruppen mit einer Konfusions-Matrix bewerten: Häufigkeit zur Einordnung von Fall (Zeile) in Gruppe (Spalte) Case c1 c2 allocated to group c1 c2 cj ck h11 h12 h1 j h1k h21 h22 h2 j h2 k cj h j1 hj2 h jj h jk ck hk 1 hk 1 hkj hkk x is group Methoden der Psychologie Confusionmatrix Hits Klassifikation Minimum Distance Classifier c1 c2 c1 h11 h21 c2 h12 h22 cj h1 j h2 j ck h1k h2 k cj h j1 hj2 h jj h jk ck hk 1 hk 1 hkj hkk Korrekte Klassifizierungen sind die Häufigkeiten auf der Diagonalen: ho i 1 hii k Erwartete Häufigkeiten bei Zufall (anteilige Gleichverteilung) Mit den Zeilensummen hˆij p j hi hi und N der Summe aller Häufigkeiten gilt (erwartete Zellhäufigkeit) mit pj der A-priori Wahrscheinlichkeit der Gruppe cj pj kann ggf. aus den empirischen Gruppenstärken über pj = hi/N geschätzt werden, wenn keine Information über die A-priori Wahrscheinlichkeiten vorliegt. Methoden der Psychologie Erwartete Confusionmatrix Dann ist k hˆ i 1 hˆii die erwartete Hit-Häufigkeit. Mit Hits Erwartete Häufigkeiten bei Zufall (anteilige Gleichverteilung) Klassifikation Minimum Distance Classifier hˆ pe N c1 c1 hˆ 11 c2 hˆ cj hˆ ck hˆ c2 hˆ21 hˆ22 hˆ2 j hˆ2 k ci hˆi1 hˆi 2 hˆij hˆik ck hˆk 1 hˆk 1 hˆkj hˆkk 12 1j 1k 2 N pe 1 pe ist ho normalverteilt über die Approximation der Binomialverteilung wenn N pe 1 pe 9 gilt. Dann testet der z- Test z ho Npe N pe 1 pe die Hitrate des MDC gegen den Zufall. Methoden der Psychologie A-priori Wahrscheinlichkeit der Gruppen Klassifikation Bayesian Classifier Man habe Information über die A-priori Wahrscheinlichkeiten der Gruppen cj: P c1 , P c2 , , P c j , P ck Dann liefert eine Klassifikation der Beobachtung A-posteriori WK x nach ihrer A-posteriori Wahrscheinlichkeit P c j x eine korrektere Zuordnung als nur nach der kürzesten Distanz zum Gruppenzentroid. Max-Aposteriori WKn Classifier Normalverteilungsannahme Regel: Gruppiere x in Gruppe ci, wenn gilt P ci x max P c2 x , P c2 x , , P c j x , P ck x Um die A-posteriori WKn zu berechnen, muss für die LikelihoodFunktionen die Annahme der multivariaten Normalverteilung gelten. Methoden der Psychologie Likelihoods Klassifikation Bayesian Classifier Mit der multivariaten Normalverteilung haben die Likelihoods die Form P x cj f x cj A-posteriori WK 2p p/2 Σj 1/ 2 e 1 2j 2 x j Σj 1 x j 2 j mit t der quadrierten Mahalanobisdistanz zum Gruppenzentroid KlassifikationsRaum j Der Klassifikationsraum ist durch alle Gruppen vollständig partitioniert. c2 x c1 c4 Normalverteilungsannahme 1 c3 Es gilt: x x c1 x c2 x ck Und wegen der Disjunktheit: P x P x c1 P x c2 P x ck Methoden der Psychologie Likelihoods Klassifikation Bayesian Classifier Da P x cj P x cj P c j (Def. der bedingten Wahrscheinlichkeit), folgt Satz der totalen WK P x P x c1 P c1 P x c2 P c2 P x ck P ck Und damit Satz von Bayes P ci x P x ci P ci P x c P c j j j der Satz von Bayes für die A-posteriori WK der Gruppe ci, gegeben die multivariate Beobachtung Normalverteilungsannahme Die approximative Gültigkkeit der multivariaten NV kann durch Q-Q-Plot Methoden überprüft werden.