Vortragsfolien

Werbung

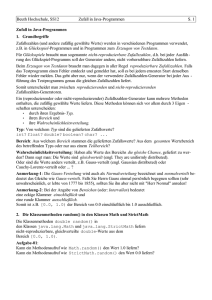

Besondere Aspekte in Multimedia-Datenbanken Methoden zur iterativen Anfrageverfeinerung (Relevanz Feedback) 12.06.2002 Niko Zenker 1 Gliederung I. II. III. IV. 12.06.2002 Motivation Methoden zur Anfrageverfeinerung Auswertungen der Verfeinerungsmechanismen Zusammenfassung Niko Zenker 2 Motivation keine genauen Kenntnisse über den Aufbau der DB und Retrieval-Umgebung Anfragen beruhen auf dem Prinzip „Glück“ Verfeinerungen können per Hand realisiert werden durch Einführung von Relevanz-Feedback Methoden wird dieser Prozess teilautomatisiert 12.06.2002 Niko Zenker 3 Grundidee Auswählen von wichtigen Termen oder Ausdrücken, die an bestimmte vorherige Dokumente gebunden sind Dokumente, die der Benutzer vorher schon nicht sehen wollte, scheinen auch nicht von Interesse zu sein Ziel: gute Ergebnisse bei vagen Anfrangen 12.06.2002 Niko Zenker 4 Information Retrieval Anfrage Dokumente Verarbeitung Verarbeitung Dokumentdarstellung Anfragedarstellung Verlgeich (Ähnlichkeitsberechnung) Ergebnisdokumente Relevanzbewertung und Feedback 12.06.2002 Niko Zenker 5 Vektor-Modell Anfragen werden mittels Vektor an die entspr. Daten gestellt Qn (q1 , q2 ,..., qi ) mit i N und 0 qi 1 Relevanz Feedback Methode(n) generiert neuen Anfragevektor Q (q1, q2 ,..., qi) 12.06.2002 Niko Zenker 6 Anfrageverfeinerung Vektor Abgleich Ide dec-hi (Vector Adjustment) Qnew Qold Fügt die Gewichte der Terme, der Dokumente direkt zu den Anfragetermen hinzu. Benutzt alle relevanten, aber nur die höchst unrelevanten zurückgelieferten Terme. Di all relvant 12.06.2002 Niko Zenker D i one nonrelevant 7 Anfrageverfeinerung (II) Vektor Abgleich Ide regular (Vector Adjustment) Qnew Qold Fügt die aktuellen Gewichte der Terme, der Dokumente direkt zu den Anfragetermen hinzu. Benutzt alle relevanten, und alle unrelevanten zurückgelieferten Terme. Di all relvant 12.06.2002 Niko Zenker D i all nonrelevant 8 Anfrageverfeinerung (III) Vektor Abgleich Standard nach Rocchio (Vector Adjustment) Reduziert die Termgewichte durch Division mit der Anzahl der entsprechenden Dokumente. Qnew Qold n1 rel doc Di n1 n2 nonrel doc Di n2 1 12.06.2002 Niko Zenker 9 Wahrscheinlichkeitsfeedback Ziel ist es, die Dokumente nach ihrer Wahrscheinlichkeit zu ordnen, die vom Benutzer als relevant in Bezug auf die Query eingestuft wurden Pr( x | rel ) log Pr( x | nonrel ) 12.06.2002 Niko Zenker 10 Anfrageverfeinerung (IV) Verhältnis, der Wahrscheinlichkeiten der relevanten zu den nichtrelevanten Termen der RetrievalErgebnisses. konventionelles Wkt.-feedback (Probabilistic conventional) qinew 12.06.2002 pi (1 ui ) log ui (1 pi ) ri 0,5 R 1,0 n r 0,5 ui P( xi | nonrel ) i i N R 1,0 pi P( xi | rel ) Niko Zenker 11 Anfrageverfeinerung (V) angepassetes Wkt.feedback bzgl. der Herkunft (Probabilistic adjusted derivation) qinew 12.06.2002 pi(1 ui) log ui (1 pi ) Verallgemeinerung des konventionellen Modells, im Bezug auf das Auftreten bestimmter Dokumente. ni N pi P( xi | rel ) R 1 ri ni N ui P( xi | nonrel ) N R 1 Niko Zenker ni ri 12 Beispiel 500 Dokumente in der DB (N) 100 mit den gewünschten Informationen (ni) 25 werden als relevant markiert (R) nur 10 dieser als relevant markierten Dokumente enthalten die gewünschte Information (ri) 12.06.2002 Niko Zenker 13 Beispiel (II) 10 0,5 100 10 0,5 pi ui 25 1,0 500 25 1 qinew 0,48536662 100 100 10 100 10 500 u 500 pi i 25 1 500 25 1 qinew 0,44109877 12.06.2002 Niko Zenker 14 Anfrageverfeinerung (VI) angepassetes Wkt.feedback bzgl. der Herkunft (verbessert) (Probabilistic adjusted derivation revised) qinew 12.06.2002 selbe Prinzip wie zuvor, nur mit anderen Werten für R‘ = R+3 und ri‘=ri+3 pi(1 ui) log ui (1 pi ) ni N pi P( xi | rel ) R 1 ri ni N ui P( xi | nonrel ) N R 1 Niko Zenker ni ri 15 Auswertung der Methoden die Effizienz der Methoden, errechnet man durch einen Vergleich der ersten Iteration des Feedback-Verfahrens und der Initiationssuche normalerweise benutzt man Recall und Precision Messungen um dieses Ergebnis zu errechnen 12.06.2002 Niko Zenker 16 Precision & Recall relvante Dokumente Precision gefundene relevante Dokumente alle gefundenen Dokumente Recall gefundene relevante Dokumente__ gespeicherte relevante Dokumente Menge aller Dokumente 12.06.2002 Niko Zenker gefundene relevante Dokumente 17 Auswertung der Methoden (II) die Auswertung der Feedback-Dokumente wird erschwert weil sich die Ergebnisse teils deutlich vom echten Feedback-Ergebnis unterscheiden der User will nicht zweimal das selbe Dokument sehen die Relevanz-Feedback Operation muss entscheiden, ob sie neue Dokumente anzeigt, die nicht ursprünglich vom User gesehen wurden 12.06.2002 Niko Zenker 18 Partial Query Expansion vs. Full Query Expansion FQE: alle Anfragevektoren haben die selbe Länge wie der Ursprung Gewichtungen werden verändert PQE: 12.06.2002 reduzieren auf durchschnittliche Länge der Anfragevektoren Terme mit hoher Frequenz werden übernommen Niko Zenker 19 Ergebnisse aus der Forschung gewichtete Terme produzieren bessere Ergebnisse beim Feedback-Prozess full expansion erweist sich als besser als partial expansion die beste Feedback-Methode ist: „Ide dec hi“ Wahrscheinlichkeits-Feedback ist im Allgemeinen schlechter als Vektor-Feedback 12.06.2002 Niko Zenker 20 Optimierung des Feedbacks die durchschnittliche Länge der Anfrage ist von besonderem Interesse schlechte Initial-Ergebnisse iterieren meist mit guten Ergebnissen präzise gestellte Anfragen werden vom Feedback-Prozess besser adaptiert 12.06.2002 Niko Zenker 21 Zusammenfassung Relevanz-Feedback ist eine „billige“ Methode für die Neuformulierung von Anfragen mit Bezug auf die vorherigen Ergebnisse wegen der Einfachheit der Veränderungen der Anfragen, sollten Relevanz-Feedback-Systeme in jedes Text-Retrieval-System eingebunden werden 12.06.2002 Niko Zenker 22