Statistik II - IV. Hypothesentests

Werbung

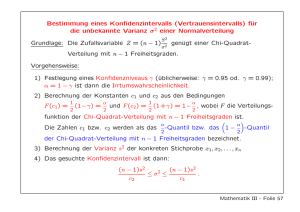

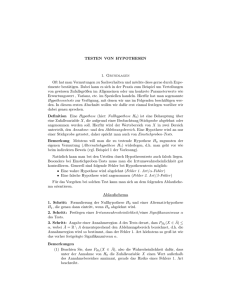

Statistik II IV. Hypothesentests Martin Huber 1 / 41 Übersicht Struktur eines Hypothesentests Stichprobenverteilung t-Test: Einzelner-Parameter-Test F-Test: Multiple lineare Restriktionen 2 / 41 Struktur eines Hypothesentests 1 Formuliere die Forschungshypothese und bestimme die zu testenden Parameter. Basierend hierauf kann die Nullhypothese H0 bestimmt werden. 2 Art der Verteilung (z.B. t-Verteilung, Normalverteilung) 3 Auswahl der Teststatistik 4 Bestimme das Signifikanzniveau (= Irrtumswahrscheinlichkeit, mit der eine korrekte Nullhypothese irrtümlicherweise abgelehnt wird) 5 Einseitiger oder zweiseitiger Test 6 Verwerfe die Nullhypothese (falls Testergebnis signifikant) oder behalte sie bei (falls insignifikant) 3 / 41 Stichprobenverteilung Annahme MLR.6: Normalität u ∼ N(0, σ 2 ) Der Fehlerterm ist unabhängig von den Kontrollvariablen und ist normalverteilt mit Mittelwert 0 und Varianz σ 2 . Annahme MLR.6 impliziert die Annahmen MLR.3 und MLR.5. Zusammenfassung der Annahmen MLR.1-MLR.6 (= Annahmen des klassischen linearen Modells) y |(x1 , x2 , ..., xk ) ∼ N(β0 + β1 x1 + β2 x2 + ... + βk xk , σ 2 ) 4 / 41 Annahme MLR.6: Normalität u ∼ N(0, σ 2 ) Zugrundeliegende Annahmen: Normalverteilung des Fehlerterms ist nicht unproblematisch, weil viele Faktoren keiner Normalverteilung folgen (z.B. Löhne sind nicht normalverteilt ⇒ logarithmische Transformation). Weitere (potenziell problematische) Annahme: Unbeobachtete Faktoren im Fehlerterm beeinflussen y in additiver Form. Nicht-normal verteilte Fehlerterme sind unproblematisch, wenn die Stichprobe gross genug ist, weil dann der Zentrale Grenzwertsatz anwendbar ist. Zentraler Grenzwertsatz: Die Summe/der Mittelwert einer grossen Zahl von unabhängigen Zufallsvariablen mit endlicher und positiver Varianz ist asymptotisch annähernd normalverteilt (sogar wenn die Variable selbst nicht normalverteilt ist!). 5 / 41 6 / 41 Konsequenz aus MLR.6: β̂j ∼ N βj , var (β̂j ) Standardisierung führt zu folgendem Ergebnis: β̂j − βj sd(β̂j ) ∼ N (0, 1) (Asymptotisch, d.h. in sehr grossen Stichproben wird MLR.6 aufgrund des Zentralen Grenzwertsatzes allerdings nicht benötigt!) 7 / 41 t-Test: Einzelner-Parameter-Test 1 Populationsmodell: y = β0 + β1 x1 + β2 x2 + ... + βk xk + u 2 Nullhypothese: H0 : βj = 0 3 t-Verteilung für standardisierter Schätzer: β̂j − βj se(β̂j ) ∼ tN−k−1 wobei N = Stichprobengrösse und k + 1 = Anzahl Parameter 4 Test Statistik = t-Statistik: tβ̂j ≡ β̂j /se(β̂j ) Beachte: I tβ̂j hat dasselbe Vorzeichen wie β̂j I gegeben se(β̂j ), tβ̂j steigt mit β̂j Interpretation: tβ̂j kann interpretiert werden als “wieviele Standardabweichungen liegt β̂j von null enfernt” 8 / 41 Einseitiger Hypothesentest: 1 Nullhypothese: H0 : βj ≤ 0 Alternativhypothese: H1 : βj > 0 2 Signifikanzniveau: α = 5% (alternativ α = 1%; 10%) 3 Verwerfungsregel: tβ̂j > c, wobei c dem 95sten Perzentil der t-Verteilung mit N − k − 1 Freiheitsgraden entspricht, auch kritischer Wert genannt Intuition: Verwerfe wenn tβ̂j “gross genug” ist, d.h. wenn tβ̂j nicht im 95sten Perzentil der t-Verteilung liegt. 9 / 41 10 / 41 11 / 41 Beispiel 12 / 41 Einseitiger Hypothesentest: 1 Nullhypothese: H0 : βj ≥ 0 Alternativhypothese: H1 : βj < 0 2 Signifikanzniveau: α = 5% (alternativ α = 1%; 10%) 3 Verwerfungsregel: tβ̂j < −c, wobei c dem 95sten Perzentil der t-Verteilung mit N − k − 1 Freiheitsgraden entspricht, auch kritischer Wert genannt 13 / 41 Beispiel: df = 18 (z.B. N = 20, k = 1) 14 / 41 Beispiel 15 / 41 Zweiseitiger Hypothesentest: 1 Nullhypothese: H0 : βj = 0 Alternativhypothese: H1 : βj 6= 0 2 Signifikanzniveau: α = 5% (alternativ α = 1%; 10%) 3 Verwerfungsregel: |tβ̂j | > c, wobei c dem (100% − α2 Perzentil der t-Verteilung mit N − k − 1 Freiheitsgraden entspricht I |tβ̂j | > c: β̂j ist statistisch signifikant bei einem Signifikanzniveau von α I |tβ̂j | < c: β̂j ist statistisch insignifikant 16 / 41 17 / 41 18 / 41 Beispiel 19 / 41 Weitere Hypothesen: H0 : βj = θj Zweiseitiger Hypothesentest H0 : βj = θj , H1 : βj 6= θj Test-Statistik: tβ̂j = β̂j − θj se(β̂j ) Signifikanzniveau: α = 5% Kritischer Wert: c = 1.96 (vorausgesetzt N ist gross genug) 20 / 41 Beispiel 21 / 41 22 / 41 p-Wert/p-value Der p-Wert entspricht dem niedrigsten Signifikanzniveau bei welchem wir H0 für eine gegebene t-Statistik verwerfen würden. ⇒ Signifikanzniveau der Test-Statistik p-Wert/p-value = P(|T | > |t|) 23 / 41 24 / 41 Beispiel 25 / 41 Konfidenzintervall Das Konfidenzintervall: β j = β̂j − c · se(β̂j ), β̄j = β̂j + c · se(β̂j )CI = [β j ; β̄j ] Angenommen man würde eine sehr (unendlich) grosse Anzahl an Stichproben aus der Population ziehen und in jeder β j und β̄j berechnen, dann würde der wahre Wert βj mit einer Häufigkeit von 1 − α (bezogen auf die Anzahl der gezogenen Stichproben) innerhalb von [β j ; β̄j ] liegen. (α gibt wiederum das Signifikanzniveau an.) Anders formuliert: Das Konfidenzintervall ist jenes Intervall, das bei unendlicher Wiederholung des Stichprobenziehung mit einer Häufigkeit von 1 − α den wahren Wert βj inkludiert. Für α = 0.05 ist der wahre Wert von βj in 95% der Stichproben inkludiert (in 5% allerdings nicht). 26 / 41 Illustration Quelle: Wikipedia 27 / 41 Illustration 28 / 41 t-Test: Einzelner-Parameter-Kombination 1 Lineares Modell: y = β0 + β1 x1 + β2 x2 + ... + βk xk + u 2 Nullhypothese: H0 : β1 = β2 oder H0 : β1 − β2 = 0 3 Test-Statistik: t= β̂1 − β̂2 se(β̂1 − β̂2 ) Ab hier gehen wir vor wie zuvor: Wähle das Signifikanzniveau und bestimme den entsprechenden kritischen Wert, oder berechne die t-Statistik und bestimme den entsprechenden p-Wert. Achtung: q q se(β̂1 − β̂2 ) = var (β̂1 − β̂2 ) = var (β̂1 ) + var (β̂2 ) − 2cov (β̂1 , β̂2 ) 29 / 41 Beispiel 30 / 41 F-Test: Multiple lineare Restriktionen Nicht restringiertes Modell: y = β0 + β1 x1 + β2 x2 + ... + βk xk + u Nullhypothese: H0 : βk−q+1 = 0, ..., βk−1 = 0, βk = 0 ⇒ Testen von Ausschlussrestriktionen (exclusion restrictions) Achtung: t-Test ist ungeeignet, da dieser die Parameter einzeln, unabhängig voneinander testet. Wir wollen die Parameter jedoch gemeinsam testen: Gemeinsamer Signifikanztest (“joint significance test”) Restringiertes Modell: y = β0 + β1 x1 + β2 x2 + ... + βk−q xk−q + u 31 / 41 F-Statistik: F = I I I I (SSRr − SSRur )/q SSRur /(N − k − 1) SSRr =Summe der quadrierten Residuen (sum of squared residuals: SSR) der restringierten Schätzung SSRur =SSR der nicht restringierten Schätzung q = Freiheitsgrade des Zählers = dfr − dfur N − k − 1 = Freiheitsgrade des Nenners Intuition: F-Statistik entspricht dem prozentualen Anstieg des unerklärten Teils, gewichtet mit den Freiheitsgraden Verwerfen: F > c (wobei c abhängt von q, N − k − 1 und α, mindestens ein Koeffizient ist statistisch signifikant) Nicht verwerfen: F ≤ c (Koeffizienten sind gemeinsam insignifikant) 32 / 41 33 / 41 34 / 41 F-Statistik: F = (SSRr − SSRur )/q SSRur /(N − k − 1) 2 ) können Gegeben, dass SSRr = SST (1 − Rr2 ) und SSRur = SST (1 − Rur wir die F-Statistik folgendermassen ausdrücken: F = 2 − R 2 )/q (Rur r 2 )/(N − k − 1) (1 − Rur Intuition: Die F-Statistik entspricht dem gewichteten Anstieg in R 2 wenn wir mehr Variablen mit ins Modell nehmen. 35 / 41 Beispiel (1) 36 / 41 Beispiel (2) 37 / 41 Beispiel (3) 38 / 41 F-Test: Test auf irgendwelche signifikanten Effekte (“overall significance test”) Besondere Form des Tests auf gemeinsame Signifikanz: ‘ Nullhypothese: H0 : β1 = 0, β2 = 0, ..., βk = 0 Nicht restringiertes Modell: y = β0 + β1 x1 + β2 x2 + ... + βk xk + u Restringiertes Modell: y = β0 + u ⇒ Achtung: Rr2 = 0 Test-Statistik: F = R 2 /k (1 − R 2 )/(N − k − 1) 39 / 41 F-Test: Allgemeine lineare Restriktionen Nicht restringiertes Modell: y = β0 + β1 x1 + β2 x2 + β3 x3 + β4 x4 + u Nullhypothese: H0 : β1 = 1, β2 = 0, β3 = 0, β4 = 0 Restringiertes Modell: y − x1 = β0 + u Test-Statistik: F = (SSRr − SSRur )/4 SSRur /(N − 4 − 1) 40 / 41 F-Test: p-Werte p-value = P(F > F ) Niedrigstes Signifikanzniveau, bei welchem wir H0 für eine gegebene Statistik verwerfen würden: Signifikanzniveau der Test-Statistik Zusammenhang zwischen F- und t-Statistiken: y = β0 + β1 x1 + β2 x2 + β3 x3 + β4 x4 + u H0 : β1 = 0; q = 1 Achtung: I 2 tN−k−1 = F1,N−k−1 41 / 41