Deklarative Programmierung - Fachbereich Informatik und

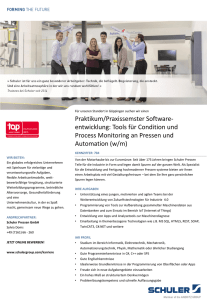

Werbung