Kapitel 2, Stochastische Prozesse

Werbung

3. STOCHASTISCHE PROZESSE

73

3. Stochastische Prozesse

3.1. Grundlegende Begriffe bei zufälligen Prozessen. In diesem Abschnitt beschäftigen wir uns mit den grundlegenden Begriffen und Definitionen von Zufallsexperimenten, also Prozessen, bei denen der Ausgang im Rahmen gewisser Möglichkeiten ungewiß oder zufÄllig ist, die aber bei Beibehaltung gewisser Rahmenbedingungen beliebig oft

wiederholt werden können und damit einer systematischen und mathematischen Beschreibung zugänglich sind.

Zum Einstieg ist es sinnvoll, zunächst nur eine diskrete und endliche Menge von möglichen

Ausgängen zu betrachten, da hier die Mathematisierung verständlicher dargestellt werden

kann.

Definition 2.54. Ein endlicher Ergebnisraum ist eine nichtleere Menge Ω = {ξ1 , . . . , ξn },

deren Elemente ξj ∈ Ω Ergebnisse genannt werden. Jede Teilmenge A ⊂ Ω wird als

Ereignis, jede einelementige Teilmenge {ξj } ⊂ Ω als Elementarereignis bezeichnet.

Nach dieser Definition sind der Ergebnisraum Ω selbst sowie die leere Menge ∅ stets Ereignisse, die man das sichere bzw. unmögliche Ereignis nennt. Gleichzeitig folgt, dass die

Menge aller Ereignisse gerade die Potenzmenge P(Ω) von Ω ist, also die Menge aller Teilmengen von Ω und für die Mächtigkeit von P(Ω) gilt die Beziehung

�

n �

�

n

|P(Ω)| =

= 2n

j

j=0

Da Ereignisse gerade als Elemente der Potenzmenge definiert sind, lassen sich Ereignisse

nach den Regeln der Mengenlehre verknüpfen.

Beispiel 2.55. Gilt A ⊂ B, so ist A ein Teilereignis von B; zwei Ereignisse A und B sind

gleich, falls A ⊂ B und B ⊂ A gilt. Das entgegengesetzte Ereignis ist

Ā = {ξ ∈ Ω : ξ ∈

/ A}

was man in der Mengenlehre auch als Negation oder das Komplement von A bezeichnet.

Definition 2.56. Sind A und B Ereignisse und gilt AB = A ∩ B = ∅, so heißen A und

B disjunkt oder unvereinbar.

Betrachtet man nun ein durch Ω und P(Ω) beschriebenes Zufallsexperiment und führt man

m unabhängige Wiederholungen durch, so kann man zählen, wie of ein Ereignis A ∈ P(Ω)

als Ergebnis der m Wiederholungen eintritt.

Definition 2.57. Tritt ein Ereignis A ∈ P(Ω) bei m unabhängigen Versuchen hm (A)–mal

ein, so nennt man hm (A) die absolute Häufigkeit und

Hm (A) =

hm (A)

m

die relative Häufigkeit von A in m Versuchen.

Man verifiziert leicht, dass die relative Häufigkeit Hm (A) die folgenden Eigenschaften

besitzt:

74

2. MATHEMATISCHE METHODEN DER MODELLBILDUNG

1) Für alle A ∈ P(Ω) gilt: 0 ≤ Hm (A) ≤ 1,

2) Es gilt: Hm (Ω) = 1,

3) Für alle A, B ∈ P(Ω) mit AB = ∅ gilt:

Hm (A ∪ B) = Hm (A) + Hm (B)

Man kommt damit zur Definition des Laplaceschen Zufallsexperiments und dem folgenden

Wahrscheinlichkeitsbegriff.

Definition 2.58. Sind in einem endlichen Ergebnisraum alle Elementarereignisse gleich

häufig, so nennt man das zugehörige Zufallsexperiment ein Laplacesches Zufallsexperiment. Die Wahrscheinlichkeit des Ereignisse A ist dann gegeben durch

Anzahl der Elementarereignisse {ξj } ⊂ A

P (A) =

Gesamtzahl der Elementarereignisse

Zufallsexperimente, die us kombinatorischen Überlegungen beruhen, lassen sich mit Hilfe

der Laplaceschen Definition einer Wahrscheinlichkeit mathematisch und beschreiben und

wir geben dazu nur ein konkretes Beispiel.

Beispiel 2.59. Eine Urne enthält n (bis auf die Farbe) gleiche Kugeln, von denen m rot

und n − m weiß sind. Aus der Urne werden zufällig k Kugeln gezogen. Wie groß ist die

Wahrscheinlichkeit dafür, dass unter

� den

� k Kugeln l rote und k − l weiße sind?

n

Zunächst kann man k Kugel auf

verschiedene Arten aus n Kugeln auswählen, d.h.

k

�

�

n

ist die Gesamtzahl der Elementarereignisse des oben formulierten Zufallsexperik

�

�

m

ments. Aus m roten Kugeln können l auf

verschiedene Arten ausgewählt werden;

l

�

�

n−m

k − l weiße aus n − m vorhandenen auf genau

Arten. Für die Laplacesche

k−l

Wahrscheinlichkeit folgt dann

�

��

�

m

n−m

l

k−l

�

�

Pk =

n

k

was man auch als hypergeometrische Verteilung bezeichnet.

Es ist offensichtlich, dass man sich bei der stochastischen Modellierung nicht allein auf

endliche Ergebnisräume Ω mit gleichwahrscheinlichen Elementarereignissen beschränken

kann.

Dies führt auf eine Definition der Wahrscheinlichkeit für allgemeine (endliche, abzählbar

und überabzählbar unendliche) Räume, wie sie 1933 von Kolmogorov10 auf axiomatischem

Weg eingeführt wurde.

10Andrej Nikolaevich Kolmogorov, russischer Mathematiker, 25. April 1903 in Tambov, 20. Oktober

1987 in Moskau

3. STOCHASTISCHE PROZESSE

75

Eine Schwierigkeit, die bei der mathematischen Formulierung auftaucht, ist dabei, dass

bei überabzählbar unendlichen Ergebnisräumen auch überabzählbar viele Elementarereignisse auftreten und man daher Probleme hat, jedem Elementarereignis eine positive

Wahrscheinlichkeit zuzuordnen.

Man beschränkt sich daher darauf, Wahrscheinlichkeiten nur für gewisse Teilmengen der

Potenzmenge P(Ω) zu definieren. Diese Teilmengen sich durch den Begriff einer σ–Algebra

charakterisiert.

Definition 2.60. Ein nichtleeres System B von Teilmengen eines Ergebnisraums Ω heißt

σ–Algebra über Ω, wenn gilt:

1)

2)

A ∈ B ⇒ Ā ∈ B

An ∈ B, n = 1, 2, . . . ⇒

∞

�

n=1

An ∈ B

Der Gesamtraum Ω und die leere Menge ∅ sind stets Elemente einer σ–Algebra: nach 1)

folgt aus A ∈ B auch Ā ∈ B und weiter gilt A ∩ Ā = Ω ∈ B und demnach Ω̄ = ∅ ∈ B.

Abzählbare Durchschnitte von Elementen aus B sind ebenfalls wieder Elemente von B,

d.h. es gilt

∞

�

An ∈ B, n = 1, 2, . . . ⇒

An ∈ B

n=1

Man kann aus jeder Teilmenge M ⊂ P(Ω) auf eindeutige Weise eine σ–Algebra B = B(M )

konstruieren, die man als die von M erzeugte σ–Algebra bezeichnet. Diese σ–Algebra

B(M ) ist auch die kleinste σ–Algebra, die die Ausgangsmenge M selbst enthÄlt, d.h. es

gilt:

1) M ⊂ B(M )

2) Ist B � eine σ–Algebra, die M enthält, so gilt B(M ) ⊂ B �

Für einen endlichen Ergebnisraum Ω = {ξ1 , . . . , ξn } ist die Potenzmenge P(Ω) offensichtlich eine σ–Algebra. Ein weiteres eichtiges Beispiel für eine σ–Algebra ist die durch die

halboffenen Intervalle I = (a, b] ⊂ R erzeugte σ–Algebra über den Ergebnisraum Ω = R,

die auch Borelsche σ–Algebra genannt wird.

Mit Hilfe des Begriffs σ–Algebra läßt sich jetzt durch die Kolmogorovschen Axiome eine

Verallgemeinerung der Laplaceschen Wahrscheinlichkeit für allgemeine Räume definieren.

Definition 2.61. Gegeben seien ein Ereignisraum Ω und eine geeignete σ–Algebra B über

Ω, sodass die Elemente von B die Ereignisse eines Zufallsexperimentes definieren. Weiter

sei P eine Funktion, die jedem Ereignis A ∈ B eine reelle Zahl zuordnet und die folgenden

Bedingungen (Kolmogorovschen Axiome) erfüllt:

A1) Für alle A ∈ B gilt: P (A) ≥ 0

A2) Es gilt: P (Ω) = 1

A3) Für paarweise disjunkte Ereignisse An ∈ B, n = 1, 2, . . . gilt:

�∞

�

∞

�

�

P

An =

P (An )

n=1

n=1

76

2. MATHEMATISCHE METHODEN DER MODELLBILDUNG

Dann nennt man P (A) die Wahrscheinlichkeit des Ereignisse A.

Um nun ein gegebenes Zufallexperiment mit Hilfe eines mathematischen Modells zu beschreiben verwendet man einen Wahrscheinlichkeitsraum (Ω, B, P ) bestehend aus dem

Ereignisraum Ω, einer σ–Algebra aus Teilmengen von Ω und eine Wahrscheinlichkeitsfuntkion P : B → R≥0 .

Satz 2.62. Es gilt stets

1)

P (∅) = 0

2)

P (Ā) = 1 − P (A)

3)

P (A ∪ B) = P (A) + P (B) − P (AB)

Beweis. Da die leere Menge ein Element von B ist, ist P (∅) wohldefiniert und aus

A1) aus Definition 2.61 folgt

P (∅) ≥ 0

Sei nun A �= ∅ ein Element von B. Dann gilt A ∪ ∅ = A ∈ B und A ∩ ∅ = ∅ ∈ B. Aus der

Bedingung A3) erhalten wir demnach

P (A) = P (A ∪ ∅) = P (A) + P (∅)

und daher P (∅) = 0.

Für Teil 2) bemerken wir, dass aus A ∪ Ā = ∅ und A ∩ Ā = Ω unter Verwendung von A2)

und A3) folgt:

1 = P (Ω) = P (A ∩ Ā) = P (A) + P (Ā)

und daher P (Ā) = 1 − P (A).

Für den letzten Teil des Satzes bemerken wir zunächst

A ∪ B = (AB̄) ∪ (AB) ∪ ĀB)

wobei die drei auf der rechten Seite stehenden Ereignisse paarweise disjunkt sind und

außerdem die Beziehungen

A = (AB) ∪ (AB̄)

B = (AB) ∪ (ĀB)

gelten. Aus A3) folgt demnach

P (A ∩ B) = P (AB̄) + P (AB) + P (ĀB)

P (A) = P (AB̄) + P (AB)

P (B) = P (AB) + P (ĀB)

Eine Kombination der drei Gleichungen ergibt aber

P (A ∩ B) = P (A) − P (AB) + P (AB) + P (B) − P (AB)

= P (A) + P (B) − P (AB)

�

3. STOCHASTISCHE PROZESSE

77

Bemerkung 2.63. Ein höchstens abzählbares System {An ∈ B : Ak An = ∅, k �= n} nennt

man auch eine vollständige Ergebnisdisjunktion, falls gilt

∞

�

An = Ω

n=1

Für ein solches System gilt wegen A2)

P

�

∞

�

An

n=1

�

=1

Weiter zeigt man mit Hilfe von A3) für zwei Elemente A, B ∈ B mit A ⊂ B die Abschätzung P (A) ≤ P (B).

Ein weiterer zentraler Begriff bei der stochastischen Modellierung ist der Begriff der bedingten Wahrscheinlichkeit.

Definition 2.64. Sei Ω, B, P ) ein Wahrscheinlichkeitsraum eines Zufallsexperimentes und

A, B ∈ B mit P (B) > 0 zwei Ereignisse. Dann nennt man

P (AB)

P (B)

die bedingte Wahrscheinlichkeit von A unter der Bedingung B.

(2.70)

P (A|B) =

Die bedingte Wahrscheinlichkeit bewertet also das Eintreffen des Ereignisses A unter der

Voraussetzung, dass das Ereignis B mit Sicherheit passiert ist.

Beispiel 2.65. Wir betrachten ein Zufallsexperiment mit zwei Würfeln und fragen nach

der Wahrscheinlichekit zwei Sechsen zu werfen, unter der Bedingung, dass mit einem

Würfel eine Sechs gewürfelt wird. Der Ergebnisraum dieses Zufallsexperiments ist die

Menge

Ω = {(w1 , w2 ) : w1 , w2 ∈ {1, . . . , 6}}

das Ereignis A ⊂ Ω zwei Sechsen zu würfeln ist dann

und

A = {(6, 6)}

B = {(w1 , 6) : w1 ∈ {1, . . . , 6}}

beschreibt das Ergebnis, dass mit dem zweiten Würfel eine Sechs gewürfelt wird und mit

dem ersten eine beliebige Augenzahl zwischen 1 und 6. Nun gilt wegen A ⊂ B

1

P (A ∩ B) = P (A) =

36

und P (B) = 1/6. Daraus folgt

P (AB)

1

=

P (B)

6

Die Wahrscheinlichkeit, zwei Sechsen zu werfen, unter der Bedingung, dass mit einem der

Würfel eine gerade Augenzahl gewürfelt wird, sollte natürlich kleiner als 1/6 sein. Mit

P (A|B) =

C = {(w1 , w2 ) : w1 ∈ {1, . . . , 6}, w2 ∈ {2, 4, 6}}

78

2. MATHEMATISCHE METHODEN DER MODELLBILDUNG

ergibt sich

P (A|C) =

P (AC)

P (A)

1/36

1

=

=

=

P (C)

P (C)

1/2

18

Einige Eigenschaften und Folgerungen der bedingten Wahrscheinlichekit sind im Folgenden

kurz zusammengefasst:

1) Es gilt stets

P (A|B)P (B) = P (B|A)P (A)

d.h. im Allgemeinen P (A|B) �= P (B|A).

2) Setzen wir für festes B ∈ B

PB (A) = P (A|B)

so erfüllt PB die Kolmogorovschen Axiome aus Definition 2.61 und definiert also

einen Wahrscheinlichkeitsraum (Ω, B, PB ). Insbesondere gilt: PB (Ω) = 1.

3) Die bedingte Wahrscheinlichkeit kann man dazu verwenden, um eine Multiplikationsregel für Wahrscheinlichkeiten zu definieren: aus (2.70) folgt

P (AB) = P (A|B)P (B)

beziehungsweise

(2.71)

P (AB) = P (B|A)P (A)

Mit Hilfe vollständiger Induktion beweist man ferner die Beziehung:

�

�

j−1

n

n

�

�

�

P

Aj =

P Aj |

Ak

j=1

j=1

k=1

Eine Anwendung von (2.71) besprechen wir im folgenden Beispiel.

11

Beispiel 2.66. In einem Raum befinden sich n Personen. Wie hoch ist die Wahrscheinlichkeit, dass mindestens 2 Personen im Raum am gleichen Tag Geburtstag haben? Um diese

Frage zu beantworten, müssen wir zunächst einige zusätzlichen Modellannahmen machen:

• wir vernachlässigen Schaltjahre, d.h. wir gehen davon aus, dass jedes Jahr 365

Tage hat,

• die Geburtstage der n Personen sind übers Jahr gleichverteilt, d.h. jeder Geburtstag besitzt diesselbe Wahrscheinlichkeit.

Sei A das Ereignis

A = {mindestens 2 Personen haben am gleichen Tag Geburtstag}

dann gilt natürlich für n > 365

P (A) = 1

Für n ≤ 365 nummerieren wir die n Personen durch und definieren die folgenden Ereignisse

A = {alle Personen haben an verschiedenen Tagen Geburtstag}

Aj

= {die j–te Person hat an einem anderen Tag als die j − 1 vorhergehenden Personen Geburtstag}

11siehe [15].

3. STOCHASTISCHE PROZESSE

79

Es folgt

P (A2 ) =

P (A3 |A2 ) =

364

365

363

365

..

.

365 − (n − 1)

365

Wegen A = A2 A3 · · · An folgt mit der Beziehung (2.71)

P (An |A2 A3 . . . An−1 ) =

und daraus

P (A) = P (A2 )P (A3 |A2 ) · · · P (An |A2 A3 . . . An−1 )

P (A) = 1 − P (A) = 1 −

364 · 363 · · · · · (365 − n + 1)

365n−1

Für verschiedene Werte von n erhält man:

n

10

20

23

30

50

100

P (A) 0.117 0.411 0.507 0.706 0.970 0.99999969

Satz 2.67. Die Ereignisse Ak , k = 1, . . . , n seien eine vollständige Ereignisdisjunktion

und es gelte P (Ak ) > 0 für alle k = 1, . . . , n. Dann folgt für jedes B ∈ B die Formel von

der totalen Wahrscheinlichkeit

n

�

P (B) =

P (B|Ak )P (Ak )

k=1

und falls P (B) > 0 die Formel von Bayes

P (Ak |B) =

P (B|Ak )P (Ak )

n

�

P (B|Ak )P (Ak )

k=1

Bemerkung 2.68. Man nennt die Wahrscheinlichkeiten P (Ak |B) die a–posteriori Wahrscheinlichkeiten, dagegen die P (Ak ) a–priori Wahrscheinlichkeiten.

Die bedingte Wahrscheinlichkeit P (A|B) gibt die Wahrscheinlichkeit für das Eintreten

des Ereignisses A an, unter der Bedingung, dass das Ereignis B sicher eingetreten ist. Im

allgemeinen gilt daher P (A) �= P (A|B). Gilt dagegen die Gleichheit, so ist das Eintreten

von A vollkommen unabhängig davon, ob B eingetreten ist oder nicht.

Definition 2.69. Gilt für A, B ∈ B

P (A|B) = P (A)

so nennt man A unabhängig von B.

Ist A unabhängig von B, so gilt für die Multiplikation

P (AB) = P (B)P (A|B) = P (A)P (B)

80

2. MATHEMATISCHE METHODEN DER MODELLBILDUNG

und daraus folgt direkt

P (A)P (B)

P (AB)

=

= P (B)

P (A)

P (A)

d.h. ist A unabhängig von B, so ist auch B unabhängig von A. Man sagt daher zusammenfassend, dass A und B voneinander unabhängig sind.

P (B|A) =

Beispiel 2.70. Ein klassisches Zufallsexperiment mit stochastisch unabhängigen Ereignissen ist das Ziehen–mit–Zurücklegen. So ist etwas die Wahrscheinlichkeit bei zweimaligen

Ziehen einer Karte aus einem Skatspiel, bei dem man die erste Karte nach dem Ziehen

wieder auf den Kartenstapel zurücklegt, zwei Asse zu ziehen gleich 1/64.

Definition 2.71. Die Ereignisse Ak ∈ B, k = 1, . . . , n, nennt man vollständig unabhängig, wenn für jede natürliche Zahl m ∈ {2, 3, . . . , n} und beliebige Zahlen 1 ≤ i1 <

i2 < · · · < im ≤ n gilt

�m

�

m

�

�

P

Ai k =

P (Aik )

k=1

k=1

3.2. Zufallsvariablen und Wahrscheinlichkeitsverteilungen. Zur analytischen

Beschreibung von Zufallsexperimenten ist es häufig notwendig, jedem Ergebnis des Experimentes eine (reelle) Zahl zuzuordnen. Damit lassen sich viele Eigenschaften aus der

Analysis auf zufällige Prozesse übertragen. Eine Funktion, die einem Ergebnis eines zufälligen Prozesses eine reelle Zahl zuordnet, wird als eine Zufallsvariable bezeichnet.

Definition 2.72. Gegeben sei ein Wahrscheinlichkeitsraum (Ω, B, P ). Eine Funktion

X:Ω → R

ξ �→ X(ξ)

die jedem Ereignis ξ ∈ Ω eine reelle Zahl zuordnet, heißt Zufallsvariable, wenn das Urbild

eines jeden Intervalls (−∞, a] ⊂ R ein Ereignis aus B ist:

Die Funktion

X −1 ((−∞, a]) ∈ B

∀a ∈ R

F (x) := P (X ≤ x)

der reellen Variablen x heißt Verteilungsfunktion der Zufallsvariablen X.

Man überlegt sich leicht, dass Verteilungsfunktionen stets die folgenden Eigenschaften

besitzen:

a) Es gilt: F : R → [0, 1] und

lim F (x) = 0,

x→−∞

lim F (x) = 1

x→∞

b) Die Funktion F (x) ist monoton nichtfallend:

x1 ≤ x2

⇒

F (x1 ) ≤ F (x2 )

c) Die Verteilungsfunktion ist rechtsseitig stetig:

F (x + 0) = lim F (x + h) = F (x)

h→0

(∀ x ∈ R)

3. STOCHASTISCHE PROZESSE

81

Eine spezielle Klasse von Zufallsvariablen sind die stetigen Zufallsvariablen, für die man

die Verteilungsfunktion stets als ein Integral über eine Dichte darstellen kann.

Definition 2.73. Eine Zufallsvariable X nennt man eine stetige Zufallsvariable, falls eine

integrierbare, nicht–negative Funktion f mit

�x

F (x) =

f (x) dx

−∞

existiert. Die Funktion f = f (x) bezeichnet man als die Dichte der Zufallsvariablen.

Wir geben im folgenden einige wichtige Beispiele für stetige Zufallsvariablen und deren

zugehörige Dichten:

Beispiel 2.74. Die Dichte

f (x) =

�

1 : 0≤x<1

0 : sonst

beschreibt die sogenannte Gleichverteilung mod 1.

Die Dichte

� 2�

1

x

f (x) = √ exp

2

2π

ist die Dichte der Standardnormalverteilung.

Die Dichte

�

0

: x≤0

f (x) =

λe−λx : x > 0

mit λ > 0 beschreibt die Exponentialverteilung.

Wir kommen nun zur Definition der Momente einer Zufallsvariablen. Gegeben sei dazu

eine stetige Zufallsvariable X mit der Dichte f (x).

Definition 2.75. Existiert das uneigentliche Integral

�∞

E(X) :=

xf (x) dx

−∞

so nennt man E(X) den Erwartungswert oder auch Mittelwert der Zufallsvariablen. Existiert für k ∈ N das uneigentliche Integral

�∞

k

E(X ) :=

xk f (x) dx

−∞

so nennt man E(X k ) das k–te Moment der Zufallsvariablen X.

Definition 2.76. Der Erwartungswert

k

E([X − E(X)] ) =

�∞

−∞

(x − E(x))k f (x) dx

82

2. MATHEMATISCHE METHODEN DER MODELLBILDUNG

heißt k–tes zentrales Moment der Zufallsvariablen X.

Spezielle Momente haben eine besondere Bedeutung und werden daher entsprechend benannt:

D2 (X) = E([X − E(X)]2 ) = var(X)

nennt man Varianz oder auch Dispersion der Zufallsvariablen X. Der Term

�

D(X) = E([X − E(X)]2 )

ist die Standardabweichung der Zufallsvariablen X.

Charakteristische Funktion einer Zufallsvariablen:

Definition 2.77. Der Erwartungswert

ϕ(s) := E(eisX )

heißt charakteristische Funktion der Zufallsvariablen X.

Satz 2.78. Existiert das k–te Moment einer Zufallsvariablen X, so gilt

ϕ(k) (0)

(k = 1, 2, . . . )

ik

Bemerkung 2.79. Man beachte den Zusammenhang zur Fourier–Transformation:

�∞

�∞

1

isx

e−isx ϕ(s) ds

ϕ(s) =

e f (x) dx

f (x) =

2π

E(X k ) =

−∞

−∞

Wir kommen nun zu einigen typischen Wahrscheinlichkeitsverteilungen, die häufig bei der

Modellierung stochastischer Prozesse verwendet werden.

Zunächst betrachten wir die sogenannte Zweipunktverteilung: gegeben sei dazu eine Zufallsvariable, die nur zwei unterschiedliche Werte x1 < x2 mit positiver Wahrscheinlichkeit

annehmen kann.

Ist dann

P (X = x1 ) = p P (X = x2 ) = 1 − p

(0 < p < 1)

so folgt für die oben angegebenen Kenngrößen der Zweipunktverteilung:

0 : x < x1

p : x 1 ≤ x < x2

F (x) =

1 : x ≥ x2

E(X) = p x1 + (1 − p) x2

D2 (X) = (x2 − x1 )2 p (1 − p)

ϕ(s) = p eisx1 + (1 − p) eisx2

Betrachtet man bei einem Zufallsexperiment mit Zweipunktverteilung n voneinander unabhängige Wiederholungen und sei Xn die diskrete Zufallsvariable, die angibt wie oft der

Wert x1 angenommen wird, so gilt

�

�

n

P (Xn = k) =

pk (1 − p)n−k

(k = 0, . . . , n)

k

3. STOCHASTISCHE PROZESSE

83

Diese Verteilung bezeichnet man als Binomialverteilung und man berechnet

�� n �

pk (1 − p)n−k

F (x) =

k

k≤x

E(X) = n p

D2 (X) = n p (1 − p)

ϕ(s) = (1 + p (eis − 1))n

Mit Hilfe der Binomialverteilung läßt sich die sogenannte Poissonverteilung ableiten.

Definition 2.80. Eine Zufallsvariable X, die die Werte k = 0, 1, 2, . . . mit den Wahrscheinlichkeiten

λk −λ

P (X = k) =

e

(λ > 0)

k!

annimmt, nennt man poissonverteilt mit Parameter λ.

Der Zusammenhang zur Binomialverteilung wurde bereits 1837 von Poisson angegeben:

Satz 2.81. Die diskrete Zufallsvariable Xn genüge der Binomialverteilung. Gilt mit der

Konstanten λ < 0 für n = 1, 2, 3, . . . die Beziehung

λ

p=

n

so gilt

λk −λ

lim P (Xn = k) =

e

n→∞

k!

Hat man keine näheren Informationen über die Verteilungsfunktion einer Zufallsvariablen,

so nimmt man häufig an, dass die Zufallsvariablen normalverteilt sind und die Normalverteilung kann damit als die wichtigste Verteilung der Wahrscheinlichkeitstheorie angesehen

werden.

Definition 2.82. Eine Zufallsvariable X ist normalverteilt (gaußverteilt), wenn ihre

Dichte durch

�

�

1

(x − µ)2

f (x) = √

exp −

(σ > 0)

2σ 2

2πσ

gegeben ist.

In der Tat können Zufallsvariablen, die durch eine additive Überlagerung einer großen

Zahl von unabhängigen zufälligen Ereignissen (Zufallsvariablen) entstehen, wobei jede der

einzelnen Zufallsvariablen einen im Verhältnis zur Gesamtsumme nur unbedeutenden Betrag liefert, als normalverteilt angesehen werden.

Von besonderen Interesse sind damit auch die Kenngrößen der Normalverteilung, die wir

im folgenden abgeben wollen: die Verteilungsfunktion der Normalverteilung ist gegeben

durch

�

�

�x

1

(t − µ)2

F (x) = √

exp −

dt

2σ 2

2πσ

−∞

84

2. MATHEMATISCHE METHODEN DER MODELLBILDUNG

die sich mit Hilfe der Gaußschen Fehlerfunktion erf (x) auch in der Form

F (x) =

=

1 2

·√

2

π

√

(x−µ)/(

� 2σ)

1 1

+ erf

2 2

2

e−t dt

−∞

�

x−µ

√

2σ

�

darstellen läßt, wobei die Fehlerfunktion (wie in Abschnitt 2.2 bereits angegeben) über die

Formel

�x

2

2

erf (x) = √

e−t dt

π

0

definiert ist.

Für den Erwartungswert einer normalverteilten Zufallsvariablen berechnet man

�

�

�x

1

(t − µ)2

√

dt = µ

E(X) =

t · exp −

2σ 2

2πσ

−∞

und die Varianz ist gegeben durch

D2 (X) = σ 2

Das k–te zentrale Moment lautet

�

1 · 3 · · · · · (k − 1) σ k : falls k gerade

k

E((x − µ) ) =

0

: falls k ungerade

und die charakteristische Funktion ist gegeben durch

�

�

(σs)2

isµ

ϕ(s) = e exp −

2

Für N (µ; σ 2 )–verteilte Zufallsvariablen gilt als eine weitere vor allem in Anwendungen

wichtige Eigenschaft:

P (µ − σ < X ≤ µ + σ) ≈ 0.68

P (µ − 2σ < X ≤ µ + 2σ) ≈ 0.955

P (µ − 3σ < X ≤ µ + 3σ) ≈ 0.997

d.h. praktisch alle Werte von X liegen zwischen µ − 3σ und µ + 3σ.

Der Begriff Zufallsvariable läßt sich auf Zufallsvariablen X : Ω → Rd erweitern, d.h. es

lassen sich auch mehrdimensionale Zufallsvariablen definieren.

Definition 2.83. Die Funktion

F (x1 , . . . , xd ) = P (X1 ≤ x1 , X2 ≤ x2 , . . . , Xd ≤ xd )

einer mehrdimensionalen Variablen X heißt Verteilungsfunktion von X.

3. STOCHASTISCHE PROZESSE

85

Die Dichte einer zweidimensionalen Zufallsvariablen berechnet sich zum Beispiel über

f (x1 , x2 ) =

∂2

F (x)

∂x1 ∂x2

Definition 2.84. Für eine zweidimensionale Zufallsvariablen X mit der Dichte f (X) =

f (x1 , x2 ) sind die Randdichten von X gegeben durch

�∞

fX1 (x1 ) =

f (x1 , x2 ) dx2

fX2 (x2 ) =

−∞

�∞

f (x1 , x2 ) dx1

−∞

Die Randdichten sind gerade die Dichten der Komponenten des Zufallsvektors X = (X1 , X2 )T .

Bemerkung 2.85. Bei der Definition der Randdichten wird die Zufälligkeit einer der

beiden Komponenten durch Integration über diese eliminiert.

Definition 2.86. Man nennt

fX1 (x1 |X2 = x2 ) =

f (x1 , x2 )

fX2 (x2 )

die bedingte Dichte von X1 unter der Bedingung X2 = x2 und

fX2 (x2 |X1 = x1 ) =

f (x1 , x2 )

fX1 (x1 )

die bedingte Dichte von X2 unter der Bedingung X1 = x1 .

Definition 2.87. Zwei Zufallsvariablen heißen unabhängig, falls

f (x, y) = fX (x) · fY (y)

Definition 2.88. Für die beiden Zufallsvariablen X und Y nennt man den Ausdruck

cov(X, Y ) = E{(X − µX )(Y − µY )}

die Kovarianz von X und Y .

Erwartungswerte von zweidimensionalen Zufallsvariablen sind dabei definiert durch

�∞ �∞

E{g(X, Y )} =

g(x, y)f (x, y) dxdy

−∞ −∞

Der Korrelationskoeffizient von X und Y ist definiert durch

ρX,Y

= ρ(X, Y ) = �

=

cov(X, Y )

D2 (X)D2 (Y )

E{(X − µX )(Y − µY )}

σX σY

86

2. MATHEMATISCHE METHODEN DER MODELLBILDUNG

Beispiel 2.89. Wir betrachten die beiden normierten Zufallsvariablen

X − µX

Y − µY

X̃ =

Ỹ =

σX

σY

und definieren für t ∈ R die zusammengesetzte Zufallsvariable

Z = tX̃ + Ỹ

Der Erwartungswert von Z ist gleich Null und für die Varianz gilt

D2 (Z) = E{(tX̃ + Ỹ )2 } = t2 + 2tρX,Y + 1 ≥ 0

Demnach gilt für alle t ∈ R:

(t + ρX,Y )2 + (1 − ρ2X,Y ) ≥ 0

Daraus folgt aber für den Korrelationskoeffizienten ρX,Y

−1 ≤ ρX,Y ≤ 1

Bemerkung 2.90. Der Korrelationskoeffizient gibt an, wie ähnlich zwei Zufallsvariablen

sind:

1) Gilt ρX,Y , so nennt man die beiden Zufallsvariablen X und Y unkorreliert

2) Für |ρX,Y | = 1, so sind X und Y maximal korreliert.

3) Unabhängige Zufallsvariablen sind stets unkorreliert. Die Umkehrung gilt aber

nicht!

4) Sind X und Y allerdings normalverteilt, so folgt aus ρX,Y die Unabhängigkeit

von X.

5) Sind X und Y unabhängig, so gilt zusätzlich cov(X, Y ) = 0 und

D2 (X + Y ) = D2 (X) + D2 (Y )

E(X · Y ) = E(X) · E(Y )

Ist die Wahrscheinlichkeit P (A) eines zufälligen Ereignisses A nicht bekannt, so kann

durch ein Zufallsexperiment mit Hilfe der relativen Häufigkeit Hn (A) ein Schätzwert für

die Wahrscheinlichkeit P (A) bestimmt werden. Umgekehrt kann man sich fragen, wie weit

bei einem Zufallsexperiment mit n unabhängigen Wiederholungen die relative Häufigkeit

Hn (A) von einer gegebenen Wahrscheinlichkeit P (A) des Ereignisse (im Mittel) abweicht.

Diese Fragen werden durch das Gesetz der großen Zahlen und die Grenzwertsätze der

Wahrscheinlichkeitstheorie beantwortet.

Wir formulieren hier nun die beiden grundlegenden Sätze, nämlich das Bernoullisches

Gesetz der großen Zahlen (siehe 2.91) und den zentralen Grenzwertsatz (siehe 2.92)

Satz 2.91. Ist X1 , X2 , . . . eine Folge von unabhängigen, identisch verteilter Zufallsvariablen mit

P (Xn = 1) = p, P (Xn = 0) = 1 − p

(0 < p < 1)

so gilt für alle ε > 0

�

�

�� n

�

�1 �

�

�

X k − p� < ε = 1

lim P �

n→∞

�

�n

k=1

3. STOCHASTISCHE PROZESSE

87

Satz 2.92. X1 , X2 , . . . sei eine Folge unabhängiger, identisch verteilter Zufallsvariablen

mit

dann gilt mit Sn =

n

�

k=1

E(Xn ) = m < ∞

D2 (Xn ) = d2 < ∞

Xk für jedes x ∈ R

lim P

n→∞

�

Sn − nm

√

≤x

nd

�

1

=√

2π

�x

−∞

y2

exp −

2

�

�

dy

3.3. Grundlagen stochastischer Prozesse. Stochastische Prozesse sind kurzgesagt Familien von Zufallsvariablen X(t), die durch einen Parameter t ∈ T gekennzeichnet

sind, wobei man T auch als Parameterraum des stochastischen Prozesses bezeichnet. Ausgangspunkt ist dabei ein Wahrscheinlichkeitsraum (Ω, B, P ). Der Parameter t übernimmt

die Rolle einer Zeitvariablen und wir unterscheiden dabei grundsätzlich zwischen diskreten

und kontinuierlichen stochastischen Prozessen.

1) Diskrete stochastische Prozesse sind solche, bei denen der Indexparameter t nur

diskrete Werte annehmen kann

2) Kontinuierliche stochastische Prozesse sind durch eine kontinuierliche Zeitvariable

t ∈ R parametrisiert.

Ein stochastischer Prozess ist also zusammenfassend durch zwei Parameter induziert:

1) Zu jedem festen Zeitpunkt t0 ∈ T ist Xt0 (ξ) = X(t0 , ξ) eine Zufallsvariable, also

Xt0 : Ω → R

ξ �→ Xt0 (ξ)

2) Wird das Ereignis ξ ∈ Ω festgehalten und betrachtet die Abhängigkeit von der

Zeit t ∈ T , so nennt man die Zeitfunktion X(t, ξ0 ) eine Realisierung oder Pfad

des Prozesses. Man spricht auch von der sogenannten Musterfunktion.

Im Allgemeinen ist die Anzahl aller möglichen Pfade eines stochastischen Prozesses (überabzählbar) unendlich groß.

Ein klassisches Beispiel für einen stochastischen Prozess ist ein sogenannte Warteschlange:

zu zufälligen Zeitpunkten treffen Kunden vor einem Schalter ein und fordern eine Bedienung, die eine bestimmte zufällige Abfertigungszeit erfordert. Eine solche Warteschlange

kann nun durch einen stochastischen Prozess X(t), der die Anzahl der zur Zeit t wartenden Kunden angibt, mathematisch modelliert werden. Die Theorie der Warteschlangen,

d.h. die Beschreibung mit Hilfe eines stochastischen Prozesses, stellt damit eine Methode

bereit, um wichtige Kenngrößen, wie z.B. die mittlere Wartezeit eines Kunden oder den

Auslastungsgrad des Schalters, zu ermitteln.

Ein typische Anwendung der Theorie der Warteschlangen findet man in der Informatik:

bei einem Betriebssystem eines Computers kann der Zugriff auf den Prozessor durch ein

Warteschlangensystem beschrieben werden. Aus den theoretischen Analysen des Modells

kann der mittlere Durchsatz und die mittlere Wartezeit berechnet werden.

88

2. MATHEMATISCHE METHODEN DER MODELLBILDUNG

Ein weiteres wichtiges Anwendungsbeispiel ist die Nachrichtenübertragung: eine Signalquelle erzeuge zufällige digitale Sendesymbole X ∈ {−3, −1, 1, 3} und die Wahrscheinlichkeiten P (X) bestimmen die Verteilung der Zufallsvariablen X. Der zugehörige stochastische Prozess kann dann folgendermaßen konstruiert werden: die Signalquelle erzeugt eine

Nachricht {Xn }∞

n=0 als Sequenz der Sendesymbole Xn (Modulationssymbole):

∞

�

x(t) =

xn · X[nT,(n+1)T ) (t)

n=0

mit der charakteristischen Funktion

X[a,b) (t) =

�

1 : t ∈ [a, b)

0 : sonst

Wir versuchen nun stochastische Prozesse anhand einiger charakteristischer Eigenschaften

zu beschreiben und zu klassifizieren. Dazu betrachten wir zunächst n diskrete Zeitpunkte

{t1 , t2 , . . . , tn } und die zugehörigen Zufallsvariablen {X(t1 ), X(t2 ), . . . , X(tn )} des vorgegebenen stochastischen Prozesses.

Die Zufallsvariablen {X(t1 ), X(t2 ), . . . , X(tn )} sind dann durch ihre gemeinsame Dichte

f (xt1 , xt2 , . . . , xtn ) charakterisiert und man kann den Begriff Stationarität mit Hilfe der

gemeinsamen Dichte definieren.

Definition 2.93. Ein stochastischer Prozess X(t) heißt streng oder stark stationär, falls

für alle n ∈ N und für alle τ, t1 , t2 , . . . , tn ∈ R gilt:

f (xt1 +τ , xt2 +τ , . . . , xtn +τ ) = f (xt1 , xt2 , . . . , xtn )

d.h. die n–dimensionalen Dichtefunktionen sind invariant gegenüber Zeitverschiebungen.

Hält man nun die Zeitvariable fest, i.e. t = tn , so lassen sich Scharmittelwerte eines

stochastischen Prozesses definieren:

Definition 2.94. Die Größe

k

E{X (tn )} =

�∞

xktn f (xtn ) dxtn

−∞

nennt man k–tes Moment der Zufallsvariablen X(tn ) und bezeichnet die Größe auch als

einen Scharmittelwert.

Scharmittelwerte hängen also in der Regel vom Zeitpunkt tn ab. Man beachte aber, dass

bei stark stationären Prozessen die Momente nicht zeitabhängig sind.

Definition 2.95. Die Funktion

ϕXX = E{X(t1 )X(t2 )} =

�∞ �∞

xt1 xt2 f (xt1 , xt2 ) dxt1 dxt2

−∞ −∞

heißt Autokorrelationsfunktion des stochastischen Prozesses X(t).

Die folgenden Bemerkungen folgen direkt aus den oben angegebenen Definitionen.

3. STOCHASTISCHE PROZESSE

89

1) Bei stark stationären Prozessen gilt stets

ϕXX (t1 , t2 ) = ϕXX (t2 − t1 ) = ϕXX (τ )

2) Die Autokorrelationsfunktion ϕXX ist für stark stationäre Prozesse stets eine

gerade Funktion.

Definition 2.96. Einen stochastischen Prozeß mit einem konstanten Erwartungswert, für

den die Autokorrelationsfunktion die Bedingung

ϕXX (t1 , t2 ) = ϕXX (t2 − t1 ) = ϕXX (τ )

erfüllt, nennt man (schwach) stationär.

Bei – sowohl stark als auch schwach – stationären stochastischen Prozessen nennt man

den Ausdruck

ϕXX (0) = E{X(t)2 }

die mittlere Leistung des Prozesses.

Bemerkung 2.97. Stark stationäre Prozesse sind auch stets schwach stationär, aber die

Umkehrung gilt nicht.

Definition 2.98. Die Funktion

cXX (t1 , t2 ) = E{(X(t1 ) − µ(t1 ))(X(t2 ) − µ(t2 ))}

= ϕXX (t1 , t2 ) − µ(t1 )µ(t2 )

mit µ(tn ) = E{X(tn )}, n = 1, 2 nennt man Autokovarianzfunktion des stochastischen

Prozesses X(t).

Bei stationären stochastischen Prozessen vereinfacht sich die Autokovarianzfunktion von

X(t) zu

cXX (t1 , t2 ) = cXX (t2 − t1 ) = cXX (τ ) = ϕXX (τ ) − µ2

Neben den Scharmittelwerte sind Zeitmittelwerte typische Kenngrößen eines stochastischen Prozesse. Dies erhält man, in dem man für einen vorgebenen Pfad eines stochastischen Prozesses Kenngrößen über die Zeit mittelt. Desweiteren kann über Zeitmittelwerte

der Begriff der Ergodizität definiert werden.

Definition 2.99. Es seien g : R → R eine reellwertige Funktion und x(t) ein Pfad des

stark stationären Prozesses X(t). Dann nennt man den Ausdruck

1

g[x(t)] := lim

T →∞ 2T

�T

g[x(t)] dt

−T

zeitlichen Mittelwert der Realisierung x(t) bezüglich der Funktion g.

Beispiel 2.100. Für g = id erhält man den Mittelwert des Pfads, also

1

m = x(t) = lim

T →∞ 2T

�T

−T

x(t) dt

90

2. MATHEMATISCHE METHODEN DER MODELLBILDUNG

Definition 2.101. Der stark stationäre stochastische Prozess X(t) heißt ergodisch bezüglich

g, wenn der Erwartungswert E{g(X(t))} existiert und die Beziehung

g[x(t)] = E{g(X(t))}

erfüllt ist, d.h. Zeitmittelwert eines beliebigen Pfades stimmen mit dem Erwartungswert

der Zufallsvariablen g[X(t)] überein.

Ergodische Prozesse sind nun wie folgt definiert: der stark stationäre stochastische Prozess

X(t) ist ergodisch, wenn alle seine statistischen Eigenschaften aus einer einzigen Realisierung x(t) abgeleitet werden können. In der Tat ist die Berechnung von Zeitmittelwerten

nur für ergodische Prozesse überhaupt sinnvoll.

Scharmittelwerte bei ergodischen Prozessen lassen sich nun wie folgt berechnen: sei x(t)

ein beliebiger Pfad des ergodischen Prozesses X(t). Dann ist

1) das k–te Moment gegeben durch

m

(k)

1

= lim

T →∞ 2T

�T

xk (t) dt

−T

2) die Autokorrelationsfunktion

1

ϕXX (τ ) = lim

T →∞ 2T

�T

x(t)x(t + τ ) dt

−T

3) die Autokovarianzfunktion

1

cXX (τ ) = lim

T →∞ 2T

�T

(x(t) − m(1) )(x(t + τ ) − m(1) ) dt

−T

Zum Abschluß dieses Abschnittes geben wir noch zwei Beispiele zu speziellen stochastischen Prozessen. Zunächst untersuchen wir das sogenannte weiße Gaussche Rauschen.

Ein Gaußprozess ist ein spezieller stochastischer Prozess X(t), für den die Zufallsvariable {X(t1 ), X(t2 ), . . . , X(tn )} für jedes n ∈ N und t1 , t2 , . . . , tn ∈ R eine n–dimensionale

Normalverteilung besitzt, d.h. der Zufallsvektor besitzt die Dichte

�

�

1

1

√

f (x1 , x2 , . . . , xn ) =

exp − (x − µ)T C −1 (x − µ)

2

(2π)n/2 det C

mit der Kovarianzmatrix C.

Weißes Gaußches Rauschen ist ein mittelwertfreier, stationärer Gaußprozess mit einem

konstanten Leistungsdichtespektrum

�∞

ϕXX (τ )e−i2πsτ dτ = konstant

∀s ∈ R

−∞

In der Warteschlangentheorie wird die Ankunft neuer Kunden fast ausschließlich mit Hilfe

eines Poissonprozesses modelliert: der stochastische Prozess X(t) beschreibe die Anzahl

3. STOCHASTISCHE PROZESSE

91

der wartenden Kunden. Gegeben sei ein ∆t ∈ R und wir machen die folgenden Modellannahmen:

1) Die Wahrscheinlichkeit dafür, dass in einem Intervall der Länge ∆t ein neuer

Kunde ankommt ist proportional zu ∆t.

2) Die Wahrscheinlichkeit dafür, dass in einem Intervall der Länge ∆t ein neuer

Kunde ankommt hängt nicht von der Lage des Intervalls ab.

3) Der Ankunftsprozess ist gedächtnislos: das Eintreffen in einem Intervall der Länge

∆t unabhängig vom Eintreffen anderer Kunden in vergangenen oder zukünftigen

Intervallen.

Die Modellannahmen führen auf den Poissonprozess, d.h. unter der Annahme X(0) = 0

gilt für X(t), t ≥ 0

(λt)k −λt

P {X(t) = k} =

e

k!

Die Eigenschaften des Poissonprozesses lassen sich kurz zusammenfassen:

a) der Erwartungswert ist E{X(t)} = λt, d.h. der Poissonprozess ist nichtstationär.

b) die Varianz ergibt sich zu D2 {X(t)} = λt.

c) die mittlere Ankunftsrate der Kunden ist λ = E{X(t)}/t und es gilt

D{X(t)}

1

=√

E{X(t)}

λt

d.h. für λt � 1 ist die Verteilung um den Erwartungswert λt konzentriert.

d) Es gilt

P {X(t) = 0} = e−λt

d.h. die Wahrscheinlichkeit dafür, dass kein Kunde ankommt geht exponentiell

mit t gegen Null.

e) Die Zeitdifferenz T zwischen zwei aufeinanderfolgenden Ankunftszeitpunkten ist

wieder eine Zufallsvariable, die nur nichtnegative Werte annehmen kann.

Weiter ist die Zeitdifferenz exponentialverteilt, d.h. die Dichte von T ist gegeben

durch

�

0

: τ ≤0

fT (τ ) =

λe−λτ : τ > 0

Weiter gilt

1

1

E{T } =

D2 {T } = 2

λ

λ

3.4. Markoffprozesse und Markoffketten. Bei einem stochastischen Prozess X(t)

stehen die beiden Zufallsvariablen X(t1 ) und X(t2 ) in einem bestimmten Zusammenhang.

Bei Markoffprozessen hat nun die Vergangenheit des Prozesses keinen Einfluß auf die

Zukunft, sofern der gegenwärtige Zustand bekannt ist:

Definition 2.102. Der stochastische Prozess X(t) heißt Markoffprozess, falls für alle

m, k ∈ N und beliebige Zeitpunkte tm−k < tm−k+1 < · · · < tm+1 gilt:

P {X(tm+1 ) ≤ xm+1 |X(tm ) ≤ xm , . . . , X(tm−k ) ≤ xm−k }

= P {X(tm+1 ) ≤ xm+1 |X(tm ) ≤ xm }

92

2. MATHEMATISCHE METHODEN DER MODELLBILDUNG

Spezielle Markoffprozesse sind Prozesse mit diskreten Zuständen und Zeit, die sogenannten

Markoffketten.

Definition 2.103. Der zustands– und zeitdiskrete stochastische Prozess X(t) mit Parameterraum T = {t0 , t1 , . . . , } heißt Markoffkette, falls für alle m > 2 und i0 , i1 , . . . , im ∈ N

gilt:

P {X(tm+1 ) = im+1 |X(tm ) = im , . . . , X(t0 ) = i0 }

= P {X(tm+1 ) = im+1 |X(tm ) = im }

Markoffketten lassen sich durch ihre Übergangswahrscheinlichkeiten charakterisieren:

Definition 2.104. X(t) sei eine Markoffkette und tm , tm+k ∈ T . Dann nennt man die

bedingten Wahrscheinlichkeiten

P {X(tm+k ) = j|X(tm ) = i} = pij (tm , tm+k )

Übergangswahrscheinlichkeiten k–ter Stufe.

Ist die Zustandsmenge der Markoffkette endlich, also

X(t) ∈ {1, 2, . . . , n}

∀t ∈ T

so lassen sich die Übergangswahrscheinlichkeiten in einer Matrix anordnen

p11 (tm , tm+k ) · · · p1n (tm , tm+k )

p21 (tm , tm+k ) · · · p2n (tm , tm+k )

P (tm , tm+k ) :=

..

..

.

.

pn1 (tm , tm+k ) · · ·

pnn (tm , tm+k )

Weiter nennt man eine Markoffkette homogen, wenn für beliebige Zustände i, j und beliebige Zeitpunkte tm , tm+1 die Übergangswahrscheinlichkeiten pij (tm , tm+1 ) = pij nicht von

der Zeit abhängen.

Im Folgenden sei X(t) eine homogene Markoffkette mit endlicher Zustandmenge Z. Die

Übergangsmatrix ist dann eine konstante Matrix

p11 · · · p1n

p21 · · · p2n

P := ..

..

.

.

pn1 · · · pnn

mit den nicht–negativen Einträgen pij ≥ 0.

Weiter ist für alle Zeilen die Zeilensumme von P gleich 1:

n

�

j=1

pij = 1

∀ i ∈ {1, 2, . . . , n}

denn ist der Prozess X(t) im Zustand i, so muß der Prozess in einen der endlich vielen

Zustände Z = {1, 2, . . . , n} übergehen.

3. STOCHASTISCHE PROZESSE

93

Definition 2.105. Eine (n × n)–Matrix P = (pij ), für deren Elemente

pij ≥ 0

∀ i, j ∈ Z

und

n

�

pij = 1

j=1

∀i ∈ Z

gilt, nennt man stochastische Matrix. Die Zeilenvektoren von P sind stochastische Vektoren.

Sei nun t ∈ N0 und

P {X(t) = i} = pi (t)

i = 1, 2, . . . , n

Wir können nun diese Wahrscheinlichkeiten in einem Zeilenvektor zusammenfassen:

p(t) = (p1 (t), p2 (t), . . . , pn (t))

Die Wahrscheinlichkeiten zum Zeitpunkt t + 1 ergeben sich dann zu

pj (t + 1) =

n

�

pij pi (t)

j = 1, 2, . . . , n

i=1

und für den kompletten Zeilenvektor ergibt sich

p(t + 1) = p(t) · P

Eine wiederholte Anwendung liefert die Formel

p(t + k) = p(t) · P k

und mit dem Startwert p(0) ergibt sich insbesondere die Darstellung

p(k) = p(0) · P k

Man beachte, dass die Matrix P k natürlich wiederum eine stochastische Matrix ist.

Homogene Markoffketten lassen sich auch man als bewertete Graphen interpretieren.

Definition 2.106. Ein gerichteter Graph ist ein Mengenpaar (BG , Fg ), wobei BG �= ∅

eine Zustandsmenge und FG ⊆ BG × BG eine Menge von Übergängen darstellt. Wir jedem

Übergang eine Übergangswahrschinlichkeit pij mit den Eigenschaften

�

pij = 1

0 ≤ pij ≤ 1

j

erhält man einen bewerteten Graphen, der auch als auch Übergangsgraph der homogenen

Markoffkette bezeichnet wird.

Eine homogene Markoffkette ist dann eine Irrfahrt auf einem bewerteten Graphen.

Definition 2.107. Eine Zustand i einer homogenen Markoffkette heißt absorbierend, falls

gilt

pii = 1

Die Menge R der absorbierenden Zustände nennt man den Rand der Markoffkette, die

Menge Z − R die Menge der inneren Zustände.

94

2. MATHEMATISCHE METHODEN DER MODELLBILDUNG

Eine Markoffkette nennt man absorbierend, wenn R �= ∅ gilt und der Rand R von jedem

inneren Zustand aus erreichbar ist. Für absorbierende Markoffketten gilt der nachfolgende

Satz über das Grenzverhalten von Irrfahrten.

Satz 2.108. Für eine absorbierende Markoffkette endet die Irrfahrt in einem Zustand des

Randes.

Wichtige Fragen im Zusammenhang mit dem letzten Satz sind dann: wie groß ist die

Wahrscheinlichkeit dafür, dass eine Irrfahrt in einer Teilmenge U ⊂ R des Randes endet

und was ist die mittlere Dauer der Irrfahrt bis zur Absorption am Rand R. Diese Fragen

werden in den Übungen zur Vorlesung behandelt.

3.5. Pseudozufallszahlen und stochastische Simulation. Wir zitieren zunächst

aus dem im Jahr 2003 im Vieweg Verlag erschienenen Buch Stochastik für Einsteiger von

Norbert Henze, der folgende Interpretation des Begriffs Simulation stochastischer Prozesse

formuliert:

Die Simulation (von lateinisch simulare: ähnlich machen, nachahmen) stochastischer Vorgänge im Computer ist ein wichtiges Werkzeug zur Analyse von Zufallsphänomenen, welche

sich aufgrund ihrer Komplexität einer analytischen Behandlung entziehen. Beispiele hierfür

sind Lagerhaltungsprobleme mit komplizierter zufallsabhängiger Nachfrage, die möglichst

naturgetreue Nachbildung von Niederschlagsmengen an einem Ort im Jahresverlauf oder

das ,,Durchspielen” von Verkehrsabläufen mit zufällig ankommenden Autos an einer Ampelkreuzung.

Eine Nachbildung des Zufalls im Computer geschieht stets nach einem vorgegebenen stochastischen Modell, wobei das Ziel die Gewinnung von Erkenntnissen über einen realen

Zufallsvorgang unter Einsparung von Zeit und Kosten ist. So könnte der Simulation des

Verkehrsablaufes an einer Kreuzung der Wunsch zugrunde liegen, die Ampelschaltung

so einzurichten, dass die mittlere Wartezeit der ankommenden Fahrzeuge möglichst kurz

wird.

Bausteine für die stochastische Simulation sind sogennante gleichverteilte Pseudozufallszahlen, die von Pseudozufallszahlengeneratoren erzeugt werden. Das im Folgenden nur der

Kürze halber weggelassene Präfix Pseudo soll betonen, dass die durch Aufrufen von Befehlen oder Drücken von Tasten wie Random, RAN oder Rd bereitgestellten Zufallszahlen

nur zufällig erzeugt scheinen.

Wir formulieren nun einen ersten Algorithmus zur Erzeugung von Pseudozufallszahlen,

der auf John von Neumann zurückgeht:12

Gegeben sei die Zahl

x0 = 0.9876

Wir quadrieren die Zahl und erhalten x20 = 0.97535376. Aus der Zahlendarstellung entnehmen wir nun die mittleren vier Dezimalstellen und setzen

x1 = 0.5353

12John von Neumann, amerikanischer Mathematiker, östr.–ungar. Herkunft, 1903–1957,wirkte in Ber-

lin, Hamburg und Princeton (N.J.)

3. STOCHASTISCHE PROZESSE

95

Das Quadrat von x1 ergibt x21 = 0.28654609 und wir setzen daher

x2 = 0.6546

Eine weitere Anwendung dieses Prinzips ergibt:

x3 = 0.8501,

x4 = 0.2670,

x5 = 0.1289

Auf den ersten Blick sehen die Zahlen in der Tat wieder Pseudozufallszahlen aus, die die

Gleichverteilung mod 1 auf dem Einheitsintervall [0, 1] approximieren. Eine genauere Untersuchung der Zahlenfolge zeigt aber, dass diese Methode mehr kleine Zahlen erzeugt als

gewünscht ist.

Ein häufig verwendeter Zufallsgenerator zur Erzeugung von Pseudozufallszahlen auf dem

Einheitsintervall ist der sogenannte lineare Kongruenzgenerator: gegeben seien die nichtnegativen ganzen Zahlen

m : Modul

a : Faktor

b : Inkrement

zo : Anfangswert

Das iterative lineare Kongruenzschema ist dann gegeben durch

zj+1 = a · zj + b (mod m)

(j = 0, 1, 2, . . . )

Aufgrund der Operation modulo m gilt stets

0 ≤ zj ≤ m − 1

(j = 0, 1, 2, . . . )

und durch die Normierung

zj

m

liefert das Schema eine Folge x0 , x1 , . . . im Einheitsintervall.

xj =

Beispiel 2.109. Wir betrachten die Zahlen

m = 100, a = 18, b = 11, z0 = 40

Dann folgt:

z1 = 18 · 40 + 11 = 731 = 31 (mod 100)

z2 = 18 · 31 + 11 = 569 = 69 (mod 100)

z3 = 18 · 69 + 11 = 1253 = 53 (mod 100)

und damit

x0 = 0.4, x1 = 0.31, x2 = 0.69, x3 = 0.53

Berechnet man die nächsten Folgenglieder erhält man allerdings

z4 = 65, z5 = 81, z6 = 69 = z2

d.h. nach zwei Schritten laufen wir in die Periode 69, 53, 65, 81 der Länge 4. Damit ist

dieser Kongruenzgenerator vollkommen ungeeignet.

96

2. MATHEMATISCHE METHODEN DER MODELLBILDUNG

Es ist leicht einsichtig, dass ein linearer Kongruenzgenerator aufgrund der oben angegebenen Rekursionsvorschrift eine maximale Periodenlänge besitzt und diese wegen

zj ∈ {0, 1, . . . , m − 1}

(j = 0, 1, 2, . . . )

gerade durch die Zahl m gegeben ist, d.h. in praktischen Anwendungen sollte daher m

möglichst groß wählen.

Im Fall b ≥ 1 wird diese Länge genau dann erreicht, wenn folgende Bedingungen erfüllt

sind:

• Das Inkrement b ist teilerfremd zu m.

• Jede Primzahl, die m teilt, teilt auch a − 1.

• Ist m durch 4 teilbar, so muss auch a − 1 durch 4 teilbar sein.

Beispiel 2.110. Das lineare Kongruenzschema

zj+1 = zj + 1 (mod m)

besitzt die maximale Periodenlänge m. Man überlegt sich aber direkt, dass die dadurch

erzeugte Zahlenfolge kaum als “zufällig erzeugt” angesehen werden kann.

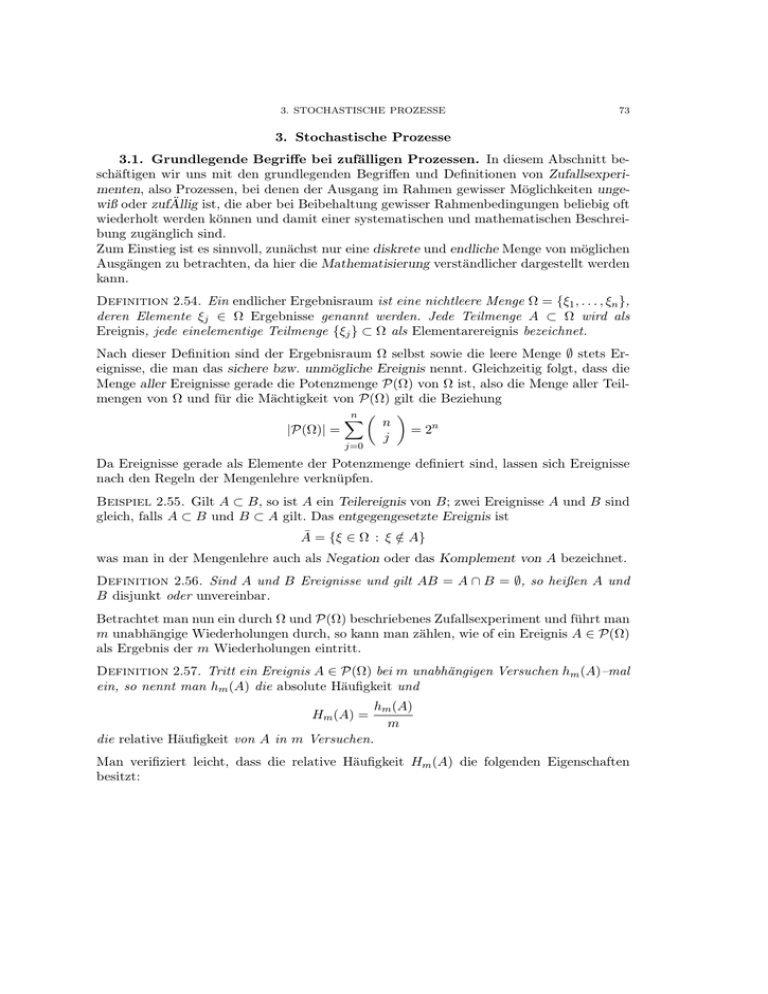

Eine weitere prinzipielle Schwäche linearer Kongruenzgeneratoren ist deren Gitterstruktur. Faßt man aufeinanderfolgende Punkte der Folge zu d–Tupeln zusammen, d.h. man

betrachtet die d–dimensionalen Vektoren (xi , xi+1 , . . . , xi+d−1 ), i ≥ 0, so läßt sich leicht

zeigen, dass diese stets auf einem Gitter im d–dimensionalen Raum Rd liegen.

Beispiel 2.111. Der lineare Kongruenzgenerator mit den Parametern

m = 256,

a = 25,

b=1

und

z0 = 1

erzeugt die nachfolgend dargestellte Punktmenge im Einheitsquadrat.

1

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

0

0.1

0.2

0.3

0.4

0.5

0.6

0.7

0.8

0.9

1

Abbildung 2.7: Gitterstruktur des linearen Kongruenzgenerators mit den Parametern

m = 256, a = 25 und b = 1.

3. STOCHASTISCHE PROZESSE

97

Ein historisches Beispiel, das die Schwäche der linearen Kongruenzgeneratoren klarmacht,

ist der Anfang der 60er Jahre des letzten Jahrhunders von der Computerfirma IBM eingeführte Zufallsgenerator randu mit den Parametern

m = 231 ,

a = 65539,

b=0

Dieser Pseudo–Zufallszahlengenerator besitzt die Periode 229 , erzeugt aber 229 Tripel

(xi , xi+1 , xi+2 ), die auf nur 15 (!) Ebenen im R3 liegen. Diese Eigenschaft wurde erst

sehr viel später entdeckt und nach Bekanntwerden von der IBM umgehend korrigiert.

Bei großen Modulen m und relativ wenigen Punktepaaren ist der Gittereffekt häufig nicht

sichtbar: die Parameter m = 224 , a = 54667, b = 1 und z0 = 1 erzeugen die 250 Punktepaare (x0 , x1 ), (x2 , x3 ), . . . , (x498 , x499 ), aus denen eine Gitterstruktur nicht erkennbar ist.

Zum Abschluss kommen wir zu einer theoretischen Beschreibung der Gitterstruktur: Für

festes d ≥ 2 betrachten wir die Spaltenvektoren

Zi = (zi , zi+1 , . . . , zi+d−1 )T ,

Durch Induktion zeigt man zunächst

0≤i<m

zi+s − zi = as (zi − z0 ) (mod m),

Für die entsprechenden Spaltenvektoren ergibt

1

a

Zi − Z0 = (zi − z0 ) .

..

ad−1

sich daraus

i, s ≥ 0

(mod m),

i≥0

wobei die Kongruenz modulo m komponentenweise anzuwenden ist.

Nach der Definition einer Kongruenzrelation gilt dann aber:

1

k1

a

k2

Zi − Z0 = (zi − z0 ) . + m . ,

i≥0

..

..

ad−1

kd

mit ganzen Zahlen k1 , k2 , . . . , kd .

Dann ist aber Z1 − Z0 eine ganzzahlige Linearkombination der d Vektoren

1

0

0

.

a m

.

.

. , . ,...,

.. ..

0

ad−1

0

m

und diese Vektoren definieren ein Gitter, auf dem alle Vektoren Zi − Z0 liegen.