Quantendynamik des harmonischen Oszillators - Physik Uni

Werbung

Bachelorarbeit im Studienfach Physik

Quantendynamik des harmonischen

Oszillators

vorgelegt am

Lehrstuhl für Theoretische Physik II

an der

Universität Augsburg

Von:

Matrikelnummer:

Michael Gromer

1176716

Am:

13.

2014

15.Mai

April

2014

Erstgutachter:

Betreuer:

Prof. Dr. Ulrich Eckern

Dr. Michael Dzierzawa

Inhaltsverzeichnis

1

2

Einleitung

Harmonischer Oszillator

2.1

2.2

3

4.2

4.3

4.4

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

5.4

5.5

7

7

8

10

11

14

20

23

Quantenmechanische Störungstheorie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25

28

Euler-Verfahren . . . . . . . . . . . . . . . . . . . . . . . .

4.1.1 Explizites Euler-Verfahren . . . . . . . . . . . . . .

4.1.2 Implizites Euler-Verfahren . . . . . . . . . . . . . .

Runge-Kutta-Verfahren . . . . . . . . . . . . . . . . . . . .

Klassische Betrachtung . . . . . . . . . . . . . . . . . . . .

Quantenmechanische Betrachtung . . . . . . . . . . . . . .

4.4.1 Ortsbasis . . . . . . . . . . . . . . . . . . . . . . .

4.4.2 Besetzungszahlbasis des harmonischen Oszillators .

4.4.3 Besetzungszahlbasis des anharmonischen Oszillators

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Ergebnisse

5.1

5.2

5.3

6

7

.

.

.

.

.

.

.

Numerische Behandlung

4.1

5

Klassische Betrachtung . . . . . .

2.1.1 Ungetriebener Fall . . . .

2.1.2 Mit treibender Kraft . . .

Quantenmechanische Betrachtung

2.2.1 Ungetriebener Fall . . . .

2.2.2 Mit treibender Kraft . . .

2.2.3 Störungstheorie . . . . . .

Anharmonischer Oszillator

3.1

4

5

Analytische Lösungen . . . . . . . . . . . . . . . . . .

Störungstheorie . . . . . . . . . . . . . . . . . . . . . .

Numerische Methoden . . . . . . . . . . . . . . . . . .

5.3.1 Programm . . . . . . . . . . . . . . . . . . . . .

5.3.2 Instabilität . . . . . . . . . . . . . . . . . . . .

Numerische Ergebnisse für den harmonischen Oszillator

5.4.1 Klassisch . . . . . . . . . . . . . . . . . . . . .

5.4.2 Quantenmechanisch . . . . . . . . . . . . . . .

5.4.3 Genauigkeit . . . . . . . . . . . . . . . . . . . .

Anharmonischer Oszillator . . . . . . . . . . . . . . . .

5.5.1 Eigenzustände . . . . . . . . . . . . . . . . . .

5.5.2 Zeitentwicklung . . . . . . . . . . . . . . . . .

Zusammenfassung

Anhang

28

28

30

31

34

35

35

38

39

41

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

41

45

47

47

48

49

49

52

58

61

61

65

70

71

A.1 Integration von Gleichung (2.16) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 71

A.2 Herleitung der Relation (2.57) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 73

A.3 Berechnung der Matrixdarstellung von x̂4 . . . . . . . . . . . . . . . . . . . . . . . . . . . 74

Literatur

76

3

1 Einleitung

Genauso, wie das zweite newtonsche Gesetz und äquivalente Formulierungen davon die grundlegenden

Gleichungen der klassischen Mechanik darstellen, bildet die Schrödingergleichung das Fundament der

Quantenmechanik. Sie ist damit der Ausgangspunkt für jedes quantenmechanische Problem. Wie jedoch

schon in der Bachelorvorlesung „Quantenmechanik“ klar wird, sind ihre Lösungen, bedingt durch ihre Form

(eine partielle Differentialgleichung) und das Vorhandensein des Potentials in der Gleichung, nur in den seltensten Fällen in mathematisch geschlossener Form darstellbar, also analytisch lösbar. Ist dies nicht mehr

möglich, so kann man einerseits das Potential durch ein analytisch Lösbares annähern oder man verwendet

Näherungsmethoden zur Lösung des ursprünglichen Potentials. Von diesen Näherungsmethoden sollen in

dieser Bachelorarbeit die Störungstheorie und die numerische Berechnung der Lösung betrachtet werden.

Zusätzlich wird auch die klassische Lösung als Referenz hinzugezogen und somit das Ehrenfest-Theorem

überprüft.

Es wird von einem harmonischen Oszillator ausgegangen, denn dieser hat den Vorteil, dass er einerseits

eines der Probleme ist, die noch analytisch lösbar sind und somit später die Resultate der verschiedenen

Näherungen mit der exakten Lösung verglichen werden können. Andererseits kann aber auch durch eine

einfache Modifikation, indem man einen quartischen Term zum Potential addiert, ein Fall konstruiert werden, der nicht mehr analytisch lösbar ist und somit nur noch näherungsweise behandelt werden kann. In

beiden Fällen wird der Oszillator zusätzlich durch eine zeitabhängige äußere Kraft angetrieben.

Die Wahl des harmonischen Oszillators ist aber nicht nur aus technischer Sicht sinnvoll. Der harmonische

Oszillator kann sehr gut auch für praktische Anwendungen eingesetzt werden: so können in der Molekülphysik die Bindungen zweier Atome näherungsweise durch eine ideale Feder beschrieben werden und eine

solche Feder stellt genau einen harmonischen Oszillator dar. Dies ist sowohl für lineare Schwingungen

(zwei verbundene Massepunkte) als auch für Torsionsschwingungen wie z.B. das Ethenmolekül möglich.

Man kann also Vorhersagen über die Schwingungsspektren treffen [Wik14]. Ein weiteres Beispiel ist das

Einstein-Modell: es beschreibt die Phononen, also Gitterschwingungen, in einem Festkörper, indem für jedes Atom das Potential eines dreidimensionalen harmonischen Oszillators verwendet wird. Damit kann der

Beitrag optischer Phononen zur Wärmekapazität eines Festkörpers berechnet werden [Wul03]. Auch andere

physikalische Phänomene können auf einen harmonischen Oszillator zurückgeführt werden: so bewegt sich

beispielsweise ein geladenes Teilchen in einem Magnetfeld spiralförmig. Der zum Magnetfeld senkrechte

Anteil dieser Bewegung kann durch einen eindimensionalen harmonischen Oszillator beschrieben werden

und man erhält dabei die Landau-Quantisierung [Wei04]. Allgemein kann jede Potentialmulde in erster

Näherung, für genügend kleine Auslenkungen, durch ein harmonisches Potential angenähert werden.

Besonderes Augenmerk wird in dieser Arbeit auf die numerische Lösung gelegt: diese ist vom Prinzip her

sehr simpel und darüber hinaus ist ihre Genauigkeit nur durch die zur Verfügung stehende Rechenleistung

bzw. Rechenzeit begrenzt. Es können also auch mit einer einfachen numerischen Methode beliebig genaue

Ergebnisse erzielt werden, wenn genügend Rechenleistung zur Verfügung steht. In der heutigen Zeit reicht

schon ein handelsüblicher PC vollkommen aus, um für eindimensionale Probleme in kurzer Zeit sehr genaue

Resultate zu bekommen.

Ziel dieser Arbeit ist es, am Beispiel des getriebenen harmonischen bzw. anharmonischen Oszillators

zu untersuchen, welche numerischen Verfahren am besten geeignet sind, die Zeitentwicklung des Systems

zu berechnen. Dazu werden die numerischen Ergebnisse mit den vorhandenen analytischen bzw. störungstheoretischen Resultaten verglichen. Ein weiterer wichtiger Aspekt ist die Stabilität und Genauigkeit der

betrachteten Verfahren sowie die benötigte Rechenzeit.

Die restlichen Abschnitte der Arbeit sind wie folgt aufgebaut: In Kapitel 2 werden die analytischen Lösungen für den klassischen und quantenmechanischen harmonischen Oszillator hergeleitet. Zusätzlich wird die

Lösung in zeitabhängiger Störungstheorie erster Ordnung gesucht. In Kapitel 3 werden wir uns dem anhar-

5

monischen Oszillator zuwenden und die Eigenzustände störungstheoretisch in erster Ordnung bestimmen.

In Kapitel 4 werden einige numerische Verfahren vorgestellt und erklärt, wie mit ihnen die Zeitentwicklung des harmonischen und anharmonischen Oszillators berechnet werden kann. Schließlich werden wir in

Kapitel 5 die Ergebnisse aller betrachteter Verfahren miteinander vergleichen und so die Stabilität und Genauigkeit der numerischen Verfahren analysieren. Zuletzt wird dann der anharmonische Oszillator mithilfe

der numerischen Verfahren genauer betrachtet. Einige eher technische Berechnungen werden im Anhang

präsentiert.

6

2 Harmonischer Oszillator

2.1 Klassische Betrachtung

Im Folgenden wird zuerst der klassische harmonische Oszillator betrachtet. Dieser ist einerseits einfacher

zu behandeln als der quantenmechanische Oszillator, da man es nicht mit einer Wellenfunktion zu tun hat,

sondern nur mit einem einzelnen Massepunkt. Andererseits werden wir später zeigen, dass die Ergebnisse

zumindest für den harmonischen Fall mit den quantenmechanischen Mittelwerten übereinstimmen.

Wie eingangs schon erwähnt, ist die, der klassischen Mechanik zugrunde liegende Gleichung, das zweite

newtonsche Gesetz (die Masse m wird hier und im Folgenden immer als konstant betrachtet):

F = ma

mit a = v̇ = ẍ =

d2 x

dt2

(2.1)

Diese Gleichung beschreibt, wie sich das System, bei gegebenem Anfangszustand im Lauf der Zeit verändert. Genau genommen beschreibt sie, wie der Massepunkt beschleunigt wird, nämlich mit der Beschleunigung mF .

2.1.1 Ungetriebener Fall

Abbildung 2.1: Vorstellung des eindimensionalen klassischen Oszillators

Die Vorstellung, die hinter dem eindimensionalen klassischen Oszillator steht, ist ein Federpendel (siehe

Abbildung 2.1): ein Massepunkt der Masse m kann sich in einer Dimension, also z.B. nach links und nach

rechts, bewegen. Über eine Feder ist er mit einem festen Punkt, z.B. an einer Wand, verbunden. Außer der

Kraft, die durch die Feder verursacht wird, wirken keine weiteren Kräfte auf den Massepunkt. Dies reicht

aus um ein schwingungsfähiges System zu erzeugen. Nimmt man nun eine ideale Feder an, also eine Feder

deren Rückstellkraft direkt proportional zur Auslenkung ist:

F = −kx

(2.2)

erhält man den harmonischen Fall. Hierbei ist F die Kraft, die durch die Feder auf den Massepunkt wirkt,

k die Federkonstante und x die Auslenkung aus der Ruhelage. Diese Kraft ist konservativ und kann somit

7

durch ein Potential mit F = − dV

dx ausgedrückt werden. Dieses lautet:

1

V(x) = kx2

(2.3)

2

Setzt man die Gleichung für die Federkraft (2.2) in das zweite newtonsche Gesetz (2.1) ein, ergibt sich die

Differentialgleichung des eindimensionalen klassischen harmonischen Oszillators:

m ẍ = −kx

(2.4)

Diese lineare harmonische Differentialgleichung kann allgemein mit einem Exponentialansatz gelöst werden. Gehen wir davon aus, dass der Massepunkt aus der Ruhelage ausgelenkt wird und dann bei x(0) = x0

mit v(0) = 0 losgelassen wird, kann man direkt den Ansatz

x(t) = x0 cos(ω0 t)

(2.5)

verwenden. Wir setzen dies in (2.4) ein und erhalten:

r

k

(2.6)

m

Gleichung (2.5) mit (2.6) löst die Gleichung (2.4) und ist somit die Bewegungsgleichung des eindimensionalen klassischen harmonischen Oszillators für die oben angegebenen Anfangsbedingungen. Der Massepunkt

schwingt mit der Frequenz f0 = ω2π0 zwischen den Umkehrpunkten x0 und −x0 sinusförmig hin und her,

daher kommt die Bezeichnung „harmonisch“.

Außerdem wird üblicherweise k durch m und ω0 ausgedrückt. Somit ist direkt die Frequenz vorgegeben

und für das Potential ergibt sich:

ω0 =

1

V(x) = mω20 x2

2

(2.7)

2.1.2 Mit treibender Kraft

Nun muss sich ein solches Federpendel aber nicht für immer im selben Schwingungszustand befinden,

sondern es kann auch nach dem Zeitpunkt t = 0 von außen angeregt werden. Um auf die Vorstellung

des Massepunktes und der Feder zurückzukommen: dies geschieht indem der zuvor feste Punkt, an dem

die Feder an der Wand befestigt war, bewegt wird. In Formeln ausgedrückt bedeutet dies, dass auf den

Massepunkt nun nicht nur die Kraft der Feder wirkt sondern zusätzlich eine zeitabhängige Störung FS (t).

Entsprechend erhält man ein zeitabhängiges Potential:

1

V(t,x) = mω20 x2 − FS (t)x

(2.8)

2

Für die treibende Kraft FS (t) werden wir im Folgenden eine Kraft mit sinusförmigem Verlauf und Kreisfrequenz ωS , die mit einer ansteigenden Exponentialfunktion bis zu einem Zeitpunkt tS eingeschaltet und von

da an mit der selben, umgekehrten Exponentialfunktion wieder ausgeschaltet wird, verwenden. Die maximale Amplitude wird mit AS bezeichnet. Dies sieht dann wie in Abbildung 2.2 aus oder, in einer Formel

ausgedrückt, folgendermaßen:

FS (t) = AS cos(ωS t)e−B|t−tS |

(2.9)

Diese spezielle Form der Kraft hat den Vorteil, dass sie analytisch sehr leicht zu behandeln ist.

Um die Bewegungsgleichung aus der Formel für die Kraft zu erhalten wird diese wieder in das zweite

newtonsche Gesetz (2.1) eingesetzt und man erhält:

ẍ + ω20 x =

FS

m

(2.10)

Diese Gleichung entspricht genau der Gleichung (2.4), allerdings nun mit der Inhomogenität FmS . Sie beschreibt allgemein den eindimensionalen klassischen getriebenen harmonischen Oszillator. Um sie zu lösen

verwendet man die greensche Funktion.

8

1

0,5

0

−0,5

−1

0

20

40

60

80

100

t

120

140

160

180

200

Abbildung 2.2: Treibende Kraft FS (t) mit AS = ωS = 1, B = 0,05 und tS = 100

Greensche Funktion

Gegeben sei eine lineare inhomogene Differentialgleichung:

L̂y(x) = f (x)

(2.11)

wobei L̂ ein linearer Differentialoperator ist:

L̂ =

n

X

i=0

ci

∂i

∂xi

(2.12)

Die allgemeine Lösung dieser Differentialgleichung ist die Summe aus der allgemeinen Lösung der homogenen Differentialgleichung ( f (x) = 0) und einer speziellen Lösung der inhomogenen Differentialgleichung

(2.11). Gesucht ist nun diese spezielle Lösung.

Wenn nun zu L̂ eine Funktion G(x,x0 ) existiert, die LG(x,x0 ) = δ(x − x0 ) erfüllt, so kann man die Lösung

von Gleichung (2.11) auch in der Form

Z ∞

y(x) =

G(x,x0 ) f (x0 )dx0

(2.13)

−∞

schreiben. Dies ist möglich, da der Differentialoperator L̂ nur auf x wirkt und nicht auf die Integrationsvariable x0 .

Lösung

Der Differentialoperator des harmonischen Oszillators (2.10) ist gegeben durch:

L̂ =

∂2

+ ω20

∂t2

(2.14)

mit zugehöriger greenscher Funktion G(t,t0 ) [HW09, S. 82]:

G(t,t0 ) =

1

sin(ω0 (t − t0 ))Θ(t − t0 )

ω0

(2.15)

9

Dabei ist Θ(t − t0 ) die Stufenfunktion. Die spezielle Lösung, die man durch die greensche Funktion erhält

sieht also folgendermaßen aus:

Z

1 ∞

x(t) =

G(t,t0 )FS (t0 )dt0 =

m −∞

Z t

1

sin(ω0 (t − t0 ))FS (t0 )dt0 =

=

mω0 −∞

Z t

0

AS

=

sin(ω0 (t − t0 )) cos(ωS t0 )e−B|t −tS | dt0

(2.16)

mω0 −∞

Die Integration dieses Ausdrucks bedarf keines besonderen Geschicks, es müssen lediglich die Trigonometrischen Funktionen durch e-Funktionen ausgedrückt werden. Um dann über den Betrag zu integrieren,

integrieren wir für t > tS von −∞ bis tS mit negiertem t − tS und dann von tS bis t. Für den Fall, dass t < tS

integrieren wir nur von −∞ bis t. Die gesamte Rechnung ist für diesen Fall im Anhang unter A.1 zu finden.

Für einige spätere Rechnungen, die ähnlich verlaufen, wird dann ein Computerprogramm verwendet und

hier nur noch das Ergebnis angegeben. Hier ergibt sich für t < tS :

AS eB(t−t0 ) − C1 sin(ωS t) + C2 cos(ωS t)

2mω0

(2.17)

AS D1 sin(ω0 t) + D2 cos(ω0 t) + eB(tS −t) C1 sin(ωS t) + C2 cos(ωS t)

2mω0

(2.18)

x(t) =

Und für t > tS :

x(t) =

Dabei wurden zur Vereinfachung folgende Konstanten verwendet:

C1 =

D1 =

B

B

−

(ω0 + ωS )2 + B2 (ω0 − ωS )2 + B2

2B cos((ω0 + ωS )tS ) 2B cos((ω0 − ωS )tS )

+

(ω0 + ωS )2 + B2

(ω0 − ωS )2 + B2

C2 =

ω0 + ωS

ω0 − ωS

+

(ω0 + ωS )2 + B2 (ω0 − ωS )2 + B2

D2 = −

2B sin((ω0 + ωS )tS ) 2B sin((ω0 − ωS )tS )

−

(ω0 + ωS )2 + B2

(ω0 − ωS )2 + B2

Dieses Ergebnis ist durch die Aufteilung der trigonometrischen Funktionen und des Betrages recht unübersichtlich. Es stellt jedoch die exakte Form der Bewegungsgleichung für den klassischen getriebenen

harmonischen Oszillator mit der oben angegeben Form für die treibende Kraft FS dar. Betrachtet man diese

Bewegungsgleichung so wird klar, wie sich der Oszillator verhält: bis zum Zeitpunkt tS wird ihm die Anregungsfrequenz ωS aufgezwungen und die Schwingungsamplitude steigt, wie auch die Anregungsamplitude,

exponentiell an. Für Zeiten größer als tS schwingt der Oszillator mit seiner Eigenfrequenz ω0 weiter, wobei

diese Schwingung mit einer exponentiell abfallenden Schwingung in Anregungsfrequenz überlagert wird.

Die Amplituden und Phasen sind dabei in den Konstanten C1 , C2 , D1 und D2 enthalten.

Oben wurde bereits gesagt, dass man, um die allgemeine Lösung zu erhalten, noch die allgemeine Lösung

der homogenen Differentialgleichung addieren müsste. Dieser Term fällt aber wieder weg, wenn man davon

ausgeht, dass sich der Oszillator zum Zeitpunkt t = −∞ in der Ruhelage befunden hat, dass also gilt:

x(−∞) = v(−∞) = 0. Genau davon gehen wir hier und im Folgenden dieser Arbeit auch aus, um für

die verschiedenen Arten der Berechnung vergleichbare Ergebnisse zu erhalten. Im Kapitel 5 wird dieses

Ergebnis nochmals betrachtet und mit weiteren Resultaten verglichen.

2.2 Quantenmechanische Betrachtung

In diesem Abschnitt wird nun der gleiche harmonische Oszillator wie bisher betrachtet, nur dass er jetzt

als quantenmechanisches System ausgewertet wird. Dabei wird zuerst wieder der ungetriebene Fall, also

ein harmonischer Oszillator ohne äußere Kraft, betrachtet und dann die treibende Kraft aus Gleichung (2.9)

hinzugefügt um einen quantenmechanischen getriebenen harmonischen Oszillator zu erhalten.

10

Im Gegensatz zur klassischen Mechanik wird nun anstatt des zweiten newtonschen Gesetzes die Schrödingergleichung verwendet. Sie lautet in zeitabhängiger Form:

∂

|ψ(t)i = Ĥ|ψ(t)i

∂t

p̂2

mit Ĥ =

+ V( x̂)

2m

i~

(2.19)

Ähnlich wie schon das zweite newtonsche Gesetz beschreibt diese Gleichung wieder, wie sich ein System

bei gegebenem Anfangszustand verändert. Dieser Anfangszustand ist nun jedoch nicht durch Position x und

Geschwindigkeit v eines Massepunktes beschrieben, sondern durch den Zustandsvektor |ψ(t)i im Hilbertraum. Das Betragsquadrat dieses Zustandsvektor gibt die Wahrscheinlichkeit an, das beschriebene Teilchen

in einem bestimmten Gebiet der noch zu wählenden Basis zu finden. Da das Teilchen nicht verschwinden

kann, wird zusätzlich gefordert, dass der Zustandsvektor normiert ist:

hψ(t)|ψ(t)i = 1

für alle t

(2.20)

Die stationären (=zeitinvarianten) Zustände werden dabei durch die stationäre Schrödingergleichung beschrieben. Es handelt sich dabei um die Eigenwertgleichung des Hamiltonoperators:

Ĥ|ψn i = En |ψn i

(2.21)

Im Gegensatz zur zeitabhängigen Schrödingergleichung liefert diese Gleichung einen oder mehrere Zustandsvektoren, die sich, wenn man die zeitabhängige Schrödingergleichung darauf anwendet, nur in ihrer

Phase verändern. Da die Phase des Zustandes für das Betragsquadrat unbedeutend ist, ändern sich die Erwartungswerte nicht mit der Zeit, der Zustand ist stationär.

2.2.1 Ungetriebener Fall

Um die Eigenzustände des quantenmechanischen harmonischen Oszillators zu finden, müssen wir die stationäre Schrödingergleichung (2.21) mit dem Hamiltonoperator für das Potential des harmonischen Oszillators

(2.7) lösen. Dieser lautet wie folgt:

Ĥ =

p̂2

p̂2 1

+ V( x̂) =

+ mω20 x̂2

2m

2m 2

(2.22)

Dies ist zwar auch in der Ortsdarstellung möglich, jedoch in der Besetzungszahlbasis sehr viel einfacher

und eleganter. Dazu definiert man zuerst scheinbar willkürlich den Operator â und seinen Adjungierten ↠,

die sogenannten Leiteroperatoren:

r

mω0

i p̂

â :=

x̂ + √

„Vernichtungsoperator“

2~

2mω0 ~

r

mω0

i p̂

†

⇒ â =

x̂ − √

„Erzeugungsoperator“

(2.23)

2~

2mω0 ~

Zusätzlich definieren wir den Besetzungszahloperator N̂ und nennen seine Eigenwerte Nn :

N̂ := ↠â

„Besetzungszahloperator“

N̂|ψn i = Nn |ψn i

(2.24)

Mit der Relation [ p̂, x̂] = −i~ lässt sich der Kommutator [â,↠] berechnen und man kann den Hamiltonoperator (2.22) durch die Leiteroperatoren oder den Besetzungszahloperator ausdrücken:

h

i

â,↠= 1

(2.25)

!

!

1

1

Ĥ = ~ω0 ↠â +

= ~ω0 N̂ +

(2.26)

2

2

11

Setzt man dies in die stationäre Schrödingergleichung (2.21) ein, erhält man:

!

!

1

1

En |ψn i = Ĥ|ψn i = ~ω0 N̂ + |ψn i = ~ω0 Nn + |ψn i

2

2

(2.27)

und sieht, dass der Hamiltonoperator und der Besetzungszahloperator die gleichen Eigenzustände |ψn i haben

und, dass außerdem für die Eigenwerte gilt:

!

1

(2.28)

En = ~ω0 Nn +

2

Nun multipliziert man die Gleichung (2.27) von links mit â und erhält folgendes:

!

!

h

i!

1

1

†

†

†

âĤ|ψn i = ~ω0 â â â + |ψn i = ~ω0 â â + â + â,â â |ψn i =

2

2

| {z }

=â

!

1

~ω0 ↠â + + 1 â|ψn i = Ĥ + ~ω0 â|ψn i = En â|ψn i

2

⇒ Ĥ â|ψn i = (En − ~ω0 ) â|ψn i

(2.29)

Gleichung (2.29) besagt genau, dass â|ψn i der Eigenzustand zur Energie En − ~ω0 ist. Analog erhält man

für ↠|ψn i einen Eigenzustand zur Energie En + ~ω0 :

Ĥ ↠|ψn i = (En + ~ω0 ) ↠|ψn i

(2.30)

Dies erklärt nun die Namen von â und ↠: sie liefern aus einem Zustand einen Zustand mit einem Energiequant ~ω0 weniger bzw. mehr, sie vernichten bzw. erzeugen also ein Energiequant.

Eigenwerte

Da man den Vernichtungsoperator â beliebig oft auf |ψn i anwenden kann, die Energie des Zustandes En =

hψn |Ĥ|ψn i aber nie negativ werden kann, muss diese Folge irgendwann ein Ende finden. Für den Grundzustand, den man |ψ0 i nennt, gilt daher:

â|ψ0 i = 0

(2.31)

Multiplikation von links mit ↠liefert:

!

Ĥ

1

− |ψ0 i

⇒ 0 = â â|ψ0 i =

~ω0 2

~ω0

⇒ Ĥ|ψ0 i =

|ψ0 i = E0 |ψ0 i

2

†

Daraus ergibt sich die Energie des Grundzustandes E0 und aus ihr durch n-maliges Anwenden des Erzeugungsoperators auf den Grundzustand, d.h. mit Gleichung (2.30), die Energien aller weiteren Zustände:

E0 =

~ω0

2

1

En = ~ω0 n +

2

!

(2.32)

Zieht man nun noch Gleichung (2.28) hinzu, sieht man sofort, dass

Nn = n

(2.33)

gelten muss. Damit wird auch die Namensgebung des Besetzungszahloperators ersichtlich: er ordnet einem

Eigenzustand seine „Nummerierung“ zu.

12

Normierung

Diese Eigenzustände sind jedoch nicht normiert, was man korrigieren muss, um daraus den physikalischen

Zustand mit der nächstniedrigeren bzw. nächsthöheren Energie zu erhalten:

K|ψn−1 i = â|ψn i

1

Nn

n

!

⇒ 1 = hψn−1 |ψn−1 i = 2 hψn |↠â|ψn i = 2 hψn |ψn i = 2

K

K

K

√

⇒K= n

Die analoge Rechnung ergibt auch die Normierung für ↠. Es gilt also:

√

â|ψn i = n|ψn−1 i

√

↠|ψn i = n + 1|ψn+1 i

(2.34)

Eigenfunktionen in Ortsdarstellung

Aus Gleichung (2.31) kann man nicht nur die Energie des Grundzustandes erhalten, sondern auch den

Grundzustand in Ortsdarstellung. Dazu setzt man die Definition des Vernichtungsoperators (2.23) ein und

verwendet für den Impuls- und Ortsoperator deren Darstellung in Ortsbasis:

d

dx

x̂ = x

p̂ = −i~

(2.35)

Man erhält dadurch folgende Differentialgleichung:

s

r

mω

~

d

0

ψ (x) = 0

x

+

0

2~

2mω0 dx

(2.36)

Daraus ergibt sich mit Normierung:

ψ0 (x) =

mω 14

0

π~

mω 0 2

exp −

x

2~

(2.37)

Da man nun die Wellenfunktion des Grundzustandes ermittelt hat, kann man darauf nun den Erzeugungsoperator beliebig oft anwenden, und somit alle Zustände des quantenmechanischen harmonischen Oszillators

zu erzeugen:

s

r

n

1 mω0

~ d

ψn (x) = √

x+

(2.38)

ψ0 (x)

2~

2mω0 dx

n!

Betrachtet man diese Gleichung genauer, so fällt auf, dass es sich dabei fast genau um die Definition der

hermiteschen Polynome handelt. Diese sind definiert als:

!n

x2

x2

d

e− 2

(2.39)

Hn (x) = e 2 ξ −

dξ

q

0

Mit ξ = x mω

~ kann man die Wellenfunktionen ψn somit auch schreiben als:

ψn (x) =

mω 41

0

π~

1

Hn

√

2n n!

r

!

1 mω0 2

mω0

x e− 2 ~ x

~

(2.40)

13

Matrixdarstellung von â, ↠und N̂

Wir wissen aus den vorherigen Kapiteln, wie die Leiteroperatoren in der Ortsbasis aussehen. Wir benötigen aber, insbesondere für spätere numerische Berechnungen in der Besetzungszahlbasis des harmonischen

Oszillators in Kapitel 4, die Darstellungen dieser Operatoren in dieser Basis, also der Eigenbasis des Besetzungszahloperators N̂. Mit Gleichung (2.34) ergeben sich die Matrixdarstellungen indem man vor und hinter

P

dem Operator dein 1-Operator Iˆ = ∞

n=0 |ψn ihψn | einschiebt. Man erhält für den Vernichtungsoperator:

â =

∞

X

m,n=0

|ψm i hψm |â|ψn ihψn |

| {z }

=âmn

√

√

mit âmn = hψm |â|ψn i = nhψm |ψn−1 i = nδm,n−1

√

0

1 √

2 √

0

0

3

⇒ â =

. .

.

0

. .

.

Analog erhält man die Matrixdarstellung für den Erzeugungsoperator:

√

√

â†mn = hψm |↠|ψn i = n + 1hψm |ψn+1 i = n + 1δm,n+1

√0

1 √0

†

2

0

⇒ â =

√

3

0

. . . .

.

.

(2.41)

(2.42)

Um später den Hamiltonoperator in Besetzungszahlbasis auszudrücken, benötigen wir nun noch die Matrixdarstellung des Besetzungszahloperators. Dazu verwendet man einfach dessen Eigenwertgleichung:

N̂mn = hψm |N̂|ψn i = nhψm |ψn i = nδmn

0

1

N̂ =

2

. .

.

(2.43)

Außerdem kann man die Definitionen der Leiteroperatoren (2.23) auch nach Impuls- bzw. Ortsoperator

auflösen:

r

mω0 ~ p̂ = −i

â − â†

2

s

~ x̂ =

â + â†

(2.44)

2mω0

Man hat somit mit dem Hamiltonoperator (2.26) alle benötigten Operatoren in Matrixdarstellung zur Verfügung und kann in Besetzungszahlbasis rechnen.

2.2.2 Mit treibender Kraft

Die analytische Lösung der Eigenzustände des quantenmechanischen harmonischen Oszillators war schon

recht kompliziert und nicht ganz einfach zu erhalten. Es ist jedoch auch noch möglich, wie in [Mab07]

14

beschrieben, die Zeitentwicklung dieser Zustände unter dem Einfluss einer externen treibenden Kraft analytisch darzustellen. Dazu verwenden wir die Besetzungszahlbasis im Wechselwirkungsbild, d.h. wir teilen

den Hamiltonoperator in einen zeitunabhängigen Teil Ĥ0 und einen zeitabhängigen Teil auf. Der zeitunabhängige Teil ist dabei genau der Hamiltonoperator des ungetriebenen harmonischen Oszillators. Der zeitabhängige Teil ist durch das Potential der treibenden Kraft gegeben und da das Potential des harmonischen

Oszillators ohne externe Kraft schon in Ĥ0 steckt, werden wir in diesem Kapitel nur den zeitabhängigen

Teil mit V̂ bezeichnen. In Gleichung (2.8) haben wir bereits das zum getriebenen harmonischen Oszillator

gehörige Potential gegeben. Damit lautet der Hamiltonoperator wie folgt:

!

p̂2 1

1

2

Ĥ(t) =

+ mω0 x̂ −FS (t) x̂ = Ĥ0 + V̂(t) = ~ω0 N̂ +

+ V̂(t)

(2.45)

2m {z

2

2

|

} | {z }

=:Ĥ0

=:V̂(t)

Der Sinn der Betrachtung im Wechselwirkungsbild ist nun, die zeitliche Entwicklung, die durch Ĥ0 verursacht wird, in die zeitliche Abhängigkeit der verwendeten Operatoren zu packen und die zeitliche Entwicke(t) auszudrücken. Mit

lung, die durch V̂ verursacht wird, durch die zeitliche Abhängigkeit des Zustandes ψ

der Tilde über den Zuständen und Operatoren wird gekennzeichnet, dass es sich um jeweilige im Wechselwirkungsbild handelt. Man wählt also eine zeitlich veränderliche Basis und muss somit jeden Zustand und

jeden Operator in diese Basis umrechnen:

e(t)i = T̂ † (t,0)|ψ(t)i = exp i Ĥ0 t |ψ(t)i

|ψ

(2.46)

0

~

i

i

e = T̂ † (t,0)ÂT̂ 0 (t,0) = exp Ĥ0 t  exp − Ĥ0 t

(2.47)

A(t)

0

~

~

Somit sind nun auch die Operatoren zeitabhängig. T̂ 0 ist dabei der Zeitentwicklungsoperator des ungetriebenen harmonischen Oszillators, der einen Zustand vom Zeitpunkt t0 zum Zeitpunkt t entwickelt. Da Ĥ0

zeitunabhängig ist, ist er gegeben durch:

i

T̂ 0 (t,t0 ) = exp − Ĥ0 (t − t0 )

(2.48)

~

Dies wurde in den Gleichungen (2.46) und (2.47) schon verwendet.

Wir werden im Folgenden einen Ausdruck für den Zeitentwicklungsoperator im Wechselwirkungsbild

e

ei berechnen und dieser kann ins

T finden. Damit lässt sich dann der Zustand im Wechselwirkungsbild |ψ

Schrödingerbild zurückkonvertiert werden, womit wir die gesuchte Zeitentwicklung des quantenmechanischen getriebenen harmonischen Oszillators gefunden haben werden.

Zeitentwicklungsoperator

Der Zeitentwicklungsoperator im Wechselwirkungsbild Te ist formal gegeben durch:

"

!#

Z

i te 0 0

V(t )dt

Te(t,t0 ) = T̂ exp −

~ t0

(2.49)

e zu verschiedenen Zeiten nicht mit sich selbst kommit dem Zeitordnungsoperator T̂ . Dieser ist nötig, da V

mutiert. Er gleicht die, durch die Exponentialfunktion „verlorene“ Zeitordnung, wieder aus. Da sich damit

jedoch nicht rechnen lässt, brechen wir das Integral im Exponenten in infinitesimal kleine Stücke auseinander und exponentieren jedes Stück einzeln. Dazu definieren wir ein „Stück“ dieses Integrals als:

Z t0 +n

e 0 )dt0 mit := t − t0

en = − i

V

V(t

(2.50)

~ t0+(n−1)

N

Somit kann man Te schreiben als:

e

e

Te(t,t0 ) = lim eVN . . . eV1

N→∞

(2.51)

15

e zu verschiedenen Zeiten nicht mit sich selbst kommutiert. Man kann jedoch

Oben haben wir gesagt, dass V

e

verwenden, dass V mit dem Kommutator kommutiert, dass also gilt:

ii

h

h

e 0 ),V(t

e 00 ) = 0

e

V(t

(2.52)

V(t),

Dies werden wir später auch für die treibende Kraft nachweisen. Man wendet nun die, unter der Voraussetzung [Â,[Â, B̂]] = [ B̂,[Â, B̂]] = 0, geltende Baker-Campbell-Hausdorff-Formel

e eB̂ = eÂ+B̂+[Â,B̂]/2

(2.53)

mehrmals auf den Ausdruck (2.51) an:

h

i

e

e e e e

e

e e e e e e

Te(t,t0 ) = lim eVN . . . eV4 eV3 eV2 eV1 = lim eVN . . . eV4 eV3 eV2 +V1 + V2 ,V1 /2 =

N→∞

= lim e

N→∞

eN

V

= lim e

N→∞

eN

V

N→∞

h

h

i i

e3 +V

e2 +V

e1 + V

e3 ,V

e2 +V

e1 + V

e2 ,V

e1 /2 /2

e4 V

V

...e e

. . . eV4 e

e

=

i i

h

i

h h

e2 ,V

e1 /2 /2

e3 ,V

e2 +V

e1 /2+ V

e3 , V

e3 +V

e2 +V

e1 + V

V

|

h

i

{z

=0

h

}=

h

i i

= lim eVN . . . eV4 +V3 +V2 +V1 + V3 ,V2 +V1 /2+ V4 ,V3 +V2 +V1 + V3 ,V2 +V1 /2 /2 =

e

e

N→∞

eN

V

= lim e

N→∞

e

e

e

e e

h

e

i

e e

e

h

e

i

e e

h

e

h

e e e

i i

2 +V1 /2 /2

. . . eV4 +V3 +V2 +V1 + V3 ,V2 +V1 /2+ V4 ,V3 +V2 +V1 /2+|V4 , V3 ,V{z

}=

=0

N

"

#!

X

n

P

1

en + V

en , V

ek

= . . . = lim exp

V

N→∞

2

k=1

n=1

e

e

e

e

e e

e

e e

e

e

e

Die zweite Summe kann man nun aus dem Kommutator herausziehen und den Limes ausführen. Dadurch

erhält man den finalen, allgemeinen Ausdruck für den Zeitentwicklungsoperator unter der Annahme, dass

Gleichung (2.52) gilt:

Z

Z t Z t0 h

i

i t

1

0

0

0

00

00

0

e

e

e

e

T (t,t0 ) = exp −

V(t )dt − 2

V(t )V(t ) dt dt

(2.54)

~ t0

2~ t0 t0

e keine Aussagen getroffen, außer, dass es mit seinem eigenen KomBisher haben wir über das Potential V

mutator kommutieren muss um auf den Ausdruck (2.54) zu kommen. Wenn wir nun das Potential (2.45)

verwenden, dann können wir Te weiter spezifizieren. Wir verwenden also:

s

~

FS (t) â + â†

V̂(t) = −FS (t) x̂ = −

(2.55)

2mω0

e mit Gleichung (2.47):

Somit ergibt sich für das Potential im Wechselwirkungsbild V

s

i

i

~

e =−

exp Ĥ0 t FS (t) â + ↠exp − Ĥ0 t =

V(t)

2mω0

~

~

s

~

=−

FS (t) exp iω0 ↠ât â + ↠exp −iω0 ↠ât =

2mω0

s

~

=−

FS (t) âe−iω0 t + ↠eiω0 t

2mω0

(2.56)

Dabei wurde, um auf die dritte Zeile zu kommen, folgende Relation verwendet. Diese wird im Anhang A.2

hergeleitet.

h

i

exp X̂ Ŷ exp −X̂ = eµ Ŷ für X̂,Ŷ = µŶ

(2.57)

h

i

h

i

↠â,â = −â ⇒ µ = −iω0 t bzw. ↠â,↠= ↠⇒ µ = iω0 t

16

e mit sich selbst, den wir unter anderem

Der Ausdruck 2.56 ist ausreichend um nun den Kommutator von V

im Ausdruck für den Zeitentwicklungsoperator (2.54) verwendet haben, zu berechnen:

h

=

h

0

0

00

00 i

~

FS (t0 )FS (t00 ) âe−iω0 t + ↠eiω0 t ,âe−iω0 t + ↠eiω0 t =

2mω0

0 h

00

00 i

0 h

00

00 i

FS (t0 )FS (t00 ) e−iω0 t â,âe−iω0 t + ↠eiω0 t + eiω0 t ↠,âe−iω0 t + ↠eiω0 t =

i

e 0 ),V(t

e 00 ) =

V(t

~

2mω0

=

i

i

0

00 h

0

00 h

~

FS (t0 )FS (t00 ) e−iω0 t +iω0 t â,↠+ eiω0 t −iω0 t ↠,â =

2mω0

|{z}

|{z}

=1

=−1

~

0

00

−iω0 (t0 −t00 )

iω0 (t0 −t00 )

FS (t )FS (t ) e

−e

=

=

2mω0

!

1 ix

mit sin x =

e − e−ix

2i

i~

FS (t0 )FS (t00 ) sin ω0 (t0 − t00 )

=−

2mω0

(2.58)

e mit sich selbst zu verschiedenen Zeiten immer eine komplexe Zahl. Eine

Somit ist der Kommutator von V

e selbst, und somit ist Gleikomplexe Zahl kommutiert aber mit jedem Operator, insbesondere auch mit V

chung (2.52) für eine treibende Kraft mit einem Potential der Form (2.55) bestätigt. Außerdem kann das

Doppelintegral im Zeitentwicklungsoperator (2.54) über genau diese komplexe Zahl nun, mit gegebenem

FS , direkt ausgerechnet werden. Wir geben diesem Integral (bis auf einen Faktor i) zur Vereinfachung der

Notation den Namen β:

Z t Z t0 h

i

i

e 0 )V(t

e 00 ) dt00 dt0 =

β(t,t0 ) := − 2

V(t

2~ t0 t0

Z t Z t0

1

=

FS (t0 )FS (t00 ) sin ω0 (t0 − t00 ) dt00 dt0

2mω0 ~ t0 t0

(2.59)

Um auch das erste Integral in (2.54) kürzer schreiben zu können, definieren wir uns zusätzlich ζ als:

Z t

0

i

FS (t0 )eiω0 t dt0

(2.60)

ζ(t,t0 ) := √

2mω0 ~ t0

Auch dieses Integral ist mit einem gegebenen FS einfach auszurechnen. Nun setzt man das Potential (2.56),

β und ζ in den Zeitentwicklungsoperator ein und erhält:

r

Z t

0

0

1

0

−iω

t

†

iω

t

0

0

0

0

Te(t,t0 ) = exp i

FS (t ) âe

+ â e

dt + iβ(t,t ) =

2mω0 ~ t0

r

r

Z

Z t

t

0

0

1

1

iβ(t,t0 )

0

−iω

t

0

0

iω

t

0

FS (t )e 0 dt â + i

FS (t )e 0 dt ↠=

=e

exp i

2mω0 ~ t0

2mω0 ~ t0

|

{z

}

|

{z

}

=−ζ ∗ (t,t0 )

=ζ(t,t0 )

= eiβ(t,t0 ) exp ζ(t,t0 )↠− ζ ∗ (t,t0 )â

Dieses Ergebnis kann nun mit dem Verschiebungsoperator D̂ nochmals kürzer ausgedrüct werden:

D̂(α) := exp α↠− α∗ â

Te(t,t0 ) = eiβt,t0 D̂(ζ(t,t0 ))

(2.61)

(2.62)

Bisher haben wir im Wechselwirkungsbild gerechnet. Wir wollen nun den Zeitentwicklungsoperator im

Schrödingerbild erhalten und führen dafür die umgekehrte Basistransformation wie in Gleichung (2.47)

17

durch:

i

i

T̂ (t,t0 ) = exp − Ĥ0 t Te(t,t0 ) exp Ĥ0 t0 =

~

~

i

i

i

= eiβ(t,t0 ) exp − Ĥ0 t D̂(ζ(t,t0 )) exp Ĥ0 t exp − Ĥ(t − t0 ) =

~

~

~

i

iβ(t,t0 )

−iω0 t

=e

D̂(ζ(t,t0 )e

) exp − Ĥ0 (t − t0 ) =

~

iβ(t,t0 )

−iω0 t

=e

D̂(ζ(t,t0 )e

)T̂ 0 (t,t0 )

(2.63)

Der Schritt von der zweiten Zeile zur dritten ist hier nicht ganz trivial. Um den Phasenfaktor im Argument

des Verschiebungsoperators zu erhalten, muss man die Exponentialfunktion im Verschiebungsoperator als

Potenzreihe schreiben und die Formel (2.57) aus Anhang A.2 für jeden Faktor â und ↠verwenden.

Zustand

Wir haben mit Gleichung (2.63) nun einen Ausdruck für den Zeitentwicklungsoperator im Schrödingerbild erhalten. Mit diesem können wir einen beliebigen Anfangszustand nun unter einer treibenden Kraft

FS zeitlich entwickeln. Damit können wir exakt beschreiben, wie sich der quantenmechanische getriebene

harmonische Oszillator verhält.

Wie schon in Kapitel 2.1.2 gehen wir auch hier wieder davon aus, dass sich der Oszillator zum Zeitpunkt

t0 = −∞ in der Ruhelage, also dem Grundzustand |ψ0 i befindet. Auf diesen Grundzustand wenden wir nun

den im letzten Kapitel berechneten Zeitentwicklungsoperator an:

|ψ(t)i = T̂ (t,t0 )|ψ0 i = eiβ(t,t0 ) D̂(ζ(t,t0 )e−iω0 t )T̂ 0 (t,t0 )|ψ0 i =

| {z }

=:α

i

iβ(t,t0 )

†

∗

=e

exp αâ − α â e− 2 ω0 t |ψ0 i =

h

i

h

i

mit eÂ+B̂ = e eB̂ e−[Â,B̂]/2 und α↠, − α∗ â = −|α|2 ↠,â = |α|2

0 ) − 2 ω0 t −|α|

=|

e−iβ(t,t{z

e }e

2 /2

i

exp α↠exp −α∗ â |ψ0 i =

=:φ(t,t0 )

2 /2

= φ(t,t0 )e−|α|

∞

X

(−α∗ )n n

exp αâ†

â |ψ0 i =

n! |{z}

n=0

=0 für n>0

|

{z

}

=|ψ0 i

2 /2

= φ(t,t0 )e−|α|

∞

X

2

αn † n

exp α↠|ψ0 i = φ(t,t0 )e−|α| /2

â |ψn i =

n!

n=0

√

∞

X

αn n!

−|α|2 /2

|ψn i =

= φ(t,t0 )e

n!

n=0

= e−iβ(t,t0 ) e− 2 ω0 t e−|α(t)|

i

2 /2

∞

X

αn (t)

√ |ψn i mit α(t) := ζ(t,t0 )eiω0 t

n!

n=0

(2.64)

Damit haben wir nun eine vollständige Formel für den Zustand des quantenmechanischen getriebenen harmonischen Oszillators zur Zeit t gefunden. Es handelt sich dabei im wesentlichen um eine Spektraldarstellung, d.h. um eine gewichtete Summe der Eigenzustände des ungetriebenen Oszillators |ψn i mit einem

zusätzlichen Phasenfaktor. Auch dieses Ergebnis werden wir in Kapitel 5 erneut betrachten. Einmal, um es

mit den restlichen Ergebnissen, wie z.B. dem klassischen zu vergleichen. Da es sich hierbei um die exakte

Lösung eines quantenmechanischen Problems handelt, können wir unsere numerischen Ergebnisse später

nicht nur auf Plausibilität überprüfen, sondern auch feststellen, wie genau diese sind.

Setzt man nun FS in ζ(t,t0 ) ein, so kann man α(t) in Abhängigkeit von t berechnen und erhält damit den

Zustand zu einem gegebenen Zeitpunkt t. Es handelt sich bei dem Integral in ζ(t,t0 ) fast um das gleiche

18

Integral, das für den klassischen Ort (2.16) berechnet werden musste. Der einzige Unterschied ist, dass hier

anstatt dem Sinus eine komplexe Exponentialfunktion auftaucht. Wir werden darauf aber in Kapitel 2.2.2

nochmals zu sprechen kommen. Man erhält für t < tS :

iAS eB(t−tS ) ωS sin(ωS t) + (B + iω0 ) cos(ωS t)

α(t) = √

ω2S + (B + iω0 )2

2~mω0

(2.65)

Und für t > tS :

2Beiω0 tS B2 + ω2 + ω2 cos(ωS tS ) − 2iω0 ωS sin(ωS tS )

iAS

0

S

α(t) = √

+

2

2~mω0

B2 + ω20 + 2ω2S B2 − ω20 + ω4S

e−iω0 t

eB(tS −t)+iω0 t (ωS sin(ωS t) − (B − iω0 ) cos(ωS t))

+

2

2

ωS + (B − iω0 )

(2.66)

Sieht man sich die Gewichtung der Eigenzustände genauer an, so fällt noch auf, dass es sich dabei um

eine Poissonverteilung handelt. Diese ist definiert als:

Pλ (k) =

λk −λ

e

k!

und die Wahrscheinlichkeit, das System zum Zeitpunkt t im Zustand |ψk i zu finden lautet:

2

2 ∞

∞

n

n

X

X

2

2

a

a

|hψk |ψ(t)i|2 = hψk |e−|α| /2

√ |ψn i = e−|α| /2

√ hψk |ψn i =

n!

n! | {z }

n=0

n=0

=δkn

2

2k

−|α|2 /2 αk 2

|α|

= e

= P|α|2 (k)

√ = e−|α|

k!

k! (2.67)

(2.68)

Erwartungswerte

Da es sich der berechneten Zeitentwicklung immer um kohärente Zustände handelt, erhält man, wie in

[Fli08, S. 259] beschrieben, für den Orts- bzw. Impulserwartungswert:

|ψ(t)i = D̂(α(t))|ψ0 i mit α(t) = ζ(t,t0 )e−iω0 t

s

Z t

~

1

Re(α(t)) =

h x̂i(t) = hψ(t)| x̂|ψ(t)i = 2

FS (t0 ) sin(ω0 (t − t0 ))dt0

2mω0

mω0 t0

r

Z t

mω0 ~

Im(α(t)) =

FS (t0 ) cos(ω0 (t0 − t))

h p̂i(t) = hψ(t)| p̂|ψ(t)i = −2i

2

t0

(2.69)

Das entspricht für h x̂i(t) exakt der in Kapitel 2.1.2 berechneten klassischen Zeitentwicklung des Ortes (2.16).

Damit ist auch geklärt, warum das Integral in α(t) dem in der klassischen Lösung vorkommenden Integral

entspricht. Die Äquivalenz von quantenmechanischem Erwartungswert und klassischer Zeitentwicklung war

nach dem Ehrenfest-Theorem zu erwarten, konnte aber somit für den harmonischen Oszillator explizit bestätigt werden. Sieht man sich die Formel des Ehrenfest-Theorems (siehe [Fli08, S. 107]) genauer an, so

wird deutlich, warum die Formeln hier exakt übereinstimmen.

m

d2 h x̂i

= −hgradV(t, x̂)i

|

{z

}

dt2

(2.70)

=hF(t, x̂)i

Für eine Kraft, die linear in x̂ ist, gilt aber zusätzlich für den Mittelwert der Kraft:

hF(t, x̂)i = F(t,h x̂i)

(2.71)

19

Beim getriebenen harmonischen Oszillator ist dies erfüllt. Aus (2.71) erhält man mit dem Ehrenfest-Theorem

(2.70) die newtonsche Bewegungsgleichung (2.1) für den Ortserwartungswert:

m

d2 h x̂i

= F(t,h x̂i)

dt2

(2.72)

Somit folgen die klassische Zeitentwicklung x(t) und der quantenmechanische Ortserwartungswert h x̂i(t)

der gleichen Dynamik. Sie müssen also bei gleichen Anfangswerten für jeden Zeitpunkt übereinstimmen.

Für den anharmonischen Oszillator wird Gleichung (2.71) nicht mehr erfüllt sein und somit werden auch die

klassische Zeitentwicklung und der quantenmechanische Ortserwartungswert nicht mehr übereinstimmen.

2.2.3 Störungstheorie

Bisher waren alle unsere Rechnungen unter den gemachten Annahmen exakt. Steht man jedoch vor einem

Problem, das sich analytisch nicht mehr exakt lösen lässt, so könnte man versuchen dieses numerisch mit

dem Computer zu lösen. Dies funktioniert in der Regel auch, hat aber nicht nur Vorteile: so sind z.B. die

Ausgangsparameter einer berechneten Lösung immer fest und um die Abhängigkeit dieser Parameter zu

bestimmen, muss man die Berechnung für sehr viele Werte dieser Parameter wiederholen. Das kann sehr

viel (Rechen-)Zeit in Anspruch nehmen. Bevor man sozusagen mit dem Vorschlaghammer auf das Problem

losgeht, kann man aber noch eine andere Methode verwenden und zwar die Störungstheorie oder auch

Störungsrechnung. Der Begriff „Störung“ steht dabei für eine Änderung eines analytisch lösbaren Systems,

in unserem Fall ist dies der ungetriebene harmonische Oszillator. Diese Störung kann entweder zeitabhängig

oder -unabhängig sein. Wenn diese Störung klein genug im Vergleich zum ungestörten System ist, kann man

die Näherungsmethoden der Störungstheorie anwenden und erhält analytische Ergebnisse, die die exakte

Lösung annähern. In unserem Fall handelt es sich bei der Störung um die treibende Kraft.

In diesem Kapitel werde ich nun zuerst die allgemeine Formel für die Spektralkoeffizienten in zeitabhängiger Störungstheorie herleiten, um dann im Folgenden diese Formel auf den getriebenen harmonischen

Oszillator anzuwenden.

Herleitung

Wir teilen, wie schon zuvor in Gleichung (2.45) den Hamiltonoperator in einen zeitlich konstanten Anteil

Ĥ0 und einen zeitabhängigen Teil V̂(t) auf, jedoch mit dem Unterschied, dass wir den zeitabhängigen Teil

nun mit einem Parameter λ skalieren. Dies ermöglicht es uns später nach Potenzen dieses Parameters zu

entwickeln.

Ĥ(t) = Ĥ0 + λV̂(t)

(2.73)

Einen Zustand |ψ(t)i des Systems kann man zu jedem Zeitpunkt durch eine Linearkombination der Eigenzustände des ungestörten Systems darstellen:

|ψ(t)i =

∞

X

n=0

cn (t)T̂ (t,t0 )|ψn i =

∞

X

i

cn (t)e− ~ En t |ψn i

(2.74)

n=0

Damit lautet die zeitabhängige Schrödingergleichung (2.19) nun:

∞

∞

X

i

i

∂ X

cn (t)e− ~ En t |ψn i = Ĥ0 + λV̂(t)

cn (t)e− ~ En t |ψn i

∂t n=0

n=0

!

∞

∞ X

X

i

i

dcn (t)

⇒

i~

+ En cn (t) e− ~ En t |ψn i =

En + λV̂(t) cn (t)e− ~ En t |ψn i

dt

n=0

n=0

i~

20

(2.75)

Diese Gleichung kann man auf einen Eigenzustand |ψm i projizieren:

!

∞

∞ X

X

i

i

dcn (t)

+ En cn (t) e− ~ En t |ψn i = hψm |

hψm |

i~

En + λV̂(t) cn (t)e− ~ En t |ψn i

dt

n=0

n=0

!

∞

∞

∞

X

X

X

i

i

i

dcn (t)

⇒

i~

+ En cn (t) e− ~ En t hψm |ψn i =

En cn (t)e− ~ En t hψm |ψn i +λ hψm |V̂(t)cn (t)e− ~ En t |ψn i

| {z }

| {z }

dt

n=0

n=0

=δmn

⇒ i~

=δmn

∞

X

n=0

i

dcm (t) − i Em t

− ~i Em t

− ~i Em t

e ~

+

Em

cm(t)e

=

Em

cm(t)e

+λ

cn (t)e− ~ En t hψm |V̂(t)|ψn i

dt

n=0

⇒ i~

∞

X

i

dcm (t)

=λ

cn (t)e ~ (Em −En )t hψm |V̂(t)|ψn i

dt

n=0

(2.76)

Nun wird die bereits erwähnte Entwicklung nach Potenzen von λ durchgeführt, d.h. man schreibt cm (t) als:

(1)

2 (2)

cm (t) = c(0)

m (t) + λcm (t) + λ cm (t) + . . .

(2.77)

Würde man diese unendliche Reihe nicht abbrechen, erhielte man immer noch das exakte Ergebnis und

zwar für jedes λ. Dabei ist zu beachten, dass die c(i)

m nicht von λ abhängen. Um später das gesuchte cm (t)

zu erhalten berechnet man diese und setzt λ = 1. Störungstheorie n-ter Ordnung bedeutet nun, dass alle

(i)

Terme cm

(t) mit i > n genügend klein sind, um sie zu vernachlässigen. Somit erhält man, indem man die

Entwicklung des Zustandes (2.77) in Gleichung (2.76) einsetzt, in nullter Ordnung:

∞

X

dc(0)

m (t)

i~

=λ

c(0)

n . . . = 0 + O(λ)

dt

n=0

⇒ c(0)

m (t) = cm (t0 )

(2.78)

Das bedeutet, dass sich das System in Störungstheorie nullter Ordnung nicht verändert, es bleibt also in

P

− ~i En t

seinem Anfangszustand |ψ(t)i = ∞

|ψn i. Dies war auch zu erwarten wenn man sich die Entn=0 cn (t0 )e

wicklung des Zustandes (2.77) mit einer nicht-existenten Störung, also für λ = 0, ansieht. Somit ergibt

die Störungstheorie in nullter Ordnung genau das ungestörte System. Als nächstes betrachtet man die erste

Ordnung und integriert:

∞

X

i

dc(0)

dc(1)

m (t)

m (t)

(Em −En )t

i~

hψm |V̂(t)|ψn i + O(λ2 )

+i~λ

=λ

c(0)

n e~

dt

dt

| {z }

n=0

=0

∞

⇒

c(1)

m (t)

iX

=−

~ n=0

Z

t

i

0

(Em −En )t

c(0)

hψm |V̂(t0 )|ψn idt0

n (t0 )e ~

(2.79)

t0

Der Term O(λ2 ) in obiger Formel gibt eine Abschätzung für den Fehler an: dieser ist also proportional zu

(2)

λ2 . Aus c(1)

m (t) könnte man nun durch erneutes Einsetzen in Gleichung (2.76) einen Ausdruck für cm und

damit Störungstheorie in zweiter Ordnung erhalten. Dies lässt sich beliebig fortführen und man erhält so

immer höhere Ordnungen und damit genauere Lösungen. Wir werden uns im Folgenden aber auf die erste

Ordnung beschränken.

Anwendung

Wir haben im letzten Kapitel eine Näherung für die Zeitentwicklung eines quantenmechanischen Systems

hergeleitet und werden diese nun auf den getriebenen harmonischen Oszillator anwenden. Wie auch schon

in den vorherigen Kapiteln, gehen wir wieder davon aus, dass sich der Oszillator zum Zeitpunkt t0 im

Grundzustand |ψ0 befindet. Somit gilt:

1 für m = 0

(0)

cm (t0 ) =

(2.80)

0 sonst

21

Außerdem verwenden wir auch hier wieder das Potential (2.55), also die gleiche treibende Kraft FS (t)

wie in den vorherigen Kapiteln. Nun sieht man sich Gleichung (2.79) nochmals an: es taucht darin das

Matrixelement V̂mn (t) = hψm |V̂(t)|ψn i auf. Durch Gleichung (2.80) ist n somit auf 0 festgelegt. An der

Matrixdarstellung des Erzeugungs- (2.42) und des Vernichtungsoperators (2.43) sieht man, dass V̂mn für

n = 0 nur für m = 1 einen Wert liefert und zwar:

s

~

V̂10 (t) = −

FS (t)

(2.81)

2mω0

In Störungstheorie erster Ordnung erhält man also ausschließlich eine Änderung der Besetzungswahrscheinlichkeit des ersten Zustandes über dem Grundzustand und der Grundzustand geht weiterhin mit dem Faktor

1 ein. Somit ist die Normierung des Zustandes in dieser Näherung nicht erhalten. Trotzdem ergeben sich für

c1 (t) plausible Werte. Der Zustand ist gegeben durch:

|ψ(t)i = e− 2 ω0 t |ψ0 i + e− 2 ω0 t c(1)

1 (t)|ψ1 i

Z t

Z t

0

i

i

iω0 t0

0

0

mit c(1)

(t)

=

−

e

V̂

(t

)dt

=

FS (t0 )eiω0 t dt0

√

10

1

~ t0

2mω0 ~ t0

i

3i

(2.82)

Es fällt noch auf, dass c(1)

1 (t) genau dem Integral ζ(t,t0 ) (2.60) aus Kapitel 2.2.2 entspricht. Wie gut diese Näherung zu den exakten Ergebnissen aus Kapitel 2.2.2 passen, werden wir in Kapitel 5 untersuchen.

Insbesondere werden wir betrachten, für welche Bereiche der Anregungsamplitude AS und der Anregungsfrequenz ωS sich noch plausible Werte ergeben.

22

3 Anharmonischer Oszillator

Im Allgemeinen bezeichnet man jeden Oszillator, dessen Rückstellkraft nicht direkt proportional zur Auslenkung ist, als anharmonisch. Ein anharmonisches Potential ist somit im Gegensatz zum harmonischen

Potential (2.7) nicht nur durch Terme mit x2 beschrieben, sondern es kommen noch andere Potenzen vor.

Da jedes analytische Potential als Taylorreihe geschrieben werden kann, genügt die Beschreibung mit Potenzen, um jede Potentialform abzudecken. Wir werden uns in dieser Bachelorarbeit auf einen zusätzlichen

Term mit x4 beschränken. Auch in diesem scheinbar einfachen Fall ist der anharmonische Oszillator schon

nicht mehr analytisch exakt lösbar. Das Potential des anharmonischen Oszillators wird also folgendermaßen

festgelegt:

1

V(x) = mω20 x2 + Ax4

2

A

dV(x)

⇒ F(x) = −

= − mω20 x − x3

dx

4

|{z}

(3.1)

=k

Dabei ist A ein Faktor, der die Stärke der Anharmonizität angibt und sowohl positiv als auch negativ sein

kann. Auf Effekte, die bei negativem A auftreten, werden wir in Kapitel 5 noch genauer eingehen. Für positives A nimmt die Rückstellkraft mit größer werdendem Abstand stärker zu als beim harmonischen Oszillator,

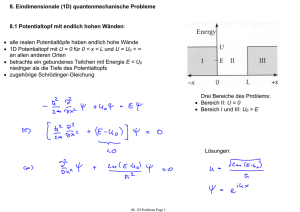

für negatives A schwächer, bis sie irgendwann repulsiv wirkt. In Abbildung 3.1 sind die unterschiedlichen

Fälle dargestellt. Wie man im untersten Bild sieht, könnte man den quadratischen Term auch explizit negativ verwenden und erhält daraus mit positivem A ein Doppelmuldenpotential, also ein Potential mit zwei

Minima. Dies soll aber nicht Gegenstand dieser Arbeit sein.

23

1 2

2x

0,4

0,2

0

−1

−0,8

−0,6

−0,4

−0,2

1,5

0

x

1 2

2x

0,2

0,4

0,6

0,8

1

0,2

0,4

0,6

0,8

1

0,2

0,4

0,6

0,8

1

0,2

0,4

0,6

0,8

1

+ x4

1

0,5

0

−1

−0,8

−0,6

−0,4

−0,2

0

x

0,1

1 2

2x

− x4

0,05

0

−1

−0,8

−0,6

−0,4

−0,2

0

x

− 12 x2 + x4

0,4

0,2

0

−1

−0,8

−0,6

−0,4

−0,2

0

x

Abbildung 3.1: Verschiedene Potentiale (von oben nach unten): harmonisch A = 0, anharmonisch A = 1,

anharmonisch A = −1 und Doppelmuldenpotential mit A = 1

24

3.1 Quantenmechanische Störungstheorie

Wir werden nun den anharmonischen Oszillator in quantenmechanischer Störungstheorie behandeln. Mit

geändertem V( x̂) ändert sich im Vergleich zu (2.22) auch der zeitunabhängige Teil des Hamiltonoperators

und die Berechnungen aus Kapitel 2.2.1 stimmen nicht mehr. Insbesondere ändern sich die Eigenenergien

und die Eigenfunktionen. Ähnlich wie in Kapitel 2.2.3 kann man nun den Term A x̂4 als Störung betrachten

und zeitunabhängige Störungstheorie verwenden, um aus den bekannten Eigenenergien und Eigenfunktionen des harmonischen Oszillators Korrekturen zu berechnen.

Herleitung

Die Strategie bei der zeitunabhängigen Störungstheorie ist recht ähnlich der zeitabhängigen Störungstheorie

mit dem wesentlichen Unterschied, dass man nicht die Zeitentwicklung eines bekannten Anfangszustandes

sucht, sondern die Änderung der Eigenenergien und Eigenzustände selbst. Die Störung wird wieder mit

einem Faktor λ skaliert. Nun wird allerdings die zeitunabhängige Schrödingergleichung (2.21), also die

Eigenwertgleichung des Hamiltonoperators verwendet:

Ĥ = Ĥ0 + λV̂

Ĥ|φn i = Ĥ0 + λV̂ |φn i = n |φn i

(3.2)

Analog zum zeitabhängigen Fall ist Ĥ0 der Hamiltonoperator des ungestörten Systems, in unserem Fall der

des harmonischen Oszillators, und V̂ die Störung, also der Term A x̂4 . Nun werden sowohl die Eigenenergien

n als auch die Eigenzustände |φn i nach λ entwickelt:

n = n(0) + λn(1) + λ2 n(2) + . . .

(1)

2 (2)

|φn i = |φ(0)

n i + λ|φn i + λ |φn i + . . .

(3.3)

Die gesuchten Eigenenergien und Eigenzustände des gestörten Systems ergeben sich nach Berechnung der

Korrekturen wieder mit λ = 1. Man erhält die Korrekturen, analog zur zeitabhängigen Störungstheorie

wieder, indem man die Ordnungen nacheinander in die verwendete Schrödingergleichung einsetzt, also hier

in (3.2). In nullter Ordnung ergibt sich:

(0 (0)

Ĥ0 + λV̂ |φ(0)

n i = n |φn i + O(λ)

(0) (0)

⇒ Ĥ0 |φ(0)

n i = n |φn i

(3.4)

Dies ist genau die ungestörte zeitunabhängige Schrödingergleichung. Damit ist der erste Term der Eigenenergie n(0) genau durch die Eigenenergie En des ungestörten Systems und der erste Term des Eigenzustandes |φ(0)

n i durch den Eigenzustand |ψn i des ungestörten Systems gegeben. Das ist wieder konsistent mit dem

Fall λ = 0.

n(0) = En

|φ(0)

n i = |ψn i

(3.5)

In erster Ordnung erhält man:

(1)

(1)

Ĥ0 + λV̂ |ψn i + λ|φ(1)

i

=

E

+

λ

|ψ

i

+

λ|φ

i

+ O(λ2 )

n

n

n

n

n

i + λE |φ(1) i + λ (1) |ψ i + O(λ2 )

⇒

Ĥ |ψ

i +λĤ0 |φ(1)

En

|ψ

n

n n

n

n i + λV̂|ψn i = n

| 0{zn}

=En |ψn i

(1)

(1)

⇒ Ĥ0 |φ(1)

n i + V̂|ψn i = E n |φn i + n |ψn i

(3.6)

Dies lässt sich wieder beliebig fortführen, um nacheinander immer höhere Ordnungen zu erhalten. Wir

beschränken uns auf die erste Ordnung. Nun stellen wir die Zustandskorrektur erster Ordnung durch die

25

Eigenzustände |ψn i des ungestörten Systems dar und projizieren Gleichung (3.6) auf einen Eigenzustand

|ψk i des ungestörten Systems:

|φ(1)

n i=

∞

X

anm |ψn i

m=0

⇒

∞ ∞

X

X

anm Ĥ0 |ψm i + V̂|ψn i = En

anm |ψm i + n(1) |ψn i

| {z }

m=0

⇒

m=0

=Em |ψm i

∞

X

(En − Em )anm |ψm i + n(1) |ψn i = V̂|ψn i

m=0

⇒

∞

X

(En − Em )anm hψk |ψm i +n(1) hψk |ψn i = hψk |V̂|ψn i

| {z }

| {z }

m=0

=δkn

=δkm

⇒ (En − Ek )ank +

n(1) δkn

= hψk |V̂|ψn i

(3.7)

Dies gilt für alle k und man erhält daraus:

k = n ⇒ (En − En ) ann + n(1) = hψn |V̂ψn i

| {z }

=0

k , n ⇒ (En − Ek )ank = hψk |V̂|ψn i

Somit sind die Korrektur erster Ordnung der Energie n(1) und alle ank bis auf ann bestimmt. Aus der Normierung des Zustandes |φn i kann man folgern, dass ann = 0 gelten muss. Siehe dazu [Fli08, S. 297]. Somit

ist die Korrektur erster Ordnung gegeben durch:

n(1) = hψn |V̂|ψn i

∞

X

hψm |V̂|ψn i

(1)

|φn i =

|ψm i

m=0 E n − E m

(3.8)

m,n

Anwendung

Wir setzen nun V̂ = A x̂4 in die störungstheoretische Korrektur der Eigenwerte und Eigenfunktionen (3.8).

4 . In Kapitel 2.2.1 haben mit (2.44) bereits

Dazu benötigen wir die Matrixelemente von hψm |V̂|ψn i = A x̂mn

die Matrixdarstellung von x̂ bestimmt:

√

0

1 √

√

s

s

1 0

2

√

~ ~

...

x̂ =

(3.9)

â + ↠=

2

0

2mω0

2mω0

√

.

.

..

..

N−1

√

N−1

0

Diese Matrix quadrieren wir einfach zwei mal und erhalten somit die Matrixdarstellung von x̂4 . Dies wurde

in Anhang A.3 durchgeführt. Somit kann man die Energieeigenwerte n des anharmonischen Oszillators

(3.1) in Störungstheorie erster Ordnung berechnen. Die Energie des Grundzustandes 0 lautet:

0 = E 0 +

26

4

A x̂00

~

= E0 + A

2mω0

!2

~

α(0) = E0 + 3A

2mω0

!2

(3.10)

Auch die Eigenzustände lassen sich berechnen und für den Grundzustand ergibt sich in erster Ordnung

Störungstheorie:

∞

4

4

X

x̂20

x̂40

V̂m,0

|φ0 i = |ψ0 i +

|ψm i = |ψ0 i + A

|ψ2 i +

|ψ4 i =

E − Em

E0 − E2

E0 − E4

m=1 0

!

!2

β(0)

γ(0)

~

|ψ2 i +

|ψ4 i =

= |ψ0 i − A

2mω0

2~ω0

4~ω0

√

√

2 A~

6 A~

= |ψ0 i − 3

|ψ2 i −

|ψ4 i

(3.11)

3

4 mω0

8 mω30

Wir haben also nun den Grundzustand des anharmonischen Oszialltors |φ0 i in der Eigenbasis des harmonischen Oszillators |ψn i berechnet. Da wir die Matrixdarstellungen aller wichtigen Operatoren in der Eigenbasis des harmonischen Oszillators schon berechnet haben, können wir nun |φ0 i in zeitabhängiger Störungstheorie behandeln. Wir setzen also |φ0 i und das zeitabhängige Potential V̂(t) = A x̂4 + FS (t) x̂ in (2.79)

ein. Zu der Integration kommt dabei mit A x̂4 nur ein zeitlich konstanter Term hinzu. Somit erhalten wir die

Zeitentwicklung des anharmonischen Oszillators.

27

4 Numerische Behandlung

In den vorherigen Kapiteln haben wir entweder versucht, durch möglichst geschickte Rechnung ein klassisches oder quantenmechanisches Problem in eine lösbare Form zu bringen, oder, wenn dies nicht möglich

war, durch eine geeignete Näherung in Störungstheorie dennoch eine brauchbare Näherung zu erhalten. Es

gibt jedoch auch Problemstellungen, in denen beides versagt. Der anharmonische Oszillator ist ein Beispiel, das nur bedingt störungstheoretisch behandelt werden kann. Störungsrechnung beinhaltet immer die

Annahme einer vergleichsweise kleinen Störung, in unserem Fall einer kleinen treibenden Kraft. Ist diese

Bedingung nicht mehr erfüllt liefert die Störungsrechnung, wenn überhaupt, erst in sehr hohen Ordnungen

brauchbare Ergebnisse. Hohe Ordnungen sind jedoch durch komplizierte Mehrfachintegrale gegeben, die

nicht oder nur sehr schwierig lösbar sein können. Abhängig von der Form der treibenden Kraft kann sich

auch schon in erster Ordnung ein nicht mehr analytisch darstellbares Integral ergeben.

In der heutigen Zeit hat man eine weitere Möglichkeit die fundamentalen Differentialgleichungen der beiden Mechaniken, also das zweite newtonsche Gesetz (2.1) für die klassische Mechanik und die Schrödingergleichung (2.19) für die Quantenmechanik zu lösen. Beide Gleichungen geben durch eine Zeitableitung an,

wie sich eine Größe (die Koordinate der Massepunkte bzw. die Wellenfunktion) verändert. Es sind beides

sogenannte Anfangswertprobleme, die allgemein durch folgende Gleichung gegeben sind:

dy(t)

= f (t,y(t))

dt

mit bekanntem y(t0 ) = y0

(4.1)

Alle im Folgenden behandelten Methoden dienen der Lösung solcher Anfangswertprobleme.

Eine Ableitung ist immer definiert durch einen Grenzübergang, also den Limes ∆t → 0, aus einem Differenzenquotienten y(t+∆t)−y(t)

. Das Grundprinzip der numerischen Berechnung ist nun, diesen Grenzübergang

∆t

rückgängig zu machen, um somit eine Berechnung in diskreten Zeitschritten zu ermöglichen.

4.1 Euler-Verfahren

4.1.1 Explizites Euler-Verfahren

Man erhält das sogenannte explizite Euler-Verfahren, indem man schlicht die Taylorentwicklung von y(t+∆t)

um den bekannten Anfangswert y(t) verwendet. Zusätzlich ersetzt man den Zeitparameter t durch einen

Index i um die Diskretisierung in der Zeit zu verdeutlichen:

y(t + ∆t) = y(t) + ∆t

dy(t) ∆t2 d2 y(t)

+

+ ...

dt

2 dt2

|{z}

= f (t,y(t))

yi := y(t0 + i∆t)

⇒ yi+1 = yi + ∆t f (t,yi ) + O(∆t2 )

(4.2)

Terme proportional zu ∆t2 und höhere Ordnungen werden also vernachlässigt oder anders ausgedrückt:

f (t,y(t)) und damit auch dy(t)

dt werden im Zeitintervall [t; t + ∆t[ als konstant angenommen. Damit handelt es

sich um ein Verfahren erster Ordnung.

Auf der rechten Seite der fundamentalen Gleichungen hat man mit f (t,y(t)) einen Ausdruck, der angibt,

wie sich y(t) zum Zeitpunkt t ändert. Diesen Ausdruck muss man berechnen, um ihn in Gleichung (4.2) einzusetzen und daraus yi+1 zu bestimmen. Dies kann direkt möglich sein, z.B. eine gegebene treibende Kraft in

der klassischen Mechanik. Es kann sich dabei aber auch um einen weiteren Differentialoperator handeln, wie

z.B. für die Schrödingergleichung in der Ortsdarstellung. In diesem Fall kann man den Differentialoperator

28

wieder mit Hilfe einer Taylorentwicklung ausdrücken, worauf wir in Kapitel 4.4 noch genauer eingehen

werden. Man kann also aus einem gegebenen Anfangswert den Wert für einen Zeitschritt später berechnen.

Dies setzt man beliebig fort und erhält somit die gesuchte Zeitentwicklung in diskreten Schritten ∆t.

Dieses Verfahren ist die einfachste Methode, um ein Anfangswertproblem numerisch zu behandeln. Der

Mathematiker Leonhard Euler behandelte es bereits in seinem Buch Institutionum calculi integralis von

1768 [HNW08, S. 35] und die Methode ist daher nach ihm benannt. Ein weiterer Punkt ist, dass auf der

rechten Seite der Gleichung nur Werte yi zum Zeitpunkt t vorkommen. Die Gleichung ist also ein expliziter

Ausdruck für den Iterationsschritt, der yi+1 liefert. Deswegen wird das Verfahren explizites Euler-Verfahren

genannt.

Genauigkeit

Diese Näherung gilt wenn ∆t „genügend“ klein ist. Was genau dabei „genügend“ bedeutet und wie genau

die Ergebnisse auch über viele Schritte, also große Zeiten hinweg sind, werden wir in Kapitel 5 genauer

betrachten. Dazu werden wir die Resultate dieses Verfahrens für den harmonischen Oszillator mit den analytischen Lösungen aus den Kapiteln 2.1.2 und 2.2.2 vergleichen. Der Term O(∆t2 ) in Gleichung (4.2) lässt

aber schon eine Abschätzung zu: der Fehler in einem Zeitschritt ist für ein Verfahren erster Ordnung in etwa

proportional zu ∆t2 .

Stabilität

Der Begriff der Stabilität eines numerischen Verfahrens gibt ein Kriterium an, für welche Funktionen f (t,y(t))

es „funktioniert“, für welche es also sinnvolle Näherungen liefert. Wie wir sehen werden, ist dies nicht immer und speziell auch beim expliziten Euler-Verfahren in Verbindung mit dem harmonischen Oszillator

nicht gegeben. Wir werden die Stabilität nun theoretisch untersuchen, aber man erkennt in Kapitel 5 auch

am praktischen Beispiel sofort, welche Auswirkungen die (In-)Stabilität eines Verfahrens auf die Ergebnisse

hat. Man verwendet zur theoretischen Untersuchung die dahlquistsche Testgleichung [Dah63]:

f (t,y(t)) = λy(t)

mit y(t0 = 0) = 1, λ ∈ C und Re(λ) < 0

dy(t)

⇒

= λy(t)

dt

(4.3)

Man sieht sofort, dass die analytische Lösung durch:

y(t) = eλt

und lim y(t) = 0

t→∞

(4.4)

gegeben ist. Dies wird mit den jeweiligen numerischen Verfahren verglichen, hier also mit dem expliziten

Euler-Verfahren (4.2). Man bringt dazu das numerische Verfahren in die Form:

yi+1 = R(∆tλ)yi

⇒ yi = R(∆tλ)i

(4.5)

Dabei wird R(z) Stabilitätsfunktion und der Bereich |R(z)| < 1 in der komplexen Ebene Stabilitätsgebiet

genannt. In diesem Bereich konvergiert yi für i → ∞ gegen 0 und liefert damit das richtige Ergebnis für den

Grenzwert der analytischen Lösung (4.4). Für |R(z)| > 1 bilden sich dagegen Oszillationen mit steigender

Amplitude und das Verfahren divergiert, es liefert damit kein brauchbares Ergebnis mehr. Das Stabilitätsgebiet lässt also Aussagen darüber zu, wann das jeweilige Verfahren funktioniert.

Sowohl der klassische als auch der quantenmechanische harmonische Oszillator sind sogenannte steife

Anfangswertprobleme. Für diese Probleme ist es von erheblichem Vorteil, wenn die komplette linke Hälfte

der komplexen Ebene im Stabilitätsgebiet enthalten ist. Dies wird klar, wenn man sich verdeutlicht, dass λ

ein Parameter ist, der durch die Problemstellung mit Re(λ) < 0 festgelegt wird. Für ein solches Verfahren

kann man also die Schrittweite ∆t > 0 beliebig wählen und befindet sich dennoch immer im Stabilitätsgebiet

|R(∆tλ)| < 1. Man erhält relativ sinnvolle Ergebnisse. Diese werden zwar für große ∆t sehr ungenau, sie

divergieren aber nicht. Ein solches Verfahren wird „A-stabil“ genannt.

29

Für das explizite Euler-Verfahren erhält man für die Stabilitätsfunktion R(z):

y0 = 1

yi+1 = yi + ∆t f (t,yi ) = (1 + ∆tλ) yi

| {z }

=R(∆tλ)

⇒ R(z) = 1 + z

(4.6)

Daraus erkennt man, dass das Stabilitätsgebiet durch das Innere eines Kreises mit Radius 1 um den Punkt

−1 in der komplexen Ebene gegeben ist. Das explizite Euler-Verfahren ist also nicht A-stabil. Man muss die

Schrittweite ∆t allein aus Stabilitätsgründen genügend klein wählen, damit |1 + ∆tλ| < 1 erfüllt ist. Das kann

zu einem sehr hoher Rechenaufwand führen, nur damit das Verfahren nicht divergiert. Genauigkeitsüberlegungen haben dabei noch gar keine Rolle gespielt.

4.1.2 Implizites Euler-Verfahren

Das Problem der Stabilität des expliziten Euler-Verfahrens kann umgangen werden. Dazu setzt man wieder die Taylorentwicklung an. Anstatt allerdings den gesuchten Wert um den bekannten Anfangswert zu

entwickeln, kann man auch diesen Anfangswert y(t) um den noch unbekannten gesuchten Wert y(t + ∆t)

entwickeln. Dies liefert das implizite Euler-Verfahren:

y(t) = y(t + ∆t) − ∆t

dy(t + ∆t) ∆t2 d2 y(t + ∆t)

+

+ ...

dt } 2

dt2

| {z

= f (t+∆t,y(t+∆t))

⇒ yi+1 = yi + ∆t f (t + ∆t,yi+1 ) + O(∆t2 )

(4.7)

Aus dieser Gleichung kann man, im Gegensatz zum expliziten Euler-Verfahren, den Wert von yi+1 nicht

direkt berechnen, er ist nur implizit gegeben. Daher kommt auch der Name „implizites“ Euler-Verfahren.

Um diesen Wert nun zu erhalten, muss das Gleichungssystem, das durch Gleichung (4.7) gegeben ist, gelöst

werden. Die folgende Stabilitätsbetrachtung dient gleichzeitig als einfaches Beispiel zur Anwendung. Hier

sei noch erwähnt, dass es sich auch bei dem impliziten Euler-Verfahren um ein Verfahren erster Ordnung

handelt und somit der Fehler pro Zeitschritt, wie schon beim expliziten Euler-Verfahren, in etwa proportional

zu ∆t2 ist.

Stabilität

Analog zu Kapitel 4.1.1 werden wir auch hier wieder unter Verwendung der dahlquistischen Testgleichung

(4.3) das Stabilitätsgebiet bestimmen:

y0 = 1

yi+1 = yi + ∆t f (t + ∆t,yi+1 ) = yi + ∆tλyi+1

Um daraus nun die Rekursionsformel zu erhalten, muss man diese Gleichung nach yi+1 auflösen. Hier ist

das relativ einfach. Im Allgemeinen kann y selbst aber z.B. ein Vektor sein und man erhält ein ganzes

Gleichungssystem, das man z.B. mit dem Gauß-Verfahren lösen kann. Genau das wird bei uns auch für den

harmonischen Oszillator sowohl klassisch als auch quantenmechanisch der Fall sein. Es könnte auch sein,

dass yi+1 in f (t + ∆t,yi+1 ) nicht nur linear vorkommt was das Problem noch weiter verkomplizieren würde.

Bei uns ist aber immer nur ein linearer Zusammenhang gegeben. Auflösen nach yi+1 liefert:

⇒ (1 − ∆tλ)yi+1 = yi

⇒ yi+1 =

1

yi

1 −{z

∆tλ

|

}

=R(∆tλ)

⇒ R(z) =

30

1

1−z

(4.8)

1 < 1 folgt |1 − z| > 0. Dies bedeutet, dass das Stabilitätsgebiet durch das gesamte ÄuAus |R(z)| = 1−z

ßere des Kreises mit Radius 1 um den Punkt +1 in der komplexen Ebene gegeben ist. Damit ist die linke

Halbebene enthalten und das implizite Euler-Verfahren ist A-stabil und damit zum numerischen Lösen des

harmonischen Oszillators um ein Vielfaches besser geeignet als das explizite Euler-Verfahren. In Kapitel 5

werden die Ergebnisse dieser beider Verfahren direkt gegenübergestellt.

4.2 Runge-Kutta-Verfahren