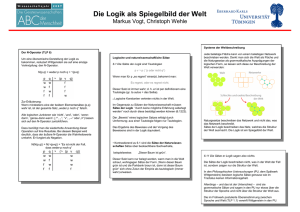

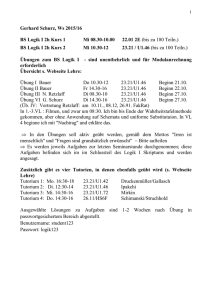

Wissenschaftsphilosophie - Philosophische Fakultät

Werbung