Entropie - TU Chemnitz

Werbung

Entropie

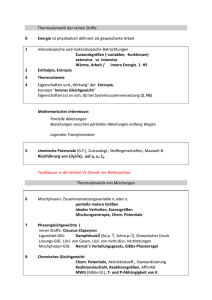

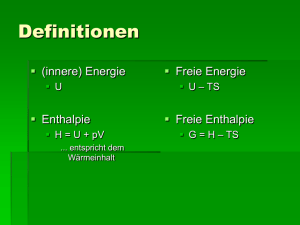

Grundlegend für das Verständnis des Begriffes der Komprimierung ist

der Begriff der Entropie. In der Physik ist die Entropie ein Maß für die

Unordnung eines Systems. In der Informationstheorie ist die Entropie

ein Maß für den Informationsgehalt einer Nachricht.

Um der Begriff der Entropie zu erläutern brauchen wir erst mal einige

Definitionen, z.B.

Endlicher Wahrscheinlichkeitsraum (X, P(X), p), wo bei X = {x1,..,xn} die

Menge der Elementarereignisse, P(X) die Potenzmenge von X und p ein

Wahrscheinlichkeitsmaß ist, welches jedem Ereignis aus der

Potenzmenge einen Wert zuordnet mit den Eigenschaften

1. ∀ Q ∈P(X) : p(Q) ≥ 0

2. p(X) = 1

3. ∀ Q, R ∈P(X) mit Q ∩ R = ∅ gilt p(Q ∪ R) = p(Q) + p(R)

Hat Q ∈ P(X) die Wahrscheinlichkeit p(Q), so wird dem Ereignis Q der

Informationsgehalt

I (Q) = - log p(Q) bzw. I (xi) = - log pi

für Elementarereignisse zugeordnet.

Rechnet man mit dem Logarithmus zur Basis 2, so wird der

Informationsgehalt in Bit gemessen. Die Umrechnung in eine andere

Basis b erfolgt durch Multiplikation mit dem Faktor log2 b.

Jetzt definieren wir den Begriff der Entropie:

Für eine Quelle X (die Menge der Elementarereignisse) mit Elementen

x1, .., xn und zugehörigen Wahrscheinlichkeiten p1, ..pn > 0 ist die

Entropie definiert wie folgt:

H(X) = - ∑ pi . log pi

Die Entropie einer Nachricht ist ganz einfach die Summe der Entropien

aller Einzelsymbole.

Die Entropie hat die folgenden Eigenschaften:

1. 0 ≤ H(X) ≤ log (n) – so gen. Minimale und maximale Entropie

• H(X) = 0 ist genau der Fall, wenn keinerlei Ungewissheit

über die von X erzeugte Nachricht besteht. Das bedeutet X

darf nur ein Element x mit Wahrscheinlichkeit 1 haben

H(X) = - p(x) . log ( p(x)) = -1 . log (1) = 0

• H(X) = log (n) tritt genau dann ein, wenn völlige

Ungewissheit über die von X erzeugte Nachricht herrscht,

d.h. wenn alle Elemente x ∈ X die gleiche

Wahrscheinlichkeit 1 / n haben

H(X) = - ∑ pi . log pi = -n . log (1 / n) = - log (1 / n) = log (n)

Gemeinsame Entropie: Seien nun X und Y zwei Quellen mit

Elementen xi bzw. yj und Wahrscheinlichkeiten p(x i) und p(y j) dann ist

die gemeinsame Entropie beider Quellen definiert als:

H(X, Y) = - ∑ p(x i, y j) . log ( p(xi, y j))

Sind X und Y diskrete Quellen, so gilt :

H(X, Y) ≤ H(X) + H(Y)

Die Gleichheit tritt dann ein, wenn X und Y unabhängige Quellen sind.

Eine reellwertige Funktion f (a i) der Elementarereignisse ai ∈ A eines

Wahrscheinlichkeitsraumes (A, P(A), p) wird durch eine Zufallsvariable

bezeichnet.

Die Schreibweise p(X = f(a i )) = pi besagt, dass die Zufallsvariable X

mit Wahrscheinlichkeit pi den Wert f (ai) annimmt.

Der Erwartungswert oder Mittelwert E(X) einer Zufallsvariablen X ist

durch

E(X) = ∑ p (ai) . f(ai)

bestimmt. X und Y seien Zufallvariablen im Wahrscheinlichkeitsraum

Q1 = (A, P(A), pa) und Q2 = (B, P(B), pb). Die Zufallsvariablen heißen

unabhängig wenn gilt:

∀ a, b ∈ R : p(X = a und Y = b) = p (X = a) . p(Y = b) = p(a).p(b)

Eine Folge von unabhängigen Zufallsvariablen bildet einen

gedächtnislosen Prozess.

Die Bezeichnungsweise p(aB) steht für die bedingte

Wahrscheinlichkeit eines Ereignisses a unter einer Bedingung B. In

diesem Zusammenhang sprechen wir von einem bedingten

Informationsgehalt und einer bedingten Entropie.

Mit anderen Worten, die bedingte Entropie misst, wie groß die

Ungewissheit über die von Quelle X erzeugte Nachricht ist, nachdem

feststeht, dass Quelle Y die Nachricht b erzeugt hat.

Für die Zufallsvariablen X und Y gilt:

p(X = a Y = b) = p (X = a und Y = b) / p(Y = b)

Sind X und Y unabhängig , so folgt allerdings

p(X = a Y = b) = p(X = a)

Eine gedächnislose diskrete Informationsquelle sendet eine Folge von

unabhängigen Quellensymbolen, die durch Zufallvariable {Xt ; t ∈ N} in

einem endlichen Wahrscheinlichkeitsraum Q = (S, P(S), p) dargestellt

werden. Dabei heißt S = {s1, ...,sq} das Quellenalphabet und H(p1,

..,pq) die Entropie der Quelle mit Signalwahrscheinlichkeiten p1 =

p(s1),..,pq = p(sq)

Für die n-te Erweiterung einer Informationsquelle, die n- stellige Wörter

über dem Alphabet S aussendet, wird der Wahrscheinlichkeitsraum

Qn = {Sn, Pn (S), pn}

in entsprechender Erweiterung von Q = { S, P(S), p} zugrunde gelegt.

Für die Entropie der n-ten Erweiterung Qn eines

Wahrscheinlichkeitsraums Q gilt bei Unabhängigkeit der Symbole in

einem Wort:

H(Sn ) = n . H(S)

Es sei eine gedächtnislose Informationsquelle Q = (S, P(S), p) mit q

Quellensymbolen gegeben. Für die Codierung der Quellsymbole

s1,...,sq sei li die Länge des zu si zugeordneten Codeworts und

L = ∑ pi . li

die mittlere Codewortlänge.

Ein eindeutig decodierbarer Code heißt kompakt, wenn seine

Codewortlänge für Codes mit r Symbolen minimal ist.

Für die Entropie als eine untere Schranke für die mittlere Codewortlänge

eines eindeutig decodierbaren Codes für die Quellsymbole haben wir

folgenden Satz:

Hr(S) ≤ L = ∑ pi . li

Die Realität zeigt, dass die minimale mittlere Codewortlänge bei der

Codierung der Quellsymbole einer Informationsquelle nicht immer die

Entropie als untere Schranke erreicht.

Eine bessere Annäherung an diese Schranke kann allerdings erzielt

werden, wenn statt der Symbole der gedächtnislosen Quelle die Wörter

ihrer n- ten Erweiterung codiert werden. Dabei kann die Differenz

zwischen der Entropie und der mittleren Codewortlänge mit

wachsendem n beliebig klein gemacht werden.

Die mittlere Wortlänge eines kompakten Codes mit r Symbolen für die nte Erweiterung einer Informationsquelle erfüllt die Ungleichung von dem

ersten Satz von Shannon

n Hr(S) ≤ Ln < n Hr(S) + 1

Wie die Entropie der Sprchwissenschaft dient?

Die relative Entropie gibt an, wie viel Speicherplatz verschwendet wird,

wenn eine Zeichenfolge mit einer Methode komprimiert wird, die für eine

andere Folge optimiert wurde.

Als Beispiel kann das Morsealphabet dienen, das für die englische

Sprache optimiert wurde. Dem häufigsten Buchstaben in der englischen

Sprache wurde die kürzeste Zeichenfolge zugeordnet. (z.B. für e ein

Punkt). Aber für andere Sprachen ist das Morsealphabet nicht optimal,

denn die Länge der Codes entspricht nicht mehr der Häufigkeit der

Buchstaben. Die relative Entropie gibt dann an, wie viele zusätzlichen

Striche oder Punkte benötigt werden, um zum Bsp einen englischen

Text zu übermitteln.

Mit einem Experiment versuchten die Wissenschaftler Benedetto,

Caglioti und Loreto den Verwandtschaftsgrad verschiedener Sprachen

herauszufinden. Zwei Sprachen, die aus der gleichen Familie stammen,

haben nämlich eine geringere relative Entropie und sollten daher

effizienter komprimiert werden können als ein Sprachenpaar, das nicht

miteinander verwandt ist. Insgesamt untersuchten die Forscher 52

europäische Sprachen. Mit Hilfe des Zip – Programms konnten sie die

Zugehörigkeit der Sprachen zu den jeweils richtigen linguistischen

Gruppen feststellen. Z.B besitzen Rätoromanisch und Italienisch wenig

relative Entropie und sind somit verwandt. Dagegen haben Schwedisch

und Kroatisch eine hohe relative Entropie und müssen somit

verschiedenen Familien angehören. Winzip konnte sogar Maltesisch,

Baskisch und Ungarisch als Sprachen identifizieren, die in keine der

bekannten Familien passen.

Der Erfolg ihrer Methode ließ bei die den Forschern die Hoffnung

aufkommen, dass die Entropiemessung durch Zipping – Software auch

für anderen Datenfolgen wie z.B Aktienkurse anwendbar sein könnte.

Aus : Neue Zürcher Zeitung