9547243 / # 0676/ 4509579

Werbung

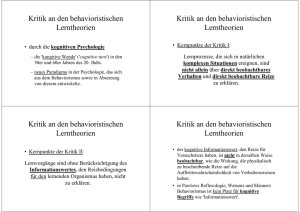

PS Allgemeine Psychologie: Kognitive Psychologie2 ID1105 Sonja Hansmann Matrikelnr.: 9547243 [email protected] / # 0676/ 4509579 „Theorien des Lernens Bd.2 (1981)“ Tolman: Zeichenlernen K.12 S 88-126 1. 2. 3. 4. 5. 6. 7. 8. Inhaltsverzeichnis Tolman: Zeichenlernen , Begriffserklärung Verhalten als zielgerichtetes Handeln Tolmans lerntheoretischen Konstrukte Erwartungen und kognitive Pläne 5.1 Lernen versus Verhaltensweisen. Empirische Befunde, die für Tolmans Ansichten relevant sind 6.1 Sensorisch-sensorische Assoziationen 6.2 Sensorische Vorkonditionierung 6.3 Kurzzeitgedächtnis bei Tieren 6.4 Das Lernen von Zielen (Zeichen) als Alternative zum Reaktionslernen 6.4.1 Belohnungserwartung 6.4.2 Ortslernen 6.4.3 Latentes Lernen 6.5 Direkte Veränderung der Zielvalenz 6.6 Verstärkung und Bestätigung von Erwartungen 6.7 Vorläufige Erwartungen als Hypothesen 6.8 Symbolisches Versuchs- und Irrtumslernen Räumliches Gedächtnis und kognitive Pläne 7.1 Kognitive Pläne bei Schimpansen Zusammenfassung und abschließende Bemerkung zu Tolmans Einfluß 2. Tolman: Zeichenlernen Edward C. Tolman (1886-1959) hat seine Theorie in seinem systematischen Hauptwerk „Purposive Behavior in Animals and Men“(1932) einen „zweckorientierten Behaviorismus“ genannt. Zeichenlernen ist die abkürzende Bezeichnung für seine Theorie, die uns auf die kognitive Orientierung der Theorie aufmerksam macht. Weitere Bezeichnungen der Theorie sind „Zeichen-Gestalt-Theorie“(Sign-GestaltTheory), „Zeichen-Bezeichnetes-Theorie“(Sign-Significant-Theory) oder Erwartungstheorie. Tolman ging es darum, die Verhaltenstheorie mit Begriffen wie Denken, Planen, Schlußfolgern und Absicht in Kontakt zu bringen. Sein Haupteinfluß lag in der Bekämpfung gewisser einschränkender Annahmen, die seine strikten behavioristischen Vorgänger und Kollegen getroffen hatten. Er galt als scharfsinniger Beobachter tierischen Verhaltens und als ein Kritiker der Zeitgenössischen S-R-Verstärkungstheorie. Seine Hauptüberzeugungen waren folgende: • Verhalten sollte auf der Ebene von Handlungen analysiert werden, nicht auf derjenigen von Bewegungen • Verhalten ist zielgerichtet und damit absichtsvoll • Verhalten ist flexibel und paßt sich bei der Verfolgung eines gegebenen Zieles den Umständen an 3. Verhalten als zielgerichtetes Handeln Tolman vertrat die Auffassung, daß Verhalten am besten als ein Handeln mit Absichten und Zielen beschrieben werde. Wir sagen, jemand kaufe ein Buch, trinke Milch usw., ohne dabei die einzelnen Bewegungen anzugeben., das Erreichen eines Zieles oder Endzustandes sollte die psychologische Analyseeinheit abgeben, nicht die Abfolge von Muskelimpulsen, welche zu diesem Ziel führen.Die Anpassungsfähigkeit (docility) des Verhaltens bezeichnet einfach den Umstand, daß es sich veränderten Gegebenheiten anpassen kann, und daß die Art und Weise wie ein Ziel erreicht wird, von den vorhandenen Mitteln abhängt. Ein Beispiel dazu wäre, daß man selbst in die Stadt fahren, den Bus nehmen oder zu Fuß gehen kann. Das gewählte Verhalten ist keine reflexartige Reaktion auf das Ziel, sondern variiert in Funktion der Gegebenheiten. Dies bedeutet insbesondere, daß ein Organismus sein Wissen über räumliche Wege, Werkzeuge und Hindernisse einsetzen kann, um völlig neuartige Lösungen bei Zielblockaden zu finden. Verhalten scheint zielgerichet zu sein , als Bewegung zu etwas hin oder von etwas weg. Das gegenwärtige Verhalten ist durch Wissen oder Glauben hinsichtlich seines Ergebnisses gesteuert. Der Vogel versucht aus dem Käfig zu fliegen, der Waldarbeiter fällt den Baum usw. Tolman beschreibt das Verhalten auf der Ebene seiner Zwecke und Ziele (molare bzw. makroskopische Beschreibung im Gegensatz zur molekularen bzw mikroskopischen Beschreibung - Ebene der Einzelbewegungen). Tolman betonte - für Mensch und Tier- die konzentrierte Reflexion des Organismus über Probleme, seine inneren Repräsentationen der Umwelt, die Verwendung dieser Repräsentationen zur Lösung von Problemen usw. Diese kognitiven Prozesse sind unseren Intuitionen über das geistige Geschehen vertraut. Mit Hilfe von Ratten versuchte Tolman kognitive Prozesse nachzuweisen ( zw.1930-1950 standen die niedrigeren Tieren im Vordergrund der Forschung), er verfaßte im Laufe der Jahre mehrere theoretische Konstrukte. 4. Tolmans lerntheoretische Konstrukte 4.1 Erwartungen und kognitive Pläne Tolmans Grundüberzeugung war, daß Organismen Wissen über ihre Umwelt erwerben, darüber, wo wichtige Ziele liegen und wie man von einem Ort zum anderen gelangt. Die Wissenseinheit war die Relation zwischen zwei oder mehreren Stimulusereignissen ( wie bei der Pawlowschen Konditionierung) oder zwischen einem Stimulus, der darauffolgenden Reaktion und einem weiteren Stimulus, der auf die Reaktion folgt. Die letzteren, dreigliedriegen Einheiten entstehen beim instrumentellen Lernen. Sie werden Erwartungen genannt. Diese dreiglietrigen Erwartungen, in Klammern als (S1- R1-S2) geschrieben, beziehen sich auf das Wissen des Organismus, daß die Reaktion R1 in der Situation S1 bald zum Stimulus S2 führen wird. Beispielsatz: Klingelknopf S1 wird gedrückt R1, erwarte ich die Türglocke S2 zuhhören. Diese dreigliedrige assoziative Einheit ist eine Erwartung, vor einer tatsächlichen Handlung. Wenn das Läuten der Türglocke zum Ziel des Handelns wird ( Tolman: S2 positive Valenz), wird diese Erwartung aktiviert. Ich drücke die Glocke nur wenn ich das Klingeln hören will oder ich kann die betreffende Erwartung auch nur als ein Wissen besitzen und nichts damit unternehmen. Tolmans Grundannahme in seiner Theorie ist daß das Tier sein Wissen durch bloßes beobachten der Umweltereignisse erwerben kann. 2 Weiters sagt er das keine Verstärkung notwendig ist sondern nur Kontinuität der erlebten Ereignisse. Tolman sagt jetzt wenn die S1-R1-S2 Erwartungen in dieser Reihenfolge auftreten werden sie jedesmal verstärkt und gleichzeitig geschwächt wenn S2 in dieser Reihenfolge ausfallen würde. Die Schwächung von Erwartungen war Tolmans Version des Löschungsvorganges, den ich laufe des Referates noch näher erkläre. Tolman glaubte auch an einen Denkprozeß den er Inferenz nannte. Hat ein Tier eine Erwartung( S1-R1-S2) und wird ihm dann eine weitere Ereignisknüpfung S2-S* beigebracht, so wird es eine neue Erwartung ( S1-R2-S*) inferieren. Inferenz war der Prozeß, über den neue Belohnende Ereignisse in einer Zielkammer (S2-S*-Paarungen) sich auf alle Reaktionswahlen auswirken konnten. Beim auskundschaften eines Territoriums erwirbt ein Tier eine große Zahl von S1-S2- und S1-R1-S2Verknüpfungen. Tolman nahm an, daß dieses Wissen in einer Art kognitiver Landkarte organisiert sei. Es handelt sich also nicht um eine zusammenhangslose Liste lokaler Stimulus-Reaktions-Paare. Er bezeichnet das „Gehirn“ als einen Karten-Kontrollraum, indem die einkommenden Stimuli überarbeitet werden und zu einer vorläufigen Karte der Umwelt zusammengesetzt werden und aufgrund deren die Reaktionen der Tiere bestimmend sind. Nach Tolmans Meinung setzen Tiere das Wissen über die räumliche Anordnung von Gegenständen und Wegen so wie Menschen Stadtpläne ein. Wenn keine Hindernisse auftreten wird der kürzeste Weg genommen. Diese Idee der kognitiven Karte führte zu vielen neueren Forschungen, die ich noch erwähne. 4.2 Lernen versus Verhaltensweisen In Tolmans System bilden Erwartungen die Einheiten des Wissens, die der Organismus lernt. Niemals führen wir aber alle Handlungen aus, derer wir fähig sind. Ein gegebenes Stück Wissen liegt gewöhnlich ungebraucht im Gedächtnis, bis es zur Erlangung eines begehrten Zieles notwendig wird. Tolman war einer der ersten Psychologen die eine Starke Trennung zwischen Lernen und dessen Auswirkung im Verhalten einführte. Tolman nahm an, daß eine Erwartung (S1-R1-S2) immer dann in eine Handlung übergeht, wenn das Ziel S2 , zu einer starken positiven Valenz wird. Hat ein Tier bereits Erfahrung mit einem Labyrinth und weiß, wie man zur Zielkammer gelangt, wo es zu trinken gibt, so wird die Valenz dieser Zielkammer nun um so größer ausfallen, je häufiger das Tier dort bereits getrunken hat und je durstiger es in einem gegebenen Moment ist. Ist es im Moment bereits mit Wasser gesättigt, hat die Zielkammer keine Valenz. Tolman nahm auch ein Prinzip der sekundären Verstärkung an. War S2 ein Stimulus mit positer Valenz und wurde dann ein neutraler Stimulus S* mit S2 gepaart, so erhielt gemäß diesem Prinzip auch S* eine positive Valenz. Daraus schließt man das bei einer hohen Valenz von S2 in einer Sequenz und der entsprechenden Erwartung (S1-R1-S2) sich auch die Valenz von S1 erhöht. So wird die Tatsache anerkannt, daß Stimuli , die zu positiv bewerteten Ereignissen führen, selber auch bewertete positive Teilziele werden. Ein Beispiel ist ein Schimpanse dem man eine Münze gibt, welche er in einen Spielautomaten wirft und daraufhin eine Banane bekommt. Der Schimpanse wird bald darauf auch die Münze positiv bewerten und neue Verhaltensweisen lernen um diese zu bekommen. 5.Empirische Befunde, die für Tolmans Ansichten relevant sind 5.1 Sensorisch-sensorische Assoziationen Kognitive Theoretiker wie Tolman sprachen sich für die Möglichkeit direkter Assoziationen zwischen sensorischen Elementen aus, also für S-S-Einheiten im Gedächtnis. Scheinbar einfache Beweise zB, daß der Mensch Wort-Wort-Assoziationen bilden kann, wurde nicht anerkannt, weil man annahm, daß der Lernende dabei implizit (mit Namengebung) auf Stimuli reagiert, so daß die Stimuli indirekt über die Reaktionen verknüpft werden. 3 Aus solchen Gründen war man der Meinung, daß sich die Frage der sensorischen Konditionierung am sichersten in Experimenten mit niedrigen Tieren entscheiden ließen. Dazu erfand man die Experimente der sensorischen Vorkonditionierung, welche wir uns nun zu wenden. 5.2 Sensorische Vorkonditionierung Bei der sensorischen Vorkonditionierung werden zwei neutrale Reize S1 und S2 in vielen Lerndurchgängen miteinander gepaart. Danach wird einer der beiden, S2, seinerseits mit einem biologischen bedeutsamen gepaart, bis S2 eine konditionierte Reaktion hervorruft. „Theorien des Lernens Bd. 2( 1981) „S94 Abb. 12.1 In der kritischen Schlußphase des Experiments wird die Assoziation des Reizes S1 mit dem CR getestet. Ruft nun auch S1 in einem gewissen Grade die CR hervor, so wird angenommen, daß sensorische Vorkonditionierung stattfand. Die Erklärung wäre, daß S1 mit S2 und hierauf mit dem US assoziiert werden, so daß beim Schlußtest S1 eine Repräsentation von S2 abruft, die ihrerseits die Vorstellung des US wachruft, was schließlich die CR auslöst. 5.3 Kurzzeitgedächtnis bei Tieren Weitere Befunde über die Fähigkeiten von Tieren, eine Reiz über kurze Zeitintervalle im Gedächtnis zu behalten, legt die Existenz sensorischer Konditionierung nahe. Diese Fähigkeit des Kurzzeitgedächtnis wird in neuerer Zeit zunehmender untersucht. Eine frühere Untersuchungstechnik war diejenige der verzögerten Reaktion. Das Tier beobachtet wie der Versuchsleiter an abwechselnden Orten Futter ablegt, nach einem bestimmten Zeitintervall wird das Tier freigelassen und der Vl stellt fest ob das Tier den richtigen Ort findet. Ist das Tier erfolgreich nimmt man an das es eine Repräsentation der Ereignisse über einen Zeitintervall hinweg behalten. Dieses Verfahren wird aber nicht mehr beibehalten, da man nicht ausschließen kann daß das Tier einfach seine Körperhaltung beibehaltet, gleich wie ein Jagdhund, der zu einem im Feld liegenden Vogel läuft. Aus diesem Grund zieht man das Verfahren des verzögerten Stimulusvergleichs vor. „Theorien des Lernens Bd.2(1981)“ S96 Ab.12.2 An der Stirnwand eines Käfigs eines Affen oder einer Taube sind drei durchsichtige Scheiben montiert, auf die von hinten Stimulusformen projiziert werden. Dem Tier wird beigebracht auf jede Scheibe die leuchtet durch drücken oder picken zu reagieren. Danach wird ihm beigebracht auf die mittlere Scheibe zu reagieren, wenn sie aufleuchtet, und damit die beiden Scheiben daneben auch zum Aufleuchten zu bringen. 4 Reagiert das Tier jetzt auf die Außenscheibe die die gleiche Form hat wie die mittlere so wird ihr Verhalten belohnt, während Reaktionen auf die falsche Scheibe nicht bekräftigt wird. Der maßgebliche mittlere Stimulus ( Dreieck) wird von Durchgang zu Durchgang nach dem Zufallsprinzip gewechselt, ebenso die Position der Wahlscheibe. Somit muß sich das Tier erstens an das Zeichen in der mittleren Scheibe erinnern und dann auch noch die passende Scheibe dazu wählen. Am Anfang hat man nur zwei Stimuli, es können aber mit zunehmen der Fertigkeiten der Tiere die Stimuli erhöht werden und die Pausen verlängert werden. 5.4 Das Lernen von Zielen( Zeichen) als Alternative zum Reaktionslernen Alle Reiz-Reaktions- Theorien gehen mit unterschiedlichem Exaktheitsanspruch davon aus, daß der Organismus durch interne und externe Reize den Weg zum Ziel entlanggetrieben wird. Er lernt dabei die richtigen Bewegungsabfolgen, weil durch sie diese Reize unter geeigneten Antriebs- und Umweltreizbedingungen nachlassen. In der traditionellen S-R-Theorie wird angenommen, daß der Organismus zum Zeitpunkt der Reaktionswahl keinerlei Repräsentation des Zieles besitzt. Das ganze Wissen des Organismus erschöpft sich nach strenger Watsonscher Interpretation darin, daß gewisse Reaktionen in gewissen Situationen gewisse Stärken aufweisen. Die Verstärkungsbedingungen sind im subjektiven Situationswissen nicht repräsentiert; sie drücken sich nur in den verschiedenen Stärken der S-R Verknüpfung aus. Dagegen vertrat Tolman die Ansicht daß der Organismus Ziele(Belohnungen) lernt, so daß er schließlich weiß, welche Reize auf bestimmte S-R Kombinationen folgen. seite 5 Tolmans S-R-S Formulierung schreibt dem Organismus also eine innere Repräsentation des Zieles oder des nächsten Stimulus in der Sequenz zu. Während er eine Rektionssequenz wie das Durchlaufen eines Labyrinthes lernt, folgt der Lernende verschiedenen zum Ziel führenden Zeichen, lernt seinen Weg zum Ziel er lernt nicht Bewegungen, folgt einer Art Karte. Problem: Gibt es nur einen Weg zum Futter und rennt das Tier bei jedem Lerndurchgang schneller zum Futter hin läßt sich nicht entscheiden, ob seine Reaktionen durch Bekräftigungen gestärkt wird oder durch zunehmende stärkere Zielvalenzen (Erwartungen von Futter) Es gibt 3 Theorien, in denen sich die Theorie des Zeichenlernens besser zu bewähren scheint, nämlich in Untersuchungen über Belohnungserwartung, über Ortslernen (place-learning) und über latentes Lernen. 5.4.1 Belohnungserwartung Eine der ersten und auffälligsten Beobachtungen machte Tinklepaugh ( 1928). Experiment: man legte Futter unter eine von 2 Behältern, wobei ein Affe zusah, dem aber Behälter und Futter zunächst noch unzugänglich waren. Später durfte dann der Affe zwischen zwei Behältern wählen, wobei sich herausstellte , daß er bald besonders häufig den richtigen Behälter aufhob. Dies entspricht der Situation verzögerter Reaktionen. Wichtig bei diesem Experiment war aber der Austausch mit einem nicht so begehrten Futter (BananeLattichblatt). Der Affe ließ das Lattichblatt liegen und zeigte jetzt ein deutliches Suchverhalten. Ähnliche Beobachtungen machte Elliott (1928) bei einem mit Ratten durchgeführten Labyrinthexperiment: er ersetzte Kleiebrei durch Sonnenblumenkerne im Zielkäfig. Später hat man auch mit Schimpansen systematischere Versuche angestellt ( Cowles und Nissen 1937). Angesichts dieser Ergebnisse kann man nicht bezweifeln, daß Tiere so etwas wie auf spezifische Zielobjekte bezogene „Vorkenntnisse“ oder Erwartungen besitzen. Wenn man nun das Zielobjekt austauscht, treten auch Symptome von Störungen des gelernten Verhaltensablaufs auf. 5 5.4.2 Ortslernen Im Experiment über Ortslernen will man zeigen, daß sich der Lernende vom Start zum Ziel nicht entlang einer fixierten Kette von Reaktionen bewegt sondern, daß er sein Verhalten entsprechend veränderten Bedingungen variieren kann, etwa so, als ob er wüßte, wo sich das Ziel befindet. z.B.: Bei einem Experiment mit einem Affen, dem man 2 nebeneinander liegenden Figuren zeigte ,wobei die eine Figur ein schwarzes Dreieck und die zweite ein weißes Quadrat war, wurde er dafür belohnt wenn er das Dreieck wählte . Trotz wechselnder Position des schwarzen Dreiecks, z.B. bei vertikaler Positionierung der Figuren , wählte der Affe immer wieder das Dreieck. Das Tier hat gelernt sich dem schwarzen Dreieck zuzuwenden und nicht auf die genaue Position der Figuren festgelegt. Es gibt drei Arten von Experimenten zum Ortslernen, bei einem geht es um die Alternative OrtslernenReaktionslernen. In der zweiten Gruppe wird eine Bewegungsgewohnheit einer Raumorientierungsgewohnheit gegenüber gestellt und in der dritten Gruppe geht es um die Verwendung von Alternativwegen wenn der eingeübte Weg blockiert ist. In der ersten Gruppe dieser Experimente bei der Gegenüberstellung von einer Bewegungsgewohnheit und einer Raumorientierungsgewohnheit bleibt der Verlauf des Weges erhalten aber der Bewegungsablauf verändert sich. Bei einem Versuch mit Ratten .denen ein Weg in einem Labyrinth bekannt war konnte man zeigen daß auch nach einem Eingriff in das Kleinhirn, der den Bewegungsablauf veränderte - sie konnten sich nur mehr in kleinen Kreisen fortbewegen- sie fähig waren den Weg ohne Fehler zurückzulegen. ( Lashley und Ball 1929) Experiment (Macfarlane1930) zeigte daß Ratten den richtigen Weg auch schwimmend fanden, nachdem sie in watend erlernt hatten. Später zeigte sich, daß Ratten, die auf einen Floß durchs Labyrinth gezogen worden waren auch ihren Weg ohne Floß fast fehlerfrei fanden. – offensichtlich hatten sie die richtige Abfolge von Zeichen oder Entscheidungshinweisen gelernt, und zwar ohne jede eigene Laufbewegung. Bei Experimenten aus der zweiten Gruppe geht man der Frage nach ob das Ortslernen leichter ist oder das Reaktionslernen. Tolman und seine Mitarbeiter (Tolman,Ritchie und Kalisch, 1947) verwendeten dafür ein kreuzförmiges Labyrinth. „Theorien des Lernens Bd.2 (1981)“S103 Abb.12.5 Die Versuchstiere der einen Gruppe bekamen immer Futter wenn sie sich nach rechts wendeten, Reaktionslernen, sie starteten abwechselnd von S1 und S2. S1-Futter bei F1 und S2 –Futter bei F2. Die Tiere in der anderen Gruppe lernten unter der Bedingung des Ortslernens. Das Futter lag immer auf der Position F1, wenn sie also von S1 starteten mußten sie sich nach rechts wenden und von S2 nach links. Den größeren Lernerfolg hatten die Tiere des Ortslernens, acht Tiere konnten nach acht Lerndurchgängen die nächsten zehn Durchgänge fehlerlos bestreiten. Die Tiere mit der Bedingung Reaktionslernen lernte nicht so schnell, vier von den Ratten hatten sogar nach 72 Lerndurchgängen keinen Erfolg. Weitere Experimente zeigten dies aber nicht immer. Restle (1957)löste einige Widersprüche er nahm an daß der lernende Organismus auf beide Arten von Hinweisreizen ( Ort und Reaktion) zu reagieren lernen kann, und aß die entsprechende Lerngeschwindigkeit von der relativen Auffälligkeit oder Unterscheidbarkeit der beiden Arten von Hinweisen in der gesamten Labyrinthsituation abhängen. Die dritte Gruppe der Experimente geht über die Verwendung von Alternativwegen, wenn der eingeübte Weg blockiert ist. Eine frühe Form dieser Variante war das Experiment von Tolman und Honzik (1930a). 6 „Theorien des Lernens Bd2 (1981)“ S104 Abb.12.6 Es führten drei Wege zum Ziel 1,2,3,Weg 1 war der kürzeste und Weg 3 der längste und damit am wenigsten bevorzugte Weg. Beim Vortraining wurde der Weg1 zeitweilig blockiert und Weg 2 wurde zum bevorzugten Weg gegenüber Weg3. Nur wenn auch Weg2 blockiert war wählten sie Weg3 zum Ziel. Wichtig war nun beim anschließenden Hauptversuch das der Weg1 und der Weg2 ein gemeinsames Teilstück hatten wobei die Blockierung im Vorlauf sich immer vor diesem Teilstück befand, die Ratte kehrte also zurück und nahm den Weg 2. Im Hauptversuch wurde die Sperre auf diesem gemeinsamen Teilstück errichtet. Es stellte sich nun die Frage ob die Ratte die neue Sperre erkannt und gleich den Weg 3 wählte oder sie zuerst den Weg2 einschlägt wo sie nicht weiterkommt. In diesem Versuch wählten die meisten Ratten den Weg3, dem längsten , was wiederum eine Bestätigung für die Hypothese wäre, das sich Ratten nach einer Art Landkarte richten und das sie nicht von blinden Gewohnheiten gesteuert werden. Neben Kritik an diesem Experiment ,daß durch Manipulation von Breite und Bewandung des Labyrinths eigentlich keinen Einfluß auf die Überlegungen des Tieres haben dürfte (Keller und Hill1936 ,Evans1936, Kuo1937 und Hash1937) konnten auch die Ergebnisse in späteren Versusanordnungen bewiesen werden(Deutsch und Clarkson 1959). Auch später Experimente mit Schimpansen (Menzel1978) ließen diese Schlußfolgerungen zu. 5.4.3 Latentes Lernen Die Versuche zu latentem Lernen beweisen daß ein Tier lediglich durch Inspektion des Labyrinthes lernen kann, ohne daß ihm dabei Futter verabreicht wird. Man erhält bei späterer Versuchsphase mit Fütterung bei Tieren die das Labyrinth bereits erkundigt haben bessere Reaktionen, als ohne diese Möglichkeit. Die Lernleistung dieser „erfahrenen Tiere“ reichte oft an bereits die von „belohnten Tieren“ heran . “Latent“ heißt es daher, weil es in einer „Kenntnis“ des Labyrinths besteht, die zunächst verborgen bleibt und erst durch Motivation (Fütterung) nutzbar gemacht wird. In einem Experiment von Tolman, und Honzik (1930b) untersuchten sie die Auswirkung einer später eingeführten Belohnung bei Ratten. In der Experimentalgruppe wurden Ratten für mehrere Tage in ein Labyrinth ohne Futter gesetzt. In der Kontrollgruppe befanden sich Ratten in einem gleichwertigen Labyrinth mit Futter. In der Kontrollgruppe verringerte sich die Fehler- und Zeitkennwerte wesentlich schneller als in der Gruppe ohne Futter. Wenn man jetzt aber beide Gruppen füttert treten keine Unterschiede auf. Beide Gruppen haben also von den Versuchsdurchgängen gleich profitiert. Da sich der Gewinn nicht in der Leistung offenbart, bezeichnet man derartiges Lernen als „latent“. „Theorien des Lernens Bd.2(1981) S106 Abb.12.7 7 Tolman erklärt das besonders eine nicht belohnende Situation sich zu Erlernen der räumlichen Relation des Labyrinths eignet. Bei dem vorhergenannten Versuch war eine Seite blockiert und konnte auf der anderen Seite durch eine Klappe verlassen werden. Durch diese Klappe zu laufen , war auf jedenfalls das die Ratte im jeweiligen Abschnitt zu letzt tat. Seite 7 Die zeitliche Nähe (von Tolman als günstige Entstehungsbedingung für „Zeichen –Gestalten“ anerkannt) läßt die Kognition- Klappe ist der Weg von einem Abschnitt zum nächsten- stärker werden, für die Ratte hat aber ohne Fütterung keinen Anlaß ihre Kenntnisse zu zeigen. Wenn sie jetzt aber ein Futter findet, wendet sie ihre kognitive Landkarte für den Weg an. Hierin liegt auch die Erklärung für die verringerte Fehlerzahl. 5.5 Direkte Veränderung der Zielvalenz Tolman glaubte, daß Tiere durch die Kombination von Wissenselementen bei einer Wahlsituation so ihren Weg erschließen können. Wenn also ein Tier in ein ihm bekanntes Labyrinth dem Ziel zusteuert, dann macht es dies deshalb weil es bei einem vorhergegangenen Versuch an diesem Ort Futter fand, und daraus schließt wieder welches vorzufinden. Wichtig dafür sind das zuvor genannte latente Lernen der Inferenzenprozeß und Experimente bei denen nach der ersten Lernphase der Anreiz am Ende des Labyrinths verändert wurde. Klassisches Experiment von Tolman und Gleitman(1949): In einem T-Labyrinth befanden sich an beiden Enden Futter, beide Arme des Labyrinths waren also gleich attraktiv. An einem bestimmten Tag, wurden die Ratten in einen Seitenarm gesetzt und erhielten massive Stromstößen. Im kritischen Entscheidungsexperiment, welches folgte, wählten die Ratten vorwiegend den Arm indem sie kein elektrischen Schläge bekammen. Wichtig dabei ist das die Tiere vom Entscheidungspunkt aus, die Zielkammern nicht wahrnehmen konnten und sich grunddessen an den Ort an dem sie „bestraft“ wurden erinnert haben mußten. Ein weiteres Experiment dieser Art wurde von Seward un Levy (1949) durchgeführt, ein Experiment zur latenten Löschung.( Forschungsliteratur von Moltz 1957 gesichert) Tiere werden zunächst in der einfachen instrumentellen Reaktion geübt z.B. einen Hebel zudrücken damit Futter kommt oder einen Weg entlang zu laufen an dessen Ende Futter zu finden ist. Danach wird der letzte Teil der Verhaltenskette wieder gelöscht indem das Tier direkt an den Zielort gebracht wird dort aber kein Futter vorfindet oder der Hebel entfernt wird,die folge ist das das Tier nicht mehr zur Futterquelle geht. Die kritischen Beobachtungen werden aber jetzt gemacht wenn den Ursprung des Experiments wieder hergestellt wird und das Futter wieder zur Verfügung steht. In diesem Fall zeigt sich das die Anfangsreaktion sichltlich geschwächt ist da das Tier <schließt> kein Futter mehr vorzufinden. Wichtig an diesen Resultaten ist der Schluß, daß sich die Stärke einer instrumentellen Reaktionssequenz verändern läßt , ohne daß dabei die betreffenden Reaktionen auftreten müssen 5.6 Verstärkung und Bestätigung von Erwartungen Tolman lehnte das Gesetz der Auswirkung ab. Er nahm an das man die Korrelationen von Ereignissen durch das Erleben lernt, und nicht durch die Belohnung oder die Bestrafung. Er gibt zwar zu, daß Motivation und Belohnung sich indirekt auf das Ergebnis des Lernens auswirken könnten, indem sie zum Teil bestimmen welche Reize die Aufmerksamkeit des Organismus auf sich ziehen. So wird eine Ratte auf Reize in der Nähe eines Futterplatzes achten und so mehr über diesen Ort lernen , als wenn dort kein Futter wäre. In Untersuchungen zum menschlichen Verbalen Lernen scheint auch diese hinweisende oder informative Funktion der Verstärkung auf. (z.B. Atkinson und Wikkens ,1971). Versuchsteilnehmer wiederholen innerlich vorallem diejenigen verbalen Elemente, die ihnen vorher als wichtig angegeben wurden. In diesem Fall wirkt die Belohnung als informatives Signal das dem Versuchsteilnehmer hilft bestimmte Ereignisse zur aufmerksamen Beachtung, Wiederholung und Speicherung auszuwählen. 8 5.7 Vorläufige Erwartungen als Hypothesen Nach Tolmans Meinung probiert der Lernende vor der Lösung eines Problems aktiv verschiedene Hypothesen bezüglich der in der Problemumgebung existierenden (S-R-S*) Relationen aus. Eine gegebene Hypothese hinsichtlich der richtigen Lösung eines Diskriminationsproblems kann als vorläufige Erwartung betrachtet werden, aufgrund der Verhalten auch dann systematisch wäre, wenn die Situation noch nicht strukturiert ist und die Wege zum Ziel nicht bekannt sind. 5.8 Symbolisches Versuchs- und Irrtumsverhalten Eine weitere Gruppe von Beobachtungen , die Tolman als Belege für seinen Ansatz zitierte, betraf das sogenannte symbolische Versuchs-und Irrtums-Verhalten von Tieren an einem Entscheidungspunkt. Dieses von Muenzinger (1938) und von Tolman(1939) untersuchte Verhalten besteht darin, daß ein Tier an einem Entscheidungspunkt zögert und verschiedene Stimuli vergleicht, bevor es sich für eine Richtung entscheidet. Tolman glaubt, daß das Tier jeden Wahlstimulus einzeln in Betracht zieht, Hypothesen generiert und sie miteinander vergleicht. 6. Räumliches Gedächtnis und kognitive Pläne Tolman gebraucht den Begriff des kognitiven Planes, um das Wissen der Ratte bezüglich der räumlichen Zusammenhänge im Labyrinth zu beschreiben. Weder Tolman noch einer seiner Schüler enwickelte eine entsprechende Theorie weiter, sie überprüften aber die Voraussage, daß das Tier bei einer Blockierung des bisher gelernten Weg den kürzesten Umweg. Eine Voraussage die im allgemeinen bestätigt werden konnte. In neueren Experimenten hat man nun begonnen, systematisch zu erforschen, wie der Organismus Kentnisse über die räumliche Anordnung von naheliegenden Gegenständen erwirbt und ein setzt. Im Punkt 10 meines Referates möchte ich jetzt auf ein Experiment mit Schimpansen von Menzel (1973,1978) näher eingehen. 6.1. Kognitive Pläne bei Schimpansen Abschließend ist noch zu erwähnen das es Schade ist das Tolman und seine Anhänger Ratten und keine Schimpansen gewählt hat. Bei der Arbeit mit Schimpansen in freier Umgebung hat man bald hunderte von Intelligenzakten bei der Verwendung mit Werkzeugen, beim sozialen Verhalten usw. Beobachtungen von Menzel (1973,1974,1978): Er beobachtete eine Schimpansengruppe dabei, wie sich mit einem neuem Gehege,einen halben Hektar groß, vertraut machten. Die Schimpansen hatte dafür aber nur ein paar Stunden am Tag Zeit. Am Anfang fürchteten sie sich vor dem unbekannten Territorium. Sie blieben in der Nähe des Gebäudes von dem aus sie das Gebiet betraten, nach einiger Zeit erkundeten sie es aber schon einen größeren Teil. Ältere 9 Schimpansen erforschten es schneller als Weibchen und jüngeren Männchen. Die Tiere bewegten sich als Gruppe und blieben in der Nähe von Bäumen und Büschen. Nachdem die Tier ihr Gebiet kennengelernt hatten brachte Menzel jeden Tag an einem anderen Ort ein Spielzeug.(z.B. eine Puppe, Teddy Bär). Innerhalb weniger Minuten entdeckten sie dieses und spielten mit ihm, das Entdecken eines neuen Gegenstandes hat natürlich eine genaue Kenntnis der alten Gegenstände des Gebietes zur Voraussetzung. Anschließend spielte Menzel eine Art Ostereier-Suchen. Ein Experimentator trug den Schimpansen herum, wobei ein zweiter Experimentator dem Tier zeigte, wo achtzehn begehrte Früchte versteckt waren. „Theorien des Lernens Bd.2 1981“ S122 Abb.12.11 Die Abbildung zeigt Pläne für vier verschiedene Affen, die Ziffern in den Kreisen geben an, in welcher Reihenfolge die Verstecke dem jeweiligen Schimpansen gezeigt wurde. Nach der Beobachtungsphase wurde der Schimpanse in das Gehege gesetzt und lief zielstrebig von einer Frucht zu anderen. Die Tiere erinnerten sich an die meisten Früchte ( 15von 18), der Weg beginnt in der Abbildung bei s und verläuft in Pfeilrichtung. Kontrollexperimente bewiesen das die Leistung nicht mit Hilfe des Geruchssinns oder aufgrund zufälliger Entdeckungen zustande kam. Außerdem optimierten sie die Gesamtstrecke, sie nahmen einen sehr ökonomischen Weg. Die Reihenfolge des Aufsuchens leitete sich nicht vom vorhergegangen Zeigen ab sondern von der Nähe der Früchte zueinander. Die Schimpansen erinnern sich anhand ihrer mentalen Karte gleichwie ein Kaufmann der in 18 Städte reist mit Hilfe einer Landkarte( eine äußere Gedächtnishilfe). Die Versuche wurde öfters an einem Tag gemacht, und zwar jedesmal mit anderen Verstecken. Die Schimpansen schienen lokale Geländemerkmale als Gedächtnisstützen zu verwenden, einerseits orientierten sie sich anhand eines hervorstehenden Objekt in der Nähe, zum Beispiel eine Baum oder Busch und einem spezifischen lokalen Hinweis, wie einem braunen Kaktus. Auftauchende Fehler ließen sich aufgrund von Verwechslungen lokaler Zeichen zurückzuführen und waren derselben Art, wie Menschen es machen würden. Zu diesem Thema gibt es weitere Experimente z.B. zur Beobachtung aus Distanz, Anzeigen der Früchte nur mit Richtungsanzeige durch die Hand. Solche Experimente zeigen das gelernte Schimpansen ein bemerkenswertes Erinnerungsvermögen haben und zielgerichtet Wege planen. Bedingung dafür ist aber das die Tiere ihre Umgebung genau kennen. Was die Theorie betrifft glaubt Menzel das die Schimpansen so etwas wie einen kognitiven Plan aufbauen, während sie sich mit ihrem umhegten Gebiet vertraut machen. Neuere Forschungen haben sich auf die Fähigkeit des Menschen konzentriert, sich aus wenigen Einblicken in ein neues Gebäude oder eine neue Stadt einen kognitiven Lageplan zu bilden (Gould und White,19749). Anzufügen ist das diese Beobachtungen zum Lernen und Benützen von Plänen bei Primaten den schlagendsten Beweis für Tolmans Theorie der kognitiven Pläne geben. 10 9. Zusammenfassung und abschließende Bemerkung zu Tolmans Einfluß Tolman gab dem Behaviorismus eine neue Form, er öffnete ihn für Probleme wie kognitive Prozesse, Problemlösen und kreative Überlegungen. .Nach seiner Meinung benutzen Tier ihr Wissen über die räumliche Anordnung von Gegenständen und Wegen wie Menschen einen Stadtplan, er nennt dies eine kognitive Landkarte. Tolmans System war zu wenig konzis, um von Dauer zu sein, aber auf seine Annahmen über das latente Lernen, der Unterscheidung zwischen Lernen und Verhaltensweisen, die Zielvorwegnahme und die Anreizmotivation und viele andere sind Entwicklungen in neueren Experimenten zurückzuführen. Tolmans Programm scheint nun in der modernen kognitiven Psychologie zur Reife zur gelangen. Quellennachweis: „Theorien des Lernens Bd.2(1981)“ K.12 S88-124 „Theorien des Lernens Bd.1(1971)“ K.7 S219-259 11