neuronale netze in bezug auf mustererkennung

Werbung

A. Steinmetz

N EURONALE N ETZE

IN

B EZUG

AUF

M USTERERKENNUNG

Vom biologischen Vorbild

zum informatischen Modell

A. Steinmetz

N EURONALE N ETZE

IN

B EZUG

AUF

M USTERERKENNUNG

Vom biologischen Vorbild

zum informatischen Modell

Ausbildungsjahr:

Fach:

Name:

Prüfer:

Koprüfer:

Ausgabetermin des Themas:

Abgabetermin der Facharbeit:

Abgabeort

WS 2002/ SS 2003

Informatik

Andrea Steinmetz

Stephan Gringard

Dr. Jürgen Mayer-Gürr

13.12.2002

20.02.2003

Oberstufenkolleg Bielefeld

Wenn unser Gehirn so simpel wäre, dass wir es verstehen

könnten, wären wir so simpel, dass wir es nicht könnten.

Emerson Puigh1 , Gehirnforscher

1

Emerson Puigh, BrainTech. Mind Machines und Bewusstsein, hg. v. Lutz Berger und

Werner Pieper, Löhrbach 1989

Vorwort

Diese Arbeit entstand im Rahmen der Abschlußprüfungen am OberstufenKolleg in Bielefeld als Facharbeit des Wahlfachs Informatik.

Ausschlaggebend für die Wahl meines Themas war der Wunsch, das Studium der Informatik im Fachbereich Neuroinformatik an einer Universität fortzuführen. In dieser Arbeit habe ich versucht, eine knappe Einführung in die

Grundlagen der Neuroinformatik zu geben. Ich hoffe, dabei die enge Verwandtschaft zweier Fachgebiete, der Biologie und der Informatik, aufgezeigt haben

zu können.

Ich möchte hier die Gelegenheit nutzen, mich bei den wissenschaftlichen Mitarbeitern des Oberstufen-Kollegs für ihre Hilfe zu bedanken, die mit Geduld

und Sachkenntnis zu der Fertigstellung meiner Facharbeit beigetragen haben.

Andrea Steinmetz

Bielefeld, 17. Februar 2003

v

vi

Inhaltsverzeichnis

Einleitung

4

1 Die Nervenzelle

5

1.1 Aufbau und Funktion eines Neurons . . . . . . . . . . . . . . . .

5

1.2 Das Myelin . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8

2 Erregung von Nervenfasern

15

2.1 Das Ruhepotential . . . . . . . . . . . . . . . . . . . . . . . . . 15

2.2 Das Aktionspotential . . . . . . . . . . . . . . . . . . . . . . . . 19

2.3 Die Reizfortpflanzung . . . . . . . . . . . . . . . . . . . . . . . . 24

3 Synaptische Erregungsübertragung

27

3.1 Die Synapse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27

3.2 Die Informationsverarbeitung . . . . . . . . . . . . . . . . . . . 30

4 Visuelle Wahrnehmung

35

4.1 Ultrakurzzeit-Gedächtnis . . . . . . . . . . . . . . . . . . . . . . 35

4.2 Kurzzeit-Gedächtnis . . . . . . . . . . . . . . . . . . . . . . . . 36

4.3 Langzeit-Gedächtnis . . . . . . . . . . . . . . . . . . . . . . . . 37

4.4 Verarbeitung visueller Reize im Gehirn . . . . . . . . . . . . . . 40

5 Die Zellen eines Künstlichen Neuronalen Netzes

43

5.1 Aktivierungszustand . . . . . . . . . . . . . . . . . . . . . . . . 44

5.2 Ausgabefunktion . . . . . . . . . . . . . . . . . . . . . . . . . . 45

5.3 Propagierungsfunktion . . . . . . . . . . . . . . . . . . . . . . . 46

5.4 Aktivierungsfunktion . . . . . . . . . . . . . . . . . . . . . . . . 47

vii

INHALTSVERZEICHNIS

6 Zellen eines KNN im Verbund

6.1

Netzwerktopologien . . . . . . . . . . . . . . . . . . . . . . . . . 49

6.2

Verschiedene Formen der Aktivierung . . . . . . . . . . . . . . . 51

6.3

Methoden des Lernens . . . . . . . . . . . . . . . . . . . . . . . 53

6.4

Lernregel . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 54

6.4.1

Hebbsche Lernregel . . . . . . . . . . . . . . . . . . . . . 55

6.4.2

Delta-Regel . . . . . . . . . . . . . . . . . . . . . . . . . 56

6.4.3

Backpropagation-Regel . . . . . . . . . . . . . . . . . . . 56

7 KNN-Modelle

59

7.1

Mustererkennung . . . . . . . . . . . . . . . . . . . . . . . . . . 59

7.2

Perzeptron . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 60

7.3

Backpropagation . . . . . . . . . . . . . . . . . . . . . . . . . . 63

7.4

7.3.1

Backpropagation-Verfahren . . . . . . . . . . . . . . . . 63

7.3.2

Probleme der Backpropagation . . . . . . . . . . . . . . 67

7.3.3

Herleitung der Delta-Regel . . . . . . . . . . . . . . . . . 71

Hopfield-Netze . . . . . . . . . . . . . . . . . . . . . . . . . . . . 72

7.4.1

Binäre Hopfield-Netze . . . . . . . . . . . . . . . . . . . 73

7.4.2

Beweis der Stabilität von Hopfield-Netzen . . . . . . . . 73

8 Simulation eines KNN in JAVA

viii

49

77

8.1

Typenklassendeklaration und Initialisierung der wichtigsten Komponenten . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 77

8.2

Das Erlernen von Mustern . . . . . . . . . . . . . . . . . . . . . 81

8.3

Die Hamming-Distanz . . . . . . . . . . . . . . . . . . . . . . . 84

8.4

Das Wiedererkennen von Mustern . . . . . . . . . . . . . . . . . 85

8.4.1

Analyse der fehlerhaften Programmfunktionen . . . . . . 88

8.4.2

Umsetzung der Wiedererkennung in Java . . . . . . . . . 90

INHALTSVERZEICHNIS

Ausblick

95

Literaturverzeichnis

98

Anhang

98

A Java-Sourcecode

99

1

INHALTSVERZEICHNIS

2

Einleitung

Technische Errungenschaften beruhen häufig auf dem Versuch, die Natur in ihrer Funktionsweise zu kopieren. Die Entwicklung der Computer lief anfänglich

noch unabhängig davon ab. Zu Beginn dienten sie der Durchführung von Berechnungen. Im Laufe der Zeit wurden sie weiterentwickelt, sodass sie kompliziertere Speicherprozesse vornehmen konnten. Dadurch zeigten sie Ähnlichkeit

mit dem menschlichen Gehirn. Dieses hat jedoch dem Computer gegenüber

einen großen Vorteil: es kann Informationen assoziativ speichern. Ist bei einem

Computer der Speicherort einer Information nicht bekannt, kann er nicht aus

den übrigen gespeicherten Informationen erschlossen werden. Auch unzureichende Informationen können von einem Computer nicht verarbeitet werden,

wohingegen das Gehirn Informationslücken assoziativ auffüllt. Ein Bereich, in

dem sich Gehirn und Computer in ihrer Speicherung unterscheiden, ist die Mustererkennung. Um diese Differenz zum biologischen Vorbild zu überwinden,

liegt es nahe, seine Funktionsweise zu simulieren.

Diese Arbeit beschäftigt sich mit der Funktionsweise des menschlichen Gehirns bezüglich der Mustererkennung und dem Versuch, diese in informatische

Modelle umzusetzen. Dazu werden im ersten Kapitel dieser Arbeit die Nervenzellen vorgestellt, die für die Informationsverarbeitung innerhalb des Gehirns

zuständig sind. Sie werden durch elektrische Reize erregt, die bei der Mustererkennung von Rezeptoren innerhalb des Auges produziert werden. Um die

Weiterleitung von Nervenreizen zu verstehen, wird der Aufbau und die chemischen Vorgänge vor, während und nach einer Erregung einer Nervenzelle in

einem weiteren Kapitel beleuchtet. Die Kommunikation zwischen Nervenzellen

ist ausschlaggebend für die Weiterverarbeitung der Informationen, die in das

Gehirn gelangen. Wie es dazu kommt, dass nicht alle Zellen in gleicher Stärke

ihre Impulse an ihre benachbarten Nervenzellen weitergeben, soll in einem darauf folgenden Kapitel erklärt werden. Der Teil, der sich mit dem menschlichen

Gehirn beschäftigt, schließt mit einem Kapitel, dass sich mit der Speicherung

von Informationen, dem Gedächtnis, beschäftigt, ab. Dabei soll ein kurzer Einblick in die Abläufe visueller Wahrnehmung gegeben werden.

3

INHALTSVERZEICHNIS

Darauf folgt ein Teil der Arbeit, der zeigen soll, wie diese Nervenzellen und ihre

Kommunikation untereinander in Modelle der Informatik umgesetzt werden.

Dabei soll der Schwerpunkt im Aufzeigen der Analogien zwischen den beiden

Fachbereichen Biologie und Informatik gelegt werden. Dieser Teil beginnt mit

den einzelnen Komponenten der Modelle und der Vorstellung mathematischer

Formeln, die die Vorgänge der Informationsweiterleitung von künstlichen Neuronen untereinander repräsentieren. Dabei soll gezeigt werden, wie sich unterschiedliche Verschaltungen künstlicher Neuronen untereinander auf die Funktionsweise eines Netzes aus mehreren Neuronen auswirkt. Ein weiteres Kapitel

stellt einige der bekanntesten Modelle künstlicher neuronaler Netze vor, denen

unterschiedliche Netzarchitekturen zugrunde liegen. Eines dieser vorgestellten

Modelle ist das Hopfield-Netz, welches im letzten Teil der Arbeit die Grundlage

für ein Programm bildet. Dabei soll dargestellt werden, wie die Informationen

der vorangegangenen Kapitel in der Programmiersprache JAVA implementiert

werden können.

Die Arbeit schließt mit einem Ausblick auf zukünftige Entwicklungen auf dem

Gebiet der künstlichen neuronalen Netze.

4

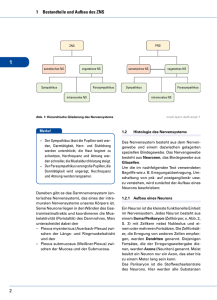

Kapitel 1

Die Nervenzelle

Alle Lebewesen reagieren auf ihre Umwelt. Pflanzen zum Beispiel, richten ihre Blätter nach dem Sonnenlicht aus. Eine solche Reaktion läuft sehr langsam

ab. Tiere und Menschen hingegen reagieren wesentlich schneller auf Reize. Dies

verdanken sie den Nervenzellen, die nur im Tier-, jedoch nicht im Pflanzenreich

vorkommen. Neben den Nervenzellen ist das Myelin ein weiterer wichtiger Bestandteil des Nervensystems. In den folgenden Kapiteln soll der Aufbau und

die Funktionsweisen der Nervenzellen und des Myelins erläutert werden.

1.1

Aufbau und Funktion eines Neurons

Nervenzellen, auch Neuronen oder Gangliazellen genannt, haben die Funktion

der Informationsverarbeitung und -weiterleitung. Sie bilden somit das Bindeglied zwischen einem Reiz und der darauf folgenden Reaktion. Die Anzahl von

Neuronen im menschlichen Gehirn kann nur geschätzt werden. Man vermutet,

dass es mehr als 100 Milliarden1 sind. Die Anzahl der Neuronen, über die ein

Mensch verfügt, steht schon vor seiner Geburt fest. Während der Embryonalphase verlieren Neuronen ihre Fähigkeit, sich zu teilen. Zu diesem Zeitpunkt

sind bereits alle Neuronen gebildet und können sich ab da nicht weiter vermehren. Jedes Neuron ist wiederum mit anderen Neuronen verknüpft.

Das Neuron hat, wie alle tierischen Zellen, eine Zellmembran (Plasmalemma),

einen Zellkern (Nucleus) und Zellflüssigkeit (Cytoplasma). Zusammen bilden

sie den Zellkörper, der die Bezeichnung Soma trägt (Abb. 1.1). Dendriten und

Neuriten (Axone oder Nervenfasern) sind Fortsätze, die dem Soma entspringen. Dendriten können in unterschiedlicher Anzahl oder gar nicht auftreten.

1

1 Milliarde = 1000 Millionen = 109

5

1. Die Nervenzelle

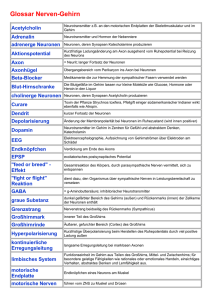

Abbildung 1.1: Schematische Darstellung eines Neurons. In der Mitte des Axons ist

der Zellkern (Nucleus) zu erkennen.

Sie sind für die Informationsaufnahme von anderen Neuronen zuständig, wohingegen die Axone genau einmal je Zelle vorkommen und Informationen an

andere Neuronen abgeben. Sie enden entweder an Dendriten anderer Neuronen

oder an deren Soma. Beachtenswert ist die Länge, die sie ausbilden können.

Dendriten haben eine durchschnittliche Länge von 200 Mikrometern bis 300

Mikrometern 2 , Axone jedoch können bis zu einem Meter lang werden. Sowohl

Dendriten als auch Axone können sich nach ihrem Abgang vom Soma weiter

aufzweigen. Die Verzweigungen des Axons werden Kollaterale genannt.

Neuronen treten in grosser Formenvielfalt auf. Anhand der Anzahl ihrer Fortsätze

lassen sie sich jedoch klassifizieren (Abb. 1.2):

• Unipolare Zellen haben keine Dendriten und ein Axon

• Bipolare Zellen haben jeweils einen Dendriten und ein Axon

• Multipolare Zellen haben viele Dendriten und ein Axon. Sie sind nur bei

Wirbeltieren vorzufinden.

Bei höher entwickelten Lebewesen ist das Axon durch eine fetthaltige Isolierschicht umgeben, dem Myelin. Das Myelin umgibt das Axon jedoch nicht

kontinuierlich. Unter dem Lichtmikroskop sind Einschnürungen zu erkennen.

Sie werden nach ihrem Entdecker Ranviersche Schnürringe genannt. Am Ende

des Axons sitzt die Synapse, die die Kontaktstelle zum Nachbarneuron darstellt.

Das Soma kann in Größen zwischen 5 µm und 100 µm vorkommen. Es enthält

neben dem Zellkern, der das genetische Material enthält und die Lebensprozesse der Zelle kontrolliert, noch weitere Organellen, die in allen Zellen, die einen

Zellkern haben, vorkommen (Abb. 1.3). Jede Organelle hat eine zellspezifische

2

6

1 mm = 1.000 µm = 1.000 Mikrometer

1.1. Das Neuron

Abbildung 1.2: Verschiedene Neuronentypen

Aufgabe.

Dicht dem Nucleus angesiedelt ist das endoplastische Retikulum. Es fungiert

als Transport- und Sammelsystem der Zelle. In seinem Inneren werden Produkte (hauptsächlich Proteine) synthetisiert, die dann über die Membran in

das Cytoplasma abgegeben werden. Das endoplastische Retikulum ist in Kompartimente aufgeteilt, den Zisternen. Auf ihnen sitzen kleine runde Partikel,

die aus RNA3 und Proteinen bestehen. Diese sogenannten Ribosomen habe die

Aufgabe der Proteinbiosynthese.

Weitere Organellen sind die Mitochondrien. Sie sind für die Zellatmung zuständig. In ihrem Inneren wird durch Nährstoffabbau ATP4 produziert. ATP

setzt bei Abspaltung seines Phosphatanteils Energie frei und ist damit ein

wichtiger Energielieferant.

Das Dictyosom (Golgi-Apparat) nimmt die am endoplastischen Retikulum synthetisierten (Glyco-)Proteine auf und modifiziert sie je nach ihrem Bestimmungsort. Die aus dem Golgi-Apparat austretenden Proteine werden mittels

Vesikel innerhalb der Zelle an ihren Bestimmungsort transportiert. Bei Proteinen, die außerhalb der Zelle benötigt werden, verschmelzen die Vesikel mit

der Zellmembran und geben dabei ihren Inhalt an das Zelläußere ab. Wie das

endoplastische Retikulum, besteht auch der Golgi-Apparat aus mehreren Zisternen, die unterschiedliche Enzyme enthalten, die unterschiedliche Aufgaben

bei der Proteinmodifikation übernehmen.

Die für die intrazellulare Verdauung zuständige Organelle ist das Lyosom. Die

3

4

Ribonucleinsäure

Adenosintriphosphat

7

1. Die Nervenzelle

Abbildung 1.3: Schematische Darstellung einer Zelle mit ihren Organellen

Membran des Lyosoms umschließt eine Vielzahl unterschiedlicher Enzyme, die

die Fähigkeit der Zerlegung von Makromolekülen besitzen.

1.2

Das Myelin

Die meisten Nervenfasern sind von einer Myelinschicht umhüllt. Je dicker eine Nervenfaser ist, umso dicker ist auch die sie umschließende Myelinschicht.

Ein Schnitt durch eine myelinisierten Nervenfaser zeigt, dass das Myelin in

mehreren Schichten um das Axon anlagert ist (Abb. 1.4). Erkennbar ist das

an den dunklen und hellen Linien, die spiralförmig um das Axon liegen. In

Abständen von 0,8-2 mm fehlt bei den myelinisierten Nervenfasern die Myelinhülle, so dass die Umhüllung eingeschnürrt erscheint. Diese Einschnürungen

heißen Ranviersche Schnürringe5 (Abb. 1.5).

Untersuchungen in den dreißiger Jahren des letzten Jahrhunderts haben gezeigt, dass sich das Myelin aus einer 5,5 Nanometer6 dicken Lipidschicht und

einer drei Nanometer dicken Proteinschicht zusammensetzt, die abwechselnd

aufeinander folgen. Diese Struktur des Myelins gleicht auffallend der von Zellmembranen. Die Entdeckung der Schwann-Zellen zeigte den Grund dieser Ähnlichkeit, denn das Myelin wird nicht von der Nervenzelle selbst produziert,

5

6

8

nach ihrem Entdecker Louis Ranvier benannt

1 Nanometer = 1nm = 1 Millionstel Millimeter

1.2. Das Myelin

Abbildung 1.4: Mikroskopie eines Schnitts durch ein Axon mit

Myelinschicht

Abbildung 1.5: Rasterelektronenmikroskopische Aufnahme von einem Axon mit Myelinschicht

sondern stammt von den Membranen der Schwann-Zelle.

Die Bildung des Myelins ist abhängig von der Lage des Axons im Nervensystem. Befindet sich das Axon außerhalb von Hirn und Rückenmark, spricht

man von peripheren Nervenfasern. Ihr Myelin wird von den Schwannschen Zellen gebildet. Nerven innerhalb von Hirn und Rückenmark bilden das Zentralnervensystem. Die Aufgabe der Myelinbildung im Zentralnervensystem übernehmen die Oligodendrocyten.

Eine Schwann-Zelle erzeugt einen zwischen zwei Ranvierschen Schnürringen liegenden Abschnitt der Myelinhülle. Der Prozess der Umwicklung beginnt

mit der Anlagerung der Schwann-Zelle an eine Nervenfaser (Abb. 1.6). Sie bildet ihre Membran zu einer flachen Zunge aus, die das Axon im Laufe der Zeit

mehrfach umwickelt. Dabei wird fast das gesamte Zellplasma aus der Membran

heraus gedrückt. Bei nur einer Umwindung liegen dem Axon also zwei Membranen an. Bestimmte Proteine (basische Proteine), die auf der Innenseite der

Zellmembran liegen, bewirken, dass die Innenseiten der Membran miteinander

verschmelzen. Dabei entstehen die in der mikroskopischen Aufnahme sichtbaren dunklen Linien. Die Außenseiten der Schwannschen Zellmembran besitzt

dieses Protein nicht. Daher berühren sich benachbarte Windungen nur und

verschmelzen nicht miteinander.

9

1. Die Nervenzelle

Abbildung 1.6: Bildung der Myelinscheide

Oligodendrocyten sind Stützstellen, die Myelin produzieren (Abb. 1.7). Sie

bilden Fortsätze aus, die zu den Axonen hinwachsen und sie einhüllen. Jedes

Myelinsegment eines Axons wird von einer anderen Stützstelle gebildet. Ein

Oligodendrocyt kann bis zu vierzig solcher Fortsätze haben.

Die Vorteile von Myelin Myelin ist, bedingt durch seinen hohen Fettanteil,

wasserabweisend und damit ein guter Isolator für Axone, durch die elektrische

Impulse laufen. Aber es gibt noch zwei weitere Vorteile: den der Geschwindigkeitserhöhung und den der Energieeinsparung. Durch myelinisierte Nervenfasern läuft ein elektrisches Signal schneller als durch ein Axon ohne Myelinmantel. Die Geschwindigkeit, mit der sich Signale in einer Nervenfaser fortpflanzen

können, hängt von ihrer Dicke ab und dem Umstand, ob die Nervenfaser isoliert

ist oder nicht. Ist sie nicht isoliert, steigt die Geschwindigkeit des sie durchlaufenden Impulses proportional zu der Quadratwurzel ihres Durchmessers. Das

würde bedeuten, dass sich bei einem vierfachen Durchmesser die Geschwindigkeit nur verdoppelt. Ist die Nervenfaser hingegen durch eine Myelinschicht

geschützt, pflanzt sich das Signal mit einer Geschwindigkeit proportional zur

Dicke der Faser fort, das heißt, dass ein Axon mit vierfachem Durchmesser

ein Signal auch in vierfacher Geschwindigkeit weiterleiten kann. Bei gleicher

Geschwindigkeit benötigt also die myelinisierte Nervenfaser weniger Platz als

die ohne Myelin. Wären die Nervenfasern im menschlichen Rückenmark nicht

von einer Myelinschicht umgeben, müsste es einen Durchmesser von mehre10

1.2. Das Myelin

Abbildung 1.7: Schematische Darstellung der Myelinisierung durch ein Oligodendrocyt (Bildmitte).

ren Metern haben, um den von ihr geforderten Leistungen gerecht werden zu

können ([Mor1980]).

Myelin hat auch einen positiven Einfluss auf den Energieverbrauch. Eine zwölf

Mikrometer dicke Nervenfaser eines Frosches leitet die Signale mit einer Geschwindigkeit von 25 Metern pro Sekunde. Die gleiche Geschwindigkeit erzielt

die Nervenfaser eines Tintenfisches. Sie ist unmyelinisiert und benötigt deshalb

einen Durchmesser, der vierzigmal so groß ist wie die des Frosches. Gewaltig

erscheint jedoch der Unterschied im Energiebedarf. Er ist beim Tintenfisch

fünftausendmal höher als beim Frosch.

Das menschliche Gehirn kann also Dank des Myelins Reize sehr schnell aufnehmen und verarbeiten, benötigt dabei wenig Platz und Energie. Wie aktiv

das Gehirn ist, verdeutlicht die Tatsache, dass es trotzdem noch etwa zwanzig

Prozent der Energie des Gesamtumsatzes für die Arbeit des Nervensystems

verwendet. Ist die Myelinproduktion gestört oder verlieren Nervenfasern ihre

Myelinschicht, kann dies schwerwiegende Folgen auf die Gesundheit haben, die

von Taubheitsgefühlen bis hin zu Lähmungserscheinungen und Erblindung reichen. Eine Krankheit, bei der die Myelinschicht abgebaut wird, ist die Multiple

Sklerose.

11

1. Die Nervenzelle

Molekulare Zusammensetzung Wie bereits erwähnt, ist Myelin eine Zellmembran. Membrane bestehen (unter anderem) aus Proteinen und Eiweißstoffen (Lipide), welche die Eigenschaft besitzen, Wasser und wasserlösliche Stoffe

abzustoßen. Im Vergleich mit der Membran von Leberzellen fällt auf, dass

beide gleichartige Moleküle, diese jedoch in unterschiedlichen Mengenverhältnissen besitzen (Abb. 1.8). Durch verschiedene Labormethoden kann man die

Abbildung 1.8: Mengenverhältnisse zwischen Proteinen und Lipiden bei Membranen

und Myelin

Lipide aus dem Myelin isolieren und untersuchen. Sie bestehen aus Cholesterin, Phospholipiden und Glycolipiden. Phospholipide enthalten alle ein Phosphoratom. Glycolipide sind fettartige Substanzen mit einem Zuckermolekül.

Einen prozentual großen Anteil der Lipide im Myelin nimmt ein Glycolipid

mit dem Namen Cerebrosid ein (Abb. 1.9). Sein Zuckermolekül ist die Galactose, die den wasserlösliche Teil des Cerebrosid ausmacht. Als Beispiel für ein

Molekül aus der Phospholipidgruppe des Myelins kann das Phosphatidylcholin

genannt werden. Wie das Cerebrosid enthält auch das Phosphatidylcholin ein

wasserlösliches Molekül.

Auch die Proteine von Myelin unterscheiden sich von denen anderer Membranen. Die meisten Membrane bestehen aus einer Vielzahl unterschiedlicher Proteine, von denen keines überwiegt. Myelin enthält weniger verschiedene Arten

von Proteinen. Von diesen bilden zwei Proteinarten einen Großteil. Die einen

sind die bereits erwähnten basischen Proteine, die anderen sind Lipoproteine.

Sie sind in die Außenseite der Myelinmembran eingebettet.

Der Einfluß der Ernährung auf die Bildung von Myelin Der Prozess

der Myelinisierung läuft parallel zur Entwicklung der Nervenfasern. Da die12

1.2. Das Myelin

Abbildung 1.9: a: Phosphatidcholin, b: Cerebrosid, c: Cholesterin. Die großen Kreise

indizieren die Moleküle, die wasserlöslich sind.

se Entwicklung hauptsächlich in den ersten drei Lebensmonaten abläuft, wird

dann auch der größte Teil des Myelins produziert. Einseitige oder unzureichende Ernährung in dieser Zeit kann dazu führen, dass nicht ausreichend Myelin

produziert wird. Versuche an Ratten haben gezeigt, dass das Gehirn von unterernährten Ratten im Vergleich zu denen von normal ernährten Ratten 40%

weniger Verknüpfungen von Nervenzellen ausgebildet hat. Da das Myelin zum

Teil aus Eiweißen besteht, ist eine eiweißhaltige Ernährung der Bildung von

Myelin zuträglich.

13

1. Die Nervenzelle

14

Kapitel 2

Erregung von Nervenfasern

Der menschliche Organismus ist in der Lage, eingehende Informationen an die

Zentren im Gehirn weiterzuleiten, die für die Verarbeitung dieser Informationen zuständig sind. Informationen haben im Nervensystem die Form von elektrischen Reizen. Diese wiederum entstehen durch die Veränderung des Spannungsunterschiedes, der zwischen dem Zellinneren eines Neurons und dem ihm

umgebenden Raum herrscht. Die folgenden Kapitel erklären, welche Bedingungen erfüllt sein müssen, damit ein Reiz von einem Neuron weitergeleitet

wird und welche elektrochemischen Veränderungen an der Zellmembran der

Neuronen ablaufen.

2.1

Das Ruhepotential

Erkenntnisse über elektrische Vorgänge innerhalb von Nervenzellen lassen sich

durch Messungen gewinnen, die man an ihnen vornimmt. Derzeitige Messmethoden sind soweit fortgeschritten, dass sie Untersuchungen an Nervenfasern

gewöhnlicher Größe zulassen.

Zur Untersuchung werden zwei Messelektroden benötigt (Abb. 2.1). Die eine

Elektrode (M1 ) besteht aus einem dünnen Glasröhrchen, das mit einer leitenden Flüssigkeit, einem Elektrolyt, gefüllt ist. Die andere Elektrode ist ein

Metallplättchen (M2 ). Zu Beginn der Untersuchung liegen beide Elektroden

im extracellulärem Raum. Der Spannungsmesser (in der Abbildung mit Oszilloskop bezeichnet), der beide Elektroden miteinander verbindet, zeigt keine

Spannungsdifferenz an. Man nennt dies extracelluläres Potential. Elektrische

Spannung wird in Volt, in diesem Fall in Millivolt (mV), gemessen. Das extracelluläre Potential beträgt also 0 mV. Sticht man mit der Glaskapillare in

einen Neuriten, zeigt der Spannungsmesser eine negative Differenz an (in der

15

2. Erregung von Nervenfasern

Abbildung 2.1: Messung des Ruhepotentials

Abbildung durch einen Pfeil gekennzeichnet). Je nach Zelltyp kann sie zwischen -60 mV und -110 mV liegen. Diese Spannungsdifferenz zwischen dem

Intracellulärraum einer unerregten Nervenzelle und ihrem Extracellulärraum

wird als Ruhepotential bezeichnet.

Ursache des Zustandekommens des Ruhepotentials Da bei der Messung des Ruhepotentials eine negative Spannungsdifferenz angezeigt wird, muss

im Intracellulärraum ein Überschuss an negativer Ladung gegenüber dem Extracellulärraum bestehen. In wässrigen Lösungen zerfallen Moleküle in Ionen,

das sind negativ, bzw. positiv geladene Teilmoleküle. Sowohl der Intra- als auch

der Extracellulärraum ist mit einer wässrigen Salzlösung angefüllt. Innerhalb

eines Neuriten ist keine Spannungsdifferenz messbar, d.h. es gibt genauso viele

negativ geladene Ionen, genannt Anionen, wie positiv geladene, Kationen genannt. Gleiches gilt für den Extracellulärraum, da sein Potential ebenfalls 0

mV beträgt.

Der Grund für die Entstehung einer Spannungsdifferenz zwischen beiden Räumen liegt in der Durchlässigkeit (Permeabilität) der Membran, die beide voneinander trennt. Diese Membran ist selektiv durchlässig. Das bedeutet, dass verschiedene Ionen unterschiedlich gut durch die Membran diffundieren können.

Untersuchungen an der Zellmembran von Neuriten haben gezeigt, dass sie für

Kalium (K+ )-Ionen, die sowohl im Intra- als auch im Extracellulärraum vorkommen, besonders gut durchlässig ist. Für weitere Ionen, die sowohl im Zellinneren wie auch im Zelläußeren auftreten, ist die Membran weniger permeabel.

In Bezug auf die Durchlässigkeit von K+ -Ionen beträgt die Durchlässigkeit

von Chlorid (Cl− )-Ionen etwa 45% und für Natrium (Na+ )-Ionen sogar nur

4%. K+ -Ionen treten im Zellinneren in sehr viel höherer Konzentration als im

Zelläußeren auf (Abb. 2.2), weshalb die Wahrscheinlichkeit, dass sie vom Intracellulärraum in den Extracellulärraum durch die Membran diffundieren höher

16

2.1. Das Ruhepotential

ist, als auf umgekehrtem Wege. Man spricht hier vom osmotischen Druck,

der die Ionen zur Diffusion bewegt. Dieser Diffusionsprozess könnte jetzt so

lange ablaufen, bis sowohl im Zellinneren als auch im Zelläußeren die gleiche

K+ -Ionenkonzentration erreicht ist. Das ist jedoch nicht der Fall. Dafür verantwortlich ist die positive Ladung von K+ -Ionen. Wie bereits erwähnt, herrscht

im Zellinneren eine hohe K+ -Ionenkonzentration. Dem gegenüber steht eine nahezu genauso hohe Konzentration von negativ geladenen Eiweißanionen (A− ),

die das Spannungsgleichgewicht im Zellinneren entstehen lässt.

Durch ihre gegensätzliche Ladung ziehen sich beide Ionen einander an (elektrostatische Kraft).

Diffundiert nun ein K+ -Ion durch

die Zellmembran, wird es vom

Eiweißanion, das nicht durch die

Membran dringen kann, vom Zellinneren aus festgehalten. Da das

Eiweißanion ’größer’ als das K+ Ion ist, macht es die Membran Abbildung 2.2: Prozentuale Ionenverteilung im

an der Stelle undurchlässig für Intra- und Extracellulärraum

weitere Kaliumionen. Das Ruhepotential entsteht daher an der Zellmembran. Es bestehen also zwei Kräfte,

die gegeneinander wirken: die elektrostatische Kraft und der osmotische Druck.

Die Diffusion durch die Membran dauert solange an, bis sich ein Gleichgewicht

zwischen diesen Kräften eingestellt hat. Dadurch erreicht das Membranpotential einen konstanten Wert. Dieses Gleichgewichtspotential lässt sich mit Hilfe

der Nernstschen Gleichung errechnen.

Errechnen des Ruhepotentials mit der Nernstschen Gleichung Die

allgemeine Form der Nernstschen Gleichung lautet:

Eion =

R∗T

Ca

∗ ln( )

z∗F

Ci

Dabei stellen die Variablen folgende Werte dar:

Eion

R

T

z

=

=

=

=

das Gleichgewichtspotential [mV]

die Gaskonstante (8,3143 J K−1 mol−1 )

absolute Temperatur (293 K, das entspricht 20°C)

die Valenz (Ladung) des Ions1

17

2. Erregung von Nervenfasern

F = die Farady-Konstante (96.487 C mol−1 )

Ca = die Konzentration des Ions außerhalb

der Zelle [mmol l−1 ]

Ci = die Konzentration des Ions innerhalb

der Zelle [mmol l−1 ]

Die Konstanten und die Temperatur lassen sich für die Berechnung des Kaliumgleichgewichtspotentials zu einem Wert zusammenfassen2 .

EK +

Ka+

= 25mV ∗ ln( + )

Ki

Mit den Werten für die Kaliumkonzentration im Intracellulärraum (410 mmol

l−1 ) und Extracellulärraum (10 mmol l−1 ), lässt sich dann der Wert berechnen3 .

EK + = 25mV ∗ ln(0, 024)

EK + = 25mV ∗ (−)3, 7

EK + = −92, 5mV

Vergleicht man das Ergebnis mit dem in der Abbildung 2.1 gemessenen Wert,

erkennt man, dass der errechnete Wert kleiner ist. Das liegt daran, dass Kalium

nicht alleine zum Ruhepotential beiträgt. Um zu einem identischen Ergebnis

zu gelangen, müssen weitere Werte in die Gleichung aufgenommen werden.

Dazu gehören die Konzentrationen von Na+ und Cl− und die für diese Ionen

entsprechende Durchlässigkeit (g) der Membran.

−

Ka+ + gN a ∗ N a+

a + gCl ∗ Cli

E = 25mV ∗ ln( +

)

−

Ki + g N a ∗ N a +

i + gCl ∗ Cla

Die Konzentrationen von Cl− sind deshalb vertauscht eingesetzt, weil sie im

Gegensatz zu K+ und Na+ negativ geladen sind.

Dabei ist:

N a+

a

N a+

i

= 460 mmol dm−3

= 50 mmol dm−3

J

Dabei gelten folgende Umformungsregeln: V = C

und 1 V = 1.000 mV

3

bei Werten, die kleiner als 1 sind, ergeben sich unter Anwendung des natürlichen Logarithmus’ negative Werte.

2

18

2.2. Das Aktionspotential

gN a

Cla−

Cli−

gCl

=

=

=

=

0,04

540 mmol dm−3

60 mmol dm−3

0,45

Diese Werte in obige Gleichung eingesetzt ergibt:

E = −62mV

Dieser Wert stimmt mit dem gemessenen Wert überein.

2.2

Das Aktionspotential

Wird eine unerregte Nervenzelle durch einen Reiz erregt, ändert sich ihr Ladungszustand. Für einen kurzen Zeitraum wechselt ihre Ladung vom Negativen

zum Positiven und kehrt anschließend wieder zu ihrem ursprünglichen Zustand

zurück. Diese kurzfristige Veränderung wird Aktionspotential genannt, man

sagt auch: ein Neuron feuert.

Eine Voraussetzung für die Entstehung des Aktionspotentials ist das Ruhe-

Abbildung 2.3: Spannungskurve des Aktionspotentials

potential. Wird eine Nervenzelle erregt, wird die in ihrem Inneren bestehende

negative Ladung abgebaut. In der Abbildung 2.3 ist dies durch den Anstieg der

Spannungskurve erkennbar. Diese Phase des Aktionspotentials wird als Aufstrich bezeichnet. Da die Zelle beim Aufstrich ihre negative Ladung verliert,

nennt man den Aufstrich auch Depolarisationsphase. Das Potential erreicht in

19

2. Erregung von Nervenfasern

dieser Phase positive Werte. Der Anteil, den die positiven Werte beim Aktionspotential ausmachen, wird als Überschuss bezeichnet. Langsamer als die Depolarisation verläuft die Repolarisation - die Phase, in der die negative Ladung

im Zellinneren wieder aufgebaut wird. Nähert sich die Ladung wieder ihrem

ursprünglichen Zustand, verlangsamt sich die Repolarisation weiter. Am Ende

dieser Phase können Nachpotentiale entstehen. Unterschreitet das Potential

nach der Repolarisation den Wert des Ruhepotentials, spricht man vom hyperpolarisierndenem Nachpotential. Bleibt das Potential noch eine kurze Zeit

oberhalb des Ruhepotentials, bevor es dieses erreicht, spricht man vom depolarisierendem Nachpotential. Die Zeitspanne, in der die Spannung während des

Aktionspotentials von der des Ruhepotentials abweicht, wird Refraktärphase

genannt. Die Dauer der Refraktärzeit ist von Zelle zu Zelle unterschiedlich. Bei

Nervenzellen dauert sie nur etwa eine Millisekunde. Der Herzmuskel benötigt

das 200-fache dieser Zeit, um seinen ursprünglichen Ladungswert wieder hergestellt zu haben. Das Aktionspotential kann durch einen Reiz ausgelöst werden. Dabei ist die Stärke des Reizes für die Auslösung entscheidend (Abb.

2.4). Wird der Ladungszustand des Intracellulärraums eines Neurons bis zu

Abbildung 2.4: Auslösebedingungen für das Aktionspotential

einem gewissen Wert verändert, wird das Aktionspotential nicht ausgelöst.

Wird dieser Wert, der als Schwellenwert bezeichnet wird, überschritten, wird

es ausgelöst und läuft dann unabhängig von der Höhe des den Schwellenwert

überschreitenden Wertes ab. Diese Tatsache wird als Alles-oder-Nichts“-Regel

”

20

2.2. Das Aktionspotential

des Aktionspotentials bezeichnet. Ist das Aktionspotential einmal ausgelöst

worden, befindet sich die Zelle in einem unerregbaren Zustand. Während der

Refraktärzeit eintreffende Reize werden nicht verarbeitet.

Ursachen der Spannungsveränderung. Wird ein Neuron über seinen

Schwellwert hinaus gereizt, verändern sich die Eigenschaften seiner Membran.

Wie auch beim Ruhepotential sind Verschiebungen von Ionen an der Membran für eine Veränderung des Spannungsunterschiedes verantwortlich. Bei

einer unerregten Nervenzelle ist die Membran durchlässig für Kalium- und

Natriumionen. Durch eine Kalium-Natrium-Pumpe, die Natrium aus dem Intracellulärraum durch die Membran in den Extracellulärraum zurück leitet,

fällt die positive Ladung von Natrium bei der Berechnung des Ruhepotentials jedoch nicht ins Gewicht. Wird das Neuron erregt, erhöht sich sprunghaft

ihre Leitfähigkeit für Natriumionen (Abb. 2.5). Außerhalb der Zelle herrscht

eine sehr viel höhere Natriumkonzentration als innerhalb der Zelle, so dass ein

Konzentrationsgefälle vorliegt, das Natriumionen veranlasst, die Membran von

Aussen nach Innen zu durchdringen (osmotischer Druck).

Während der Erregung übertrifft die Leitfähigkeit für Natriumionen die für

Abbildung 2.5: Membranleitfähigkeit während des Aktionspotentials. Oben Zeitverlauf

eines Aktionspotentials, darunter Zeitverlauf der Membranleitfähigkeit von Natriumionen (gN a ) und Kaliumionen (gK ) während des Aktionspotentials

Kaliumionen. Durch das Eindringen von Natriumionen erhöht sich die positive

Ladung im Zellinneren und der negative Spannungsunterschied zwischen Intraund Extracellulärraum wird kompensiert.

Währenddessen steigt die Kaliumleitfähigkeit der Membran weiter an, bis

sie mehr als das Hundertfache ihres ursprünglichen Wertes erreicht hat. Die

Natriumionen würden jetzt solange in die Zelle einströmen, bis sich der osmotische Druck abgebaut haben würde. Wäre das der Fall, müsste der höchste

gemessene Spannungswert bei etwa +60 mV liegen. In der Abbildung 2.3 sieht

21

2. Erregung von Nervenfasern

man jedoch, dass der Wendepunkt der Spannungskurve bei +30 mV liegt. Das

hat zwei Gründe:

• Die Natriumionen-Leitfähigkeit der Membran hält nicht lange genug an,

um so viele Natriumionen durchzulassen, bis ein Spitzenwert von +60

mV erreicht werden kann.

• Neben der Erhöhung der Leitfähigkeit von Natriumionen wird auch die

Leitfähigkeit von Kaliumionen mit einer Verzögerung von etwa 1 ms

verstärkt. Somit wird die positive Ladung im Zellinneren wieder abgebaut.

Ist also die Spitze der Spannungskurve erreicht, werden die Poren, die Natriumionen in die Zelle lassen, wieder geschlossen und die Poren, die Kaliumionen,

die für die Entstehung des Ruhepotentials verantwortlich sind, durchlassen,

erhöhen ihre Aktivität, sodass die Spannungskurve wieder sinkt.

Der Ladungsausgleich ist am Ende dieses Prozesses im Intra- und Extracellulärraum wieder hergestellt. Die Mengenverhältnisse von Natrium- und Kaliumionen haben sich jedoch sowohl außerhalb als auch innerhalb der Zelle verändert. Um dieser Veränderung entgegenzuwirken und die ursprünglichen Mengenverhältnisse wieder herzustellen, erhöhen die bereits erwähnten

Natrium-Kalium-Pumpen ihre Tätigkeit und transportieren Natriumionen aus

dem Zellinneren ins Zelläußere und Kaliumionen aus dem Zelläußeren ins Zellinnere. Damit ist das Ruhepotential wieder hergestellt.

In der Abbildung 2.6 sind die Vorgänge in der Membran während des Aktionspotentials schematisch dargestellt. Jedes einzelne Teilbild zeigt dabei den

Zustand der Poren, die Natriumionen durchlassen (eckig dargestellt) und denen, die Kaliumionen durchlassen (rund dargestellt). Diese Abbildung vernachlässigt aus Gründen des besseren Verständnisses die Tatsache, dass die

Kaliumionen durchlassenden Poren auch schon während des Ruhepotentials

geöffnet sind.

Die Menge der Ionen, die die Membran während des Aktionspotentials durchdringen, ist im Verhältnis zu denen, die die Zelle umgeben, relativ klein. Das

bedeutet auch, dass die Menge der Natriumionen, die während des Aktionspotentials in die Zelle eindringt, nur einen Bruchteil der Menge der Natriumionen

ausmacht, die die Zelle umschließt. Schaltet man die für den Rücktransport

der Natriumionen aus dem Extra- in den Intracellulärraum verantwortliche

Natrium-Kalium-Pumpe aus, können noch Tausende von Aktionspotentialen

ablaufen, ehe der Natriumgehalt außerhalb der Zelle so hoch geworden ist, dass

22

2.2. Das Aktionspotential

Abbildung 2.6: Vorgänge in der Membran während des AP

die Zelle unerregbar wird. Der Einfluss der Natriumkonzentration im Extracellulärraum auf das Ruhepotential ist nahezu unerheblich. Das Ruhepotential

würde unter einer solchen Bedingung um etwa 10 mV geringer werden. Der

Einfluss auf das Aktionspotential ist jedoch um ein Vielfaches größer. Das Aktionspotential entfaltet sich nicht mehr in seiner gewohnten Größe. Das heißt,

dass der Überschuss abnimmt und sich der Aufstrich verlangsamt. Die Unerregbarkeit der Neuronen ist dann erreicht, wenn der Natriumgehalt im Extracellulärraum auf ein Zehntel seiner Ursprünglichen Konzentration absinkt.

Beschleunigen kann man diesen negativen Effekt, indem man die Natriumkonzentration im Innern des Neurons erhöht. Da das Konzentrationsgefälle

zwischen Intra- und Extracellulärraum nicht mehr so stark ist, ist auch der osmotische Druck schwächer. Die Geschwindigkeit der in die Zelle einströmenden

Natriumionen verringert sich und die Zelle wird nicht mehr in gleicher Höhe

depolarisiert.

Funktionsweise der Natrium-Kalium-Pumpe. Im Intracellulärraum befindet sich ein Trägermolekül (in der Abbildung 2.7 mit A’ bezeichnet), das

die Eigenschaft besitzt, sich mit Natriumionen verbinden zu können. Die Ionenpumpe kann diese Verbindung in den Extracellulärraum leiten. Dort löst

sich diese Verbindung wieder. Ein Enzym verändert das Trägermolekül so,

23

2. Erregung von Nervenfasern

dass es nun Natriumionen binden kann (in den Abbildung mit A’ bezeichnet).

Diese neue Verbindung diffundiert nun durch die Membran ins Zellinnere und

zerfällt dort wieder. Das veränderte Trägermolekül wird nun wieder durch ein

Enzym in seinen ursprünglichen Zustand zurück verwandelt, so dass es wieder Natriumionen binden kann. Bei diesem Umwandlungsprozess wird Energie

benötigt, die aus dem Abspalten eines Phosphatteils von ATP gewonnen wird.

Dabei wird ADP4 gebildet. Für jedes Natriumion, das die Membran nach außen

passiert, wird ein Kaliumion in den Intracellulärraum geleitet.

Abbildung 2.7: Mechanismus der Ionenpumpe

2.3

Die Reizfortpflanzung

Werden an mehreren Stellen eines Axons Messpunkte angebracht und an einem

Ende des Axons durch einen elektrischer Reiz, der den Schwellwert übersteigt,

das Aktionspotential ausgelöst, so tritt das Aktionspotential an dem Messpunkt auf, der dem Reizpunkt am nächsten liegt, dann an dem zweitnächsten,

usw. Daran erkennt man, dass sich ein Reiz entlang eines Axons fortpflanzt.

Mithilfe der Meßstationen lässt sich auch die Geschwindigkeit5 der Reizübertragung ermitteln. Sie ist abhängig von den Eigenschaften des Neurons und

kann zwischen 1 m/s und mehr als 100 m/s liegen. Das Aktionspotential ist

an allen gemessenen Stellen gleichgroß. Das zeigt, dass ein Neuron den Strom

nicht einfach nur leitet (elektrotonische Ausbreitung), denn dann würde der an

4

5

24

Adenosindiphosphat

Geschwindigkeit = Weg / Zeit

2.3. Die Reizfortpflanzung

den Messpunkten gemessene Wert abnehmen. Bei der Reizfortpflanzung wirken elektrotonische Ausbreitung und Erregung zusammen. Wird die Zellmembran an einer Stelle zur Auslösung des Aktionspotentials gereizt, fließt Strom

in benachbarte Membranbereiche und depolarisiert diese. Das dort entstehende elektrotonische Potential überschreitet den Schwellwert und löst dabei das

selbstständig ablaufende Aktionspotential aus. Von dieser Stelle aus werden

wieder die Nachbarbereiche depolarisiert. Da sich die Stelle, von der aus der

Reiz ursprünglich ausging aber noch in der Refraktärphase befindet, also unerregbar ist, pflanzt sich der Reiz nur in eine Richtung, von der Reizquelle weg,

fort. Diese Reizströme bewegen sich ringförmig von der Reizquelle weg und

werden deshalb auch Kreisströmchen genannt.

Die Leitungsgeschwindigkeit hängt von verschiedenen Faktoren ab. Einer dieser

Faktoren ist der Faserdurchmesser. Der Widerstand der Faser, die den elektrotonischen Strom abbremst, fällt mit dem Quadrat des inneren Faserdurchmessers. Durch einen geringeren Widerstand werden benachbarte Membranbereiche schneller depolarisiert und das Aktionspotential kann früher ausgeführt

werden.

Ebenfalls Einfluss auf die Leitungsgeschwindigkeit nimmt die Höhe des NatriumEinstroms in die Zelle. In der Depolarisationsphase schießen Natriumionen in

den Intracellulärraum und depolarisieren dabei die Zellmembran. Der dabei

entstehende elektrotonische Strom fließt in die Nachbarbezirke und depolarisiert die Membran an dieser Stelle. Ist der Natriumionenstrom geringer, z.B.

bei einem erniedrigten (weniger negativen) Ruhepotential, kann auch weniger

elektrotonischer Strom in die benachbarten Bereiche fließen, um diese zu depolarisieren. Daher steigt die Leitungsgeschwindigkeit mit der Amplitude des

Natriumionen-Einstroms in die Zelle.

Einen weiteren Faktor stellt das Vorhandensein einer Myelinschicht dar. An

den Internioden, das sind die Stellen des Axons, die von einem Myelinmantel

umhüllt sind, kann sich kein Aktionspotential bilden, da die Membran nicht

mit dem Extracellulärraum in Berührung kommt (Abb. 2.8). Das bedeutet,

dass an diesen Stellen nur der elektrotonische Strom den Reiz leitet. Der elektrotonische Strom ist abhängig von Membrankapazität und -widerstand. Geringere Kapazität und höherer Membranwiderstand wirken sich positiv auf die

elektrotonische Leitfähigkeit aus. Die Myelinschicht erzeugt genau diese Bedingungen an der Membranoberfläche: Der Widerstand erhöht sich und die

Kapazität sinkt. In den Internioden wird also die Stärke eines elektrischen

Reizes nur sehr wenig verringert und schnell weitergeleitet. Eine Verzögerung

tritt erst wieder ein, wenn das Signal einen Ranvierschen Schnürring erreicht,

25

2. Erregung von Nervenfasern

an dem Membrankapazität und -widerstand wieder ihren normalen Wert haben. An diesen myelinlosen Stellen steigt das elektrotonische Potential an und

löst ein Aktionspotential aus. Bei myelinisierten Nervenfasern springt also das

Aktionspotential von Schnürring zu Schnürring. Die Erregungsleitung wird

deshalb dort saltatorisch genannt6 . Da das Aktionspotential immer in voller

Höhe ausgeführt wird (Alles-oder-Nichts-Regel), entstehen keine Signalverluste. Verluste, die auf dem Weg zu einem Schnürring auftreten können, werden

durch die volle Auslösung des Aktionspotentials also wieder ausgeglichen.

Myelinisierte Nervenfasern benötigen auch weniger Energie als unmyelinisierte. Das liegt daran, dass die energieverbrauchende Natrium-Kalium-Pumpe nur

an den Ranvierschen Schnürringen, jedoch nicht an den Internioden arbeiten

muss.

Abbildung 2.8: Erregungsfortleitung am myelinisierten Axon. R 1 ist eine Reizelektrode, R2 die dazugehörige Bezugselektrode. An den Meßpunkten a und d wird ein

Aktionspotential ausgebildet. An diesen Stellen ist ein Ranvierscher Schnürring, daher kommt die Zellmembran mit dem Extracellulärraum in Kontakt. Hier wird der

Reiz durch Erregung fortgepflanzt. An den Meßpunkten b und c ist das Axon durch

eine Myelinschicht vom Extracellulärraum getrennt. Hier kann sich kein Aktionspotential ausbilden. An diesen Stellen wird der Reiz durch elektrotonische Leitung

fortgepflanzt.

6

26

saltare lat. springen

Kapitel 3

Synaptische

Erregungsübertragung

Die Stellen, an denen Axone enden und mit anderen Zellen eine Verbindung

eingehen, werden Synapsen genannt. Früher nahm man an, dass es sich bei den

Synapsen um feste Verbindungen handelte, die das Aktionspotential auf die

nächste Zelle ohne Unterbrechung weiterleiteten. Als dann die Labortechniken

in ihrer Entwicklung fortschritten und die Synapsen mit einem Elektronenmikroskop untersucht werden konnten, stellte man fest, dass es zwar Synapsen

dieser Form, die heute elektronische Synapsen genannt werden, gibt, sie jedoch

nur sehr selten vorkommen. Sehr viel häufiger sind die chemischen Synapsen,

die sich wiederum in hemmende und erregende chemische Synapsen untergliedern lassen. Bei den chemischen Synapsen liegt zwischen den aneinander

liegenden Zellen ein schmaler Spalt, das heißt, die Membrane berühren einander nicht. Aufbau und Funktion der chemischen Synapsen, sowie die Methoden

mit denen Nervenzellen Informationen verarbeiten, sollen im Folgenden erklärt

werden.

3.1

Die Synapse

Synapsen können in großer Formenvielfalt vorkommen. In Abbildung 3.1 sieht

man verschiedene Arten von Verbindungen, nach denen die Synapsen wie folgt

benannt werden: axo-axonale Synapse (AAS), axo-dendritische Synapse (ADS)

und axo-somatische Synapse (ASS). Ihnen allen ist ihre Funktion gemein.

Aufbau einer chemischen Synapse. Das Axon endet in einer Verdickung,

dem Synapsenendknöpfchen. Da es den vorderen Teil der Synapse bildet, wird

27

3. Synaptische Erregungsübertragung

Abbildung 3.1: Synaptische Verbindungen zwischen verschiedenen Nervenzellen

es auch präsynaptische Endigung genannt (Abb. 3.2). Sie enthält eine Vielzahl von Mitochondrien und Vesikeln. Diese sind mit Transmittersubstanzen

gefüllt, die im Synapsenendknöpfchen synthetisiert werden. Die präsynaptische

Endigung ist durch einen Spalt, dem synaptischen Spalt, von der postsynaptischen Seite getrennt. Dieser Spalt ist zwischen 10 nm und 50 nm breit. Auf der

gegenüberliegenden Seite des synaptischen Spaltes, der postsynaptischen Seite, liegt die postsynaptische Membran. Sie wird auch subsynaptische Membran

genannt. Untersuchungen mit dem Elektronenmikroskop haben gezeigt, dass

dieser Membranteil dicker ist als die Membran, die nicht einem Synapsenendknöpfchen gegenüberliegt. Das deutet darauf hin, dass sie sich auch funktionell

voneinander unterschieden.

Funktion einer chemischen Synapse. Im Synapsenendknöpfchen werden

Neurotransmitter synthetisiert und in Vesikeln gespeichert, die sich an die

präsynaptische Membran legen. Ein an der Synapse ankommendes Aktionspotential veranlasst die Vesikelmembran mit der präsynaptischen Membran zu

verschmelzen. Dabei werden die in den Vesikeln gelagerten Neurotransmitter

in den synaptischen Spalt freigesetzt. Die Moleküle der freigesetzten Neurotransmitter binden sich an Rezeptormoleküle, die an den Ionenkanälen der

Empfängerzelle sitzen. Durch diese Bindung werden die Ionenkanäle veranlasst

sich zu öffnen. Dabei strömen Ionen in den Intracellulärraum der Empfängerzelle und verändern das Membranpotential an dieser Stelle. Hierbei unterscheiden sich erregende Synapsen von hemmenden:

28

3.1. Die Synapse

Abbildung 3.2: Schematische Darstellung einer längsgeschnittenen axo-dendritischen

Synapse

• Handelt es sich bei der Synapse um eine erregende Synapse, binden sich

die Moleküle ihrer Neurotransmitter an die Rezeptormoleküle von Natriumporen. Diese sind (da die Zelle unerregt ist) geschlossen. Durch die

Bindung öffnen sie sich und Natriumionen strömen in die Empfängerzelle. Dabei wird dieser Bereich der Membran depolarisiert. Liegt die

Depolarisation über dem Schwellwert, kann ein neues Aktionspotential

ausgebildet werden. Das an der postsynaptischen Membran gemessene

Potential wird als excitatorisches postsynaptisches Potential (EPSP) bezeichnet. Die Abbildung 3.3 zeigt die Ausbildung eines EPSP’s. Je nach

Neuronentyp kann die Amplitude ihre Größe verändern. In diesem Beispiel beträgt die Höhe der Depolarisation nur wenige Millivolt.

• Bei hemmenden Synapsen werden andere Transmitterstoffe ausgeschüttet,

die sich an Rezeptoren von Chlorid- und Kaliumionenporen binden. Diese

öffnen sich und Chloridionen treten in die Empfängerzelle ein, Kaliumionen treten aus. Dabei wird die intracelluläre Spannung negativer. Das bedeutet, dass sich der Spannungsunterschied zwischen Intracellulärraum

der Empfängerzelle und dem synaptischen Spalt erhöht. Das an der postsynaptischen Membran gemessene Potential wird als inhibitorisches postsynaptisches Potential (IPSP) bezeichnet (Abb. 3.4).

Durch die im Zellinneren steigende negative Ladung wird die Ausbildung

29

3. Synaptische Erregungsübertragung

eines neuen Aktionspotentials erschwert. Die Erregbarkeit des Neurons

wird also vermindert.

Nachdem sich die Ionenkanäle geöffnet haben, werden die Transmittermoleküle

von Enzymen aufgespalten und verlieren dadurch ihre Eigenschaft die Kanäle

offen zu halten. Die gespaltenen Moleküle werden von der präsynaptischen

Membran wieder aufgenommen und für die Synthese weiterer Transmittermoleküle verwendet. Werden keine neuen Transmittermoleküle gebildet, reicht der

im Synapsenendknöpfchen gespeicherte Vorrat noch für die Übertragung von

bis zu 5000 Impulsen ([Sch1974]).

Es gibt eine Vielzahl verschiedener Transmitterstoffe. Sie weisen häufig Aminosäurecharakteristika auf oder gehen aus einfachen chemischen Reaktionen

aus Aminosäuren hervor. Ein Transmitterstoff, der in erregenden Synapsen

synthetisiert wird, ist das Acetylcholin. Es wirkt im vegetativen Nervensystem

und bei der Übertragung von Nervenimpulsen auf Muskelzellen. Ein hemmender Transmitter ist das Glycin oder Gamma-Aminosäurebutter. Es konnte im

schlafenden Gehirn nachgewiesen werden.

Neuronen können nur Transmitter eines bestimmten Typs synthetisieren. Daher sind alle Synapsen eines Neurons entweder erregend oder hemmend. Man

spricht deshalb auch von erregenden oder hemmenden Neuronen.

Abbildung 3.3: Zeitlicher Verlauf

des EPSP

3.2

Abbildung 3.4: Zeitlicher Verlauf

des IPSP

Die Informationsverarbeitung

In den vorangehenden Kapiteln haben wir gesehen, dass ein Nervensignal

immer in voller Stärke übertragen wird (Alles-oder-Nichts-Regel). Für die

Übermittlung der Intensität eines Signals kann also die Höhe der Depolarisation während des Aktionspotentials nicht ausschlaggebend sein. Variieren

30

3.2. Die Informationsverarbeitung

kann jedoch der Zeitraum zwischen zwei Aktionspotentialen. Wird auf eine

Nervenfaser ein Reiz in konstanter Höhe ausgeübt, bildet sich in regelmäßigen Abständen ein Aktionspotential aus. Erhöht man die Stärke des Reizes,

verkürzen sich diese Abstände (Abb. 3.5). Die Stärke des Signals ist umgekehrt

proportional zu der Länge der Zwischenräume, die zwischen den Aktionspotentialen entstehen. Dieses Prinzip wird Frequenzmodulation genannt.

Durch Frequenzmodulation wird das Nervensystem vor Systemüberlastung und Informationsverfälschung geschützt. Während der Refraktärzeit kann kein neues Aktionspotential ausgebildet werden. Das bedeutet, dass die Impulsfrequenz einen Maximalwert nicht überschreiten kann.

Dadurch wird das Nervensystem gegen Überlastung gesichert.

Abbildung 3.5: Auswirkungen

von Reizstärke auf Aktionspotentialfrequenz

Die Nervenfasern besitzen einen für sie spezifischen Leitwiderstand. Wird durch ein myelinisiertes Axon ein elektrotonischer Reiz geleitet,

verliert er auf dem Weg durch das Axon an Stärke. Erreicht der Reiz einen

Ranvierschen Schnürring, kann er immer noch groß genug sein, um ein weiteres Aktionspotential auszulösen. Die Breite eines Schnürringes ist so breit,

dass die elektrotonische Reizstärke ausreicht, um die Zellmembran bis zum

Schwellenwert zu depolarisieren. Die Ranvierschen Schnürringe wirken also

wie Reizverstärker. Das Aktionspotential wird immer in gleicher Stärke ausgebildet, das bedeutet, dass durch die Reizverstärkung der Reiz weder erhöht,

noch erniedrigt wird, er wird lediglich erhalten. Arbeitet ein Schnürring nicht

einwandfrei, wird das Aktionspotential am ihm folgenden Schnürring ausgebildet, der Reiz geht also nicht verloren. Da für die Signalintensität die Frequenz

entscheidend ist und nicht die Höhe des Aktionspotentials, bietet hier die Frequenzmodulation einen Schutz gegen Informationsverfälschung.

Im Nervensystem können auf Neuronen eine Vielzahl von Synapsen unterschiedlicher anderer Neuronen wirken. Diese Impulse können zu unterschiedlichen Zeitpunkten und in unterschiedlicher Frequenz eintreffen. Wie bereits

erwähnt, enden Synapsen vorgeschalteter Neuronen entweder an der Somamembran oder an den Dendriten. An diesen Stellen können keine Aktionspotentiale ausgebildet werden. Die dort eingehenden Impulse verursachen eine

kurzzeitige Veränderung des Membranpotentials, das durch die Membran bis

zum Ansatzpunkt des Axons am Soma, dem Axonhügel, weitergeleitet wird.

Gleichzeitig eingehende Signale summieren einander auf. Das bedeutet, dass

31

3. Synaptische Erregungsübertragung

erregende Impulse das Membranpotential in positiver Richtung anheben und

hemmende dieses wieder senken. In der Abbildung 3.6 sieht man, wie sich ein

erregendes (A) und ein hemmendes Signal (B) gegenseitig aufheben.

Überschreitet das am Axonhügel eingehende Signal den Schwellenwert, wird an dieser Stelle das Aktionspotential ausgelöst,

das dann durch das Axon bis an sein Ende weiterläuft und an den Synapsen endet.

Diese Art der Erregungsauslösung nennt

man räumliche Summation, da sie durch

Abbildung 3.6: Zusammenwirken die gleichzeitige Aktivität mehrerer räumvon hemmender und erregender lich voneinander getrennten Synapsen bewirkt wird.

Synapse zur gleichen Zeit

Eine ähnliche Erregungsauslösung wird zeitliche Summation genannt. Bei ihr

wirkt nur eine Synapse auf das Neuron, die in hoher Frequenz Signale sendet.

Die Spannung, die auf das Soma wirkt, klingt nur langsam ab, weshalb sich

mehrere kurz aufeinander folgende Signale addieren (Abb. 3.7).

Bei allen Erregungsarten ist der Schwellenwert ausschlaggebend für die Weiter-

Abbildung 3.7: Zeitliche Summation der postsynaptischen Potentiale. Oberer Graph:

Messung an der präsynaptischen Membran. Unterer Graph: Messung an der postsynaptischen Membran

leitung eines Signals. Die Membrandepolarisation baut sich über einen längeren Zeitraum ab als die Refraktärzeit lang ist. Liegt die Depolarisation der

Membran nach einem Aktionspotential oberhalb des Schwellenwertes, werden

weitere Aktionspotentiale ausgelöst, bis die Depolarisation den Schwellenwert

unterschritten hat (Abb. 3.10).

Kommen zwei erregende Reize zeitlich versetzt an einem Neuron an, hängt es

vom Schwellenwert ab, wie diese Signale verarbeitet werden und welche Form

32

3.2. Die Informationsverarbeitung

das Signal annimmt, das das Neuron wieder verlässt (Abb. 3.8 und 3.9).

Abbildung 3.8: Räumliche Summation mit niedrigem Schwellenwert

Abbildung 3.9: Räumliche Summation mit hohem Schwellenwert

Abbildung 3.10: Weiterleitung

von Aktionspotentialen

33

3. Synaptische Erregungsübertragung

34

Kapitel 4

Visuelle Wahrnehmung

In den vorangegangenen Kapiteln ist gezeigt worden, wie Neuronen arbeiten

und wie Reize weitergeleitet und verarbeitet werden. Einen Großteil der Reize,

die das Gehirn verarbeitet, sind visuelle Reize mit denen die Umwelt wahrgenommen wird. Die über das Auge aufgenommenen Informationen gelangen

in das Gehirn. Doch wie werden diese Informationen dort gespeichert? Wie

kommt es, dass wir uns Dinge für eine kurze Zeit merken können und uns

anschließend nicht mehr an sie erinnern? Auf der anderen Seite bleiben bestimmte Ereignisse, die uns unwichtig erscheinen, im Gedächtnis verankert.

Wie kommt es dazu? Und wie lässt sich das Phänomen erklären, dass Menschen, die einen elektrischen Schock erleiden, deren elektrischen Reize im Gehirn also überlastet und durcheinander gebracht werden, anschließend nicht

unter vollkommener Amnesie1 leiden?

Die Antworten zu diesen Fragen haben gemein, dass sie mit dem Gedächtnis zu tun haben. Das Gedächtnis lässt sich in drei Speicherphasen aufteilen:

dem Ultrakurzzeit-Gedächtnis, dem Kurzzeit-Gedächtnis und dem Langzeitgedächtnis. Wie diese Speicherstufen im einzelnen funktionieren und wie sie

zusammenhängen, soll in den folgenden Kapiteln erklärt werden. Desweiteren

soll der Weg, den visuelle Informationen im Gehirn nehmen, nachgezeichnet

werden.

4.1

Ultrakurzzeit-Gedächtnis

Auf das Gehirn strömen innerhalb einer kurzen Zeit eine große Menge an

Sinneseindrücken und die mit ihnen verbundenen Informationen ein. Diese

1

Gedächtnisverlust

35

4. Visuelle Wahrnehmung

Informationen, die im Ultrakurzzeit-Gedächtnis eingehen, klingen nach einer

kurzen Zeit von etwa zwanzig Sekunden wieder ab, sodass sie nicht mehr abrufbar sind. Ein Beispiel aus dem Sport kann dies verdeutlichen: Während

eines Fussballspiels wird einer der Spieler gefoult. Der Spieler liegt am Boden

und man kümmert sich um eventuelle Verletzungen. Anschließend wird der

Spieler gefragt, wie dieses Foul zustande gekommen sei, doch er kann sich an

den Vorfall nicht mehr erinnern (diese Form des Vergessens wird retrograde

Amnesie genannt). Wird der Spieler jedoch noch innerhalb der ersten zwanzig Sekunden nach dem Foul befragt, kann er den Hergang genau schildern,

auch später wird er sich noch daran erinnern können. Zu diesem Zeitpunkt

sind die Informationen noch nicht aus dem Ultrakurzzeit-Gedächtnis gelöscht

worden. Dadurch, dass sie innerhalb der ersten zwanzig Sekunden, nachdem

sie ins UKZ-Gedächtnis aufgenommen wurden, abgerufen werden, können sie

in die nächsthöhere Speicherstufe gelangen. Es gibt mehrere Störfaktoren, die

dies verhindern können: mangelndes Interesse, fehlende Assoziation, Reizüberflutung oder störende Zusatzwahrnehmungen, wie zum Beispiel Schmerz.

Diese Form des Überganges von einer Speicherstufe zur nächsten kann man als

Filter sehen, der für das Gehirn uninteressante oder unwichtige Informationen

herausfiltert, um es vor Überlastung zu schützen.

Die von den Sinnesorganen an das Gehirn übergebenen Impulse sind elektrisch.

Ein Hinweis darauf liefert ein Experiment, das an Ratten vorgenommen wurde. Ratten lernen leicht, einer Gefahrquelle auszuweichen. Durch eine leichte

Gehirnreizung lässt sich diese Erinnerung an das Erlernte wieder aus dem

Gedächtnis löschen. Wartet man mit der Gehirnreizung länger als zwanzig Sekunden, nachdem die Ratte gelernt hat, ist eine Löschung des Erlernten mit

gleicher Reizstärke nicht mehr möglich, da es bereits die nächste Speicherstufe

erreicht hat.

4.2

Kurzzeit-Gedächtnis

Das Kurzzeit-Gedächtnis unterscheidet sich nur unwesentlich vom UltrakurzzeitGedächtnis. Die Zeit, die die Informationen in dieser Speicherphase verweilen,

ist jedoch länger. Sie beträgt etwa zwanzig Minuten. Man könnte hier von

einer Nachfilterung sprechen. Auch hier lassen sich die Informationen mittels

einer Gehirnreizung löschen, nur muss dieser Reiz sehr viel stärker sein als

der, der Informationen aus dem Ultrakurzzeit-Gedächtnis löscht. Ein Beispiel,

bei dem dies geschieht, ist ein Autounfall. Ein Autofahrer verlässt morgens

seine Wohnung, um mit dem Auto zur Arbeit zu fahren. Auf dem Weg zur

36

4.3. Langzeit-Gedächtnis

Arbeit gerät sein Auto von der Fahrbahn ab und prallt gegen einen Baum.

Unfallwagen und Polizei treffen an der Unfallstelle ein. Die Polizisten befragen

den Autofahrer, der unter Schock steht, wie es dazu gekommen ist, dass der

Wagen von der Fahrbahn abgekommen sei, doch der Fahrer kann sich nicht

mehr daran erinnern. Er weiß lediglich, wie er morgens das Haus verlassen

hat, aber alles was darauf folgte hat er vergessen. Der Schock, den er bei dem

Unfall erlitten hat, ist so groß, dass er nicht nur die Informationen, die im

Ultrakurzzeit-Gedächtnis gespeichert waren, gelöscht hat, sondern auch die,

die sich Kurzzeit-Gedächtnis befanden. Polizeiberichten zufolge geschieht das

häufig bei größeren Unfällen oder wenn es bei Unfällen zu Personenschäden

gekommen ist ([Ves1975]).

Auch im bereits erwähnten Rattenversuch kann dies simuliert werden. Wartet

man mit der Gehirnreizung länger als eine halbe Minute, kann das Erlernte

nicht mehr gelöscht werden. Versetzt man der Ratte jedoch noch vor Ablauf

von zwanzig Minuten einen elektrischen Schock, ist des Erlernte vergessen.

4.3

Langzeit-Gedächtnis

Das Langzeit-Gedächtnis ist die Gedächtnisstufe, die dem Kurzzeit-Gedächtnis

folgt. Bis in die fünfziger Jahre des letzten Jahrhunderts hinein nahm man an,

dass das Gedächtnis nur durch elektrische Impulse gespeichert wird. Untersuchungen mit dem Elektroenzephalogramm (EEG) schienen diese Vermutung

zu bestätigen. In einem gewissen Grade ist dies auch richtig, da alle eingehenden Informationen auf diese Weise aufgenommen werden. Die Langzeitspeicherung hebt sich jedoch von der (Ultra-)Kurzzeit-Speicherung deutlich ab.

Immer mehr Experimente zeigen deutlich, dass die Speicherung nicht mehr

ausschließlich über elektrische Impulse verläuft, sondern stofflicher Natur ist.

Der Versuch, das Langzeit-Gedächtnis von Ratten mittels Stromschlag zu löschen, schlug fehl. Griff man in ihren Stoffwechsel ein und stoppte durch Verabreichung bestimmter chemischen Stoffe die Protein-Synthese, konnte das von den

Ratten Erlernte nicht länger als eine Stunde gespeichert werden. Die (Ultra)Kurzzeit-Erinnerung wurde durch diesen Eingriff nicht vermindert. Dieses

Experiment lässt vermuten, dass die Lanzeitspeicherung andersartig ablaufen

muss. In der Gen-Forschung wurden viele Entdeckungen gemacht, die Aufschluss über diese Speicherart geben können.

In den Zellkernen aller in unserem Körper befindlichen Zellen mit Zellkern,

37

4. Visuelle Wahrnehmung

also auch in denen der Neuronen, befinden sich Doppelspiralen aus DNA2 , die

die Erbinformationen der Zelle speichert - die Gene. Da die Reproduktion von

DNA einen wichtigen Punkt bei der Speicherung von Informationen darstellt,

soll dieser Vorgang näher beleuchtet werden.

Ein in den Zellen vorhandener Grundstoff ist die Nucleinsäure. Nucleinsäure

setzt sich aus drei verschiedenen Verbindungsklassen zusammen: Zucker, organische Stickstoffbasen und Phosphorsäure. Die DNA besteht aus Nucleinsäure.

Es gibt vier verschiedene Stickstoffbasen, die eine DNA enthalten kann. Diese

sind Cytosin (C), Thymin (T), Guanin (G) und Adenin (A). Eine Einheit, die

durch ein Zucker-Molekül, einer der Stickstoffbasen und einem PhosphorsäureMolekül gebildet wird, wird Nucleotide genannt. Das Phosphorsäure-Molekül

eines Nucleotids kann sich an ein Zucker-Molekül eines anderen Nucleotids binden. Dadurch bildet sich eine DNA-Kette. C,T,G und A können ebenfalls Verbindungen eingehen, sogenannte Basenpaare, wobei sich das A eines Nucleotids

nur an ein T eines anderen Nucleotids binden kann. Äquivalent verhält es sich

mit C und G. Durch die Basenpaarbildung liegt dem DNA-Strang ein weiterer

DNA-Strang gegenüber, man nennt ihn DNA-Doppelstrang. Durch die Struktur seiner Moleküle ist er spiralförmig gewunden.

Die RNA3 ist ebenfalls eine Nucleinsäure. Im Unterschied zur DNA hat sie ein

Abbildung 4.1: Modell der DNA

anderes Zucker-Molekül und sie hat anstelle des T die Base Uracil (U), die sich

aber wie T an A binden kann. RNA tritt (mit Ausnahme einiger Viren-RNA’s)

2

3

38

Desoxyribonukleinsäure

Ribonucleinsäure

4.3. Langzeit-Gedächtnis

nur einsträngig auf.

Bei der DNA-Reproduktion lösen sich die Basenverbindungen an bestimmten

Stellen auf. Bei Nervenzellen wird dies durch ein eingehendes Nervensignal katalysiert. An den Stellen, an denen die DNA-Basen keine Verbindung zu ihrer

gegenüberliegenden DNA-Kette haben, lagern sich die Basen der RNA an und

bilden eine RNA-Kette, die in ihrer Basenfolge eine Kopie des gegenüberliegenden DNA-Strangs darstellt (man könnte auch sagen, dass die Basenfolge

des RNA-Strangs eine Negativabbildung von der Basenfolge des abgelesenen

DNA-Strangs ist).

Der RNA-Strang löst sich nun wieder von der DNA und tritt aus dem Zellkern

Abbildung 4.2: Schematische Darstellung der Transkription

aus und wandert zu einem Ribosom des endoplastischen Retikulums (vergl.

Abb. 1.3). Innerhalb des Ribosoms werden, je nach Basenfolge der RNA, verschiedene Proteine synthetisiert. Die Umsetzung der genetischen Information

aus der Basensequenz der RNA in die Aminosäurensequenz, aus denen Proteine bestehen, wird Translation genannt. Während der Translation zerfällt die

RNA wieder in ihre Nucleotide.

Jede Zelle zeichnet sich durch Eigenschaften aus, die durch Stoffwechselprozesse repräsentiert werden. Diese werden mittels Proteine katalysiert. Die in den

Ribosomen synthetisierten Proteine haben also die gleichen Stoffwechseleigenschaften wie die Zelle, aus der sie stammen. Die Flußrichtung der genetischen

39

4. Visuelle Wahrnehmung

Information (DN A → RN A → P rotein) wird das zentrale Dogma der Molekularbiologie genannt ([Haf1980]).

Die Proteine, die in den Ribosomen von Nervenzellen produziert werden, werden in die Zellmembran eingelagert. Da die Nervenzelle nur an wenig Stoffwechselfunktionen beteiligt ist, dient ein Großteil dieser eingelagerten Proteine

einem anderen Zweck. Sie dienen als Erkennungsmoleküle, die durch gezielte

Signale und über eingeprägte Bahnen in der Zellmembran gefunden werden

können und dann auch die Zelle aktivieren, um selbst Signale auszusenden.

Dieser Prozess von der RNA-Bildung bis zur Proteinsynthese dauert etwa

zwanzig Sekunden - also etwa die gleiche Zeit, wie das Gehirn Informationen

im Kurzzeitgedächtnis aufbewahrt. Wird Information nicht aus dem KurzzeitGedächtnis ins Langzeitgedächtnis übernommen, bedeutet das, dass die RNA

zerfällt, ohne vorher zur Proteinsynthese verwendet worden zu sein. Der Zeitpunkt der Proteinsynthese stellt also den Übergang von Kurzzeit- zum Langzeitgedächtnis dar. Das oben beschriebene Experiment und weitere Experimente, konnten dies bestätigen.

Besonders ältere Menschen können sich schlecht an Dinge erinnern, die nur

wenige Tage zurückliegen, was jedoch vor mehreren Jahren oder Jahrzehnten

geschehen ist, können sie mit wesentlich weniger Schwierigkeiten wiedergeben.

Das hängt ebenfalls mit der Proteinsynthese zusammen, da diese im Alter abnimmt.

4.4

Verarbeitung visueller Reize im Gehirn

Visuelle Reize werden vom Auge aufgenommen. Im Inneren des Auges befindet sich die Netzhaut (Retina), auf die das durch das Auge aufgenommene

Bild projeziert wird. Die Netzhaut besteht aus Zapfen, die für die Farbwahrnehmung, und Stäbchen, die für die Helligkeitswahrnehmung zuständig sind

(Abb. 4.3).

Es gibt drei verschiedene Zapfentypen, die jeweils für rotes, blaues und grünes

Licht empfänglich sind. Zapfen und Stäbchen sind Rezeptoren, die visuelle Signale in Nervenimpulse umwandeln.

Die Reize, die von den Rezeptoren ausgehen, werden auf den Sehnerv übertragen. Die Sehnerven, die von jedem Auge ins Gehirn führen, vereinigen sich

in einem Areal des Gehirns, dem Chiasma opticum (Abb. 4.4). Dort kreuzen

etwa die Hälfte der Nervenfasern in die andere Gehirnhälfte, die andere Hälfte verbleibt in der Gehirnhälfte, von der sie stammen. Von dort aus führen

40

4.4. Verarbeitung visueller Reize im Gehirn

Abbildung 4.3: Rezeptoren der Retina: Stäbchen und Zapfen

sie ihren Weg fort in den hinteren Bereich des Gehirns und enden im Corpus geniculatum laterale (CGL), einem Teil des Hirnstammes. Obwohl sich

Abbildung 4.4: Schema des Verlaufes der Sehbahnen im Gehirn des Menschen

die Nervenbahnen bereits gekreuzt haben, werden die Signale, die von beiden Augen kommen, erst im CGL als Ganzes verarbeitet. Von dort aus werden die Nervensignale in den visuellen Cortex4 geleitet. Bildreize werden in

verschiedenen Neuronenklassen verarbeitet. Es gibt mindestens fünfzehn verschiedene Neuronenklassen, die jeweils einzelne Eigenschaften des Bildes, wie

Helligkeit, Kontrast, Farbe, Bewegung, etc. getrennt voneinander verarbeiten.

4

Cortex = Hirnrinde

41

4. Visuelle Wahrnehmung

Zwei dieser Neuronenklassen befinden sich im CGL: die Kontrastneurone und

die Hell-Dunkelneurone. Die Kontrastneurone sind besonders aktiv, wenn im

Gesichtsfeld ein kontrastreiches Bild erscheint. Diffuse Beleuchtung hingegen

bewirkt geringere Aktivität. Andere Neuronenklassen sind im visuellen Cortex

zu finden.

Die einzelnen neuronalen Vorgänge während der Gestaltwahrnehmung sind

noch nicht bekannt. Durch Versuche konnte jedoch gezeigt werden, dass das

Gehirn Informationen assoziativ verarbeitet. Assoziation ist die (un-)bewusste

Verknüpfung bedeutungsähnlicher Begriffe. Erkennt das Auge einen Gegenstand, wie zum Beispiel ein Glas Milch, werden gleichzeitig mit dieser Gestaltwahrnehmung Assoziationen verbunden. Eine dieser Assoziationen könnte die

Farbe weiß sein. Ohne dass es einem bewusst wird, wird dieses assoziierte

Wort mitaktiviert und ist dadurch schneller abrufbar als ohne eine vorherige

Assoziation ([Rol2003]).

42

Kapitel 5

Die Zellen eines Künstlichen

Neuronalen Netzes

Die Neuronen eines Künstlichen Neuronalen Netzes (KNN) haben die gleichen

Grundbausteine wie ihre Vorbilder in der Biologie. Sie sind zusammengesetzt

aus Dendriten, Soma und einem Axon. Die Funktionen, die sie im KNN übernehmen sind identisch geblieben. Die Dendriten nehmen Informationen von

vorgeschalteten Neuronen auf und leiten diese ans Soma. Das Soma summiert

alle eingehenden Signale auf und bestimmt die Größe des ausgehenden Signals,

das dann über das Axon und dessen Synapsen an nachgeschaltete Neuronen

weitergeleitet wird.

In der Abbildung 5.1 sind zwei Neuronen dargestellt. Die Stärke der Verbindungen, die diese Neuronen über ihre Synapsen mit dem Soma eingehen, ist

mit w bezeichnet, wobei die erste Stelle des Indexes die vorgeschaltete, die

zweite Stelle die Nervenzelle, auf die sie einwirkt, indiziert. Besteht zwischen

dem Neuron i und dem Neuron j keine Verbindung, ist der Wert ihrer Verbindung wij gleich Null.

Links der Neuronen wirken die Informationen vorgeschalteter Neuronen, sie

werden Netzeingaben (neti,j ) genannt, ein. Der Aktivierungszustand der Neu-

Abbildung 5.1: Darstellung von Zellen eines neuronalen Netzes

43

5. Die Zellen eines Künstlichen Neuronalen Netzes

ronen ist in der Abbildung mit ai und aj bezeichnet, die Ausgabe mit oi und

oj . Alle diese Werte sind durch Funktionen untereinander verknüpft und von

ihnen abhängig.

Die Ausgabe eines Neurons wird durch eine Ausgabefunktion fout bestimmt,

die sich aus dem Aktivierungszustand eines Neurons ergibt.

oi = fout (ai )

(5.1)

Mit den so errechneten Werten für die Ausgabe vorgeschalteter Neuronen und

den Werten der Verbindungsgewichte lässt sich mit der Propagierungsfunktion

die Netzeingabe berechnen.

netj (t) =

X

oi (t)wij

(5.2)

Der neue Aktivierungszustand eines Neurons ist abhängig von dem alten Aktivierungszustand (aj (t)), der Netzeingabe (netj ) und dem Schwellenwert. Der

Schwellenwert des Neurons wird mit Θj bezeichnet. Die Aktivierungsfunktion (fact ) berechnet mit diesen Parametern den neuen Wert der Aktivierung

(aj (t + 1)).

aj (t + 1) = fact (aj (t), netj (t), Θj )

(5.3)

Welche unterschiedliche Formen der Aktivierungszustand, die Ausgabefunktion, die Propagierungsfunktion und die Aktivierungsfunktion annehmen können,

soll in den folgenden Kapiteln erläutert werden.

5.1

Aktivierungszustand

Die verschiedenen Werte, die der Aktivierungszustand ai (t) eines Neurons annehmen kann, lassen sich in diskrete und (quasi-)kontinuierliche Wertebereiche

trennen (Abb. 5.2). Bei kontinuierlichen Wertebereichen beschränken die meisten Modelle den Aktivierungszustand auf ein Intervall. Das liegt daran, dass

die meisten Netzmodelle nichtlineare oder sigmoide Aktivierungsfunktionen

und die Identität als Ausgabefunktion verwenden.

Ebenfalls zu den kontinuierlichen Wertebereichen gehört die Menge aller reellen Zehlen.

Das ursprüngliche Hopfield-Modell und andere Modelle verwenden diskrete

Aktivierungszustände. Diese werden dann auch in der Implementierung als

44

5.2. Ausgabefunktion

Abbildung 5.2: Unterschiedliche Realisierungen des Aktivierungszustandes

binäre Werte gespeichert und verarbeitet.

Bei den biologischen Nervenzellen kann man ebenfalls zwischen Wertebereichen unterscheiden. Das einfachste Beispiel ist ein binärer Wertebereich, der

angibt, ob sich ein Neuron im unerregten Zustand befindet oder ob gerade

ein Aktionspotential ausgeführt wird. Auch die Natriumionen-Konzentration

gibt Aufschluss über der Aktivierungszustand. Misst man den relativen Anteil,

können die Werte in einem Intervall von 0 bis 100 auftreten.

5.2

Ausgabefunktion

Mit Hilfe der Ausgabefunktion lässt sich der Wert berechnen, den eine Zelle an

eine nachgeschaltete Zelle, bzw. ins Neuronale Netz weitergibt. Sie verwendet

dabei den derzeitigen Aktivierungszustand der Zelle. Somit gibt die Ausgabefunktion an, wie stark ein Neuron feuert.

Die Ausgabefunktion kann verschiedene Formen haben. Eine dieser Funktionen

ist die Identiät (Abb. 5.3). Das bedeutet, dass die Ausgabe identisch mit dem

Aktivierungszustand der Zelle ist. Der Wertebereich der Aktivierungsfunktion

gibt dadurch den Wertebereich des Aktivierungszustandes an.

Die binäre Schwellenwertfunktion kommt dem biologischen Original sehr nahe, da ein Axon erst beim Erreichen eines Schwellenwertes feuert. Jedoch wird

dabei vernachlässigt, dass das Neuron ja in unterschiedlicher Stärke (Impulsfrequenz) feuern kann. Daher werden lineare Ausgabefunktionen verwendet.

Die Abstände, in denen ein Neuron feuern kann, sind durch die Refraktärzeit

nach unten hin beschränkt, daher bietet es sich an, eine Mischform aus einer

linearen Funktion und einer mit Schwellenwert zu verwenden. In der Abbildung ist ein Beispiel einer solchen semilinearen Funktion dargestellt (linear bis

45

5. Die Zellen eines Künstlichen Neuronalen Netzes

Abbildung 5.3: Häufig verwendete Ausgabe-, bzw. Aktivierungsfunktionen. Die Achsenbeschriftung ’out’ bezeichnet den Ausgabewert, ’net’ die Netzeingabe. Bei der Ausgabefunktion repräsentiert ’net’ den Aktivierungszustand

Sättigung). Einige Funktionen stellen ein Glättung dieser semilinearen Funktion dar (sin(x), logistische Funktion, tanh(x)). Da sie S-förmig sind, werden

sie auch sigmoide Funktionen genannt. Diese nichtlinearen Funktionen sind die

am häufigsten verwendeten.

5.3

Propagierungsfunktion

Die Propagierungsfunktion errechnet aus der Summe aller Ausgaben vorgeschalteter Zellen mit ihren jeweiligen Gewichten die Netzeingabe zu einem

Zeitpunkt t, die auf ein Neuron wirkt.

Das Vorbild in der Biologie ist ein Neuron, das mehrere Impulse von vorgeschalteten Neuronen erhält. Die Impulse können sowohl erregender wie auch

46

5.4. Aktivierungsfunktion

hemmender Natur sein. Für das Auslösen eines Aktionspotentials ist die Summe aller Impulse, die zu einem Zeitpunkt ankommen, ausschlaggebend, also

die räumliche Summation. Bei den KNN lassen sich die Neuronen ebenfalls in

erregende und hemmende separieren. Dies spiegelt sich in den Werten ihrer

Gewichte wieder. Sie sind positiv, wenn das Neuron erregend wirkt, negativ