Sprache - TU Dresden

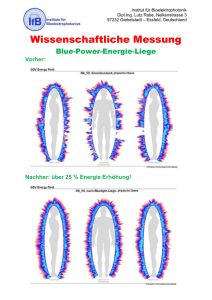

Werbung

Fachrichtung Psychologie Professur Allgemeine Psychologie Modul A1: Kognitive Prozesse (SS 2013) Sprache Thomas Goschke 1 Literaturempfehlungen zur Vorbereitung auf die Modulprüfung Eysenck, M.W. & Keane, M.T. (2010). Cognitive psychology. A student’s handbook (6th ed.). Psychology Press. PART III: Language (Kapitel 9 und 10). Gazzaniga, M., Ivry, R. & Mangun, R. (2009). Cognitive neuroscience. The biology of the mind (3rd Ed.). Norton. Kapitel 10. Goldstein, E.B. (2007). Wahrnehmungspsychologie (7. Aufl.). Heidelberg: Spektrum Akademischer Verlag. (Kapitel 13 zur Auditiven Sprachwahrnehmung). 2 Überblick Einführung: Grundmerkmale und Struktur der Sprache Wahrnehmung gesprochener Sprache Wahrnehmung geschriebener Sprache Das mentale Lexikon: Repräsentation von Wortbedeutungen Sprache und Gehirn 3 Was ist Sprache? Ein System von Symbolen und Regeln, dass es uns ermöglicht, zu kommunizieren Weitere Funktionen der Sprache • Unterstützung von Denkprozessen • Aufzeichnung und Weitergabe von Wissen • u. v. m. Voraussetzung für komplexere Formen von Technologie, Zivilisation und Kultur 4 Sprache als interdisziplinärer Forschungsgegenstand Linguistik • Theorien der Sprachkompetenz (Wissen über grammatische Regeln) Psychologie • Untersuchung der Sprachperformanz (Prozesse und Strukturen des Sprachverstehens und der Sprachproduktion) Informatik • Entwicklung von künstlichen Systemen, die Sprache verwenden können Neuropsychologie und Kognitive Neurowissenschaft • Untersuchung neurologisch bedingter Sprachstörungen und neurobiologischer Grundlagen der Sprache 5 Wichtige Begriffe Syntax: Grammatische Regeln, die bestimmen, wie Wörter zu Sätzen kombiniert werden dürfen Semantik: Bedeutung sprachlicher Ausdrücke Pragmatik: Gebrauch von Sprache zur Kommunikation und Erreichung von Zielen (z.B. Versprechen, Drohen, Überzeugen, Erklären etc.) Prosodie: Melodische Aspekte sprachlicher Äußerungen (Betonung, Intonation) emotionaler Ausdruck 6 Sprache bei Menschenaffen? Frühe Versuche, Affen Sprechen beizubringen, scheiterten ( Anatomie des Vokaltrakts) Spätere Studien: Menschenaffen können begrenzt den Gebrauch von Symbolen lernen Z.B. Gardner & Gardner: Schimpansin Washoe: Zeichensprache 7 Gardner, R.A. & Gardner, B.T. (1969). Teaching sign language to a chimpanzee. Science, 165, 664-72 Sprache bei Menschenaffen? Savage-Rumbaugh: Bonobos Kanzi und Panbanisha lernten Gebrauch einer Tastatur mit ca. 400 Lexigrammen • kombinieren Symbole zu einfachen Sequenzen: „Ich möchte Eiskaffee“; „Ich möchte essen“ • Wenig völlig neue Sätze • Selten Bezug auf nicht sichtbare Dinge • Beschränkte Komplexität der Sätze • Unklar, ob echte Syntax • Kritik: Nur operantes Konditionieren? 8 Sprache bei Menschenaffen? Universelle Eigenschaften der menschlichen Sprache Unabhängigkeit von der Gegenwart • Wir können über Dinge sprechen, die nicht vorhanden sind. Ausdruckskraft • Wir können über beliebige Inhalte sprechen. Produktivität und Generativität • Wir können aus endlicher Anzahl von Wörtern mit Hilfe grammatikalischer Regeln unendlich viele Sätze bilden. 10 Sprache und Denken Die These des linguistischen Relativismus Benjamin L. Whorf (1956): Die Sprache determiniert die Wahrnehmung und das Denken Abgeschwächte These: Sprache beeinflusst Wahrnehmung und Gedächtnis Evidenz: Unterschiede zwischen Sprachen • Z.B. Hanuxoo auf den Philippinen haben 92 verschiedene Namen für unterschiedliche Reissorten • Z.B. Eskimos: zahlreiche Wörter für verschiedene Schneearten Kritische Einwände • auch in anderen Sprachen können ähnlich feine Unterscheidungen ausgedrückt werden, allerdings werden dazu mehrere Wörter benötigt • Nicht die Sprache bestimmt Denken/Wahrnehmung, sondern Unterschiede zwischen Sprachen spiegeln die Relevanz bestimmter perzeptueller / konzeptueller Unterscheidungen in einer Kultur 11 Sprache und Denken Roschs Experimente zum Gedächtnis für Farben Eleanor Rosch (1972, 1973): Experimente zum Einfluss der Farbwörter einer Sprache auf Wahrnehmung und Erinnern von Farben Studie zum Farb-Gedächtnis mit Angehörigen der Dani (Volksstamm auf Neuguinea), deren Sprache nur zwei Farbworte enthält („mola“ = hell/warm und „mili“ = dunkel/kalt) • Dani-Probanden machten in Gedächtnistests für Farben ähnliche Fehler wie amerikanische Probanden • Dani-Probanden zeigten ebenso wie amerikanische Probanden bessere Gedächtnisleistung für fokale Farben Rosch‘s Schlussfolgerung: Keine Evidenz für Whorfs These des Sprachdeterminismus 12 Replikationsstudie von Roberson et al. (1990) Studie mit englischen Probanden und Angehörigen der Berinmo auf Papua Neuguinea • Englisch: Worte für blau vs. grün • Berinmo: Worte für nol (≈ grün) vs. Wor (≈ gelb) (aber keines für blau) Probanden sollten aus jeweils drei Farben die zwei ähnlichsten auswählen Vorhersage der Relativitätshypothese: Probanden sollten Farben aus der gleichen sprachlichen Kategorie als ähnlicher klassifizieren • Grün1 – Grün2 – Blau • Nol1 - nol2 - wor Ergebnis: In beiden Gruppen wurden die Klassifikationen stark durch die jeweilige Muttersprache beeinflusst 13 Roberson, D., Davies, I., & Davidoff, J. (2000). Color categories are not universal: Replications and new evidence from a stone-age culture. Journal of Experimental Psychology: General, 129(3), 369-398. Hemisphärenasymmetrie des Einflusses sprachlicher Kategorien auf die Farbwahrnehmung Gilbert, A.L. et al. (2006). Proceedings of the National Academy of Sciences 103, 489–494 Hemisphärenasymmetrie des Einflusses sprachlicher Kategorien auf die Farbwahrnehmung Gilbert, A.L. et al. (2006). Proceedings of the National Academy of Sciences 103, 489–494 Fazit Weitere Befunde (s. Eysenck & Keane, S. 329-331) • Roberson et al. (2000): Rekognitionstest, bei dem englische Probanden und Berinmo entscheiden sollten, welche von 2 Farben mit einer zuvor dargebotenen Farbe übereinstimmt In beiden Gruppen besseres Farbgedächtnis, wenn die 2 Testfarben aus verschiedenen Sprachkategorien stammten Befunde sprechen insgesamt für moderate Variante von Whorfs Hypothese, dass Sprache (unter bestimmten Bedingungen) Kategorisierung und Gedächtnis beeinflusst Vom Sprachsignal zur Bedeutung Prozesse beim Produzieren und Verstehen von Sprache 21 Ward (2010) Probleme, die das Gehirn beim Sprachverstehen lösen muss Diskrimination von Sprachsignal u. irrelevantem auditorischen Input Echtzeitverarbeitung: Sprachinput = ca. 10 Phoneme pro sec Segmentierung: Extraktion diskreter Einheiten (Phoneme, Silben, Wörter) aus akustischem Input Variabilität: Aussprache von Phonemen variiert je nach Kontext (Koartikulation) und zwischen Sprechern Lexikalische Selektion aus mentalem Lexikon mit einigen 10.000 (oft phonologisch ähnlichen) Wörtern Semantische Interpretation: Konstruktion einer kohärenten Bedeutung aus einzelnen Wörtern Integration in mentales Modell der Sprachintention 22 Auditorische Sprachwahrnehmung 23 Teilprozesse und Verarbeitungsstufen der auditorischen Sprachwahrnehmung nach Cutler & Clifton (1999) Abb. Aus Eysenck & Keane (2010) Gesprochene Sprache: Der akustische Input Phoneme: Kleinste Lauteinheiten, die Bedeutungsunterschiede anzeigen • /d/ vs. /t/ danken – tanken • Anzahl und Verknüpfungsregeln variieren zwischen Sprachen Allophone: Lautvariationen, die keine Bedeutungsänderungen anzeigen • z.B. /l/ und /r/ im Japanischen Morpheme: Kleinste Bedeutung tragende Einheiten • Freie Morpheme: können allein stehen, gewöhnlich Wörter • Gebundene Morpheme: können nicht allein stehen, meist Präfixe u. Suffixe: 25 verstehend, Hunde, Unglück, glücklich, betrinken Erzeugung von Phonemen • Beim Sprechen wird der exhalatorische Luftstrom durch Stimmbänder, weichen Gaumen, Zunge u. Lippen moduliert Vokale: • kontinuierlicher Luftstrom bei charakteristischer Öffnungsform des Stimmtrakts Konsonanten: • Zusammenziehen oder Schließen des Stimmtrakts • Rascher Wechsel von Luftstromimpulsen und Ruhephasen • Unterbrechungen der Luftströme mit charakteristischer Art und Position 27 Erzeugung von Phonemen: Phonetische Merkmale Stimmhaftigkeit: Schwingende vs. nicht schwingende Stimmbänder • Stimmhaft: alle Vokale; einige Konsonanten (z.B. /b/, /d/, /m/) • Stimmlos: z.B. /s/, /t/, /f/ Artikulationsort: Ort, an dem Luftstrom blockiert wird • Alveolar: Zahnfächer (Alveolaren): /d/ • Labiodental: Unterlippe und obere Schneidezähne: /f/ • Bilabial: beide Lippen (/b/) Artikulationsart: Wie wird Luftstrom verändert • Verschlusslaute (Plosive): Blockieren des Luftstroms (/d/, /p/) • Reibelaut (Frikativ): (/f/) • Vokale: Position der Zunge (hoch-niedrig, vorne-hinten) 29 Sprachwahrnehmung: Das Sprachsignal Physikalisches Signal ≠ Gehörte Laute Physikalisch: Kontinuierlicher Lautstrom (keine klaren Pausen zwischen Wörtern; oft Pausen innerhalb von Worten) Gehört: Individuelle, klar voneinander getrennte Wörter Spektrogramm (Frequenz x Zeit; Intensität = Schwärze) Formanten 32 Abb. aus Goldstein (1999). Das Segmentierungsproblem 34 Hinweise auf Wortgrenzen • Bestimmte Lautfolgen kommen nie in einer Silbe vor • Lautfolgen, die keinen Vokal enthalten, können kein Wort sein • Betonung (z.B. werden im Englischen die meisten Substantive auf der ersten Silbe betont) • Stärkere Koartikulationseffekte innerhalb als zwischen Wörtern Courtesy of Tamara Swaab. © 1997 Das Variabilitätsproblem vs. Variabilität aufgrund inter- und intraindividueller Unterschiede in der Aussprache Tonhöhe, Geschwindigkeit, Akzent und Dialekt, Sorgfalt Koartikulation: Variabilität der Phoneme durch umgebende Laute • Lautproduktion wird von vorangehenden und nachfolgenden Lauten beeinflusst • Lippen passen sich beim Aussprechen eines Phonems antizipatorisch an das folgende Phonems an • z.B. bei „Boot“ sind Lippen beim Aussprechen des /b/ bereits gerundet für das folgende /o/; bei „Bad“ dagegen nicht 36 Abb. aus Goldstein (1999). © Spektrum Verlag. Bottom-up-Prozesse: Kategoriale Wahrnehmung von Phonemen Eimas & Corbit (1973): Variierten Vokaleinsatzzeit (vocal onset time; VOT) nach einem Konsonanten Gradueller Anstieg der VOT von 0 msec ("da") zu 80 msec ("ta"), aber kategoriale Wahrnehmung von "da" oder "ta" ohne Zwischenstufen /da/ /ta/ 38 Abb. aus Goldstein (2002). Interaktion akustischer und visueller Information: Der McGurk-Effekt McGurk & MacDonald (1976): • Versuchspersonen sehen die Lippenbewegungen von "gaga" und hören dazu "baba". Sie nehmen "dada" wahr! • Bei geschlossenen Augen hören sie korrekt "baba". • Visueller Kontext beeinflusst Wahrnehmung des auditiven Sprachsignals 40 Top-down-Prozesse und Kontexteffekte: Einfluss der Bedeutung Segmentierung aufgrund der Bedeutung "Druckerzeugnis": Druck-Erzeugnis oder Drucker-Zeugnis? "I scream, you scream, everybody wants ice cream“ Interpretation aufgrund von Vorwissen und Kontext Identifikation von Phonemen aufgrund der Bedeutung Phoneme (z.B. "b") werden in Wörtern ("Bat") schneller erkannt als in Nicht-Wörtern ("Baf") (Rubin, Turvey & Van Gelder, 1976) 41 Top-down-Prozesse und Kontexteffekte: Phonemischer Restaurationseffekt Warren & Warren (1970): • Einzelne Phoneme in Sätzen wurden durch ein Geräusch ersetzt • Keine Versuchsperson bemerkte dies! • Statt dessen wurde das fehlende Phonem "gehört“. Dargeboten It was found that the *eel was on the axle It was found that the *eel was on the table It was found that the *eel was on the orange Gehört Wheel Meal Peel Gleicher akustischer Input wird je nach Bedeutungskontext unterschiedlich wahrgenommen 42 Top-down-Verarbeitung: Kognitive Prozesse bei der Sprachwahrnehmung Miller & Isard (1963): • Probanden sollten Wörtern trotz Hintergrundgeräuschen erkennen • Wörter in syntaktisch & semantisch korrekten Sätzen wurden besser verstanden als Wörter in nur syntaktisch korrekten Sätzen bzw. sinnlosen Wortfolgen • 63% vs. 22% vs. 3% korrekte Wiedergabe Salasoo & Pisoni (1985): • Wörter, bei denen ein Teil durch ein Geräusch überdeckt war, wurden in bedeutungsvollen Sätzen besser erkannt als isoliert • Wörter wurden besser erkannt, wenn der Anfang statt des Endes hörbar war 44 Mattys et al.’s (2005) Hierarchisches Modell der Sprach-Segmentierung Abb. Eysenck & Keane, 2010 Modelle der auditorischen Worterkennung 46 Teilprozesse und Verarbeitungsstufen der auditorischen Sprachwahrnehmung nach Cutler & Clifton (1999) Abb. Aus Eysenck & Keane (2010) 09-06 48 Schematisches Modell der Strukturen und Prozesse beim Verstehen gesprochener und geschriebener Sprache Aus: Gazzaniga, Ivry & Mangun (2009) Das mentale Lexikon Langzeitgedächtnis für das Wissen über Worte enthält • • • • Phonologische Information (Klang) Orthographische Information (Visuelle Wortform) Syntaktische Information (Wortklasse; Abfolge; Kombination zu Sätzen) Semantische Information (Bedeutung) (Wird von einigen Forschern als separates System angenommen!) Standardsprache: ca. 75.000 Wörter (Gesamtwortschatz: mehrere 100.000 Wörter) Echtzeitverarbeitung: Wir können ca. 3 Worte pro Sekunde verstehen / produzieren Wie wird aufgrund des Sprachinput auf die richtigen Einheiten im mentalen Lexikon zugegriffen (lexical access)? Zwei wichtige Modelle der auditorischen Worterkennung • Kohorten-Modell (Marslen-Wilson & Tyler, 1980, 1990) • Trace-Modell (Elman & McClelland,1986) Kohortenmodell (Marslen-Wilson &Tyler, 1980) 52 1. Lexikalische Aktivierung aller Kandidaten, die mit Anfangsphonem übereinstimmen 2. Lexikalische Selektion: Schrittweise Einschränkung auf zunehmend weniger Kandidaten 3. Worterkennung: Prozess bricht ab, sobald nur noch ein Wort in der Kohorte ist (uniqueness point) Aus: Gazzaniga, Ivry & Mangun (2009) Kohortenmodell (Marslen-Wilson &Tyler, 1980) Parallele Verarbeitung: phonologische, lexikalische, syntaktische und semantische Informationen wird simultan genutzt, um Anfangskohorte einzuschränken Semantische Kontexteffekte: die Selektion von Wortkandidaten kann durch den Satzkontext beeinflusst werden ( vgl. später das Experiment von Zwitserlood, 1989) 53 Kontexteffekte: Das Experiment von Zwitserlood et al. (1989) Vpn hörten Sätze: • Carrier Phrase: • Neutral context: • Biasing context: Das nächste Wort ist Kapitän Sie betrauerten den Verlust ihres Kapitäns In gedrückter Stimmung standen die Männer um das Grab. Sie betrauerten den Verlust ihres Kapitäns Zu verschiedenen Zeitpunkten während der akustischen Darbietung des Wortes „Kapitäns“ („K“, „Ka“, „Kap“) erschien visueller „Probe“-Stimulus: • SCHIFF • GELD • LIVUL = semantisch mit „Kapitän“ assoziiert = semantisch mit lexikalischem Konkurrent („Kapital“) assoziiert = Nichtwort Vpn sollten lexikalische Entscheidung für den visuellen Reiz treffen 56 Kontexteffekte: Experiment von Zwitserlood et al. (1989) 1. Akustischer Satzkontext: In gedrückter Stimmung standen die Männer um das Grab. Sie betrauerten den Verlust ihres... 3. Visuelles Probe-Wort & Lexikalische Entscheidung 2. Anfangsphoneme des PrimeWorts: Ka Kap Kapit Kapitä 57 Kontexteffekte: Experiment von Zwitserlood et al. (1989) In einer „Gating-Aufgabe“ wurden für jedes Prime-Wort vier ProbePositionen bestimmt: Positionen 1 + 2: Ohne Kontext werden sowohl das Zielwort (KAPITÄN) als auch alternative Konkurrenten (KAPITAL) genannt Phase der lexikalischen Aktivierung Position 3: Ohne Kontext wird das Zielwort am häufigsten genannt; einige Probanden nennen noch auch alternative Worte Phase der lexikalischen Selektion Position 4: Das Wort wird eindeutig erkannt Punkt der eindeutigen Rekognition 58 59 Kontexteffekte: Experiment von Zwitserlood et al. (1989) Biasing Context Neutral Context Carrier Phrase Probe related to competitor („KAPITAL“): GELD Carrier Phrase Neutral Context Biasing Context 130 60 199 278 410 ms Probe related to actual word („KAPITÄN“) SCHIFF Kontexteffekte: Experiment von Zwitserlood et al. (1989) Primingeffekt für Probes, die mit dem Zielwort und dem Konkurrenten assoziiert waren parallele Aktivierung einer lexikalischen Kohorte Kein Effekt des semantischen Kontexts an Probe Position 1 und 2 frühe lexikalische Aktivierung erfolgt weitgehend „botton-up“ Signifikanter Effekt des Kontext an Probe Position 3 und 4 Satzkontext beeinflusst lexikalische Selektion 63 Revidiertes Kohortenmodell (Marslen-Wilson (1990, 1994) Kandidaten einer Wort-Kohorte können im Grad ihrer Aktivation variieren (statt Alles-oder-Nichts-Prinzip) • Z.B. werden häufige Wortkandidaten stärker aktiviert als seltene Die initiale Kohorte kann Worte mit ähnlichen (anstatt identischen) initialen Phonemen wie das dargebotene Wort enthalten Größere Betonung von bottom-up Prozessen, um den relativ späten Einfluss semantischer Kontexte zu erklären Stärke des Modells: berücksichtigt Interaktion parallel ablaufender (phonologischer, syntaktischer, semantischer) Verarbeitungsprozesse Einschränkungen des Modelle: • Das revidierte Modell ist sehr flexibel, aber auch schwer zu testen bzw. zu widerlegen • Es ist nicht völlig geklärt, wie die initiale Identifikation von Wortanfängen funktioniert • Sehr starke/eindeutige Kontexte können Verarbeitung früher beeinflussen als im Modell angenommen (van Petten et al., 1999) Blickbewegungsstudie von Magnuson et al. (2008) Probanden lernten, Nomen (einer Kunstsprache) mit Objekten zu assoziieren und Adjektive mit Texturen zu assoziieren Danach wurden jeweils vier Objekte präsentiert und Probanden sollten auf dasjenige klicken, das mit einem bestimmten Nomen assoziiert war In jedem Trial wurde das korrekte Ziel-Nomen zusammen mit einem “Competitor”-Wort dargeboten, das mit dem gleichen Phonem begann A.V.: Anteil von Blick-Fixationen auf das Ziel-Wort und das “Competitor”-Wort Wenn das “Competitor”-Wort ein Adjektiv war, wurde es extrem schnell ignoriert (oder gar nicht beachtet) Spricht gegen die Annahme des Kohortenmodell, dass die initiale Wort-Kohorte unbeeinflusst von TopDown-Effekten ist Abb. Aus Eysenck & Keane (2010) Konnektionistische Modelle: Die TRACE-Theorie von McClelland & Elman (1986) TRACE-Modell (McClelland & Elman,1986) 67 bit /b/ stimmhaft stimmlos tip ... Worte /t/ ... Phoneme nasal plosiv labial alveolar ... Merkmale Drei Ebenen von Verarbeitungseinheiten für phonetische Merkmale, Phoneme, Worte. Hemmende Verbindungen zwischen Einheiten derselben Ebene (laterale Hemmung). Bahnende Verbindungen zwischen Einheiten verschiedener Ebenen. 67 TRACE-Modell (McClelland & Elman,1986) 68 bit /b/ stimmhaft stimmlos tip ... Worte /t/ ... Phoneme nasal plosiv labial alveolar ... Merkmale Je besser ein Merkmal zum Sprachsignal passt, umso stärker wird es aktiviert Merkmalseinheiten aktivieren Phonemeinheiten Phonemeinheiten aktivieren alle Worte in denen sie enthalten sind. TRACE-Modell (McClelland & Elman,1986) 69 bit /b/ stimmhaft stimmlos tip ... Worte /t/ ... Phoneme nasal plosiv labial alveolar ... Merkmale Je besser ein Merkmal zum Sprachsignal passt, umso stärker wird es aktiviert Merkmalseinheiten aktivieren Phonemeinheiten Phonemeinheiten aktivieren alle Worte in denen sie enthalten sind. Worteinheiten aktivieren top-down Phonemeinheiten. Empirische Evidenz für das TRACE-Modell Erkennen von verrauschtem Sprachinput Musterergänzung aufgrund top-down-Einflüssen kategoriale Wahrnehmung von Phonemen Nebeneffekt der lateralen Hemmung zwischen Phonem-Units („winner-takes-all“Prinzip) Effekte der Worthäufigkeit höhere Baseline-Aktivierung von Worteinheiten Wortüberlegenheitseffekt (Cutler et al., 1987): Phoneme werden schneller in Worten als in Nichtworten entdeckt Nebeneffekt der top-down-Aktivierung von der Wort- zur Phonemebene Lexical identification shift (Ganong, 1980): ambige Phoneme werden so wahrgenommen, dass sich sinnvolles Wort ergibt Nebeneffekt der top-down-Aktivierung von der Wort- zur Phonemebene 70 TRACE-Modell Einschränkungen Top-Down-Einflüsse werden im Modell evtl. überschätzt ( Modell produziert häufig „halluzinierte“ Wahrnehmungen) Simulation bislang nur mit relativ begrenztem Lexikon ( Frage der Skalierung der Prozesse auf realistisch großes Lexikon) 71