Schätzung von Parametern(16.09.2004)

Werbung

Kapitel 8

Schätzung von Parametern

8.1 Schätzmethoden

Gegeben seien Beobachtungen

x1 ; x2 ; : : : ; xn ;

die wir als Realisationen von unabhängig und identisch verteilten Zufallsvariablen

X1 ; X2 ; : : : ; Xn

auffassen. Die Verteilung der Xi hänge von einem oder mehreren unbekannten Parametern

ab. Die Parameter sollen aufgrund der vorliegenden Beobachtungen geschätzt werden. Wir

werden zwei allgemeine Schätzmethoden besprechen.

8.1.1 Die Methode der Momente

Definition 8.1

Das k -te Stichprobenmoment ist definiert als

n

0 = 1 X xk :

i

mk

n i=1

Das erste Stichprobenmoment ist z.B.

n

0 = 1 X x = x :

i

m1

n i=1

Die Methode der Momente beruht darauf, dass man

a) zunächst die Parameter einer Verteilung durch die Momente 0k der Verteilung ausdrückt.

b) anschließend in dem in a) entstandenen Ausdruck die Momente 0k durch die entsprechenden Stichprobenmomente m0k ersetzt.

142

8.1. SCHÄTZMETHODEN

143

Beispiel 8.1 Die Exponentialverteilung hat einen Parameter und es gilt

0 = 1=

1

Daher schätzt man durch

oder

= 1=01 :

^ = 1=m01 = 1=x :

Beispiel 8.2 Für eine normalverteilte Zufallsvariable

X

N (; )

2

gilt

EX

Daher verwendet man

= = 01 :

n

X

^ = m01 = x = n1 xi

i=1

als Schätzer von . Für die Varianz von X gilt

VarX

= 2 = EX 2 (EX )2 = 02 (01 )2 :

Daher schätzt man 2 durch

^ = m02 (m01 )2 :

2

Es gilt

n

X

(m01 )2 = n1 x2i (x)2

m02

^ =

2

i=1

n

X

= n1 (xi x)2 = s2 :

i=1

Beispiel 8.3 Die Gammaverteilung hat zwei Parameter und , und es gilt

EX

= =

VarX

und

Daraus folgt

und

= =2 :

0

EX

= Var

= 0 (10 )2

X

2

1

EX )2

(01 )2

= EX = (Var

=

X

02

(01 )2

:

Daher sind die Schätzer von und nach der Methode der Momente

0

) = x

^ = m0 (m1(m

0 )2 s2

2

und

2

2

1

0

^ = 0 m1 0 2 = x2 :

m2

(m1 ) s

Beispiel 8.4 Die Poissonverteilung hat einen Parameter und es gilt

0 = EX = :

1

Daher schätzt man durch

^ = m01 = x :

144

KAPITEL 8. SCHÄTZUNG VON PARAMETERN

Beispiel 8.5 Die Bernoulli-Verteilung hat einen Parameter und es gilt

0 = EX = :

1

Daher schätzt man durch

^ = m01 = x :

8.1.2 Die Maximum-Likelihood-Methode

Von dem Philosophen Rudolph Hermann Lotze (1817 - 1881), der von 1844 - 1880 in Göttingen lebte und nach dem die Lotzestraße benannt ist, stammt das folgende Zitat:

Wenn gegebene Thatsachen aus mehreren verschiedenen Ursachen ableitbar sind, so ist diejenige Ursache die wahrscheinlichste, unter deren Voraussetzung die aus ihr berechnete

Wahrscheinlichkeit der gegebenen Thatsachen die größte ist.

Das ist eine sehr treffende Beschreibung der Maximum-Likelihood-Schätzmethode, die allgemein Fisher (1912) zugeschrieben wird, obwohl es sogar Quellen aus dem 18. Jahrhundert

für diese Methode gibt.

Definition 8.2 Der Maximum-Likelihood-Schätzer eines Parameters ist der Wert des

Parameters, der den Beobachtungen die größte Wahrscheinlichkeit zuordnet.

Beispiel 8.6 Es soll die Wahrscheinlichkeit

= P (fKopf g) ;

mit der eine Münze mit ,,Kopf” auftrifft, geschätzt werden. Dazu werde die Münze sechsmal geworfen.

Sei

Xi

=

(

1

0

wenn das Ergebnis im i-ten Wurf ,,Kopf” ist,

wenn das Ergebnis im i-ten Wurf ,,Zahl” ist.

Die gemeinsame Wahrscheinlichkeitsfunktion von X1 ; X2 ; : : : ; X6 ist

; ) = P (fX1 = x1 ; X2 = x2 ; : : : ; X6 = x6 g) :

(

PX1 X2 :::X6 x1 ; x2 ; : : : ; x6 Wenn man annimmt, dass die Versuche unabhängig sind, gilt

; ) = P (fX1 = x1 g) P (fX2 = x2 g) : : : P (fX6 = x6 g) :

(

PX1 X2 :::X6 x1 ; x2 ; : : : ; x6 Die Beobachtungen in 6 Würfen seien

1 1 0 1 0 1:

Die Wahrscheinlichkeit dieser Beobachtungen ist

PX1 X2 :::X6

(1; 1; 0; 1; 0; 1) =

=

(1

4

(1

)

2

:

) (1

)

8.1. SCHÄTZMETHODEN

145

Sie hängt vom Parameter ab. Deshalb sollte man schreiben

PX1 X2 :::X6

(1; 1; 0; 1; 0; 1; ) :

Die Likelihoodfunktion ist die gemeinsame Wahrscheinlichkeitsfunktion an der Stelle der Beobachtungen x1 ; x2 ; : : : ; xn . Sie wird jedoch als Funktion des Parameters betrachtet. Um das zu betonen,

schreibt man

( ; 1; 1; 0; 1; 0; 1)

L statt

PX1 X2 :::X6

(1; 1; 0; 1; 0; 1; ) :

Wir können die Likelihoodfunktion für verschiedene Werte von bestimmen.

( ; 1; 1; 0; 1; 0; 1) = 4 (1

L 0.1

0.2

0.3

0.4

0.5

0.6

0.7

0.8

0.9

)2

0.000081

0.001024

0.003969

0.009216

0.015625

0.020736

0.021609

0.016384

0.006561

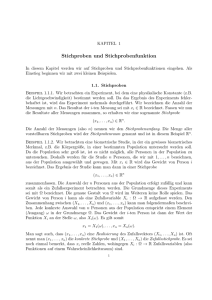

Das Maximum liegt zwischen 0:6 und 0:7.

Abbildung 8.1 zeigt die Likelihoodfunktion als Funktion von . Der Wert = 4=6 = 0:666 maximiert die Wahrscheinlichkeit dieser Beobachtungen. Wir können die Likelhoodfunktion analytisch

maximieren. Dabei benutzen wir den folgenden Satz:

Likelihood * 1000

25

20

15

10

5

0

0.0

0.2

0.4

0.6

0.8

1.0

π

Abbildung 8.1: Graphische Darstellung der Likelihoodfunktion

Satz 8.1 Der Wert 0 maximiert die Funktion L( ) genau dann, wenn er die Funktion

log(L( )) maximiert.

146

KAPITEL 8. SCHÄTZUNG VON PARAMETERN

Abbildung 8.2 zeigt für das obige Beispiel die Likelihoodfunktion und die Loglikelihoodfunktion.

25

-2

-4

-6

-8

Loglikelihood

Likelihood * 1000

20

15

10

-10

-12

-14

-16

5

-18

-20

0

-22

0.0

0.2

0.4

0.6

0.8

1.0

0.0

0.2

0.4

π

0.6

0.8

1.0

π

Abbildung 8.2: Likelihoodfunktion und Loglikelihoodfunktion

Es ist oft einfacher den Logarithmus der Likelihoodfunktion zu maximieren.

In unserem Beispiel ist

log(L(; 1; 1; 0; 1; 0; 1) = 4 log() + 2 log(1

)

:

Um das Maximum der Loglikelihoodfunktion zu bestimmen, bilden wir die Ableitung nach .

d

log(L()) = 4

d

2 ;:

1 Diese Ableitung ist gleich null zu setzen.

2 =0

1 ^

4

^

() 4(1 ^ ) = 2^ () 4 = 6^ () ^ = 23 :

Der Maximum-Likelihood-Schätzer von ist also

^ = 23 :

Streng genommen, müsste jetzt noch überprüft werden, ob die zweite Ableitung der Loglikelihood^ negativ ist, um sicher zu gehen, dass tatsächlich ein Maximum und

funktion nach an der Stelle kein Minimum vorliegt.

Beispiel 8.7 An die folgenden 10 Beobachtungen soll eine Poissonverteilung angepasst werden.

15 14 19 20 23 25 24 11 15 18

Für die Poissonverteilung gilt

x

( ) = xe!

P x

x

= 0; 1; 2; : : :

:

8.1. SCHÄTZMETHODEN

147

Die Likelihoodfunktion ist

( ; 15; 14; 19; 20; 23; 25; 24; 11; 15; 18) =

L PX1 X2 :::X10

10

Y

=

i=1

(15; 14; : : : ; 18; )

( )

PXi xi

15 e 14

18

e

e

::: 15!

14!

18!

=

:

-25

Loglikelihood

-30

-35

-40

-45

-50

-55

-60

10

15

20

25

30

λ

Abbildung 8.3: Loglikelihoodfunktion

Abbildung 8.3 zeigt den Graphen der Loglikelihoodfunktion.Die Loglikelihoodfunktion hat ihr Maximum an der Stelle 18:4.

Die Loglikelihoodfunktion ist:

log(L(; 15; 14; : : : ; 18)) =

15 log() log(15!) + 14 log() log(14!) + : : : + 18 log() log(18!) =

(15 + 14 + : : : + 18) log() 10 (log(15!) + log(14!) + : : : + log(18!)) =

184 log() 10 :

Dabei steht für eine Konstante, die nicht vom Parameter abhängt. Durch Differenzieren nach und Nullsetzen der Ableitung ergibt sich

184=^ 10 = 0 :

Daraus folgt

^ = 184=10 = 18:4 :

Allgemein gilt bei gegebenen Beobachtungen

x1 ; x2 ; : : : ; xn

für die Likelihoodfunktion

( ;

L x1 ; x2 ; : : : ; xn

)=

n

Y

xi e i=1

xi

!

:

Die Loglikelihoodfunktion ist dann

log(L(; x1 ; x2 ; : : : ; xn )) =

n

X

i=1

(xi log()

= log() n

X

i=1

xi

n

log(xi !))

n

X

i=1

log(xi !) :

148

KAPITEL 8. SCHÄTZUNG VON PARAMETERN

Die Ableitung der Loglikelihoodfunktion nach ist

n

P

d

log(L(; : : :)) = i=1 xi

d

Nullsetzen ergibt

n:

n

P

xi

^ =n:

i=1

Daraus folgt als Maximum-Likelihood-Schätzer des Parameters der Poissonverteilung

n

P

xi

^ = i=1 = x :

n

Beispiel 8.8 Die Zufallsvariable X sei normalverteilt mit dem Parameter und 2 d.h.

1 exp

f (x) = p

22

(x

)2

22

!

1<x<1:

Dann ist die Likelihoodfunktion

(

L ; 2

!

p 1 2 exp

) =

2

i=1

(xi )2

22

n

X

= (2) n=2 (2 ) n=2 exp 21 2 (xi

i=1

n

Y

)

!

2

;

und die Loglikelihoodfunktion ist

log L(; ) = (n=2) log(2) (n=2) log 2

1

n

X

22 i=1(xi

2

Die partiellen Ableitungen sind

log L(; 2 ) = 1

2

und

log L(; 2 ) =

n

n

X

i=1

(xi

1

n

X

)

2

22 + 2(2 )2 i=1(xi ) :

Nullsetzen der partiellen Ableitungen und Multiplikation mit ^2 bzw. 2^2 ergibt

2

n

X

i=1

und

n

(xi ^) = 0

n

X

+ 1^2 (xi ^)2 = 0 :

i=1

Die Lösungen der beiden Gleichungen sind

^ = x

)2 :

8.1. SCHÄTZMETHODEN

und

149

n

n

^ = 1 X(xi ^)2 = 1 X(xi x)2 = s2 :

n

n

2

i=1

i=1

An die folgenden Beobachtungen soll eine Normalverteilung angepasst werden:

87.8

94.4

85.8

87.3

91.1

111.5

67.5

96.4

123.2

104.4

73.8

110.4

112.8

106.8

100.1

107.8

81.5

121.2

103.1

96.4

97.0

100.7

89.8

120.3

98.0

107.0

100.0

109.6

119.5

113.1

94.0

81.0

109.2

111.4

85.5

101.5

83.3

105.8

92.2

90.6

101.4

114.5

113.2

101.3

102.0

80.6

101.0

80.7

93.8

106.8

log(L)

-210 -205 -200

Abbildung 8.4 zeigt die Loglikelihoodfunktion als Funktion von und 2 .

30

0

105

20

σ2

0

10

0

100

µ

95

Abbildung 8.4: Loglikelihoodfunktion für anzupassende Normalverteilung

Es ergeben sich als Schätzer

^ = 99:36

^ = 159:5 :

2

Beispiel 8.9 Wir wollen die Maximum-Likelihood-Schätzer für eine Rechteckverteilung (X

bestimmen. Gegeben seien die drei Beobachtungen

U (a; b))

21:4 3:7 28:9 :

Die Likelihoodfunktion ist allgemein bei Beobachtungen

x1 ; x2 ; : : : ; xn

( ;

L a; b x1 ; x2 ; : : : ; xn

)=

1

b

n

a

für a x1 ; x2 ; : : : ; xn

b:

Um L zu maximieren, muss (b a) minimiert werden, d.h. b muss so klein wie möglich (bei den

^ = 3:7).

obigen Beobachtungen ^b = 28:9) und a so groß wie möglich sein (a

Allgemein ist

^ = min(x1 ; x2 ; : : : ; xn )

a

und

^b = max(x1 ; x2 ; : : : ; xn ) :

150

KAPITEL 8. SCHÄTZUNG VON PARAMETERN

8.2 Einige Eigenschaften von Schätzern

Meistens gibt es mehrere Möglichkeiten, um einen Parameter zu schätzen, und man muss

sich zwischen verschiedenen Schätzern (oder auch Schätzfunktionen) entscheiden. Um die

Wahl zu erleichtern, geben wir einige Eigenschaften von Schätzern an, die wir zur Beurteilung ihrer Qualität heranziehen werden. Man wählt dann den Schätzer aus, der die besten“

”

Eigenschaften hat oder der die Eigenschaften hat, die in der jeweiligen praktischen Situation von Bedeutung sind. Zunächst ist festzustellen, dass ein Schätzer eine Zufallsvariable

ist, also eine Verteilung hat und insbesondere Momente, die wir gleich zur Beurteilung der

Güte des Schätzers heranziehen werden. Mit wollen wir den zu schätzenden Parameter

bezeichnen, mit ^ den Schätzer (oder die Schätzfunktion).

8.2.1 Erwartungstreue, Bias

Die Abbildungen 8.5 - 8.7 sollen jeweils zehn Realisationen von verschiedenen Schätzern

^1 ; ^2 und ^3 zeigen. Der Schätzer ^1 überschätzt in den meisten Fällen, ^2 unterschätzt den

zu schätzenden Parameter , während ^3 im Mittel weder überschätzt noch unterschätzt.

Solch ein Schätzer heißt erwartungstreu.

Abbildung 8.5: Typische Realisationen des Schätzers ^1

Abbildung 8.6: Typische Realisationen des Schätzers ^2

Abbildung 8.7: Typische Realisationen des Schätzers ^3

Definition 8.3 Ein Schätzer ^ heißt erwartungstreu, wenn gilt

E ^ = :

8.2. EINIGE EIGENSCHAFTEN VON SCHÄTZERN

151

Definition 8.4 Der Bias eines Schätzers ^ ist definiert als

Bias(^) = E ^

:

Offensichtlich ist ein Schätzer ^ genau dann erwartungstreu, wenn Bias(^) = 0 gilt.

Beispiel 8.10 Die Beobachtungen

x1 ; x2 ; : : : ; xn

seien Realisierungen von unabhängigen N (; 2 )-verteilten Zufallsvariablen. Als Schätzer von betrachten wir

n

X

1

^ = n Xi :

i=1

Es ist

n

n

X

X

^ = E n1 Xi = n1 EXi = ;

E

i=1

i=1

d.h. ^ ist ein erwartungstreuer Schätzer von .

Eine abgeschwächte Forderung an den Schätzer ist die asymptotische Erwartungstreue:

Definition 8.5 Ein Schätzer ^ heißt asymptotisch erwartungstreu, wenn gilt

lim

^

!1 E = :

n

Asymptotische Erwartungstreue ist gleichbedeutend damit, dass der Bias (auch Verzerrung

genannt), mit wachsendem Stichprobenumfang n ! 1 verschwindet.

Beispiel 8.11 Die Beobachtungen

x1 ; x2 ; : : : ; xn

seien wieder Realisierungen von unabhängigen N (; 2 )-verteilten Zufallsvariablen. Wir betrachten

den Schätzer der Varianz 2 ,

n

X

^ 2 = S 2 = n1 (Xi

i=1

Es ist bekannt, dass

nS 2

2

)2 :

X

(n 1) :

2

Dann gilt nach Satz 3.13

ES

2

2

2

= n E (2 (n 1)) = n (n 1) :

152

KAPITEL 8. SCHÄTZUNG VON PARAMETERN

Somit ist S 2 kein erwartungstreuer Schätzer von 2 . Für den Bias gilt

Bias(S 2 ) =

2

n

(n 1)

2

=

=n :

(Xi

X

2

Würde man anstelle S 2 den Schätzer

2

S

= n n 1 S2 = n 1 1

verwenden, so hätte man wegen

2

ES

n

X

i=1

)2

= n n 1 ES 2 = 2

einen erwartungstreuen Schätzer. Das ist der Grund, weshalb S2 häufig als Schätzer der Varianz 2

verwendet wird. Für den Bias von S 2 gilt

Bias(S 2 ) =

2

=n

!0

!1

n

Damit ist S 2 asymptotisch erwartungstreu.

Asymptotische Erwartungstreue ist eine Eigenschaft des Schätzers für große Stichprobenumfänge n. Ein asymptotisch erwartungstreuer Schätzer kann für kleine Stichprobenumfänge erhebliche Verzerrungen liefern. So gilt z.B. für n = 2 für den Schätzer S 2 : E (S 2 ) =

2 =2, d.h. 2 wird im Durchschnitt erheblich unterschätzt.

8.2.2 Standardfehler

Definition 8.6 Der Fehler eines Schätzers ^ ist definiert als

^

:

Die Abbildungen 8.8 und 8.9 zeigen typische Realisationen von zwei jeweils erwartungstreuen Schätzern. Der Schätzer ^1 zeichnet sich durch eine kleinere Streuung aus und ist deshalb

vorzuziehen. Das entsprechende Maß für die Streuung eines Schätzers ist seine Standardabweichung, d.h. die Wurzel aus seiner Varianz.

Definition 8.7 Der Standardfehler eines Schätzers ^ ist seine Standardabweichung, d.h.

SF(^) =

q

Var(^) :

8.2. EINIGE EIGENSCHAFTEN VON SCHÄTZERN

153

Abbildung 8.8: Typische Realisationen des Schätzers ^1

Abbildung 8.9: Typische Realisationen des Schätzers ^2

Beispiel 8.12 Wie in Beispiel 8.10 seien die Beobachtungen

x1 ; x2 ; : : : ; xn

Realisierungen von unabhängigen N (; 2 )-verteilten Zufallsvariablen, und wir betrachten wieder

den Schätzer

n

X

1

^ = n Xi :

i=1

Es ist

!

n

1X

2

Xi = =n

n

Var(^

) = Var

i=1

p

und damit

SF(^

) = = n :

und S2 .

Der Schätzer S war nicht erwartungstreu, sondern nur asymptotisch erwartungstreu, während S2

erwartungstreu ist. Es ist die Frage offen, was für die Verwendung von S 2 , also eines nicht erwartungstreuen Schätzers spricht. Aus diesem Grunde untersuchen wir jetzt, wie sich beide Schätzer

hinsichtlich ihres Standardfehlers verhalten. Es gilt

Beispiel 8.13 Wir beziehen uns auf Beispiel 8.11 und die dort betrachteten Schätzer

2

VarS

2

2

= Var

n

!

2

und damit

4

(n 1) = n2 2(n 1)

2q

( ) = n 2(n 1) :

SF S 2

Für S2 gilt

2

VarS

= Var

n

n

und damit

s

( )=

2

SF S

2

1

S

2

2

4

= (n n 1)2 VarS 2 = 2 n 1

2 = n SF (S 2 ) > SF (S 2 ) :

n 1

n

1

Die Erwartungstreue wird also mit einem größeren Standardfehler erkauft.

S2

154

KAPITEL 8. SCHÄTZUNG VON PARAMETERN

8.2.3 Mittlerer quadratischer Fehler

Zur Beurteilung der Güte eines Schätzers muss man sowohl den Bias als auch den Standardfehler berücksichtigen. Wir definieren jetzt ein Maß, das beide Größen zusammenfasst.

Definition 8.8 Der mittlere quadratische Fehler eines Schätzers ^ ist definiert als

MQF(^) = E (^

) :

2

Der mittlere quadratische Fehler misst also die zu erwartende quadratische Abweichung zwischen dem Schätzer und dem zu schätzenden Parameter.

Satz 8.2 Für den mittleren quadratischen Fehler eines Schätzers ^ gilt

MQF(^) = Var(^) + (Bias(^))2

:

Beweis:

MQF(^) =

=

=

=

=

E (^

= E (^ E ^ + E ^ )2

2

E ((^ E ^) + (E ^ ))

2

2

E ((^ E ^) + 2(^ E ^)(E ^ ) + (E ^ ) )

2

2

E (^ E ^) + 2E (^ E ^)(E ^ ) + E (E ^ )

2

V ar (^) + 2(E ^ E ^)(E ^ ) + (E ^ )

|

{z

}

)

2

|

=0

{z

}

Bias(^))2

=(

= Var(^) + (Bias(^))2

}

Die zu erwartende quadratische Abweichung ist somit die Summe aus der Varianz von ^ und

dem quadrierten Bias von ^.

Beispiel 8.14 Wie in den früheren Beispielen seien die Beobachtungen

x1 ; x2 ; : : : ; xn

Realisierungen von unabhängigen N (; 2 )-verteilten Zufallsvariablen. Wir betrachten zunächst den

Schätzer

n

X

^ = n1 Xi :

i=1

8.2. EINIGE EIGENSCHAFTEN VON SCHÄTZERN

Da ^ erwartungstreu ist, gilt

155

2

) = Var(^

) = =n :

MQF(^

Für den Schätzer S 2 gilt

MQF(S 2 ) = Var(S 2 ) + (Bias(S 2 ))2

4

2

= n2 2(n 1) +

!2

n

4

= n2 (2n 1) :

Der Schätzer S2 ist erwartungstreu. Daher gilt

MQF(S2 ) = Var(S2 ) = 4

Es ist

MQF(S

2

)=

4

2

1 < 4 2

n2

n

n

<

4

2

n

1:

2 = M QF (S 2 ) :

n 1

Beurteilt man also einen Schätzer nach dem mittleren quadratischen Fehler, so ist S 2 gegenüber S2

vorzuziehen.

Satz 8.3 Für einen erwartungstreuen Schätzer ^ gilt

MQF(^) = Var(^) :

Beweis: Für einen erwartungstreuen Schätzer ^ gilt Bias(^) = 0 und daher

MQF(^) = Var(^) + (Bias(^))2 = Var(^) :

}

8.2.4 Konsistenz

Die Varianz eines Schätzers als alleiniges Kriterium ist also nur für erwartungstreue Schätzer

sinnvoll. Bei asymptotisch erwartungstreuen Schätzern geht mit wachsendem Stichprobenumfang der Bias gegen Null. Geht gleichzeitig auch die Varianz gegen Null, so konvergiert

auch der mittlere quadratische Fehler gegen Null. Man spricht dann von Konsistenz, genauer:

Konsistenz im quadratischen Mittel.

Definition 8.9 Ein Schätzer ^ heißt konsistent im quadratischen Mittel, wenn gilt

lim

^

!1 M QF ( ) = 0

n

156

KAPITEL 8. SCHÄTZUNG VON PARAMETERN

Die Konsistenz ist eine asymptotische Eigenschaft, die nur für große Stichprobenumfänge

gilt. Eine konsistente Schätzfunktion kann für endliche Stichprobenumfänge eine große Varianz und eine erhebliche Verzerrung besitzen.

Die Konsistenz im quadratischen Mittel wird auch als starke Konsistenz bezeichnet. Eine

alternative Form der Konsistenz ist die schwache Konsistenz, bei der verlangt wird, dass die

Wahrscheinlichkeit, mit der die Schätzfunktion Werte in einem beliebig kleinen Intervall um

den wahren Parameter annimmt, mit wachsendem Stichprobenumfang gegen Eins konvergiert. Anschaulich bedeutet dies, dass der Schätzwert für große n in unmittelbarer Nähe des

wahren Parameters liegt.

Definition 8.10 Ein Schätzer ^ heißt schwach konsistent, wenn für beliebiges > 0 gilt

!1 P (j

< )

oder gleichbedeutend

^

lim

!1 P (j

j

^

lim

n

n

=1

j ) = 0

Aus der Konsistenz im quadratischen Mittel (oder der starken Konsistenz) folgt die schwache

Konsistenz.

Beispiel 8.15 Wie im vorigen Beispiel seien die Beobachtungen

x1 ; x2 ; : : : ; xn

Realisierungen von unabhängigen N (; 2 )-verteilten Zufallsvariablen. Wir wissen, dass der Schätzer

n

X

^ = n1 Xi

i=1

erwartungstreu ist und den folgenden mittleren quadratischen Fehler besitzt:

2

MQF(^

) = Var(^

) = =n

Der mittlere quadratische Fehler konvergiert offensichtlich gegen Null, d.h. der Schätzer ist konsistent

im quadratischen Mittel. Die schwache Konsistenz folgt aus der starken. Man könnte sie auch so

beweisen:

(j P X

j ) =

P

= X

=

pn pn

pn

!

pn

!1

!1

n

0=1

Diese Wahrscheinlichkeit ist in Abbildung 8.10 grafisch dargestellt. Mit wachsendem Stichprobenumfang liegt die gesamte Verteilung innerhalb der senkrechten Striche bei und + .

8.2. EINIGE EIGENSCHAFTEN VON SCHÄTZERN

157

n3 = 20

n2 = 10

n1 = 2

µ−ε

µ

µ+ε

Abbildung 8.10: Wahrscheinlichkeiten P (jX

numfängen n1 = 2; n2 = 10; n3 = 20

j ) für = 3=4; = 1 bei Stichprobe-

Ein erwartungstreuer Schätzer ist offensichtlich genau dann konsistent im quadratischen Mittel, wenn die Varianz gegen Null konvergiert. Dasselbe läßt sich auch für die schwache Konsistenz zeigen. Dazu brauchen wir die Tschebyscheffsche Ungleichung:

Satz 8.4 (Ungleichung von Tschebyscheff)

Sei X eine Zufallsvariable mit E (X ) = und Var(X ) =

Ungleichung für beliebiges > 0:

j

j ) P( X

2.

Dann gilt die folgende

2

2

Diese Ungleichung besagt, dass bei festem die Wahrscheinlichkeit, dass X um mindestens

von abweicht desto geringer ist, je kleiner die Varianz ist.

Da P (jX

j

< )

=1

j

P( X

j ) folgt daraus sofort eine zweite Ungleichung:

j

j

P( X

< )

2

1

2

Die Tschebyscheffsche Ungleichung lässt sich so beweisen: Wir definieren eine diskrete

Zufallsvariable Y durch

(

Y

=

0

Dann gilt: P (Y = 0) = P (jX

j

< )

E (Y )

Nach Definition von Y gilt immer Y

E (Y )

jX

jX

falls

falls

2

und P (Y

= 2 P (jX

jX

E (X

j

)

2

2

j

j

= ) = P (jX

j )

<

2

und somit

= Var(X ) = 2

j ). Also ist:

158

KAPITEL 8. SCHÄTZUNG VON PARAMETERN

Also haben wir

j

2

und damit P (jX

j ) 2

2

j ) P( X

2

.

Für einen Schätzer ^ folgt aus der Tschebyscheffschen Ungleichung

j

P ( ^

^

j ) Var ()

2

Daraus folgt, dass jeder erwartungstreue Schätzer schwach konsistent ist, wenn Var(^)

0.

!1

!

n

= E (X ) einer Zufallsvariablen X mit Var(X ) = 2 wird

geschätzt. Da E (X ) = E (X ) ist X ein erwartungstreuer Schätzer.

durch das arithmetische Mittel X

gilt Var(X ) = n2 n!1

! 0. Demnach ist X konsistent im quadratischen Mittel

Für die Varianz von X

Beispiel 8.16 Der Erwartungswert

und auch schwach konsistent.

8.2.5 Effizienz

Der mittlere quadratische Fehler (MQF) ist ein Maß für die Güte eines Schätzers, das sowohl

die Verzerrung als auch die Varianz des Schätzers berücksichtigt. Demnach ist von zwei

Schätzern ^1 und ^2 derjenige vorzuziehen, der den kleineren mittleren quadratischen Fehler

besitzt. Man sagt dann, dass ^1 MQF-wirksamer ist als ^2 , wenn

M QF (^1 )

M QF (^ )

2

Hierbei muss man jedoch den Bereich der zugelassenen Verteilungen einschränken, z.B. auf

alle Poissonverteilungen, wenn es um die Schätzung des Parameters der Poissonverteilung geht oder auf alle Verteilungen mit endlicher Varianz, wenn es um die Schätzung des

Erwartungswertes geht.

Betrachtet man nur erwartungstreue Schätzer, d.h. Schätzer ohne Bias, so reduziert sich die

Betrachtung der Wirksamkeit auf den Vergleich der Varianzen:

Definition 8.11 Ein erwartungstreuer Schätzer ^1 heißt wirksamer oder effizienter als

der ebenfalls erwartungstreue Schätzer ^2 , wenn

Var(^1 ) Var(^2 )

für alle zugelassenen Verteilungen gilt.

Ein erwartungstreuer Schätzer ^ heißt wirksamst oder effizient, wenn seine Varianz für

alle zugelassenen Verteilungen den kleinsten möglichen Wert annimmt, d.h. wenn für alle

anderen erwartungstreuen Schätzer ^ gilt:

Var(^) Var(^ )

8.2. EINIGE EIGENSCHAFTEN VON SCHÄTZERN

159

Es gibt eine untere Schranke für die Varianz einer erwartungstreuen Schätzfunktion, die sogenannte Cramér-Rao-Schranke, die wir jedoch im Rahmen dieser Vorlesung nicht angeben

können. Diese Schranke wird von wirksamsten Schätzern angenommen.

Effiziente Schätzfunktionen sind u.a.

X

X

für den Erwartungswert, wenn alle Normalverteilungen zugelassen sind,

X

für den Anteilswert , wenn alle Bernoulli-Verteilungen zugelassen sind,

X

für den Parameter , wenn alle Poisson-Verteilungen P o() zugelassen sind,

X

für g () = 1=, wenn alle Exponentialverteilungen Exp() zugelassen sind,

für den Erwartungswert, wenn alle Verteilungen mit endlicher Varianz zugelassen

sind,

die mittlere quadratische Abweichung bzgl. , d.h.

n

1 P

n

(Xi

i=1

)2

für die Varianz 2 ,

wenn alle Normalverteilungen mit Erwartungswert zugelassen sind,

n

P

)2 für die Varianz

die Stichprobenvarianz S2 = n 1 1 (Xi X

i=1

verteilten Grundgesamtheit, wenn unbekannt ist.

2

einer

N (; 2 )-

Als Literatur zu diesem Kapitel sei Fahrmeir u.a. (1997), Bamberg und Baur (1996), Schlittgen (1996a, 1996b) genannt.