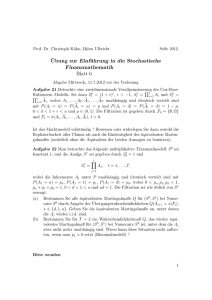

Stochastische Unabhängigkeit

Werbung

Stochastische Unabhängigkeit

01. Dezember 2014

1

1

Der Begriff der Unabhängigkeit

Großbritannien, im November 1999. Die Anwältin Sally Clark wird wegen Mordes an ihren Kindern angeklagt. Clark geriet unter Verdacht nachdem ihre beiden Söhne (*1996, *1997) innerhalb kurzer Zeit nach deren

Geburt verstarben. Lagen hier zwei Fälle von plötzlichem Kindstod vor oder

hatte die Mutter ihre Söhne umgebracht? Im Prozess wird der renommierte

Kinderarzt Roy Meadow hinzugezogen. Dieser stützt seine Aussage auf eine

statistische Untersuchung, welche besagt, dass die Wahrscheinlichkeit eines

Krippentods in einer Familie mit dem gesellschaftlichen Status der Clarks

etwa 1 zu 8543 sei. Daraus schließt Meadow, dass die Wahrscheinlichkeit,

dass zwei solche Todesfälle in derselben Familie auftreten, dem Quadrat

dieser Zahl entspreche: 1 zu 73 Millionen. Aufgrund dieser statistischen

Analyse wird Sally Clark wegen Mordes an ihren beiden Kindern schuldig

befunden.

Wann beeinflussen sich zwei Ereignisse bzw. zwei Zufallsvariablen, wann

nicht?

Sind zwei Ereignisse abhängig voneinander, dann wird die Wahrscheinlichkeit

für ein bestimmtes Ereignis durch das Eintreten eines vorherigen Ereignisses

beeinflusst.

1.1

Def. Bedingte Wahrscheinlichkeiten

Sei (Ω, A, P ) Wahrscheinlichkeitsraum. Sei B ∈ A mit P (B) > 0, heißt

P (A | B) = PB (A) :=

P (A ∩ B)

für jedes A ∈ A

P (B)

die bedingte Wahrscheinlichkeit von A gegeben B.

Durch Umstellen der obigen Formel erhält man das allgemeine Multiplikationstheorem P (A ∩ B) = P (A | B) · P (B). Nimmt man an, dass das

vorherige Ereignis (hier B) keinen Einfluss auf das darauffolgende Ereignis

(hier A) hat, dann gilt: P (A | B) = P (A). Daraus ergibt sich folgende

Definition:

1.2

Def. Unabhängigkeit

Sei (Ω, A, P ) Wahrscheinlichkeitsraum. Zwei Ereignisse A, B ∈ A heißen

(stochastisch) unabhängig genau dann, wenn gilt:

P (A ∩ B) = P (A) · P (B).

2

Folgerung: Stochastische Unabhängigkeit ist ein symmetrischer Begriff.

Das heißt, wenn A von B unabhängig ist, dann gilt auch B ist von A unabhängig. Dies gilt genauso für Ā und B, A und B̄ sowie Ā und B̄.

Ob bei einem Zufallsexperiment Abhängigkeit oder Unabhängigkeit vorliegt,

kann häufig auch aus der Struktur des Zufallsexperiments abgeleitet werden.

Betrachtet man den aufeinanderfolgenden Wurf einer fairen Münze, so ist

klar, dass das Ergebnis des vorangehenden Wurfes das darauf folgende Ergebnis nicht beeinflusst. Die Wahrscheinlichkeit ”Kopf” oder ”Zahl” zu erhalten

ist stets jeweils 21 .

Auch Meadow ging davon aus, dass wiederholte Fälle plötzlichen Kindstods

innerhalb einer Familie statistisch unabhängig voneinander sind. Das heißt,

dass der Tod des einen Kindes nichts mit dem Tod des anderen Kindes zu

tun hat. Jedoch ignorierte er in diesem Kontext Hintergrundbedingungen

wie z.B. die Existenz von genetisch vererbten Risikofaktoren. So ist es ein

Fehler, den Tod der beiden Kinder als unabhängig zu betrachten und somit

hätte Meadows die Wahrscheinlichkeit nicht quadrieren dürfen.

2

Unabhängigkeit bei diskreten WahrscheinlichkeitsMaßen

Betrachte das Laplace’sche Zufallsexperiment ”Werfen eines Würfels”. Für

das Zufallsexperiment erhält man den Ergebnisraum Ω = {1, 2, 3, 4, 5, 6},

| Ω |= 6. Nach der Definition der Gleichverteilung ergibt sich für jedes

dieser Ereignisse die Wahrscheinlichkeit von 16 . Wird das Zufallsexperiment

auf ”Zweimaliges Würfeln mit einem Würfel” erweitert, vergrößert sich der

Ergebnisraum Ω = {(i, j)}, i, j = 1, ..., 6, | Ω |= 36. Die Wahrscheinlichkeit

1

für jedes Ereignis verkleinert sich dementsprechend auf 36

, bleibt jedoch gleichverteilt.

Im Folgenden soll gezeigt werden, wenn die Zufallsvariablen x und y unabhängig voneinander und jeweils gleichverteilt sind, ist auch die Zufallsvariable (x, y) gleichverteilt.

Sei x nach einem diskreten W-Maß P1 mit Masse in den Punkten ai , i ∈ N

verteilt, analog y mit W-Maß P2 , Punkte bj , i ∈ N. Dann nimmt (x, y)

Werte in der Menge {(aj , bj ) : i, j ∈ N} an. Nach Voraussetzung sind x und

y unabhängig, somit nimmt (x, y) den Wert (ai , bj ) mit der Wahrscheinlichkeit P {(ai , bj )} = P1 {ai }P2 {bj } an. P ist ein W-Maß, da

∞ P

∞

∞

∞

P

P

P

P {(aj , bj )} = P1 {ai } P2 {bj } = 1.

1

1

1

1

3

Weiterhin gilt

P (A ∩ B) =

=

=

∞ X

∞

X

1

1

∞ X

∞

X

P {(aj , bj )}1A∩B (aj , bj )

P1 {ai }P2 {bj }1A (ai )1B (bj )

1

1

∞

X

P1 {ai }1A (ai )

1

∞

X

P2 {bj }1B (bj )

1

= P1 (A)P2 (B).

Sind P1 und P2 Gleichverteilungen über endlich vielen Werten {a1 , ..., an1 }

und {b1 , ..., bn2 } , dann gilt: P1 {ai } = n11 und P2 {B} = n12 , also P ({ai , bi }) =

1

n1 ·n2 , das heißt, P ist auch eine Gleichverteilung.

Beachte: Das Umgehen des Unabhängigkeitsbegriffs ist nur bei gleichverteilten Zufallsvariablen möglich.

3

3.1

Unabhängigkeit mehrerer Ereignisse

Def. Unabhängigkeit von n Ereignissen

Die n Ereignisse A1 , A2 , ..., An eines endlichen Wahrscheinlichkeitsraumes

(Ω, A, P ) heißen genau dann stochastisch unabhängig, wenn für jede

Auswahl von k Ereignissen Ai1 , Ai2 , ..., Aik aus der Menge {A1 , A2 , ..., An }

der gegebenen n Ereignisse die Gleichung

P (Ai1 ∩ Ai2 ∩ ... ∩ Aik ) = P (Ai1 ) · P (Ai2 ) · ... · P (Aik )

erfüllt ist. Hierbei ist k jede natürliche Zahl mit 1 < k ≤ n.

Seien drei Ereignisse A1 , A2 und A3 gegeben. Gemäß der Definition müssen

folgende vier Gleichungen bei stochastischer Unabhängigkeit erfüllt sein:

P (A1 ∩ A2 ) = P (A1 ) · P (A2 ),

P (A1 ∩ A3 ) = P (A1 ) · P (A3 ),

P (A2 ∩ A3 ) = P (A2 ) · P (A3 ),

P (A1 ∩ A2 ∩ A3 ) = P (A1 ) · P (A2 ) · P (A3 ).

Zwar impliziert die stochastische Unabhängigkeit von n Ereignissen die stochastische Unabhängigkeit jedes Ereignispaares, jedoch gilt dies nicht umgekehrt!

4

Von der paarweisen stochastischen Unabhängigkeit von n Ereignissen lässt

sich nicht auf die stochastische Unabhängigkeit der n Ereignisse schließen.

Das soll im Folgenden das Beispiel des gefärbten Tetraeders veranschaulichen:

Ein Tetraeder habe eine rote, eine blaue, eine grüne und eine Seite mit

allen drei Farben. Seien die Ereignisse A/B/C, dass das Tetraeder auf

eine Fläche mit roter/blauer/grüner Farbe fällt. So erhält man mit der

Laplace’schen-Wahrscheinlichkeitsrechnung P (A) = P (B) = P (C) = 21 und

P (A∩B) = P (A∩C) = P (B∩C) = 41 . Die Ereignisse A, B und C sind demnach paarweise stochastisch unabhängig. Außerdem gilt P (A ∩ B ∩ C) = 14 .

Jedoch gilt nicht

P (A ∩ B ∩ C) = P (A) ∗ P (B) ∗ P (C),

denn P (A) ∗ P (B) ∗ P (C) = 21 · 12 · 12 = 18 6= 14 .

Das heißt, die Ereignisse A, B und C sind abhängig.

4

4.1

Funktionen unabhängiger Zufallsvariabler

Def. Diskrete Zufallsvariablen

Sei (Ω, ℘(Ω), P ) ein Wahrscheinlichkeitsraum mit abzählbarer Ergebnismenge

Ω. Dann heißt jede Funktion

X : Ω −→ R mit ω 7→ X(ω)

eine diskrete Zufallsvariable auf Ω.

4.2

Def. Unabhängigkeit von Zufallsvariablen

Sei (Ω, A, P, ) Wahrscheinlichkeitsraum. Seien X, Y ∈ R Zufallsvariablen.

Diese sind genau dann unabhängig, wenn für alle A ⊆ A sowie alle B ∈ A

gilt

P (X ∈ A, Y ∈ B) = P (X ∈ A) · P (Y ∈ B).

Bemerkung: Liegt ein diskretes Wahrscheinlichkeitsmaß vor, ist die vorangegangene Gleichung äquivalent zu

P (X = x, Y = y) = P (X = x) · P (Y = y).

Als Beispiel zur Unabhängigkeit von Zufallsvariablen betrachte das Zufallsexperiment ”Zweifaches Würfeln”. Sei dazu (Ω, ℘(Ω), P ) der zum Zufallsexperiment definierte Wahrscheinlichkeitsraum mit der Ergebnismenge

Ω = {(i, j) | i, j ∈ {1, ..., 6}}. Die diskreten Zufallsvariablen seien definiert

als

5

X((i, j)) = i ist ”Augenzahl 1. Würfel”,

Y ((i, j)) = j ist ”Augenzahl 2. Würfel”,

Z((i, j)) = i + j ist ”Summe der Augenzahlen”.

Sind X und Y bzw. Y und Z unabhängig voneinander?

Für X und Y gilt:

P (X ∈ A, Y ∈ B) = P ({(i, j) ∈ {1, ..., 6}}2 : X(i, j) ∈ A, Y (i, j) ∈ B})

= P ({(i, j) ∈ {1, ..., 6}2 : i ∈ A, j ∈ B})

|A×B |

|A|·|B|

= P (A × B) =

=

36

36

P (X ∈ A) = P ({(i, j) ∈ {1, 6}2 : i ∈ A})

= P (A × {1, ...6})

| A × {1, ..., 6} |

|A|

=

=

36

6

Analog gilt: P (Y ∈ B) = |B|

6 .

Das heißt, P (X ∈ A, Y ∈ B) = P (X ∈ A) · P (Y ∈ B) ist erfüllt und damit

sind X und Y unabhängig voneinander.

Für den zweiten Fall nehme an, dass die Augenzahl des 1. Würfels 6 ist

und die Summe der Augenzahlen ≥ 11. Dann kann leicht errechnet werden

(siehe Bsp. Kap. 2), dass

P (X ∈ {6}, Z ∈ {11, 12}) 6= P (X ∈ {6}) · P (Z ∈ {11, 12})

2

6 3

1

6=

·

= .

36

36 36

72

Daraus folgt, dass X und Z abhängig voneinander sind.

Merke: Funktionen unabhängiger Zufallsvariabler sind wieder unabhängig.

Es gilt zu zeigen, dass die verbundene Verteilung der beiden Variablen

(f (x), g(y)) ein Produktmaß ist, wenn die verbundene Verteilung von (x, y)

eines war.

Sei P die verbundene Verteilung von (x, y), dann wird P ∗ (f, g) durch

P ∗ (f, g)(C) = P {(x, y) ∈ (X ∩ Y ) : (f (x), g(y)) ∈ C}

definiert. P ·(f, g) ist dabei das von P und der Abbildung (x, y) 7→ (f (x), g(y))

induzierte Wahrscheinlichkeitsmaß.

6

Da

{(x,y) ∈ (X ∩ Y ) : (f (x), g(y)) ∈ (A ∩ B)}

= ({x ∈ X : f (x) ∈ A} ∩ {y ∈ Y : g(y) ∈ B}

= (f −1 A) ∩ (g −1 B),

erhalten wir für C = (A ∩ B):

P ∗ (f, g)(A ∩ B) = P ((f −1 A) ∩ (g −1 B))

Ist P ein Produktmaß, dann gilt

P ((f −1 A) ∩ (g −1 B)) = P (f −1 A) · P (g −1 B)

= P ∗ f (A) · P ∗ g(B),

also:

P ∗ (f, g)(A ∩ B) = P ∗ f (A) · P ∗ g(B)

Da P ∗f und P ∗g Wahrscheinlichkeitsmaße sind, ist das Multiplikationstheorem aus 1.2 erfüllt. Daher lässt sich schließen, dass die induzierte Verteilung

ein unabhängiges Produkt ist.

References

[1] J. Pfanzagl: Elementare Wahrscheinlichkeitsrechnung, Walter de

Gruyter, 1991, ISBN 978-3110133849.

[2] J. Behnke, N. Behnke: Grundlagen der Statistischen Datenanalyse

- Eine Einführung für Politikwissenschaftler, Verlag für Sozialwissenschaften, 2006, ISBN 978-3531145761.

[3] C. Comez, L. Schneps: Wahrscheinlich Mord - Mathematik im Zeugenstand, Carl Hanser Verlag, 2013, ISBN 978-3446436756.

[4] H. Kütting, M.J. Sauer: Elementare Stochastik - Mathematische

Grundlagen und didaktische Konzepte, Spektrum Akademischer Verlag, 2008, 2.Auflage, ISBN 978-3827418548.

7