VL 6 InstrumKond 2 - Fachsymposium

Werbung

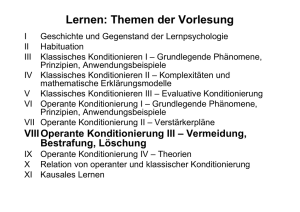

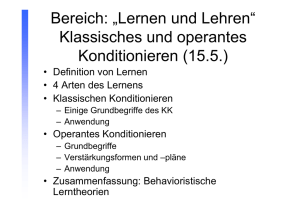

Professur für Allgemeine Psychologie Vorlesung im WS 2011/12 Lernen und Gedächtnis Instrumentelles Konditionieren II Prof. Dr. Thomas Goschke Überblick Thorndikes Gesetz des Effekts Skinners Forschung zum operanten Konditionieren Shaping und Verhaltenssequenzen Was wird beim O.K. gelernt? Arten von Verstärkern Verstärkungspläne Generalisierung und Diskrimination Abbau unerwünschter Verhaltensweisen und Bestrafung Flucht- und Vermeidungstraining Anwendungsbeispiele klassischer Lerntheorien Generalisierung und Diskrimination Reizgeneralisierung Guttman & Kalish (1956) • • • Trainierten Tauben, auf eine beleuchtete Taste zu picken Picken auf Licht einer bestimmten Wellenlänge wurde mit Futter belohnt Transferphase: Licht anderer Wellenlänge beleuchtet Generalisierung als Suche nach ähnlichen Effekten Generalisierung spiegelt die erwartete Wahrscheinlichkeit, dass die gleiche Reaktion auf zwei verschiedene Reize die gleiche Konsequenz haben wird Differenzielles Training und Generalisierungsgradienten (Jenkins & Harrison 1960) Nichtdifferenzielles Training • Tauben wurden nach variablem Intervallplan trainiert, auf eine beleuchtete Scheibe zu picken, wenn ein 1000-Hz Ton dargeboten wurde • Löschungsphase: Töne anderer Frequenz oder kein Ton Differenzielles Training • Durchgänge mit beleuchteter Scheibe und 1000 Hz Ton Verstärkung • Durchgänge mit beleuchteter Scheibe ohne Ton Keine Verstärkung 50 No. 8 No. 52 40 No. 54 No. 58 30 No. 60 No. 70 30 No. 71 No. 72 20 20 S 10 10 SD 0 300 450 670 1000 1500 2250 Frequenz in Zyklen pro Sekunde 3500 No Tone 0 300 450 670 1000 1500 2250 Frequenz in Zyklen pro Sekunde 3500 No Tone Reizdiskrimination (Jenkins & Harrison, 1962) Standardtraining: 1000-Hz-Ton auf Taste picken Verstärkung Diskriminationstraining: Zusätzlich 950-Hz-Ton keine Verstärkung Gluck, Mercado and Myers (2008) Copyright © 2008 by Worth Publishers Negative Generalisierungsgradienten (Terrace 1972) • Tauben wurden trainiert, bei Licht auf Scheibe zu picken, erhielten aber keine Verstärkung, wenn das Licht gelb-rot (570nm) war • Testphase: Licht unterschiedlicher Wellenlänge Spences (1937) Theorie des Diskriminationslernens Verstärkung in Anwesenheit eines Reizes positiver Generalisierungsgradient Keine Verstärkung negative Generalisierungsgradient Peak Shift Verhalten ist Kombination positiver und negativer G.-Gradienten Relationales Lernen Anwendung von Spence‘s Theorie auf Auswahl zwischen zwei Reizen: • Training, zwischen Reizen von 160 und 256 cm2 zu diskriminieren • Test: Tier bekommt Wahl zwischen Reizen von 256 und 409 cm2 Tiere wählen meist Reiz von 409 cm2 Steht in Einklang mit Spence-Theorie Alternative Erklärung: Tiere lernen die Relation zwischen den Reizen („Wähle den größeren Reiz“) Relationales Lernen (Lawrence & DeRivera, 1954) Karten in unterschiedlichen Grauschattierungen (1= weiß; 7 = schwarz) Ratten wurden trainiert, • sich nach rechts zu drehen, wenn obere Karte heller war • sich nach links zu drehen, wenn obere Karte dunkler war Ratten drehten sich nach links Ratten drehten sich nach rechts Tiere haben die relationale Information gelernt! Abbau unerwünschter Verhaltensweisen: Löschung und Bestrafung Arten von Verstärkern Verhaltenskonsequenz Angenehm Unangenehm Reiz erscheint nach Reaktion Positive Verstärkung (Belohnung) Bestrafung 1. Art Reiz verschwindet nach Reaktion Bestrafung 2. Art Negative Verstärkung (Flucht / Vermeidung) Reiz (Verhaltenskonsequenz) Angenehm Unangenehm Reiz erscheint nach Reaktion Futter, Lob, Geld Schmerz, Tadel Reiz verschwindet nach Reaktion Futter, Lob, Geld wird entzogen Schmerz, Tadel hört auf Abbau unerwünschter Verhaltensweisen 3 Möglichkeiten: • Bestrafung des unerwünschten Verhaltens • Löschung: die das Verhalten aufrechterhaltenden Verstärker entziehen • Alternativverhalten aufbauen, das das unerwünschte Verhalten ablöst Bestrafung kann sehr wirksam sein: • Eine einzige Lernerfahrung kann Verhalten eliminieren (z.B. heiße Herdplatte) Bestrafung und Zeitverzögerung 1.Phase: Ratten wurden trainiert, Hebel zu drücken, um Futter zu bekommen 2. Phase: Auf 50% der Hebeldrücke folgt ein Elektroschock sofort, nach 7,5 oder nach 30 Sekunden (Kontrollgruppe: gleiche viele Schocks, aber kein Zusammenhang zu den Reaktionen) Mittlere Anzahl von Reaktionen 80 70 60 50 40 30 20 10 0 0 7,5 30 Kontrolle Camp, Raymond & Curch, 1967 Intensität der Bestrafung Unterdrückung eines Verhaltens (Hebeldrücken) steigt mit Intensität der Bestrafung Ausmaß der Unterdrückung (%) 0,8 0,7 0,6 0,5 0,4 0,3 0,2 0,1 0 0 0,15 0,5 2 Stärke des Schocks (mA) Church, 1969 Kontingenz der Bestrafung Vortraining: Ratten lernten, Hebel zu drücken, um Futter zu bekommen Phase 1: • Experimentalgruppe: Elektroschocks unabhängig vom Verhalten • Kontrollgruppe: Nur Belohnung Phase 2: Beide Gruppen erhalten nur Belohnung Phase 3: Beide Gruppen erhalten reaktionskontingente Schocks Church, 1969 Reaktionsrate (% der Baseline) Kontingenz der Bestrafung 140 Nicht Erneutes Kontingente Training Kontingente Bestrafung (Belohnung) Bestrafung 120 100 80 60 40 Kontrollgruppe (keine Schocks in Phase 1) Exp.-gruppe Schocks in Phase 1) 20 0 Bestrafung war nur wirksam, wenn sie kontingent auf das Verhalten folgt Erfahrung nicht-kontingenter Bestrafung verhinderte späteres Lernen einer reaktions-kontingenten Bestrafung ( vgl. erlernte Hilflosigkeit) Konsequenzen nicht-kontingenter Bestrafung: Erlernte Hilflosigkeit Exp. von Overmier & Seligman (1967) / Maier & Seligman (1976) mit Hunden Phase 1: • Experimentgruppe: Glockenton -> unausweichlicher Stromstoß • Kontrollgruppe: Konnten Schock durch eigenes Verhalten vermeiden Phase 2: • Beide Gruppen Vermeidungstraining • Stromstoss wurde durch Ton angekündigt; Tiere konnten Stromstoss durch Sprung über eine Barriere vermeiden Ergebnis: • Kontrolltiere lernten schnell die Vermeidungsreaktion • Tiere der Experimentalgruppe zeigten Anzeichen von Furcht, aber machten keine Anstalten, dem Schock zu entfliehen „Erlernte Hilflosigkeit“: • Erfahrung, dass Bestrafung nicht durch eigenes Verhalten beeinflusst werden kann, erschwert Erwerb und/oder Ausführung instrumenteller Reaktionen • Tiere lernen, dass eigenes Verhalten keinen Effekt hat Konsequenzen nicht-kontingenter Bestrafung: Erlernte Hilflosigkeit Erlernte Hilflosigkeit bei Menschen Hiroto (1974) Phase 1: unangenehme laute Geräusche • Gruppe 1: Töne weder vermeidbar noch kontrollierbar • Kontrollgruppe 2: Töne nicht vermeidbar; per Knopfdruck abstellbar • Kontrollgruppe 3: keine Vorbehandlung Phase 2: Ton wurde durch 5 sec. Lichtsignal angekündigt und konnte durch Schieberegler abgestellt werden A.V: Latenzzeit für das Lernen Abstell-Reaktion Ergebnis: Gruppe 1 lernte langsamer als Gruppe 2 und 3 Interpretation: • Erfahrung der Unkontrollierbarkeit hat drei Effekte: (1) motivationales Defizit (keine Anstrengung zu fliehen) (2) kognitives Defizit (verzögertes Lernen) (3) emotionales Defizit (Apathie, „Depression“) Bestrafung und Verhaltensalternativen Unterdrückung eines Verhaltens durch Bestrafung ist sehr viel effektiver, wenn der Organismus eine alternative Verhaltensmöglichkeit hat Dies gilt insbesondere, wenn alternatives Verhalten zu Belohnung führt Anzrin & Holz (1966): • Phase 1: Tauben lernten, auf einen Schalter zu picken, um Futter zu erhalten • Phase 2: Auf Picken folgte Schock - Gruppe A: Taube konnte auf anderen Schalter picken - Gruppe B: Nur ein Schalter • Ergebnis: Tauben in Gruppe A zeigten stärkere Unterdrückung des Pickens auf den ursprünglichen Schalter Bestrafung und Verhaltensalternativen Reaktionen / min. 300 Alternative Reaktion verfügbar 250 200 150 keine alternative Reaktion verfügbar 100 50 0 0 20 40 60 80 Bestrafungsintensität (V) Negative Folgen von Bestrafung Bestrafung kann unter bestimmten Bedingungen zur Unterdrückung von jeglichem Verhalten führen Beziehung zwischen Bestrafendem und Bestraftem leidet (kann Ärger, Aggression und Täuschungsverhalten erzeugen) falsche Vorbildfunktion: Kinder könnten lernen, dass Bestrafung (Aggression) ein angemessenes Mittel zur Konfliktlösung ist Bestrafung unterdrückt oft lediglich Verhalten (Performanz); hohe Wahrscheinlichkeit, dass unerwünschtes Verhalten wieder gezeigt wird, sobald keine Bestrafung mehr erwartet wird Wenn Bestrafung, sollte stets erwünschtes Alternativverhalten ermöglicht und verstärkt werden Abbau unerwünschten Verhaltens durch Löschung Die das unerwünschte Verhalten aufrecht erhaltenden Bedingungen (Verstärker) identifizieren Entzug eben dieser Verstärker Beispiel: Kind erhält durch ständiges Stören mehr Aufmerksamkeit Löschung ist besonders effektiv, wenn gleichzeitig Alternativverhalten positiv verstärkt wird Negative Verstärkung: Flucht- und Vermeidungsverhalten Negative Verstärkung Verhalten kann verstärkt / aufrechterhalten werden, weil es Bestrafung vermeidet Exp. von Solomon & Wynne (1953): Hunde in Käfig mit Stahlgitter als Boden 10 Sek. Licht aus Licht aus Elektroschock Hund springt über Barriere in sicheren Käfig Hund springt über Barriere in sicheren Käfig Negative Verstärkung und Vermeidungsverhalten Vermeidungsverhalten kann sehr löschungsresistent sein Auch wenn kein Schock mehr gegeben wird, springen Hunde weiter (mitunter 200 mal) über Barriere (Solomon, Kamin, & Wynne, 1953) Latenz des Vermeidungsverhaltens nimmt sogar weiter ab Warum wird Vermeidungsverhalten nicht gelöscht wird, obwohl die Tiere nie mehr einen Schock erhalten? Vermeidungsverhalten verhindert, dass die Hunde lernen, dass die Kontingenz zwischen Licht und Schock gar nicht mehr besteht Erklärt die Aufrechterhaltung von Vermeidungsverhalten bei phobischen Ängsten (z.B. soziale Angst; Flugangst) Negative Verstärkung und Vermeidungsverhalten Wie kann Vermeidungsverhalten gelöscht werden? (1) Bestrafung (z.B. Schock) wird erteilt, obwohl das Vermeidungsverhalten gezeigt wird Organismus lernt, dass es keine Kontingenz zwischen Verhalten und Bestrafung gibt (2) Verhindern, dass das Vermeidungsverhalten ausgeführt wird Baum (1969): • Vermeidungstraining (Ton Schock Flucht) • Danach wurden Ratten daran gehindert, beim Ton in sicheren Teil des Käfigs zu flüchten • Nach kurzer Zeit hatten Ratten gelernt, dass es keine Kontingenz mehr zwischen Ton und Schock gab Klinische Anwendung: Reizkonfrontationstherapie bei Phobien Zwei-Prozess-Theorie des Vermeidungslernens (Mowrer, 1947) 1. Phase: Klassisches Konditionieren CS (Ton) US (Schock) UR (Angst) CR (Angst) CS (Ton) 2. Phase: Operantes Konditionieren Angstreaktion ist mit wahrnehmbaren inneren Reizen verbunden (z.B. Veränderung der Herzrate, Atmung, etc.) Vermeidungsreaktion Ton aus Angstreduktion (Vermeidungsreaktion wird als Fluchtreaktion (vor dem angstauslösenden CS) uminterpretiert) Probleme der Zweifaktorentheorie I Phase 1: Klassisches Konditionieren Wenn konditionierte Angst die Vermeidungsreaktion auslöst (bzw. Angstreduktion der Verstärker ist), sollte Angst umso größer sein, je stärker Vermeidungsreaktion ist Aber: Vermeidungsverhalten tritt auch auf, wenn CS keine Anzeichen von Furcht mehr auslöst (z.B. Kamin, Brimer, & Black, 1963) Nachdem Vermeidungsreaktion gelernt wurde, verschwinden oft Anzeichen von Angst (z.B. Solomon & Wynne, 1953) Alternative Erklärung: Gelernt wird nicht CS-CR-Assoziation (Ton-Furcht), sondern CS-USAssoziation (Ton-Schock) CS (Ton) Antizipation des US (Schock) Vermeidungsreaktion wird durch Antizipation des US ausgelöst Probleme der Zweifaktorentheorie II Phase 2: Operantes Konditionieren Zweifaktorentheorie: Elimination des CS und damit verbundene Angstreduktion soll verstärkend sein Aber: Elimination des CS ist gar nicht nötig für Vermeidungslernen Kamin (1956): Tiere lernen Vermeidungsverhalten, auch wenn der CS nach dem Vermeidungsverhalten andauerte Probleme der Zweifaktorentheorie II Sidmans (1953, 1966): Freie operante Vermeidung • • • • Schock kommt ohne Warnung (kein äußerer CS) Tier kann Schock für 30 Sekunden aufschieben, indem es Hebel drückt Tiere lernen, Schock komplett zu vermeiden, indem sie Hebel rechtzeitig drücken Vermeidungsverhalten obwohl kein CS durch das Verhalten eliminiert wird (a) Wenn das Individuum nicht reagiert, wird alle 5 Sekunden ein Schock verabreicht. a) Elektroschocks Reaktionen Zeit (Sekunden) 0 20 40 60 30 Sekunden (b) Jede Reaktion verschiebt den nächsten Schock um 30 Sekunden. b) 80 100 30 Sekunden Elektroschocks Reaktionen Zeit (Sekunden) 0 20 40 60 80 100 Schlussfolgerung und alternative kognitive Erklärung Lebewesen lernen Kontingenzen zwischen CS, Reaktionen und Verhaltenskonsequenzen Dies ermöglicht es, negative Konsequenzen zu antizipieren und Verhalten auszuwählen, dass negative Konsequenzen vermeidet Kontiguität vs. Kontingenz: Instrumentelles Konditionieren als kausale Inferenz Zeitliche Kontiguität Dickinson et al. (1992): Kürzere Abstand zwischen Verhalten und Verstärkung effektivere Konditionierung Effekte der Verzögerung zwischen Reaktion und Konsequenz auf die Lerngeschwindigkeit Schlinger & Blakely, 1994 Gluck, Mercado and Myers: Learning and Memory. © 2008 by Worth Publishers Abergläubisches Verhalten Skinner (1948): • • • • Tauben erhielten alle 15 s Futterkörner Futtergabe war völlig unabhängig vom Verhalten (fixer Intervall-Plan) Viele Tiere zeigten mitunter bizarre Verhaltensweisen (Z.B. mehrmals gegen den Uhrzeigersinn drehen) Tauben verhielten sich so, als ob sie glaubten, dass sie durch ihr Verhalten die Verstärkergabe kontrollieren konnten Erklärung: • • • vor jeder Verstärkung zeigen Tiere zufällig irgendein Verhalten, dessen Wahrscheinlichkeit durch die Verstärkung erhöht wird Dies erhöht die Wahrscheinlichkeit, dass dieses Verhalten (zufälligerweise) erneut vor der Verstärkergabe auftritt weitere Verstärkung Im Lauf der Zeit können sich so komplexe Verhaltensmuster bilden (analog zu „natürlicher Selektion“) Abergläubisches Verhalten: Folgestudien und Reinterpretation Staddon & Simmelhag (1971): Verstärker Interimsverhalten Diverse Verhaltensweise (Picken, Drehen etc.), für die das Lebewesen angeborene Disposition hat, wenn kein Verstärker erwartet wird Verstärker Endverhalten Antizipatorische Reaktionen (z.B. Picken in der Nähe des Futterspenders) Verhalten ist weniger „abergläubisch“, sondern Anpassung an zeitliche Struktur des Verstärkungsplans Abergläubisches Verhalten: Einschränkungen Staddon & Simmelhag (1971): • nach nicht-kontingenter Verstärkung zeigten Tauben (wie von Skinner beschrieben) alle möglichen Verhaltensweisen • unmittelbar vor der Verstärkung zeigten Tauben antizipatorische Reaktionen (insb. Picken in Erwartung des Futters) • Verhalten ist also viel weniger „abergläubisch“, sondern Anpassung an zeitliche Struktur des Verstärkungsplans Reine Kontiguität reicht normalerweise nicht aus, um Verhalten zu verstärken, sondern Organismen lernen Kontingenzen zwischen Verhalten und Verstärkern Kontiguität vs. Kontingenz Hammon et al. (1980): Ratten wurden trainiert, Hebel zu drücken, um Futter zu erhalten Reaktion innerhalb 1 s 5% Chance eines Verstärkers 5% Chance eines Verstärkers nach 1 s egal ob Reaktion oder nicht Wie Phase 1 Wie Phase 2 Instrumentelles Konditionieren als kausale Inferenz Wasserman (1990) Vpn konnten Taste drücken Dies führte manchmal dazu, dass Licht aufleuchtete UV1: p(Licht|Taste) = 0; 0.25; 0.5; 0.75; 1.0 UV2: p(Licht|keine Taste) = 0; 0.25; 0.5; 0.75; 1.0 vgl. Rescorla-WagnerTheorie des klassischen Konditionierens! (O = Outcome; R = Response) Allgemeinere Schlussfolgerungen Organismen lernen kausale Regularitäten, die es ermöglichen, Effekte des eigenen Verhalten zu antizipieren Dies ermöglicht es Organismen, sich adaptiv („rational“) zu verhalten = Verhalten zu selektieren, dass positive Konsequenzen hat und negative Konsequenzen zu vermeiden Adaptives Verhalten muss nicht auf bewusster Überlegung oder Einsicht in die relevanten Kontingenzen beruhen Relativ einfache assoziative Mechanismen können Verhalten erzeugen, das rational und zielgerichtet erscheint Biologische Einschränkungen beim operanten Konditionieren Biologische Einschränkungen beim operanten Konditionieren: Instinktive Drift Breland & Breland (1961): • Trainierten Waschbären, Holzmünzen aufzuheben und in einen Behälter zu legen • Tiere zeigten nach kurzer Zeit nicht verstärkte Verhaltensweisen (z.B. „Waschen“ der Münzen) machte Trainingsprogramm zunichte • Entspricht artspezifischem Verhalten bei der Nahrungssuche • Analoge Ergebnisse für andere Spezies Wie beim Klassischen Konditionieren wird Effizienz des Lernens durch biologische Lernbereitschaften beeinflusst Breland, K. & Breland, M. (1961) The misbehavior of organisms. American Psychologist, 16, 681-684. Biologische Einschränkungen beim operanten Konditionieren: Autoshaping Brown & Jenkins (1968): • Tauben wurden trainiert, aus Futterspender zu fressen • Im Abstand von durchschnittlich 60 Sek. leuchtete Reaktionstaste für 8 Sek. Auf; danach wurde Futter präsentiert • Obwohl Futtergabe unabhängig vom Verhalten erfolgte, begannen Tauben, auf die beleuchtete Taste zu picken Biologische Einschränkungen beim operanten Konditionieren: Reizmerkmale Organismen sind biologisch prädisponiert, bestimmte Reize als bedeutsam zu betrachten und andere zu ignorieren Foree & LoLordo (1973): • Trainierten Tauben mit kombiniertem CS (Licht + Ton) • Wenn Verstärker Futter war, wurde Verhalten durch Licht kontrolliert • Wenn Verstärker Schock war, wurde Verhalten durch Ton kontrolliert Interpretation • Visuelle Information ist in natürlicher Umwelt kritisch, um Futter zu identifizieren • Geräusche signalisieren oft Gefahr Biologische Einschränkungen beim operanten Konditionieren: Reaktionsmerkmale Shettleworth (1975): Hamster zeigten bestimmtes Verhalten, wenn sie hungrig waren • Auf Hinterbeine aufrichten (open rear) • An Wänden kratzen (scrabbling) • Graben (digging) Andere Verhaltensweisen traten nicht häufiger auf • Waschen; kratzen; markieren Experiment: • Hamster wurden für unterschiedliche Verhaltensweisen mit Futter belohnt Tiere sind biologisch prädisponiert, bestimmte Reaktions-Verstärker Assoziationen besser zu lernen als andere Mittlere Zeit, die die verstärkte Reaktion innerhalb 120 sek ausgeführt wurde