Brainstorms - Eine Einführung in die Computational

Werbung

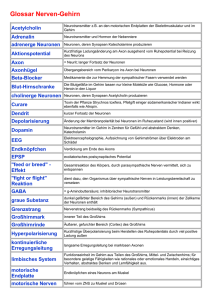

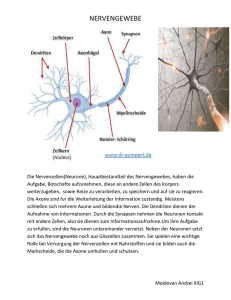

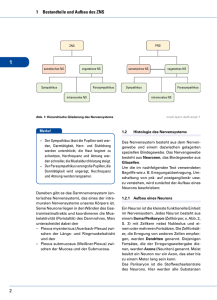

Brainstorms - Eine Einführung in die Computational Neuroscience Version 1.1 16. Oktober 2003 Dominik Schnitzer1 Ein Einstieg in die Computational Neuroscience. Im ersten Teil dieser Arbeit werden nach einem kurzen neurobiologischen Überblick, verschiedene Typen realistischer Neuronenmodelle vorgestellt, die in der Informatik Verwendung finden. Im zweiten Teil ist das praktische Anwendungsfeld der Computational Neuroscience Thema - Neuromorphic Engineering. Es werden bereits funktionierende Anwendungen, wie zum Beispiel eine künstliche Retina oder ein Geruchslokalisierungssystem, vorgestellt. 1 <[email protected]> Inhaltsverzeichnis 1 Simulation des Gehirns? 1.1 Forschung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3 3 2 Neurbiologische Grundlagen 2.1 Neuronen . . . . . . . . . . . . . . . . 2.1.1 Typen von Nervenzellen . . . . 2.1.2 Aufbau und Funktionsweise von 2.2 Messen von Neuronaler Aktivität . . . . . . . . . . . . . . . Neuronen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4 4 4 5 6 3 Neuronenmodellierung 3.1 Integrate and Fire Model . . . . . . . . 3.1.1 Leaky Integrate and Fire Model 3.2 Rate Model . . . . . . . . . . . . . . . 3.3 Conductance Model . . . . . . . . . . . 3.4 Kinetische Modelle von Ionenkanälen . 3.5 Modelle Synaptischer Veränderung . . 3.6 Multikompartmentmodelle . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8 8 9 9 10 10 11 11 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4 Neurocomputing 12 4.1 Neuron, Genesis und NSL . . . . . . . . . . . . . . . . . . . . . . . . . . 13 5 Neuromorphic Engineering 5.1 Eine Künstliche Retina . . . . . . . . . . . 5.1.1 Der Aufbau der natürlichen Retina 5.1.2 Implementation . . . . . . . . . . . 5.2 NOSE . . . . . . . . . . . . . . . . . . . . 5.3 Andere Wahrnehmungen . . . . . . . . . . 5.4 Verrückteiten? . . . . . . . . . . . . . . . . 6 Fazit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13 14 14 15 15 16 17 18 2 1 Simulation des Gehirns? Das Gebiet der Computational Neuroscience befasst sich mit der Emulation von neuronalen Abläufen am Computer. Es wird versucht Nervennetzwerke zu verstehen, die Abläufe darin modellierbar zu machen um in Folge die sehr effizient ablaufenden Denkund Signalverarbeitungsprozesse im Gehirn am Computer zu verwenden. Motivation dafür sind die hervorragenden Datenverarbeitungsqualitäten des Gehirns, die denen moderner Computer in vieler Hinsicht überlegen sind. Zwar scheint eine Emulation eines Neuronennetzwerks auf den ersten Blick gar nicht so vorteilhaft: Niedrige Verarbeitungsgeschwindigkeit (Ungefähre Taktfrequenz des Gehirns: 300Hz) und manchmal unvorhersehbare Ergebnisse (Irren ist Menschlich) sind Features, die die Verwendung eines Neuronenmodells zur Problemlösung in der klassischen Informatik vielleicht unbrauchbar erscheinen lassen. Ein zweiter genauerer Blick offenbart aber Vorteile, die in der modernen Datenverarbeitung sehr hohen Stellenwert besitzen: Ausfallssicherheit/Stabilität. Durch den hohen Vernetzungsgrad der Nervennetze führen Einzelausfälle von Knoten nicht zu einem Gesamtausfall des Netzwerks, und haben nur sehr geringe negative Auswirkungen auf das Verhalten des Gesamtnetzes. Sehr Hohe Parallelität in der Signalverarbeitung. Durch den großen Vernetzungsgrad eines Nervennetzes kann die Datenverarbeitung sehr schnell durchgeführt werden. Durch den hohen Vernetzungsgrad wird außerdem der Nachteil der relative langsamen Datenübertragung zwischen Nerven wieder wett gemacht, da so tausende Signale parallel verarbeitet werden können. Überlegenheit in der Verarbeitung. In vielen Bereichen wie zum Beispiel im Bereich der Mustererkennung, Informationsspeicherung oder Reizverarbeitung sind die Lösungen der Natur den aktuellen Techniken weit überlegen und schon mehrere Millionen Jahre erfolgreich im Einsatz. 1.1 Forschung In der Computational Neuroscience treffen sich zwei Forschungsgebiete: Informatik und Neurobiologie. Auf der informatischen Seite der Computational Neuroscience stehen Algorithmen und Techniken im Vordergrund, die sich das gewonnene Modellwissen zunutze machen und in andere Projekte integrieren, die mit der eigentlichen Herkunft des Neuronenmodells oft nicht mehr viel zu tun haben. Beispielsweise wird von Autoherstellern in Anlehnung an das menschliche Auge an Sensoren geforscht, die das Auto selbstständig in der Autobahnspur halten können, bzw. Alarm geben können wenn das Auto die Spur zur Straßengrenze überquert[1]. Vom biologischen Standpunkt aus gesehen sind in der Computational Neuroscience vor allem möglichst genaue Nachbildungen von Neuronennetzwerken von Interesse - um mit 3 den Erkenntnissen beispielsweise die Effekte von Drogen oder anderen Stoffen auf das Nervennetz zu simulieren und erforschen zu können[3]. In dieser Ausarbeitung werden Modelle, die sowohl für die informatische als auch biologische Seite wichtig sind vorgestellt. Anhand der Komplexität eines Modells und der verwendeten Parameterwerte lässt sich ein Modell generell sehr leicht dem informatischen oder biologischen Anwendungsfeld zuordnen - komplexe Modelle sind eher der Biologie zuordenbar, simple und damit schnell berechenbare Modelle der Informatik. Natürlich ist diese Zuordnung nicht immer korrekt, verdeutlicht aber sehr gut die für die einzelnen Gebiete wichtigen Ziele: Hohe biologische Exaktheit steht auf der einen Seite, gute und schnelle Anwendbarkeit auf der anderen-informatischen Seite gegenüber. 2 Neurbiologische Grundlagen Um die hier nun vorgestellten Neuronennetzwerkmodelle besser zu verstehen, wird die den Modellen zugrundeliegende Biologie besprochen. Grundbegriffe werden definiert und grundlegende Funktionsweisen der Informationsübermittlung in Nervenzellen erläutert. 2.1 Neuronen 2.1.1 Typen von Nervenzellen Es existieren eine Vielzahl verschiedener Nervenzellentypen. Grundsätzlich unterteilt man diese in folgende Gruppen: Sensorische Nervenzellen. Nehmen Reize (wie z.B. Druck, Temperatur, Schall, Licht) auf und leiten diese über Nevenfasern elektrisch weiter. Motorische Nervenzellen. Steuern die Muskeln. Interneuronen. Sind Nervenzellen zur Weiterleitung und Verarbeitung von Informationen. Interneuronen stellen den größten Teil der Neuronen dar. Abgesehen von den drei gerade vorgestellten Nervenzellengrundtypen unterscheiden diese sich untereinander noch signifikant durch Struktur und Größe. Es existieren innerhalb der drei vorgestellten Gruppen noch viele verschiedene Nervenzellen. Aus der Vielfältigkeit der Neuronen in der Natur ergeben sich auch in der Modellierung viele verschiedene Neuronenmodelle. Eine Computermodellierung von Neuronen muss die unterschiedlichen Parameter der Neuronen in Betracht ziehen. Abbildung 1 stellt zwei verschiedene Neuronen gegenüber. Die Kleinhirnzelle besitzt gegenüber der Zelle aus der Retina einen hoch verzweigten Dendritenbaum und damit viel mehr potentielle Anknüpfungspuntkte an andere Nervenzellen. 4 Abbildung 1: Links: Eine Kleinhirnzelle, Rechts: Eine Nervenzelle aus der menschlichen Retina[1] 2.1.2 Aufbau und Funktionsweise von Neuronen So viele verschiedene Nervenzellentypen und Untertypen es auch gibt, besitzen sie aber prinzipiell alle den selben Aufbau. Das Neuron ist in drei unterscheidbare Regionen unterteilt: Den Zellkörper (Soma) mit Zellkern (Nucleus), den Dendritenbaum sowie einen fadenförmigen Fortsatz, das Axon oder die Nervenfaser. Die Dendriten sind für den Empfang von Signalen zuständig und mit Axonen benachbarter Neuronen verbunden. Das Axon hat die Aufgabe, Signale zu anderen Neuronen weiterzuleiten, die vom Zellkörper des Neurons kommen. Es verästelt sich an seinem Ende wieder und jeder dieser Zweige führt zu einer Synapse. Die Weiterleitung von Signalen innerhalb einer Nervenzelle passiert auf Basis des selektiven Inonentransports durch die halbdurchlässige Zellmembran[2]. Die Trägerstoffe sind dabei Na+, Cl- und K+ Ionen. In der Zellmembran existieren Ionenpumpen und Ionenkanäle durch welche die Ionen die Zellwand durchdringen und Signale weiterleiten können. Im sogenannten Ruhezustand einer Nervenzelle sind die Ionenkanäle geschlossen und die Ionenpumpen erzeugen ein Konzentrationsgefälle, das zu einer Potentialdifferenz zwischen dem Zellinneren und dem Zelläußeren führt. Diese Potentialdifferenz nennt man Membranpotential. Im Ruhezustand ergibt sich durch die Ionenkonzentration im Ruhezustand ein Membranpotential von ungefähr -70 mV (VN a+ = +45mV, VK+ = −87mV, VCl− = −67mV ). Wird die Zelle über diese -70mV hinaus polarisiert nennt man das Hyperpolarisation, das Ansteigen der Spannung Depolarisation. Ein Depolarisationsprozess setzt dann ein, wenn im Zellkörper ein Grenzwert von 45mV überschritten wird. Durch diesen elektrischen Prozess werden die Ionenkanäle der positiven Na+ Ionen geöffnet und das Potentialgefälle steigt für 0.5ms auf +40mV 5 an. Unmittelbar danach setzt die sogenannte Repolarisationsphase ein, die durch die Öffnung der K+ Ionenkanäle veranlasst wird. Dieser Vorgang dauert solange, bis sich wieder ein negatives Potential aufgebaut hat, das mit -80mV kurz einen Wert deutlich unter dem Ruhepotential erreicht. Der Impuls der durch diesen Prozess entstanden ist wird Aktionspotential oder Spike genannt. Die Entstehung eines Aktionspotentials setzt das Überschreiten der -45mV-Grenze voraus. Damit basiert die Signalweiterleitung und -verarbeitung im Neuron auf einem alles oder nichts Grundsatz, und ist mit der digitalen Signalverarbeitung gut vereinbar und gut modellierbar. Der Spike hat insgesamt eine Dauer von 1-2ms und wandert als Welle entlang dem Axon. In den nachfolgenden 1-2ms kann kein weiteres Aktionspotential entstehen. Diese Zeitspanne nennt man Refraktärzeit. In 2-4ms ist das normale Ruhepotential einer Nervenzelle wiederhergestellt. Während das Signal innerhalb der Nervenzelle elektrisch weitergeleitet wird, wird die Information zwischen zwei Zellen auf biochemischen Weg weitergegeben - es existieren keine elektrischen Verbindungen zwischen Axon und dem angewachsenen Dendrit der nächsten Nervenzelle. Das Axon verästelt sich an seinem Ende und jeder Zweig endet im sogenannten präsynaptischen Ende, das in den Vesiklen die chemischen Botenstoffe, die Neurotransmitter, beinhaltet. Ein ankommendes Spike verursacht im präsynaptischen Ende die Öffnung der Ca+ Kanäle. Dort werden dann Neurotransmitter freigesetzt, diese wandern über den synaptischen Spalt und werden schließlich von den Neurorezeptoren an einem Dendritenende des Nachbarneurons empfangen. Die Übertragung eines Aktionspotentials in ein postsynaptisches Potential dauert etwa 1ms. Eine Vesikelöffnung transportiert dabei die kleinste Einheit an Information und wird als Quantum bezeichnet. Insgesamt wurden hier nach dem schon vorgeschlagenem Parameter Verzweigungsgrad der Dendriten wieder eine Vielzahl von Parametern vorgestellt, die eine wichtige Rolle bei der Modellierung von Neuronennetzwerken spielen könnten und damit Neurocomputing wichtig und sein könnten: Die Signallaufzeiten, Spikes, elektrischen Potentiale oder gar die Funktionsweise der Ionenkanäle/-pumpen. 2.2 Messen von Neuronaler Aktivität Um Neuronale Abläufe vor der versuchten Modellierung nun auch tatsächlich experimentell zu messen und zu überprüfen stehen Forschern mehrere Methoden zur Verfügung: 1. EEG - Das Elektronenenzephalogramm ist die bekannteste Technik um Gehirnaktivität zu messen. Es werden der Testperson dazu elektrische Kontakte am Kopf angebracht, die die elektrischen Signale die bei Reizen im Gehrin entstehen aufzeichnen sollen. Es kann beim EEG eine sehr hohe Zeitliche Auflösung erreicht werden. Leider kann aber nicht genau bestimmt werden wo ein Nervenimpuls tatsächlich stattgefunden hat. In Kombination mit anderen Techniken kann dieser Nachteil aber relativ minimiert werden. Abbildung 2 zeigt eine Versuchsperson mit angebrachter Messhaube. 6 Abbildung 2: Versuchsperson mit Messhaube für das EEG[1] Abbildung 3: Tracer Stoff Calcium Green in einer Kleinhirnzelle[4] 2. PET - Die Positronenemissionstomographie verwendet radioaktive Stoffe um Nervenaktivität zu messen. Grundgedanke ist, dass Regionen mit stärkerer neuronaler Aktivität einen höheren Blutdurchlauf besitzen. Das bei der PET meist intravenös injizierte Radiopharmakon gelangt so relativ schnell in die aktiven Hirnregionen. Radioaktive Stoffe können sehr leicht gemessen werden. So kann in der PET das Zentrum Neuronaler Aktivität sehr genau lokalisiert werden. Die Kehrseite davon ist, dass die Radioparmakone einige Zeit brauchen bis sie im Blutkreislauf an der angeregten Stelle angekommen sind und dadurch das Ergebnis einer PET zeitlich schlecht aufgelöst ist. Wie schon im vorigen Punkt angesprochen, kann man durch Kombination von PET und EEG aber insgesamt zeitlich und räumlich hoch aufgelöste Ergebnisse erzielen. 3. Neuronfärbungen - Neben radioaktiven Tracer Stoffen, wie sie in der PET verwendet werden, werden auch Ladungssensitive Stoffe eingesetzt, die mit Änderung des Zellmembranpotentials ihre Farbe ändern. Neuronenaktivität wird dann mit einem hochauflösenden Mikroskop beobachtet. Abbildung 3 zeigt eine Anwendung des Tracer Stoffs Calcium Green in einer Kleinhirnzelle[4]. 4. Elektrische Kontakte - Wenn kleine Neuronennetzwerke beobachtet werden sollen, werden auch manchmal an die Neuronen Metallnadeln eingesetzt, die dann direkt zum Messen der elektrischen Signale verwendet werden. Interessant ist, dass Krankheiten in Gehirnregionen auch bei der Erforschung von Nerofunktionen hilfreich sind. Da bei einer Nervenkrankheit meistens ein Stoff plötzlich fehlt oder übermäßig produziert wird, kann auf Grund der Auswirkungen einer Krankheit festgestellt werden welche Aufgabe ein Stoff hat oder hätte. Zum Beispiel wird bei Alzheimer Patienten im Hippokampus eine stark verringerte Glutamat Konzentration gemessen[3]. Glutamat ist der häufigste Neurotransmitter im Gehirn. Diese Beobachtung ist damit einer der vielen Erklärungsansätze für die Demenz. 7 3 Neuronenmodellierung Es gibt viele verschiedene Ansätze, Neuronen und Neuronennetzwerke zu modellieren. Hier wird von dem einfachsten Modell, dem Integrate and Fire Model, ausgegangen. Mit jedem weiteren vorgestellten Modell steigt die Komplexität des Modells bis zu Neuronenmodellen, die sehr genau sogar die Ionenkanal-Ladungen der ihnen unterliegenden Partikel beschreiben. Mit steigender Genauigkeit ändert sich auch das tatsächliche Einsatzfeld des Modells in der Computational Neuroscience. Während es beispielsweise zur Modellierung eines Problems der Audiosignalverarbeitung absolut ausreichend ist das einfache Integrate and Fire Model anzuwenden, ist diese Herangehensweise in biologischen Fragestellungen, zum Beispiel der Erforschung von Einflüssen bestimmter Stoffe auf ein Neuronennetz, unpraktikabel. In so einem Fall wird man auf ein Netzwerk zurückgreifen, dass ein Neuron sehr detailliert beschreibt und beispielsweise die Integration von Neurotransmittern oder hemmender Signalübertragung im Modell selbst überhaupt erlaubt. Weiters wird in einem Punkt noch auf Aspekte und Phänomene eingegangen, die für realistische Neuronennetzwerke von großer Bedeutung sind: Plastische Veränderungen von Synapsenverbindungen, die die Basis des Lernens und der Erinnerung bilden. 3.1 Integrate and Fire Model Dem Integrate and Fire Model liegt die Idee zugrunde, dass die Spike Zeit und das Muster mit dem die Spikes am Neuronennetzwerk austreten, die wichtigsten Faktoren des Output eines Neuronennetzwerks sind. Mathematisch gesehen wird das Integrate and Fire Model durch folgende Gleichung beschrieben[5]: I(t) = Cm dVm dt (1) Cm ist die Kapazität des Neurons, Vm das Membranpotential. I(t) ist der über die Zeit aufsummierte Strom, der über die Synapsen von den benachbarten Neuronen hineinkommt. Wird ein vordefinierter Grenzwert überschritten, wird ein Aktionspotential aufgebaut und das Neuron feuert. Neben der Feuergrenze kann man in das Modell auch sehr einfach andere Parameter einbauen, die es verbessern. Die wohl wichtigste Erweiterung ist die Einführung der Refraktärzeit, der Zeit in der das Neuron kein weiteres Mal feuern kann. Das lässt sich sehr einfach mit der Angabe einer maximalen Feuerfrequenz implementieren, die sich ja unmittelbar aus der Länge der Refraktärzeit ergibt: fmax = 1/tpol Durch zusammenschalten mehrerer solcher Neuronen, kann leicht ein ganzes Netzwerk erzeugt werden: Die Ausgänge/Axon-Enden eines Neurons werden mit den Eingängen anderer Neuronen verbunden. Ein Aktionspotential wird als Funktion repräsentiert und die Neuronen eventuell vorliegenden Parametern genauer beschrieben. Eine Beispielanwendung, in der ein Integrate and Fire Model angewendet wird wird im Abschnitt über 8 das Neuromorphic Engineering gegeben. Dabei wird ein Geruchssensor-Roboter mit einem Integrate and Fire Model betrieben. 3.1.1 Leaky Integrate and Fire Model In einer Erweiterung des Integrate and Fire Model wird durch das Einbeziehen eines Leak-Stroms (”Leak Current”) das Modell erweitert. Dabei wird durch die Erweiterung um einen Leak-Strom erreicht, dass älterer Eingangsstrom mit der Zeit weniger stark gewichtet wird. Somit verblassen ältere Neuronenerregungen mit der Zeit immer mehr. Diese Erweiterung ist sehr einfach durchzuführen und macht das Modell aber durch die Integration des Abklingens älterer Erregungen, mit einer sehr einfachen Methode sehr viel realistischer. Technisch gesehen wird im Schaltplan eines solchen Neurons parallel zum Kondensatorstromkreis, der das normale Integrate and Fire Model beschreibt, ein Widerstand geschalten. Der Gesamtstrom I setzt sich damit dann aus dem Strom IKondensator und ILeak−Strom (dem Strom des gerade beschriebenen Leakstromkreises) zusammen[5]. Im = Cm Vm dVm + dt Rm (2) 3.2 Rate Model In vielen Fällen wird zur Neuronenmodellierung auch das einfache Rate Model herangezogen. Ein Neuron wird durch dessen maximalen Feuerrate beschrieben. Der Output eines solchen Neurons wird durch eine sigmoide Funktion beschrieben, die Feuerrate und Membranpotential miteinbezieht. Eine sigmoide Funktion ist eine s-förmige Funktion, die stetig ansteigt und differenzierbar ist. Die aktuelle Feuerrate zi (t) eines Neurons i zum Zeitpunkt t berechnet sich dabei normalerweise mit folgender sigmoiden Funktion[5]: zi (t) = zmax 1 + e−bVm (t)−θ (3) Durch das Einbeziehen der maximalen Feuerrate zmax wird die Repolarisationsperiode im Modell berücksichtigt. Der Faktor b beeinflusst den Anstieg und den Grenzwert der Erregung des Neurons. Somit kann man durch Variation dieser Parameter sehr leicht verschiedene Neuronentypen modellieren. Ein großer Vorteil dieser einfachen Neuronenbeschreibung ist, dass gerade durch die Einfachheit, große Netzwerke effizient beschrieben werden können. Im Gegensatz zu den Integrate and Fire Modellen liegt hier aber die Überlegung im Vordergrund, dass nicht Spike-Synchronisation oder die genaue Zeit des Feuerns eines Neurons die im Netzwerk transportierte Information beschreibt, sondern vielmehr die Feuerrate allein. 9 3.3 Conductance Model In vielen Arbeiten der Neurowissenschaft, werden Neuronennetzwerke auf Basis der den Neuronen zugrundeliegenden Ionenkanäle beschrieben. Das kommt von der Tatsache, dass das bekannteste Conductance Model auch das in der Neurobiologie meist angewandte Modell ist, nämlich das Hodgkin Huxley Modell. Dieses Modell beschreibt das Neuron durch Modellierung seiner einzelnen Ionenkanäle. Es wurde in den frühen 50er Jahren von A. L. Hodgkin und A. F. Huxley entwickelt. Für diese Entwicklung wurde ihnen später auch der Nobelpreis verliehen. Da sich sehr viele Neurowissenschaftler in ihren Experimenten direkt auf das Hodgkin Huxley Modell bezogen haben, liegen heutzutage viele echte experimentelle Ergebnisse für Neuronennetzwerke auf Basis des Hodgkin Huxley Modells vor. Durch dieses Faktum ist das Hodgkin Huxley Modell auch in der Computational Neuroscience sehr wertvoll - Viele Parameter von Modellen brauchen nur nachgeschlagen werden. Im Hodgkin Huxley Modell sind die Ionenkanäle als Widerstände oder Kondensatoren beschrieben, die in einer Parallelschaltung zusammengeschalten werden. Eine grundsätzlich ähnliche Schaltung wurde schon bei den Leaky Integrate and Fire Models vorgestellt. Hier werden aber zusätzlich zum Leak-Strom weitere Widerstände dazugeschalten, die die einzelnen Ströme der Ionenkanäle beschreiben. Eine mathematische Beschreibung einer Thalamuszelle sieht beispielsweise so aus: Cm dV = IT − Ih − IN a − IK − Il − IGABAA − IGABAB dt (4) Die Ströme IT , Ih , IN a , IK und ILeak−Strom sind interne Ströme, IGABAA und IGABAB sind synaptische Ströme. Weiters werden im Hodgkin Huxley Modell ”Gates” für die Ionenkanäle verwendet, die festlegen ob ein Ionenkanal durchlässig ist oder nicht. Der Status eines Gates, also ob der Zustand offen oder geschlossen ist kann aus dem Membranpotential errechnet werden. 3.4 Kinetische Modelle von Ionenkanälen Die mit dem Hodgkin Huxley Modell vorgestellte Modellierung von Ionenströmen beschreibt die eigentlichen Vorgänge in den Ionenkanälen für manche Anwendungen noch auf sehr ungenaue Weise. Deshalb geht man in einem weiteren Schritt noch eine Detailstufe tiefer, und probiert die Ionenkanäle durch ihre Gate Partikel und deren Übergangsfunktionen noch genauer nachzubilden[5]. Beispielsweise wird in solchen Modellen ein K-Ionenkanal durch 4 Gates beschrieben. Jedes dieser Gates kann entweder offen (1) oder geschlossen (0) sein. Erst wenn alle vier Gates im Zustand 1 sind leitet der Ionenkanal. Damit kann ein einziger Ionenkanal vom Status (0000) durch 14 verschiedene Stadien gehen, bevor er offen (1111) ist. Das kann glücklicherweise durch Annahmen, dass es sich bei den Übergängen um einen Markov Prozess handelt und die manche Zustände kinetisch identisch sind (z.B. 0001 und 1000) auf 5 verschiedene Stadien reduziert werden. 10 3.5 Modelle Synaptischer Veränderung Nach der Hebbschen These, wird Lernen durch gezielte Anpassung der Stärke einzelner Synapsen realisiert. Die Idee beruht auf der Annahme, dass ein Neuronennetzwerk nicht starr ist, sondern sich dynamisch und flexibel auf die gespeicherten Informationen und den Informationsfluss anpasst. Langzeitige synaptische Veränderungen werden laut Hebb durch erhöhte Erregung von Neuronenverbindungen verursacht[6]. Diese These von Hebb wurde mittlerweile schon durch Experimente nachgewiesen. Als Beispiel für ein primitives Neuronennetz, das nach Hebb lernt, kann man das bekannte Experiment des Pawlowschen Hundes heranziehen: Jedes Mal wenn der Versuchshund etwas zu Essen vorgesetzt bekommt, wird eine Glocke geläutet. Das wird öfters wiederholt. Der Hund lernt, dass das Glockenläuten mit dem Essen in Zusammenhang steht. Nun wird in dem Experiment die Glocke geläutet, ohne dass Essen gebracht wird. Trotzdem kein Essen angerichtet wurde, kann man beim Versuchshund erhöhten Speichelfluss feststellen. Um das Experiment mit einem Neuronenmodell nachzubilden braucht man 3 Neuronen: Wahrnehmen-von-Essen, Wahrnehmen-von-Glocke und Speichelfluss-aktivieren. Neuron Wahrnehmen-von-Glocke und Wahrnehmen-von-Essen sind jeweils mit dem Neuron Speichelfluss-aktivieren verbunden. Im Normalfall reicht es aus dass der Hund Essen in Irgendeiner Form wahrnimmt um den Speichelfluss zu aktiveren. Neuron Wahrnehmenvon-Glocke ist nur ganz schwach mit dem Speichelfluss Neuron verbunden, ein Glockenläuten hat zu Beginn also praktisch gar keine Verbindung mit dem Speichelfluss. Dadurch dass im Experiment aber gleichzeitig zum Essen auch immer das Neuron Wahrnehmen-vonGlocke aktiviert wird, verstärkt sich dessen Bindung zu Speichelfluss-aktivieren mit jeder Durchführung des Experiments, bis die Bindung zum Neuron so stark ist dass allein ein Läuten der Glocke schon den Speichelfluss beim Hund bewirkt. Abbildung 4 zeigt, wie sich synaptische Verbindungen bei einem Kleinkind entwickeln. Es existieren mehrere verschiedene Vorschläge zur Implementation von Synapsenmodifikationen. Grundsätzlich wird zwischen kurz anhaltende (Sekunden bis Minuten) und länger anhaltende Änderungen unterschieden. Ein Modell für kurzzeitige Synaptische Änderungen wurde von Abbot 1997 vorgeschlagen[5]. 3.6 Multikompartmentmodelle Neuronen bestehen eigentlich aus hochverzweigten Dendriten und Axonbäumen. Modelle, die die Art der Verzweigungen und den Verzweigungsgrad in ihre Modelle miteinbeziehen, fallen in die Kategorie der Multikompartmentmodelle. In dieser Herangehensweise werden die in den Dendritenästen auftretenden Ionenströme untersucht und das Neuron daraufhin in mehrere Kompartments unterteilt. Rall beschäftigte sich damit erstmals 1964 in seinen Arbeiten, indem er den Dendritenbaum eines Neurons durch komplizierte Kabelgleichungen beschrieben hat[5]. Dieser Lösungsweg ist sehr kompliziert und ist in 11 Abbildung 4: Die Entwicklung der synaptischen Verbindungen bei einem Kleinkind.[1] vielen Anwendungsfällen gar nicht notwendig. Es wurde aber gezeigt, dass manche Neuronennetze, die mit einfachen Kompartmentmodellen fehlerhaftes Verhalten an den Tag legen, nur mit Multikompartmentmodellen korrekt funktionieren. 4 Neurocomputing Um ein Neuronenmodell zu implementieren, gibt es generell zwei verschiedene Möglichkeiten: Den analogen oder den digitalen Weg. Eine analoge Implementation eines Neuronennetzwerks, also in Form eines realen elektronischen Schaltplanes, hätte von Haus aus schon dieselben physikalischen Strukturen wie in der Natur, würde wie in der Natur mit kontinuierlichen Werten arbeiten und automatisch die im Neuronenmodell vorhandene Parallelität bieten. Leider ist ein solcher Schaltungsentwurf und Implementation sehr teuer und zeitaufwändig und damit häufig unpraktikabel. Ein möglicher analoger Schaltungsentwurf für ein einziges Neuron des Thalamus, wie im Kapitel zum Conductance Model vorgestellt, könnte wie in Abbildung 5 dargestellt aussehen. Im Gegensatz zur analogen Herangehensweise besitzt die digitale Lösung weniger Vorteile: Hauptargument für digitale Lösung sind aber der Preis und kurze Entwicklungszeiten. Außerdem existieren schon viele Tools und Programmiersprachen die das digitale Neuronennetz Erstellen sehr vereinfachen und damit auch Argument für eine digitale Lösung sind. In Folge wird hier kurz auf einige dieser Neuronal Computing Programmierumgebungen eingegangen. 12 Abbildung 5: Ein Schaltungsentwurf für ein einziges Neuron des Thalamus 4.1 Neuron, Genesis und NSL NEURON [8] ist eine Neurobiologisches Simulationsumgebung, mit der Neuronennetzwerke und Neuronen modelliert werden können. Die Umgebung wird auf der Duke Universität entwickelt und ist frei verfügbar. Die Webseite von NEURON erwähnt dass das System vor allem für Probleme geeignet ist, in denen komplexe Neuronen mit beispielsweise einzelnen Ionenkanälen beschrieben werden. GENESIS [7] ist ähnlich wie NEURON eine Simulationsplattform für neurobiologische Systeme. Als Einsatzgebiet wird praktisch alles von komplexen Modellen einzelner Neuronen bis große Netzwerksysteme bestehend aus kleinen einfachen Neuronen genannt. Dieses System wird größtenteils auf der Caltech Universität entwickelt und ist wie NEURON frei verfügbar. Das Programmpaket hat dem Autor sehr gut gefallen, da es viele kleine Beispielprogramme beinhaltet, mit denen leicht und schnell experimentiert werden kann. Neural Simulation Language [9] ist eine weitere Simulationssprache. Dieses Framework bietet vollständige Objektorientierung der Modelle und Unterstützung für C++ und Java. Es eignet sich hervorragend für große Netzwerke und unterstützt einfache und komplexe Modelle wie zum Beispiel die vorhin beschriebenen Multikompartment Modelle. Auf der Webseite gibt es online Java Demonstrationen einiger Modelle, die ohne Installation sofort im Browser lauffähig sind. 5 Neuromorphic Engineering Einer der Punkte an dem sich Technik und Biologie treffen ist das sogenannte Biomorphic Engineering - Techniken, die die Biologie möglichst gut imitieren. Eine Ebene spezieller, im Berührungspunkt der Informatik mit der Neurobiologie ist der Begriff Neuromorphic Engineering anzusiedeln. Hauptziel in diesem Gebiet ist es Techniken zu nutzen, imitieren und entwickeln, die in der Natur in mehreren Millionen Jahren entstanden sind. 13 Dabei geht es im Endeffekt um eine Emulation auf elektrischer oder digitaler - nicht aber biologischer - Basis. 5.1 Eine Künstliche Retina Die natürliche Retina ist künstlichen Bildverarbeitungs und Aufnahmesystemen in vielen Gebieten wesentlich überlegen. Sie besitzt einen sehr großen Helligkeitsdynamikbereich, komprimiert die Bilddaten sehr effizient und nutzt die ihr zur Verfügung stehende Datenbandbreite im Sehnerv optimal aus. Zwar gibt es schon viele elektronische Möglichkeiten Bilddaten aufzunehmen und zu verarbeiten, aber gerade in natürlichen Umgebungen ist die Qualität und Performance der biologischen Lösung noch unerreicht. Die Retina gehört, durch ihre vom Rest vom Gehirn exponierte Position, zu den best erforschten Teilen des Gehirns. Sie ist leicht zugänglich für Analysen, außerdem sind die Eingangssignale und mit dem Sehnerv auch sehr genau die Position des Ausgangssignals bekannt. Da das Sehempfinden zu den wichtigsten Wahrnehmungsfunktionen des Menschen gehört, gibt es großes Interesse an weiterer Erforschung und Nachbildung der genauen Arbeitsweise der Retina. 5.1.1 Der Aufbau der natürlichen Retina Fünf Hauptzellentypen sind in 3 Schichten angeordnet. Die Schicht der Fotorezeptoren, bestehend aus den sogenannten Stäbchen- und Zapfenzellen, sind auf der dem Lichteinfall abgewandten Seite platziert, werden praktisch also von der Rückseite her beleuchtet. Die Zapfenzellen sprechen auf Reize im Tageslichtbereich an, die Stäbchenzellen sind auf Dämmerlicht spezialisiert. Generell wandeln die Fotorezeptorzellen Lichtreize in elektrische Signale um. Die an die Fotorezeptoren angewachsenen Bipolar- Amakrinund Horizontalzellen verarbeiten die empfangenen Lichtsignale analog weiter. Die Zellen sind sehr stark untereinander gekoppelt, sodass ein von einem Fotorezeptor empfangener Reiz auch von der Umgebung (gedämpft) empfangen und mitverarbeitet wird. Die Ganglienzellen erzeugen in der dritten Ebene dann fertige Aktionspotentiale, die über den Sehnerv dann an das Gehirn übermittelt werden. Auf der Retina existiert ein Punkt, der sogenannte Fovea Centralis, mit einem Durchmesser von einem halben Millimeter, auf dem besonders viele Fotorezeptorzellen sind. Dort ist die Sehauflösung am größten. Insgesamt gibt es ungefähr 125 Millionen Fotorezeptoren auf der Netzhaut. Die auf der einen Seite sehr gute Farbunterscheidung und Auflösung des Auges (rund um die Fovea Centralis) macht es uns möglich sehr detaillierte Betrachtungen zu machen. Auf der anderen Seite ermöglicht der schlechter auflösende aber stark lichtempfindliche Rand der Netzhaut ein großes Gesichtsfeld. Weiters verdanken wir der logarithmischen Charakteristik der Fotorezeptorzellen eine der aktuellen Helligkeit angepasste Kontrastwahrnehmung. Diese Anpassungsfähigkeit machte es aber schwer tatsächliche Helligkeiten abzuschätzen, was sich viele optische Täuschungen zunutze machen. 14 Abbildung 6: Ein Knoten der künstli- Abbildung 7: Ein erfolgreich eingesetzchen Retina von 1970[10] tes Silikon Retinaimplantat von optobionics[11] 5.1.2 Implementation Eine der ersten künstliche Retinae wurde 1970 von K. Fukushima et al. vorgestellt. Diese Retina war eine analoge Nachbildung und bestand aus Elektronik-Standardkomponenten: Fotosensoren, Widerständen, Kondensatoren und Lampen. Die Fotosensoren haben die Fotorezeptorzellen emuliert, ein erregendes und hemmendes Widerstandsnetz die Horizontalzellen und die Differenzenverstärker die Ganglienzellen. Auf einer Lampentafel wurde das das von der künstlichen Retina übertragene Bild dann veranschaulicht. Diese frühe Emulation einer Retina war ein voll paralleles System, das in Echtzeit lief und ohne Computer ausgekommen ist. Abbildung 6 stellt den Schaltkreis eines Knotens der damaligen Retina dar. Nach 20 Jahren ging man dazu über Retina-Emulationen als integrierte Schaltungen im bekannten Siliziumprozess herzustellen. Vorteile von siliziumbasierten Schaltungen sind die geringe Größe, der minimale Stromverbrauch und relative Robustheit. Leider ist es sehr schwierig die hohe Verknüpfungsdichte der Neuronen untereinander im Siliziumprozess zu erzeugen. Zur Zeit schafft es mit modernen Prozessen einen Quadratzentimeter Chip mit einer Auflösung von circa 690x630 Pixel auszustatten[10]. Mittlerweile ist die Forschung auf dem Gebiet sogar schon soweit gediehen, dass man Halbblinden Menschen tatsächlich Seh-Prothesen einpflanzen kann. Die japanische Firma Optobionics [11] erzeugt und implantiert künstliche Retinae. Patienten müssen zwar einen funktionierenden Sehnerv besitzen, können nach einem erfolgreichen chirurgischen Eingriff aber tatsächlich wieder Umrisse und Kontraste erkennen! Abbildung 7 zeigt einen erfolgreich eingesetzten Silikon-Retina Ersatz. 5.2 NOSE NOSE ist in diesem Fall eine Abkürzung für Neuromimetic Olfactory Sensing und ist ein Projekt an der Universität Nancy/FR. Im Zentrum der Forschung steht das Erkennen von Gerüchen mit nicht selektiven Chemosensoren, die das Verhalten von Tieren beim Erschnüffeln einer Geruchsquelle imitieren[13]. Typische Anwendungsgebiet ist das 15 lokalisieren von Drogen, Gas-Austrittsstellen oder Sprengstoff. Folgende Dinge wurden bei der Entwicklung dieses Roboters beachtet: Wie bei Tieren und Menschen besitzt der Roboter zwei Geruchssensoren. Um möglichst stabile Analyseergebnisse zu erzielen hat der Roboter auch einem Schnüffelmechanismus. Luft wird durch die zwei Geruchszylinder angezogen und dann ohne Gefahr, dass während der Analyse beispielsweise ein Windstoß neue Gerüche herantreibt oder alte wegträgt, analysiert. Jedem nicht selektiven Chemosensor ist ein Integrate and Fire Model nachgeschaltet, dass ohne Eichung auf ein spezielles Gas die Eingaben analysiert. Die Eigentliche Analyse des Gases passiert automatisch im Neuronennetzwerk. NOSE nimmt nur die Ausgangszeiten der Aktionspotentiale und damit entstehenden Muster ab und kann anhand dieser zwei Parameter Gase erriechen. So konnte der Roboter beispielsweise leicht zwischen Ethanol und Buthanol unterscheiden. Im aktuellen Status (Abbildung 8) kann der NOSE Roboter tatsächlich schon Gerüche verfolgen, indem man ihm zu Beginn das zu erschnüffelnde Gas riechen lernt (also Spiking Muster und Zeiten einlernt) und dann auf Suche schickt. Abbildung 8: Der NOSE Roboter. Die zwei abstehenden Metallzylinder sind die künstlichen Nasenröhren, die die Geruchssensoren eingebaut haben.[12] 5.3 Andere Wahrnehmungen Tasten Wie wichtig unsere Haut für die Wechselwirkung mit dem Alltag ist, sieht man allein an der Anzahl der Sinneszellen die in ihr stecken. In einem Quadratzentimeter Lederhaut sitzen durchschnittlich 200 Schmerzrezeptoren, 100 Druckrezeptoren, 12 Kälterezeptoren und zwei Wärmerezeptoren. Nicht ohne Grund, denn sonst könnte der Mensch feine Oberflächen gar nicht ertasten. Das ist auch das zur Zeit größte Problem von künstlichen Nachbildungen: Sie erreichen noch bei weitem nicht so hohe Tast-Auflösung, wie die Haut[1]. 16 Hören Ähnlich wie schon am vorgestellten Beispiel Auge/Retina, wird schon länger an einem neuromorphischen künstlichen Cochlea Ersatz gearbeitet. Es existieren auch hier schon funktionierende Implantate für Menschen, die fast gar nicht mehr hören können, oder durch Schockerlebnisse ihr Gehör verloren haben. Beim Implantieren wird ein kleines schneckenförmiges Implantat in das Ohr eingesetzt, das sehr nahe am Gehörnerv anliegt und für den Gehörnerv verständliche elektrische Reize erzeugt. Im Jahr 1999 wurden weltweit über 3000 solcher Implantate eingesetzt.[15] Ein anderes Problem, bei dem man sich stark am natürlichen Ohr orientiert, ist Schalllokalisierung. In [14] wird neben einer analogen Cochlea aus Silikon auch ein biologisch realistisches Neuronennetzwerk zur Schallquellenlokalisierung vorgestellt. Dieser Algorithmus lokalisiert Schallquellen indem er nur die Signallaufzeiten, die der Schall in der Cochlea benötigt, verwendet. Im Zuge dieser Arbeit wurde auch ein auf Basis dieses Neuronennetzwerks arbeitender Roboterkopf entwickelt, der sich autonom einer Schallquelle zuwenden kann. 5.4 Verrückteiten? Neben den gerade vorgestellten Entwicklungen, gibt es auch Forscher im Gebiet der Neuroscience, die einen Schritt weitergehen und an vielleicht zur Zeit noch verrückt klingenden Ideen arbeiten. Einer dieser Forscher ist der nicht gerade medienscheue Professor Kevin Warwick der Universität Reading/UK. Der widmet sich in seiner Arbeit ganz dem Thema Cyborg, Menschen mit elektronischen Erweiterungen. Seine Meinung ist, dass sich Menschen in Zukunft nur noch mit direkter Technischer Unterstützung im Körper weiterentwickeln werden können. Im März 2002 hat er sich von Chirurgen in einem spektakulären Selbstversuch ein kreditkartengrosses Relais in den Oberarm implantieren lassen. Ungefähr 100 Elektroden dieses Implantats berühren den Armnerv. Das Implantat ist mit dem PC via Sender verbunden. Immer wenn Warwick seine Finger bewegt, sollte der Nervenimpuls vom Rechner aufgezeichnet und verarbeitet werden. Tatsächlich ist es ihm so auch gelungen eine Roboterhand zu steuern. In Zukunft könnte man so beschädigte Nerven von Behinderten Menschen überbrücken und hochwertige Prothesen aufsetzen. Mittlerweile besitzt auch seine Frau schon ein Implantat, mit dem sich Warwick erhofft hatte direkt mit seiner Frau Gefühle austauschen zu können, aber noch nicht so richtig funktioniert. 17 6 Fazit Abgesehen von den ethischen Fragen ist ist die ”Cyborg Forschung” von Warwick sicher ein interessantes und in Zukunft, beispielsweise gekoppelt mit der Medizin, wichtiges Thema. Doch Warwicks Ideen erinnern stark an die Goldgräberversprechen die man schon einmal in der gerade aufkommenden Artificial Intelligence gemacht hat. Es wird das Speichern von Gedanken am PC versprochen, implantierte Computer sollen dem dem Menschen beim täglichen Leben unterstützen oder Geräte sollen mit Gedanken gesteuert werden. Echter Fortschritt wird in Zukunft aber wohl in neuen, verbesserten Nervennetzwerkmodellen oder im Feld ähnlich der hier präsentierten Anwendungen passieren. Literatur [1] Begleitpublikation zur Sonderausstellung im Heinz Nixdorf Museumsforum, 2001 Computer.Gehirn: Was kann der Mensch? Was können die Computer?, Verlag Ferdinand Schönigh. [2] Uwe Krüger, 1995 Neuronale Netzwerke mit zeitverzögerter Signalübertragung, Verlag Harri Deutsch. [3] Chip Spezial, 1996 Gehirn, Gedächtnis, Neuronale Netze, Vereinigte Motor Verlag. [4] A. Prasanna de Silvia, Jens Eilers, George Zlokarnik, 1999 Emerging fluorescence sensing technologies: From photophysical principles to cellular applications, German-American Frontiers of Science Symposium. [5] Elisabeth Thomas, 2002 Encyclopedia of Cognitive Science, Nature Publishing Group. [6] Ralph Morelli, W. Miller Brown, 1992 Computational Models of Cognition, Ablex Publishing Corporation. [7] GENESIS Simulation Language, 2003, http://www.genesis-sim.org/GENESIS/. [8] NEURON Simulation Language, 2003, http://neuron.duke.edu/. [9] Neural Simulation Language, 2003, http://www.neuralsimulationlanguage.org/. [10] Jörg Kramer, 1999 Künstliche Retina - Analog-Chips kopieren die Natur, Bulletin SEV/VSE. 18 [11] Optobionics, 2003, http://www.optobionics.com/. [12] NOSE - Neuromimetic Olfactory SEnsing, 2003, http://www.loria.fr/ rochel/nose/en/. [13] Oliver Rochel, Dominique Martinez et al., 2002, Stereo-olfaction with a sniffing neuromorphic robot using spiking neurons, Eurosensors 2002. [14] Mete Erturk et al., 1999, A Neuromorphic Approach to the Analysis of Monoaureal and Binaureal Auditory Signals, University of Maryland. [15] Earsurgery Information Site http://www.earsurgery.org/cochlear.html 19