formelsammlung zur schliessenden statistik

Werbung

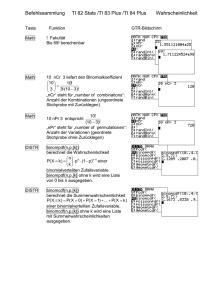

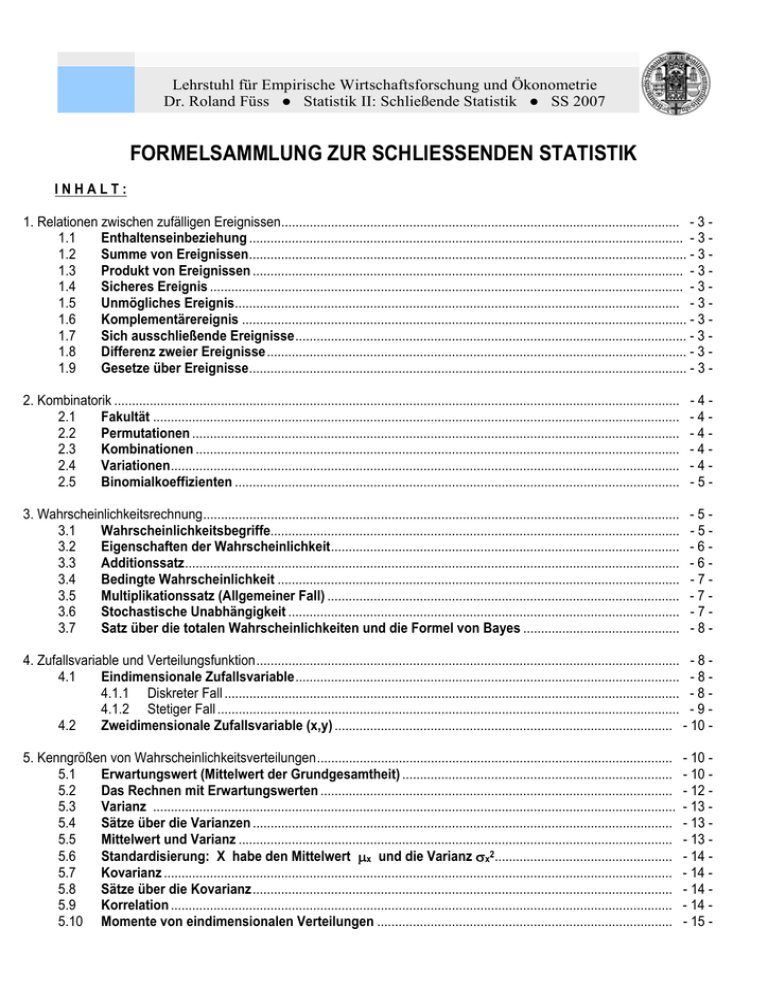

Lehrstuhl für Empirische Wirtschaftsforschung und Ökonometrie Dr. Roland Füss ● Statistik II: Schließende Statistik ● SS 2007 FORMELSAMMLUNG ZUR SCHLIESSENDEN STATISTIK INHALT: 1. Relationen zwischen zufälligen Ereignissen ................................................................................................................ - 3 1.1 Enthaltenseinbeziehung .......................................................................................................................... - 3 1.2 Summe von Ereignissen ........................................................................................................................... - 3 1.3 Produkt von Ereignissen ......................................................................................................................... - 3 1.4 Sicheres Ereignis ..................................................................................................................................... - 3 1.5 Unmögliches Ereignis............................................................................................................................. - 3 1.6 Komplementärereignis ............................................................................................................................. - 3 1.7 Sich ausschließende Ereignisse .............................................................................................................. - 3 1.8 Differenz zweier Ereignisse ...................................................................................................................... - 3 1.9 Gesetze über Ereignisse ........................................................................................................................... - 3 2. Kombinatorik ............................................................................................................................................................... 2.1 Fakultät .................................................................................................................................................... 2.2 Permutationen ......................................................................................................................................... 2.3 Kombinationen ........................................................................................................................................ 2.4 Variationen ............................................................................................................................................... 2.5 Binomialkoeffizienten ............................................................................................................................. -4-4-4-4-4-5- 3. Wahrscheinlichkeitsrechnung ...................................................................................................................................... 3.1 Wahrscheinlichkeitsbegriffe................................................................................................................... 3.2 Eigenschaften der Wahrscheinlichkeit .................................................................................................. 3.3 Additionssatz ........................................................................................................................................... 3.4 Bedingte Wahrscheinlichkeit ................................................................................................................. 3.5 Multiplikationssatz (Allgemeiner Fall) ................................................................................................... 3.6 Stochastische Unabhängigkeit .............................................................................................................. 3.7 Satz über die totalen Wahrscheinlichkeiten und die Formel von Bayes ............................................ -5-5-6-6-7-7-7-8- 4. Zufallsvariable und Verteilungsfunktion ....................................................................................................................... - 8 4.1 Eindimensionale Zufallsvariable ............................................................................................................ - 8 4.1.1 Diskreter Fall ................................................................................................................................ - 8 4.1.2 Stetiger Fall .................................................................................................................................. - 9 4.2 Zweidimensionale Zufallsvariable (x,y) ............................................................................................... - 10 5. Kenngrößen von Wahrscheinlichkeitsverteilungen .................................................................................................... 5.1 Erwartungswert (Mittelwert der Grundgesamtheit) ............................................................................ 5.2 Das Rechnen mit Erwartungswerten ................................................................................................... 5.3 Varianz ................................................................................................................................................... 5.4 Sätze über die Varianzen ...................................................................................................................... 5.5 Mittelwert und Varianz .......................................................................................................................... 5.6 Standardisierung: X habe den Mittelwert μx und die Varianz σx2.................................................. 5.7 Kovarianz ............................................................................................................................................... 5.8 Sätze über die Kovarianz ...................................................................................................................... 5.9 Korrelation ............................................................................................................................................. 5.10 Momente von eindimensionalen Verteilungen ................................................................................... - 10 - 10 - 12 - 13 - 13 - 13 - 14 - 14 - 14 - 14 - 15 - 5.11 5.12 5.13 5.14 Momenterzeugende Funktion............................................................................................................... Momente von zweidimensionalen Verteilungen ................................................................................. Schiefe ................................................................................................................................................... Wölbung (Exzeß) ................................................................................................................................... - 15 - 16 - 16 - 16 - 6. Spezielle diskrete Wahrscheinlichkeitsmodelle ......................................................................................................... 6.1 Bernoulli - Verteilung ............................................................................................................................ 6.2 Geometrische Verteilung ...................................................................................................................... 6.3 Binomialverteilung ................................................................................................................................ 6.4 Poisson - Verteilung.............................................................................................................................. 6.5 Hypergeometrische Verteilung ............................................................................................................ - 16 - 16 - 17 - 17 - 18 - 19 - 7. Spezielle stetige Wahrscheinlichkeitsmodelle ........................................................................................................... 7.1 Normalverteilung ................................................................................................................................... 7.1.1 Normalverteilung N(x∗μ,σ2)...................................................................................................... 7.1.2 Standardnormalverteilung N(x∗0,1) .......................................................................................... 7.1.3 Mehrdimensionale Normalverteilung N(x∗μ,3) .......................................................................... 7.2 Exponentialverteilung ........................................................................................................................... 7.3 Lineare Verteilungen ............................................................................................................................. 7.4 Testverteilungen.................................................................................................................................... - 20 - 20 - 20 - 20 - 23 - 23 - 24 - 25 - 8. Grenzwertsätze ......................................................................................................................................................... 8.1 Stochastische Konvergenz................................................................................................................... 8.2 Tschebyscheff'sche Ungleichung........................................................................................................ 8.3 Gesetz der großen Zahlen .................................................................................................................... 8.4 Zentrale Grenzwertsätze ....................................................................................................................... - 25 - 25 - 26 - 26 - 27 - 9. Grundlagen der Schätztheorie .................................................................................................................................. 9.1 Punktschätzungen ................................................................................................................................ 9.2 Kriterien für Punktschätzungen ........................................................................................................... 9.3 Intervallschätzungen............................................................................................................................. 9.4 Schätzfehler, Intervalllänge und Stichprobenverlauf ......................................................................... - 28 - 28 - 29 - 30 - 31 - 10. Testtheorie .............................................................................................................................................................. 10.1 Fehlerarten und Entscheidungsregeln ................................................................................................ 10.2 Unterschied bei Anteilssätzen und Mittelwerten ................................................................................ 10.2.1 Ein - Stichproben - Problem ....................................................................................................... 10.2.2 Zwei - Stichproben - Problem ..................................................................................................... 10.3 Prüfung anderer Parameter .................................................................................................................. 10.3.1 Unterschied der Varianzen ......................................................................................................... 10.3.2 Abweichung des Korrelationskoeffizienten von 0 ....................................................................... 10.4 χ2 -Test ................................................................................................................................................... 10.4.1 Anpassungstest ......................................................................................................................... 10.4.2 Unabhängigkeitstest zwischen zwei Variablen X , Y ................................................................. 11. Nichtparametrische Testverfahren .......................................................................................................................... - 33 - 33 - 33 - 33 - 34 - 35 - 35 - 36 - 36 - 36 - 37 - 33 - Kritische Werte t(α) der t - Verteilung für verschiedene α ................................................................................... - 38 Ausgewählte Werte der χ2 - Verteilung .................................................................................................................... - 39 Kritische Werte F(α) der F - Verteilung ..................................................................................................................... - 40 Wahrscheinlichkeiten der Standardnormalverteilung N(x∗0,1) .............................................................................. - 22 Kritische Werte für Binomialverteilung, Mann-Whitney- und Wilcoxon-Test............................................................ -42 - 1. Relationen zwischen zufälligen Ereignissen Ereignis: A, B, C 1.1 Enthaltenseinbeziehung: A⊂B 1.2 Summe von Ereignissen: A∪B 1.3 Produkt von Ereignissen: A∩B 1.4 Sicheres Ereignis: E 1.5 Unmögliches Ereignis: ∅ 1.6 Komplementärereignis: 1.7 Sich ausschließende Ereignisse: A ∩ B = ∅ 1.8 Differenz zweier Ereignisse: B \ A = B ∩ A 1.9 Gesetze über Ereignisse: GESETZE Idempotenz Kommutativgesetz Assoziativgesetz Absorptionsgesetz Distributivgesetz (A zieht B nach sich) ein.) (Es tritt A oder B ein; oder A und B treten gleichzeitig (Die Ereignisse treten gleichzeitig auf.) A A heißt das zu A komplementäre Ereignis (A und B heißen unvereinbar (disjunkt, wenn ihr gleichzeitiges Auftreten unmöglich ist.) (Alle Elemente in B, welche nicht in A sind.) DURCHSCHNITT VEREINIGUNG A∩A=A A∪A=A A∩B=B∩A A∪B=B∪A A ∩ (B ∩ C) = (A ∩ B) ∩ C A ∪ (B ∪ C) = (A ∪ B) ∪ C A ∩ (A ∪ B) = A A ∪ (A ∩ B) = A A ∩ (B ∪ C) = (A ∩ B) ∪ (A ∩ C) (A ∪ B) ∩ (A ∪ C) = A ∪ (B ∩ C) Komplementgesetz E = ∅; ∅ = E ; A ∩ A = ∅ Gesetz für neutrale Elemente A∩∅ =∅ A∪E=E A∩E=A A∪∅=A A∪ A = E; ( A ) = A -4- 2. Kombinatorik 2.1 Fakultät (1) n ! = 1 ⋅ 2 ⋅ 3...(n − 1) ⋅ n (Def.: O! = 1) Näherungsformel von Stirling: (2) n ! ≈ nn ⋅ e− n 2π n 2.2 Permutationen Bei n verschiedenen Elementen: (3) Pn = n ! Zirkularpermutation: (3a) Pn| = (n − 1 ) ! Bei k von n verschiedenen Elementen, mit n1 +n2 + ... + nk = n: n! W (4) Pn = n1 ! n2 ! ... nk ! 2.3 Kombinationen (ohne Berücksichtigung der Anordnung) Ohne Wiederholungen: n! ⎛ n⎞ (5) C nk = ⎜ ⎟ = ⎝ k⎠ k ! (n − k) ! Mit Wiederholungen: ⎛ n + k − 1⎞ (n + k - 1 ) ! w ⎟= (6) C nk = ⎜ k !(n - 1) ! k ⎠ ⎝ 2.4 Variationen (mit Berücksichtigung der Anordnung) Ohne Wiederholungen: n! (7) V nk = (n − k) ! Mit Wiederholungen: (8) w V nk = nk -52.5 Binomialkoeffizienten Funktion der Binomialkoeffizienten ⎛n⎞ (9) F k ( n ) = ⎜⎜ ⎟⎟ ( 0 ≤ k ≤ n ; F 0 ( n ) = 1 ) ⎝k ⎠ Es gelten die Beziehungen: (10a) ⎛ n + 1⎞ ⎛ n ⎞ ⎛ n ⎞ ⎜⎜ ⎟⎟ = ⎜⎜ ⎟⎟ + ⎜⎜ ⎟⎟ ⎝ k ⎠ ⎝ k − 1⎠ ⎝ k ⎠ (10b) ⎛ n + 1⎞ ⎛ n ⎞ ⎛ n ⎞ ⎜⎜ ⎟⎟ = ⎜⎜ ⎟⎟ + ⎜⎜ ⎟⎟ ⎝ k + 1⎠ ⎝ k + 1⎠ ⎝ k ⎠ (10c) ⎛n⎞ ⎛ n ⎞ n! ⎜⎜ ⎟⎟ = ⎜⎜ ⎟⎟ = ⎝ k ⎠ ⎝ k − 1⎠ k ! (n − k) ! (10d) ⎛n⎞ ⎜⎜ ⎟⎟ = 1 ⎝0⎠ (10e) ⎛ 0⎞ ⎜⎜ ⎟⎟ = 1 ⎝ 0⎠ 3. Wahrscheinlichkeitsrechnung 3.1 Wahrscheinlichkeitsbegriffe 3.1.1 Statistischer Wahrscheinlichkeitsbegriff: (11) P ( A ) = lim n A n→∞ n 3.1.2 Klassischer Wahrscheinlichkeitsbegriff: Anzahl der günstigen Fälle n A = (12) P ( A ) = Anzahl der möglichen Fälle n 3.1.3 Axiomatischer Wahrscheinlichkeitsbegriff: Indirekte Definition durch Angabe von Eigenschaften und Relationen (3 Grundaxiome): A1: Jedem zufälligen Ereignis A wird eine nicht-negative reelle Zahl W (die Wahrscheinlichkeit) zugeordnet, die zwischen 0 und 1 liegt: (13) 0 ≤ P( A )≤1 -6A2: Das sichere Ereignis E hat die Wahrscheinlichkeit eins: (14) P ( E )= 1 A3: Bei sich ausschließenden Ereignissen addieren sich die Wahrscheinlichkeiten: (15) P ( A ∪ B ) = P( A ) + P ( B ) 3.1.4 Subjektiver Wahrscheinlichkeitsbegriff: Wahrscheinlichkeit ist das Maß für den Grad der Überzeugtheit von der Richtigkeit einer Aussage. 3.1.5 Geometrische Wahrscheinlichkeiten Ist dem Ereignisraum E (mit überabzählbar unendlich vielen Elementarereignissen) ein endliches geometrisches Maß (Längen-, Flächen-, Volumenmaß) zugeordnet, so ist die Wahrscheinlichkeit des zufälligen Ereignisses A in E: (16) P ( A )= Länge von A Fläche von A Volumen von A bzw. bzw. Länge von E Fläche von E Volumen von E 3.2 Eigenschaften der Wahrscheinlichkeit Die Wahrscheinlichkeit des unmöglichen Ereignisses ist gleich 0: P ( ∅ )= 0 (17) Die Wahrscheinlichkeit des sicheren Ereignisses ist gleich 1: W(E) = 1 (18) Ist P(A) die Wahrscheinlichkeit des Ereignisses A und A das zu A komplementäre Ereignis, so gilt die Beziehung: (19) W(A) + P( A ) = 1 = P(E) bzw. P( A ) = 1 - P(A) Gilt für die zufälligen Ereignisse A und B die Beziehung A ⊂ B (A zieht B nach sich), so ist (20) P(A) ≤ P(B) Sind A und B zwei beliebige Zufallsereignisse, dann ist (21) P(A\B) = P(A) - P(A ∩ B) 3.3 Additionssatz 3.3.1 Für beliebige Ereignisse A und B: (22) P(A ∪ B) = P(A) + P(B) - P(A ∩ B) ausgedehnt auf die beliebigen Ereignisse A, B, C; (23) P(A ∪ B ∪ C) = P(A) + P(B) + P(C) - P(A ∩ B) - P(A ∩ C) - P(B ∩ C) + P(A ∩ B ∩ C) -73.3.2 für sich ausschließende Ereignisse: (24) P(A ∪ B) = P(A) + P(B) bzw. bei n sich ausschließenden Ereignissen: (25) P(A1 ∪ A2 ∪...∪ An) = P(A1) + P(A2) +...+ P(An) 3.4 Bedingte Wahrscheinlichkeit Die Wahrscheinlichkeit des Ereignisses A unter der Bedingung, dass das Ereignis B eingetreten ist, wird bezeichnet mit: P( A∩ B ) P ( A | B )= wenn P ( B ) > 0 (26) P( B ) P( A∩ B ) P ( B | A )= wenn P ( A ) > 0 (27) P( A ) Additionssatz für die Ereignisse A, B, C a) für beliebige Ereignisse A, B, C: (28) P(A ∪ C ⎜B) = P(A ⎜B) + P(C ⎜B) - P(A ∩ C ⎜B) b) für sich ausschließende Ereignisse A, C: (29) P ( A ∪ C | B )= P ( A | B )+ P ( C | B )= P( A∩ B ) P( C ∩ B ) + P( B ) P( B ) 3.5 Multiplikationssatz (Allgemeiner Fall) Haben zwei Ereignisse A und B bei einem Zufallsexperiment die Wahrscheinlichkeit P(A) bzw. P(B), so beträgt die Wahrscheinlichkeit des gleichzeitigen Eintreffens von A und B (30) P(A ∩ B) = P(A) ∗ P(B ⎜A) = P(B) ∗ P(A ⎜B) 3.6 Stochastische Unabhängigkeit Man nennt ein Ereignis A bzw. B stochastisch unabhängig von dem Ereignis B bzw. A, wenn die Gleichung (31) P(A⏐B) = P(A) bzw. P(B⏐A) = P(B) besteht, das heißt das Eintreten des Ereignisses A bzw. B hängt vom Eintreten des Ereignisses B bzw. A nicht ab. Multiplikationssatz (für unabhängige Ereignisse) (32) P(A ∩ B) = P(A) ∗ P(B) für n unabhängige Ereignisse gilt: (33) P(A1 ∩ A2 ∩...∩ An) = P(A1) ∗ P(A2) ∗ ... ∗ P(An) -83.7 Satz über die totalen Wahrscheinlichkeiten und die Formel von Bayes Schließen die n zufälligen Ereignisse A1, A2,..., An einander paarweise aus und ist das Ereignis A = A1 ∪ A2 ∪...∪ An das sichere Ereignis, so gilt für ein beliebiges zufälliges Ereignis B, das genau mit einem der Ereignisse Ai eintritt: (34) n P ( B) = P ( A1 ) ⋅ P (B | A1 ) + . . .+ P( An ) ⋅ P(B | An ) = ∑ P ( Ai ) ⋅ P ( B | Ai ) i=1 Unter den gleichen Voraussetzungen wie in (34) heißt die Formel von Bayes: (35) P ( A j | B )= P ( Aj ) ⋅ P ( B | Aj ) n ∑P ( A i ( i = 1, . . . j, . . . n ) ) ⋅ P ( B | Ai ) i=1 4. Zufallsvariable und Verteilungsfunktion 4.1 Eindimensionale Zufallsvariable 4.1.1 Diskreter Fall Wahrscheinlichkeitsfunktion Eine diskrete Zufallsvariable X nehme abzählbar viele Werte x1, x2, ..., xn mit den zugehörigen Wahrscheinlichkeiten f(xi) an. f(xi) heißt Wahrscheinlichkeitsfunktion (probability function). (36) P ( X = xi ) = f ( xi ) = p i Eigenschaften der Wahrscheinlichkeitsfunktion n (37a) 0 ≤ f ( xi ) ≤ 1 ∑ f( (37b) xi ) = 1 i=1 Verteilungsfunktion (cumulative distribution function) (38) F(x) = W(X ≤ x) = ∑ f ( xi ) xi ≤ x Intervallwahrscheinlichkeiten (39) P ( a < X ≤ b )= ∑ f ( xi ) = F ( b ) − F ( a ) ∑ f ( xi ) = F ( b ) − F ( a ) + f ( a ) a < xi ≤ b aber: P ( a ≤ X ≤ b )= a ≤ xi ≤ b Eigenschaften der Verteilungsfunktion (40) F(x) wächst monoton (Treppenfunktion) von lim F ( x ) = 0 bis x → −∞ lim F ( x ) = 1 x → +∞ -94.1.2 Stetiger Fall Grundannahme im stetigen Fall: Stetige Zufallsvariable; daneben wird stetige Differenzierbarkeit der Verteilungsfunktion bzw. Stetigkeit der Dichtefunktion gefordert. Dichtefunktion (density function) (41) f(x) = d F(x) d x Eigenschaften der Dichtefunktion (42a) f ( x ) ≥ 0 +∞ (42b) ∫ f(x)d x = 1 −∞ Verteilungsfunktion (cumulative distribution function): x (43) F ( x )= P ( X ≤ x )= ∫ f ( u )d u −∞ lntervallwahrscheinlichkeiten b (44) P ( a < X ≤ b )= ∫ f ( x ) d x = F ( b ) − F ( a ) a Für stetige Verteilungen gilt stets: (45) P (a < X ≤ b) = P ( a ≤ X ≤ b) = P( a < X < b) = P( a ≤ X < b) Eigenschaften der Verteilungsfunktion (46) F(x) steigt monton und stetig von lim F ( x ) = 0 bis lim F ( x ) = 1 x → −∞ x → +∞ - 10 4.2 Zweidimensionale Zufallsvariable (x,y) Begriff Nr.: Diskreter Fall Stetiger Fall Wahrscheinlichkeitsfunktion bzw. Dichtefunktion (47a) f ( xi , y j ) f(x , y) (47b) 0 ≤ f ( xi , y j ) ≤ 1 0 ≤ f(x , y) ∑∑ (47c) i Verteilungsfunktion Randverteilungen j ∑ ∑ F (x , y) = (48) xi ≤ x y j ≤ y f( xi , y j ) F ist eine Treppenfunktion und steigt von F(-∝,-∝) = 0 bis F(+∝,+∝) = 1. ∞ ∞ ∞ F ist stetig differenzierbar und steigt monoton von F(-∝,-∝) = 0 bis F(+∝,+∝) = 1 • f(x) = f ( y j ) = ∑ f ( xi , y j ) = p• f(x , y)d y ∞ j f(y) = ∫ f(x , y)d x −∞ (50a) f ( xi | y j ) = (50b) f ( y j | xi ) = f ( xi , y j ) f ( yj ) f ( xi , y j ) f ( xi ) k E ( X | yj) = ∫ −∞ j (49a) , y)d x d y = 1 ∞ f ( x i ) = ∑ f ( x i , y j ) = pi (51a) ∞ F(x , y)= ∫ ∫ f ( u, v)d u d v (49b) Bedingte Erwartungswerte ∞ x y i Bedingte Verteilungen ∞ ∫ ∫f(x f ( xi , y j ) = 1 ∑x i f ( xi | y j ) = μ x |y j f ( y j |xi ) = μ y |x f(x , y) f(y) f(x , y) f(y | x) = f(x) f(x | y) = i=1 (51b) m E ( Y | xi ) = ∑y j=1 Unabhängigkeit von X und Y (52) f ( x i , y j ) = f ( xi ) ⋅ f ( y j ) 5. Kenngrößen von Wahrscheinlichkeitsverteilungen 5.1 Erwartungswert (Mittelwert der Grundgesamtheit) N (53a) Diskreter Fall: E(X) = ∑x i=1 ∞ (53b) Stetiger Fall: E ( X ) = ∫ −∞ N i f ( xi ) = ∑x i=1 x f ( x ) d x = μx i pi = μ x f ( x , y )= f ( x ) ⋅ f( y) - 11 - Wahrscheinlichkeitsfunktion f(zn) für die Summe der Augenzahlen n zn = ∑x , bei n = 1, 2, 3, 4, 5 Würfen mit einem regulären Würfel i i = 1 zn f(z1) f(z2) f(z3) f(z4) f(z5) *6 * 62 * 63 * 64 * 65 1 1 2 1 1 3 1 2 1 4 1 3 3 1 5 1 4 6 4 6 1 5 10 7 6 8 f(z1) f(z2) f(z3) f(z4) f(z5) 0,1667 0,1667 0,0278 0,1667 0,0555 0,0046 0,1667 0,0833 0,0139 0,0008 1 0,1667 0,1111 0,0278 0,0031 0,0001 10 5 0,1667 0,1388 0,0463 0,0077 0,0006 15 20 15 0,1667 0,0694 0,0154 0,0019 5 21 35 35 0,1388 0,0972 0,0270 0,0045 9 4 25 56 70 0,1111 0,1157 0,0432 0,0090 10 3 27 80 126 0,0833 0,1250 0,0617 0,0162 11 2 27 104 205 0,0555 0,1250 0,0802 0,0264 12 1 25 125 305 0,0278 0,1157 0,0965 0,0392 13 21 140 420 0,0972 0,1080 0,0540 14 15 146 540 0,0694 0,1127 0,0694 15 10 140 651 0,0463 0,1080 0,0837 16 6 125 735 0,0278 0,0965 0,0945 17 3 104 780 0,0139 0,0802 0,1003 18 1 80 780 0,0046 0,0617 0,1003 19 56 735 0,0432 0,0945 20 35 651 0,0270 0,0837 21 20 540 0,0154 0,0694 22 10 420 0,0077 0,0540 23 4 305 0,0031 0,0392 24 1 205 0,0008 0,0264 25 126 0,0162 26 70 0,0090 27 35 0,0045 28 15 0,0019 29 5 0,0006 30 1 0,0001 ϕ 6 36 = 62 216 = 63 1296 = 64 7776 = 65 1,0000 1,0000 1,0000 1,0000 1,0000 - 12 - 5.2 Das Rechnen mit Erwartungswerten Der Erwartungswert ist ein linearer Operator (54) E(a) = a (55) E(b ∗ X) = b∗ E(X) (56) E(a + b ∗ X) = a + b ∗ E(X) (57) E(X+Y) = E(X) + E(Y) (58) E(X1+X2+ ... +Xn) = E(X1) + E(X2) + ... + E(Xn) (59) E(X ∗ Y) = E(X) ∗ E(Y) bei Unabhängigkeit ! Eine Funktion einer Zufallsvariablen ist im allgemeinen wieder eine Zufallsvariable. Erwartungswerte von mittelbaren Zufallsvariablen können berechnet werden, ohne dass die zugehörige Wahrscheinlichkeitsfunktion bekannt ist. Dazu dienen die Sätze: (60) N Y = Φ ( X ) → E ( Y ) = ∑ φ ( xi ) ⋅ f ( xi ) i=1 (61) Z = Ψ ( X , Y ) → E ( Z ) = ∑ ∑ψ ( xi , y j ) ⋅ f ( xi , y j ) i j - 13 5.3 Varianz (62) Var ( X ) = E [ X − E ( X ) ] 2 (63a) Diskreter Fall: Var ( X ) = ∑ ( xi − μ )2 ⋅ f ( xi ) = σ 2x N i=1 ∞ (63b) Stetiger Fall: Var ( X ) = ∫(x μ )2 ⋅ f ( x ) d x = σ 2x −∞ (64) σ x = Var ( X ) = Standarda bweichung 5.4 Sätze über die Varianzen Verschiebungssatz (65) Var( X ) = E ( X 2 ) − [ E ( X ) ] 2 N ⎧ 2 2 = xi ⋅ f ( xi ) − μ ∑ ⎪ i=1 ⎪ ⎨ ∞ ⎪ = x2 ⋅ f ( x ) d x − μ 2 ⎪⎩ −∫∞ (66) Var(a) = 0 (67) Var(X+a) = Var(X) (68) Var(b ∗ X) = b2 ∗ Var(X) (69) Var(a+b ∗ X) = b2 ∗ Var(X) (70) σa+bX = │b│ ∗ σx (71) Bei Unabhängigkeit von X , Y gilt: Var(X+Y) = Var(X) + Var(Y) (72) Bei Unabhängigkeit der Xi gilt: Var(X1+X2+ ... +Xn) = Var(X1) + Var(X2) + ... + Var(Xn) 5.5 Mittelwert und Varianz einer Summe unabhängiger identisch verteilter Zufallsvariablen (73) E(X1+X2+ ... +Xn) = n ∗ μ (74) Var(X1+X2+ ... +Xn) = n ∗ σx2 - 14 5.6 Standardisierung: X habe den Mittelwert μx und die Varianz σx2 X − μx (75) Z= (76) E(Z) = μz = 0 (77) Var(Z) = σz2 = 1 σx 5.7 Kovarianz (Kenngröße und Unabhängigkeitsmaß für zweidimensionale Verteilungen) (78) Cov ( X , Y ) = E [[ (79) Diskreter Fall: Cov ( X , Y ) = ∑ ∑ ( x −μ i (80) Stetiger Fall: Cov ( X , Y ) = ∞ ∞ −∞ −∞ ∫ ∫ i x ]]= σ x y ) ⋅ ( y j − μ y ) ⋅ f ( xi , y j ) j =∑ i X −E( X ) ] ⋅ [ Y −E( Y ) ∑ xi ⋅ y j ⋅ f ( xi , y j ) - μ x ⋅ μ y j ( x − μx ) ⋅ ( y − μy ) ⋅ f ( x , y ) d x d y 5.8 Sätze über die Kovarianz Cov ( X , Y ) = E ( X ⋅ Y ) − E ( X ) ⋅ E ( Y ) = E ( X ⋅ Y ) − μ x ⋅ μ y (81) Daraus folgt (Erwartungswert eines Produktes von Zufallsvariablen): (82) E(X ∗ Y) = E(X) ∗ E(Y) + Cov(X,Y) Bei Unabhängigkeit ist Cov(X,Y) = 0 (83) Cov(X,X) = V(X) Cov(a+b ∗ X, c+d ∗ Y) = b ∗ d Cov(X,Y) (84) Varianz einer Summe nicht unabhängiger Zufallsvariablen (85) ⎛ V ⎜∑ ⎝i = 1 n (85a) Var(X+Y) = Var(X) + Var(Y) + 2 ∗ Cov(X,Y) n ⎞ X i ⎟ = ∑ V ( X i ) + ∑ ∑ Cov ( X i , X j ) ⎠ i = 1 i j i ≠ j 5.9 Korrelation (Bravais - Pearson'scher Korrelationskoeffizient) Unabhängigkeitsmaß bei zweidimensionalen Verteilungen (86) ρ ( X , Y )= Cov ( X , Y ) σxy = Var ( X ) ⋅ Var ( Y ) σ x ⋅ σ y - 15 Eigenschaften der Korrelation: ρ (X , Y) = ρ (Y , X) (87) ρ ( X , − X )= − 1 (88) ρ (X , X) = + 1 (89) − 1 ≤ ρ ≤ + 1 (90) (91) ρ ( X , Y ) falls ( sign b ) = ( sign d ) ⎩ − ρ ( X , Y ) falls ( sign b ) ≠ ( sign d ) ⎧ ρ(a + bX , c + dY) = ⎨ Bei Unabhängigkeit ist ρ(X,Y) = 0 5.10 (Umkehrung gilt nicht) Momente von eindimensionalen Verteilungen 5.10.1 Allgemeine Momente (A ist ein beliebiger Wert): (92) 5.10.2 r mr ( A ) = E ( X − A ) ( r = 1 , 2 , . . . ) Momente um den Nullpunkt (Anfangsmomente) (A = O): (93) r r mr ( 0 ) = E ( X ) = ∑ xi ⋅ f ( xi ) bzw. i ∞ ∫ r x ⋅ f ( x )d x −∞ z.B.: m1(0) = E(X) = μ 5.10.2 Momente um den Mittelwert (Zentralmomente) (A = μ) r r m r ( μ ) = E ( X − μ ) = ∑ ( xi − μ ) ⋅ f ( xi ) i (94) ∞ bzw. ∫ ( x−μ ) r ⋅ f ( x )d x −∞ z.B.: m1(μ) = 0 (Schwerpunkteigenschaft) m2(μ) = σ2 5.11 Momenterzeugende Funktion (95) (96) Diskreter Fall: m ( t ) = E ( et X ) m ( t ) = ∑ et x i ⋅ f ( xi ) i ∞ (97) Stetiger Fall: m ( t )= ∫e t x ∞ ⋅ f ( x )d x - 16 5.12 Momente von zweidimensionalen Verteilungen 5.12.1 Momente um den Nullpunkt (Anfangsmomente): r s (98) mr s ( 0 ) = E ( X Y ) z.B.: m10(0) = μx m01(0) = μy 5.12.2 Momente um den Mittelwert (Zentralmomente): (99) mr s ( μ ) = E ( X − μ x [ ) s ] Schiefe γ = (103) 5.14 ( ⋅ Y − μy m2 0 ( μ ) = σ 2x m0 2 ( μ ) = σ 2y m1 1 ( μ ) = σ y x (100) (101) (102) 5.13 )r 3 E(X − μ ) σ 3 = m3 ( μ ) 3 m2 ( μ )2 Wölbung (Exzeß) ε = (104) 4 E(X − μ ) σ 4 − 3 = m4 ( μ ) 2 − 3 m2 ( μ ) 6. Spezielle diskrete Wahrscheinlichkeitsmodelle 6.1 Bernoulli - Verteilung Eine Zufallsvariable (Bernoulli - Variable; 0,1 -Variable) nimmt die Werte 0 und 1 mit den Wahrscheinlichkeiten p und q an: (105) Wahrscheinlichkeitsfunktion: f(x) = pxq1-x (106a) Mittelwert: μ=P (106b) Varianz: σ2 = pq (106c) mx(t) = 1 + p(et - 1) Momenterzeugende Funktion: x f(x) 0 q 1 p sonst 0 - 17 6.2 Geometrische Verteilung Frage der Wahrscheinlichkeit des Eintritts des 1. Erfolges Bed.: gleichbleibende Erfolgswahrscheinlichkeiten, stochastische Unabhängigkeit Wahrscheinlichkeitsfunktion: x − 1 (107a) g ( x | p )= p ⋅ q für x = 1 , 2 , 3 , . . . Verteilungsfunktion: x (107b) F g ( x )= ∑ p ⋅ qk −1 k =1 Erwartungswert: (108a) E(X) = μ = 1 p Varianz: Var ( X ) = σ 2 = (1O8b) q 1− p = 2 2 p p Momenterzeugende Funktion: (108c) 6.3 mx ( t )= p ⋅ et 1 − et ( 1 − p ) Binomialverteilung Urnenmodell: In einer Urne befinden sich M weiße und N - M schwarze Kugeln. Wie groß ist die Wahrscheinlichkeit bei einer (unabhängigen) Stichprobe mit Zurücklegen vom Umfang n genau x (0 # x # n) weiße Kugeln zu ziehen? Bezeichnungen: p= Wahrscheinlichkeit für das Auftreten eines betrachteten (0,1) - Merkmals (z. B. weiße Kugeln) in der Grundgesamtheit. M = const. = Anteilssatz der weißen Kugeln. p = N N − M = Anteilssatz der schwarzen Kugeln. q = 1 − p = N n = Anzahl der Elemente in einer unabhängigen Stichprobe (mit Zurücklegen bei endlicher Urne). x = Anzahl der Ereignisträger (z.B. weiße Kugeln) in einer Stichprobe Wahrscheinlichkeitsfunktion: (109) ⎛n⎞ f ( x ) = b ( x | n , p ) = ⎜⎜ ⎟⎟ ⋅ p x ⋅ q n − x ( x = 0 , 1 , 2 , . . . , n ) ⎝ x⎠ - 18 (109a) n ∑ n b ( x | n , p )= x=0 ∑ x=0 Verteilungsfunktion: (11O) x F b ( x )= ∑ k =0 Erwartungswert: (111) μ=n ⋅ p Varianz: (112a) σ 2= n ⋅ p ⋅ q Momenterzeugende Funktion: (112b) ⎛ n⎞ k ⎜⎜ ⎟⎟ ⋅ p ⋅ q n − k ⎝k ⎠ mx(t) = [1 + p(et - 1)]n Rekursionsformel: (113) b ( x + 1 | n , p )= Relativierte Binomialvariable: X 1 (114) F= = ⋅ n n 6.4 ⎛n⎞ x ⎜⎜ ⎟⎟ ⋅ p ⋅ q n − x = ( p + q )n = 1 ⎝ x⎠ (115a) μ= p (115b) σ 2= n−x p ⋅ ⋅ b( x | n , p ) x +1 q ( X 1+ X 2 + . . . + Xn ) p ⋅q n Poisson - Verteilung Dieser Verteilung liegt im wesentlichen dasselbe Problem zugrunde wie der Binomialverteilung. Es unterscheidet sich nur darin, daß die Zahl n der aus der Urne gezogenen Kugeln sehr groß und die Wahrscheinlichkeit für das Ziehen einer bestimmten (z.B. weißen) Kugel sehr klein ist. (λ = np = const.) Wahrscheinlichkeitsfunktion: (116) (116a) Verteilungsfunktion: (117) x λ p ( x | λ )= ⋅ e −λ x ! ∞ ∑ p ( x | λ )= x=0 ∑ x=0 x F p ( x )= ∞ ∑ k =0 ( x=0 , 1 , 2 , . . . ) λx ⋅ −λ = λ ⋅ −λ = 1 e e e x ! λk ⋅ − λ = − λ ⋅ e e k ! λk ∑k k ≤ x ! - 19 Mittelwert und Varianz: (118) μ = σ2 = λ Momenterzeugende Funktion: (119) m x ( t ) = exp [ μ Rekursionsformel: (120) p ( x + 1 | λ )= ( e − 1 )] t λ x +1 ⋅ p( x | λ ) Reproduktivität: Die Summe von Poisson-Variablen ist wieder poissonverteilt. 6.5 Hypergeometrische Verteilung Urnenmodell: Endliche Urne wie bei der Binomialverteilung, Unabhängige Stichprobe ohne Zurücklegen. Bezeichnungen: N = Anzahl der Elemente in der Grundgesamtheit. M = Anzahl der Elemente mit einem bestimmten alternativen Merkmal = Ereignisträger (z.B. weiße Kugeln). M p = = Wahrscheinlichkeit des Auftretens des betrachteten (0,1) - Merkmals (z. B. weiße N Kugeln) - p verändert sich von Zug zu Zug -. N − M = Gegenwahrscheinlichkeit N n = Anzahl der Elemente der Stichprobe (ohne Zurücklegen). q = 1 − p = x = Anzahl der Ereignisträger (z.B. weiße Kugeln) in der Stichprobe. Wahrscheinlichkeitsfunktion: (121) Verteilungsfunktion: (122) Mittelwert: (123) ⎛M ⎞ ⎛N − M ⎞ ⎟ ⎜ ⎟⋅⎜ ⎜ x⎟ ⎜ n − x⎟ ⎠ h ( x | n ; M ; N )= ⎝ ⎠ ⎝ ⎛N⎞ ⎜ ⎟ ⎜ n⎟ ⎝ ⎠ ⎛M ⎞ ⎛N − M ⎞ ⎟ ⎜ ⎟⋅⎜ ⎜ k⎟ ⎜ n − k⎟ ⎠ ⎝ ⎝ ⎠ F h ( x )= ∑ ⎛N⎞ k ≤ x ⎜ ⎟ ⎜ n⎟ ⎝ ⎠ μ=n ⋅ M =n ⋅ p N - 20 Varianz (124) σ 2= Rekursionsformel: (125) N −n M N −M N −n ⋅ n ⋅ ⋅ ⋅ n ⋅ p ⋅ q = N −1 N N N −1 h ( x + 1| n ; M ; N ) = (n − x ) ⋅ (M − x ) ⋅ h ( x | n ; M; N ) (x + 1) ⋅ (N − M − n + x +1) 7. Spezielle stetige Wahrscheinlichkeitsmodelle 7.1 Normalverteilung 7.1.1 Normalverteilung N(x│μ,σ2) Dichtefunktion: (126) N ( x | μ ,σ 2 ) = f ( x ) = σ Verteilungsfunktion: ⎡ ( u − μ )2 ⎤ exp ⎢ ⎥ du ∫ 2 −∞ ⎣ 2σ ⎦ x 1 (127) F ( x ) = ⎡ ( x − μ )2 ⎤ ⋅ exp ⎢ − ⎥ (− ∞< x<∞ ) 2 σ2 ⎦ 2 π ⎣ 1 σ 2π Mittelwert und Varianz: ⋅ E(X) = μ Var ( X ) = σ 2 (128a) (128b) Momenterzeugende Funktion: ⎛ σ 2 ⋅ t2 ⎜ μ exp ( t ) = ⋅ t + mx ⎜ 2 ⎝ (129) ⎞ ⎟⎟ ⎠ 7.1.2 Standardnormalverteilung N(z│0,1) Standardisierung: (130) Z = X − μ σ Dichtefunktion: (131) N ( z |0 ,1 )= ϕ ( z )= Verteilungsfunktion: (132) φ ( z )= 1 2π ⎛ u2 ⎞ exp ⎜⎜ − ⎟⎟ d u ∫ ⎝ 2 ⎠ − ∞ z ⋅ 2 ⎛ ⎞ ⋅ exp ⎜ − z ⎟ ( − ∞ < z < ∞ ) 2π ⎝ 2 ⎠ 1 Momenterzeugende Funktion: ⎛ 1 ⎞ (133) m x ( t ) = exp ⎜ ⋅ t 2 ⎟ ⎝ 2 ⎠ - 21 Wichtige Beziehung: ⎛ X −μ ⎞ (134) F ( x ) = φ ⎜ ⎟ ⎝ σ ⎠ Symmetrische Fläche unter der Dichtefunktion: z ⎛ u2 ⎞ 1 (135) ψ ( z )= ⋅ ∫ exp ⎜⎜ − ⎟⎟ d u 2 π −z ⎝ 2 ⎠ Es gelten folgende Beziehungen: (136a) (136b) (136c) φ( −z) = 1 − φ(z) 1 ψ(z) + φ(z) = 2 2 1⎞ ⎛ ψ(z) = 2 ⎜ φ(z) − ⎟ ⎝ 2 ⎠ ⎛ b−μ ⎞ ⎛ a−μ ⎞ W ( a ≤ X ≤ b )= F ( b ) − F ( a )= φ ⎜ ⎟ −φ ⎜ ⎟ ⎝ σ ⎠ ⎝ σ ⎠ Kenngrößen: (137) (138a) μ (138b) σ2 (138c) σ = 1 (138d) γ = 0 (138e) ε = 0 = 0 = 1 - 22 Wahrscheinlichkeiten der Standardnormalverteilung N(z∗0,1) Werte der Verteilungsfunktion Symetrische Intervallwahrscheinlichkeit Es gilt: Φ(-z) = 1 - Φ(z) Es gilt: ψ(z) = 2Φ(z) - 1 z Φ(z) ψ(z) 0,0 0,5000 0,0000 0,1 0,5398 0,0796 0,2 0,5793 0,1585 0,3 0,6179 0,2358 0,4 0,6554 0,3108 0,5 0,6915 0,3829 0,6 0,7257 0,4515 0,7 0,7580 0,5161 0,8 0,7881 0,5763 0,9 0,8159 0,6319 1,0 0,8413 0,6827 1,1 0,8643 0,7287 1,2 0,8849 0,7699 1,3 0,9032 0,8064 1,4 0,9192 0,8385 1,5 0,9332 0,8664 1,6 0,9452 0,8904 1,7 0,9554 0,9109 1,8 0,9641 0,9281 1,9 0,9713 0,9426 2,0 0,9772 0,9545 2,1 0,9821 0,9643 2,2 0,9861 0,9722 2,3 0,9893 0,9786 2,4 0,9918 0,9836 2,5 0,9938 0,9876 2,6 0,9953 0,9907 2,7 0,9965 0,9931 2,8 0,9974 0,9949 2,9 0,9981 0,9963 3,0 0,9986 0,9973 - 23 Häufig gebrauchte Werte: 7.1.3 Φ (z) = 0,975 Φ (z) = 0,95 → → z = 1,96 z = 1,65 ψ (z) = 0,90 ψ (z) = 0,95 ψ (z) = 0,975 ψ (z) = 0,99 → → → → z = 1,65 z = 1,96 z = 2,24 z = 2,58 Mehrdimensionale Normalverteilung N(x│μ, ∑) (μ = Erwartungswert, ∑ = Varianz-Kovarianz-Matrix, T = Transposition) Dichtefunktion: (139a) N ( x | μ , Σ) = f ( x )= ( 2π ) n 1 ⋅ det ∑ ⎡ 1 ⋅ exp ⎢− ⋅ ( x − μ ) T ⋅ ∑ − 1 ⋅ ( x − μ ⎣ 2 für x ∈ R n ⎛ σ 12 σ 1 2 ⎛ μ1⎞ ⎜ ⎜ ⎟ ⎜σ ⎜μ ⎟ 2 ⎜ 2 1 σ2 ⎜ 2⎟ ⎜ . ⎜ .⎟ . μ = ⎜ ⎟ und ∑ = ⎜ mit ⎜ . ⎜ .⎟ . ⎜ ⎜ ⎟ . ⎜ . ⎜ .⎟ ⎜⎜ ⎜⎜ ⎟⎟ ⎝ μn⎠ ⎝σ n 1 σ n 2 Momenterzeugende Funktion: 1 ⎡ T T (139b) m x ( t ) = exp ⎢ μ ⋅ x + ( x ⋅ 2 ⎣ ( 7.2 ) . . . . . . . . . σ 1 n⎞ ⎟ . σ 2 n⎟ ⎟ .⎟ ⎟ .⎟ ⎟ . .⎟ ⎟ . σ 2n ⎟⎠ ⎤ ∑ ⋅ x )⎥ ⎦ Exponentialverteilung (140a) Dichtefunktion: (140b) Verteilungsfunktion: (141a) Erwartungswert: (141b) Varianz: (141c) f ( x ) = a e− a x F(x) = 1 − e 1 μ = a 1 σ2 = a2 Momenterzeugende Funktion: mx ( t ) = (a > 0 ; x ≥ 0) −a x 1 1 − keine Reproduktivität t a ⎤ )⎥ ⎦ - 24 7.3 Lineare Verteilungen Verteilung Gleichverteilung (Rechtecksverteilung) Dichtefunktion Mittelwert/ Varianz 1 b − a (a ≤ x ≤ b) a+b 2 2 ( b−a ) 2 σ = 12 f (x) = (142a) linksschiefe Dreiecksverteilung f ( x )= 2 ⋅ ( x−a ) ( b−a ) ( a≤ x≤b ) 2 (142b) rechtsschiefe Dreiecksverteilung f ( x )= 2 ⋅ ( b−x ) ( b−a ) ( a≤ x≤b ) 2 (142c) Unimodale symmetrische Dreiecksverteilung (142d) μ= ( a+2 b ) 3 ( b − a )2 2 σ = 18 μ= (2 a + b) 3 2 (b − a ) = 18 μ = σ2 f ( x )= ⎧4 ⋅ ( x − a ) a +b ⎞ ⎛ für ⎜ a ≤ x ≤ ⎟ ⎪ 2 2 ⎠ ⎝ ⎪ ( b − a) ⎨ ⎪ - 4 ⋅ ( x−b ) für ⎛⎜ a +b≤ x ≤ b⎞⎟ ⎪ ( b−a )2 ⎝ 2 ⎠ ⎩ a+b 2 ( b − a )2 2 = σ 24 μ= f (x) = Symmetrische V - Verteilung (142e) a+ b ⎞ ⎧- 4x + 2a + 2b ⎛ ⎟ ⎪ ( b − a )2 für ⎜⎝ a ≤ x ≤ 2 ⎠ ⎪ ⎨ 4x - 2a − 2b ⎛ a + b⎞ ⎪ ⎟ für ⎜ 2 ⎝ 2 ⎠ ⎪⎩ (b− a) ( a+b ) 2 ( b − a )2 2 σ = 8 μ= - 25 7.4 Testverteilungen Verteilungsfunktionen werden zur Prüfung statistischer Hypothesen herangezogen. Die Verteilungen sind tabelliert. Es handelt sich um unabhängige Zufallsvariablen. 7.4.1 χ2 - Verteilung X1, X2, . . . , Xν seien standardnormalverteilt. Dann heißt v χ 2 = ∑ X i2 (143a) i=1 χ2 - verteilt mit ν Freiheitsgraden [χ2 (ν)] 7.4.2 t - Verteilung (Student) Ist X standardnormalverteilt und Y χ2(ν) - verteilt, so heißt X t= (144) 1 ⋅Y v t - verteilt mit ν Freiheitsgraden [t(ν)]. 7.4.3 F - Verteilung (Snedecor) Ist X χ2(ν1) - verteilt und Y χ2(ν2) - verteilt, so heißt 1 ⋅ X v 1 (145) F= 1 ⋅Y v2 F - verteilt mit (ν1,ν2) Freiheitsgraden [F(ν1,ν2)]. 8. Grenzwertsätze 8.1 8.2 Stochastische Konvergenz Eine Zufallsvariable Xn strebt mit n → ∞ stochastisch gegen θ (wahrer Wert), wenn für jedes ε > 0 gilt: (146) lim P ( | X n − θ | < ε )= 1 n →∞ 8.3 Tschebyscheff'sche Ungleichung X sei eine Zufallsvariable, c eine gegebene Konstante, ε > 0. (147) P ( | X − c|≥ ε )≤ 1 ε 2 ⋅ E ( X − c )2 Spezialisierung c = μ: Abweichungen einer Zufallsvariablen von ihrem Mittelwert. (148) P (| X − μ |≥ ε )≤ σ2 ε2 - 26 Man drückt ε durch Vielfaches von σ aus: ε = tσ 1 P ( | X − μ |≥ t ⋅ σ )≤ 2 (149) t Umgeschrieben auf die Gegenwahrscheinlichkeit: 1 P ( | X − μ |< t ⋅ σ ) ≥ 1 − 2 (150) t 8.3 Gesetz der großen Zahlen Homograder Fall (qualitative Merkmale) Theorem von Bernoulli ⎛ m − p ≥ε (151) P ⎜⎜ ⎝ n (152) ⎞ p ⋅ q ⎟⎟ ≤ 2 ⎠ n ⋅ε p ⋅ q ⎞ m − p < ε ⎟⎟ ≥ 1 − n n ⋅ ε2 ⎠ ⎛ P ⎜⎜ ⎝ für n → ∞ : Gesetz der großen Zahl ⎛ m ⎞ − p < ε ⎟⎟ = 1 (153) P ⎜⎜ lim n →∞ ⎝ n ⎠ Heterograder Fall (quantitative Merkmale) X1, X2, . . . , Xn seien identisch verteilte unabhängige Zufallsvariable (Stichprobe). Für den Mittelwert der Stichprobe gilt: 1 n (154) Xn = ∑ Xi n i=1 (155) (156) P ( X n − μ ≥ ε )≤ P( σ2 n ⋅ ε2 2 σ X n − μ < ε )≥ 1 − n ⋅ ε2 für n → ∞ : Gesetz der großen Zahl (157) lim P ( n →∞ X n − μ < ε )= 1 Hauptsatz der mathematischen Statistik (Gliwenko): Die empirische Verteilungsfunktion einer Stichprobe konvergiert mit wachsendem Stichprobenumfang stochastisch gegen die Verteilungsfunktion der Grundgesamtheit. - 27 8.4 Zentrale Grenzwertsätze Grenzwertsatz von de Moivre, Laplace: Approximation der Binomialverteilung durch die Normalverteilung X −n ⋅ p (158) Z= ≅ N ( z |0 , 1 ) n ⋅ p ⋅ q Zentraler Grenzwertsatz: Unter sehr allgemeinen, praktisch immer erfüllten Bedingungen sind Summen und Durchschnitte (Stichprobenmittelwerte) von unabhängigen Zufallsvariablen für große n angenähert normalverteilt. Grenzwertsatz von Lindeberg - Levy: X1, X2, . . . , Xn seien identisch verteilte unabhängige Zufallsvariable mit Mittelwert μ und Varianz σ2: X + X2 + . . . +Xn−n ⋅ μ Z= 1 ≅ N ( z |0 , 1 ) (159) σ ⋅ n − μ Z= Xn ⋅ n ≅ N ( z |0 , 1 ) (160) σ Grenzwertsatz von Ljapunoff: X1, X2, . . . , Xn seien beliebig verteilte unabhängige Zufallsvariable mit Mittelwerten μi und Varianz σi2: n x i − μi (161) Z= ∑ ≅ N ( z |0 , 1 ) i=1 ∑σ 2 i i Folgerungen aus dem zentralen Grenzwertsatz: 1. Für große n und nicht zu kleine Werte von p (oder) q ( Als Faustregel gilt: npq > 4 − brauchbare Näherung, npq > 9 ∼ gute Näherung;) kann die Binomialverteilung durch eine Normalverteilung approximiert werden (Grenzwertsatz von de Moivre, Laplace). 2. Für große n und kleine Auswahlsätze n/N läßt sich die hypergeometrische Verteilung durch eine Normalverteilung approximieren. 3. Für λ > 4 (brauchbare Näherung) oder λ > 9 (gute Näherung) läßt sich die Poisson - Verteilung durch eine Normalverteilung approximieren. X −λ Z= ≅ N ( z |0 , 1 ) (162) λ 4. Für Summen und Durchschnitte von Variablen (Stichprobenmittelwerte) gilt, daß diese bei genügend großem n (n > 30) annähernd normalverteilt sind, gleichqültig, aus welcher Ausgangsverteilung sie stammen. - 28 - 9. Grundlagen der Schätztheorie 9.1 Punktschätzungen N = Umfang der Grundgesamtheit; n = Umfang der Stichprobe Homograder Fall: (Qualitative Merkmale) Grundgesamtheit: Urne mit zweierlei Kugeln, weiß und schwarz (O,1 - Variable). M (163) P = = Anteilsatz in der Grundgesamtheit N m (164) p = = Anteilsatz in der Stichprobe n (165) σ 2 = P ⋅ Q = P ( 1 − P ) = Varianz der Grundgesamtheit n⋅ p ⋅q = Varianz der Stichprobe (166) s 2 = n −1 Heterograder Fall: (Quantitative, diskrete Merkmale) Grundgesamtheit: Urne mit Kugeln auf denen zahlenmäßige Merkmalsausprägungen vemerkt sind. Mittelwert und Varianz der Grundgesamtheit k N (167) μ= ∑x (168) bzw. μ = i=1 N N σ = 2 i ∑ ∑x i ⋅ Ni i=1 N k ∑ ( x −μ ) ( x i − μ )2 2 i bzw. σ = 2 i=1 N ⋅ Ni i=1 N Mittelwert und Varianz der Stichprobe k n (169) ∑x x= i bzw. x = i=1 n ∑x i ⋅ ni i=1 n n k ∑( x −x ) ∑( x −x ) 2 2 i (170) 2 s = i=1 i 2 n −1 bzw. s = i=1 n −1 ⋅ ni - 29 Varianz der Stichprobenmittelwerte Homograder Fall: P ⋅ Q N −n ⋅ n N −1 P ⋅Q = n (171) Var ( P ) = σ 2P = (172) Var ( P ) = σ 2P (Fall ohne Zurücklegen) (Fall mit Zurücklegen) Heterograder Fall: (173) (174) ( )= Var ( X ) = Var X σ 2 X = σ2 ⋅ N −n n (Fall ohne Zurücklegen) N −1 σ2 σ 2X = (Fall mit Zurücklegen) n Schätzwerte der Varianz der Stichprobenmittelwerte (Wenn nicht alle möglichen Stichprobenmittelwerte vorliegen) Homograder Fall: p ⋅ q N −n ⋅ n −1 N p ⋅q = n −1 (175) var ( p ) = σˆ 2p = (Fall ohne Zurücklegen) (176) var ( p ) = σˆ 2p (Fall mit Zurücklegen) Heterograder Fall: (177) (178) 9.2 ( )= var ( x ) = var x 2 N −n s ⋅ σˆ 2x = (Fall ohne Zurücklegen) σˆ 2x (Fall mit Zurücklegen) n 2 s = n N Kriterien für Punktschätzungen (Kriterien guter Schätzfunktionen) 9.2.1.Konsistenz Bei zunehmendem Stichprobenumfang n strebt der Schätzwert θ$n stochastisch gegen den wahren Wert θ. (179a) lim P θˆn − θ < ε = 1 ( lim P ( n →∞ (179b) z.B.: n →∞ ) X n − μ < ε )= 1 - 30 9.2.2 Erwartungstreue Der Durchschnitt aller Stichprobenmittelwerte ergibt den wahren Wert: (180a) E θ$ = θ (180b) z.B.: ( ) E( X ) (180c) z.B.: E( S (180d) z.B.: E ( S2 ) 2 ) μ = = = σ2 (im Fall mit Zurücklegen) N ⋅ σ2 N −1 (im Fall ohne Zurücklegen) 9.2.3 Effizienz Von zwei erwartungstreuen Schätzfunktionen heißt diejenige effizienter, die die kleinere Varianz besitzt. θ$1 heißt effizienter als θ$2 , wenn gilt: (181) ( ) Var ( θˆ1 ) < Var θˆ2 9.2.4 Asymptotische Normalverteilung Strebt die Verteilung der Schätzwerte θ$n für großen Stichprobenumfang n gegen die Normalverteilung so erhält man asymptotisch normalverteilte Schätzwerte. Bei großem n verteilen sich z.B. die Stichprobenmittelwerte asymptotisch normal. 9.2.5 Suffizienz Gegebene Stichprobe schöpft alle relevanten Informationen aus. 9.3 Intervallschätzungen Fall: Inklusionsschluß (direkter Schluß) Für den Anteilssatz in der Stichprobe: Homograder Fall a) ohne Zurücklegen P ⋅Q N −n P ⋅Q N −n (182) P − z ⋅ ⋅ ≤ p ≤ P+ z ⋅ ⋅ n N −1 n N −1 (183) P − z ⋅ b) mit Zurücklegen P ⋅Q ≤ p ≤ P+ z ⋅ n P ⋅Q n Für den Stichprobenmittelwert: Heterograder Fall a) ohne Zurücklegen σ σ N −n N −n (184) μ − z ⋅ ⋅ ≤ x ≤ μ+z⋅ ⋅ N −1 N− 1 n n b) mit Zurücklegen (185) μ − z ⋅ σ n ≤ x ≤ μ+z ⋅ σ n - 31 Fall: Repräsentationsschluß (indirekter Schluß) Für den Anteilssatz in der Grundgesamtheit: Homograder Fall a) ohne Zurücklegen N −n p⋅q (186) p − z ⋅ ⋅ ≤ P ≤ p+ z ⋅ n −1 N (187) p − z ⋅ p ⋅ q N −n ⋅ n −1 N b) mit Zurücklegen p ⋅ q ≤ P ≤ p+ z ⋅ n −1 p ⋅ q n −1 Für den Mittelwert der Grundgesamtheit: Heterograder Fall (188) x − z ⋅ a) ohne Zurücklegen N −n s ⋅ ≤ μ ≤ x+ z ⋅ N n s N −n ⋅ N n b) mit Zurücklegen s ≤ μ ≤ x+ z ⋅ (189) x − z ⋅ n s n Bemerkungen: 1. Die zugehörige Konfidenzwahrscheinlichkeit ist jeweils: z 1 ⎛ u2 ⎞ ψ ( z )= ⋅ exp ⎜⎜ − ⎟⎟ d u = ( 1 − α ) ⋅ 100 % 2 π −∫z ⎝ 2 ⎠ N− n N − n n 2. Der Korrekturfaktor für die Varianz tritt nur im Fall ohne = 1 − ≈ N − 1 N N Zurücklegen auf. Wird er im Fall ohne Zurücklegen vernachlässigt, so ergeben sich größere Vertrauensintervalle (d.h. schlechtere Abschätzungen). Für n/N ≤ 0,05 kann der Korrekturfaktor auch im Fall ohne Zurücklegen durch 1 ersetzt werden. 9.4 Schätzfehler, Intervallänge und Stichprobenverlauf Der Schätzfehler ist definiert: Heterograder Fall: (190) e = z ⋅ σx Homograder Fall: (191) e = z ⋅ σp wobei für σ x bzw. σ p die Formeln (171) bis (174) gelten. - 32 Relativer Fehler = relative Genauigkeit Homograder Fall ohne Zurücklegen: (192) er = e = z ⋅ P Q N −n ⋅ n ⋅ P N −1 Heterograder Fall ohne Zurücklegen: er = (193) e μ = z ⋅ 2 N −n V ⋅ n N −1 ⎛ σ ⎜⎜ V = = Variations koeffizient μ ⎝ ⎞ ⎟⎟ ⎠ Auflösung nach n ergibt die Formeln für den notwendigen Stichprobenumfang. Bei Vernachlässigung des Korrekturfaktors vereinfachen sich die Formeln. Formeln für den notwendigen Stichprobenumfang Fall: ohne Korrekturfaktor mit Korrekturfaktor* Homograd: Absoluter Fehler e vorgegeben (194) n ≥ 2 z ⋅P⋅Q 2 e Relativer Fehler er vorgegeben (196) n ≥ 2 z ⋅Q 2 er ⋅ P Absoluter Fehler e vorgegeben (198) n ≥ 2 2 z ⋅σ 2 e (199) n ≥ Relativer Fehler er vorgegeben (200) n ≥ 2 2 z ⋅V 2 er (201) n ≥ (195) n ≥ (197) n ≥ ⎛ ⎜⎜ ⎝ ⎛ ⎜⎜ ⎝ N N ⋅ e2 1+ 2 z ⋅ P ⋅Q N N ⋅ e 2r ⋅ P 1+ 2 z ⋅Q ⎞ ⎟⎟ ⎠ Heterograd: * ⎛ ⎜⎜ ⎝ N N ⋅ e2 1+ 2 2 z ⋅σ ⎞ ⎟⎟ ⎠ ⎛ ⎜⎜ ⎝ N N ⋅ e2r 1+ 2 2 z ⋅V ⎞ ⎟⎟ ⎠ Bei mit Korrekturfaktor wird der Einfachheit halber N - 1 ≈ N gesetzt. Da PQ, σ2 bzw. Q/P, V2 unbekannt sind, müssen sie möglichst ungünstig (d.h. durch Maximalwerte) abgeschätzt werden. ⎞ ⎟⎟ ⎠ - 33 - 10. Testtheorie 10.1 Fehlerarten und Entscheidungsregeln Fehler 1. Art H0 wird verworfen, obwohl die Hypothese richtig ist. (Wahrscheinlichkeit des Fehlers = α bzw. Signifikanzniveau des Tests) Fehler 2. Art H0 wird angenommen, obwohl die Hypothese falsch ist. (Wahrscheinlichkeit des Fehlers = β ; 1 - β = Güte des Tests) Die Entscheidungsregel besagt: Ist die Teststatistik T , die aus der gegebenen Stichprobe errechnet wurde, kleiner als der kritische Wert bei gegebenem Signifikanzniveau α , dann behält man die Nullhypothese H0 bei, also bei (202) | T | ≤ t ( α ) bzw. F ( α ) bzw. χ 2 ( α ) bzw. z Ist dagegen (203) | T | > t ( α ) bzw. F ( α ) bzw. χ 2 ( α ) bzw. z wird die Nullhypothese verworfen. 10.2 Unterschied bei Anteilssätzen und Mittelwerten 10.2.1 Ein - Stichproben - Problem Homograder Fall (Anteilsätze): Stichprobenumfang n, Anteilsatz p (204) 1. P > P0 H 0 : P = P0 ; H 1 : 2. P ≠ P0 3. P < P0 T= p − P0 P0 ⋅ ( 1 − P0 ) ⋅ n - 34 Heterograder Fall (Mittelwerte): Stichprobenumfang n, Anteilsatz x (205) 1. μ > μ 0 H 0 : μ = μ 0 ; H 1 : 2. μ ≠ μ 0 3. μ < μ 0 T= x − μ0 s ⋅ n Die Testgröße T ist bei kleinem Stichprobenumfang t - verteilt, mit ν = n - 1 Freiheitsgraden und bei großem Stichprobenumfang (n > 30) standardnoralverteilt. 10.2.2 Zwei - Stichproben - Problem (σ - Differenz - Verfahren) Homograder Fall: Stichprobe 1: n1, p1; Stichprobe 2: n2, p2: (206) 1. P1 > P 2 H 0 : P1 = P 2 ; H 1 : 2. P1 ≠ P 2 3. P1 < P 2 T= mit (207) p ⋅ ( 1 − p )= p1 − p 2 ⎛ 1 1 p ⋅ ( 1 − p ) ⋅ ⎜⎜ + ⎝ n1 n 2 ⎞ ⎟⎟ ⎠ n1 ⋅ p 1 ⋅ ( 1 − p 1 ) + n 2 ⋅ p 2 ⋅ ( 1 − p 2 n1 + n 2 − 2 ) - 35 Heterograder Fall: Stichprobe 1: n1 , x1 , s12 Stichprobe 2: n2 , x 2 , s22 (208) 1. μ 1 > μ 2 H 0 : μ 1 = μ 2 ; H 1 : 2. μ 1 ≠ μ 2 3. μ 1 < μ 2 T= x1 − x 2 ⎛ 1 1 ⎞ 2 ⎟⎟ s ⋅ ⎜⎜ + ⎝ n1 n 2 ⎠ mit ( n1 − 1 ) ⋅ s12 + ( n 2 − 1 ) ⋅ s 22 n1 + n 2 − 2 Die Testgröße T ist bei kleinem Stichprobenumfang t - verteilt, mit ν = n1 + n2 - 2 Freiheitsgraden und bei großem Stichprobenumfang (n > 30) standardnormalverteilt. (209) 10.3 2 s = Prüfung anderer Parameter 10.3.1 Unterschied der Varianzen a) Ein - Stichprobenproblem Stichprobe: n , s: (210) 1. σ > σ 0 H 0 : σ = σ 0 ; H 1 : 2. σ ≠ σ 0 3. σ < σ 0 T= ( n - 1 ) ⋅ s2 σ 02 Die Testgröße T ist χ2 - verteilt mit ν = n - 1 Freiheitsgraden. - 36 b) Zwei - Stichprobenproblem Stichprobe 1: n1 , s12 (211) Stichprobe 2: H0 : σ 1 = σ 2 ; s12 T = 2 s2 ( bei Die Testgröße T ist F - verteilt mit 10.3.2 n2 , s22 H1 : σ 1 > σ 2 s1 > s2 ) ν1 = n1 - 1 und ν2 = n2 - 1 Freiheitsgraden. Abweichung des Korrelationskoeffizienten von 0 Korrelationskoeffizient einer Stichprobe mit Umfang n : (212) H0 : ρ =0 ; T= r s H1 : ρ ≠0 r= mit sx y sx ⋅ sy 2 s = 1 - r2 n-2 Die Testgröße T ist t - verteilt mit ν = n - 2 Freiheitsgraden. 11. Nichtparametrische Testverfahren 11.4 χ2 -Test 11.4.1 Anpassungstest Test auf Übereinstimmung zwischen gegebener empirischer Häufigkeitsverteilung und theoretischer Verteilung i = 1 , .... k = Merkmale bzw. Klassen ni = empirisch beobachtete Werte (absolute Häufigkeiten) ei = n f(xi) = theoretisch erwartete Werte im diskreten Fall ei = n ΔFi(x) = theoretisch erwartete Werte im stetigen Fall wobei: (213) k k ∑ n = ∑ e =n i i=1 i i=1 H1 : F ( x ) ≠ F 0 ( x ) H0 : F ( x ) = F 0 ( x ) ; k T = ∑ i = 1 ( ni − ei ei )2 ni2 = ∑ − n i = 1 ei k Die Testgröße T ist χ2 - verteilt mit ν = k - 1 Freiheitsgraden. - 37 - 11.4.2 Unabhängigkeitstest zwischen zwei Variablen X , Y Test auf Übereinstimmung zwischen empirisch beobachteten Häufigkeiten nij (i = 1, ..., k; j = 1, ..., l) und den theoretisch erwarteten Häufigkeiten eij, die eintreffen würden, wenn X und Y unabhängig wären. Unabhängigkeitsannahme: fij = fi..f.j nij = empirisch beobachtete Häufigkeiten eij = n.fi..f.j = 1/n.(ni..n.j) = theoretisch erwartete Häufigkeiten (214) H 0 : Die zwei Variablen sind unabhängig Die zwei Variablen sind abhängig H1 : k l i = 1 j = 1 ∑ ∑ T = (n i j − ei j ) 2 ei j Die Testgröße T ist χ2 - verteilt mit ν = (k - 1)(l - 1) Freiheitsgraden. Spezialfall: Es treten nur zwei Klassifikationen für die beiden Variablen auf: i = 1, 2; j = 1, 2 Dadurch reduziert sich die Kontigenztafel auf eine Vierfeldertafel: (215) T = j=1 j=2 fi. i=1 a b a+b i=2 c d c+d f.j a+c b+d a+b+c+d =n ( a ⋅ d − b ⋅ c )2 ⋅ n ( a+b ) ⋅ ( a+c ) ⋅ ( b+ d ) ⋅ ( c+ d ) Die Testgröße T ist χ2 - verteilt mit ν = 1 Freiheitsgraden. 11.4.3 Kolmogorov-Smirnov –Test (216) T = sup F ( x ) − F i x 0 ( xi ) - 38 11.4.4 Mann-Whitney-U-Test (217) T = n1 ⋅ n2 + n1(n1 + 1) − R1 2 Die Testgröße T ist U-verteilt. Sie geht bei n1 > 10 und n2 > 10 in eine Normalverteilung mit denselben Parameter über. 11.4.5 Kruskall-Wallis-Test k ⎛ R2 ⎞ 12 (218) T = ⋅ ∑ ⎜⎜ i ⎟⎟ − 3 ⋅ (n + 1) n ⋅ (n + 1) i =1 ⎝ ni ⎠ Die Testgröße T ist h-verteilt. Sie geht bei ni > 5 in eine χ2-Verteilung mit. ν = k − 1 Freiheitsgraden über. 11.4.6 McNemar-Test + a c + - b d (219) Bei n ≤ 20 : T = b Die Testgröße T ist binomialverteilt mit p 0 = 0,5 und n = c + b (220) Bei n > 20 : T = (b − c) 2 b+c Die Testgröße T ist χ2-verteilt mit ν = 1 Freiheitsgrad. 11.4.7 Cochrans Q-Test 2 Y⎞ ⎛ l (l − 1)∑ ⎜ y⋅ j − ⎟ (l − 1)(l ∑ Y⋅ 2j − Y 2 ) l⎠ ⎝ (221) Bei T = = l ⋅ Y − ∑ Yi ⋅2 ∑ Yi⋅ (l − Yi⋅ ) Die Testgröße T ist χ2-verteilt mit ν = (l − 1) Freiheitsgraden. 11.4.8 Wilcoxon-Test (222) T = ∑ Ri (+ ) 11.4.8 Friedman-Test (223) T = l 12 R 2j − 3n(l + 1) ∑ n ⋅ l ⋅ (l + 1) j =1 Die Testgröße T ist χ2-verteilt mit ν = (l − 1) Freiheitsgraden (für n ≥ 10 und l ≥ 4 ). - 39 Kritische Werte t(α) der t-Verteilung für verschiedene α Signifikanzniveau α (Zweiseitige Fragestellung) Zahl der Freiheitsgrade u 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 35 40 50 60 80 100 500 1000 ∞ Zahl der Freiheitsgrade u 0,10 6,314 2,920 2,353 2,132 2,015 1,943 1,895 1,860 1,833 1,812 1,796 1,782 1,771 1,761 1,753 1,746 1,740 1,734 1,729 1,725 1,721 1,717 1,714 1,711 1,708 1,706 1,703 1,701 1,699 1,697 1,690 1,684 1,676 1,671 1,664 1,660 1,648 1,646 1,645 0,05 12,706 4,303 3,182 2,776 2,571 2,447 2,365 2,306 2,262 2,228 2,201 2,179 2,160 2,145 2,131 2,120 2,110 2,101 2,093 2,086 2,080 2,074 2,069 2,064 2,060 2,056 2,052 2,048 2,045 2,042 2,030 2,021 2,008 2,000 1,990 1,984 1,965 1,962 1,960 0,01 63,657 9,925 5,841 4,604 4,032 3,707 3,499 3,355 3,250 3,169 3,106 3,055 3,012 2,977 2,947 2,921 2,898 2,878 2,861 2,845 2,831 2,819 2,807 2,797 2,787 2,779 2,771 2,763 2,756 2,750 2,724 2,704 2,678 2,660 2,638 2,626 2,586 2,581 2,576 0,050 0,025 0,005 Signifikanzniveau α (einseitige Fragestellung) - 40 Ausgewählte Werte der χ2-Verteilung (für ν = 1, ... Freiheitsgrade und gegebene α-Werte) Zahl der Freiheitsgrade ν α 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 40 50 60 70 80 90 100 0,99 0,00 0,02 0,11 0,30 0,55 0,87 1,24 1,65 2,09 2,56 3,05 3,57 4,11 4,66 5,23 5,81 6,41 7,01 7,63 8,26 8,90 9,54 10,20 10,86 11,52 12,20 12,88 13,56 14,26 14,95 22,16 29,71 37,48 45,44 53,54 61,75 70,06 0,95 0,00 0,10 0,35 0,71 1,14 1,64 2,17 2,73 3,32 3,94 4,57 5,23 5,89 6,57 7,26 7,96 8,67 9,39 10,12 10,85 11,59 12,34 13,09 13,85 14,61 15,38 16,15 16,93 17,71 18,49 26,51 34,76 43,19 51,74 60,39 69,13 77,93 χ2(α) 0 Signifikanzniveau α 0,90 0,02 0,21 0,58 1,06 1,61 2,20 2,83 3,49 4,17 4,86 5,58 6,30 7,04 7,79 8,55 9,31 10,08 10,86 11,65 12,44 13,24 14,04 14,85 15,66 16,47 17,29 18,11 18,94 19,77 20,60 29,05 37,69 46,46 55,33 64,28 73,29 82,36 0,10 2,70 4,60 6,25 7,78 9,24 10,64 12,02 13,36 14,68 15,99 17,28 18,55 19,81 21,06 22,31 23,54 24,77 25,99 27,20 28,41 29,62 30,81 32,01 33,20 34,38 35,56 36,74 37,92 39,09 40,26 51,80 63,17 74,40 85,53 96,58 107,56 118,50 0,05 3,84 5,99 7,81 9,49 11,07 12,59 14,07 15,51 16,92 18,31 19,68 21,03 22,36 23,68 25,00 26,30 27,59 28,87 30,14 31,41 32,67 33,92 35,17 36,42 37,65 38,88 40,11 41,34 42,56 43,77 55,76 67,50 79,08 90,53 101,88 113,14 124,34 0,01 6,63 9,21 11,34 13,28 15,09 16,81 18,48 20,09 21,67 23,21 24,72 26,22 27,69 29,14 30,58 32,00 33,41 34,80 36,19 37,57 38,93 40,29 41,64 42,98 44,31 45,64 46,96 48,28 49,59 50,89 63,69 76,15 88,38 100,42 112,33 124,12 135,81 - 41 - Kritische Werte F(α) der F-Verteilung (ν1 = Freiheitsgrade der größeren Varianz) (α = 0,01) α 0 ν1 F(α) 3 4 5 6 7 8 9 10 12 15 20 30 40 60 ∞ 3 29,5 28,7 28,2 27,9 27,7 27,5 27,4 27,2 27,0 26,9 26,7 26,5 26,4 26,3 26,1 4 16,7 16,0 15,5 15,2 15,0 14,8 14,7 14,6 14,4 14,2 14,0 13,8 13,8 13,6 13,5 5 12,0 11,4 11,0 10,7 10,5 10,3 10,2 10,0 9,9 9,7 9,6 9,4 9,3 9,2 9,0 6 9,8 9,2 8,8 8,5 8,3 8,1 8,0 7,9 7,7 7,6 7,4 7,2 7,1 7,1 6,9 7 8,4 7,9 7,5 7,2 7,0 6,8 6,7 6,6 6,5 6,3 6,2 6,0 5,9 5,8 5,6 8 7,6 7,0 6,6 6,4 6,2 6,0 5,9 5,8 5,7 5,5 5,4 5,2 5,1 5,0 4,9 9 7,0 6,4 6,1 5,8 5,6 5,5 5,4 5,3 5,1 5,0 4,8 4,6 4,6 4,5 4,3 10 6,6 6,0 5,6 5,4 5,2 5,1 4,9 4,8 4,7 4,6 4,4 4,2 4,2 4,1 3,9 11 6,2 5,7 5,3 5,1 4,9 4,7 4,6 4,5 4,4 4,2 4,1 3,9 3,9 3,8 3,6 12 6,0 5,4 5,1 4,8 4,6 4,5 4,4 4,3 4,2 4,0 3,9 3,7 3,6 3,5 3,4 13 5,7 5,2 4,9 4,6 4,4 4,3 4,2 4,1 4,0 3,8 3,7 3,5 3,4 3,3 3,2 14 5,6 5,0 4,7 4,5 4,3 4,1 4,0 3,9 3,8 3,7 3,5 3,4 3,3 3,2 3,0 15 5,4 4,9 4,6 4,3 4,1 4,0 3,9 3,8 3,7 3,5 3,4 3,2 3,1 3,0 2,9 16 5,3 4,8 4,4 4,2 4,0 3,9 3,8 3,7 3,6 3,4 3,3 3,1 3,0 2,9 2,8 17 5,2 4,7 4,3 4,1 3,9 3,8 3,7 3,6 3,5 3,3 3,2 3,0 2,9 2,8 2,6 18 5,1 4,6 4,2 4,0 3,8 3,7 3,6 3,5 3,4 3,2 3,1 2,9 2,8 2,7 2,6 19 5,0 4,5 4,2 3,9 3,8 3,6 3,5 3,4 3,3 3,2 3,0 2,8 2,8 2,7 2,5 20 4,9 4,4 4,1 3,9 3,7 3,6 3,5 3,4 3,2 3,1 2,9 2,8 2,7 2,6 2,4 25 4,7 4,2 3,8 3,6 3,5 3,3 3,2 3,1 3,0 2,8 2,7 2,5 2,4 2,4 2,2 30 4,5 4,0 3,7 3,5 3,3 3,2 3,2 3,0 2,8 2,7 2,6 2,4 2,3 2,2 2,0 40 4,3 3,8 3,5 3,3 3,1 3,0 3,0 2,8 2,7 2,5 2,4 2,2 2,1 2,0 1,8 60 4,1 3,6 3,3 3,1 3,0 2,8 2,8 2,6 2,5 2,4 2,2 2,0 1,9 1,8 1,6 120 4,0 3,5 3,2 3,0 2,8 2,7 2,6 2,5 2,3 2,2 2,0 1,9 1,8 1,7 1,4 ∞ 3,8 3,3 3,0 2,8 2,6 2,5 2,4 2,3 2,2 2,0 1,9 1,7 1,5 1,5 1 ν2 - 42 Werte der Verteilungsfunktion binomialverteilter Variablen für p = 0,5 und p = 0,1 sowie verschiedene n. n x p = 0,5 p = 0,1 5 10 15 18 20 15 20 0 0,031 0,001 0,000 0,000 0,000 0,206 0,122 1 0,187 0,011 0,000 0,000 0,000 0,549 0,392 2 0,500 0,055 0,004 0,001 0,000 0,816 0,677 3 0,813 0,172 0,018 0,004 0,001 0,944 0,867 4 0,969 0,377 0,059 0,015 0,006 0,987 0,957 5 1,00 0,623 0,151 0,048 0,021 0,998 0,989 6 0,828 0,304 0,119 0,058 1,000 0,998 7 0,945 0,500 0,240 0,132 1,000 1,000 8 0,989 0,696 0,407 0,252 1,000 1,000 9 0,999 0,849 0,593 0,412 1,000 1,000 10 1,000 0,941 0,760 0,588 1,000 1,000 11 0,982 0,881 0,748 1,000 1,000 12 0,996 0,952 0,868 1,000 1,000 13 1,000 0,985 0,942 1,000 1,000 14 1,000 0,996 0,979 1,000 1,000 15 1,000 0,999 0,994 1,000 1,000 16 1,000 0,999 1,000 1,000 17 1,000 1,000 1,000 1,000 18 1,000 1,000 1,000 1,000 19 1,000 1,000 1,000 20 1,000 1,000 1,000 - 43 Kritische Werte bei einem zweiseitigen Mann-Whitney-Test (auch U-Test) für (α = 0,05) (die obere Reihe in einer Zeile gibt den kritischen Wert an der Untergrenze tu, die untere Reihe an der Obergrenze to an). m n 2 3 4 5 6 7 8 9 10 11 12 2 - - - - - - 1 15 1 17 1 19 1 21 2 22 3 - - - 1 14 2 16 2 19 3 21 3 24 4 26 4 29 5 31 4 - - 1 15 2 18 3 21 4 24 5 27 5 31 6 34 7 37 8 40 5 - 1 14 2 18 3 22 4 26 6 29 7 33 8 37 9 41 10 45 12 48 6 - 2 16 3 21 4 26 6 30 7 35 9 39 11 43 12 48 14 52 15 57 7 - 2 19 4 24 6 29 7 35 9 40 11 45 13 50 15 55 17 60 19 65 8 1 15 3 21 5 27 7 33 9 39 11 45 14 50 16 56 18 62 20 68 23 73 9 1 17 3 24 5 31 8 37 11 43 13 50 16 56 18 63 21 69 24 75 27 81 10 1 19 4 26 6 34 9 41 12 48 15 55 18 62 21 69 24 76 27 83 30 90 11 1 21 4 29 7 37 10 45 14 52 17 60 20 68 24 75 27 83 31 90 34 98 12 2 22 5 31 8 40 12 48 15 57 19 65 23 73 27 81 30 90 34 96 38 106 - 44 Kritische Werte bei einem zweiseitigen Wilcoxon-Test (die obere Reihe in einer Zeile gibt den kritischen Wert an der Untergrenze tu, die untere Reihe an der Obergrenze to an). n Signifikanzniveau α 0,01 0,05 0,1 5 - - 1 14 6 - 20 7 - 8 n Signifikanzniveau α 0,01 0,05 0,1 15 16 104 26 94 31 89 3 18 16 20 116 30 106 36 100 3 25 4 24 17 24 129 35 118 42 111 1 35 4 32 6 30 18 28 143 41 130 48 123 9 2 43 6 39 9 36 19 33 157 47 143 54 136 10 4 51 9 46 11 44 20 38 172 53 157 61 149 11 6 60 11 55 14 54 21 43 188 59 172 68 163 12 8 70 14 64 18 60 22 49 204 66 167 76 177 13 10 81 18 73 22 69 23 55 221 74 202 84 192 14 13 92 22 83 26 79 24 62 238 82 218 92 208 25 69 256 90 235 101 224 - 45 Annahmekennzahlen c0 zum Kolmogorov-Smirnov-Test für n > 35 Signifikanzniveau α 0,1 1 Annahmekennzahl c0 n 0,05 1 1,224 n 0,01 1,358 1 n 0,001 1 1,628 n 1,949 Annahmekennzahlen c0 zum Kolmogorov-Smirnov-Test für n ≤ 35. Für kleine Stichproben sind die Werte in Abhängigkeit von n und α wie folgt tabelliert: n α=0,1 α=0,05 n α=0,1 α=0,05 n α=0,1 α=0,05 n α=0,1 α=0,05 3 0,636 0,708 13 0,325 0,361 23 0,247 0,275 33 0,208 0,231 4 0,565 0,624 14 0,314 0,349 24 0,242 0,269 34 0,205 0,227 5 0,509 0,563 15 0,304 0,338 25 0,238 0,264 35 0,202 0,224 6 0,468 0,519 16 0,295 0,327 26 0,233 0,259 36 0,199 0,221 7 0,436 0,483 17 0,286 0,318 27 0,229 0,254 37 0,196 0,218 8 0,410 0,454 18 0,278 0,309 28 0,225 0,250 38 0,194 0,215 9 0,387 0,430 19 0,271 0,301 29 0,221 0,246 39 0,191 0,213 10 0,369 0,409 20 0,265 0,294 30 0,218 0,242 40 0,189 0,210 11 0,352 0,391 21 0,259 0,287 31 0,214 0,238 50 0,170 0,188 12 0,388 0,375 22 0,253 0,281 32 0,221 0,234 100 0,121 0,134