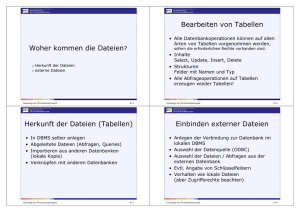

Data Management - Institut für Biometrie und Klinische Epidemiologie

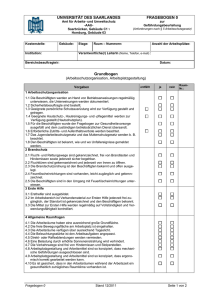

Werbung