Skript der Vorlesung

Werbung

Modeling and Data Analysis of Complex Systems

Markus Abel

Udo Schwarz, Karsten Ahnert, Carolina Figueras

8th May 2009

Contents

I

1. Vorlesung: Organisation und Motivation

2

1 Organisatorisches

1.1 Motivation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2

3

2 Ziel der Vorlesung

3

3 Komplexe Systeme

3

4 Modellierung komplexer Systeme

4

5 Modellierung und Datenalyse komplexer Systeme

6

6 Komplexe Systeme

7

7 Dynamische Systeme

7

8 Übung: Einführung in R

9

II

Zufallsvariablen

10

9 Eine Zufallsvariable

9.1 Wahrscheinlichkeitsdichte . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9.2 Mittelwerte und Momente . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9.3 Die charakteristische Funktion und die Kumulanten . . . . . . . . . . . . . .

1

10

10

11

11

10 Mehrdimensionale Zufallsvariablen

10.1 Wahrscheinlichkeitsdichte, charakteristische Funktion . . . . . . . . . . . . .

10.2 Summe der Zufallsvariablen, Zentraler Grenzsatz . . . . . . . . . . . . . . .

10.3 Stabile Wahrscheinlichkeitsverteilungen . . . . . . . . . . . . . . . . . . . . .

13

13

15

15

III

17

Zufallsvariablen

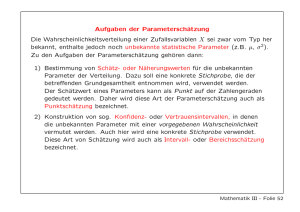

11 Schätzung

17

2

Part I

1. Vorlesung: Organisation und

Motivation

1

Organisatorisches

Dokumentation

Die Vorlesung wird dokumentiert

• klassich: per Mitschrift

• experimentell, da zum ersten mal: auf Video

• per Skript bzw. Kopie von Folien

• hosted von K.Ahnert: www.stat.physik.uni-potsdam.de/ kahnert/index.php?page=MDACS2009

Termine

Raum und Zeit

Do 11-12:30 Vorlesung, R. 2.28.0.104 Mo 11-12:30 Übung, Computerpool Literatur: s.

homepage

Statistik

Die Teilnehmer sind/haben ... ?

• Experimentatoren, Theoretiker?

• interessante Themen?

• Vorbildung?

• Programmierkenntnisse?

Erreichen des Vorlesungsziels

Wie üblich

gibt es Übungen und eine Klausur. An beiden muss erfolgreich teilgenommen worden sein.

Sprache

Wir bieten englisch an

Standard ist deutsch. Entscheidung nach Wunsch der Teilnehmer: Deutsch.

3

1.1

Motivation

Thema der Vorlesung

Warum soll man sich mit dem Thema beschäftigen. Wozu dient es?

• Wissenschaftlich: gute Modelle von neuen Systemen sind ein Dauerbrenner der Forschung.

Bsp.: Klima

• Industriell: Beispiel Finanzwelt

• Intellektuell: Es ist eine große Herausforderung gegebene Systeme einer Frage gemäß

zu abstrahieren und eine entsprechende Beschreibung zu finden.

2

Ziel der Vorlesung

Ziel der Vorlesung

Ziel der Vorlesung ist es, die theoretischen und technischen Kenntnisse zu vermitteln,

die nötig sind, ein komplexes System theoretisch zu analysieren, erhobene Daten statistisch/dynamisch zu verarbeiten und auf gefordertem Niveau zu modellieren.

3

Komplexe Systeme

Komplexe Systeme (gr. systema, das Gebilde,das Zusammengestellte)

• Was macht ein System komplex?

• Was ist ein System ?

• Was bedeutet komplex ?

• Wechselwirkungen vieler Komponenten

• Ein System ist eine Menge von Elementen oder Komponenten, die miteinander in

Beziehung stehen

• viele Komponenten oder nichtlineare Wechselwirkungen oder beides

Komplexe Systeme: Beispiele

• Gekoppelte Oszillatoren: Nichtlineare ODE’s

• Gekoppelte Abbildungen: Integratoren

• Fluid–Dynamik: Turbulenz, Akustik

4

• Plasmaphysik

• Astrophysik: Dynamik von N Himmelskörpern

• Physikalische Chemie: Polymere, Kolloide, Grenzflächen

• Ökonomie’: Börsencrash

• Klima, Wetter, Geodynamik

• Netzwerke: Verkehr, WWW, . . .

• Architektur von Computerprogrammen

• Populationsdynamik, Soziologie

• Biologie

4

Modellierung komplexer Systeme

Modellierung (lat. modulus,modus = Art, Weise)

Vereinfachte Beschreibung

um ein reales System zu erklären (Der Art und Weise, wie es funktioniert). Meist in mathematischer Form anhand von Gleichungen.

Modellierung

Verwirrenderweise

in verschiedenem Kontext semantisch verschieden benutzt

• Ingenieure: Nachbildung eines technischen Erzeugnisses in verkleinertem Maßstab,

auch als detailliertes Computerprogramm (im Ggs. zur Physik)

• Informatik: Abbild einer Software, bei OO z.B. mit UML

• Klima: Nachbilden z.T. unbekannter Mechanismen durch vernünftige Annahmen oder

Vergröberung

• Geschäftsprozesse: Abbild (z.T. sehr detailliert) eines Unternehmens oder einer Unternehmensidee.

• etc.

5

Modellierung: Beispiel Physikalisches Pendel

Aufgabe:

Bestimmung der Periode einer Pendeluhr, mit grober Genauigkeit

Vernünftige Annahmen

• keine Reibung

• Punktmasse

• Achse ohne Masse

• Kräftegleichgewicht

Man erhält die Gleichung für das mathematische Pendel

mlφ̈ = mg sin(φ)

pg

mit kleiner Auslenkung φ̈ + l φ = 0

(1)

Modellierung: Beispiel Physikalisches Pendel

Aufgabe:

Bestimmung der Periode einer Pendeluhr, mit hoher Genauigkeit

Vernünftige Annahmen

• keine Reibung

• Punktmasse

• Achse ohne Masse

• Kräftegleichgewicht

Man erhält die Gleichung für das physikalische Pendel

I φ̈ + kφ + f (φ, φ̇) + mgl sin(φ)

(2)

I ist das Trägheitsmoment, f eine nichtlineare Reibung.

Modellierung: Fazit

Modellierung – eine hohe Kunst

Bei der Modellierung komplexer Systeme ist es unbedingt nötig genau nachzudenken, welche

Fragen man beantworten will. Je nach Anforderung kann mehr oder weniger genau modelliert

werden. Im Falle komplexer Wechselwirkungen muss identifiziert werden, welche Komponenten für welche Effekte wichtig sind, Hierarchien oder Skalenprinzipien können erstellt

werden.

6

5

Modellierung und Datenalyse komplexer Systeme

Modellierung und Datenanalyse

Bei völlig unbekannter Funktionsweise

eines Systems und der Unterkomponenten kann man meist durch Messung Informationen

erhalten.

• Nicht alle Fragen können immer beantwortet werden

• Unmöglichkeit der direkten Messung (z.B. bei Zerstörung)

• zu lange Messungen

• zu teure Messungen

• zu komplexe Ausgabe

Modellierung und Datenanalyse

Gezielte Fragen

helfen beim Design einer Messung deren Ausgabe bzw. deren Daten (lat. datum, das

Gegebene), analysiert wird und so als Eingabe für ein Modell dient.

Bei Kenntnis oder Annahme eines Modells

bleibt immer noch die Bestimmung von Parametern, die oft qualitative und quantitative Dynamik eines Systems bestimmen. Z.B. die genaue Kenntnis einer Spannungs-Dehnungskurve

eines Werkstücks, das belastet wird.

Modellierung und Datenanalyse

Datenanalyse (gr. analein, auflösen)

bedeutet also im Rahmen dieser Vorlesung die Untersuchung von Daten, die man aus einer

Messung erhält. Die Messung wird an einem System vorgenommen, dessen Funktionsweise

man verstehen will. Mindestens möchte man eine Charakterisierung erhalten, die es ermöglicht

verschiedene Klassen von Systemen oder Parametern zu unterscheiden; bestenfalls ist das

Ergebnis ein mathematisches Modell, das Vorhersagen über den Systemzustand erlaubt.

Datenanalyse komplexer Systeme

Datenanalyse – noch eine Kunst

• direkter Zugang: Welche Daten benötige ich, um Frage XY zu beantworten?

• inverser Zugang: Welche Fragen kann man stellen, die mit vorhandenen Daten beantwortet werden können?

7

• Nicht alle Fragen können anhand gegebener Daten beantwortet werden

• Welcher Typ von Datenanalyse passt zur Fragestellung?

• Sind die Fragen mit den vorhandenen Resourcen beantwortbar (Rechner, Experimente,

Geld, Zeit)?

• Welche Information gibt es in meinen Daten?

• Wieviel Information gibt es in meinen Daten?

Datenanalyse komplexer Systeme

Empfehlung: Werte NIE Daten blind aus, d.h. ohne klare Fragestellung oder Ziele!

6

Komplexe Systeme

Komplexität

Komplexität. Lat. complectere, umfassen

Komplexität. Lat. complectere, umfassen

Beispiel

Leeres Bild - verrauschtes Bild. Keine Information - zufällige Information Komplexität kann

als globales Maß angesehen werden, das den Zustand des betrachteten Systems beschreibt.

Es gibt eine Vielzahl von Komplexitäts – Definitionen. Einige werden wir kennenlernen (und

nutzen).

Systeme

Systemtheorie

In den 20er Jahren des 20ten Jahrhunderts entstandene Betrachtungsweise von Individuen/Gruppen/Unters

als wechselwirkende Einheiten. Erstmals in der Biologie. Sehr erfolgreich in der nichtlinearen

Dynamik (Synergie)

7

Dynamische Systeme

Dynamische Systeme

Dynamik (gr. dynamos, Kraft)

Beschreibt die zeitliche Entwicklung eines Systems, in der Physik meist in Form von Gleichungen.

Dynamisches System

8

Figure 1: Interaktiv unter http : //www.art − sciencef actory.com/complexity −

mapf eb09.html.

9

Ein System, das eine zeitliche Entwicklung hat. Kommt aus der Formulierung durch Kräfteglegewicht.

Deterministische Systeme

Deterministische Systeme

Determinismus (lat. determinare, bestimmen)

Vorherbestimmtheit. Drückt aus, dass die zeitliche Entwicklung eines Systems durch Anfangszustand und Entwicklungsvorschrift vollständig vorherbestimmt ist.

Nichtlineare Systeme

können chaotisch werden. Dann ist die Bestimmung des Systemzustandes durch Genauigkeitsbetrachtungen eingeschränkt. Landläufiges Argument für Anti-determinismus: Spätestens

im Quantenbereich kann ein Zustand nicht beliebig genau angegeben werden.

Stochastische Systeme

Stochastische Systeme

Stochastik (gr. stochastiki, Vermutens)

Lehre vom Zufall, Beschreibung von zeitlichen Abläufen, die durch zufällige Ereignisse

beschrieben werden.

Stochastisches System

ein System, das neben deterministischen Termen auch Zufallsterme beinhaltet. Jede Messung

beinhaltet Zufall, nämlich über die Messgenauigkeit.

8

Übung: Einführung in R

Geschichte

Community

Wachstum

Installation

Nutzen des Internets

Packages

Dokumentation

Bücher und Tutorien

10

Part II

Zufallsvariablen

Für diese Vorlesung danke ich herzlichst Arkadi Pikovski, der sein Skript mit mir geteilt hat.

9

Eine Zufallsvariable

9.1

Wahrscheinlichkeitsdichte

Eine Zufallsvariable x wird durch

• Die Menge aller m”oglichen Werte (z.B. die Menge der Punkte der reelen Achse)

• Die Wahrscheinlichkeitsverteilung auf dieser Menge

gegeben. Die Menge kann sowohl diskret als auch kontinuierlich sein. Zuerst betrachten wir

nur skalare Zufallsvariablen.

Die Wahrscheinlichkeit wird entsprechend der Kolmogorov-Axiomatik gegeben. F”ur

jedes Ereignis A gilt P (A) ≥ 0, und f”ur verschiedene sich ausschliessende Ereignisse

X

P {A1 ∪ A2 ∪ . . . ∪ An } =

P (Ai )

Ausserdem P (∅) = 0, P (die ganze Menge) = 1.

Die Wahrscheinlichkeitsverteilung ist die Funktion W (ξ) = P rob(x ≤ ξ). Diese Funktion

nimmt nie ab und hat die Randbedingungen W (−∞) = 0, W (∞) = 1. Die WahrscheinRb

lichkeit, die Variable x in einem Interval a < x ≤ b zu finden ist W (b) − W (a) = a dW (x).

Das Integral hier ist ein Stiltjes-Integral. Man sagt, dass damit ein ein Wahrscheinlichkeitsma”s

auf der reelen Achse definiert wird. Jedes Ma”s kann in drei Komponenten zergegt werden:

1. Der kontinuierliche differenzierbare Teil dW ∼ dx. Diese Teil hat eine Dichte w(x) =

dW/dx.

2. Der diskrete Teil ergibt Spr”unge der Funktion W . Ein Sprung W (x0 + 0) − W (x0 ) = p

bedeutet, dass die Zufallsvariable den Wert x0 mit der Wahrscheinlichkeit p annimmt.

Die Dichte kann auch geschrieben werden, ist aber eine verallgemeinerte Deltafunktion:

w(x) = pδ(x − x0 ).

3. Der kontinuierliche singul”are Teil, die ein fraktales Ma”s beschreibt. Hier gilt dW ∼

(dx)γ , wobei 0 < γ < 1.

Das gesamte Ma”s kann alle drei Komponenten beinhalten.

Beispiele:

Kontinuierliche Verteilung: Alle Zahlen auf dem Interval 0 ≤ x ≤ 1 sind gleich wahrscheinlich, w(x) = 1.

11

P

Diskrete Verteilung: Die ganzen Zahlen x = 1, 2, . . . mit der Dichte w(x) = 2−n δ(x − n).

Fraktale Verteilung: Wir stellen jede Zahl 0 ≤ x ≤ 1 als einen bin”aren Bruchteil dar

x = 0, 0110100 . . ., und weisen 0 eine Wahrscheinlichkeit p und 1 die Wahrscheinlichkeit

q = 1 − p zu. Dann hat jede Menge, die durch einen eindlichen bin”aren Bruchteil dargestellt

wird, die Wahrscheinlichkeit pn q m , wobei n und m die Anzahlen von 0 und 1 sind. Das

Verh”altnis

pn q m

∆W

=

∆x

(1/2)n+m

kann jeden Wert zwischen ∞ und 0 annehmen und hat keinen Grenzwert bei ∆x → 0.

Wir werden hier immer w(x) schreiben und die Dichte als (m”oglicherweise) verallgemeinerte oder fraktale Funktion betrachten.

9.2

Mittelwerte und Momente

Der Mittelwert einer Funktion der Zufallvariable ist

Z

hf (x)i = f (x)w(x) dx

Aus dieser Definition folgt, dass die Wahrscheinlichkeitsdichte selbst als ein Mittelwert

dargestellt werden kann

Z

w(y) = hδ(y − x)i = δ(y − x)w(x) dx

Die Momente sind die Mittelwerte von Potenzen: Mm = hxm i. Das erste Moment ist

dabei der Mittelwert

M1 = hxi

F”ur den zweiten Moment M2 = hx2 i k”onnen wir schreiben

h(x − hxi)2 i = hx2 − 2xhxi + hxi2 i = M2 − M12 = D

Diese Gr”o”se heisst die Varianz.

9.3

Die charakteristische Funktion und die Kumulanten

Die Fourier-Transformation der Wahrscheinlichkeitsdichte

Z

ikx

G(k) = he i = eikx w(x) dx

ist die charakteristische Funktion. F”ur sie gilt G(0) = 1, |G(k)| ≤ 1. Nach Entwicklung der

Exponentialfunktion erhalten wir die Momente

Z X

X (ik)n

(ik)n n

x w(x) dx =

Mn

G(k) =

n!

n!

12

Aus dieser Formel folgt

Mn = (−i)n G( n)(k)

Enwickelt man ln G nach k, so erh”alt man

ln G =

∞

X

(ik)M

1

m!

κm

Man nennt κm die Kumulanten. Wir haben also zwei Darstellungen der charakteristischen

Funktion

∞

X

P∞ (ik)m

(ik)n

G(k) =

Mn = e m=1 m! κm

n!

n=0

Nach dem Vergleich

k2

ik 3

k2

M2 −

M3 . . . = eikκ1 − 2 κ2 ...

2

6

erhalten wir einen Zusammenhang zwischen Momenten und Kumulanten

1 + ikM1 −

κ1

κ2

κ3

κ4

=

=

=

=

M1

M2 − M12 = D

M3 − 3M2 M1 + 2M12

M4 − 4M3 M1 − 3M22 + 12M2 M12 − 6M14

Zur Charakterisierung von Verteilungen werden h”aufig folgende Verh”altnisse benutzt:

M̄3

M̄4

γ

=

−3

2

D3/2

D2

Hier sind M̄n die zentralen Momente M̄n = h(x − hxi)n i. γ1 heisst Schiefe und γ2 heisst

Steilheit (Kurtosis).

Beispiele.

γ1 =

1. Die Verteilung w(x) = λe−λx , x ≥ 0. Die Momente sind Mn =

λ

1/λ, D = 1/λ2 . Die charakteristische Funktion ist G(k) = λ−ik

.

n!

,

λn

so dass hxi =

2. Die Gaussische Verteilung

1

(x − hxi)2

w(x) = √

exp[−

]

2D

2πD

hat die charakteristische Funktion

G(k) = eikhxi−

k2 D

2

Die Momente sind M̄2n+1 = 0, M̄2n = 1 · 3 · · · (2n − 1)Dn . Die Schiefe und die Steilheit

sind Null.

Es gibt einen Satz: Sei die charakteristische Funktion G(k) = ePn (k) , wobei Pn ein

Polynom n-te Ordnung ist, dann n = 2. Das bedeutet, dass entweder unendlich viele

Kumulanten nicht Null sind, oder es ist eine Gaussische Verteilung.

13

3. Cauchy-Verteilung

w(x) =

1

λ

π λ2 + (x − α)2

Hier G(k) = eiαk−λ|k| . Man kann sehen, dass M1 nicht existiert, und M2 = ∞.

Betrachten wir eine Funktion der Zufallsvariable x: y = f (x). Die Wahrscheinlichkeitsdichte f”ur y ist

Z

X

wx (xi )

wy (y) = hδ(y − f (x))i = δ(y − f (x))wx (x) dx =

|f 0 (xi )|

alle Wurzeln f (x)=y

F”ur eine one-to-one Funktion man kann einfache schreiben |wx (x) dx| = wy (y) dy|.

10

10.1

Mehrdimensionale Zufallsvariablen

Wahrscheinlichkeitsdichte, charakteristische Funktion

Die Wahrscheinlichkeitsverteilung von x1 , . . . xn wird durch die Dichte w(x1 , . . . xn ) gegeben.

Ein Teil von Variablen x1 , . . . xs wird durch die Randverteilungsdichte

Z

w(x1 , . . . , xs ) = w(x1 , . . . xn ) dxs+1 . . . dxn

gegeben. Die bedingte Wahrscheinlichkeit

ws|n−s =

w(x1 , . . . xn )

w(xs+1 , . . . xn )

ist die Wahrscheinlichkeitsdichte, die Werte (x1 , . . . , xs ) zu beobachten, vorausgesetzt die

Variablen xs+1 . . . xn bestimmte Werte haben. Wenn die bedingte Wahrscheinlichkeit von

die Gruppe xs+1 , . . . xn unabh”angig ist, dann

w(x1 , . . . xn ) = w(x1 , . . . xs )w(xs+1 , . . . xn ).

Im Allgemeinen: Wenn alle Zufallsvariablen unabh”angig sind, ist die Gesamtdichte ein

Produkt von Einzelndichten:

w(x1 . . . xn ) = w1 (x1 )w2 (x2 ) . . . wn (xn )

Die Momente:

1 m2

hxm

1 x2

n

. . . xm

n i

Z

=

mn

1 m2

xm

1 x2 . . . xn w(x1 . . . xn ) dx1 . . . dxn

Die charakteristische Funktion

G(k1 , k2 , . . . kn ) = heik1 x1 +···+ikn xn i

14

Die Kumulanten

ln G =

X (ik1 )m1 (ik2 )m2 . . . (ikn )mn

m1 !m2 ! . . . mn !

mn

1 m2

hhxm

1 x2 . . . xn ii

Am wichtigsten sind die Momente und Kumulante zweiter Ordnung:

hxi xj i

hhxi xj ii = hxi xj i − hxi ihxj i = h(xi − hxi i)(xj − hxj i)i

Diese Kumulante heisst die Kovarianz. Wenn man normiert

hhxi xj ii

ρij = p

Dx Dy

bekommt man den Korrelationskoeffizient.

Wenn zwei Zufallsvariablen unabh”angig sind, dann

m1

m2

1 m2

1. hxm

1 x2 i = hx1 ihx2 i

2. G(k1 , k2 ) = G1 (k1 )G2 (k2 )

1 m2

3. hhxm

1 x2 ii = 0 wenn m1 6= 0 und m2 6= 0

Die Zufallsvariablen heissen unkorelliert, wenn ρ12 = 0.

Beispiel:

Die Wahrscheinlichkeitsdichte zweier Gaussscher Zufallsvariablen

"

##

"

1

(x − hxi)2

(x − hxi)(y − hyi) (y − hyi)2

1

p

− 2ρ

exp −

+

w(x, y) = p

2(1 − ρ2

Dx

Dy

Dx Dy

2π Dx Dy (1 − ρ2 )

ist von 5 Parametern hxi, hyi, Dx , Dy , ρ abh”angig. Wenn ρ = 0, sind die Gausssche Variablen

unabh”agig.

Im Allgemeinen definiert man f”ur mehere Gausssche Variablen die Kovarianzmatrix

σij = hhxi xj ii

und schreibt die Dichte in der Form

exp −

w(~x) =

− h~xi)σ (~x − h~xi)

p

(2π)n detσ

1

(~x

2

−1

Die charakteristische Funktion ist

1~ ~

~

G(~k) = eikh~xi− 2 kσk

Alle Momente kann man durch die Elemente der Kovarianzmatrix σ darstellen (siehe

Aufgabe 1.5).

15

10.2

Summe der Zufallsvariablen, Zentraler Grenzsatz

Finden wir die Wahrschenlichkeitsdichte der Summe von zwei Zufallsvariablen z = x + y:

Z

Z

w(z) = hδ(z − x − y)i = δ(z − x − y)w(x, y) dx dy = w(z − y, y) dy

Wenn die Variablen unabh”angig sind, dann erhalten wir die Faltung

Z

w(z) = wx (z − y)wy (y) dy

F”ur Mittelwerte gilt immer

hzi = hxi + hyi

F”ur Varianz gilt

hhz 2 ii = hhx2 ii + hhy 2 ii

nur wenn die Zufallsvariablen unkorreliert sind, ρ = 0. F”ur unabh”angige x und y gilt

Gz (k) = Gx (k)Gy (k)

Wir betrachten eine Summe von n unabh”angigen Variablen mit den Mittelwert Null

y = x1 + · · · + xn

Die Varianz ist hhy 2 ii = nhhx2 ii, deshalb normieren wir y mit

y=

x1 + · · · + xn

√

n

√

n. Dann haben wir

k

Gy (k) = [Gx ( √ )]n

n

Wir setzen jetzt

1

Gx (k) = e− 2 hhx

ein und erhalten

2 iik 2 − ik3 hhx3 ii+···

6

3

1 2

hhx2 ii− ik6 hhx3 iin−1/2

Gy (k) = e− 2 k

1 2

hhx2 ii

≈ e− 2 k

Das ergibt die Gausssche Verteilung f”ur die Summe.

Bemerkungen:

- Die Variablen xi k”onnen auch verschiedene Verteilungen haben

- Die Variablen xi k”onnen auch abh”angig sein, nur die Abh”angigkeit muss schwach sein.

10.3

Stabile Wahrscheinlichkeitsverteilungen

Betrachten wir eine Summe von unabh”angigen gleich verteilten Zufallsvariablen

s = x1 + · · · + xn

16

Wenn die Gro”se s nach der Normierung s/cn die selbe Verteilung hat wie x, dann heisst

diese Verteilung stabil. Man kann ”uberlegen, dass der Normierungskoeffizient ein Potenz

von n sein muss: cn = n1/α , 0 < α ≤ 2. Man kann auch ”aquivalent formulieren, dass

s1/α x1 + t1/α x2 und (s + t)1/α x die selbe Verteilung haben.

Die Gauss-Verteilung ist die einzige stabile Verteilung mit einer endlichen Varianz, hier

ist α = 2.

Beispiele.

Die Cauchy-Verteilung w(x) = π(λ2λ+x2 ) hat die charakteristische Funktion e−λ|k| . Diese

k

Verteilung ist stabil mit α = 1: [e−λ| n | ]n = e−λ|k| .

Die Holzmark-Verteilung. Welche Gravitationskraft erzeugt ein Sternsystem? Nehmen

wir ein Sternsystem mit der Dichte λ und betrachten die x-Komponente der Kraft im Punkt

O. Diese Komponente ist eine Zufallsvariable Xλ . Weil die Gravitationskr”afte sich addieren,

Xs + Xt und Xs+t haben die selbe Verteilung. Sei X1 die Zufallsvariable im Falle der Dichte

1. Bei Dichte t alle Abst”ande verkleinern sich um Faktor t1/3 , und die Kraft vergr”ossert

sich um Faktor t2/3 . Deshalb haben t2/3 X1 und Xt die selbe Verteilung. Wir erhalten die

Gleichung

d

s2/3 X1 + t2/3 X2 = (s + t)2/3 X

Das bedeutet, dass die Kraft die stabile Verteilung mit α = 3/2 hat.

17

Part III

Zufallsvariablen

11

Schätzung

Statistik

lat. status = Zustand

• Zustandsaufnahme einer Population durch Zählen oder Proporz

• Stichprobe: Messung eines Teils der Gesamtheit

• Experiment → Realisierung von X → N-mal = Stichprobe mit Umfang N

• Bedingung: Repräsentativ, Unabhängigkeit, etc.

• Verteilung ? Parameter ?

Wahrscheinlichkeitsraum

Ein W.-Raum

besteht aus dem Tupel {Ω, A, P } mit

• Ω eine Algebra

• A die Ergebnismenge (z.B. experimentelle Ergebnisse)

• P die zugeordneten Wahrscheinlichkeiten

Zufallsvariable

Eine Zufallvariable X

beschreibt die Zuordnung X : A 7→ p, p ∈ R. Wenn A = x ∈ R, dann ist die ZV X(x)

Schätzung

Messung einer ZVen

ergibt wieder eine ZV! Bsp.: Stichprobenmittel

N

N

1 X

1 X

¯

Xi → XN =

Xi

x¯N =

N i=1

N i=1

ist eine ZV. Wo klar, werden Indizes weggelassen.

18

(3)

Schätzung

Aussagekraft der Schätzung?

• < X̄ >= E(X̄)

• V AR(X̄)

• etc.

Erwartungsttreue Schätzung

ˆ

geschätzt: Ẑ = f (X)

Z ist erwartungstreu,

Pwenn < Z >=< Ẑ >

z.B. < X̄ >= N1 N

i=1 < Xi >=< X >

Sonstige Schätzer für mittlere Größen

• Median: halbiert eine Verteilung

• Modus: häufigster Wert

Schwankung von X̄

V AR(X̄)

V AR(X̄) =

X

1

1

V

AR(

X

)

=

V AR(X)

i

N2

N

Standardabweichung

q

σX

σX̄ = V AR(X̄) = p

V AR(X)

Achtung: Wir kennen nicht < X >, sondern nur eine (evtl. mehr) Realisierung von X̄. Also

X̄ − σX̄ ≤< X >≤ X̄ + σX̄

Der wahre MW liegt mit 68% W. im obigen Intervall

Konfidenzintervall

Konfidenzintervall zum Niveau α

Konfidenzintervall 68%

σX

σX

X̄ − √ ; X̄ + √

N

N

1 − α% -Konfidenzintervall α mit dem q1−α/2 -Quantil

σX

σX

X̄ − q1−α/2 √ ; X̄ + q1−α/2 √

N

N

19

(4)

(5)

Schwankung

Schätzung der Varianz

σX ist i.a. nicht bekannt ⇒ Schätzung

N

S2 =

1 X

(Xi − X̄)2

N − 1 i=1

(6)

X̄ aus der gleichen Stichprobe. Erwartungstreu? Berechne

2

< S 2 >= V AR(X) = σX

N − 1 konsistent mit N = 1 → < S 2 > nicht bestimmt.

Varianz

Schwankung der Schätzung

2

=< S 2 >. Verteilung von S 2 ? S 2 ist Summe von Quadraten von

Bekannt ist S 2 , nicht σX

N N0,1 verteilten Variablen

N0,1 (Standardnormalverteilung)

χ2 -Verteilung

Verteilung

P

von Y − Xi2 ?

p(xi ) = √

Z

x2

1

i

e− 2σ2

2πσ

(7)

p(Y, N ) = ?

Z

Z

X

N

dx p(x1 ...xN ) =

dy dxN δ(y −

x2i )p(x1 ...xN )

(8)

(9)

Auswertung:

Y

1

p(Y, N ) = p

Y N/2−1 e− 2σ2

N

(2σ) Γ(N/2)

(10)

χ2 -Verteilung mit N Freiheitsgraden

chi2 − V erteilung

Zurück zu S 2 : Schätzung von V AR(S 2 )

Y =

2 (N −1)

SN

2

σX

ist χ2 verteilt mit N − 1 Fr.gr.

√

gemessen: (X̄− < X >), normalverteilt, bzw. Z =

Ersetzung σX

20

N

(X̄−

σX

< X >) ist N0,1 verteilt.

0.15

0.10

dchisq(x, df = 4)

0.05

0.00

0

2

4

6

8

10

x

Figure 2: χ2 -Verteilung mit R: dchisq(x,df). Hier df=4

Schätzung von V AR(S 2 )

Quotient

(X̄− < X >)

p

Abweichung durch M essung

2

SN

Z

= p

Y (N − 1)

(11)

(12)

Quotient N0,1 -verteilt und χ2 -verteilter Variablen → t-verteilt: pt (N −1, x). Fast wie Gauss,

wichtig für N . 32

F-Verteilung

Näheres: Übung

Für Y1 , Y2 χ2 -verteilt mit N1 − 1, N2 − 2 Freiheitsgraden ist Z =

Yi = SNi ,i )

Schätzung von V AR(S 2 )

2

Wie nahe liegt σ 2 bei SN

→ (1 − α)-Konfidenzintervall

"

X̄N −

t,N

q1−α/2

p

p #

2

SN

S2

t,N

√

; X̄N + q1−α/2 √ N

N

N

21

Y1 (N2 −1)

Y2 (N1 −1)

F-verteilt. (z.B.

0.4

0.3

0.2

dt(x, df = 4)

0.1

0.0

−4

−2

0

2

4

x

Figure 3: t-Verteilung mit R: dt(x,df). Hier der Vergleich für kleines N=4 (schwarz), großes

N=20 (rot), und Standardnormalverteilung(blau).

(σX →

√

t,N

S 2 ), q1−α/2

: 1 − α/2-Quantil der t-Verteilung

t-Verteilung

t-Verteilung

Zusammenfassung: Schätzer

ZV: Z=F(X)

Schätzung: Z̄N =

σ2

√Z

N2

1

N

PN

F (Xi ) ist ein Schätzer für < Z > und selbst eine ZV. Fehler: σZ̄2 =

q

q P

2

1

S2

2

2

2

2

Schätzung von σZ aus S ' N

F (Xi ) −Z̄ Dann ist Z̄N − q1−α/2 N ; Z̄N + q1−α/2 SN

i=1

das Interbvall, in dem mit Wahrscheinlichkeit 1 − α der wahre Wert < Z > liegt. q ist das

Quantil der F entsprechenden Verteilung.

Hypothesen und deren Tests

Hypo=gr. unter, thesis=Gesagtes: Unterstellung

Aussage, die falsifiziert oder verifiziert werden soll. Frage: Wie gut ist die Veri/Falsifizierung?

Bsp: zwei Verteilungen sind gleich! Zwei Mittelwerte sind unterschiedlich! A ist schlauer als

B!

22

Gleichheit von Mittelwerten: Test

t-Test

2

Hypothese:

< X1 >=< X2 > Betrachte Differenz ∆ = X1 − X2 und Schwankung S∆

⇒

q

N2 √∆

ist t-verteilt.

T = NN1+N

2

1

2

S∆

Verwerfen der hHypothese mitisignifikanz α

t

t

liegt. Das heisst ∆ liegt nicht in

; q1−α/2

wenn T nicht in −q1−α/2

"

r

t

−q1−α/2

t

2 N1 + N2

; q1−α/2

S∆

N1 N2

r

#

N

+

N

1

2

2

.

S∆

N1 N2

Test auf Gleichheit von Varianzen: F-Test

F-Test

Betrachte Y1 =

S12 (N1 −1)

,

σ12

Y2 =

S22 (N2 −1)

.

σ22

bilde

Y1

Y2

und untersuche die Verteilung. Es ergibt

sich die F-Verteilung und daraus der F-Test. Übung.

Gleichheit zweier Verteilungen: χ2 -Test

Messung vs. Theorie

Null-Hypothese: Messung (Stichprobengröße N) repräsentiert ZV mit Verteilung P (X).

Idee: Vergleiche W.-Dichte, mit Histogramm wegen diskreten Werten (Messung)

• Klassenbildung (erfordert Histogramm): K Klassen s, W. ps

• ns = N ps : Theoretische Häufigkeit für Ergebnis in Klasse s

• ys =Häufigkeit für Messung in Klasse s

P

P

•

s Ys = N

s p(s) = 1,

• Ys ist poissonverteilt mit < Ys >= ns , V AR(Ys ) = ns

Gleichheit zweier Verteilungen: χ2 -Test

Kurzherleitung

• Normierung: Zs =

Y√

s −ns

ns

• Zusammenfassung der Abweichungen: V 2 =

P

s

Zs2

• V 2 ist Summe von K Quadraten von N0,1 -verteilten (N genügend groß) ZVen

• V 2 ist χ2 (K − 1)-verteilt

23

2

χ

• also wird die Hypothese mit Signifikanz α verworfen, wenn V 2 > q1−α

•

•

Gleichheit zweier Verteillungen: Kolmogorov-Smirnow-Test

Idee: Teste die kumulativen Verteilungen

24