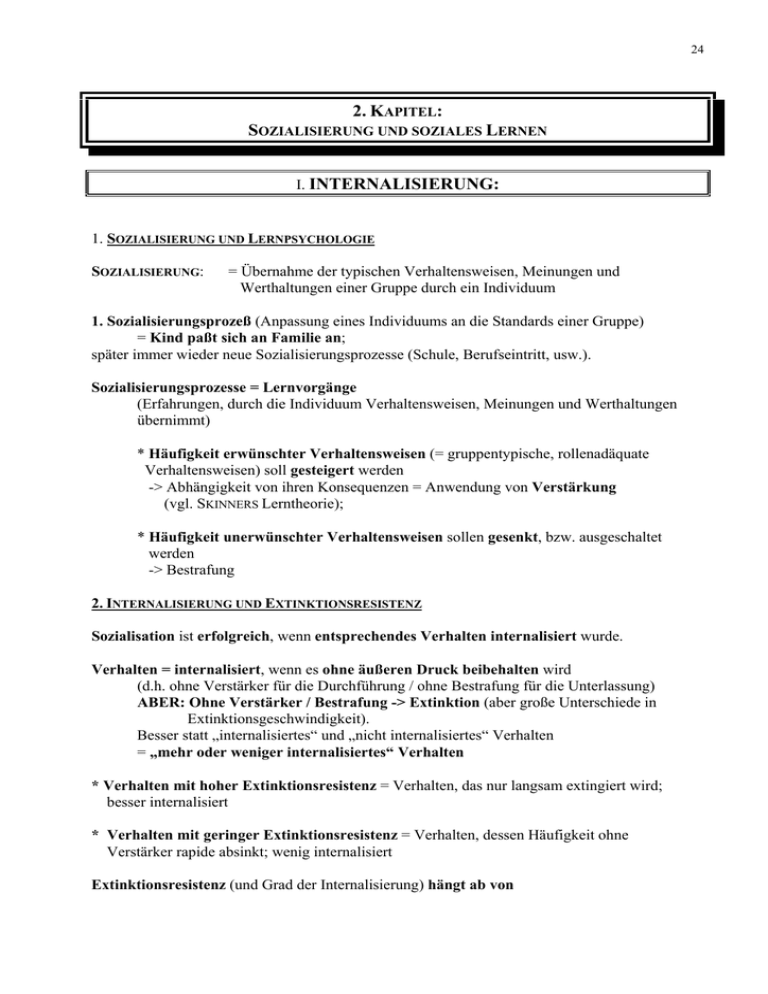

2. kapitel - poekl-net

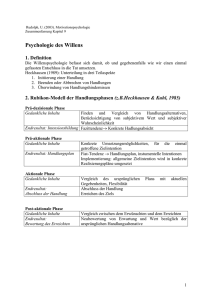

Werbung