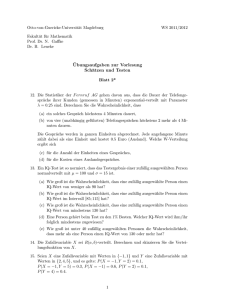

Wahrscheinlichkeit und Statistik - Mathematik@TU

Werbung