Stochastik für Informatiker und Regelschullehrer

Werbung

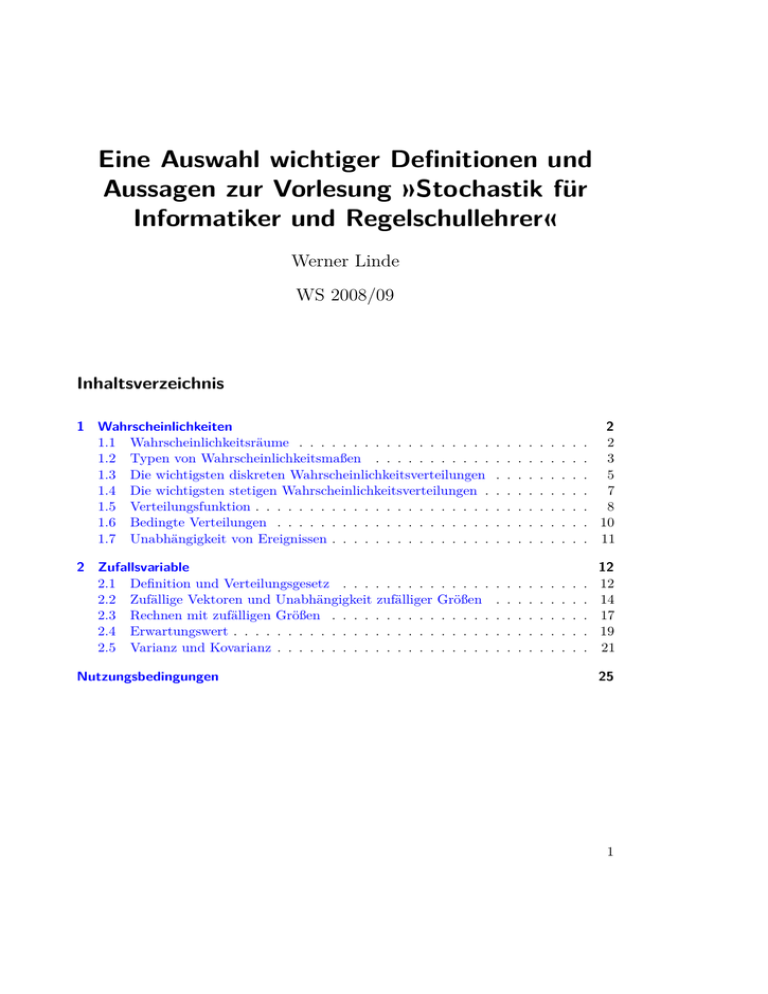

Eine Auswahl wichtiger Definitionen und

Aussagen zur Vorlesung »Stochastik für

Informatiker und Regelschullehrer«

Werner Linde

WS 2008/09

Inhaltsverzeichnis

1 Wahrscheinlichkeiten

1.1 Wahrscheinlichkeitsräume . . . . . . . . . . . . . . . . . .

1.2 Typen von Wahrscheinlichkeitsmaßen . . . . . . . . . . .

1.3 Die wichtigsten diskreten Wahrscheinlichkeitsverteilungen

1.4 Die wichtigsten stetigen Wahrscheinlichkeitsverteilungen .

1.5 Verteilungsfunktion . . . . . . . . . . . . . . . . . . . . . .

1.6 Bedingte Verteilungen . . . . . . . . . . . . . . . . . . . .

1.7 Unabhängigkeit von Ereignissen . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2

. 2

. 3

. 5

. 7

. 8

. 10

. 11

2 Zufallsvariable

2.1 Definition und Verteilungsgesetz . . . . . . . . . . . . . .

2.2 Zufällige Vektoren und Unabhängigkeit zufälliger Größen

2.3 Rechnen mit zufälligen Größen . . . . . . . . . . . . . . .

2.4 Erwartungswert . . . . . . . . . . . . . . . . . . . . . . . .

2.5 Varianz und Kovarianz . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Nutzungsbedingungen

12

12

14

17

19

21

25

1

1 Wahrscheinlichkeiten

1 Wahrscheinlichkeiten

1.1 Wahrscheinlichkeitsräume

1.1.1 Grundraum

Der Grundraum (meist mit Ω bezeichnet) ist eine Menge, die mindestens alle bei einem

stochastischen Versuch oder Vorgang auftretenden Ergebnisse enthält. Die Teilmengen von

Ω heißen Ereignisse, die einpunktigen Teilmengen nennt man Elementarereignisse.

1.1.2 Eintreten eines Ereignisses

Ein Ereignis A ⊆ Ω tritt ein, wenn das beim Versuch oder dem Vorgang beobachtete

zufällige Ergebnis in der Menge A liegt.

1.1.3 σ-Algebra

Auf dem Grundraum Ω wird ein System A ⊆ P(Ω) von Ereignissen ausgezeichnet,

denen man in sinnvoller Weise die Wahrscheinlichkeit ihres Eintretens zuordnen kann.

Aus naheliegenden Gründen fordert man, dass A eine σ-Algebra bildet, d. h. A erfüllt

folgende Eigenschaften:

(i) ∅ ∈ A.

(ii) Aus A ∈ A folgt Ac ∈ A.

(iii) A1 , A2 , . . . ∈ A impliziert

S∞

j=1 Aj

∈ A.

Ist Ω höchstens abzählbar unendlich, so kann man als σ-Algebra stets die Potenzmenge

P(Ω) von Ω nehmen.

1.1.4 Wahrscheinlichkeitsmaß

Ein Wahrscheinlichkeitsmaß (oder eine Wahrscheinlichkeitsverteilung) P ist eine

Abbildung von A nach [0,1], die jedem Ereignis A ∈ A die Wahrscheinlichkeit seines

Eintretens zuordnet und folgende Eigenschaften besitzt:

(i) Es gilt P(∅) = 0 und P(Ω) = 1.

(ii) P ist σ-additiv, d. h. für disjunkte Aj ∈ A folgt

P

∞

[

j=1

2

Aj =

∞

X

j=1

P(Aj ) .

1.2 Typen von Wahrscheinlichkeitsmaßen

1.1.5 Wahrscheinlichkeitsraum

Das Tripel (Ω, A, P) heißt Wahrscheinlichkeitsraum. Zufällige Experimente werden

durch geeignete Wahrscheinlichkeitsräume beschrieben.

1.1.6 Eigenschaften von Wahrscheinlichkeitsmaßen

(i) Jedes Wahrscheinlichkeitsmaß ist auch endlich additiv, d. h. sind A1 , . . . , An aus

A disjunkt, so folgt

n

[

Aj =

P

j=1

n

X

P(Aj ) .

j=1

(ii) Wahrscheinlichkeitsmaße sind monoton, d. h. gilt für A, B ∈ A die Inklusion

A ⊆ B, so impliziert dies P(A) ≤ P(B).

(iii) Für A, B ∈ A mit A ⊆ B folgt P(B \ A) = P(B) − P(A). Insbesondere ergibt sich

hieraus P(Ac ) = P(Ω \ A) = 1 − P(A) für A ∈ A.

(iv) Wahrscheinlichkeitsmaße sind stetig von oben, d. h. gilt für Aj ∈ A die Aussage

A1 ⊇ A2 ⊇ · · ·, so folgt

P

∞

\

Aj = lim P(Aj ) .

j→∞

j=1

(v) Wahrscheinlichkeitsmaße sind auch stetig von unten, d. h. gilt für Aj ∈ A die

Aussage A1 ⊆ A2 ⊆ · · ·, so folgt

P

∞

[

Aj = lim P(Aj ) .

j=1

j→∞

1.2 Typen von Wahrscheinlichkeitsmaßen

1.2.1 Wahrscheinlichkeitsmaße auf höchstens abzählbar unendlichen Grundräumen

Bei einem Experiment seien höchstens abzählbar unendlich viele Versuchsergebnisse

möglich. Dann kann man entweder Ω = {ω1 , . . . , ωN } oder aber Ω = {ω1 , ω2 , . . . } wählen.

Als σ-Algebra nimmt man in diesen Fällen stets die Potenzmenge P(Ω). Setzt man

pi := P({ωi }) ,

1≤i≤N

bzw. i = 1,2, . . . ,

(1)

dann erhält man Zahlen mit den Eigenschaften

(i) pi ≥ 0 und

3

1 Wahrscheinlichkeiten

(ii)

PN

i=1 pi

= 1 bzw.

P∞

i=1 pi

= 1.

Für eine Menge A ⊆ Ω folgt dann

P(A) :=

X

pi .

(2)

{i : ωi ∈A}

Umgekehrt, gibt man eine Folge (pi )i≥1 reeller Zahlen mit Punkt (i) und Punkt (ii) vor,

so wird durch Gleichung 2 ein Wahrscheinlichkeitsmaß P auf P(Ω) definiert. Für endliche

oder abzählbar unendliche Grundräume Ω hat man also folgende Äquivalenz:

{P : P Wahrscheinlichkeitsmaß auf P(Ω)} ⇐⇒ {(pi )i≥1 : (pi )i≥1 erfüllen ((i)) und ((ii))}

Die Zuordnung erfolgt über Gleichung 1 bzw. Gleichung 2.

1.2.2 Diskrete Wahrscheinlichkeitsmaße

Sei nunmehr Ω ein beliebiger Grundraum (nicht notwendig endlich oder abzählbar unendlich). Ein Wahrscheinlichkeitsmaß P auf (Ω, P(Ω)) heißt diskret, wenn es eine höchstens

abzählbar unendliche Teilmenge D ⊆ Ω mit P(D) = 1 gibt. Mit D = {ω1 , ω2 , . . . } gilt

dann für A ⊆ Ω wie zuvor

P(A) :=

X

pi ,

{i : ωi ∈A}

wobei pi := P({ωi }). Auf höchstens abzählbar unendlichen Grundräumen ist somit jedes

Wahrscheinlichkeitsmaß diskret.

1.2.3 Wahrscheinlichkeitsdichten

Eine stückweise stetige Funktion p : R 7→ R heißt Wahrscheinlichkeitsdichte, wenn

(i) p(x) ≥ 0 für x ∈ R und

(ii)

R∞

−∞ p(x) dx

=1

gelten.

1.2.4 Borel-σ-Algebra

Mit B(R) bezeichnet man die kleinste σ-Algebra von Mengen aus R, die die halboffenen

Intervalle enthält. Man nennt B(R) die σ-Algebra der Borelmengen. Elemente von B(R)

sind z. B. alle offenen oder abgeschlossenen Mengen, deren abzählbaren Vereinigungen

und Durchschnitte usw.

4

1.3 Die wichtigsten diskreten Wahrscheinlichkeitsverteilungen

1.2.5 Stetige Wahrscheinlichkeitsmaße

Gegeben sei eine Wahrscheinlichkeitsdichte p. Dann existiert ein eindeutig bestimmtes

Wahrscheinlichkeitsmaß P : B(R) 7→ [0,1] mit

Zβ

P([α, β]) = P((α, β]) =

p(x) dx

α

für alle reelle Zahlen α < β. Das so erzeugte Wahrscheinlichkeitsmaß P heißt stetig und p

nennt man die Dichte von P. Stetige Wahrscheinlichkeitsmaße beschreiben Vorgänge, bei

denen überabzählbar viele reelle Zahlen als Ergebnis auftreten können (z. B. Lebenszeiten,

Messwerte etc.).

1.3 Die wichtigsten diskreten Wahrscheinlichkeitsverteilungen

1.3.1 Einpunktverteilung

Gegeben sei ein ω0 ∈ Ω, fest aber beliebig. Dann wird durch

(

δω0 (A) :=

1

0

: ω0 ∈ A

: ω0 ∈

/A

die Einpunktverteilung in ω0 (oder das Diracsche δ-Maß in ω0 ) definiert. Der Wahrscheinlichkeitsraum (Ω, P(Ω), δω0 ) beschreibt Vorgänge, bei denen mit Wahrscheinlichkeit

1 genau ω0 eintritt (deterministische Vorgänge).

1.3.2 Gleichverteilung auf N Punkten

Gegeben seien N Punkte ω1 , . . . , ωN ∈ Ω. Das Maß P auf P(Ω) mit

P :=

N

1 X

δω

N i=1 i

heißt Gleichverteilung auf {ω1 , . . . , ωN }. Für ein Ereignis A gilt dann

P(A) =

card{i ≤ N : ωi ∈ A}

Anzahl der günstigen Fälle für A

=

.

N

Anzahl der möglichen Fälle

5

1 Wahrscheinlichkeiten

1.3.3 Binomialverteilung

Sei Ω = {0, . . . , n} und sei p ∈ [0,1] vorgegeben. Dann wird durch

!

Bn,p ({k}) :=

n k

p (1 − p)n−k ,

k

k = 0, . . . , n ,

ein Wahrscheinlichkeitsmaß Bn,p auf P(Ω) definiert. Man nennt Bn,p Binomialverteilung mit den Parametern n und p. Die Zahl Bn,p ({k}) gibt die Wahrscheinlichkeit

an, dass man bei n unabhängigen Versuchen genau k-mal Erfolg hat. Dabei ist die

Erfolgswahrscheinlichkeit in jedem einzelnen Versuch p, die für Misserfolg 1 − p.

1.3.4 Hypergeometrische Verteilung

Gegeben seien Zahlen

M, N, n ∈ N0 mit M, n ≤ N . Dann wird durch

HN,M,n ({m}) :=

M N −M m n−m

N

n

ein Wahrscheinlichkeitsmaß HN,M,n auf P({0, . . . , n}) definiert. Man nennt HN,M,n hypergeometrische Verteilung mit den Parametern N, M und n. Sind in einer Lieferung

von N Geräten M Stück defekt, so beschreibt HN,M,n ({m}) die Wahrscheinlichkeit, dass

man in einer zufällig entnommenen Stichprobe vom Umfang n genau m defekte Geräte

beobachtet.

1.3.5 Poissonverteilung

Es sei Ω = N0 = {0,1,2, . . . }. Für eine Zahl λ > 0 definiert man die Poissonverteilung

mit Parameter λ durch

Pλ ({k}) :=

λk −λ

e

k!

für

k ∈ N0 .

Die Bedeutung der Poissonverteilung ergibt sich aus folgendem Satz:

Satz 1.1 Gegeben sei eine Zahl λ > 0. Für n ∈ N setze man pn := λ/n. Dann folgt für

alle k ∈ N0 stets

lim Bn,pn ({k}) = Pλ ({k}) .

n→∞

Inhaltlich bedeutet dies: Führt man sehr viele unabhängige Versuche durch (n Stück),

bei denen jeweils nur mit sehr kleiner Wahrscheinlichkeit p Erfolg eintreten kann, so ist

die Anzahl der insgesamt beobachteten Erfolge approximativ gemäß Pλ verteilt, wobei

λ = n · p.

6

1.4 Die wichtigsten stetigen Wahrscheinlichkeitsverteilungen

1.3.6 Geometrische Verteilung

Bei einem einzelnen Versuch trete Erfolg wieder mit Wahrscheinlichkeit p und Misserfolg

mit Wahrscheinlichkeit 1 − p auf. Man führt nun so lange unabhängige Versuche durch,

bis man erstmals Erfolg beobachtet. Die Wahrscheinlichkeit, dass dies im (k + 1)-ten

Versuch mit k ∈ N0 geschieht, wird durch die geometrische Verteilung mit Parameter

p ∈ (0,1] beschrieben:

P({k}) := p · (1 − p)k ,

k ∈ N0 .

1.4 Die wichtigsten stetigen Wahrscheinlichkeitsverteilungen

1.4.1 Gleichverteilung auf einem Intervall

Es sei [a, b] ein endliches Intervall. Durch

(

p(x) :=

1

b−a

0

: x ∈ [a, b]

:x∈

/ [a, b]

wird eine Wahrscheinlichkeitsdichte auf R definiert. Damit berechnet sich die Wahrscheinlichkeit eines Intervalls [α, β] durch

Zβ

P([α, β]) =

p(x) dx =

α

Länge von ([α, β] ∩ [a, b])

.

b−a

(3)

Insbesondere ergibt sich im Fall [α, β] ⊆ [a, b] die Formel

β−α

,

b−a

d. h. die Wahrscheinlichkeit des Eintretens von [α, β] ⊆ [a, b] hängt nur von seiner Länge,

nicht aber von seiner speziellen Lage innerhalb [a, b], ab. Das durch Gleichung 3 erzeugte

Wahrscheinlichkeitsmaß heißt Gleichverteilung auf dem Intervall [a, b].

P([α, β]) =

1.4.2 Exponentialverteilung

Gegeben sei eine Zahl λ > 0. Man definiert die Exponentialverteilung Eλ mit Parameter λ > 0 durch ihre Dichte

(

p(x) :=

λ e−λx

0

:x>0

.

:x≤0

Für ein Intervall [α, β] ⊆ [0, ∞) berechnet sich damit die Wahrscheinlichkeit seines

Eintretens durch

Zβ

Eλ ([α, β]) = λ

e−λx dx = e−λα − e−λβ .

α

7

1 Wahrscheinlichkeiten

1.4.3 Normalverteilung

Gegeben seien Zahlen µ ∈ R und σ > 0. Die Funktion

pµ,σ2 (x) := √

1

(x−µ)2/2σ 2

e−

,

2πσ

x∈R,

erzeugt ein Wahrscheinlichkeitsmaß N (µ, σ 2 ), das man Normalverteilung mit Mittelwert µ und Varianz σ 2 nennt. Es gilt dann

1

N (µ, σ )([α, β]) = √

2πσ

2

Zβ

(x−µ)2/2σ 2

e−

dx .

α

Im Fall µ = 0 und σ = 1 erhält man die Standardnormalverteilung N (0,1). Wahrscheinlichkeiten des Eintretens von Intervallen berechnen sich in diesem Fall durch

1

N (0,1)([α, β]) = √

2π

Zβ

x2/2

e−

dx .

α

1.4.4 Gleichverteilung auf einer Menge im Rn

Es sei E ⊆ Rn eine beschränkte und abgeschlossene Teilmenge, deren n-dimensionales

Volumen voln (E) man berechnen kann. Man definiert die Gleichverteilung auf E

durch den Ansatz

P(A) =

voln (A ∩ E)

.

voln (E)

Insbesondere ergibt sich für A ⊆ E die Aussage

P(A) =

voln (A)

,

voln (E)

d. h., wie im eindimensionalen Fall hängt die Wahrscheinlichkeit des Eintretens einer

Menge A ⊆ E nur von deren Volumen ab, nicht aber von deren Lage innerhalb E noch

von ihrer Gestalt.

1.5 Verteilungsfunktion

1.5.1 Definition

Für ein Wahrscheinlichkeitsmaß P auf (R, B(R)) wird die Verteilungsfunktion F : R 7→

R durch

F (t) := P((−∞, t]) ,

8

t∈R,

(4)

1.5 Verteilungsfunktion

definiert.

Hinweis: Ist P ein diskretes Wahrscheinlichkeitsmaß auf (Ω, P(Ω)) mit Ω ⊆ R, so

modifiziert sich die Definition zu

F (t) := P((−∞, t] ∩ Ω) ,

t∈R.

1.5.2 Eigenschaften der Verteilungsfunktion

Satz 1.2 Die Verteilungsfunktion F eines Wahrscheinlichkeitsmaßes besitzt folgende

Eigenschaften:

(i) limt→−∞ F (t) = 0 und limt→∞ F (t) = 1,

(ii) die Funktion F ist nichtfallend und

(iii) die Funktion F ist rechtsseitig stetig.

1.5.3 Weitere Eigenschaften von Verteilungsfunktionen

(a) Für jedes halboffene Intervall (α, β] gilt

P((α, β]) = F (α) − F (β) .

(b) Die Funktion F besitzt in einem Punkt t0 ∈ R genau dann einen Sprung der Höhe

h > 0 (man hat F (t0 ) − F (t0 − 0) = h), wenn P({t0 }) = h gilt. Insbesondere hat die

Verteilungsfunktion eines diskreten Maßes Sprünge in den Punkten, wo die Masse

des Maßes konzentriert ist. Dazwischen ist sie konstant.

(c) Ist F Verteilungsfunktion eines stetigen Wahrscheinlichkeitsmaßes P mit Dichte p,

so berechnet sich F aus

Zt

F (t) =

p(x) dx ,

t∈R.

−∞

Insbesondere gilt für alle t ∈ R, in denen p stetig ist, die Gleichung

0

F (t) =

dF

dt

(t) = p(t) .

9

1 Wahrscheinlichkeiten

1.6 Bedingte Verteilungen

1.6.1 Definition

Es sei (Ω, A, P) ein Wahrscheinlichkeitsraum. Dann wird für B ∈ A mit P(B) > 0 die

bedingte Wahrscheinlichkeit P( · |B) (oder die Wahrscheinlichkeit von A unter der

Bedingung B) durch

P(A|B) :=

P(A ∩ B)

P(B)

für A ∈ A

(5)

definiert. Sie gibt die Wahrscheinlichkeit dafür an, dass A eintritt, unter der Bedingung,

dass B bereits eingetreten ist. Häufig verwendet man Gleichung 5 auch in der Form

P(A ∩ B) = P(B) P(A|B) .

1.6.2 Eigenschaften

Satz 1.3 Die Abbildung

A 7→ P(A|B)

von A nach [0,1] ist ein Wahrscheinlichkeitsmaß mit den zusätzlichen Eigenschaften

P(B|B) = 1

und

P(B c |B) = 0 .

1.6.3 Formel über die totale Wahrscheinlichkeit

Satz 1.4 Gegeben seien disjunkte Mengen B1 , . . . , Bn in A mit P(Bj ) > 0. Dann gilt

S

für A ∈ A mit A ⊆ nj=1 Bj die Aussage

P(A) =

n

X

P(Bj ) · P(A|Bj ) .

j=1

Bemerkung: Insbesondere gilt der Satz im Fall

Sn

j=1 Bj

= Ω für alle A ∈ A.

1.6.4 Formel von Bayes

Zur Berechnung von a posteriori Wahrscheinlichkeiten ist die Formel von Bayes wichtig.

Sie besagt das folgende:

Satz 1.5 Unter den Voraussetzungen aus Satz 1.4 an B1 , . . . , Bn und A folgt für P(A) > 0

die Identität

P(Bk ) · P(A|Bk )

P(Bk |A) = Pn

für k = 1, . . . , n .

(6)

j=1 P(Bj ) · P(A|Bj )

Bemerkung: Den Nenner in Gleichung 6 kann man (falls bekannt) durch P(A) ersetzen.

10

1.7 Unabhängigkeit von Ereignissen

1.7 Unabhängigkeit von Ereignissen

1.7.1 Unabhängigkeit von zwei Ereignissen

Gegeben seien zwei Ereignisse A, B aus einem Wahrscheinlichkeitsraum (Ω, A, P). Dann

heißen A und B (stochastisch) unabhängig, wenn

P(A ∩ B) = P(A) P(B)

gilt.

1.7.2 Eigenschaften

Die ∅ und Ω sind von jeder Menge A ∈ A unahängig. Sind A und B unahängig, dann

gilt dies auch für die Paare A und B c bzw. Ac und B c .

1.7.3 Unabhängigkeit von n Ereignissen

Die Ereignisse A1 , . . . , An aus A heißen (stochastisch) unabhängig, wenn für alle Teilmengen I ⊆ {1, . . . , n} stets

P

\

i∈I

Ai =

Y

P(Ai )

(7)

i∈I

gilt. Man kann dies auch wie folgt formulieren: Für alle m ≥ 2 und alle 1 ≤ i1 < · · · <

im ≤ n hat man

P(Ai1 ∩ · · · ∩ Aim ) = P(Ai1 ) · · · P(Aim ) .

(8)

Die Ereignisse A1 , . . . , An aus A heißen paarweise unabhängig, wenn jeweils zwei

Ereignisse aus A1 , . . . , An unabhängig sind, d. h. Gleichung 7 muss nur für card(I) = 2

bzw. Gleichung 8 nur für m = 2 erfüllt sein.

1.7.4 Eigenschaften

Unabhängige Mengen A1 , . . . , An sind auch paarweise unabhängig. Die Umkehrung ist

i. a. falsch. Ebenso falsch ist, dass aus

P(A1 ∩ · · · ∩ An ) = P(A1 ) · · · P(An )

stets die Unabhängigkeit der Aj folgt.

Sind A1 , . . . , An unabhängig, so gilt dies auch für (Aj )j∈J mit J ⊆ {1, . . . , n}.

11

2 Zufallsvariable

2 Zufallsvariable

2.1 Definition und Verteilungsgesetz

2.1.1 Das vollständige Urbild

Für eine Abbildung X : Ω 7→ R und eine Teilmenge B ⊆ R wird das vollständige

Urbild von B unter X durch

X −1 (B) := {ω ∈ Ω : X(ω) ∈ B}

definiert. Verkürzend schreibt man auch X −1 (B) = {X ∈ B}.

2.1.2 Zufällige Größen

Sei Ω eine Menge, die mit einer σ-Algebra A versehen ist. Eine Abbildung X : Ω 7→ R

heißt zufällige Größe oder reellwertige Zufallsvariable oder zufällige reelle Zahl,

wenn für jedes t ∈ R die Menge {ω ∈ Ω : X(ω) ≤ t} zur σ-Algebra A gehört.

Bemerkung: In diesem Fall gilt dann auch X −1 (B) ∈ A für jede Borelmenge B ⊆ R.

2.1.3 Verteilungsgesetz einer zufälligen Größe

Sei (Ω, A, P) ein Wahrscheinlichkeitsraum. Für eine zufällige Größe X : Ω 7→ R ist die

Abbildung PX : B(R) 7→ [0,1] mit

PX (B) = P X −1 (B) = P{ω ∈ Ω : X(ω) ∈ B} = P({X ∈ B}) = P(X ∈ B)

sinnvoll definiert.

Satz 2.1 Die Abbildung PX ist ein Wahrscheinlichkeitsmaß auf (R, B(R)).

Man nennt PX das Verteilungsgesetz von X (bzgl. P).

2.1.4 Typen von zufälligen Größen

Eine zufällige Größe X heißt diskret, wenn PX ein diskretes Wahrscheinlichkeitsmaß ist.

Damit hat PX die Gestalt

PX (B) =

X

{i : xi ∈B}

12

pi

2.1 Definition und Verteilungsgesetz

mit geeigneten xi ∈ R und pi ≥ 0. Die xi sind die möglichen Werte von X, d. h. es gilt

P(X ∈ {x1 , x2 , . . . }) = 1, und

pi = P{ω ∈ Ω : X(ω) = xi } .

Eine zufällige Größe X heißt stetig, falls PX ein stetiges Wahrscheinlichkeitsmaß ist.

Das gilt genau dann, wenn mit einer Wahrscheinlichkeitsdichte p für alle α < β die

Gleichung

PX ([α, β]) = P{ω ∈ Ω : α ≤ X(ω) ≤ β} =

Zβ

p(x) dx

α

erfüllt ist. Die Funktion p nennt man auch Verteilungsdichte (oder einfach Dichte)

von X.

2.1.5 Speziell verteilte diskrete zufällige Größen

Eine zufällige Größe X heißt gleichverteilt auf einer endlichen Menge oder binomialverteilt oder Poissonverteilt etc., wenn PX von diesem Typ ist. In allen diesen Fällen

ist X diskret. Zum Beispiel ist X gemäß Bn,p verteilt (man schreibt auch X ∼ Bn,p ),

falls für 0 ≤ k ≤ n stets

!

n k

p (1 − p)n−k

k

PX ({k}) = P{ω ∈ Ω : X(ω) = k} =

gilt. Analog ist X gemäß Pλ verteilt, sofern für k ∈ N0

PX ({k}) = P{ω ∈ Ω : X(ω) = k} =

λk −λ

e .

k!

2.1.6 Speziell verteilte stetige zufällige Größen

Eine zufällige Größe X heißt gleichverteilt auf einem Intervall, oder exponentialverteilt oder normalverteilt etc., wenn PX von diesem Typ ist. Alle diese zufälligen

Größen sind stetig. Zum Beispiel ist X gleichverteilt auf [a, b], falls für alle α < β stets

PX ([α, β]) = P{ω ∈ Ω : α ≤ X(ω) ≤ β} =

Länge von ([α, β] ∩ [a, b])

b−a

gilt. Oder X ist N (µ, σ 2 )-verteilt (man schreibt X ∼ N (µ, σ 2 )), sofern

1

PX ([α, β]) = P{ω ∈ Ω : α ≤ X(ω) ≤ β} = √

2πσ

Zβ

(x−µ)2/2σ 2

e−

dx .

α

13

2 Zufallsvariable

2.1.7 Identisch verteilte zufällige Größen

Zwei zufällige Größen X und Y sind identisch verteilt, wenn PX = PY gilt, d. h. für

alle B ∈ B(R) hat man

P{ω ∈ Ω : X(ω) ∈ B} = P{ω ∈ Ω : Y (ω) ∈ B} .

d

Man schreibt dann X = Y .

2.1.8 Verteilungsfunktion einer zufälligen Größe

Die Verteilungsfunktion FX einer zufälligen Größe ist die Verteilungsfunktion ihres

Verteilungsgesetzes, d. h., es gilt

FX (t) = PX (−∞, t] = P{ω ∈ Ω : X(ω) ≤ t} ,

t∈R.

d

Für zwei zufällige Größen X und Y gilt genau dann X = Y , wenn man FX = FY hat.

Die Funktion FX besitzt die Eigenschaften aus Satz 1.2.

2.2 Zufällige Vektoren und Unabhängigkeit zufälliger Größen

2.2.1 Zufällige Vektoren

~ : Ω 7→ Rn heißt (n-dimensioSei Ω eine Menge mit einer σ-Algebra A. Eine Abbildung X

naler) zufälliger Vektor, wenn seine Koordinatenabbildungen Xj : Ω 7→ R alle zufällige

Größen sind. Dabei sind wie üblich die Xj durch

~

X(ω)

= (X1 (ω), . . . , Xn (ω)) ,

ω ∈Ω,

definiert.

2.2.2 Gemeinsames Verteilungsgesetz

Sei (Ω, A, P) ein Wahrscheinlichkeitsraum. Dann definiert man wie im eindimensionalen

~ durch

Fall das Verteilungsgesetz PX~ von X

~ −1 (B) = P{ω ∈ Ω : (X1 (ω), . . . , Xn (ω)) ∈ B} .

PX~ (B) := P X

Im Spezialfall B = B1 × · · · × Bn für Borelmengen Bj ⊆ R folgt

PX~ (B) = P(X1 ∈ B1 , . . . , Xn ∈ Bn ) .

Deshalb nennt man PX~ auch gemeinsames Verteilungsgesetz der zufälligen Größen

X1 , . . . , Xn .

14

2.2 Zufällige Vektoren und Unabhängigkeit zufälliger Größen

2.2.3 Randverteilungen

~ nennt man die Verteilungsgesetze PX , 1 ≤ j ≤ n,

Für einen zufälligen Vektor X

j

~ Hierbei sind wie zuvor die zufälligen Größen Xj die

die Randverteilungen von X.

zugehörigen Koordinatenabbildungen.

Satz 2.2 Die Randverteilungen berechnen sich aus der gemeinsamen Verteilung durch

PXj (B) = PX~ (R × · · · × B × · · · × R) ,

B ∈ B(R) .

↑ j-te Stelle

Damit bestimmt die gemeinsame Verteilung die zugehörigen Randverteilungen.

Bemerkung: Die Umkehrung der obigen Aussage ist i. a. falsch, d. h. es existieren zufällige

~ = (X1 , . . . , Xn ) und Y

~ = (Y1 , . . . , Yn ) mit PX = PY , 1 ≤ j ≤ n, aber mit

Vektoren X

j

j

PX~ 6= PY~ .

2.2.4 Randverteilungen diskreter Vektoren

Wir betrachten hier nur den Fall n = 2. Ein zufälliger 2-dimensionaler Vektor hat die

Gestalt (X, Y ) mit vorgegebenen zufälligen Größen X und Y . Weiterhin seien X und Y

diskret und die Folgen (xi )i≥1 bzw. (yj )j≥1 von reellen Zahlen bezeichnen die möglichen

Werte von X bzw. Y . Dann nimmt der Vektor (X, Y ) die Werte (xi , yj )i,j≥1 an und für

das Verteilungsgesetz von P(X,Y ) , d. h. die gemeinsame Verteilung von X und Y , gilt

X

P(X,Y ) (B) =

B ∈ P(R2 ) ,

pij ,

{(i,j) : (xi ,yj )∈B}

wobei

pij = P(X,Y ) ({(xi , yj )}) = P(X = xi , Y = yj ) .

Für die Randverteilungen ergibt sich dann

PX (B) =

X

qi

und

X

PY (B) =

{i : xi ∈B}

rj ,

B ∈ P(R) ,

{j : yj ∈B}

mit

qi =

∞

X

j=1

pij

und

rj =

∞

X

pij .

i=1

15

2 Zufallsvariable

2.2.5 Randverteilungen stetiger Vektoren

Zur besseren Übersichtlichkeit betrachten wir auch hier nur den Fall n = 2. Der 2dimensionale Vektor (X, Y ) sei wie oben definiert. Diesmal nehmen wir aber an, dass

P(X,Y ) eine Dichte hat, es also eine Funktion p : R2 7→ R gibt, so dass für alle α < β und

γ < δ stets

P(X,Y ) [α, β] × [γ, δ] = P{ω ∈ Ω : α ≤ X(ω) ≤ β, γ ≤ Y (ω) ≤ δ} =

Zβ Zδ

p(x, y) dy dx

α γ

gilt. Dann haben X bzw. Y Verteilungsdichten q und r mit

Z∞

q(x) :=

Z∞

p(x, y) dy

und

−∞

r(y) :=

p(x, y) dx .

−∞

2.2.6 Unabhängigkeit von zufälligen Größen

Gegeben seien n zufällige Größen X1 , . . . , Xn auf (Ω, A, P). Gilt für beliebige Borelmengen

B1 , . . . , Bn ∈ B(R) stets

P(X1 ∈ B1 , . . . , Xn ∈ Bn ) = P(X1 ∈ B1 ) · · · P(Xn ∈ Bn ) ,

(9)

so heißen X1 , . . . , Xn unabhängig.

Bemerkung 1: Die Unabhängigkeit der Xj ist äquivalent

zu folgender

Aussage: Für

n

−1

beliebige Borelmengen Bj ∈ B(R) sind die Ereignisse Xj (Bj )

unabhängig. Das

j=1

folgt aus der Tatsache, dass man in Gleichung 9 für gewisse vorgegebene Bj auch die

reellen Zahlen R einsetzen kann.

Bemerkung 2: Es reicht aus, wenn Gleichung 9 mit Intervallen Bj der Form (−∞, tj ]

für alle tj ∈ R gilt. Die zufälligen Größen X1 , . . . , Xn sind also dann und nur dann

unabhängig, wenn für alle tj ∈ R stets

P(X1 ≤ t1 , . . . , Xn ≤ tn ) = P(X1 ≤ t1 ) · · · P(Xn ≤ tn )

folgt.

Bemerkung 3: Aufgrund von Gleichung 9 ist die gemeinsame Verteilung von X1 , . . . , Xn

im Fall der Unabhängigkeit eindeutig durch ihre Randverteilungen PXj , 1 ≤ j ≤ n,

bestimmt.

16

2.3 Rechnen mit zufälligen Größen

2.2.7 Spezialfälle

Besitzen X und Y die Eigenschaften aus Abschnitt 2.2.4, so sind X und Y dann und nur

dann unabhängig, wenn

pij = qi · rj ,

1 ≤ i, j < ∞ .

Im stetigen Fall (Abschnitt 2.2.5) sind X und Y genau dann unabhängig, wenn

p(x, y) = q(x) · r(y) ,

x, y ∈ R .

2.3 Rechnen mit zufälligen Größen

2.3.1 Transformationen

Eine Abbildung f : R 7→ R heißt messbar, wenn für jedes t ∈ R die Menge {x ∈

R : f (x) ≤ t} eine Borelmenge ist. Stetige Funktionen, Grenzwerte stetiger Funktionen

oder auch monotone Funktionen besitzen diese Eigenschaft.

Satz 2.3 Sei X eine zufällige Größe und sei f : R 7→ R messbar. Dann ist Y := f (X)

ebenfalls eine zufällige Größe.

Allgemeine Aufgabe: Man bestimme PY mit Hilfe von PX und f . Folgendes Beispiel

illustriere die Situation: Sei U gleichverteilt auf [0,1], so ist mit f (s) := 1 − s auch

Y := f (U ) = 1 − U gleichverteilt auf [0,1].

2.3.2 Simulation stetiger zufälliger Größen

Sei X eine stetige zufällige Größe mit Verteilungsfunktion FX . Wir nehmen an, dass mit

zwei Zahlen −∞ ≤ a < b ≤ ∞ die Verteilungsfunktion FX (a) = 0, FX (b) = 1 erfülle und

auf (a, b) streng wachsend sei. Dann existiert die inverse Funktion von FX , die mit FX−1

bezeichnet wird, und es gilt FX−1 : (0,1) 7→ (a, b).

Satz 2.4 Sei U eine auf [0,1] gleichverteilte zufällige Größe. Unter den obigen Vorausd

setzungen gilt dann für Y := FX−1 (U ) die Aussage X = Y .

Anwendung: Sind u1 , . . . , un unabhängig erzeugte reelle Zahlen, die gemäß der Gleichverteilung aus [0,1] gewählt wurden, so sind die Zahlen xj := FX−1 (uj ) ebenfalls unabhängig

und gemäß PX verteilt.

17

2 Zufallsvariable

2.3.3 Lineare Transformationen

Für reelle Zahlen a 6= 0 und b ∈ R betrachte man die lineare Transformation

Y := a X + b

einer zufälligen Größe X.

Satz 2.5 Im Fall a > 0 folgt

FY (t) = FX

t−b

a

.

Ist a < 0, so ergibt sich

t−b

FY (t) = 1 − P X <

a

,

also

FY (t) = 1 − FX

t−b

a

im Fall stetiger X.

Folgerung: Besitzt X die Verteilungsdichte p, so hat Y = a X + b eine Dichte q, die sich

aus p durch

t−b

1

p

|a|

a

q(t) =

,

t ∈ R,

ergibt.

2.3.4 Addition zufälliger Größen

Für zwei zufällige Größen X und Y wird ihre Summe X + Y durch

(X + Y )(ω) := X(ω) + Y (ω) ,

ω ∈Ω,

definiert.

Satz 2.6 Sind X und Y zufällige Größen, so gilt dies auch für X + Y .

Das Verteilungsgesetz der Summe X + Y kann man für unabhängige zufällige Größen in

einigen Fällen in einfacher Form angeben.

Satz 2.7 Es seien X und Y unabhängige zufällige Größen.

18

2.4 Erwartungswert

1. Nehmen X und Y Werte in den ganzen Zahlen Z an, so folgt

P(X + Y = k) =

∞

X

P(X = i) P(Y = k − i) ,

k∈Z.

i=−∞

2. Besitzen X und Y Werte in N0 , so ergibt sich

P(X + Y = k) =

k

X

P(X = i) P(Y = k − i) ,

k ∈ N0 .

i=0

Im Fall stetiger zufälliger Größen gilt folgender Satz:

Satz 2.8 Seien X und Y unabhängig mit Verteilungsdichten p und q. Dann besitzt X +Y

die Verteilungsdichte r mit

Z∞

r(x) =

p(x − y) q(y) dy =

−∞

Z∞

p(y) q(x − y) dy .

−∞

Man nennt r die Faltung von p und q und schreibt r = p ∗ q.

2.3.5 Addition speziell verteilter zufälliger Größen

Satz 2.9 Im folgenden seien X und Y stets als unabhängig vorausgesetzt. Dann gilt:

(a) Aus X ∼ Bn,p und Y ∼ Bm,p folgt X + Y ∼ Bn+m,p .

(b) Aus X ∼ Pλ und Y ∼ Pµ erhält man X + Y ∼ Pλ+µ .

(c) Aus X ∼ N (µ1 , σ12 ) und Y ∼ N (µ2 , σ22 ) folgt X + Y ∼ N (µ1 + µ2 , σ12 + σ22 ).

2.4 Erwartungswert

2.4.1 Erwartungswert diskreter zufälliger Größen

Eine zufällige Größe X nehme Werte x1 , x2 , . . . aus [0, ∞) an. Dann definiert man den

Erwartungswert von X durch

EX :=

∞

X

xi P(X = xi ) .

i=1

Es gilt dann 0 ≤ EX ≤ ∞.

19

2 Zufallsvariable

Sind nunmehr die Werte von X beliebige reelle Zahlen (nicht notwendig ≥ 0), so sagt

man, dass X einen Erwartungswert besitzt, wenn

∞

X

|xi | P(X = xi ) < ∞ .

i=1

In diesem Fall ist der Erwartungswert von X mit

EX :=

∞

X

xi P(X = xi )

i=1

eine wohldefinierte reelle Zahl.

2.4.2 Erwartungswert stetiger zufälliger Größen

Sei p die Verteilungsdichte einer zufälligen Größe X. Dann besitzt X einen Erwartungswert, wenn

Z∞

|x| p(x) dx < ∞ ,

−∞

und man definiert den Erwartungswert von X durch

Z∞

x p(x) dx .

EX :=

−∞

2.4.3 Beispiele zur Berechnung von Erwartungswerten

Verteilung

X

X

X

X

X

X

X

20

gleichverteilt auf x1 , . . . , xN

∼ Bn,p

∼ Pλ

geometrisch verteilt mit Parameter p

gleichverteilt auf [a, b]

∼ Eλ

∼ N (µ, σ 2 )

Erwartungswert

EX

EX

EX

EX

EX

EX

EX

PN

= N1

= np

=λ

= 1−p

p

= a+b

2

= λ1

=µ

i=1 xi

2.5 Varianz und Kovarianz

2.4.4 Eigenschaften des Erwartungswertes

Satz 2.10 Der Erwartungswert einer zufälligen Größe hat folgende Eigenschaften:

1. Der Erwartungswert ist linear, d. h. für alle a, b ∈ R und zufällige Größen X und

Y gilt

E(aX + bY ) = a EX + b EY .

2. Sei X diskret mit möglichen Werten x1 , x2 , . . . aus R. Dann existiert für eine

Funktion f : R 7→ R der Erwartungswert Ef (X) genau dann, wenn

∞

X

|f (xi )| P(X = xi ) < ∞ ,

i=1

und es gilt

Ef (X) =

∞

X

f (xi ) P(X = xi ) .

i=1

3. Ist X stetig mit Verteilungsdichte p, so existiert für eine messbare Abbildung

f : R 7→ R genau dann der Erwartungswert von f (X), wenn

Z∞

|f (x)| p(x) dx < ∞ ,

−∞

und man hat

Z∞

f (x) p(x) dx .

Ef (X) =

−∞

4. Sind X und Y unabhängige zufällige Größen deren Erwartungswert existiert, so

existiert auch der Erwartungswert von X · Y , und es gilt

E(X · Y ) = EX · EY .

2.5 Varianz und Kovarianz

2.5.1 Momente

Sei n ∈ N. Eine zufällige Größe X besitzt ein n-tes Moment, wenn E|X|n < ∞. Im

diskreten Fall bedeutet dies

∞

X

|xi |n P(X = xi ) < ∞

i=1

21

2 Zufallsvariable

und im stetigen

Z∞

|x|n p(x) dx < ∞ .

−∞

Insbesondere hat X ein erstes Moment, genau dann, wenn EX existiert.

Satz 2.11 Sei 1 ≤ m ≤ n. Hat eine zufällige Größe X ein n-tes Moment, so besitzt

sie auch ein m-tes Moment. Insbesondere hat jede zufällige Größe mit zweitem Moment

einen Erwartungswert.

2.5.2 Varianz

Es sei X eine zufällige Größe mit zweitem Moment. Sei a := EX. Dann definiert man die

Varianz (oder Streuung) von X durch

VX := E(X − a)2 .

Die Varianz gibt den mittleren quadratischen Abstand einer zufälligen Größe X von

ihrem Erwartungswert an. Sie ist ein Maß dafür, wie sehr die Werte von X um EX

schwanken.

2.5.3 Eigenschaften der Varianz

Satz 2.12 Im folgenden seien X und Y zufällige Größen mit zweiten Momenten. Dann

gelten die folgenden Aussagen:

1. Mit a := EX berechnet sich die Varianz für diskrete zufällige Größen in der Form

VX =

∞

X

(xi − a)2 P(X = xi ) ,

i=1

und im stetigen Fall hat man

Z∞

VX =

(x − a)2 p(x) dx .

−∞

2. Es besteht die Identität

VX = EX 2 − (EX)2 .

3. Für eine konstante zufällige Größe X folgt VX = 0.

22

2.5 Varianz und Kovarianz

4. Für α ∈ R erhält man

V(α X) = α2 VX .

5. Sind X und Y unabhängig, dann gilt

V(X + Y ) = VX + VY .

2.5.4 Beispiele zur Berechnung von Varianzen

Verteilung

X

X

X

X

Varianz

gleichverteilt auf x1 , . . . , xN

∼ Bn,p

∼ Pλ

geometrisch verteilt mit Parameter p

VX

VX

VX

VX

2

= N1 N

i=1 (xi − EX)

= n p (1 − p)

=λ

= 1−p

p2

P

VX = (b−a)

12

VX = λ12

VX = σ 2

X gleichverteilt auf [a, b]

X ∼ Eλ

X ∼ N (µ, σ 2 )

2

2.5.5 Kovarianz

Gegeben seien zwei zufällige Größen X und Y mit zweiten Momenten. Seien a := EX

und b := EY . Dann wird die Kovarianz von X und Y durch

cov(X, Y ) := E(X − a)(Y − b)

definiert.

Eigenschaften:

1. Sind X und Y diskret mit möglichen Werten x1 , x2 , . . . bzw. y1 , y2 , . . . aus R, so

berechnet sich die Kovarianz aus der Formel

cov(X, Y ) =

∞

X

(xi − a)(yj − b) pij

i,j=1

wobei

pij = P(X = xi , Y = yj ) .

23

2 Zufallsvariable

2. Hat die Verteilung des zufälligen Vektors (X, Y ) eine Dichte p : R2 7→ R, so ergibt

sich die Kovarianz von X und Y aus

Z∞ Z∞

cov(X, Y ) =

(x − a)(y − b) p(x, y) dx dy .

−∞ −∞

3. Sind X und Y unabhängig, so impliziert dies cov(X, Y ) = 0, d. h. X und Y

sind unkorreliert. Man beachte, dass aus der Unkorreliertheit i. a. nicht die

Unabhängigkeit folgt.

4. Man hat

|cov(X, Y )| ≤ (VX) /2 (VY ) /2 .

1

1

(10)

2.5.6 Korrelationskoeffizient

Für zwei zufällige Größen X und Y mit zweiten Momenten definiert man ihren Korrelationskoeffizienten durch

ρ(X, Y ) :=

cov(X, Y )

.

(VX)1/2 (VY )1/2

Aus Gleichung 10 folgt

−1 ≤ ρ(X, Y ) ≤ 1 .

Für unkorrelierte zufällige Größen gilt ρ(X, Y ) = 0. Der Korrelationskoeffizient ist ein Maß

für den Grad der Abhängigkeit von X und Y . Je näher ρ(X, Y ) an 1 oder −1 liegt, desto

größer ist die Abhängigkeit zwischen X und Y . Im stärksten Fall der Abhängigkeit von

X und Y , nämlich Y = X bzw. Y = −X, hat man ρ(X, X) = 1 bzw. ρ(X, −X) = −1.

24

Nutzungsbedingungen

Dieses Dokument wurde für die auf der Titelseite genannte Vorlesung erstellt und wird jetzt

im Rahmen des Projekts »Vorlesungsskripte der Fakultät für Mathematik und Informatik«

weiter betreut. Das Dokument wurde nach bestem Wissen und Gewissen angefertigt.

Dennoch garantiert weder der auf der Titelseite genannte Dozent, die Personen, die an

dem Dokument mitgewirkt haben, noch die Mitglieder des Projekts für dessen Fehlerfreiheit.

Für etwaige Fehler und dessen Folgen wird von keiner der genannten Personen eine

Haftung übernommen. Es steht jeder Person frei, dieses Dokument zu lesen, zu verändern

oder auf anderen Medien verfügbar zu machen, solange ein Verweis auf die Internetadresse

des Projekts http: // uni-skripte. lug-jena. de/ enthalten ist.

Diese Ausgabe trägt die Versionsnummer 1889 und ist vom 15. November 2008. Eine

neue Ausgabe könnte auf der Webseite des Projekts verfügbar sein.

Jeder ist dazu aufgerufen, Verbesserungen, Erweiterungen und Fehlerkorrekturen für das

Skript einzureichen bzw. zu melden oder diese selbst einzupflegen – einfach eine E-Mail

an die Mailingliste <uni-skripte@ lug-jena. de> senden. Weitere Informationen sind

unter der oben genannten Internetadresse verfügbar.

Hiermit möchten wir allen Personen, die an diesem Skript mitgewirkt haben, vielmals

danken:

• Prof. Werner Linde (2008/09)

25

Index

B

besitzt Erwartungswert, 20

binomialverteilt, 13

Binomialverteilung, 6

Borelmenge, 4

D

Dichte, 5, 13

Diracsche δ-Maß, 5

diskret, 4, 12

E

Einpunktverteilung, 5

Elementarereignis, 2

endlich additiv, 3

Ereignis, 2

Erwartungswert, 19, 20

exponentialverteilt, 13

Exponentialverteilung, 7

F

Faltung, 19

G

gleichverteilt, 13

Gleichverteilung, 5, 7

auf E, 8

Grundraum, 2

K

Korrelationskoeffizient, 24

Kovarianz, 23

M

messbar, 17

monoton, 3

N

normalverteilt, 13

26

Normalverteilung, 8

n-tes Moment, 21

P

Poissonverteilt, 13

Poissonverteilung, 6

R

Randverteilung, 15

S

σ-Algebra, 2

Standardnormalverteilung, 8

stetig, 5, 13

von oben, 3

von unten, 3

Streuung, 22

T

tritt ein, 2

U

unabhängig, 11, 16

paarweise, 11

unkorreliert, 24

Urbild

vollständiges, 12

V

Varianz, 22

verteilt

identisch, 14

Verteilung

geometrische, 7

hypergeometrische, 6

Verteilungsdichte, 13

Verteilungsfunktion, 8, 14

Verteilungsgesetz, 12

gemeinsames, 14

Index

W

Wahrscheinlichkeit

bedingte, 10

Wahrscheinlichkeitsdichte, 4

Wahrscheinlichkeitsmaß, 2

Wahrscheinlichkeitsraum, 3

Wahrscheinlichkeitsverteilung, 2

Z

Zufallsvariable

reellwertige, 12

zufällige

Größe, 12

reelle Zahl, 12

-r Vektor, 14

27