bisheriges Formelblatt

Werbung

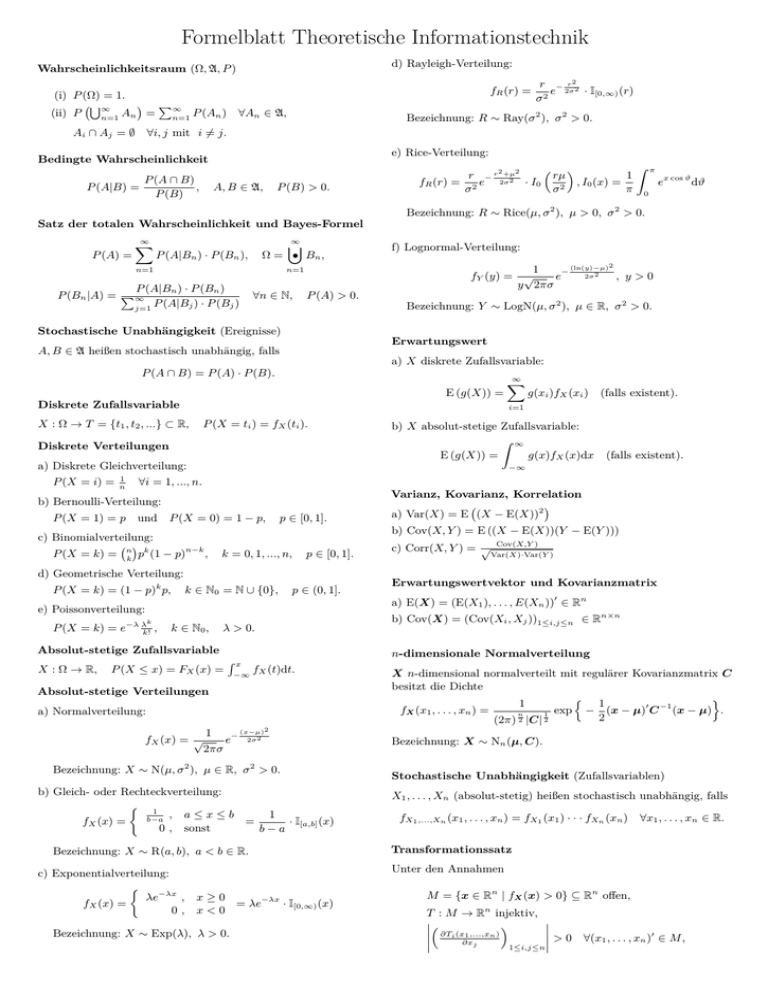

Formelblatt Theoretische Informationstechnik

d) Rayleigh-Verteilung:

Wahrscheinlichkeitsraum (Ω, A, P )

fR (r) =

(i) P (Ω) = 1.

(ii) P

S∞

P∞

n=1

An =

Ai ∩ Aj = ∅

n=1

∀An ∈ A,

P (An )

r − r22

e 2σ · I[0,∞) (r)

σ2

Bezeichnung: R ∼ Ray(σ 2 ), σ 2 > 0.

∀i, j mit i 6= j.

e) Rice-Verteilung:

Bedingte Wahrscheinlichkeit

P (A ∩ B)

P (A|B) =

,

P (B)

A, B ∈ A,

P (B) > 0.

r − r2 +µ2

fR (r) = 2 e 2σ2 · I0

σ

rµ

1

, I0 (x) =

σ2

π

Z

π

ex cos ϑ dϑ

0

Bezeichnung: R ∼ Rice(µ, σ 2 ), µ > 0, σ 2 > 0.

Satz der totalen Wahrscheinlichkeit und Bayes-Formel

P (A) =

∞

X

∞

[

P (A|Bn ) · P (Bn ),

Ω = • Bn ,

n=1

(ln(y)−µ)2

1

−

2σ 2

fY (y) = √

e

, y>0

y 2πσ

n=1

P (A|Bn ) · P (Bn )

P (Bn |A) = P∞

P (A|Bj ) · P (Bj )

j=1

∀n ∈ N,

f) Lognormal-Verteilung:

P (A) > 0.

Bezeichnung: Y ∼ LogN(µ, σ 2 ), µ ∈ R, σ 2 > 0.

Stochastische Unabhängigkeit (Ereignisse)

Erwartungswert

A, B ∈ A heißen stochastisch unabhängig, falls

a) X diskrete Zufallsvariable:

P (A ∩ B) = P (A) · P (B).

E (g(X)) =

∞

X

Diskrete Zufallsvariable

X : Ω → T = {t1 , t2 , ...} ⊂ R,

P (X = ti ) = fX (ti ).

Diskrete Verteilungen

1

n

Z

g(x)fX (x)dx

(falls existent).

−∞

∀i = 1, ..., n.

P (X = 1) = p

Varianz, Kovarianz, Korrelation

P (X = 0) = 1 − p,

und

p ∈ [0, 1].

n

k

pk (1 − p)

n−k

,

k = 0, 1, ..., n,

p ∈ [0, 1].

d) Geometrische Verteilung:

P (X = k) = (1 − p)k p,

k ∈ N0 = N ∪ {0},

p ∈ (0, 1].

e) Poissonverteilung:

k

P (X = k) = e−λ λk! ,

k ∈ N0 ,

λ > 0.

Absolut-stetige Zufallsvariable

P (X ≤ x) = FX (x) =

f (t)dt.

−∞ X

(x−µ)2

1

−

fX (x) = √

e 2σ2

2πσ

Bezeichnung: X ∼ N(µ, σ 2 ), µ ∈ R, σ 2 > 0.

b) Gleich- oder Rechteckverteilung:

1

b−a

,

0,

a≤x≤b

1

=

· I[a,b] (x)

sonst

b−a

Bezeichnung: X ∼ R(a, b), a < b ∈ R.

fX (x) =

λe−λx ,

0,

Cov(X,Y )

Var(X)·Var(Y )

Erwartungswertvektor und Kovarianzmatrix

a) E(X) = (E(X1 ), . . . , E(Xn ))0 ∈ Rn

b) Cov(X) = (Cov(Xi , Xj ))1≤i,j≤n ∈ Rn×n

X n-dimensional normalverteilt mit regulärer Kovarianzmatrix C

besitzt die Dichte

1

n

2

(2π) |C|

1

2

exp

n

−

1

(x − µ)0 C −1 (x − µ) .

2

o

Bezeichnung: X ∼ Nn (µ, C).

Stochastische Unabhängigkeit (Zufallsvariablen)

X1 , . . . , Xn (absolut-stetig) heißen stochastisch unabhängig, falls

fX1 ,...,Xn (x1 , . . . , xn ) = fX1 (x1 ) · · · fXn (xn )

∀x1 , . . . , xn ∈ R.

Transformationssatz

Unter den Annahmen

c) Exponentialverteilung:

c) Corr(X, Y ) = √

fX (x1 , . . . , xn ) =

a) Normalverteilung:

fX (x) =

n-dimensionale Normalverteilung

Rx

Absolut-stetige Verteilungen

a) Var(X) = E (X − E(X))2

b) Cov(X, Y ) = E ((X − E(X))(Y − E(Y )))

c) Binomialverteilung:

X : Ω → R,

∞

E (g(X)) =

b) Bernoulli-Verteilung:

P (X = k) =

(falls existent).

b) X absolut-stetige Zufallsvariable:

a) Diskrete Gleichverteilung:

P (X = i) =

g(xi )fX (xi )

i=1

x≥0

= λe−λx · I[0,∞) (x)

x<0

Bezeichnung: X ∼ Exp(λ), λ > 0.

M = {x ∈ Rn | fX (x) > 0} ⊆ Rn offen,

T : M → Rn injektiv,

∂T (x1 ,...,xn ) i

> 0 ∀(x1 , . . . , xn )0 ∈ M ,

∂xj

1≤i,j≤n

besitzt der Zufallsvektor Y = T (X) eine Dichte

fY (y1 , . . . , yn ) = Entropie

1

∂Ti (x)

∂xj

fX T −1 (y1 , . . . , yn )

|x=T −1 (y1 ,...,yn ) −1

∂Ti (y1 , . . . , yn ) fX T −1 (y1 , . . . , yn ) ,

= ∂yj

(y1 , . . . , yn )0 ∈ T (M ).

](x, y) =

y

x

y

x

y

x

arctan

π

2

P

P (X = xj ) log P (X = xj )

j

Gemeinsame Entropie

P

H(X, Y ) = −

P (X = xi , Y = yj ) log P (X = xi , Y = yj )

i,j

Bedingte Entropie

P

H(X|Y ) = −

Erweiterter Arcustangens ](x, y)

arctan

arctan

H(X) = −

P (X = xi , Y = yj ) log P (X = xi |Y = yj )

i,j

+π

x > 0,

x<0

x > 0,

x = 0,

x = 0,

+ 2π

− π2

y≥0

Transinformation

I(X; Y ) = H(X) − H(X|Y )

y<0 .

y≥0

y<0

Differentielle Entropie

Summen von Zufallsvariablen

H(X) = −

R∞

−∞

f (x) log f (x)dx

0

X = (X1 , X2 ) Zufallsvektor mit Dichte fX (x1 , x2 ).

Dann besitzt Y = X1 + X2 die Dichte

Gemeinsame differentielle Entropie

∞

Z

H(X, Y ) = −

fX (t, y − t)dt.

fY (y) =

R∞ R∞

−∞

f (x, y) log f (x, y)dxdy

−∞

−∞

Komplexe Normalverteilung

Bedingte differentielle Entropie

a) X = U + iV ∈ Cn heißt komplex normalverteilt, wenn

(U , V )0 2n-dimensional normalverteilt ist.

H(X|Y ) = −

b) X ist zirkulär symmetrisch komplex normalverteilt, wenn

Kullback-Leibler-Distanz

1

=

2

U

Cov

V

Re Q

Im Q

− Im Q

Re Q

D(f k g) =

D(p k q) =

R∞ R∞

−∞

−∞

f (x, y) log f (x|y)dxdy

R∞

(x)

dx (kontinuierlich)

f (x) log fg(x)

−∞

P

pi

i

pi log

(diskret)

qi

für eine hermitesche, n.n.d. Matrix Q, X ∼ SCN(µ, Q).

Entropie der Normalverteilung

c) X ∼ SCN(µ, Q), Q regulär =⇒ X besitzt die Dichte

fX (x) = [det(πQ)]−1 exp −(x − µ)∗ Q−1 (x − µ) .

d) X ∼ SCN(µ, Q) =⇒ E (X − E(X))(X − E(X))∗

= Q.

e) X ∼ SCN(µ, Q), A ∈ Cm×n =⇒ AX ∼ SCN(Aµ, AQA∗ ).

1

2

X ∼ Nn (µ, C) =⇒ H(X) =

ln ((2πe)n |C|).

Binärer symmetrischer Kanal

C = max I(X; Y ) = 1 + (1 − ) log2 (1 − ) + log2 (p0 ,p1 )

f) X ∼ SCN(µ1 , Q1 ), Y ∼ SCN(µ2 , Q2 ), X, Y stochastisch

unabhängig =⇒ X + Y ∼ SCN(µ1 + µ2 , Q1 + Q2 ).

Gaußkanal mit binärer Eingabe

g) X ∼ SCN(µ, Q), Q regulär =⇒ H(X) = log |πeQ|.

C = max I(X; Y ) = 1 − E log2 (1 + e−W ) , W ∼ N

Stochastische Prozesse

Reeller Gaußkanal

{X(t) | t ∈ T }, {Y (t) | t ∈ T }, T ⊆ R:

C=

a) µX (t) = E (X(t)),

max I(X; Y ) =

E(X 2 )≤L

1

2

L

σ2

ln 1 +

Paralleler Gaußkanal

c) CXX (t1 , t2 ) = RXX (t1 , t2 ) − µX (t1 ) · µ∗X (t2 ),

I(X; Y ) =

C = Pn max

E(Xi2 )≤L

i=1

d) RXY (t1 , t2 ) = E (X(t1 )Y (t2 )).

2µ2 4µ2

, σ2

σ2

(p0 ,p1 )

b) RXX (t1 , t2 ) = E (X(t1 )X ∗ (t2 )),

∗

ΣZ = T diag(λ1 , . . . , λn )T 0 ,

Pn

1

2

i=1

Pn

i=1

ln 1 +

(ν−λi )+

λi

,

(ν − λi )+ = L.

Leistungsdichtespektrum

a) E |X(t)|2 = RXX (0) =

R∞

−∞

b) SXX (f ) ∈ R und SXX (f ) ≥ 0

SXX (f )df ,

∀f ∈ R,

c) SXX (f ) = SXX (−f ) , falls RXX (t) ∈ R.

Bandbegrenzer Gaußkanal

C=

R∞

b) µY (t) = E(Y (t)) = µX (t)

−∞

I(X; Y ) =

h(u)

R∞

−∞

R∞

−∞

∗

i=1

log

νλi

σ2

+

Pt

i=1,λi >0

,

ν−

σ2

λi

+

= L.

h(u)du,

h (v)RXX (t − u + v)dvdu,

d) SY Y (f ) = |H(f )|2 SXX (f ).

Pt

H ∗ H = U diag(λ1 , . . . , λt )U ∗ ,

h(u)X(t − u)du,

−∞

c) RY Y (t) =

max

∗

E(X X)≤L

LTI-Systeme

R∞

E(X 2 )≤L

L

N0 W

MIMO-Kanal (festes H)

C=

a) Y (t) =

max I(X; Y ) = W ln 1 +

MIMO-Kanal (normalverteiltes H)

C=

max

∗

E(X X)≤L

I X; (Y , H) = E log det Ir +

L

HH ∗

tσ 2

.